ディープフェイクに代わるものとして期待されていますか?今年最も人気のある NeRF テクノロジーの素晴らしさを明らかにする

えっ、まだ NeRF を知らないのですか?

NeRF は、コンピューター ビジョンの分野で今年最も注目されている AI テクノロジーとして広く使用されており、明るい将来があると言えます。

ステーション B の友人たちは、このテクノロジーを新しい方法で使用しています。

良いニュースを引き寄せるために

それでは、NeRFとは一体何なのでしょうか?

NeRF (Neural Radiance Fields) は、2020 ECCV カンファレンスの最優秀論文で最初に提案された概念であり、2D ポーズ画像のみを監督として使用し、暗黙的な表現を新しいレベルに押し上げます。次元のシーン。

一石は千の波を巻き起こす その後、NeRF は急速に発展し、「新しい視点の合成、三次元再構成」など、多くの技術的方向に応用されています。

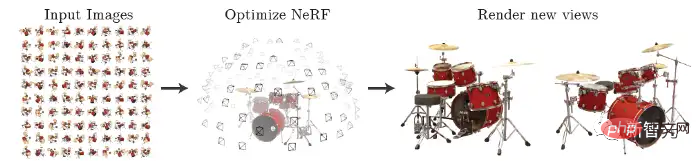

NeRF は、トレーニング用のポーズ付きのまばらなマルチアングル画像を入力して神経放射線野モデルを取得し、このモデルに従って、下図に示すように、どの角度から見ても鮮明な写真をレンダリングできます。これは、MLP を使用して 3 次元シーンを暗黙的に学習すると簡単に要約することもできます。

#ネチズンは当然、NeRF と同様に人気のあるディープフェイクを比較します。

MetaPhysics によって公開された最近の記事では、NeRF の進化の歴史、課題、利点を評価し、NeRF が最終的にディープフェイクに取って代わることを予測しました。

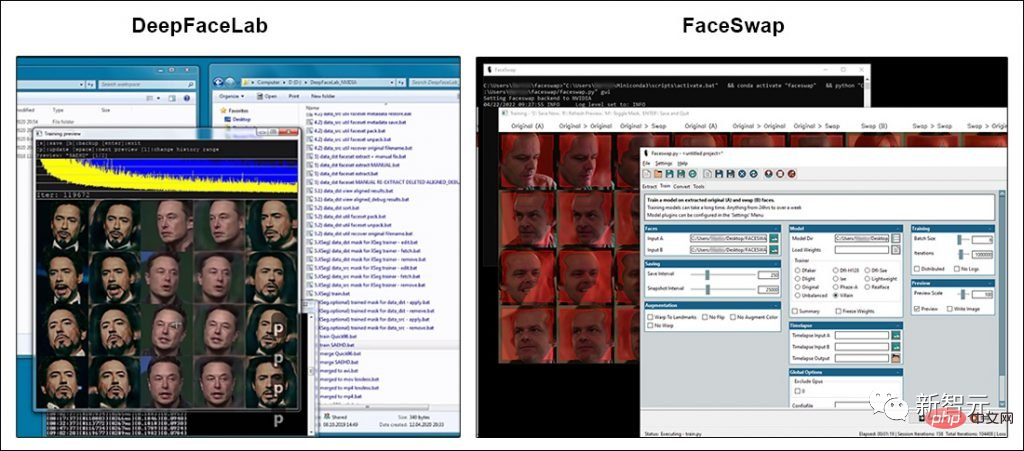

ディープフェイク技術に関する目を引くトピックのほとんどは、ディープフェイクが 2017 年に世間の注目を集めるようになった 2 つのオープンソース ソフトウェア パッケージ、DeepFaceLab (DFL) と FaceSwap に言及しています。

どちらのパッケージにも広範なユーザー ベースと活発な開発者コミュニティがありますが、どちらのプロジェクトも GitHub コードから大きく逸脱していません。

もちろん、DFL と FaceSwap の開発者は怠けているわけではありません。より高価な GPU が必要になりますが、より大きな入力画像を使用してディープフェイク モデルをトレーニングできるようになりました。

#しかし実際には、過去 3 年間でメディアが宣伝したディープフェイクの画質向上は主にエンドユーザーによるものです。

彼らは、データ収集における「時間を節約し、まれな」経験と、モデルをトレーニングするための最良の方法 (1 回の実験に数週間かかる場合もあります) を蓄積し、オリジナルの 2017 年のデータを活用して拡張する方法を学びました。コード。最も外側の制限。

VFX および ML 研究コミュニティの一部は、機械学習モデルを最大 1024×1024 の画像でトレーニングできるようにアーキテクチャを拡張することで、人気のディープフェイク パッケージの「ハード リミット」を突破しようとしています。

ピクセルは、DeepFaceLab または FaceSwap の現在の実際の範囲の 2 倍であり、映画やテレビの制作に役立つ解像度に近くなります。

NeRFについて一緒に学びましょう~

お披露目

2020年に登場したNeRF(Neural Radiance Fields)は、ニューラルネットワークの一種で、物体や環境を再構成する手法です。ネットワーク内の複数の視点からの写真をつなぎ合わせることによって。

入力ビューの疎なセットを使用して基礎となる連続体積シーン関数を最適化することで、複雑なシーン ビューを合成するための最良の結果が得られます。

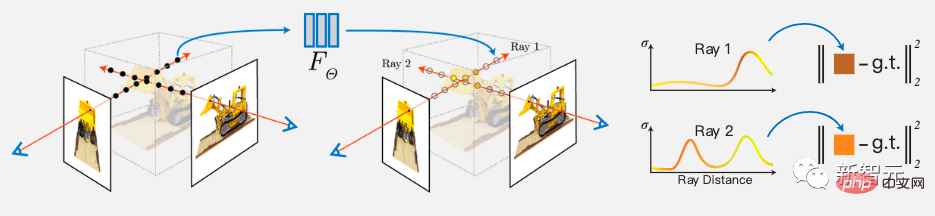

このアルゴリズムでは、完全に接続されたディープ ネットワークも使用してシーンを表現します。その入力は単一の連続 5D 座標 (空間位置 (x、y、z) および視線方向 (θ、φ)) であり、その出力は、空間位置での体積密度と、それに関連する発光振幅の明るさです。

ビューは、カメラ レイに沿って 5D 座標をクエリし、古典的なボリューム レンダリング技術を使用して出力の色と密度を画像に投影することによって合成されます。

実装プロセス:

まず、連続シーンを 5D ベクトル値関数として表します。その入力は、の出力は発光色 c と体積密度 σ です。

実際には、3D デカルト単位ベクトル d が方向を表すために使用されます。この連続 5D シーン表現は MLP ネットワークで近似され、その重みが最適化されます。

さらに、位置 x の関数として体積密度 σ を予測するようにネットワークを制限することで、表現が複数のビューにわたって一貫性を持つように奨励されます。また、位置と視線方向の関数として RGB カラー c を予測できるようになります。 。

これを実現するために、MLP はまず、入力 3D 座標 x を 8 つの完全に接続された層 (ReLU アクティベーションと層ごとに 256 チャネルを使用) で処理し、σ および 256 次元の特徴ベクトルを出力します。

この特徴ベクトルは、カメラ レイの視線方向と連結され、ビューに関連付けられた RGB カラーを出力する完全に接続された追加の層に渡されます。

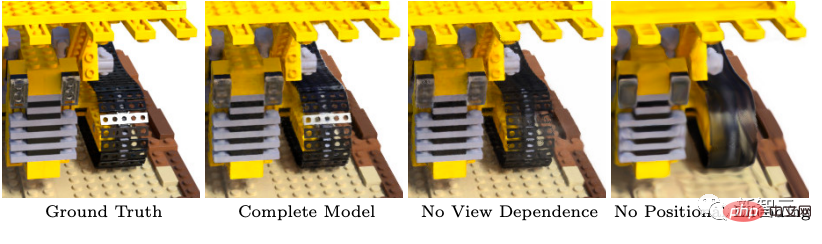

さらに、NeRF では、高解像度の複雑なシーンの表現を実現するために 2 つの改善も導入されています。 1 つ目は、MLP による高周波関数の表現を支援する位置エンコーディングであり、2 つ目は、高周波表現を効率的にサンプリングできるようにする層別サンプリング プロセスです。

ご存知のとおり、Transformer アーキテクチャの位置エンコーディングは、シーケンス内のマークの離散位置をアーキテクチャ全体の入力として提供できます。 NeRF は位置コーディングを使用して連続入力座標を高次元空間にマッピングし、MLP が高周波関数を近似しやすくします。

以上がディープフェイクに代わるものとして期待されていますか?今年最も人気のある NeRF テクノロジーの素晴らしさを明らかにするの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7456

7456

15

15

1376

1376

52

52

77

77

11

11

14

14

10

10

プログラマーに適したAI起業家アイデア

Apr 09, 2024 am 09:01 AM

プログラマーに適したAI起業家アイデア

Apr 09, 2024 am 09:01 AM

皆さんこんにちは、カソンです。プログラマーの友人の多くは、独自の AI 製品の開発に参加したいと考えています。 「プロセスの自動化度」と「AIの適用度」に基づいて、製品形態を4つの象限に分けることができます。その中には、プロセス自動化の度合いは「製品のサービスプロセスのうち、どれだけ手動介入が必要か」を測定し、AI 適用の度合いは「製品における AI アプリケーションの割合」を測定します。まず、AI がサービスを処理する能力を制限します。 AI 画像アプリケーション、およびユーザーはアプリケーションを介してそれを渡します。完全なサービス プロセスは UI と対話することで完了できるため、高度な自動化が実現します。一方で、「AI画像処理」はAIの能力に大きく依存するため、AIの活用度は高い。第 2 象限は、知識管理アプリケーション、時間管理アプリケーション、高度なプロセス自動化などの従来のアプリケーション開発分野です。

家電業界の展望: AI のサポートにより、家全体のインテリジェンスがスマート家電の未来になるでしょうか?

Jun 13, 2023 pm 05:48 PM

家電業界の展望: AI のサポートにより、家全体のインテリジェンスがスマート家電の未来になるでしょうか?

Jun 13, 2023 pm 05:48 PM

人工知能を第 4 次産業革命にたとえると、大型モデルは第 4 次産業革命の食糧備蓄に相当します。アプリケーションレベルでは、業界が 1956 年に米国で開催されたダートマス会議のビジョンを再検討し、世界を再構築するプロセスを正式に開始することができます。 AI家電とは、大手メーカーの定義によれば、相互接続性、人間とコンピュータの相互作用、能動的な意思決定機能を備えた家電であり、スマート家電の最高峰といえる。しかし、現在市場に出ているAIを活用した家全体のスマートモデルは、将来的に業界の主役になれるのでしょうか?家電業界に新たな競争パターンが生まれるのか?この記事ではそれを3つの側面から分析します。なぜ家全体の情報音が雨よりも大きいのでしょうか?出典: Statista、Zhongan.com、iResearch Consulting、Luotu Technology、National Lock Industry Information Center

生成 AI テクノロジーは、製造会社のコスト削減と効率の向上を強力にサポートします。

Nov 21, 2023 am 09:13 AM

生成 AI テクノロジーは、製造会社のコスト削減と効率の向上を強力にサポートします。

Nov 21, 2023 am 09:13 AM

2023 年、生成型人工知能 (Artificial Intelligence Generated Content、略して AIGC) がテクノロジー分野で最もホットなトピックになっているのは間違いありません。製造業にとって、生成型 AI という新興テクノロジーからどのようなメリットを得るべきでしょうか?デジタルトランスフォーメーションを実践している大多数の中小企業は、ここからどのようなインスピレーションを得られるのでしょうか?最近、Amazon Cloud Technology は製造業界の代表者と協力して、中国の製造業の現在の発展傾向、伝統的な製造業のデジタル変革が直面する課題と機会、生成人工知能による製造業の革新的な再構築について話し合いました。 - 製造業における生成型 AI の現在の適用状況についての詳細な議論中国の製造業について言及

Huawei Yu Chengdong氏は「Hongmengは強力な人工知能の大型モデル機能を備えている可能性がある」と述べた

Aug 04, 2023 pm 04:25 PM

Huawei Yu Chengdong氏は「Hongmengは強力な人工知能の大型モデル機能を備えている可能性がある」と述べた

Aug 04, 2023 pm 04:25 PM

ファーウェイのマネージングディレクター、ユー・チェンドン氏は本日、微博にHDCカンファレンスへの招待状を投稿し、HongmengがAI大型モデルの機能を備えている可能性があることを示唆した。彼のフォローアップ Weibo コンテンツによると、招待テキストはスマート音声アシスタント Xiaoyi によって生成されました。 Yu Chengdong氏は、Hongmeng Worldは間もなく、よりスマートでより思いやりのある新しいエクスペリエンスをもたらすだろうと述べ、以前に公開された情報によると、Hongmeng 4は今年AI機能で大幅な進歩を遂げ、Hongmengシステムの中核機能としてAIをさらに強化すると予想されている。

IMAX 中国の AI アート超大作が劇場を古典的なランドマークに移動

Jun 10, 2023 pm 01:03 PM

IMAX 中国の AI アート超大作が劇場を古典的なランドマークに移動

Jun 10, 2023 pm 01:03 PM

IMAX 中国の AI アート超大作が劇場を古典的なランドマークに移動 麗江時報 最近、IMAX は中国初の AI アート超大作を制作し、AI テクノロジーの助けを借りて、IMAX シアターが万里の長城、敦煌、桂林麗江、張掖丹霞に「上陸」しました。この地域には国内の伝統的なランドマークが数多くあります。この AI アート超大作は、IMAX がデジタル アーティスト @kefan404 および NEO Digital と協力して作成したもので、4 つの絵画で構成されています。IMAX の象徴的な超大型スクリーンは、張掖丹霞の色とりどりの自然の「キャンバス」に広がることもあれば、何千年もの歴史を伝えることもできます。豊かな文化遺産を持つ都市、敦煌は、桂林の漓江の風景に溶け込み、あるいは山々に囲まれた雄大な万里の長城を眺めながら、隣り合って建っています。実現するだろう。 2008年より東京にて

AI テクノロジーが反復を加速: 周宏毅の視点から見た大規模モデル戦略

Jun 15, 2023 pm 02:25 PM

AI テクノロジーが反復を加速: 周宏毅の視点から見た大規模モデル戦略

Jun 15, 2023 pm 02:25 PM

今年以来、360 グループの創設者である周宏毅氏は、すべての演説で 1 つのテーマと切り離せないようになりました。それは人工知能の大型モデルです。彼はかつて自分自身を「GPT の伝道者」と呼び、ChatGPT によって達成された画期的な成果を大いに賞賛し、その結果としての AI テクノロジーの反復について断固として楽観的でした。自己表現が得意な著名起業家である周宏儀氏のスピーチは機知に富んだ発言が多いため、彼の「説教」も多くの話題を生み、実際に大型AIモデルの火に油を注ぐことになった。しかし、周宏儀氏にとっては、オピニオンリーダーであるだけでは十分ではなく、外部の世界は彼が経営する会社 360 がこの AI の新たな波にどう対応するかにさらに関心を持っています。実際、360 社内では、周宏毅氏はすでに全従業員を対象とした変革を開始しており、4 月には社内書簡を発行し、360 社の全従業員と全従業員に要請しました。

AI接客代替のメリットが最大限に発揮されるが、需要マッチングと普及には時間がかかる。

Apr 12, 2023 pm 07:34 PM

AI接客代替のメリットが最大限に発揮されるが、需要マッチングと普及には時間がかかる。

Apr 12, 2023 pm 07:34 PM

手動コールセンターの時代から、IVRプロセス設計、オンライン顧客サービスシステムなどの適用を経験し、今日の人工知能(AI)顧客サービスに発展しました。顧客サービス産業は、顧客にサービスを提供する重要な窓口として、常に時代の最前線に立ち、常に新しいテクノロジーを使用して新たな生産性を開発し、高効率、高品質、高サービス、そしてパーソナライズされた全天候型の顧客を目指してきました。サービス。顧客数の増加と人件費の急増に伴い、人工知能やビッグデータなどの新世代情報技術を活用して、さまざまな業界のカスタマーサービスセンターを労働集約型からインテリジェントで洗練されたものへの変革をどのように促進するかテクノロジーの変革とアップグレードは、多くの業界が直面する重要な問題となっています。人工知能テクノロジーの継続的な進歩とシナリオベースのアプリケーションの急速な開発の恩恵を受け、

AI が人類にもたらす最も重要な前向きな意義は、なぜ情報の平等なのでしょうか?未来の物語を探索する

Sep 21, 2023 pm 06:21 PM

AI が人類にもたらす最も重要な前向きな意義は、なぜ情報の平等なのでしょうか?未来の物語を探索する

Sep 21, 2023 pm 06:21 PM

未来のテクノロジーがあふれる世界において、人工知能は人間の生活に欠かせないアシスタントとなっています。しかし、人工知能は私たちの生活を容易にするだけでなく、人間社会の構造と運営を静かな形で変えつつあります。最も重要なプラスの影響の 1 つは、情報の平等によってデジタル ディバイドが解消され、誰もがテクノロジーによってもたらされる利便性を平等に享受できるようになることであり、現在のデジタル時代において、情報化は社会の発展を促進する重要な力となっています。しかし、私たちはまた、デジタルデバイドが存在し、一部の人々がテクノロジーによってもたらされる利便性を享受できないという現実的な問題にも直面しています。したがって、情報化における平等な権利は特に重要であり、情報化格差を解消し、誰もが科学技術の発展の成果を平等に共有し、社会全体の進歩を達成することができます。