テクノロジー周辺機器

テクノロジー周辺機器

AI

AI

「スパースコーディング」は理論から実践へ! Ma Yi 教授の NeurIPS 2022 での新しい研究: スパース畳み込みのパフォーマンスと堅牢性は ResNet を超える

「スパースコーディング」は理論から実践へ! Ma Yi 教授の NeurIPS 2022 での新しい研究: スパース畳み込みのパフォーマンスと堅牢性は ResNet を超える

「スパースコーディング」は理論から実践へ! Ma Yi 教授の NeurIPS 2022 での新しい研究: スパース畳み込みのパフォーマンスと堅牢性は ResNet を超える

ディープ ニューラル ネットワークは画像分類において強力な経験的パフォーマンスを持っていますが、そのようなモデルはしばしば「ブラック ボックス」とみなされ、最も批判されるのは「説明が難しい」という点です。

対照的に、スパース畳み込みモデルは、信号が畳み込みモデルで表現できることを前提とした、自然画像を分析するための強力なツールでもあります。は、畳み込み辞書内のいくつかの要素の線形結合として表現され、良好な 理論的解釈可能性 と 生物学的合理性 を備えています。

しかし、実際のアプリケーションでは、スパース畳み込みモデル 原理的には機能しますが、経験的に設計されたディープ ネットワークと比較すると、期待どおりのパフォーマンスは得られません。パフォーマンス上の利点。

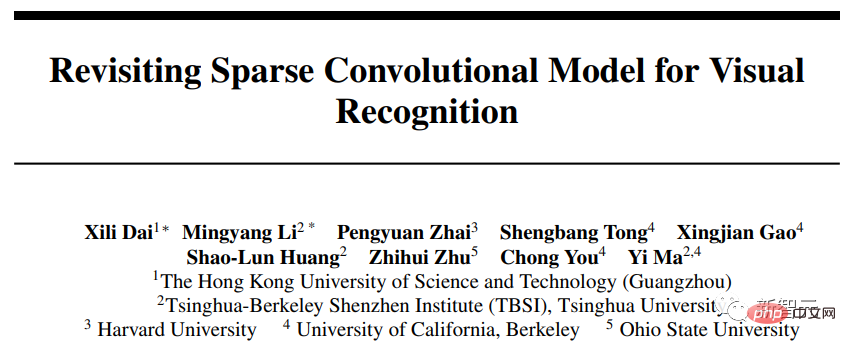

最近、Ma Yi 教授の研究グループ は、NeurIPS 2022 で新しい論文を発表しました。この論文では、画像分類におけるスパース畳み込みモデルの適用と、経験的なデータ間の不一致をレビューしています。スパース畳み込みモデルのパフォーマンスと解釈可能性がうまく解決されました。

#コードリンク: https://github.com/Delay-Xili/SDNet

記事内で提案されていますマイクロ最適化層

は、 畳み込みスパース コーディング (CSC) を使用して、標準の 準畳み込み層を置き換えます。 結果は、従来のニューラル ネットワークと比較して、これらのモデルが CIFAR-10、CIFAR-100、ImageNet データセットに対して同様に強力な経験的パフォーマンスを示していることを示しています。

研究者らは、スパース モデリングの堅牢な回復特性を利用することで、スパース正則化とデータ再構築項の間の単純で適切なトレードオフだけで、これらのモデルが入力に対してより堅牢になることを示しています。汚職と テストにおける敵対的な混乱

。

Ma Yi 教授は、1995 年に清華大学でオートメーションと応用数学の二重学士号を取得し、その後カリフォルニア大学バークレー校で学びました。 、米国、1997年にEECSで修士号、数学の修士号、2000年にEECSで博士号を取得。

卒業後、イリノイ大学アーバナ・シャンペーン校で教鞭をとり、電気・コンピュータ工学科史上最年少の准教授になりました。

2009 年、マイクロソフト リサーチ アジアのビジュアル コンピューティング グループで上級研究員を務めました。 2014 年に上海理工大学情報科学技術学部にフルタイムで入学しました。

2018 年にカリフォルニア大学バークレー校および清華バークレー深セン研究所に入社。現在はカリフォルニア大学バークレー校の電気工学およびコンピューター サイエンス学科の教授を務めています。また、IEEE フェロー、ACM フェロー、および SIAM フェローでもあります

Ma Yi 教授の研究対象には、3D コンピュータ ビジョン、高次元データの低次元モデル、スケーラビリティの最適化、機械学習などがあります。最近の研究テーマには、大規模な 3D 幾何学的再構成、低次元モデルと深層ネットワーク間の相互作用と関係などが含まれます。

スパース畳み込み

深層畳み込みネットワーク (ConvNets) は画像分類の主流の方法となり、パフォーマンスにおいて他のモデルを上回っていますが、その内部コンポーネントの特定のデータの意味は、畳み込み、非線形関数、正規化についてはまだ説明されていません。スパース データ モデリングは、解釈可能な表現を学習する機能と強力な理論的保証 (破損したデータの処理など) アプリケーションによってサポートされ、多くの信号および画像処理で広く使用されてきましたが、その分類はImageNet などのデータセットのパフォーマンスは、経験的なディープ モデルほど優れていません。

強力なパフォーマンスを備えたスパース モデルにも依然として欠陥があります:

1) ネットワーク構造を特別に設計する必要があるため、モデルの適用可能性が制限されます。

2) トレーニングの計算速度は数桁遅くなります;

3) 解釈可能性と堅牢性において明らかな利点は見られません。

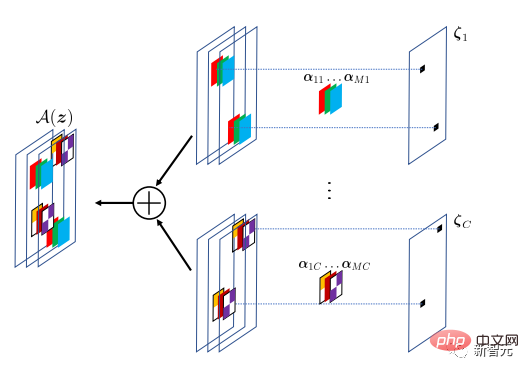

研究者らはこの論文で視覚認識フレームワークを提案し、レイヤー入力がすべてのデータポイントで表現できると仮定して、単純な設計を通じてスパースモデリングをディープラーニングと組み合わせることができることを実証しました。共有辞書内の複数のアトムによって表現され、階層的な解釈可能性と安定性が向上しながら、標準的な ConvNet と同じパフォーマンスを実現します。

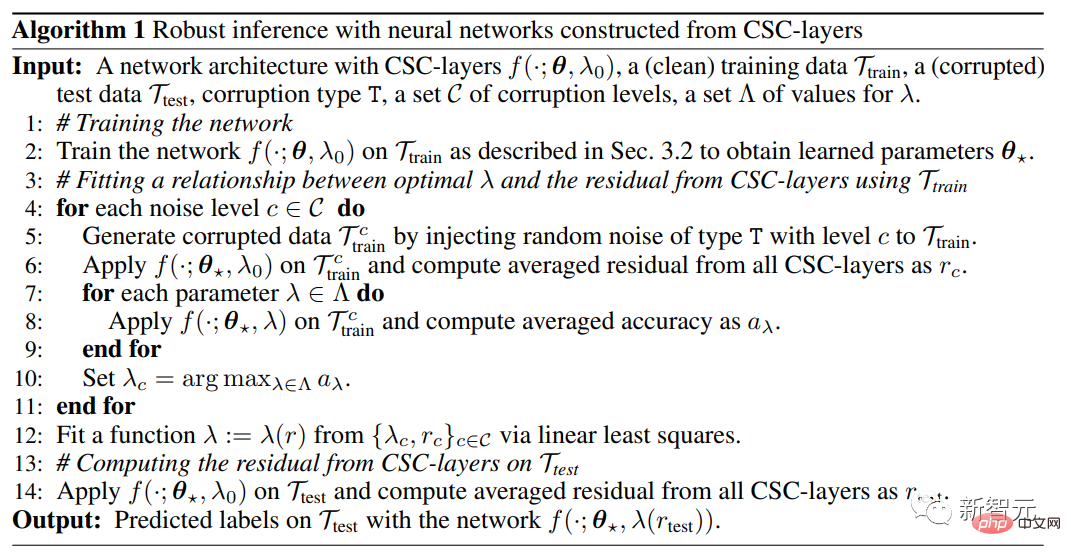

このメソッドは、スパース モデリングを暗黙的層にカプセル化し、それを標準 ConvNet の畳み込み層の代わりとして使用します。

従来の全結合層または畳み込み層で使用される陽的関数と比較して、隠れ層は陰的関数を使用します。この論文の隠れ層は、層の入力パラメータと重みパラメータの最適化問題に基づいて定義され、隠れ層の出力は最適化問題の解になります。

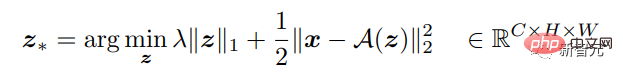

多次元入力信号が与えられた場合、レイヤーの関数は、より適切なスパース出力への逆マッピングを実行するように定義できます。出力チャネルの数は入力とは異なる場合があるため、上記は、Lasso 型の最適化問題に対する最適なスパース解を見つけることができます。

隠れ層は畳み込みスパースコーディング (CSC) モデルを実装しており、入力信号は畳み込み内のアトムのスパース線形結合によって近似されます。辞書 。この畳み込み辞書は、バックプロパゲーションを通じてトレーニングされる CSC 層のパラメーターとみなすことができます。

CSC モデルの目標は、A(z) 演算子を通じて入力信号を再構築することです。ここで、特徴マップ z は畳み込みフィルターを指定します。 A の位置と値。モデリングの違いを許容するために、再構成が正確である必要はありません。

決定された CSC 層の入出力マッピングに基づいて、関連する最適化を解決し、入力 x とパラメーターに対する最適な係数解を導出することで、順伝播を実行できます。 A の勾配はバックプロパゲーションを実行するために使用されます。

CSC 層を備えたネットワーク全体は、クロスエントロピー損失を最小限に抑えることで、ラベル付きデータからエンドツーエンドの方法でトレーニングできます。

#実験結果

#実験結果

分類性能の比較

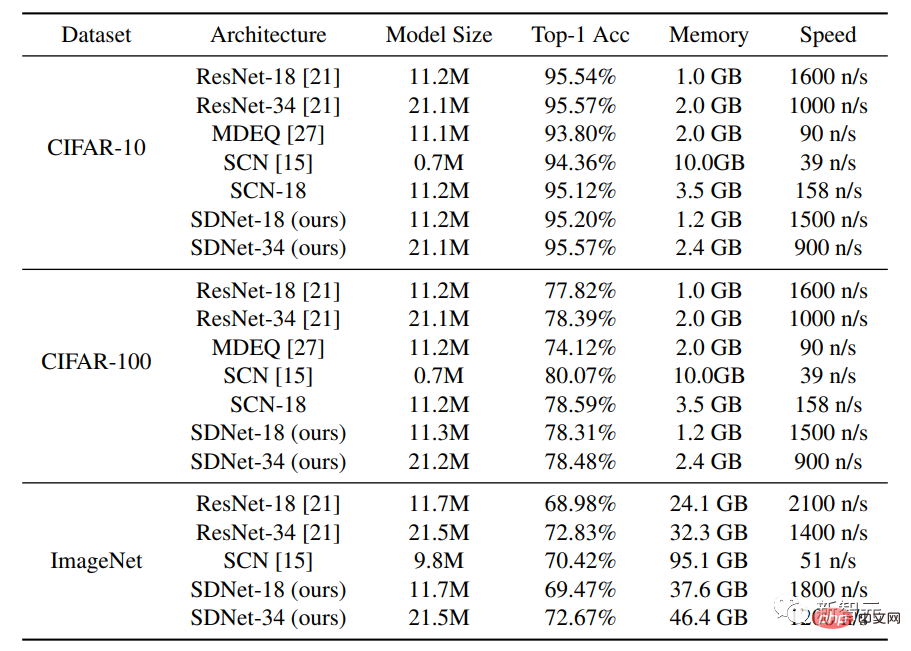

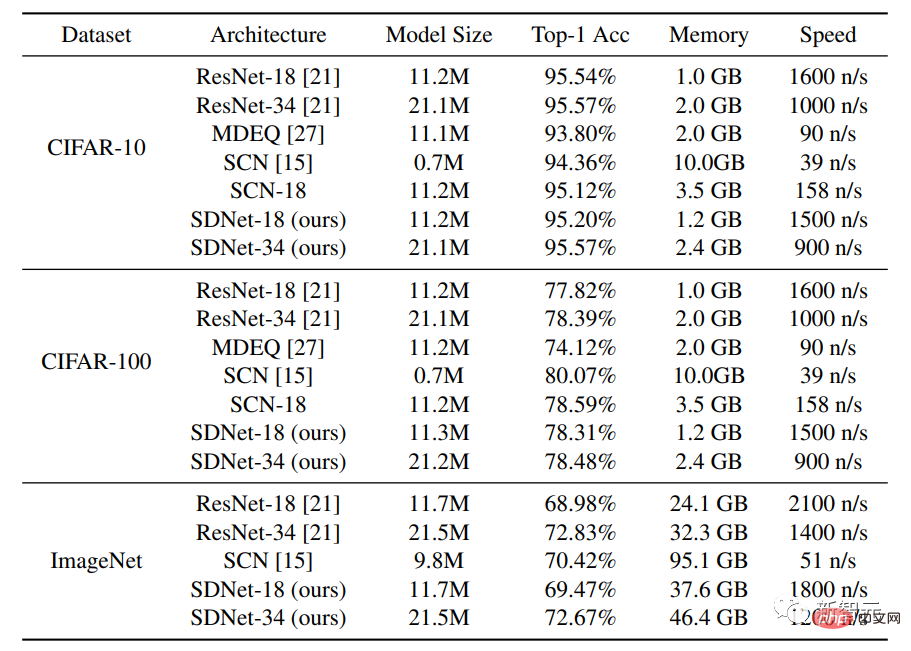

実験で使用したデータ セットは CIFAR-10 と CIFAR-100 です。各データ セットには 50,000 個のトレーニング画像と 10,000 個のテスト画像が含まれています。各画像のサイズは 32 × 32 です、RGBチャンネル。研究者らは、この手法を標準ネットワーク アーキテクチャである ResNet-18 および ResNet-34 と比較することに加えて、隠れ層アーキテクチャを備えた MDEQ モデルおよびスパース アーキテクチャを備えた SCN とも比較しました。アーキテクチャのモデリング、比較。

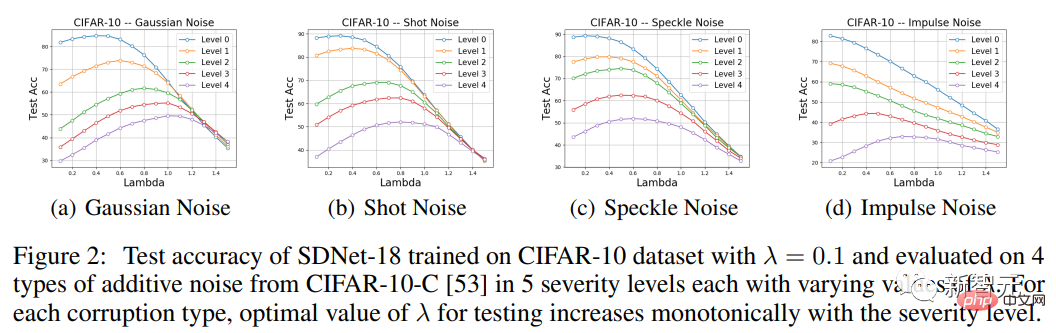

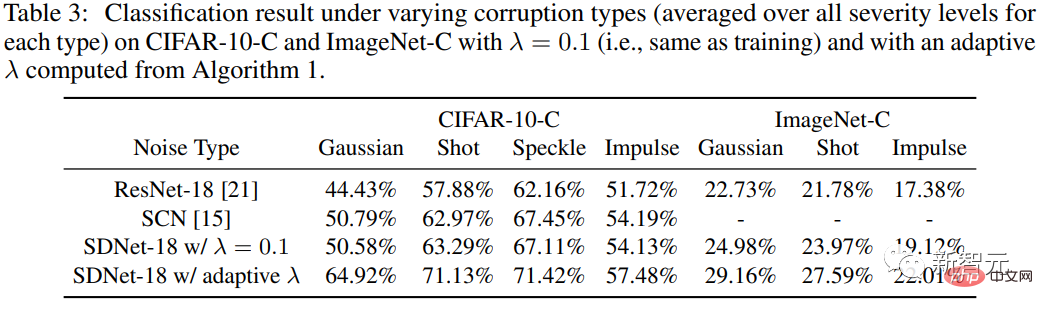

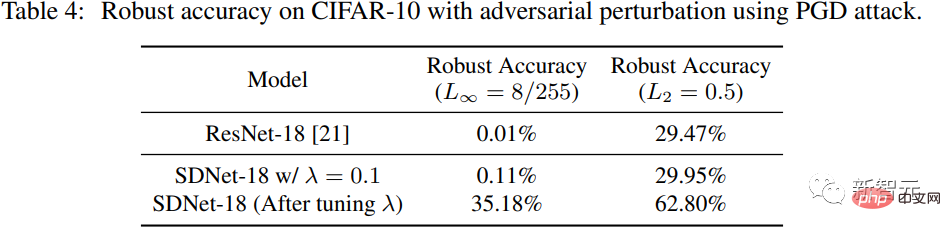

SDNet-18 モデルを同様のモデル サイズの MDEQ モデルと比較すると、SDNet-18 は MDEQ よりも正確であるだけでなく、はるかに高速 (7 倍以上) であることがわかります。 MDEQ は SDNet のように破損したデータを処理できないことに注意してください。 スパース モデリングも使用する SCN ネットワークは、トップ 1 の精度を達成していますが、SCN の重要な欠点は、トレーニング速度が非常に遅いことです。畳み込みスパースコーディングモデルでは、順伝播ごとにさらにスパースコーディングの問題を解決する必要があり、並列計算の恩恵を受けることができません。 ロバスト推論による入力摂動の処理 研究者らは、入力摂動に対するメソッドのロバスト性をテストするために、以下を使用しました。 CIFAR-10-C データセット。さまざまなタイプの合成ノイズとさまざまな重大度によってデータが破損します。 モデルの CSC 層は入力信号と再構成された信号の間のエントリごとの差にペナルティを与えるため、理論的には SDNet が加法性ノイズの処理により適しているはずです。 したがって、実験部分では主に CIFAR-10-C の 4 種類の加法性ノイズ、つまりガウス ノイズ、ショット ノイズ、スペックル ノイズに焦点を当てます。インパルス ノイズを測定し、SDNet-18 の精度を評価し、そのパフォーマンスを ResNet-18 と比較します。 さまざまな種類のノイズとさまざまな重大度 (レベル 0、1、2 のインパルス ノイズを除く) に対して、適切なノイズを選択することがわかります。トレーニング中に使用されたラムダ値とは異なるラムダ値は、テストのパフォーマンスを向上させるのに役立ちます。 具体的には、λ の関数としての精度曲線は単峰性の形状を示し、パフォーマンスは最初に増加し、その後減少します。さらに、各データ破損タイプにおいて、パフォーマンスのピークに達する λ 値は破損の重大度に応じて単調増加しており、これは予想と一致する観察結果です。 敵対的摂動への対処 研究者らは SDNet で PGD を使用しました (λ =0.1) 敵対的摂動を生成します。摂動の L∞ パラダイムは 8/255、摂動の L2 パラダイムは 0.5 です。 ResNet-18 と比較すると、λ=0.1 の場合、SDNet のパフォーマンスはそれほど高くないことがわかります。 ResNet よりも優れていますが、パラメータ λ を調整することでロバスト性の精度を大幅に向上させることができます。

以上が「スパースコーディング」は理論から実践へ! Ma Yi 教授の NeurIPS 2022 での新しい研究: スパース畳み込みのパフォーマンスと堅牢性は ResNet を超えるの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7554

7554

15

15

1382

1382

52

52

83

83

11

11

24

24

96

96

PHP バージョン 5.4 の新機能: 呼び出し可能な型ヒント パラメーターを使用して呼び出し可能な関数またはメソッドを受け入れる方法

Jul 29, 2023 pm 09:19 PM

PHP バージョン 5.4 の新機能: 呼び出し可能な型ヒント パラメーターを使用して呼び出し可能な関数またはメソッドを受け入れる方法

Jul 29, 2023 pm 09:19 PM

PHP5.4 バージョンの新機能: 呼び出し可能な型ヒント パラメーターを使用して呼び出し可能な関数またはメソッドを受け入れる方法 はじめに: PHP5.4 バージョンでは、非常に便利な新機能が導入されています。呼び出し可能な型ヒント パラメーターを使用して、呼び出し可能な関数またはメソッドを受け入れることができます。この新機能により、追加のチェックや変換を行わずに、関数やメソッドで対応する呼び出し可能なパラメーターを直接指定できるようになります。この記事では、呼び出し可能な型ヒントの使用法を紹介し、いくつかのコード例を示します。

製品パラメータとは何を意味しますか?

Jul 05, 2023 am 11:13 AM

製品パラメータとは何を意味しますか?

Jul 05, 2023 am 11:13 AM

製品パラメータは、製品属性の意味を指します。たとえば、衣類のパラメータには、ブランド、素材、モデル、サイズ、スタイル、生地、適用グループ、色などが含まれ、食品のパラメータには、ブランド、重量、素材、保健免許番号、適用グループ、色などが含まれ、家電のパラメータには、家電製品のパラメータが含まれます。ブランド、サイズ、色、原産地、適用可能な電圧、信号、インターフェース、電力などが含まれます。

PHP 警告: in_array() に対する解決策にはパラメーターが必要です

Jun 22, 2023 pm 11:52 PM

PHP 警告: in_array() に対する解決策にはパラメーターが必要です

Jun 22, 2023 pm 11:52 PM

開発プロセス中に、次のようなエラー メッセージが表示される場合があります: PHPWarning: in_array()expectsparameter。このエラー メッセージは、in_array() 関数を使用するときに表示されます。関数のパラメータの受け渡しが正しくないことが原因である可能性があります。このエラー メッセージの解決策を見てみましょう。まず、in_array() 関数の役割を明確にする必要があります。配列に値が存在するかどうかを確認します。この関数のプロトタイプは次のとおりです: in_a

i9-12900Hパラメータ評価リスト

Feb 23, 2024 am 09:25 AM

i9-12900Hパラメータ評価リスト

Feb 23, 2024 am 09:25 AM

i9-12900H は 14 コア プロセッサです。使用されているアーキテクチャとテクノロジはすべて新しく、スレッドも非常に高速です。全体的な動作は優れており、いくつかのパラメータが改善されています。特に包括的で、ユーザーに優れたエクスペリエンスをもたらします。 。 i9-12900H パラメータ評価レビュー: 1. i9-12900H は、q1 アーキテクチャと 24576kb プロセス テクノロジを採用した 14 コア プロセッサで、20 スレッドにアップグレードされています。 2. 最大 CPU 周波数は 1.80! 5.00 ghz で、主にワークロードによって異なります。 3. 価格と比較すると、非常に適しており、価格性能比が非常に優れており、通常の使用が必要な一部のパートナーに非常に適しています。 i9-12900H のパラメータ評価とパフォーマンスの実行スコア

C++ 関数パラメータの型の安全性チェック

Apr 19, 2024 pm 12:00 PM

C++ 関数パラメータの型の安全性チェック

Apr 19, 2024 pm 12:00 PM

C++ パラメーターの型の安全性チェックでは、コンパイル時チェック、実行時チェック、静的アサーションを通じて関数が予期される型の値のみを受け入れるようにし、予期しない動作やプログラムのクラッシュを防ぎます。 コンパイル時の型チェック: コンパイラは型の互換性をチェックします。実行時の型チェック:dynamic_cast を使用して型の互換性をチェックし、一致しない場合は例外をスローします。静的アサーション: コンパイル時に型条件をアサートします。

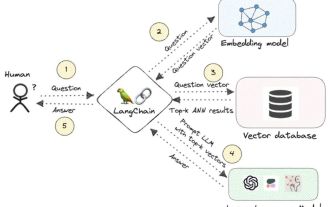

ナレッジ グラフ: 大規模モデルの理想的なパートナー

Jan 29, 2024 am 09:21 AM

ナレッジ グラフ: 大規模モデルの理想的なパートナー

Jan 29, 2024 am 09:21 AM

大規模言語モデル (LLM) は、滑らかで一貫したテキストを生成する機能を備えており、人工知能の会話や創造的な文章などの分野に新たな可能性をもたらします。ただし、LLM にはいくつかの重要な制限もあります。まず、彼らの知識はトレーニング データから認識されたパターンに限定されており、世界に対する真の理解が欠けています。第 2 に、推論スキルには限界があり、論理的な推論を行ったり、複数のデータ ソースからの事実を融合したりすることができません。より複雑で自由回答の質問に直面すると、LLM の答えは「幻想」として知られる不条理または矛盾したものになる場合があります。したがって、LLM はいくつかの面では非常に便利ですが、複雑な問題や現実世界の状況を扱う場合には、依然として一定の制限があります。これらのギャップを埋めるために、検索拡張生成 (RAG) システムが近年登場しました。

いくつかの一般的なエンコード方法

Oct 24, 2023 am 10:09 AM

いくつかの一般的なエンコード方法

Oct 24, 2023 am 10:09 AM

一般的なエンコード方法には、ASCII エンコード、Unicode エンコード、UTF-8 エンコード、UTF-16 エンコード、GBK エンコードなどがあります。詳細な紹介: 1. ASCII エンコードは、英語の文字、数字、句読点、制御文字などを含む 128 文字を表すために 7 ビット 2 進数を使用する、最も初期の文字エンコード標準です; 2. Unicode エンコードは、文字を表すために使用される方法です。世界中のすべての文字 各文字に固有のデジタル コード ポイントを割り当てる文字の標準的なエンコード方式、3. UTF-8 エンコードなど。

指定された値を引数として受け取る逆双曲線正弦関数の値を見つける C++ プログラム

Sep 17, 2023 am 10:49 AM

指定された値を引数として受け取る逆双曲線正弦関数の値を見つける C++ プログラム

Sep 17, 2023 am 10:49 AM

双曲線関数は、円の代わりに双曲線を使用して定義され、通常の三角関数と同等です。ラジアン単位で指定された角度から双曲線正弦関数の比率パラメーターを返します。しかし、その逆、つまり別の言い方をすればいいのです。双曲線正弦から角度を計算したい場合は、双曲線逆正弦演算のような逆双曲線三角関数演算が必要です。このコースでは、C++ で双曲線逆サイン (asinh) 関数を使用し、ラジアン単位の双曲線サイン値を使用して角度を計算する方法を説明します。双曲線逆正弦演算は次の式に従います -$$\mathrm{sinh^{-1}x\:=\:In(x\:+\:\sqrt{x^2\:+\:1})}ここで\:In\:is\:自然対数\:(log_e\:k)