上海で家を借りるために、Python を使用して 20,000 件以上の住宅情報を一晩で調べました。

最近、急な仕事の変更により、新しいオフィスの場所が現在の住居から遠方になったため、新しい家を借りることになりました。

私は代理店の eMule に乗って、街の奇妙な場所を探索し始めました。

さまざまなレンタルアプリを切り替える過程で、効率が非常に低いため、非常に心配しました。

まず第一に、私は一緒に住んでいるからです。私のガールフレンド 一緒に、2 人は同時に職場までの距離を考慮する必要がありますが、各プラットフォームの通勤時間に基づいて家を検索する機能は比較的役に立ちません。一部のプラットフォームは同時に複数の場所の選択をサポートしていません。また、プラットフォームによっては各拠点からの通勤距離を機械的にしか取得できないため、同じ継続時間の地点では利用ニーズに応えられません。

第二に、賃貸人の観点から見ると、賃貸プラットフォームが多すぎて、各プラットフォームのフィルタリングと並べ替えロジックが一貫していないため、類似した物件の情報を水平的に比較することが困難です。

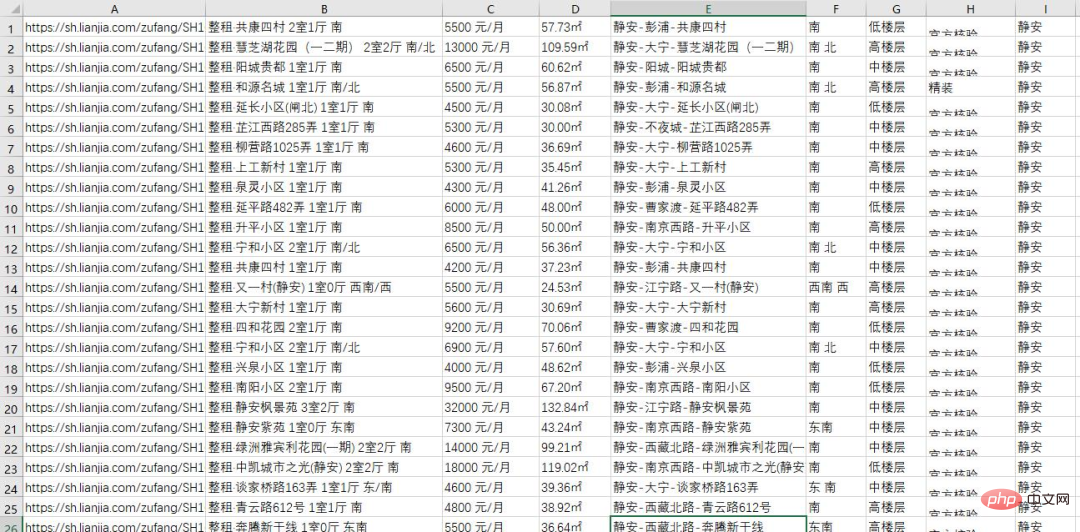

でも、それは問題ではありません。プログラマーとして、問題を解決するにはプログラマーの方法を使用する必要があります。そこで、昨夜、Python スクリプトを使用して、上海エリアの賃貸プラットフォームのすべての住宅情報を取得しました。合計 20,000 件以上ありました。はクロール データです。プロセス全体が全員と共有されます。

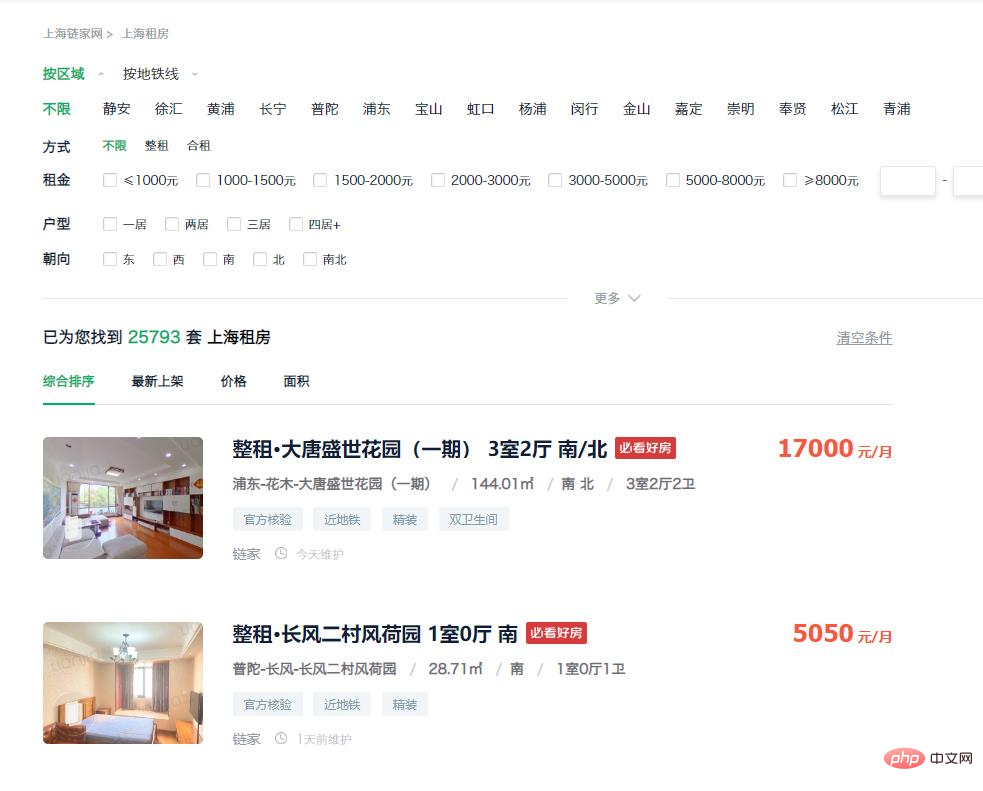

ページを分析してエントリ ポイントを見つける

https://sh.lianjia.com/zufang/

#次のステップは、URL を取得する方法を検討することです。観察の結果、この地域には2万戸以上の住宅が存在することが判明しましたが、ウェブページからアクセスできるデータは最初の100ページまでであり、各ページに表示される件数の上限は30件です。合計3k、全ての情報を取得することは不可能です。

https://sh.lianjia.com/zufang/jingan/

https://sh.lianjia.com/zufang/jingan/pg2/

しかし、ここで問題が発生し、同じページ数を訪問するたびに取得されるデータが異なるため、収集されるデータが重複してしまいます。そこで、並べ替え条件の「棚にある最新」をクリックして、次のリンクを入力します:

しかし、ここで問題が発生し、同じページ数を訪問するたびに取得されるデータが異なるため、収集されるデータが重複してしまいます。そこで、並べ替え条件の「棚にある最新」をクリックして、次のリンクを入力します:

https://sh.lianjia.com/zufang/jingan/pg2rco11/

この並べ替え方法で得られるデータの順序は安定しています。この時点で、私たちの考え方は次のとおりです。小さな領域の最初のページを個別に取得し、最初のページまでの現在の領域の最大ページ数を取得し、各ページにアクセスしてすべてのデータを取得するシミュレートされたリクエストにアクセスします。

データのクローリング

アイデアを思いついた後、コードを書き始める必要があります。まず、すべてのリンクを収集する必要があります。コードは次のとおりです:

# 所有小地区对应的标识

list=['jingan','xuhui','huangpu','changning','putuo','pudong','baoshan','hongkou','yangpu','minhang','jinshan','jiading','chongming','fengxian','songjiang','qingpu']

# 存放所有链接

urls = []

for a in list:

urls.append('https://sh.lianjia.com/zufang/{}/pg1rco11/'.format(a))

# 设置请求头,避免ip被ban

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/81.0.4044.9 Safari/537.36'}

# 获取当前小地区第1页的dom信息

res = requests.get('https://sh.lianjia.com/zufang/{}/pg1rco11/'.format(a), headers=headers)

content = res.text

soup = BeautifulSoup(content, 'html.parser')

# 获取当前页面的最大页数

page_num = int(soup.find('div', attrs={'class': 'content__pg'}).attrs['data-totalpage'])

for i in range(2,page_num+1):

# 将所有链接保存到urls中

urls.append('https://sh.lianjia.com/zufang/{}/pg{}rco11/'.format(a,i))その後は、一つずつ行う必要があります 前のステップで取得した URL を処理して、リンク内のデータを取得します コードは次のとおりです:

num=1

for url in urls:

print("正在处理第{}页数据...".format(str(num)))

res1 = requests.get(url, headers=headers)

content1 = res1.text

soup1 = BeautifulSoup(content1, 'html.parser')

infos = soup1.find('div', {'class': 'content__list'}).find_all('div', {'class': 'content__list--item'})データを整理してファイルをエクスポート

ページ構造を観察することで、各要素の保存場所を取得し、対応するページ要素を見つけて、必要な情報を取得できます。

完全なコードはここに添付されています。興味のある友人は、必要に応じてリンク内の地域識別子と小さな地域識別子を置き換えて、独自の情報を取得できます。あなたの地域について。他のレンタルプラットフォームのクローリング方法はほとんど同様であるため、詳細は説明しません。import time, re, csv, requests

import codecs

from bs4 import BeautifulSoup

print("****处理开始****")

with open(r'..sh.csv', 'wb+')as fp:

fp.write(codecs.BOM_UTF8)

f = open(r'..sh.csv','w+',newline='', encoding='utf-8')

writer = csv.writer(f)

urls = []

# 所有小地区对应的标识

list=['jingan','xuhui','huangpu','changning','putuo','pudong','baoshan','hongkou','yangpu','minhang','jinshan','jiading','chongming','fengxian','songjiang','qingpu']

# 存放所有链接

urls = []

for a in list:

urls.append('https://sh.lianjia.com/zufang/{}/pg1rco11/'.format(a))

# 设置请求头,避免ip被ban

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/81.0.4044.9 Safari/537.36'}

# 获取当前小地区第1页的dom信息

res = requests.get('https://sh.lianjia.com/zufang/{}/pg1rco11/'.format(a), headers=headers)

content = res.text

soup = BeautifulSoup(content, 'html.parser')

# 获取当前页面的最大页数

page_num = int(soup.find('div', attrs={'class': 'content__pg'}).attrs['data-totalpage'])

for i in range(2,page_num+1):

# 将所有链接保存到urls中

urls.append('https://sh.lianjia.com/zufang/{}/pg{}rco11/'.format(a,i))

num=1

for url in urls:

# 模拟请求

print("正在处理第{}页数据...".format(str(num)))

res1 = requests.get(url, headers=headers)

content1 = res1.text

soup1 = BeautifulSoup(content1, 'html.parser')

# 读取页面中数据

infos = soup1.find('div', {'class': 'content__list'}).find_all('div', {'class': 'content__list--item'})

# 数据处理

for info in infos:

house_url = 'https://sh.lianjia.com' + info.a['href']

title = info.find('p', {'class': 'content__list--item--title'}).find('a').get_text().strip()

group = title.split()[0][3:]

price = info.find('span', {'class': 'content__list--item-price'}).get_text()

tag = info.find('p', {'class': 'content__list--item--bottom oneline'}).get_text()

mixed = info.find('p', {'class': 'content__list--item--des'}).get_text()

mix = re.split(r'/', mixed)

address = mix[0].strip()

area = mix[1].strip()

door_orientation = mix[2].strip()

style = mix[-1].strip()

region = re.split(r'-', address)[0]

writer.writerow((house_url, title, group, price, area, address, door_orientation, style, tag, region))

time.sleep(0)

print("第{}页数据处理完毕,共{}条数据。".format(str(num), len(infos)))

num+=1

f.close()

print("****全部完成****")以上が上海で家を借りるために、Python を使用して 20,000 件以上の住宅情報を一晩で調べました。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7488

7488

15

15

1377

1377

52

52

77

77

11

11

19

19

40

40

mysqlは支払う必要がありますか

Apr 08, 2025 pm 05:36 PM

mysqlは支払う必要がありますか

Apr 08, 2025 pm 05:36 PM

MySQLには、無料のコミュニティバージョンと有料エンタープライズバージョンがあります。コミュニティバージョンは無料で使用および変更できますが、サポートは制限されており、安定性要件が低く、技術的な能力が強いアプリケーションに適しています。 Enterprise Editionは、安定した信頼性の高い高性能データベースを必要とするアプリケーションに対する包括的な商業サポートを提供し、サポートの支払いを喜んでいます。バージョンを選択する際に考慮される要因には、アプリケーションの重要性、予算編成、技術スキルが含まれます。完璧なオプションはなく、最も適切なオプションのみであり、特定の状況に応じて慎重に選択する必要があります。

インストール後にMySQLの使用方法

Apr 08, 2025 am 11:48 AM

インストール後にMySQLの使用方法

Apr 08, 2025 am 11:48 AM

この記事では、MySQLデータベースの操作を紹介します。まず、MySQLWorkBenchやコマンドラインクライアントなど、MySQLクライアントをインストールする必要があります。 1. mysql-uroot-pコマンドを使用してサーバーに接続し、ルートアカウントパスワードでログインします。 2。CreatedAtaBaseを使用してデータベースを作成し、データベースを選択します。 3. createTableを使用してテーブルを作成し、フィールドとデータ型を定義します。 4. INSERTINTOを使用してデータを挿入し、データをクエリし、更新することでデータを更新し、削除してデータを削除します。これらの手順を習得することによってのみ、一般的な問題に対処することを学び、データベースのパフォーマンスを最適化することでMySQLを効率的に使用できます。

mysqlはインターネットが必要ですか?

Apr 08, 2025 pm 02:18 PM

mysqlはインターネットが必要ですか?

Apr 08, 2025 pm 02:18 PM

MySQLは、基本的なデータストレージと管理のためにネットワーク接続なしで実行できます。ただし、他のシステムとのやり取り、リモートアクセス、または複製やクラスタリングなどの高度な機能を使用するには、ネットワーク接続が必要です。さらに、セキュリティ対策(ファイアウォールなど)、パフォーマンスの最適化(適切なネットワーク接続を選択)、およびデータバックアップは、インターネットに接続するために重要です。

高負荷アプリケーションのMySQLパフォーマンスを最適化する方法は?

Apr 08, 2025 pm 06:03 PM

高負荷アプリケーションのMySQLパフォーマンスを最適化する方法は?

Apr 08, 2025 pm 06:03 PM

MySQLデータベースパフォーマンス最適化ガイドリソース集約型アプリケーションでは、MySQLデータベースが重要な役割を果たし、大規模なトランザクションの管理を担当しています。ただし、アプリケーションのスケールが拡大すると、データベースパフォーマンスのボトルネックが制約になることがよくあります。この記事では、一連の効果的なMySQLパフォーマンス最適化戦略を検討して、アプリケーションが高負荷の下で効率的で応答性の高いままであることを保証します。実際のケースを組み合わせて、インデックス作成、クエリ最適化、データベース設計、キャッシュなどの詳細な主要なテクノロジーを説明します。 1.データベースアーキテクチャの設計と最適化されたデータベースアーキテクチャは、MySQLパフォーマンスの最適化の基礎です。いくつかのコア原則は次のとおりです。適切なデータ型を選択し、ニーズを満たす最小のデータ型を選択すると、ストレージスペースを節約するだけでなく、データ処理速度を向上させることもできます。

hadidb:pythonの軽量で水平方向にスケーラブルなデータベース

Apr 08, 2025 pm 06:12 PM

hadidb:pythonの軽量で水平方向にスケーラブルなデータベース

Apr 08, 2025 pm 06:12 PM

hadidb:軽量で高レベルのスケーラブルなPythonデータベースHadIDB(HadIDB)は、Pythonで記述された軽量データベースで、スケーラビリティが高くなっています。 PIPインストールを使用してHADIDBをインストールする:PIPINSTALLHADIDBユーザー管理CREATEユーザー:CREATEUSER()メソッド新しいユーザーを作成します。 Authentication()メソッドは、ユーザーのIDを認証します。 fromhadidb.operationimportuseruser_obj = user( "admin"、 "admin")user_obj。

MongoDBデータベースパスワードを表示するNAVICATの方法

Apr 08, 2025 pm 09:39 PM

MongoDBデータベースパスワードを表示するNAVICATの方法

Apr 08, 2025 pm 09:39 PM

Hash値として保存されているため、Navicatを介してMongoDBパスワードを直接表示することは不可能です。紛失したパスワードを取得する方法:1。パスワードのリセット。 2。構成ファイルを確認します(ハッシュ値が含まれる場合があります)。 3.コードを確認します(パスワードをハードコードできます)。

MySQLワークベンチはMariadBに接続できますか

Apr 08, 2025 pm 02:33 PM

MySQLワークベンチはMariadBに接続できますか

Apr 08, 2025 pm 02:33 PM

MySQLワークベンチは、構成が正しい場合、MariadBに接続できます。最初にコネクタタイプとして「mariadb」を選択します。接続構成では、ホスト、ポート、ユーザー、パスワード、およびデータベースを正しく設定します。接続をテストするときは、ユーザー名とパスワードが正しいかどうか、ポート番号が正しいかどうか、ファイアウォールが接続を許可するかどうか、データベースが存在するかどうか、MariadBサービスが開始されていることを確認してください。高度な使用法では、接続プーリングテクノロジーを使用してパフォーマンスを最適化します。一般的なエラーには、不十分な権限、ネットワーク接続の問題などが含まれます。エラーをデバッグするときは、エラー情報を慎重に分析し、デバッグツールを使用します。ネットワーク構成を最適化すると、パフォーマンスが向上する可能性があります

MySQLにはサーバーが必要ですか

Apr 08, 2025 pm 02:12 PM

MySQLにはサーバーが必要ですか

Apr 08, 2025 pm 02:12 PM

生産環境の場合、パフォーマンス、信頼性、セキュリティ、スケーラビリティなどの理由により、通常、MySQLを実行するためにサーバーが必要です。サーバーには通常、より強力なハードウェア、冗長構成、より厳しいセキュリティ対策があります。小規模で低負荷のアプリケーションの場合、MySQLはローカルマシンで実行できますが、リソースの消費、セキュリティリスク、メンテナンスコストを慎重に考慮する必要があります。信頼性とセキュリティを高めるには、MySQLをクラウドまたは他のサーバーに展開する必要があります。適切なサーバー構成を選択するには、アプリケーションの負荷とデータボリュームに基づいて評価が必要です。