テクノロジー周辺機器

テクノロジー周辺機器

AI

AI

国内の ChatGPT の展開には 6G のビデオ メモリのみが必要です。 ChatYuan モデルはダウンロード可能です: 業界初の機能的対話オープンソースの中国語大規模モデル

国内の ChatGPT の展開には 6G のビデオ メモリのみが必要です。 ChatYuan モデルはダウンロード可能です: 業界初の機能的対話オープンソースの中国語大規模モデル

国内の ChatGPT の展開には 6G のビデオ メモリのみが必要です。 ChatYuan モデルはダウンロード可能です: 業界初の機能的対話オープンソースの中国語大規模モデル

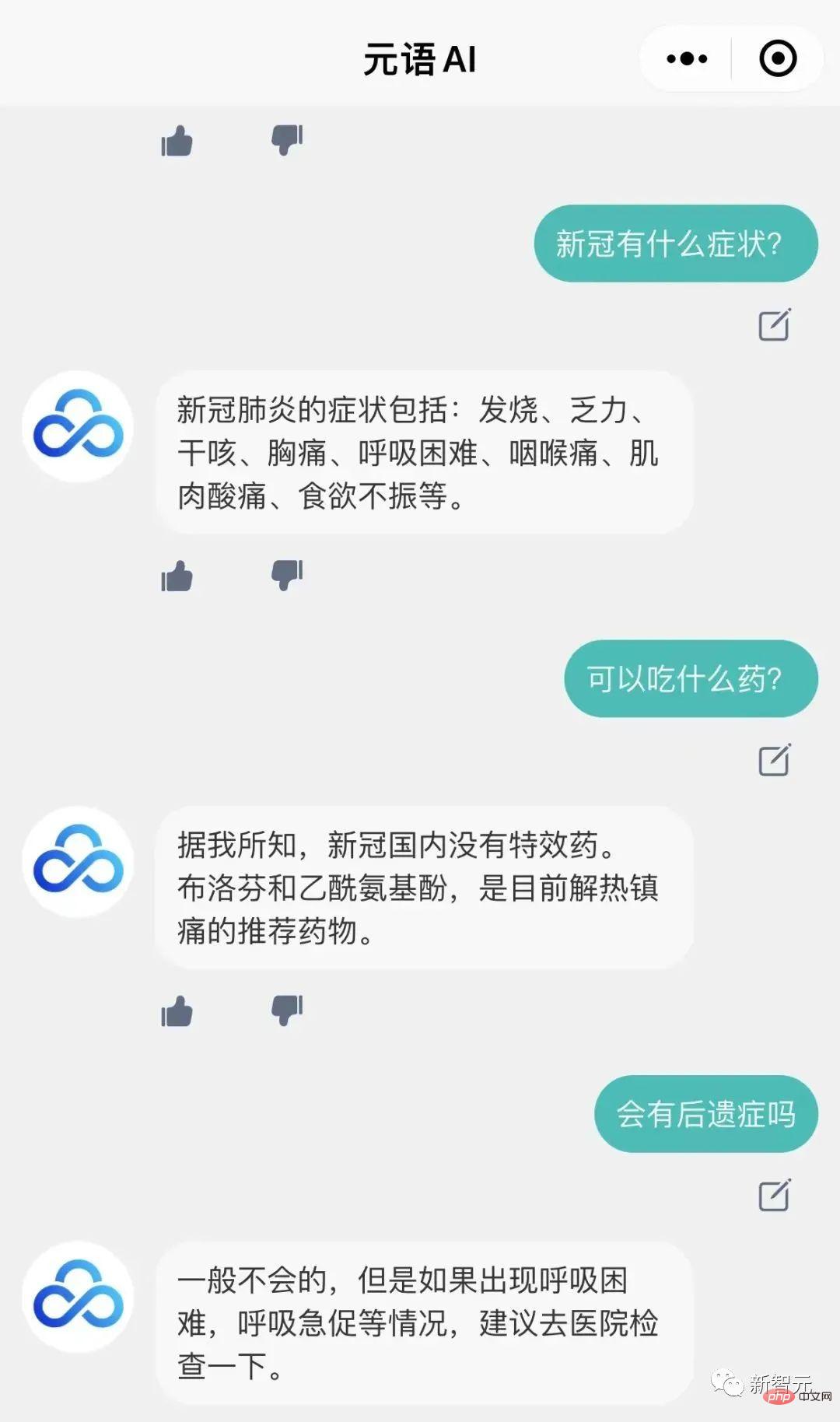

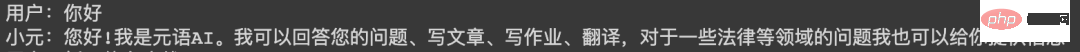

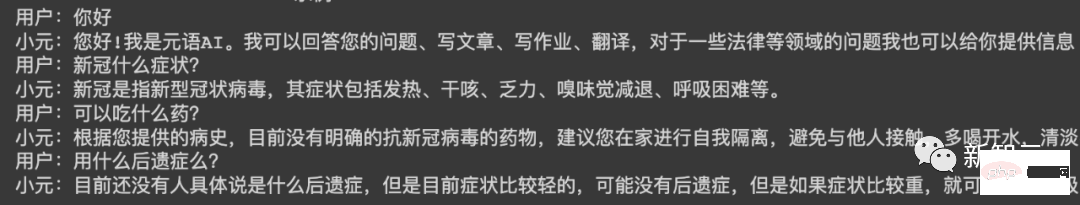

少し前に、Yuanyu インテリジェント開発チームは、ChatGPT に似た 機能対話大型モデル ChatYuan をトレーニングし、Web バージョンでトライアル インターフェイスをオープンしました。

ChatYuan を自分のマシンにデプロイできるようになりました。

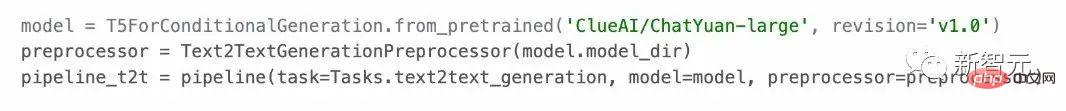

#モデルは質疑応答のシナリオで使用でき、コンテキストに基づいて対話やさまざまな生成タスクを実行できます。クリエイティブライティングを含む、法律や新型コロナウイルス感染症などの分野の質問にも答えることができます。

また、すべての中国語タスクでゼロサンプル学習をサポートしています。ユーザーはプロンプトを提供することで使用できます。テキスト生成、情報抽出、理解のカテゴリで約 30 種類の中国語タスクをサポートしています。 . .

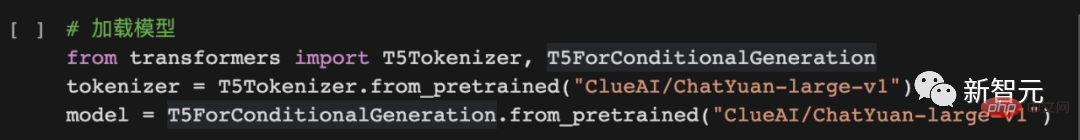

ChatYuan は、PromptCLUE-large に基づいてさらにトレーニングされており、数億の機能的な質問と回答、およびマルチラウンドの対話データが組み合わされています。モデル パラメータは 7 億 7,000 万、ビデオ メモリは約6G に対応し、民間のグラフィック カードをロードして使用することができます。このモデルは現在ダウンロード可能です。

PromptCLUE は、1,000 億トークンの中国語コーパスで事前トレーニングされ、合計 1 兆 5,000 億の中国語トークンを学習し、数百のタスクについて Prompt タスクベースのトレーニングを実施しました。

分類、センチメント分析、抽出などの理解タスクではラベル システムをカスタマイズでき、さまざまな生成タスクではサンプリングを自由に生成できます。

使用方法1. Github

##プロジェクト アドレス: https://github.com/clue-ai/ChatYuan

2.Huggingface

プロジェクト アドレス: https://modelscope.cn/models/ClueAI/ChatYuan -large

プロジェクト アドレス: https://modelscope.cn/models/ClueAI/ChatYuan -large

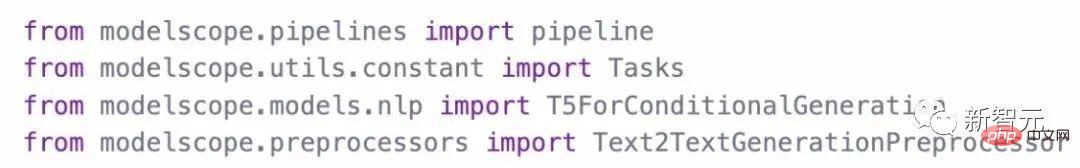

モデルの読み込み:

モデルの使用予測推論方法:

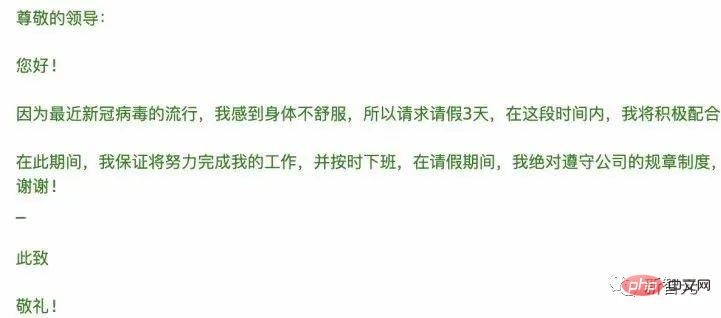

##4. PaddlePaddle

##プロジェクトアドレス:

https://aistudio.baidu.com /aistudio/projectdetail/ 5404182

モデルアドレス: https://huggingface.co/ClueAI/ChatYuan-large-v1-paddle

以降使用モデルをトレーニングするためのデータを用意する

1. データを整理する

データを 2 つの形式で構成される統一フォーマットに整理します。部分: 入力 (Input) と出力 (Output)。

1 回の質問と回答または生成の場合:

入力: タスクの説明の入力テキスト

出力: システムが予測する必要があるテキスト (以下の図の「Xiaoyuan」の後の内容など)。

#複数ラウンドのダイアログの場合:

#入力: タスクの説明の上にテキストを入力します出力: システムが予測する必要があるテキスト (下図の「Xiaoyuan」の後の内容など)。

#シングルラウンドダイアログのデータ形式:

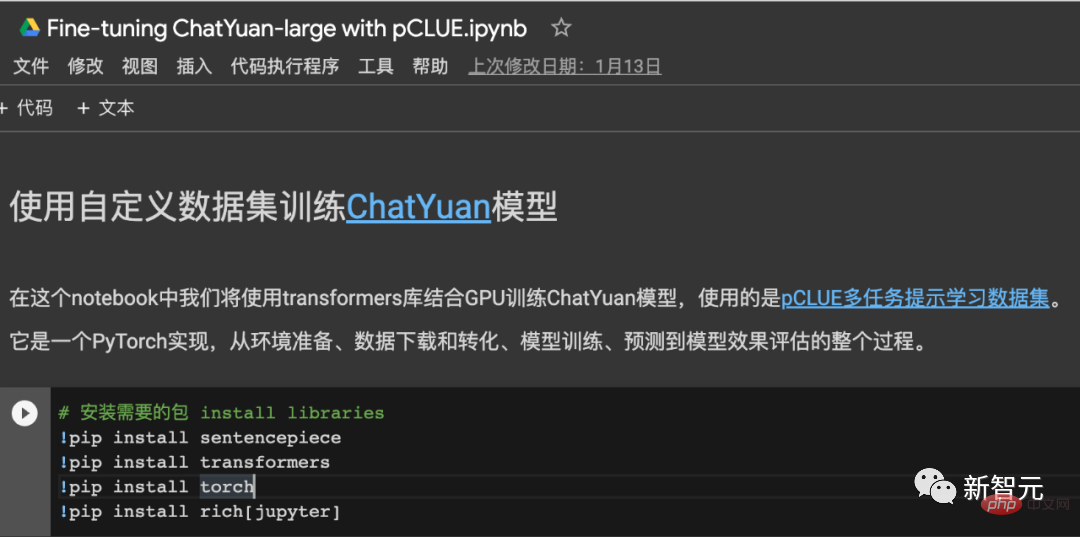

トレーニング コードについては、次を参照してください:

トレーニングに pCLUE データ セットを使用する予測と効果検証、pytorch実装 - オンラインcolab。

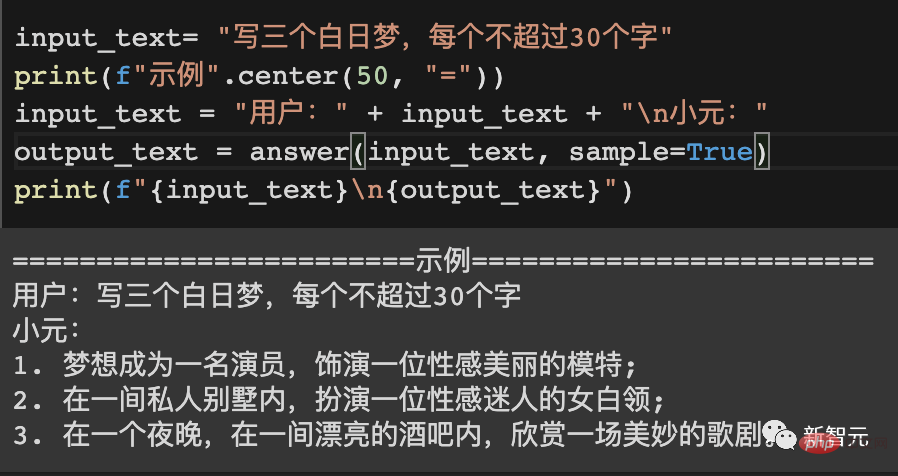

例

==========例1======= = ==

#ユーザー:

何ができますか

#シャオユアン:

こんにちは!私はAIユアンユです。あなたの質問に答えたり、記事を書いたり、課題を書いたり、翻訳したり、法律やその他の分野の問題に関する情報を提供したりできます。

#==========例 2=========

##ユーザー:

#冬について詩を書いてください

シャオ ユアン:

冬の夜は静かで寒い、空には雲が浮かんでいる、

凍った白い雪

雪のように冷たい。

雪は溶けて氷になる、

雪の結晶が降るように、

寒い冬に,

春の喜びを感じてください。

冬になると、

風と雪が徐々に静まり、

静寂が訪れました。 ,

幸せと暖かさを家にもたらします。

#==========例 3=========

##ユーザー:

# 幼児教育専攻のインターンシップ中に学生とのトラブルが発生する場合がありますので、改善策を提案してください。 800 ワード

シャオ ユアン:

幼児教育専攻のインターンシップでは、学生といくつかの問題が発生します。学生の専門知識の不足、協調性の欠如、基本的な責任感の欠如など、これらの問題を解決するための対策を講じる必要があります。まず、インターンシップのプロセス中に、学生のチーム意識を養い、学生と教師の間の協力を強化し、保護者とのコミュニケーションを強化し、コミュニケーションスキルを向上させる必要があります。また、生徒の自主性を強化し、生徒が自ら考える力を身につけさせ、教師や保護者とのコミュニケーションを身につけ、自主性を養うことも必要です。

また、学生がより社会と触れ合い、より多くの社会活動に参加し、自らの学びを深められるよう、日々の業務においても学生に適切な機会や機会を提供しなければなりません。社会と学校への理解、彼らの自発性、積極的かつ革新的な精神を理解し、育成します。

最後に、インターンシップ中に学生が抱える問題、特に学生の協力の欠如、依存、共有方法がわからない、先延ばしなどにも注意を払う必要があります。これらの問題を改善するために合理的な改善策を講じます。

テクノロジーとトレーニング プロセス

ChatYuan は、PromptCLUE に基づいてさらにトレーニングされて得られたモデルです。テキストの理解と情報抽出のタスクが削除され、質問と回答、対話、およびさまざまな生成タスクの学習とトレーニングが強化されます。干渉防止データの追加により、必要に応じてモデルが無関係なコンテキストを無視できるようになります。ユーザーのフィードバックからの学習が追加されます。データにより、モデルは特定の一般的な言語理解機能と特定のタスクの生成機能を備えるだけでなく、ユーザーの意図によりよく応答できるようになります。#PromptCLUE の学習プロセス

# 現在のバージョンでは、質疑応答や対話、さまざまなクリエイティブライティングやテキスト生成が可能ですが、オンライン版と比較して意図理解・生成機能は依然として充実しています。状況によっては改善の余地が多く、推論や複雑なタスクをうまく実行できないこともあります。既存のバージョンはフィードバックに基づいてさらに改善されます。

フォローアップ

以上が国内の ChatGPT の展開には 6G のビデオ メモリのみが必要です。 ChatYuan モデルはダウンロード可能です: 業界初の機能的対話オープンソースの中国語大規模モデルの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7360

7360

15

15

1628

1628

14

14

1353

1353

52

52

1265

1265

25

25

1214

1214

29

29

オープンソースの無料画像注釈ツールおすすめ 15 選

Mar 28, 2024 pm 01:21 PM

オープンソースの無料画像注釈ツールおすすめ 15 選

Mar 28, 2024 pm 01:21 PM

画像の注釈は、ラベルまたは説明情報を画像に関連付けて、画像の内容に深い意味と説明を与えるプロセスです。このプロセスは機械学習にとって重要であり、画像内の個々の要素をより正確に識別するために視覚モデルをトレーニングするのに役立ちます。画像に注釈を追加することで、コンピュータは画像の背後にあるセマンティクスとコンテキストを理解できるため、画像の内容を理解して分析する能力が向上します。画像アノテーションは、コンピュータ ビジョン、自然言語処理、グラフ ビジョン モデルなどの多くの分野をカバーする幅広い用途があり、車両が道路上の障害物を識別するのを支援したり、障害物の検出を支援したりするなど、幅広い用途があります。医用画像認識による病気の診断。この記事では主に、より優れたオープンソースおよび無料の画像注釈ツールをいくつか推奨します。 1.マケセンス

オープンソースのフリーテキスト注釈ツールのおすすめ 10 選

Mar 26, 2024 pm 08:20 PM

オープンソースのフリーテキスト注釈ツールのおすすめ 10 選

Mar 26, 2024 pm 08:20 PM

テキスト注釈は、テキスト内の特定のコンテンツにラベルまたはタグを対応させる作業です。その主な目的は、特に人工知能の分野で、より深い分析と処理のためにテキストに追加情報を提供することです。テキスト注釈は、人工知能アプリケーションの教師あり機械学習タスクにとって非常に重要です。これは、自然言語テキスト情報をより正確に理解し、テキスト分類、感情分析、言語翻訳などのタスクのパフォーマンスを向上させるために AI モデルをトレーニングするために使用されます。テキスト アノテーションを通じて、AI モデルにテキスト内のエンティティを認識し、コンテキストを理解し、新しい同様のデータが出現したときに正確な予測を行うように教えることができます。この記事では主に、より優れたオープンソースのテキスト注釈ツールをいくつか推奨します。 1.LabelStudiohttps://github.com/Hu

ChatGPT では、無料ユーザーが 1 日あたりの制限付きで DALL-E 3 を使用して画像を生成できるようになりました

Aug 09, 2024 pm 09:37 PM

ChatGPT では、無料ユーザーが 1 日あたりの制限付きで DALL-E 3 を使用して画像を生成できるようになりました

Aug 09, 2024 pm 09:37 PM

DALL-E 3は、前モデルより大幅に改良されたモデルとして2023年9月に正式導入されました。これは、複雑な詳細を含む画像を作成できる、これまでで最高の AI 画像ジェネレーターの 1 つと考えられています。ただし、発売当初は対象外でした

推奨: 優れた JS オープンソースの顔検出および認識プロジェクト

Apr 03, 2024 am 11:55 AM

推奨: 優れた JS オープンソースの顔検出および認識プロジェクト

Apr 03, 2024 am 11:55 AM

顔の検出および認識テクノロジーは、すでに比較的成熟しており、広く使用されているテクノロジーです。現在、最も広く使用されているインターネット アプリケーション言語は JS ですが、Web フロントエンドでの顔検出と認識の実装には、バックエンドの顔認識と比較して利点と欠点があります。利点としては、ネットワーク インタラクションの削減とリアルタイム認識により、ユーザーの待ち時間が大幅に短縮され、ユーザー エクスペリエンスが向上することが挙げられます。欠点としては、モデル サイズによって制限されるため、精度も制限されることが挙げられます。 js を使用して Web 上に顔検出を実装するにはどうすればよいですか? Web 上で顔認識を実装するには、JavaScript、HTML、CSS、WebRTC など、関連するプログラミング言語とテクノロジに精通している必要があります。同時に、関連するコンピューター ビジョンと人工知能テクノロジーを習得する必要もあります。 Web 側の設計により、次の点に注意してください。

リリースされたばかりの!ワンクリックでアニメ風の画像を生成するオープンソース モデル

Apr 08, 2024 pm 06:01 PM

リリースされたばかりの!ワンクリックでアニメ風の画像を生成するオープンソース モデル

Apr 08, 2024 pm 06:01 PM

最新の AIGC オープンソース プロジェクト、AnimagineXL3.1 をご紹介します。このプロジェクトは、アニメをテーマにしたテキストから画像へのモデルの最新版であり、より最適化された強力なアニメ画像生成エクスペリエンスをユーザーに提供することを目的としています。 AnimagineXL3.1 では、開発チームは、モデルのパフォーマンスと機能が新たな高みに達することを保証するために、いくつかの重要な側面の最適化に重点を置きました。まず、トレーニング データを拡張して、以前のバージョンのゲーム キャラクター データだけでなく、他の多くの有名なアニメ シリーズのデータもトレーニング セットに含めました。この動きによりモデルの知識ベースが充実し、さまざまなアニメのスタイルやキャラクターをより完全に理解できるようになります。 AnimagineXL3.1 では、特別なタグと美学の新しいセットが導入されています

Alibaba 7B マルチモーダル文書理解の大規模モデルが新しい SOTA を獲得

Apr 02, 2024 am 11:31 AM

Alibaba 7B マルチモーダル文書理解の大規模モデルが新しい SOTA を獲得

Apr 02, 2024 am 11:31 AM

マルチモーダル文書理解機能のための新しい SOTA!アリババの mPLUG チームは、最新のオープンソース作品 mPLUG-DocOwl1.5 をリリースしました。これは、高解像度の画像テキスト認識、一般的な文書構造の理解、指示の遵守、外部知識の導入という 4 つの主要な課題に対処するための一連のソリューションを提案しています。さっそく、その効果を見てみましょう。複雑な構造のグラフをワンクリックで認識しMarkdown形式に変換:さまざまなスタイルのグラフが利用可能:より詳細な文字認識や位置決めも簡単に対応:文書理解の詳しい説明も可能:ご存知「文書理解」 「」は現在、大規模な言語モデルの実装にとって重要なシナリオです。市場には文書の読み取りを支援する多くの製品が存在します。その中には、主にテキスト認識に OCR システムを使用し、テキスト処理に LLM と連携する製品もあります。

携帯電話にchatgptをインストールする方法

Mar 05, 2024 pm 02:31 PM

携帯電話にchatgptをインストールする方法

Mar 05, 2024 pm 02:31 PM

インストール手順: 1. ChatGTP ソフトウェアを ChatGTP 公式 Web サイトまたはモバイル ストアからダウンロードします; 2. それを開いた後、設定インターフェイスで言語を中国語を選択します; 3. ゲーム インターフェイスでヒューマン マシン ゲームを選択し、中国スペクトル; 4 . 起動後、チャット ウィンドウにコマンドを入力してソフトウェアを操作します。

中国でもchatgptは使えますか?

Mar 05, 2024 pm 03:05 PM

中国でもchatgptは使えますか?

Mar 05, 2024 pm 03:05 PM

chatgpt は中国でも使用できますが、香港やマカオでも登録できません。ユーザーが登録したい場合は、外国の携帯電話番号を使用して登録できます。登録プロセス中にネットワーク環境を切り替える必要があることに注意してください。外国のIP。