SOTAを3.27%上回り、上海交通大学などが適応型ローカル集約の新たな手法を提案

この記事では、AAAI 2023 に掲載された論文を紹介します。この論文は、上海交通大学およびクイーンズ大学ベルファストのスケーラブル コンピューティングおよびシステムの上海主要研究所の Hua Yang 氏と Louis Ann 氏によって書かれました。那州州立大学が共同で完成させた。

- 紙のリンク: https://arxiv.org/abs/2212.01197

- コードリンク (ALA モジュールの使用手順を含む): https://github.com/TsingZ0/FedALA

本論文は、クライアントが必要とする情報をグローバルモデルから自動的に取得することにより、フェデレーテッドラーニングにおける統計的不均一性問題に対処するフェデレーテッドラーニングのための適応型ローカル集約手法を提案する。著者は 11 個の SOTA モデルを比較し、最適な方法を 3.27% 上回る優れたパフォーマンスを達成しました。著者は、適応型ローカル集約モジュールを他のフェデレーテッド ラーニング手法に適用し、最大 24.19% の改善を達成しました。

1 はじめに

フェデレーション ラーニング (FL) は、ユーザーのプライバシー データを広めずにローカルに保存することで、プライバシーを保護しながら、人々がお互いを完全に理解し、学び合うのに役立ちます。ユーザーデータに。ただし、クライアント間のデータは目に見えないため、データの統計的な不均一性 (非独立で同一に分散されたデータ (非 IID) およびデータ量の不均衡) が FL の大きな課題の 1 つとなっています。データの統計的不均一性により、従来のフェデレーション学習手法 (FedAvg など) では、FL プロセス トレーニングを通じて各クライアントに適した単一のグローバル モデルを取得することが困難になります。

近年、データの統計的不均一性に対処できるため、パーソナライズされたフェデレーテッド ラーニング (pFL) 手法がますます注目を集めています。高品質のグローバル モデルを求める従来の FL とは異なり、pFL アプローチは、フェデレーション ラーニングの協調的なコンピューティング能力を使用して、各クライアントに適したパーソナライズされたモデルをトレーニングすることを目的としています。サーバー上でのモデルの集約に関する既存の pFL 研究は、次の 3 つのカテゴリに分類できます。

(1) 単一のグローバル モデルを学習して微調整する方法 (Per-FedAvg など)および FedRep;

(2) pFedMe や同上など、追加のパーソナライゼーション モデルを学習する方法;

(3) パーソナライゼーションによる集約 (またはローカル アグリゲーション) ローカル モデルを学習するためのメソッド (FedAMP、FedPHP、FedFomo、APPLE、PartialFed など)。

カテゴリ (1) および (2) の pFL メソッドは、ローカル初期化 (各反復でのローカル トレーニングの前にローカル モデルを初期化することを指します) にグローバル モデルからのすべての情報を使用します。ただし、グローバル モデルでは、ローカル モデルの品質を向上させる情報 (ローカルのトレーニング目標を満たす、クライアントが必要とする情報) のみがクライアントにとって有益です。グローバル モデルには、単一のクライアントに必要な情報と不要な情報の両方が含まれるため、一般化が不十分です。したがって、研究者らは、パーソナライズされた集約を通じてグローバル モデルで各クライアントが必要とする情報を取得するカテゴリー (3) の pFL 手法を提案しています。ただし、カテゴリ (3) の pFL メソッドは依然として存在しており、(a) クライアントのローカル トレーニング目標を考慮せず (FedAMP や FedPHP など)、(b) 計算コストと通信コストが高くなります (FedFomo や APPLE など)、(c)プライバシー漏洩などの問題 (FedFomo や APPLE など)、および (d) パーソナライズされた集計とローカルのトレーニング目標の間の不一致 (PartialFed など)。さらに、これらのメソッドは FL プロセスに大幅な変更を加えているため、これらのメソッドが使用するパーソナライズされた集計メソッドは、ほとんどの既存の FL メソッドでは直接使用できません。

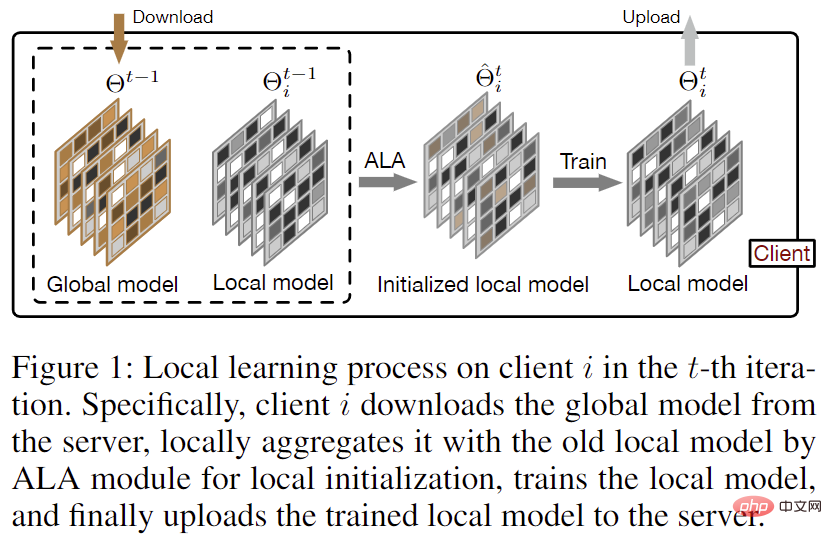

FedAvg と比較して反復ごとの通信コストを増加させることなく、クライアントが必要とする情報をグローバル モデルから正確に取得するために、著者はフェデレーション Learning Adaptive Local Aggregation の手法を提案しました。メソッド (FedALA)。図 1 に示すように、FedALA は、各ローカル トレーニングの前に、適応ローカル アグリゲーション (ALA) モジュールを通じてグローバル モデルとローカル モデルを集約することにより、グローバル モデル内の必要な情報を取得します。 FedALA は、FedAvg と比較して、他の FL プロセスを変更せずに各反復でローカル モデルの初期化プロセスを変更するために ALA のみを使用するため、ALA は他のほとんどの既存の FL メソッドに直接適用して、それぞれのパフォーマンスを向上させることができます。

#図 1: 反復におけるクライアント上のローカル学習プロセス

2 メソッド

##2.1 適応型ローカル集約 ( ALA)

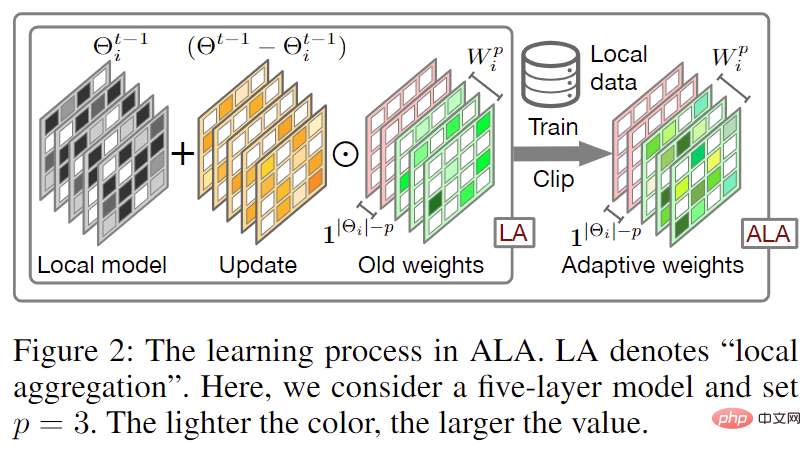

図 2: アダプティブ ローカル アグリゲーション (ALA) プロセス

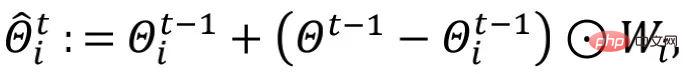

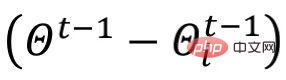

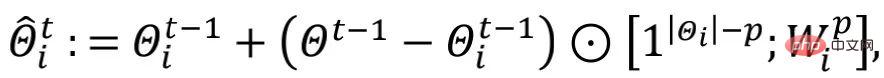

適応型ローカル アグリゲーション (ALA) プロセスを図 2 に示します。従来のフェデレーテッド ラーニングと比較して、ダウンロードされたグローバル モデルはローカル モデル で直接上書きされ、ローカル初期化モデルを取得します。 の方法 (つまり、) では、FedALA は、各パラメータのローカル集約の重みを学習することにより、適応型ローカル集約を実行します。

その中で、著者は

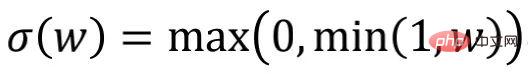

「renew」と呼んでいます。さらに、作者は要素ごとの重み枝刈りメソッド  を通じて正則化を実装し、

を通じて正則化を実装し、 の値を [0,1] に制限します。

の値を [0,1] に制限します。  ディープ ニューラル ネットワーク (DNN) の下位層ネットワークは上位層に比べて相対的に一般的な情報を学習する傾向があり、一般的な情報は各ローカル モデルに必要な情報であるため、したがって、グローバル モデルの下位ネットワークの情報のほとんどは、ローカル モデルの下位ネットワークで必要な情報と一致します。ローカル集約の重みを学習するために必要な計算コストを削減するために、著者は ALA の範囲を制御するハイパーパラメータ p を導入し、グローバル モデルの下位層のネットワーク パラメータがローカル モデルの下位層のネットワークを直接カバーするようにします。上位層のみ ALA を有効にします。

ディープ ニューラル ネットワーク (DNN) の下位層ネットワークは上位層に比べて相対的に一般的な情報を学習する傾向があり、一般的な情報は各ローカル モデルに必要な情報であるため、したがって、グローバル モデルの下位ネットワークの情報のほとんどは、ローカル モデルの下位ネットワークで必要な情報と一致します。ローカル集約の重みを学習するために必要な計算コストを削減するために、著者は ALA の範囲を制御するハイパーパラメータ p を導入し、グローバル モデルの下位層のネットワーク パラメータがローカル モデルの下位層のネットワークを直接カバーするようにします。上位層のみ ALA を有効にします。

このうち、

このうち、

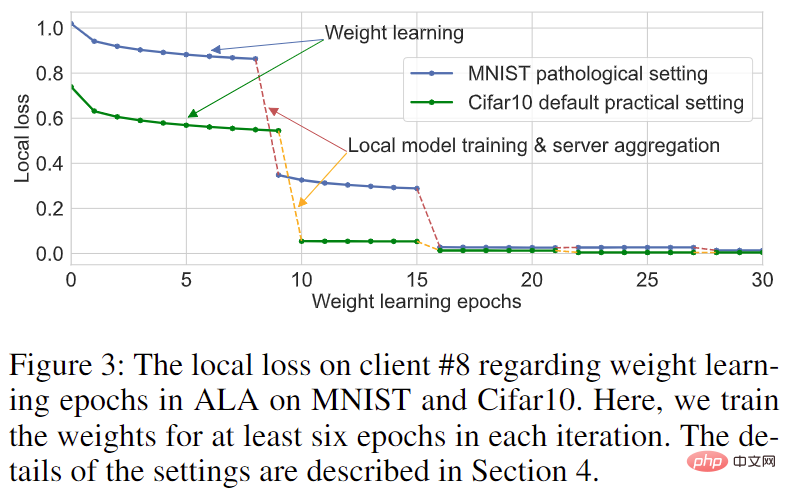

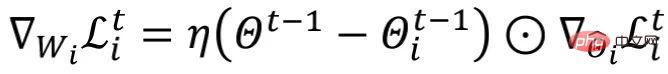

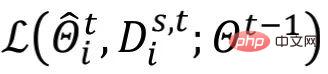

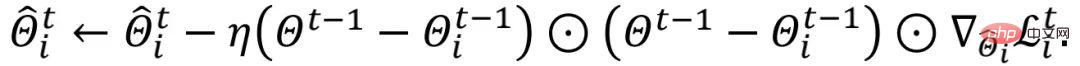

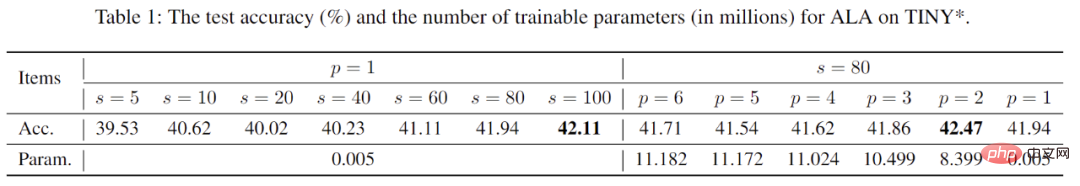

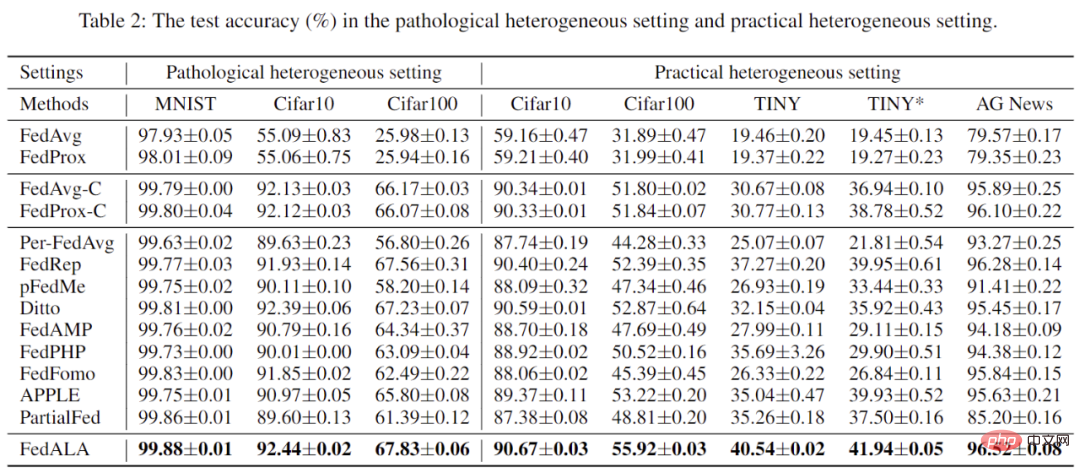

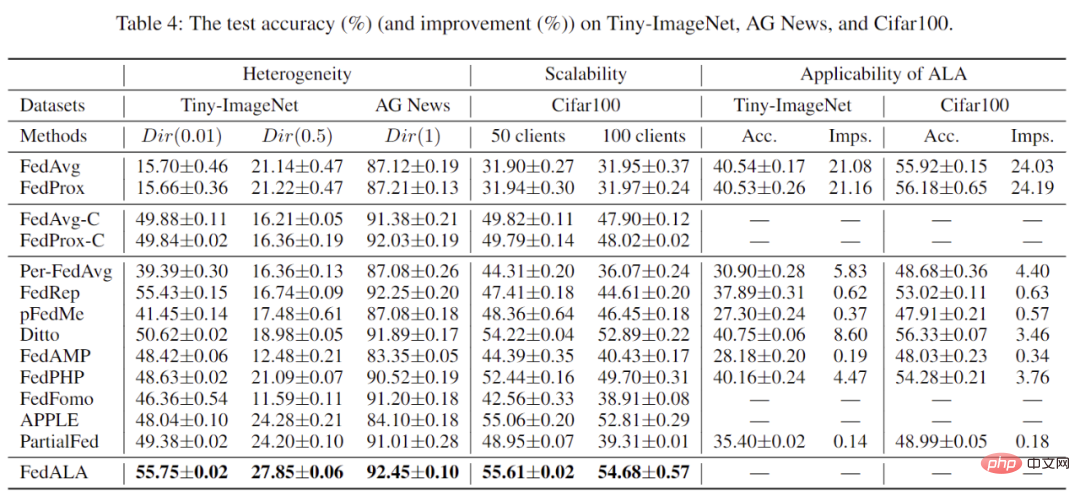

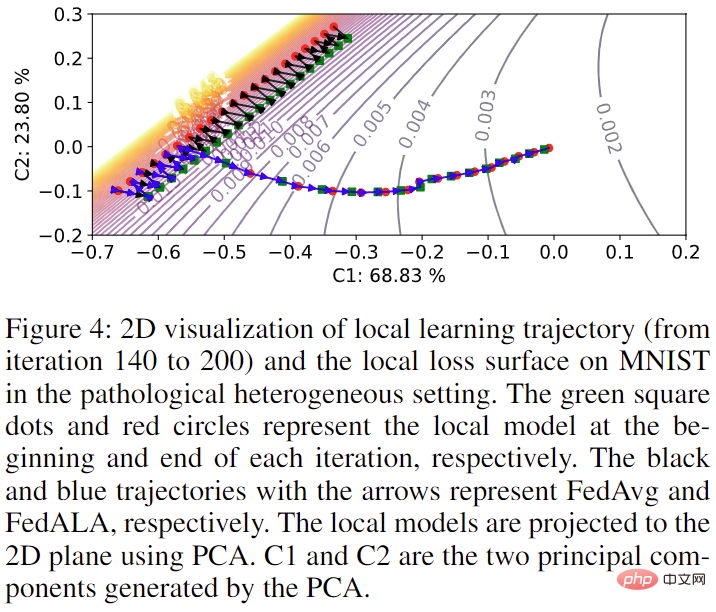

は 作成者は、 を使用します。ここで、 図 3: MNIST および Cifar10 データセットにおけるクライアント 8 の学習曲線 より小さい p 値を選択すると、FedALA のパフォーマンスに影響を与えることなく、ALA のトレーニングに必要なパラメーターを大幅に削減できます。さらに、図 3 に示すように、最初のトレーニング セッションで収束するようにトレーニングされると、その後の反復でトレーニングされたとしても、ローカル モデルの品質に大きな影響を与えないことを著者らは観察しました。つまり、各クライアントは古い 2.2 ALA 分析 分析に影響を与えることなく、簡単にするために、作成者は 勾配項 著者は、ResNet-18 を使用して、実際のデータ異種混合環境における Tiny-ImageNet データセットのハイパーパラメータ s と p を比較しました。 FedALA の影響を表 1 に示します。の場合、ALA モジュール学習によりランダムにサンプリングされたローカル トレーニング データを使用すると、パーソナライズされたモデルのパフォーマンスが向上しますが、計算コストも増加します。 ALA を使用する場合、 のサイズは各クライアントの計算能力に基づいて調整できます。表からわかるように、FedALA は、非常に小さい s (s=5 など) を使用した場合でも優れたパフォーマンスを発揮します。 p については、異なる p 値はパーソナライズされたモデルのパフォーマンスにほとんど影響を与えませんが、計算コストには大きな違いがあります。この現象は、モデルを分割し、ニューラル ネットワーク層をクライアントにアップロードせずに出力の近くに保持する FedRep などの手法の有効性を、ある側面から示しています。 ALA を使用する場合、パーソナライズされたモデルのパフォーマンス機能を確保しながら、より小さく適切な p 値を使用して計算コストをさらに削減できます。 #表 1: ハイパーパラメータとその FedALA への影響に関する調査 #著者は、FedALAと11のSOTA手法を、病理学的データ異種環境と実践データ異種環境において比較分析した。表 2 に示すように、データは、これらのケースで FedALA がこれら 11 の SOTA メソッドよりも優れていることを示しています。ここで、「TINY」とは、Tiny-ImageNet で 4 層 CNN を使用することを意味します。たとえば、TINY の場合、FedALA は最適なベースラインを 3.27% 上回っています。 #表 2: 病理学的データと実データの異種環境下での実験結果 さらに、著者はFedALA のパフォーマンスも、さまざまな異種環境とクライアントの総数の下で評価されました。表 3 に示すように、FedALA はこれらの条件下でも依然として優れたパフォーマンスを維持しています。 #表 3: その他の実験結果 最後に、著者は、図 4 に示すように、MNIST 上の元の FL プロセスでのモデル トレーニングに対する ALA モジュールの追加の影響も視覚化しました。 ALA がアクティブ化されていない場合、モデル トレーニングの軌跡は FedAvg を使用した場合と一致します。 ALA がアクティブ化されると、グローバル モデルでキャプチャされたトレーニングに必要な情報を使用して、モデルは最適な目標に向かって直接最適化できます。

図 4: クライアント No. 4 でのモデル トレーニングの軌跡の視覚化 のニューラル ネットワーク層の数を表します。 (またはニューラル ネットワーク ブロックの数)、

のニューラル ネットワーク層の数を表します。 (またはニューラル ネットワーク ブロックの数)、 は

は  の下位ネットワークの形状と一致しており、

の下位ネットワークの形状と一致しており、 の残りの部分と一致しています。 p 層の上位ネットワークは同じ形状です。

の残りの部分と一致しています。 p 層の上位ネットワークは同じ形状です。

のすべての値を 1 に初期化し、ローカル初期化の各ラウンド中に古い

のすべての値を 1 に初期化し、ローカル初期化の各ラウンド中に古い  に基づいて

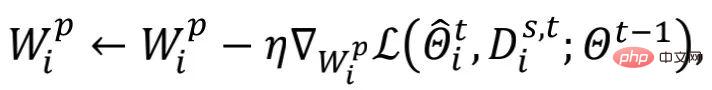

に基づいて  を更新します。計算コストをさらに削減するために、著者はランダム サンプリング s

を更新します。計算コストをさらに削減するために、著者はランダム サンプリング s

は学習です。

は学習です。  レートを更新します。

レートを更新します。  を学習する過程で、著者は

を学習する過程で、著者は  を除く他の学習可能なパラメータを凍結しました。

を除く他の学習可能なパラメータを凍結しました。

を再利用して、必要な情報を取得できます。著者は、計算コストを削減するために、後続の反復で

を再利用して、必要な情報を取得できます。著者は、計算コストを削減するために、後続の反復で  を微調整する方法を採用しています。

を微調整する方法を採用しています。

を無視し、

を無視し、 と仮定します。上記の式により、

と仮定します。上記の式により、 が得られます。

が得られます。 は

は  を表します。作成者は、ALA の

を表します。作成者は、ALA の  の更新を

の更新を  の更新と考えることができます。

の更新と考えることができます。

は、各ラウンドで要素ごとにスケールされます。ローカル モデルのトレーニング (または微調整) 方法とは異なり、上記の

は、各ラウンドで要素ごとにスケールされます。ローカル モデルのトレーニング (または微調整) 方法とは異なり、上記の  の更新プロセスは、グローバル モデル内の共通情報を認識できます。異なる反復ラウンド間で、動的に変化する

の更新プロセスは、グローバル モデル内の共通情報を認識できます。異なる反復ラウンド間で、動的に変化する  によって ALA モジュールに動的な情報が導入され、FedALA が複雑な環境に適応しやすくなります。

によって ALA モジュールに動的な情報が導入され、FedALA が複雑な環境に適応しやすくなります。 3 実験

以上がSOTAを3.27%上回り、上海交通大学などが適応型ローカル集約の新たな手法を提案の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7450

7450

15

15

1374

1374

52

52

77

77

11

11

14

14

7

7

ddrescue を使用して Linux 上のデータを回復する

Mar 20, 2024 pm 01:37 PM

ddrescue を使用して Linux 上のデータを回復する

Mar 20, 2024 pm 01:37 PM

DDREASE は、ハード ドライブ、SSD、RAM ディスク、CD、DVD、USB ストレージ デバイスなどのファイル デバイスまたはブロック デバイスからデータを回復するためのツールです。あるブロック デバイスから別のブロック デバイスにデータをコピーし、破損したデータ ブロックを残して正常なデータ ブロックのみを移動します。 ddreasue は、回復操作中に干渉を必要としないため、完全に自動化された強力な回復ツールです。さらに、ddasue マップ ファイルのおかげでいつでも停止および再開できます。 DDREASE のその他の主要な機能は次のとおりです。 リカバリされたデータは上書きされませんが、反復リカバリの場合にギャップが埋められます。ただし、ツールに明示的に指示されている場合は切り詰めることができます。複数のファイルまたはブロックから単一のファイルにデータを復元します

オープンソース!ゾーイデプスを超えて! DepthFM: 高速かつ正確な単眼深度推定!

Apr 03, 2024 pm 12:04 PM

オープンソース!ゾーイデプスを超えて! DepthFM: 高速かつ正確な単眼深度推定!

Apr 03, 2024 pm 12:04 PM

0.この記事は何をするのですか?私たちは、多用途かつ高速な最先端の生成単眼深度推定モデルである DepthFM を提案します。従来の深度推定タスクに加えて、DepthFM は深度修復などの下流タスクでも最先端の機能を実証します。 DepthFM は効率的で、いくつかの推論ステップ内で深度マップを合成できます。この作品について一緒に読みましょう〜 1. 論文情報タイトル: DepthFM: FastMonocularDepthEstimationwithFlowMatching 著者: MingGui、JohannesS.Fischer、UlrichPrestel、PingchuanMa、Dmytr

Google は大喜び: JAX のパフォーマンスが Pytorch や TensorFlow を上回りました! GPU 推論トレーニングの最速の選択肢となる可能性があります

Apr 01, 2024 pm 07:46 PM

Google は大喜び: JAX のパフォーマンスが Pytorch や TensorFlow を上回りました! GPU 推論トレーニングの最速の選択肢となる可能性があります

Apr 01, 2024 pm 07:46 PM

Google が推進する JAX のパフォーマンスは、最近のベンチマーク テストで Pytorch や TensorFlow のパフォーマンスを上回り、7 つの指標で 1 位にランクされました。また、テストは最高の JAX パフォーマンスを備えた TPU では行われませんでした。ただし、開発者の間では、依然として Tensorflow よりも Pytorch の方が人気があります。しかし、将来的には、おそらくより大規模なモデルが JAX プラットフォームに基づいてトレーニングされ、実行されるようになるでしょう。モデル 最近、Keras チームは、ネイティブ PyTorch 実装を使用して 3 つのバックエンド (TensorFlow、JAX、PyTorch) をベンチマークし、TensorFlow を使用して Keras2 をベンチマークしました。まず、主流のセットを選択します

iPhoneのセルラーデータインターネット速度が遅い:修正

May 03, 2024 pm 09:01 PM

iPhoneのセルラーデータインターネット速度が遅い:修正

May 03, 2024 pm 09:01 PM

iPhone のモバイル データ接続に遅延や遅い問題が発生していませんか?通常、携帯電話の携帯インターネットの強度は、地域、携帯ネットワークの種類、ローミングの種類などのいくつかの要因によって異なります。より高速で信頼性の高いセルラー インターネット接続を実現するためにできることがいくつかあります。解決策 1 – iPhone を強制的に再起動する 場合によっては、デバイスを強制的に再起動すると、携帯電話接続を含む多くの機能がリセットされるだけです。ステップ 1 – 音量を上げるキーを 1 回押して放します。次に、音量小キーを押して、もう一度放します。ステップ 2 – プロセスの次の部分は、右側のボタンを押し続けることです。 iPhone の再起動が完了するまで待ちます。セルラーデータを有効にし、ネットワーク速度を確認します。もう一度確認してください 修正 2 – データ モードを変更する 5G はより優れたネットワーク速度を提供しますが、信号が弱い場合はより適切に機能します

超知性の生命力が覚醒する!しかし、自己更新 AI の登場により、母親はデータのボトルネックを心配する必要がなくなりました。

Apr 29, 2024 pm 06:55 PM

超知性の生命力が覚醒する!しかし、自己更新 AI の登場により、母親はデータのボトルネックを心配する必要がなくなりました。

Apr 29, 2024 pm 06:55 PM

世界は狂ったように大きなモデルを構築していますが、インターネット上のデータだけではまったく不十分です。このトレーニング モデルは「ハンガー ゲーム」のようであり、世界中の AI 研究者は、データを貪欲に食べる人たちにどのように餌を与えるかを心配しています。この問題は、マルチモーダル タスクで特に顕著です。何もできなかった当時、中国人民大学学部のスタートアップチームは、独自の新しいモデルを使用して、中国で初めて「モデル生成データフィード自体」を実現しました。さらに、これは理解側と生成側の 2 つの側面からのアプローチであり、両方の側で高品質のマルチモーダルな新しいデータを生成し、モデル自体にデータのフィードバックを提供できます。モデルとは何ですか? Awaker 1.0 は、中関村フォーラムに登場したばかりの大型マルチモーダル モデルです。チームは誰ですか?ソフォンエンジン。人民大学ヒルハウス人工知能大学院の博士課程学生、ガオ・イージャオ氏によって設立されました。

アメリカ空軍が初のAI戦闘機を公開し注目を集める!大臣はプロセス全体を通じて干渉することなく個人的にテストを実施し、10万行のコードが21回にわたってテストされました。

May 07, 2024 pm 05:00 PM

アメリカ空軍が初のAI戦闘機を公開し注目を集める!大臣はプロセス全体を通じて干渉することなく個人的にテストを実施し、10万行のコードが21回にわたってテストされました。

May 07, 2024 pm 05:00 PM

最近、軍事界は、米軍戦闘機が AI を使用して完全自動空戦を完了できるようになったというニュースに圧倒されました。そう、つい最近、米軍のAI戦闘機が初めて公開され、その謎が明らかになりました。この戦闘機の正式名称は可変安定性飛行シミュレーター試験機(VISTA)で、アメリカ空軍長官が自ら飛行させ、一対一の空戦をシミュレートした。 5 月 2 日、フランク ケンダル米国空軍長官は X-62AVISTA でエドワーズ空軍基地を離陸しました。1 時間の飛行中、すべての飛行動作が AI によって自律的に完了されたことに注目してください。ケンダル氏は「過去数十年にわたり、私たちは自律型空対空戦闘の無限の可能性について考えてきたが、それは常に手の届かないものだと思われてきた」と語った。しかし今では、

柔軟かつ高速な 5 本の指を備え、人間のタスクを自律的に完了する初のロボットが登場、大型モデルが仮想空間トレーニングをサポート

Mar 11, 2024 pm 12:10 PM

柔軟かつ高速な 5 本の指を備え、人間のタスクを自律的に完了する初のロボットが登場、大型モデルが仮想空間トレーニングをサポート

Mar 11, 2024 pm 12:10 PM

今週、OpenAI、Microsoft、Bezos、Nvidiaが投資するロボット企業FigureAIは、7億ドル近くの資金調達を受け、来年中に自立歩行できる人型ロボットを開発する計画であると発表した。そしてテスラのオプティマスプライムには繰り返し良い知らせが届いている。今年が人型ロボットが爆発的に普及する年になることを疑う人はいないだろう。カナダに拠点を置くロボット企業 SanctuaryAI は、最近新しい人型ロボット Phoenix をリリースしました。当局者らは、多くのタスクを人間と同じ速度で自律的に完了できると主張している。人間のスピードでタスクを自律的に完了できる世界初のロボットである Pheonix は、各オブジェクトを優しくつかみ、動かし、左右にエレガントに配置することができます。自律的に物体を識別できる

Alibaba 7B マルチモーダル文書理解の大規模モデルが新しい SOTA を獲得

Apr 02, 2024 am 11:31 AM

Alibaba 7B マルチモーダル文書理解の大規模モデルが新しい SOTA を獲得

Apr 02, 2024 am 11:31 AM

マルチモーダル文書理解機能のための新しい SOTA!アリババの mPLUG チームは、最新のオープンソース作品 mPLUG-DocOwl1.5 をリリースしました。これは、高解像度の画像テキスト認識、一般的な文書構造の理解、指示の遵守、外部知識の導入という 4 つの主要な課題に対処するための一連のソリューションを提案しています。さっそく、その効果を見てみましょう。複雑な構造のグラフをワンクリックで認識しMarkdown形式に変換:さまざまなスタイルのグラフが利用可能:より詳細な文字認識や位置決めも簡単に対応:文書理解の詳しい説明も可能:ご存知「文書理解」 「」は現在、大規模な言語モデルの実装にとって重要なシナリオです。市場には文書の読み取りを支援する多くの製品が存在します。その中には、主にテキスト認識に OCR システムを使用し、テキスト処理に LLM と連携する製品もあります。