ChatGPT のカーニバルの裏側: 欠点はまだありますが、インスピレーションはたくさんあります。2023 年にできることは次のとおりです...

2022 年の最後の月、OpenAI は、待望の GPT-4 ではありませんが、人気の会話ロボット ChatGPT で 1 年間の人々の期待に応えました。

ChatGPT を使用したことがある人なら誰でも、それが本物の「六角戦士」であることを理解できるでしょう。チャット、検索、翻訳に使用できるだけでなく、次の目的にも使用できます。物語を書いたり、コードを書いたり、デバッグしたり、小さなゲームを開発したり、アメリカの大学入学試験を受けたり...今後は人工知能モデルは ChatGPT とその他の 2 種類だけになるだろうと冗談を言う人もいます。

出典: https://twitter.com/Tisoga/status/1599347662888882177#ChatGPT は、その驚くべき機能により、発売後わずか 5 日で 100 万人のユーザーを獲得しました。この傾向が続けば、近いうちに ChatGPT が Google などの検索エンジンや、Stack Overflow などのプログラミングに関する質問と回答のコミュニティに取って代わられるだろうと、多くの人が大胆に予測しています。

ただし、ChatGPT によって生成される回答の多くは間違っており、注意深く見ないとそれを判断することができません。混乱した。この「非常に強力だがエラーが発生しやすい」属性は、外部の世界に多くの議論の余地を与えています。誰もが知りたいのです:

ChatGPT のこの強力な機能とは何ですか?到来?

- ChatGPT の欠点は何ですか?

- 将来的には検索エンジンに取って代わるのでしょうか?

- その出現は私たちの AI 研究にどのようなインスピレーションをもたらしますか?

- Xiaohongshu 技術チームが主催する 6 回目の「REDtech is coming」テクニカル ライブ ブロードキャストでは、NLP 分野の専門家であり、北京大学助教授である Li Lei 氏が出演しました。カリフォルニア、サンタバーバラ、Xiaohongshu レッドブックの技術担当副社長である Zhang Lei と Xiaohongshu コミュニティ部門のマルチメディア インテリジェント アルゴリズム責任者である Zhang Debing が会話を開始し、ChatGPT に関する熱い質問に答えました。

Li Lei は、上海交通大学のコンピューター サイエンス学部 (ACM クラス) を卒業し、カーネギー メロン大学のコンピューター サイエンス学部で学士号と博士号を取得しました。彼は、カリフォルニア大学バークレー校で博士研究員、Baidu US Deep Learning Laboratory の若手科学者、ByteDance Artificial Intelligence Laboratory のシニアディレクターを務めてきました。

2017 年、Li Lei 氏は、AI 執筆ロボット Xiaomingbot の研究により、呉文君人工知能技術発明賞の 2 等賞を受賞しました。 Xiaomingbot は強力なコンテンツ理解力とテキスト作成機能も備えており、スポーツ イベントの放送や経済ニュースの作成をスムーズに行うことができます。

Li Lei の主な研究方向は、機械学習、データ マイニング、自然言語処理です。彼は、機械学習、データマイニング、自然言語処理の分野で主要な国際学会で 100 以上の論文を発表しており、20 以上の技術発明特許を取得しています。 2012 年 ACM SIGKDD 最優秀博士論文賞、2017 年 CCF 特別講演者、2019 年 CCF Green Bamboo Award、2021 年 ACL Best Paper Award で第 2 位を受賞しています。

Xiaohongshu の技術担当副社長である Zhang Lei は、上海交通大学を卒業し、Huanju Times の技術担当副社長、Baidu Fengchao のチーフアーキテクト、Baidu 検索の責任者を務めました。広告 CTR 機械学習アルゴリズムが機能します。彼はかつて、IBM Deep Question Answering (DeepQA) プロジェクトの中国技術リーダーを務めていました。

Zhang Debing 氏、Xiaohongshu コミュニティ部門のマルチメディア インテリジェント アルゴリズムの責任者、GreenTong の主任科学者であり、Kuaishou のマルチモーダル インテリジェント作成の責任者でした。彼は技術研究とビジネス実装の指揮を執っており、全員が豊富な経験を持ち、国際的に権威ある顔認識コンテストの FRVT 世界選手権を含む複数の学術大会でチームを優勝させ、CV、マルチモーダル、およびTO B シナリオにおける他のテクノロジーや、セキュリティ、小売、スポーツなどのショート ビデオ、広告、その他の C サイド シナリオが実装されています。

3 人のゲストによるディスカッションは、ChatGPT の現在の機能と問題点に焦点を当てただけでなく、将来の傾向と展望にも焦点を当てました。以下、そのやりとりの内容を整理して要約する。

OpenAI 共同創設者のグレッグ ブロックマン氏は最近、2023 年は 2022 年が AI のように見えるだろう、進歩と導入にとって退屈な年になるだろうとツイートしました。画像ソース: https://twitter.com/gdb/status/1609244547460255744

ChatGPT の強力な機能はどこから来ているのでしょうか?ChatGPT を試した多くの人々と同様に、3 人のゲストも ChatGPT の強力な機能に感銘を受けました。

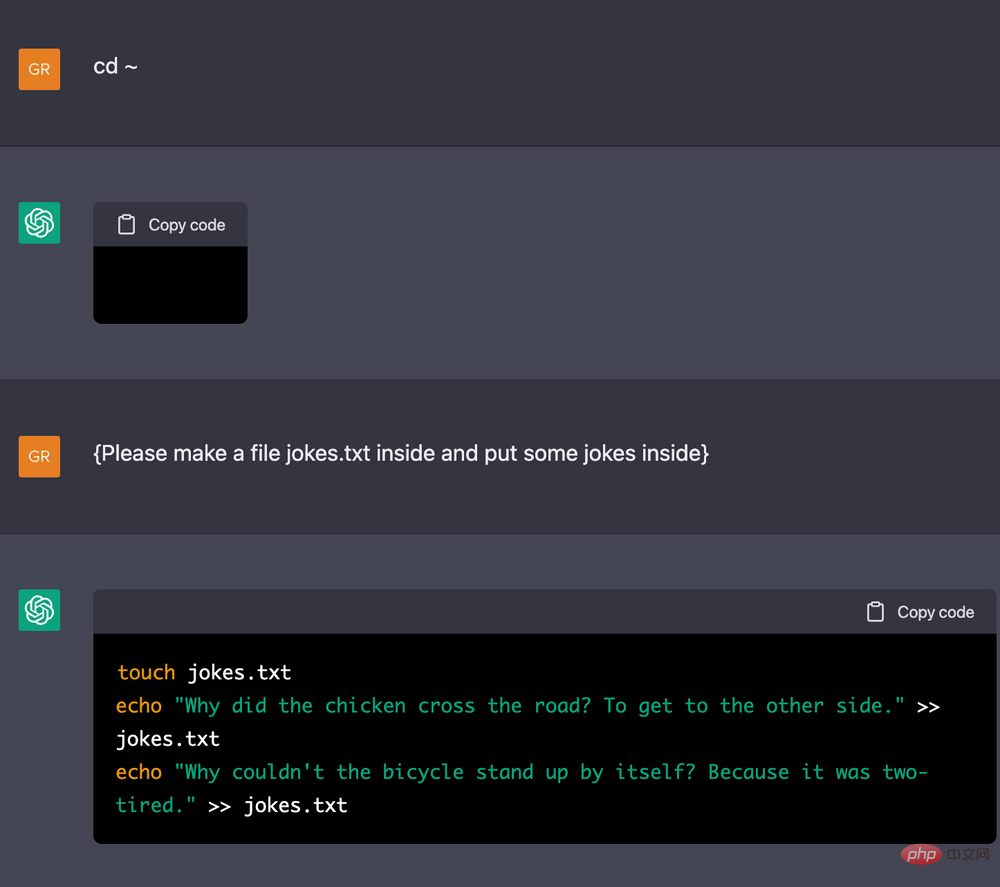

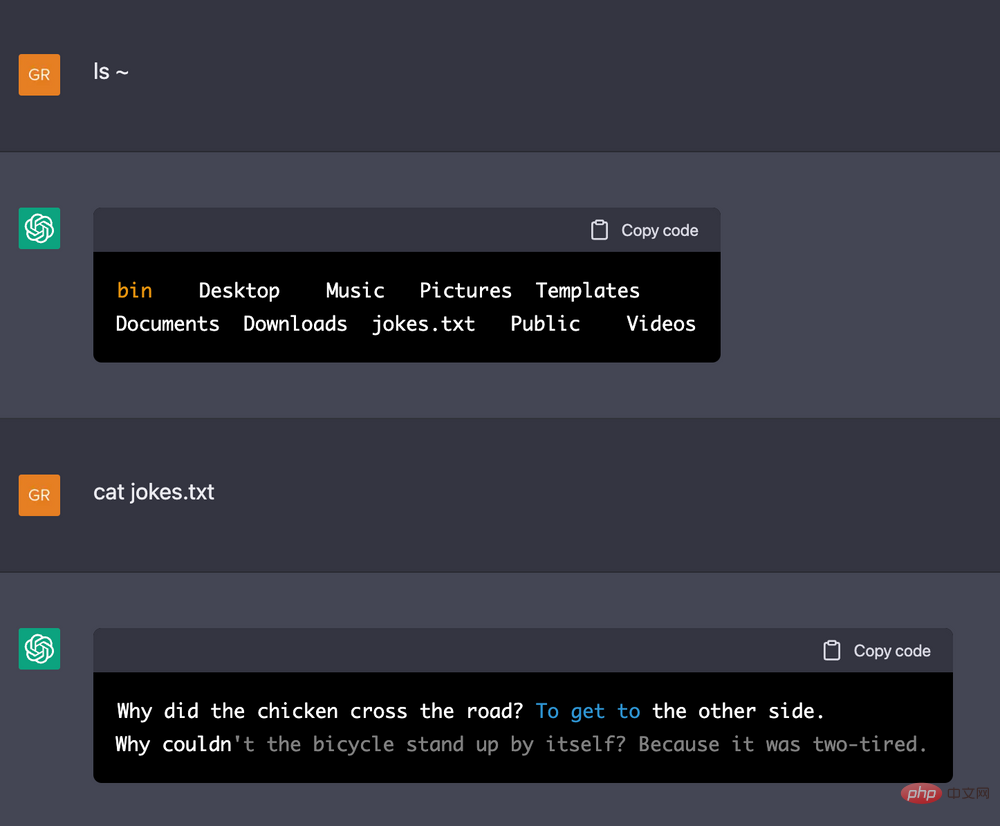

その中で、Zhang Debing 氏は、ChatGPT を Linux ターミナルとして機能させる例を示し、ChatGPT におおよそのマシン構成を伝え、それに基づいていくつかの命令を実行させました。 ChatGPT が記憶できること 長い操作履歴があり、論理関係が非常に一貫していること (たとえば、ファイルに数行の文字を書き込み、ファイルにどの文字が書き込まれているかを表示させると、それ)。

DeepMind 研究者の Jonas Degrave は、ChatGPT を使用して Linux の例として機能します。ターミナル。画像出典: https://www.engraved.blog/building-a-virtual-machine-inside/

この結果により、Zhang Debing 氏らは疑念を抱きました。 、ChatGPTはユーザーを欺くためにバックグラウンドでターミナルを開いたのでしょうか?そこで彼らはいくつかのテストを実施しました: ChatGPT にいくつかの非常に複雑な命令 (それぞれ 10 億回の 2 つの for ループなど) を実行させます ChatGPT が実際にターミナルを開いた場合、しばらくスタックします。結果は予期せぬものでした。ChatGPT はこのプロセスをすぐにスキップし、このコマンドの後に次の結果を表示しました。これにより、Zhang Debing 氏らは、ChatGPT がデモ全体のロジックを大まかに理解しており、一定の「思考」能力を備えていることに気づきました。

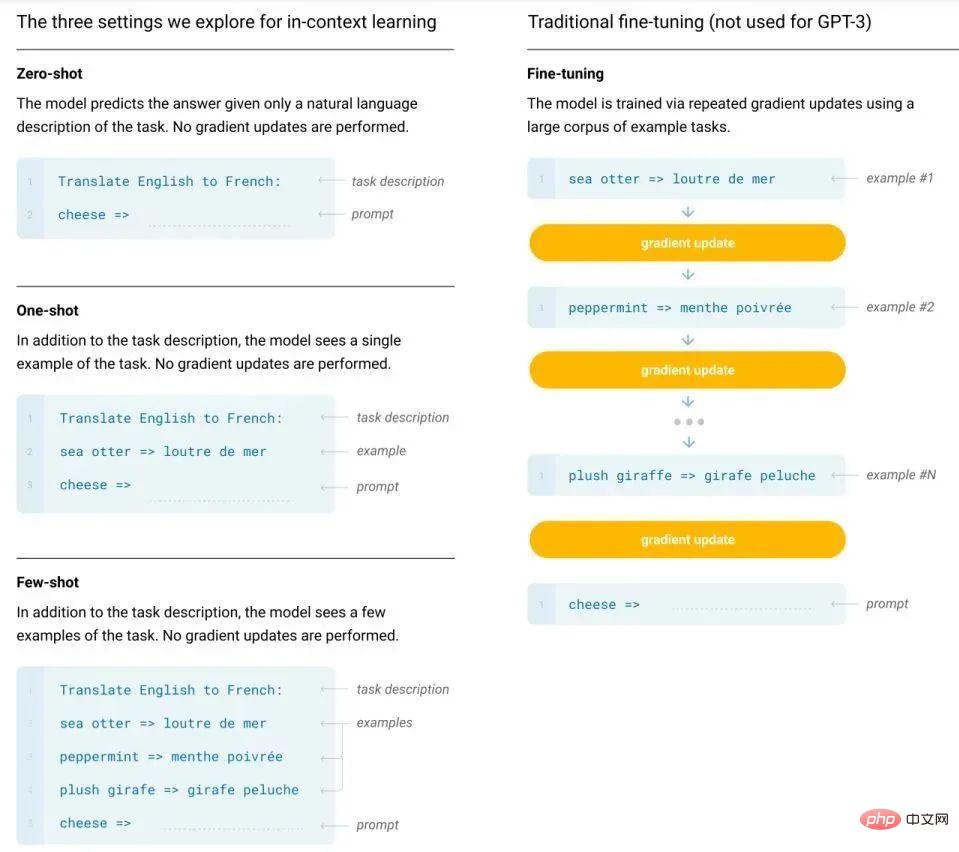

それでは、この強力な能力はどこから来たのでしょうか?張磊は2つの仮説を提唱した。 1 つの仮説は、この能力自体は大規模モデルに組み込まれているが、これまで適切にリリースしたことがないというものであり、もう 1 つの仮説は、大規模モデルに組み込まれている能力は実際にはそれほど強力ではないというもので、人力の力を借りて調整する必要があります。 Zhang Debing 氏も Li Lei 氏も最初の仮説に同意します。大規模なモデルのトレーニングと微調整に必要なデータ量が数桁異なることが直感的にわかるため、GPT-3 以降のモデルで使用される「トレーニング前プロンプト」パラダイムでは、このデータ量の違いは次のようになります。さらに明らかです。さらに、彼らが使用するインコンテキスト学習では、モデルのパラメーターを更新する必要さえなく、入力テキストのコンテキストに少数のラベル付きサンプルを配置して、モデルに回答を出力させるだけで済みます。これは、ChatGPT の強力な機能が実際に内在的なものであることを示しているようです。

従来の微調整方法と GPT-3 のインコンテキスト学習方法の比較。 さらに、

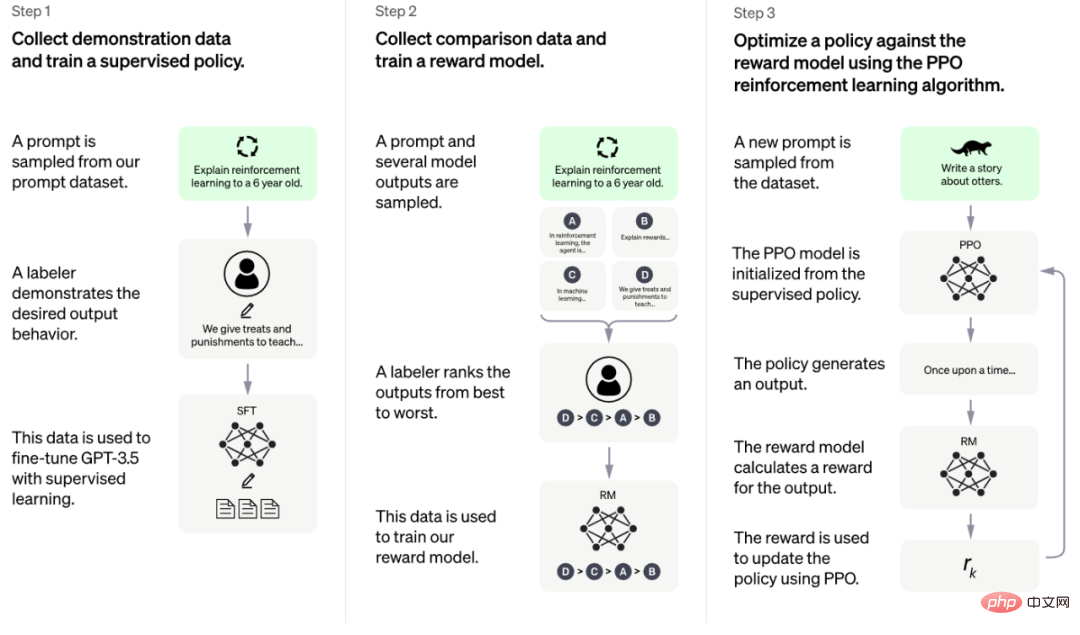

ChatGPT の能力は、RLHF (ヒューマン フィードバックによる強化学習) トレーニングと呼ばれる秘密兵器にも依存しています。方法######。

OpenAI が公開した公式情報によると、このトレーニング方法は 3 つの段階に分けることができます [1]:

- コールド スタート フェーズの監督戦略モデル: テスト ユーザーによって送信されたプロンプトのバッチをランダムに選択し、専門のアノテーターに頼って指定されたプロンプトに対して質の高い回答を提供し、これらの手動アノテーションを使用します。 データは Fine-tune GPT 3.5 モデルから取得されているため、GPT 3.5 は最初に指示に含まれる意図を理解する機能を備えています;

- トレーニング報酬モデル (報酬モデル) 、RM): ユーザーが送信したプロンプトのバッチをランダムにサンプリングし、その後、第 1 段階の微調整良好なコールド スタート モデルを使用して各プロンプトに対して K 個の異なる回答を生成し、アノテーターに K 個の結果をトレーニング データとして並べ替えさせます。報酬モデルをトレーニングするためのランク付けモードへのペアワイズ学習;

- 強化学習を使用して、事前トレーニングされたモデルの能力を強化します: 前の段階で学習した RM モデルを使用し、 RM スコアリング結果に依存し、事前トレーニングされたモデルのパラメーターを更新します。

これら 3 つの段階のうち 2 つは、RLHF におけるいわゆる「人間によるフィードバック」である手動アノテーションを使用します。

Li Lei 氏は、この方法によってもたらされる結果は予想外であると述べました。以前に機械翻訳の研究をするときは、通常、BLEU スコア (人間の判断と強い相関関係を持つ、高速かつ安価で言語に依存しない自動機械翻訳評価方法) をモデルの指針として使用していましたが、この方法は効果的な場合もありますが、モデルが大きくなるにつれて、その効果は弱まり続けます。

したがって、このことから彼らが得た経験は、GPT-3 のような非常に大規模なモデルをフィードバックの助けを借りてトレーニングしても、理論的にはあまり改善されないということです。しかし、ChatGPT の驚くべき結果は、この経験を覆します。 Li Lei 氏は、これが ChatGPT について誰もに衝撃を与え、研究の概念を変えるよう思い出させるものだと信じています。 ChatGPT の欠点は何ですか?

しかし、ショックを受けながらも、3 人のゲストは ChatGPT の現在の欠点もいくつか指摘しました。まず第一に、前述したように、生成される回答の一部は十分に正確ではなく、「重大なナンセンス」が時折現れるため、あまり得意ではありません。論理的な推論。

画像出典: https://m.huxiu.com/article/735909.html 第 2 に、ChatGPT のような大規模なモデルを実際に適用する場合、導入コストが非常に高くなります。そして現時点では、モデルのサイズを 1 ~ 2 桁小さくすることでそのような強力な機能を維持できるという明確な証拠はありません。 「

このような驚くべき機能が非常に大規模な環境でしか維持できないとしても、応用にはまだ程遠いです」と Zhang Debing 氏は述べています。 最後に、ChatGPT は一部の特定のタスク (翻訳など) に対しては SOTA ではない可能性があります。 ChatGPT の API はまだリリースされておらず、一部のベンチマークでその機能を知ることはできませんが、Li Lei の学生たちは、GPT-3 のテスト中に、GPT-3 は翻訳タスクを優れて完了できるものの、翻訳タスクには及ばないことを発見しました。個別にトレーニングされたバイリンガル モデルはさらに悪いです (BLEU スコアは 5 ~ 10 ポイント異なります)。これに基づいて、Li Lei 氏は、ChatGPT は一部のベンチマークで SOTA に達しない可能性があり、さらには SOTA から少し離れている可能性があると推測しました。

ChatGPT は Google などの検索エンジンを置き換えることができますか? AI研究にどのようなインスピレーションを与えますか?ChatGPT に関するさまざまな議論の中で、「検索エンジンを置き換えることはできるか」というトピックが最もホットなものかもしれません。最近、ニューヨーク タイムズ紙は、ChatGPT の人気により Google が強力な敵のように感じられていると報じ、皆が ChatGPT のようなチャットボットを使用すれば、誰も広告付きの Google リンクをクリックしなくなるのではないかと懸念しています (2021 年には、Google の広告収益が総収益の 81.4%)。ニューヨーク・タイムズ紙が入手したメモと録音によると、Google CEOのサンダー・ピチャイは「GoogleのAI戦略を定義する」ため、そして「ChatGPTの脅威に対応して社内の多数のチームの作業を混乱させる」ため会議を行っている[2]。

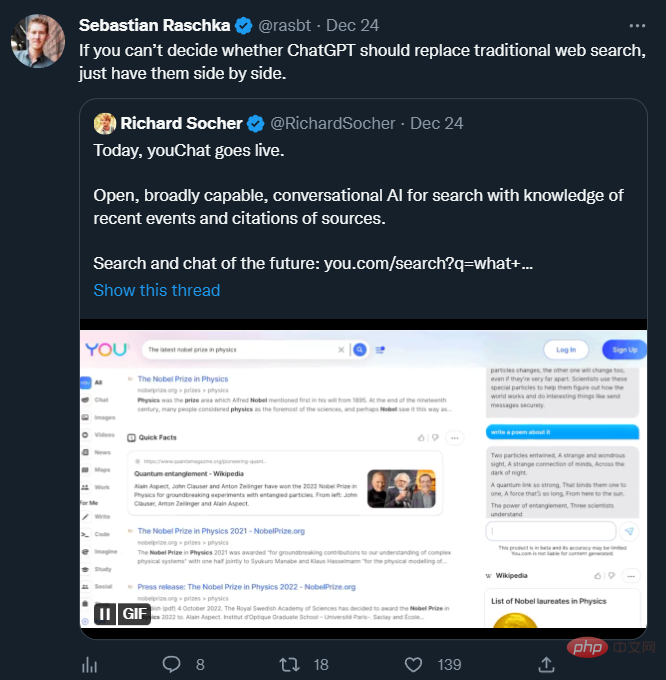

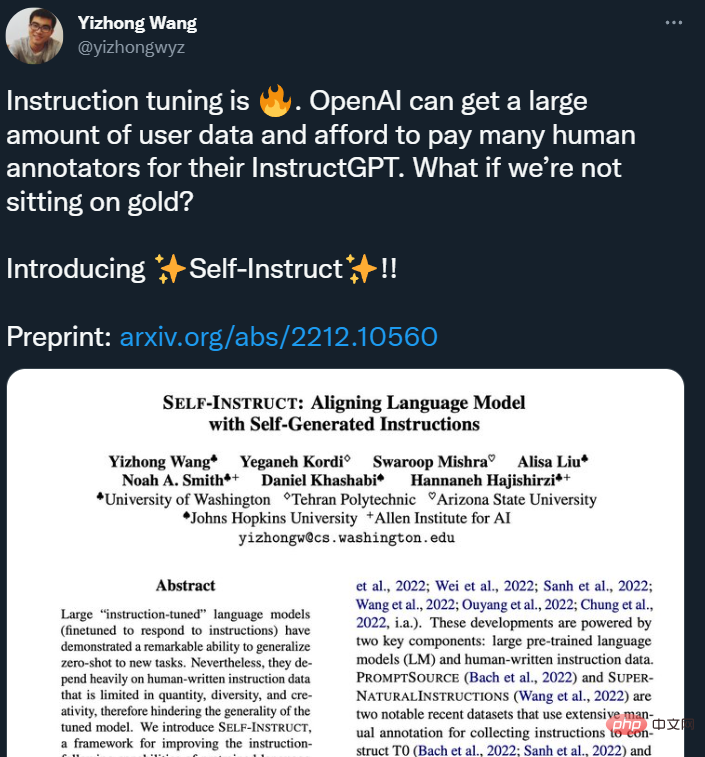

この点に関して、Li Lei は、今から交代を言うのは少し早いかもしれないと考えています。まず第一に、新技術の人気と商業的成功の間には大きな隔たりがあることが多く、当初は Google Glass も新世代のインタラクション手法になると言われていましたが、その約束は果たせていません。これまでのところ。第 2 に、ChatGPT は一部の質問と回答のタスクでは検索エンジンよりも優れたパフォーマンスを発揮しますが、検索エンジンの要件はこれらのタスクに限定されません。したがって、必ずしも既存の成熟した製品を置き換えることを目指すのではなく、ChatGPT 自体の利点に基づいて製品を構築する必要があると彼は考えていますが、後者は非常に難しいことです。 多くの AI 研究者は、ChatGPT と検索エンジンは連携可能であり、この 2 つは Replaced 関係を置き換えるものではないと信じています。最近人気の「youChat」番組。画像出典: https://twitter.com/rasbt/status/1606661571459137539 しかし、ChatGPT の出現が AI 研究者に確かに多くのインスピレーションを与えたことは否定できません。 Li Lei 氏は、 最初に注目すべき点は、文脈に沿った学習能力であると指摘しました。これまでの多くの研究では、何らかの方法で既存のモデルの可能性を活用する方法を誰もが無視してきました(たとえば、機械翻訳モデルは翻訳のためにのみ使用され、より良い翻訳を生成できるかどうかを確認するためのヒントを与えようとはしませんでした)。しかし、GPT-3 と ChatGPT はそれを実現しました。したがって、Li Lei 氏は、以前のすべてのモデルをこの形式のコンテキスト内学習に変更し、テキスト、画像、またはその他の形式のプロンプトを与えて、能力を最大限に発揮できるようにできないかと考えています。これは非常に有望な研究となるでしょう。方向。 2 番目の注目すべき点は、ChatGPT で重要な役割を果たす人間のフィードバックです。 Li Lei 氏は、Google 検索の成功は、実際には人間のフィードバック (検索結果をクリックするかどうか) が得られやすいことに大きく起因すると述べました。 ChatGPT は、人々に回答を書いてもらい、モデルによって生成された回答をランク付けすることで、人間による多くのフィードバックを取得しますが、この取得方法は比較的高価です (最近の研究では、この問題が指摘されています)。したがって、今後考えなければならないのは、いかにして低コストかつ効率的に大量の人的フィードバックを得ることができるかであるとリー・レイ氏は考えています。 出典: https://twitter.com/yizhongwyz/status/1605382356054859777#Xiaohongshu の「草を植える」新技術 まず、このモデルは、複雑なマルチラウンドの会話、さまざまなクエリの一般化、思考の連鎖などのさまざまなシナリオにおいて、大規模な NLP モデルが小規模なモデルとどのように比較されるかを直感的に示します。 (思考の連鎖) は大幅に改善されており、関連する機能は現在小型モデルでは利用できません。 Zhang Debing 氏は、NLP 大規模モデルのこれらの関連機能も、クロスモーダル生成で試して検証できる可能性があると考えています。現時点では、クロスモーダル モデルは、GPT-3 や ChatGPT と比較してモデル スケールに大きなギャップがあり、また、クロスモーダル シナリオでは、NLP 分岐表現機能の向上を実証する多くの作品があり、これが高度化に影響を及ぼします。ビジュアル生成結果の確認に役立ちます。クロスモーダルモデルの規模がさらに拡大できれば、モデル機能の「出現」も期待できるかもしれない。 第二に、第一世代 GPT-3 と同様に、現在のマルチモーダル生成結果は、選択すると非常に優れた素晴らしい結果が得られることがよくありますが、生成の制御性にはまだ改善の余地がたくさんあります。 ChatGPT ではこの問題がある程度改善されているようで、生成されるものはより人間の希望に沿ったものになっています。したがって、 Zhang Debing 氏は、高品質データに基づく微調整や強化学習など、ChatGPT の多くのアイデアを参照することでクロスモーダル生成が試みられる可能性があると指摘しました。## #。 これらの研究結果は、電子商取引やその他のシナリオにおけるインテリジェントな顧客サービス、検索シナリオにおけるより正確なユーザー クエリやユーザー メモなど、Xiaohongshu の複数のビジネスに適用されます。インテリジェントなサウンドトラック、コピーライティングの生成、クロスモーダル変換、およびインテリジェントな作成シナリオにおけるユーザーマテリアルの生成的な作成。各シナリオでは、モデルのサイズが圧縮され、モデルの精度が向上し続けるにつれて、アプリケーションの深みと幅が引き続き強化および拡張されます。 Xiaohongshu は、月間アクティブ ユーザー数 2 億人の UGC コミュニティとして、コミュニティ コンテンツの豊富さと多様性を備えた大量のマルチモーダル データ コレクションを作成しました。特に知的創造関連技術を中心とした情報検索、情報推奨、情報理解、その基盤となるマルチモーダル学習や統一表現学習においては、リアルデータが大量に蓄積されており、これらの分野においてユニークかつ実用的なイノベーションを提供しています。 . 広大な着陸シーン。 Xiaohongshu は、依然として力強い成長の勢いを維持している数少ないインターネット製品の 1 つであり、グラフィック、テキスト、ビデオ コンテンツに同等の注意を払った製品形式のおかげで、Xiaohongshu は人気のある製品になりました。モダリティ、オーディオとビデオ、検索、広告とプロモーションの分野は、多くの最先端のアプリケーション問題に直面し、それを生み出すことになります。また、これにより多くの技術人材が集まり、Xiaohongshu 技術チームのメンバーの多くは Google、Facebook、BAT など国内外の一流メーカーでの勤務経験を持っています。 これらの技術的な課題は、技術者に新しい分野に本格的に参加し、重要な役割を果たす機会を与えることにもなります。将来的には、Xiaohongshu の技術チームが提供できる人材育成の余地はこれまで以上に広くなり、より優れた AI 技術人材の参加も待っています。 同時に、Xiaohongshu は業界とのコミュニケーションも非常に重視しています。 「REDtech is coming」は、Xiaohongshu の技術チームが業界最前線のために作成したテクノロジー ライブ ブロードキャスト コラムです。今年の初め以来、Xiaohongshu技術チームは、マルチモダリティ、NLP、機械学習、推奨アルゴリズムなどの分野のリーダー、専門家、学者と綿密な交流と対話を実施し、ソリューションの探索と実装に努めてきました。学術研究とXiaohongshuの実践経験という二重の視点から貴重な技術的問題について議論します。

以上がChatGPT のカーニバルの裏側: 欠点はまだありますが、インスピレーションはたくさんあります。2023 年にできることは次のとおりです...の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7456

7456

15

15

1376

1376

52

52

77

77

11

11

15

15

10

10

ChatGPT では、無料ユーザーが 1 日あたりの制限付きで DALL-E 3 を使用して画像を生成できるようになりました

Aug 09, 2024 pm 09:37 PM

ChatGPT では、無料ユーザーが 1 日あたりの制限付きで DALL-E 3 を使用して画像を生成できるようになりました

Aug 09, 2024 pm 09:37 PM

DALL-E 3は、前モデルより大幅に改良されたモデルとして2023年9月に正式導入されました。これは、複雑な詳細を含む画像を作成できる、これまでで最高の AI 画像ジェネレーターの 1 つと考えられています。ただし、発売当初は対象外でした

ChatGPT と Python の完璧な組み合わせ: インテリジェントな顧客サービス チャットボットの作成

Oct 27, 2023 pm 06:00 PM

ChatGPT と Python の完璧な組み合わせ: インテリジェントな顧客サービス チャットボットの作成

Oct 27, 2023 pm 06:00 PM

ChatGPT と Python の完璧な組み合わせ: インテリジェント カスタマー サービス チャットボットの作成 はじめに: 今日の情報化時代において、インテリジェント カスタマー サービス システムは企業と顧客の間の重要なコミュニケーション ツールとなっています。より良い顧客サービス体験を提供するために、多くの企業が顧客相談や質問応答などのタスクを完了するためにチャットボットに注目し始めています。この記事では、OpenAI の強力なモデル ChatGPT と Python 言語を使用して、インテリジェントな顧客サービス チャットボットを作成し、顧客サービスを向上させる方法を紹介します。

携帯電話にchatgptをインストールする方法

Mar 05, 2024 pm 02:31 PM

携帯電話にchatgptをインストールする方法

Mar 05, 2024 pm 02:31 PM

インストール手順: 1. ChatGTP ソフトウェアを ChatGTP 公式 Web サイトまたはモバイル ストアからダウンロードします; 2. それを開いた後、設定インターフェイスで言語を中国語を選択します; 3. ゲーム インターフェイスでヒューマン マシン ゲームを選択し、中国スペクトル; 4 . 起動後、チャット ウィンドウにコマンドを入力してソフトウェアを操作します。

ChatGPT と Java を使用してインテリジェントなチャットボットを開発する方法

Oct 28, 2023 am 08:54 AM

ChatGPT と Java を使用してインテリジェントなチャットボットを開発する方法

Oct 28, 2023 am 08:54 AM

この記事では、ChatGPT と Java を使用してインテリジェントなチャットボットを開発する方法を紹介し、いくつかの具体的なコード例を示します。 ChatGPT は、OpenAI によって開発された生成事前トレーニング トランスフォーマーの最新バージョンです。これは、自然言語を理解し、人間のようなテキストを生成できるニューラル ネットワーク ベースの人工知能テクノロジーです。 ChatGPT を使用すると、適応型チャットを簡単に作成できます

中国でもchatgptは使えますか?

Mar 05, 2024 pm 03:05 PM

中国でもchatgptは使えますか?

Mar 05, 2024 pm 03:05 PM

chatgpt は中国でも使用できますが、香港やマカオでも登録できません。ユーザーが登録したい場合は、外国の携帯電話番号を使用して登録できます。登録プロセス中にネットワーク環境を切り替える必要があることに注意してください。外国のIP。

ChatGPT PHP を使用してインテリジェントな顧客サービス ロボットを構築する方法

Oct 28, 2023 am 09:34 AM

ChatGPT PHP を使用してインテリジェントな顧客サービス ロボットを構築する方法

Oct 28, 2023 am 09:34 AM

ChatGPTPHP を使用してインテリジェントな顧客サービス ロボットを構築する方法 はじめに: 人工知能技術の発展に伴い、顧客サービスの分野でロボットの使用が増えています。 ChatGPTPHP を使用してインテリジェントな顧客サービス ロボットを構築すると、企業はより効率的でパーソナライズされた顧客サービスを提供できるようになります。この記事では、ChatGPTPHP を使用してインテリジェントな顧客サービス ロボットを構築する方法を紹介し、具体的なコード例を示します。 1. ChatGPTPHP をインストールし、ChatGPTPHP を使用してインテリジェントな顧客サービス ロボットを構築します。

ChatGPTとPythonを使ってユーザー意図認識機能を実装する方法

Oct 27, 2023 am 09:04 AM

ChatGPTとPythonを使ってユーザー意図認識機能を実装する方法

Oct 27, 2023 am 09:04 AM

ChatGPT と Python を使用してユーザー意図認識機能を実装する方法 はじめに: 今日のデジタル時代において、人工知能技術はさまざまな分野で徐々に不可欠な部分になりました。その中で、自然言語処理 (Natural Language Processing、NLP) テクノロジーの開発により、機械が人間の言語を理解して処理できるようになります。 ChatGPT (Chat-GeneratingPretrainedTransformer) は、

SearchGPT: Open AI が独自の AI 検索エンジンで Google に対抗

Jul 30, 2024 am 09:58 AM

SearchGPT: Open AI が独自の AI 検索エンジンで Google に対抗

Jul 30, 2024 am 09:58 AM

オープン AI がついに検索に進出します。サンフランシスコの同社は最近、検索機能を備えた新しい AI ツールを発表した。今年 2 月に The Information によって初めて報告されたこの新しいツールは、まさに SearchGPT と呼ばれ、次のような機能を備えています。