特殊効果を追加するには 1 つの文または画像だけが必要であり、Stable Diffusion 社は AIGC を使用して新しいトリックを実行しました。

特に 2022 年の AIGC の流行を経験したことで、多くの人が生成 AI テクノロジーの魅力をすでに理解していると思います。 Stable Diffusion に代表されるテキストから画像への生成技術は、かつて世界中で普及し、AI の助けを借りて芸術的な想像力を表現するために無数のユーザーが殺到しました...

比較画像編集、ビデオ編集の場合 編集はより難しいトピックであり、時間的な一貫性を維持しながら、単に見た目を変更するのではなく、新しいアクションを合成する必要があります。

多くの企業がこの道を模索しています。少し前に、Google はビデオ編集にテキスト条件付きビデオ拡散モデル (VDM) を適用する Dreamix をリリースしました。

最近、Stable Diffusion の作成に参加した企業である Runway は、テキスト プロンプトまたは参照を適用することで指定されたスタイルを使用する新しい人工知能モデル「Gen-1」を発表しました。画像。既存のビデオを新しいビデオに変換できます。

# 論文リンク: https://arxiv.org/pdf/2302.03011.pdf

プロジェクトホームページ: https://research.runwayml.com/gen1

2021 年、ランウェイと大学ミュンヘンの研究者が協力して、安定拡散の最初のバージョンを構築しました。その後、英国の新興企業である Stability AI が、より多くのデータでモデルをトレーニングするために必要な計算費用に資金提供するために介入しました。 2022 年、Stability AI は Stable Diffusion を主流にし、それを研究プロジェクトから世界的な現象に変えます。

Runway は、Stable Diffusion が画像に対して実現したことを、Gen-1 がビデオに対しても実現できることを期待していると述べました。

「画像生成モデルの爆発的な増加を目の当たりにしました」と、Runway の CEO 兼共同創設者である Cristóbal Valenzuela 氏は述べています。 「2023 年はビデオの年になると心から信じています。」

#具体的には、Gen-1 はいくつかの編集モードをサポートしています:1。様式化。画像やプロンプトのスタイルをビデオのすべてのフレームに転送します。

2. ストーリーボード。モデルを完全に様式化されたアニメーション化されたレンダリングに変換します。

3. マスク。ビデオ内のトピックを分離し、単純なテキスト プロンプトを使用して変更します。

4. レンダリング。入力イメージまたはプロンプトを適用することで、テクスチャレス レンダリングをフォトリアリスティックな出力に変換します。

#5. カスタマイズ。モデルをカスタマイズしてより忠実度の高い結果を得ることで、Gen-1 のパワーを最大限に引き出します。

同社の公式 Web サイトに掲載されているデモでは、Gen-1 がどのようにビデオ スタイルをスムーズに変更できるかを示しています。

たとえば、「路上の人々」を「粘土の人形」に変えるには、プロンプトは 1 行だけ必要です:

# または、「テーブルに積み上げられた本」を「夜の街並み」に変える:

# または、「テーブルに積み上げられた本」を「夜の街並み」に変える:

##「雪の上を走る」から「月の上を歩く」へ:

#若い女の子、数秒で古代の賢者になる:

#

論文の詳細

視覚効果とビデオ編集は、現代のメディア環境において広く普及しています。ビデオ中心のプラットフォームの人気が高まるにつれて、より直感的で強力なビデオ編集ツールの必要性が高まっています。ただし、ビデオ データの時間的な性質により、この形式での編集は依然として複雑で時間がかかります。最先端の機械学習モデルは編集プロセスの改善に大きな期待を寄せていますが、多くの方法では時間的な一貫性と空間的な詳細のバランスを取る必要があります。

画像合成の生成手法は、大規模なデータセットでトレーニングされた拡散モデルの導入により、最近品質と人気が急速に成長しています。 DALL-E 2 や安定拡散などの一部のテキスト条件付きモデルを使用すると、初心者ユーザーでもテキスト プロンプトだけで詳細な画像を生成できます。潜在拡散モデルは、知覚的に圧縮された空間に合成することで画像を生成する効率的な方法を提供します。

この論文では、研究者らは、大規模なデータセットでトレーニングされた、字幕なしのビデオとテキストと画像のペアデータに関する、制御可能な構造とコンテンツを認識したビデオ拡散モデルを提案します。コンテンツを表現するために事前にトレーニングされたニューラル ネットワークによって予測される構造と埋め込みを表現するために、単眼の深度推定を使用することを選択しました。

この方法では、生成プロセス中にいくつかの強力な制御モードが提供されます。まず、画像合成モデルと同様に、研究者はモデルをトレーニングして、外観やスタイルなどの推定ビデオ コンテンツを作成します。ユーザーが指定した画像またはテキスト プロンプトと一致します (図 1)。次に、拡散プロセスにヒントを得て、研究者らは情報マスキング プロセスを構造表現に適用して、モデルが特定の構造をどの程度適切にサポートするかを選択できるようにしました。最後に、生成されたセグメントの時間的一貫性の制御を実現するために、分類不要のガイダンスにヒントを得たカスタム ガイダンス方法を通じて推論プロセスを調整します。

全体として、この研究のハイライトは次のとおりです。

- 事前トレーニングされた画像モデルに時間層を導入することによって画像とビデオの共同トレーニングにより、潜在拡散モデルがビデオ生成の分野に拡張されます。

- は、サンプル画像の指導の下でビデオを変更する構造とコンテンツを認識したモデルを提案します。またはテキスト。編集は完全に推論時間内で行われ、ビデオごとに追加のトレーニングや前処理を必要としません。

- は、時間、コンテンツ、構造の一貫性を完全に制御することを示します。この研究は、画像データとビデオデータの共同トレーニングにより、推論時間の時間的一貫性を制御できることを初めて示しました。構造の一貫性を保つため、表現のさまざまな詳細レベルでトレーニングすると、推論中に目的の設定を選択できるようになります。

- ユーザー調査では、私たちの方法が他のいくつかの方法よりも人気があります。

- トレーニングされたモデルは、少数の画像セットを微調整することでさらにカスタマイズでき、特定の被写体のより正確なビデオを生成できます。

方法

調査目的の場合、コンテンツと構造の両方の観点からビデオを検討すると役立ちます。ここでの構造とは、物体の形状や位置、時間的変化など、その幾何学的形状や力学を記述する特徴を意味します。コンテンツの場合、ここではオブジェクトの色やスタイル、シーンの照明など、ビデオの外観と意味論を記述する特徴として定義されます。 Gen-1 モデルの目標は、ビデオの構造を維持しながらビデオのコンテンツを編集することです。

この目標を達成するために、研究者はビデオ x の生成モデル p (x|s, c) を学習しました。その条件は構造表現 (s で表される) とコンテンツ表現です。 ( c で表します)。彼らは入力ビデオから形状表現を推測し、編集を説明するテキスト プロンプト c に基づいてそれを修正します。まず、条件付き潜在ビデオ拡散モデルとしての生成モデルの実装について説明し、次に、形状およびコンテンツ表現の選択について説明します。最後に、モデルの最適化プロセスについて説明します。

#モデルの構造を図 2 に示します。

実験

この方法を評価するために、研究者たちはDAVISビデオとさまざまな資料を使用しました。編集プロンプトを自動的に作成するために、研究者らはまず字幕モデルを実行して元のビデオ コンテンツの説明を取得し、次に GPT-3 を使用して編集プロンプトを生成しました。

定性調査

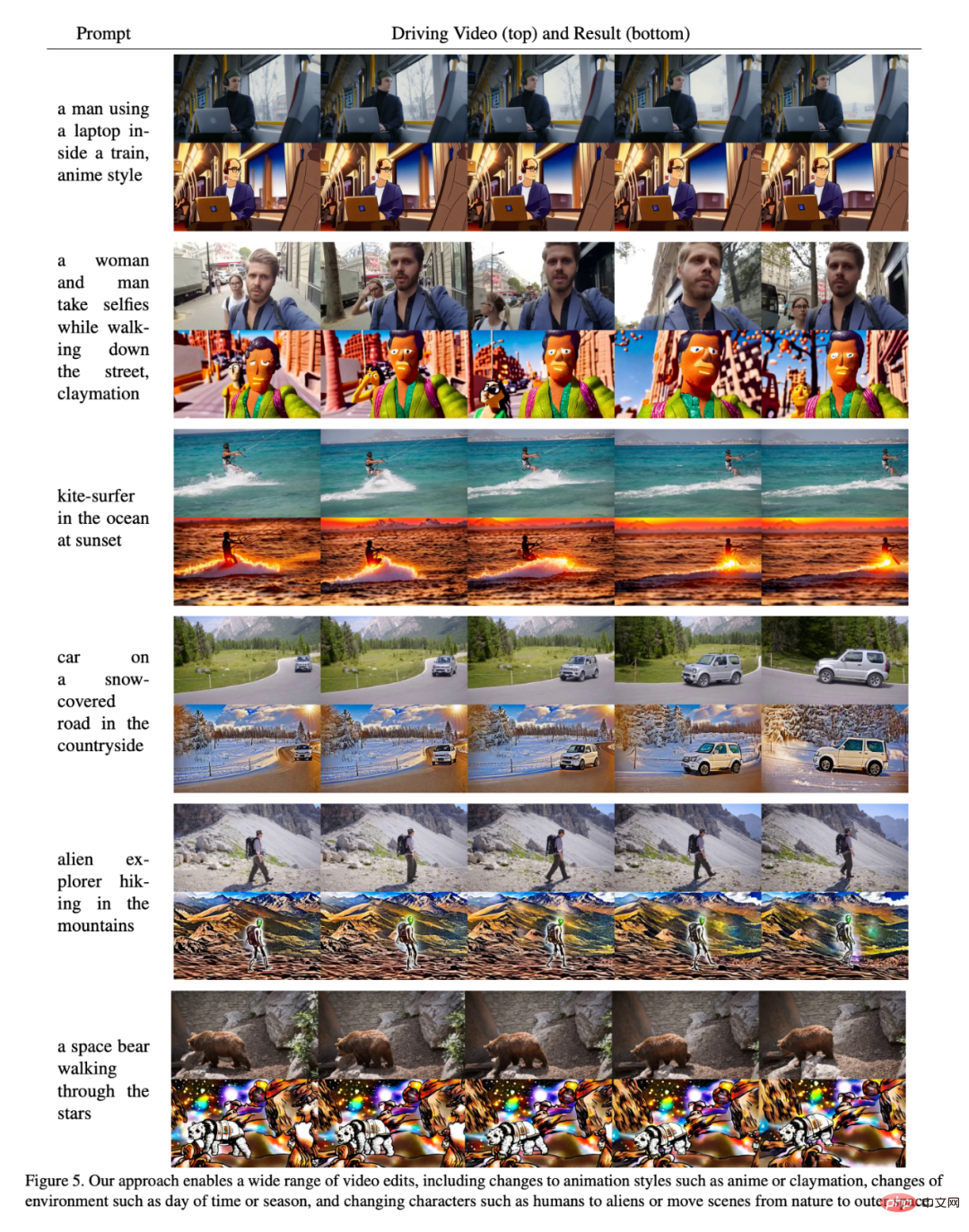

図 5 に示すように、結果は、この記事の方法が次の場合に有効であることを証明しています。いくつかの異なる入力では良好なパフォーマンスが得られます。

##ユーザー調査

研究者もユーザー調査は、Amazon Mechanical Turk (AMT) を使用して、35 の代表的なビデオ編集プロンプトの評価セットに対して実施されました。各サンプルについて、5 人のアノテーターに、ベースライン手法と私たちの手法の間でビデオ編集プロンプトの忠実度を比較するよう依頼し (「提供された編集された字幕をより適切に表すビデオはどれですか?」)、その後ランダムに順番に提示し、多数決を使用して最終決定を行いました。結果。

結果を図 7 に示します。

##定量的評価

図 6 は、この記事のフレームワークの一貫性指標とプロンプト一貫性指標を使用した各モデルの結果を示しています。このペーパーのモデルのパフォーマンスは、両方の側面でベースライン モデルを上回る傾向があります (つまり、図の右上隅でパフォーマンスが高くなります)。研究者らはまた、ベースライン モデルの強度パラメータを増やすと若干のトレードオフがあることにも気づきました。つまり、強度スケーリングを大きくすると、フレームの一貫性が低下する代わりに、プロンプトの一貫性が向上することを意味します。彼らはまた、構造スケーリングを増加させると、コンテンツが入力構造によって決定されなくなるため、プロンプトの一貫性が向上することも観察しました。

カスタマイズ

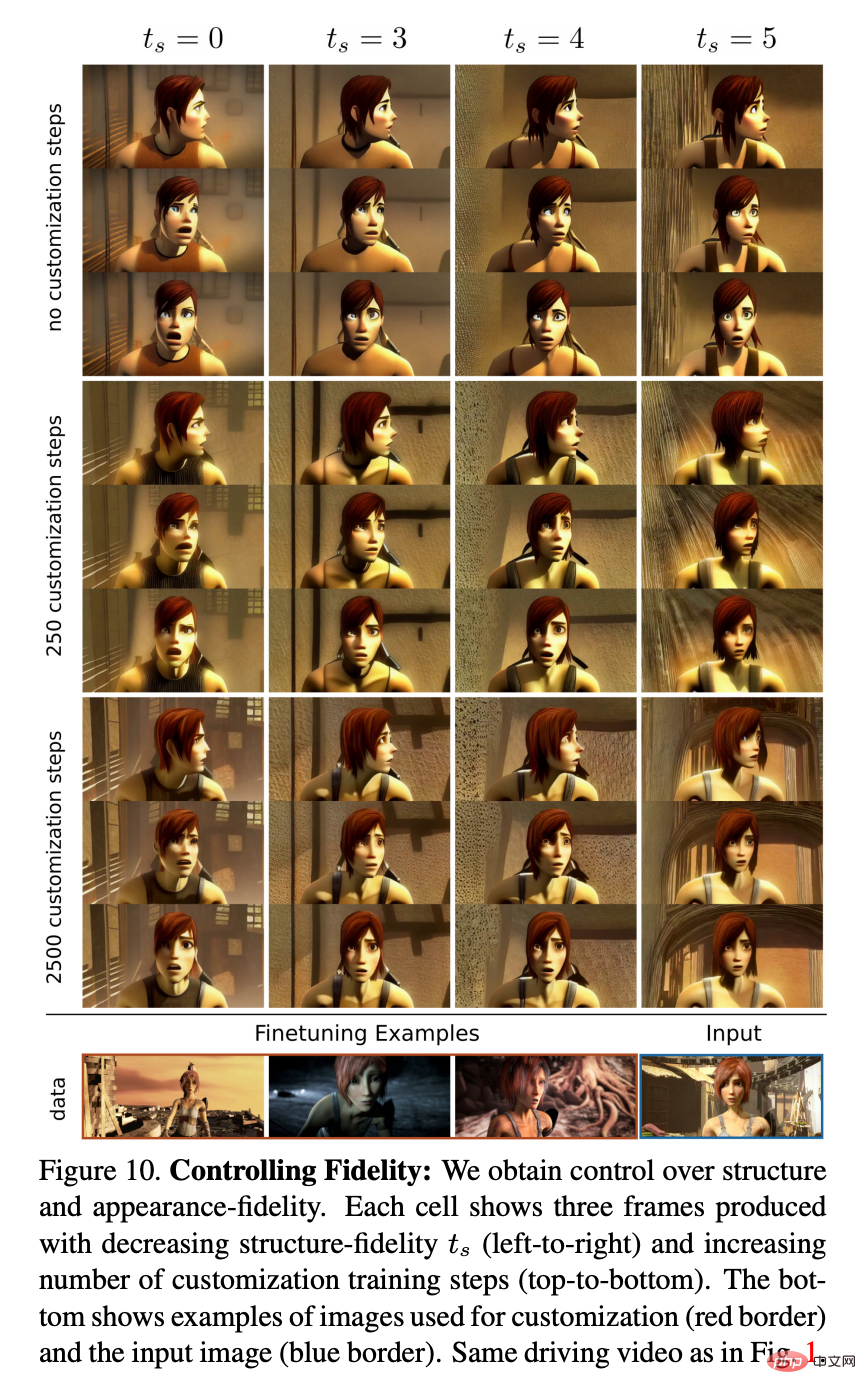

図 10 は、さまざまな数のカスタマイズ ステップとさまざまなレベルの構造依存関係を持つモデルを示しています。例。研究者らは、カスタマイズによってキャラクターのスタイルと外観の忠実度が高まるため、異なる特性を持つキャラクターの駆動ビデオを使用しているにもかかわらず、より高い ts 値と組み合わせることで、正確なアニメーション効果を実現できることを観察しました。

以上が特殊効果を追加するには 1 つの文または画像だけが必要であり、Stable Diffusion 社は AIGC を使用して新しいトリックを実行しました。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7446

7446

15

15

1374

1374

52

52

76

76

11

11

14

14

6

6

Windows 11でデスクトップの背景の最近の画像履歴をクリアする方法

Apr 14, 2023 pm 01:37 PM

Windows 11でデスクトップの背景の最近の画像履歴をクリアする方法

Apr 14, 2023 pm 01:37 PM

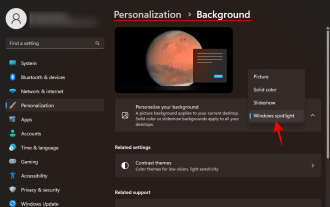

<p>Windows 11 ではシステムの個人設定が改善され、ユーザーが以前に行ったデスクトップの背景の変更の最近の履歴を表示できるようになりました。 Windows システム設定アプリケーションの個人設定セクションに入ると、さまざまなオプションが表示されます。背景の壁紙の変更もその 1 つです。ただし、システムに設定されている背景壁紙の最新の履歴を確認できるようになりました。これを見るのが嫌で、この最近の履歴を消去または削除したい場合は、この記事を読み続けてください。レジストリ エディターを使用してこれを行う方法の詳細を学ぶのに役立ちます。 </p><h2>レジストリ編集の使用方法

Windows スポットライトの壁紙画像を PC にダウンロードする方法

Aug 23, 2023 pm 02:06 PM

Windows スポットライトの壁紙画像を PC にダウンロードする方法

Aug 23, 2023 pm 02:06 PM

窓は決して美観を無視するものではありません。 XP の牧歌的な緑の野原から Windows 11 の青い渦巻くデザインに至るまで、デフォルトのデスクトップの壁紙は長年にわたってユーザーの喜びの源でした。 Windows スポットライトを使用すると、ロック画面やデスクトップの壁紙に使用する美しく荘厳な画像に毎日直接アクセスできるようになります。残念ながら、これらの画像は表示されません。 Windows スポットライト画像の 1 つが気に入った場合は、その画像をダウンロードして、しばらく背景として保存できるようにする方法を知りたいと思うでしょう。知っておくべきことはすべてここにあります。 Windowsスポットライトとは何ですか? Window Spotlight は、設定アプリの [個人設定] > から利用できる自動壁紙アップデーターです。

Python で画像セマンティック セグメンテーション テクノロジを使用するにはどうすればよいですか?

Jun 06, 2023 am 08:03 AM

Python で画像セマンティック セグメンテーション テクノロジを使用するにはどうすればよいですか?

Jun 06, 2023 am 08:03 AM

人工知能技術の継続的な発展に伴い、画像セマンティックセグメンテーション技術は画像分析分野で人気の研究方向となっています。画像セマンティック セグメンテーションでは、画像内のさまざまな領域をセグメント化し、各領域を分類して、画像の包括的な理解を実現します。 Python はよく知られたプログラミング言語であり、その強力なデータ分析機能とデータ視覚化機能により、人工知能技術研究の分野で最初に選択されます。この記事では、Python で画像セマンティック セグメンテーション技術を使用する方法を紹介します。 1. 前提知識が深まる

iOS 17: 写真でワンクリックトリミングを使用する方法

Sep 20, 2023 pm 08:45 PM

iOS 17: 写真でワンクリックトリミングを使用する方法

Sep 20, 2023 pm 08:45 PM

iOS 17 の写真アプリを使用すると、Apple は写真を仕様に合わせて簡単にトリミングできるようになります。その方法については、読み続けてください。以前の iOS 16 では、写真アプリで画像をトリミングするにはいくつかの手順が必要でした。編集インターフェイスをタップし、トリミング ツールを選択し、ピンチでズームするジェスチャまたはトリミング ツールの角をドラッグしてトリミングを調整します。 iOS 17 では、Apple がありがたいことにこのプロセスを簡素化し、写真ライブラリで選択した写真を拡大すると、画面の右上隅に新しい切り抜きボタンが自動的に表示されるようになりました。クリックすると、選択したズームレベルで完全なトリミングインターフェイスが表示されるので、画像の好きな部分をトリミングしたり、画像を回転したり、画像を反転したり、画面比率を適用したり、マーカーを使用したりできます。

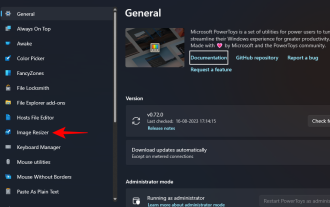

Windows で PowerToys を使用して画像のサイズを一括変更する方法

Aug 23, 2023 pm 07:49 PM

Windows で PowerToys を使用して画像のサイズを一括変更する方法

Aug 23, 2023 pm 07:49 PM

日常的に画像ファイルを扱う必要がある人は、プロジェクトや仕事のニーズに合わせて画像ファイルのサイズを変更する必要があることがよくあります。ただし、処理する画像が多すぎる場合、画像を個別にサイズ変更すると、多くの時間と労力がかかる可能性があります。この場合、PowerToys のようなツールは、画像サイズ変更ユーティリティを使用して画像ファイルのサイズをバッチで変更するのに役立ちます。 Image Resizer 設定をセットアップし、PowerToys を使用して画像のバッチ サイズ変更を開始する方法は次のとおりです。 PowerToys を使用して画像のサイズをバッチ変更する方法 PowerToys は、日常業務のスピードアップに役立つさまざまなユーティリティと機能を備えたオールインワン プログラムです。そのユーティリティの 1 つは画像です

2D画像を使って3Dの人体を作成し、好きな服を着たり、動きを変えたりすることができます。

Apr 11, 2023 pm 02:31 PM

2D画像を使って3Dの人体を作成し、好きな服を着たり、動きを変えたりすることができます。

Apr 11, 2023 pm 02:31 PM

NeRF が提供する微分可能なレンダリングのおかげで、最近の 3D 生成モデルは静止したオブジェクトに対して素晴らしい結果を達成しました。ただし、人体のようなより複雑で変形可能なカテゴリでは、3D 生成には依然として大きな課題が伴います。この論文では、超解像度モデルを使用せずに高解像度 (512x256) の 3D 人体生成を可能にする、人体の効率的な組み合わせ NeRF 表現を提案します。 EVA3D は、4 つの大規模な人体データ セットに関する既存のソリューションを大幅に上回り、コードはオープンソースになっています。論文名: EVA3D: 2D 画像コレクションからの合成 3D 人間の生成 論文アドレス: http

画像生成に関する新しい視点: NeRF ベースの一般化手法についての議論

Apr 09, 2023 pm 05:31 PM

画像生成に関する新しい視点: NeRF ベースの一般化手法についての議論

Apr 09, 2023 pm 05:31 PM

新しい透視画像生成 (NVS) は、コンピュータ ビジョンの応用分野です。1998 年のスーパーボウル ゲームで、CMU の RI は、マルチカメラ ステレオ ビジョン (MVS) を備えた NVS をデモンストレーションしました。当時、この技術は、米国のスポーツ テレビ局に移転されました。英国BBC放送社も研究開発に投資したが、結局は商品化されなかった。イメージベース レンダリング (IBR) の分野には、NVS アプリケーションの一分野、つまり深度イメージベース レンダリング (DBIR) があります。また、2010年に大流行した3Dテレビも単眼映像から両眼立体感を得る必要がありましたが、技術の未熟さから結局普及には至りませんでした。当時、次のような機械学習をベースとした手法が研究され始めていました。

ワンクリックでシミやシワを消す:DAMOアカデミーの高精細ポートレート肌美人モデルABPNの徹底解説

Apr 12, 2023 pm 12:25 PM

ワンクリックでシミやシワを消す:DAMOアカデミーの高精細ポートレート肌美人モデルABPNの徹底解説

Apr 12, 2023 pm 12:25 PM

デジタル文化産業の活発な発展に伴い、人工知能技術は画像編集や美化の分野で広く使用され始めています。その中でも、ポートレートの肌の美化は間違いなく最も広く使用され、最も需要のある技術の 1 つです。従来の美容アルゴリズムは、フィルターベースの画像編集テクノロジーを使用して、自動化された肌の再表面化とシミの除去効果を実現しており、ソーシャルネットワーキング、ライブブロードキャスト、その他のシナリオで広く使用されてきました。しかし、敷居の高いプロの写真業界では、画像解像度と品質基準に対する高い要件があるため、手動レタッチャーが依然として肖像画の美しさのレタッチにおいて主な生産力であり、肌の滑らかさ、シミの除去、美白などのタスクを完了します。仕事。通常、プロのレタッチャーによる高精細ポートレートの美肌処理の平均処理時間は1~2分ですが、より高い精度が要求される広告、映画、テレビなどの分野では、この処理が最適化されています。