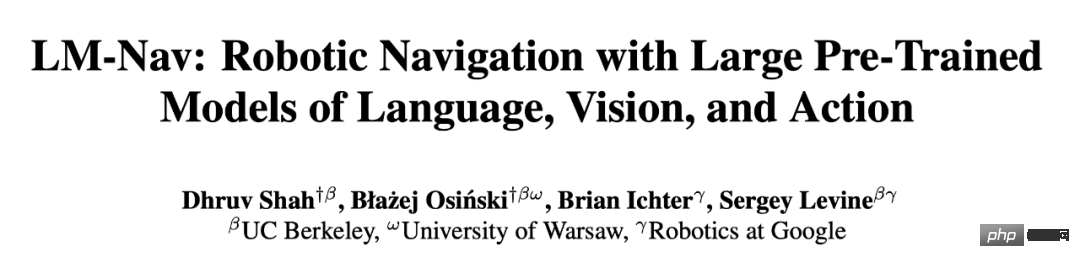

強化学習の第一人者であるセルゲイ・レヴィンの新作: 3 つの大きなモデルがロボットに自分の進むべき道を認識するよう教える

大型モデルが組み込まれたロボットは、地図を見ずに言語の指示に従って目的地に到達することを学習しました。この成果は、強化学習の専門家であるセルゲイ・レヴィン氏の新しい研究によるものです。

目的地が与えられたとき、ナビゲーション トラックなしでスムーズに目的地に到達することはどれほど難しいでしょうか?

- 論文リンク: https://arxiv.org/pdf/2207.04429.pdf

- コードリンク: https://github.com/blazejosinski/lm_nav

LM-Nav モデルの概要

では、研究者は事前トレーニングされた画像と言語モデルをどのように使用して、ビジュアル ナビゲーション モデルにテキスト インターフェイスを提供するのでしょうか?

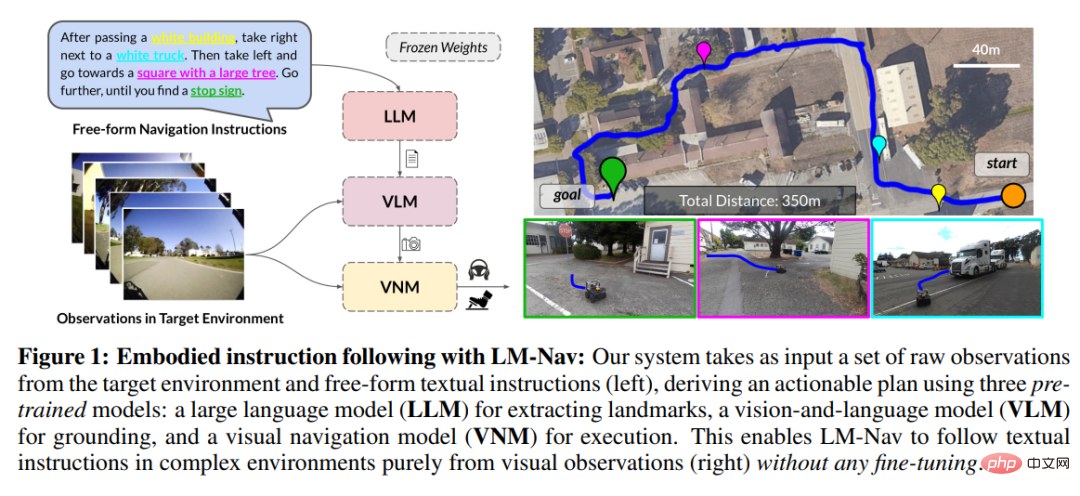

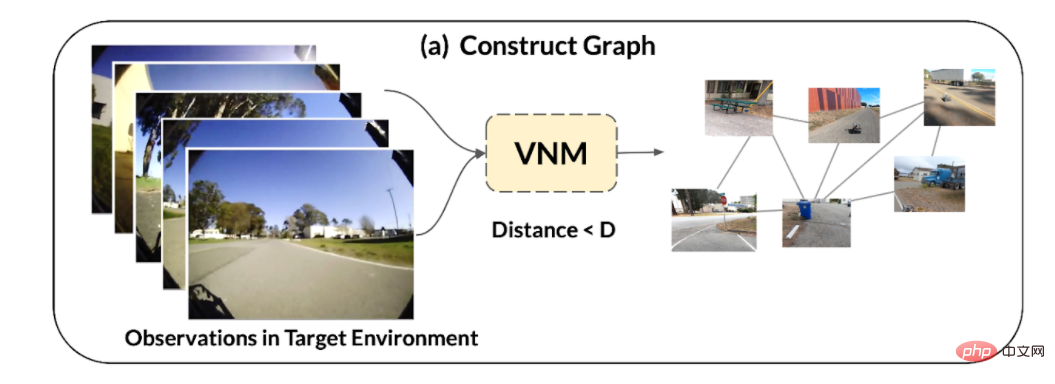

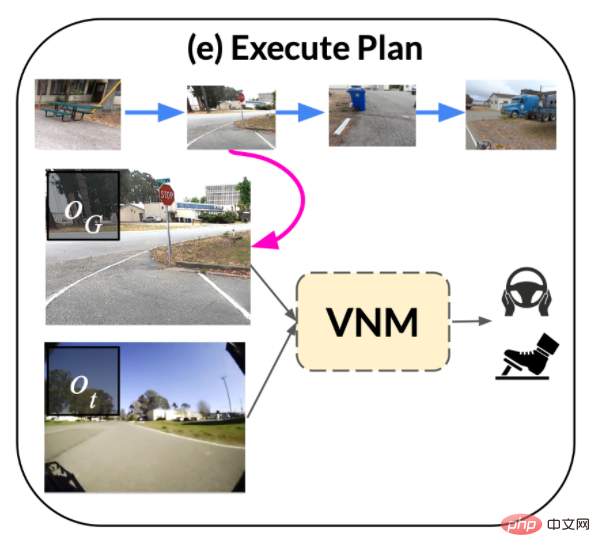

1. ターゲット環境における一連の観測結果が与えられた場合、ビジュアル ナビゲーション モデル (VNM) であるターゲットの条件付き距離関数を使用します。部分的に、それらの間の接続性を推測し、環境内の接続性のトポロジ マップを構築します。

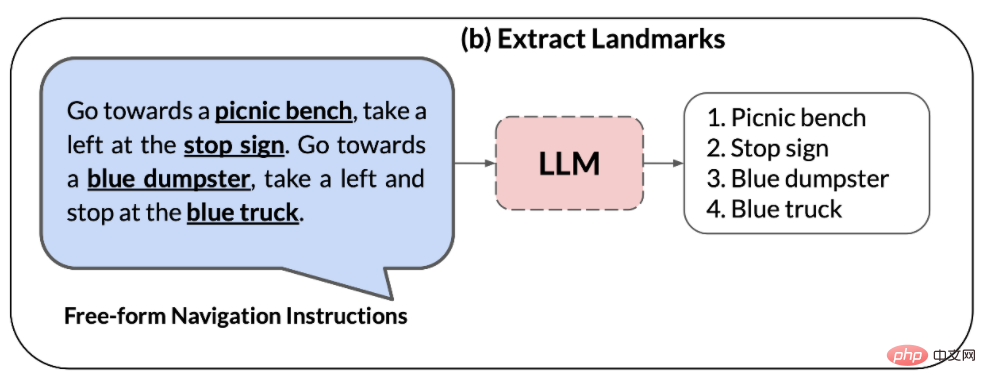

## 2. 大規模言語モデル (LLM) は、自然言語命令を一連の特徴点に解析するために使用されます。ポイントは、ナビゲーションの中間サブ目標として使用できます。

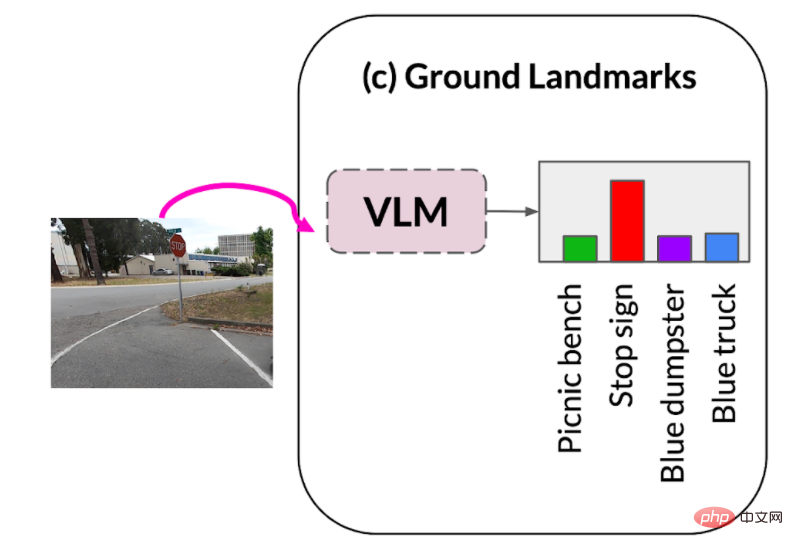

3. 視覚言語モデル (VLM) は、特徴点フレーズに基づいて視覚的な観察を確立するために使用されます。

視覚言語モデルは、特徴点の説明と画像の同時確率分布を推測します (上のグラフのノードを形成します)。

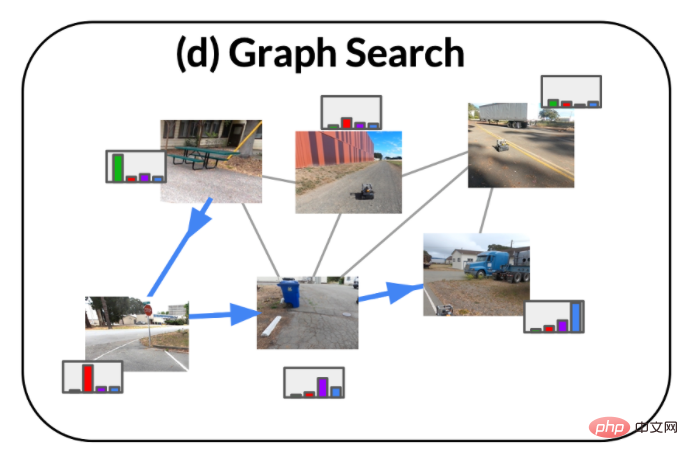

は新しい検索アルゴリズムを採用し、環境内の最適な命令パスを検索します。これは、(i) 元の命令を満たし、(ii) 目標を達成できるグラフ内の最短パスです。

命令パスは、VNM の一部であるターゲット条件ポリシーによって実行されます。

実験結果

定性的評価

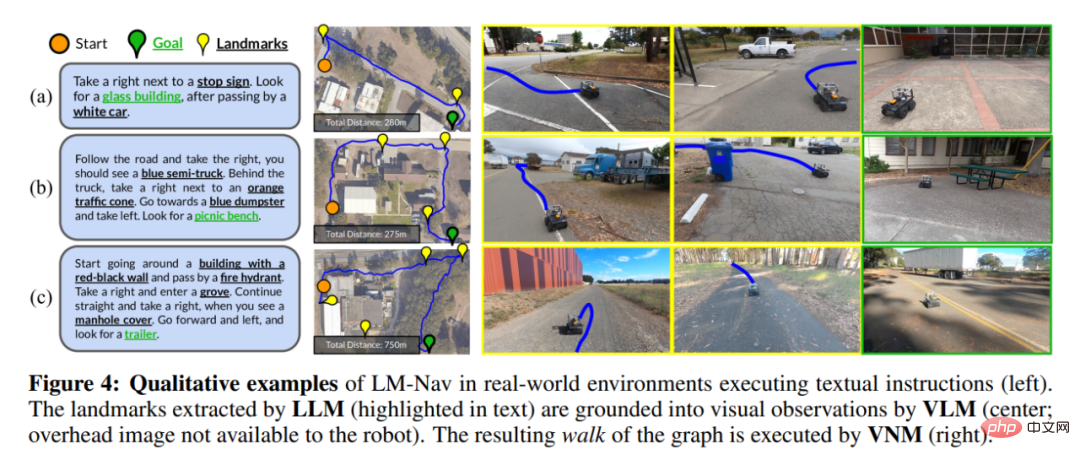

図 4 は、ロボットがたどる経路の例をいくつか示しています。 (ロボットは頭上の画像や特徴点の空間的な位置を取得することはできず、表示されるのは視覚効果のみであることに注意してください)。

図 4(a) では、LM-Nav は以前の走査から単純な特徴点を正常に特定し、ゴールまでの短いパスを見つけることができます。環境内には複数の駐車特徴点がありますが、式 3 の目的関数により、ロボットは状況に応じて正しい駐車特徴点を選択できるため、全体の移動距離が最小限に抑えられます。

図 4(a) では、LM-Nav は以前の走査から単純な特徴点を正常に特定し、ゴールまでの短いパスを見つけることができます。環境内には複数の駐車特徴点がありますが、式 3 の目的関数により、ロボットは状況に応じて正しい駐車特徴点を選択できるため、全体の移動距離が最小限に抑えられます。

図 4(b) は、複数の特徴点を持つ指定されたルートを解析する LM-Nav の機能を強調しています。たとえ指示パスを無視した場合、最後の特徴点に直接到達することが最短ルートであっても、ロボットは依然として A パスを維持します。すべての特徴点を正しい順序で訪問するものが見つかります。

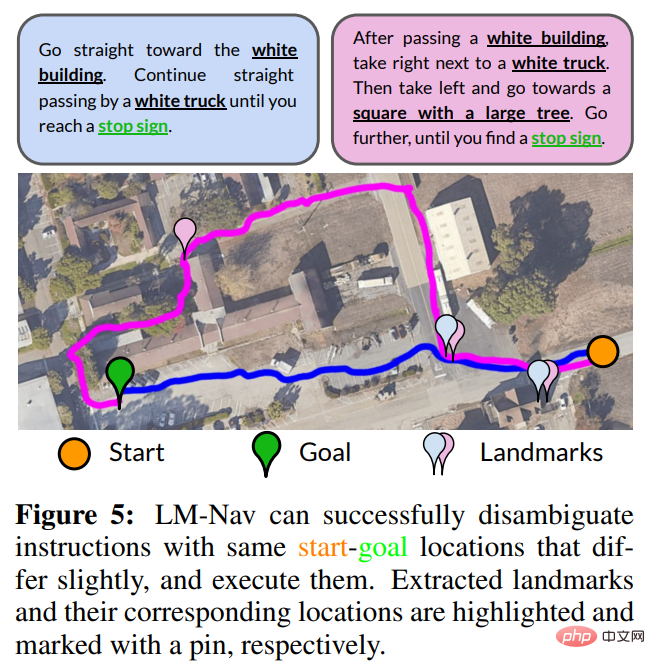

曖昧さを解消するにはディレクティブを使用します。 LM Nav の目標は、最終目標に到達するだけではなく、指示に従うことであるため、指示が異なれば、トラバースも異なる場合があります。図 5 は、命令を変更することで目標への複数のパスを明確にする例を示しています。短いプロンプト (青) の場合、LM Nav はより直接的なパスを優先します。より詳細なルート (マゼンタ) を指定すると、LM Nav はさまざまな特徴点のセットを通る代替パスを選択します。

特徴点を取得する際の VLM の有効性を独自に評価したところ、研究者らは、VLM がこの種のタスクに最適な既製モデルであるにもかかわらず、CLIP は少数の「ハード」特徴点を取得できないことを発見しました。 、消火栓やセメントミキサーなど。しかし、現実世界の多くの状況では、ロボットは依然として残りの特徴点を訪問するための経路を正常に見つけることができます。

定量的評価

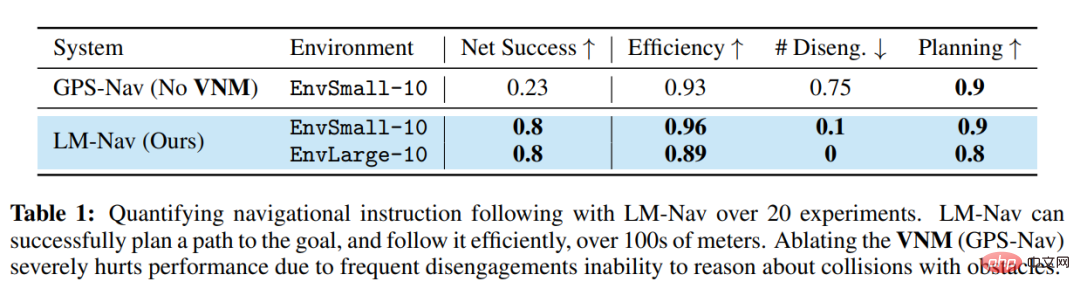

表 1 は、20 個の命令におけるシステムの定量的なパフォーマンスをまとめたものです。実験の 85% で、LM-Nav は衝突や離脱を起こすことなく一貫して指示に従うことができました (平均して 6.4 キロメートルの移動ごとに 1 回の介入)。ナビゲーション モデルのないベースラインと比較して、LM-Nav は効率的で衝突のないターゲット パスの実行において一貫して優れたパフォーマンスを発揮します。失敗したすべての実験において、失敗の原因は、計画段階での能力不足、つまり検索アルゴリズムがグラフ内の特定の「難しい」特徴点を直観的に特定できないこと、その結果、命令が不完全に実行されたことが原因であると考えられます。これらの故障モードの調査により、システムの最も重要な部分は、消火栓などの見慣れない特徴点や、露出不足の画像などの厳しい照明条件下のシーンを検出する VLM の機能であることが明らかになりました。

以上が強化学習の第一人者であるセルゲイ・レヴィンの新作: 3 つの大きなモデルがロボットに自分の進むべき道を認識するよう教えるの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7672

7672

15

15

1393

1393

52

52

1206

1206

24

24

91

91

11

11

この記事では、SHAP: 機械学習のモデルの説明について説明します。

Jun 01, 2024 am 10:58 AM

この記事では、SHAP: 機械学習のモデルの説明について説明します。

Jun 01, 2024 am 10:58 AM

機械学習とデータ サイエンスの分野では、モデルの解釈可能性が常に研究者や実務家に焦点を当ててきました。深層学習やアンサンブル手法などの複雑なモデルが広く適用されるようになったことで、モデルの意思決定プロセスを理解することが特に重要になってきました。 Explainable AI|XAI は、モデルの透明性を高めることで、機械学習モデルに対する信頼と自信を構築するのに役立ちます。モデルの透明性の向上は、複数の複雑なモデルの普及や、モデルを説明するための意思決定プロセスなどの方法によって実現できます。これらの方法には、特徴重要度分析、モデル予測間隔推定、ローカル解釈可能性アルゴリズムなどが含まれます。特徴重要度分析では、入力特徴に対するモデルの影響度を評価することで、モデルの意思決定プロセスを説明できます。モデルの予測間隔の推定

学習曲線を通じて過学習と過小学習を特定する

Apr 29, 2024 pm 06:50 PM

学習曲線を通じて過学習と過小学習を特定する

Apr 29, 2024 pm 06:50 PM

この記事では、学習曲線を通じて機械学習モデルの過学習と過小学習を効果的に特定する方法を紹介します。過小適合と過適合 1. 過適合 モデルがデータからノイズを学習するためにデータ上で過学習されている場合、そのモデルは過適合していると言われます。過学習モデルはすべての例を完璧に学習するため、未確認の新しい例を誤って分類してしまいます。過適合モデルの場合、完璧/ほぼ完璧なトレーニング セット スコアとひどい検証セット/テスト スコアが得られます。若干修正: 「過学習の原因: 複雑なモデルを使用して単純な問題を解決し、データからノイズを抽出します。トレーニング セットとしての小さなデータ セットはすべてのデータを正しく表現できない可能性があるため、2. 過学習の Heru。」

宇宙探査と人類居住工学における人工知能の進化

Apr 29, 2024 pm 03:25 PM

宇宙探査と人類居住工学における人工知能の進化

Apr 29, 2024 pm 03:25 PM

1950 年代に人工知能 (AI) が誕生しました。そのとき、研究者たちは、機械が思考などの人間と同じようなタスクを実行できることを発見しました。その後、1960 年代に米国国防総省は人工知能に資金を提供し、さらなる開発のために研究所を設立しました。研究者たちは、宇宙探査や極限環境での生存など、多くの分野で人工知能の応用を見出しています。宇宙探査は、地球を超えた宇宙全体を対象とする宇宙の研究です。宇宙は地球とは条件が異なるため、極限環境に分類されます。宇宙で生き残るためには、多くの要素を考慮し、予防策を講じる必要があります。科学者や研究者は、宇宙を探索し、あらゆるものの現状を理解することが、宇宙の仕組みを理解し、潜在的な環境危機に備えるのに役立つと信じています。

C++ での機械学習アルゴリズムの実装: 一般的な課題と解決策

Jun 03, 2024 pm 01:25 PM

C++ での機械学習アルゴリズムの実装: 一般的な課題と解決策

Jun 03, 2024 pm 01:25 PM

C++ の機械学習アルゴリズムが直面する一般的な課題には、メモリ管理、マルチスレッド、パフォーマンスの最適化、保守性などがあります。解決策には、スマート ポインター、最新のスレッド ライブラリ、SIMD 命令、サードパーティ ライブラリの使用、コーディング スタイル ガイドラインの遵守、自動化ツールの使用が含まれます。実践的な事例では、Eigen ライブラリを使用して線形回帰アルゴリズムを実装し、メモリを効果的に管理し、高性能の行列演算を使用する方法を示します。

AI はどのようにロボットをより自律的で順応性のあるものにすることができるのでしょうか?

Jun 03, 2024 pm 07:18 PM

AI はどのようにロボットをより自律的で順応性のあるものにすることができるのでしょうか?

Jun 03, 2024 pm 07:18 PM

産業オートメーション技術の分野では、人工知能 (AI) と Nvidia という無視できない 2 つの最近のホットスポットがあります。元のコンテンツの意味を変更したり、コンテンツを微調整したり、コンテンツを書き換えたり、続行しないでください。「それだけでなく、Nvidia はオリジナルのグラフィックス プロセッシング ユニット (GPU) に限定されていないため、この 2 つは密接に関連しています。」このテクノロジーはデジタル ツインの分野にまで広がり、新たな AI テクノロジーと密接に関係しています。「最近、NVIDIA は、Aveva、Rockwell Automation、Siemens などの大手産業オートメーション企業を含む多くの産業企業と提携に至りました。シュナイダーエレクトリック、Teradyne Robotics とその MiR および Universal Robots 企業も含まれます。最近、Nvidiahascoll

Cloud Whale Xiaoyao 001 の掃除と掃き掃除ロボットには「頭脳」があります。 | 経験

Apr 26, 2024 pm 04:22 PM

Cloud Whale Xiaoyao 001 の掃除と掃き掃除ロボットには「頭脳」があります。 | 経験

Apr 26, 2024 pm 04:22 PM

掃除ロボットやモップ拭きロボットは、近年消費者の間で最も人気のあるスマート家電製品の 1 つです。操作の利便性、あるいは操作の必要がないことで、怠け者は手を解放し、消費者は日常の家事から「解放」され、好きなことにもっと時間を費やすことができるようになり、生活の質が向上します。この流行に乗って、市場に出回っているほぼすべての家電ブランドが独自の掃除ロボットや拭き掃除ロボットを製造しており、掃除ロボット市場全体が非常に活発になっています。しかし、市場の急速な拡大は必然的に隠れた危険をもたらします。多くのメーカーがより多くの市場シェアを急速に占有するために機械の海戦術を使用し、その結果、アップグレードポイントのない多くの新製品が生まれるとも言われています。まさに「マトリョーシカ」モデルです。ただし、すべての掃除ロボットやモップロボットがそうであるわけではありません。

あなたが知らない機械学習の 5 つの流派

Jun 05, 2024 pm 08:51 PM

あなたが知らない機械学習の 5 つの流派

Jun 05, 2024 pm 08:51 PM

機械学習は人工知能の重要な分野であり、明示的にプログラムしなくてもコンピューターにデータから学習して能力を向上させる機能を提供します。機械学習は、画像認識や自然言語処理から、レコメンデーションシステムや不正行為検出に至るまで、さまざまな分野で幅広く応用されており、私たちの生活様式を変えつつあります。機械学習の分野にはさまざまな手法や理論があり、その中で最も影響力のある 5 つの手法は「機械学習の 5 つの流派」と呼ばれています。 5 つの主要な学派は、象徴学派、コネクショニスト学派、進化学派、ベイジアン学派、およびアナロジー学派です。 1. 象徴主義は、象徴主義とも呼ばれ、論理的推論と知識の表現のためのシンボルの使用を強調します。この学派は、学習は既存の既存の要素を介した逆演繹のプロセスであると信じています。

説明可能な AI: 複雑な AI/ML モデルの説明

Jun 03, 2024 pm 10:08 PM

説明可能な AI: 複雑な AI/ML モデルの説明

Jun 03, 2024 pm 10:08 PM

翻訳者 | Li Rui によるレビュー | 今日、人工知能 (AI) および機械学習 (ML) モデルはますます複雑になっており、これらのモデルによって生成される出力はブラックボックスになっており、関係者に説明することができません。 Explainable AI (XAI) は、利害関係者がこれらのモデルがどのように機能するかを理解できるようにし、これらのモデルが実際に意思決定を行う方法を確実に理解できるようにし、AI システムの透明性、信頼性、およびこの問題を解決するための説明責任を確保することで、この問題を解決することを目指しています。この記事では、さまざまな説明可能な人工知能 (XAI) 手法を検討して、その基礎となる原理を説明します。説明可能な AI が重要であるいくつかの理由 信頼と透明性: AI システムが広く受け入れられ、信頼されるためには、ユーザーは意思決定がどのように行われるかを理解する必要があります