AGI と ChatGPT については、Stuart Russell と Zhu Songchun がそう考えています

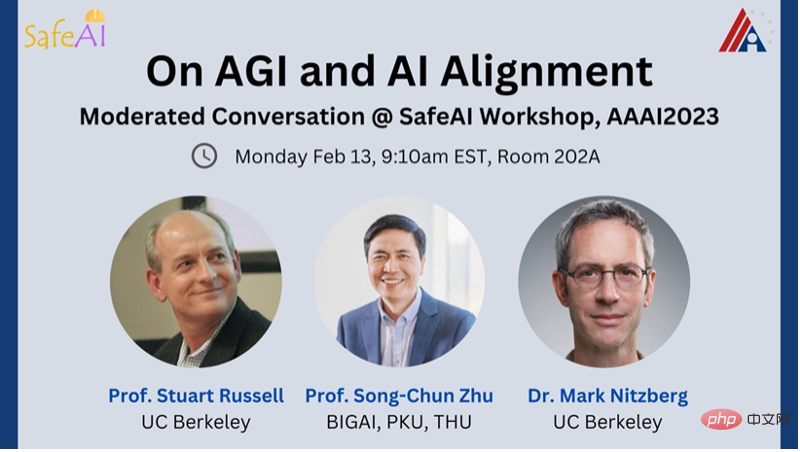

Mark Nitzberg: 本日は、人工知能のトップ専門家 2 名をこの SafeAI セミナーに招待できることを光栄に思います。

彼らは次のとおりです: スチュアート ラッセル、カリフォルニア大学バークレー校のコンピューター科学者、クラス互換人工知能センター (CHAI) 所長、運営委員会のメンバー人工知能研究所 (BAIR) の博士。世界経済フォーラムの人工知能およびロボット委員会の副委員長、AAAS フェロー、および AAAI フェロー。

Zhu Songchun は、北京総合人工知能研究所の学部長、北京大学の教授、北京大学知能学部および人工知能研究所の学部長です。清華大学の基礎科学の主席教授。

マーク・ニッツバーグ: 「汎用人工知能」とは何ですか?いつ作成されたかを判断する明確に定義されたテストはありますか?

スチュアート・ラッセル: 一般的な人工知能は、人間が完了できるすべてのタスクを完了できると説明されていますが、これは単なる概念にすぎません。一般的な声明。私たちは、すべての知識を要約したり、複雑な粒子相互作用をシミュレートしたりするなど、人間にはできないことを一般的な人工知能ができるようになると期待しています。

一般的な人工知能を研究するには、特定のタスクのベンチマークからタスク環境の一般的な属性に移行できます 部分的な可観測性、長期的、予測不可能性などの特性を考慮し、これらの特性に対する完全なソリューションを提供する能力があるかどうかを自問してください。この能力があれば、一般的な人工知能は人間が完了できるタスクを自動的に完了できるはずであり、さらに多くのタスクを完了する能力も備えているはずです。一般性をテストすると主張するいくつかのテスト (BigBench など) はありますが、「重力波検出器を発明できますか?」など、人工知能システムがアクセスできないタスクはカバーしていません

#Zhu Songchun:数年前、多くの人が汎用人工知能の実現は達成不可能な目標だと考えていましたが、最近の ChatGPT の人気により、誰もが期待に胸を膨らませており、汎用人工知能の実現は実現不可能であると感じています。知性は手の届くところにあるようです。私が中国の新しい研究開発機関である北京総合人工知能研究所(BIGAI)を設立したとき、専門的な人工知能と区別するために、機関名の一部としてAGIを使用することに特に決めました。通園語の「Tong」という単語は、「A」、「G」、「I」の 3 つの文字で構成されています。 「トン」という言葉の発音から、汎用人工知能のことをトンAIとも呼びます。

一般的な人工知能は、人工知能研究の本来の目的であり、最終的な目標です。目標は、人間の感情、倫理、道徳概念に沿った、自律的な知覚、認知、意思決定、学習、実行、および社会的コラボレーションの能力を備えた一般的な知的エージェントを実現することです。しかし、過去 20 ~ 30 年の間に、人々は膨大な機密データを使用して、顔認識、ターゲット検出、テキスト翻訳などのタスクを 1 つずつ解決するようになり、どれだけのタスクを実行できるかという問題が生じました。普遍的だと考えられますか?

#私は、一般的な人工知能を実現するには 3 つの重要な要件があると考えています。 1) 汎用エージェントは、複雑で動的な物理的および社会的環境で事前定義されていないタスクを含め、無制限のタスク # を処理できます。2) 汎用エージェントは # である必要があります。 ##Autonomous、つまり、人間のようにタスクを自分で生成して完了できる必要があります。3) 一般エージェントは、価値システムを持つ必要があります。 , その目標は価値観によって定義されるからです。インテリジェント システムは、価値システムを備えた認知アーキテクチャによって駆動されます。

Mark Nitzberg: 大規模言語モデル (LLM) やその他の基本的なタイプで一般的な人工知能を実現できると思いますか?スタンフォード大学の教授が最近書いた論文では、言語モデルは9歳児の精神状態に匹敵する精神状態を持っている可能性があると主張している。この発言についてどう思いますか?Zhu Songchun:

大規模な言語モデルでは驚くべき進歩が見られましたが、上記の 3 つの基準を比較すると、次のことがわかりました。大規模な言語モデルはまだ一般的な人工知能の要件を満たしていません。1) 大規模な言語モデルのタスク処理能力は限られており、テキスト ドメイン内のタスクのみを処理でき、物理的および社会的環境と対話することはできません。これは、ChatGPT のようなモデルは、物理空間を体験するための身体を持たないため、言語の意味を真に「理解」できないことを意味します。中国の哲学者は、「知識と行動の統一」、つまり人々の世界に関する「知識」は「行動」に基づいているという概念を長い間認識していました。これは、一般知性が実際に物理的場面や人間社会に参入できるかどうかの鍵でもあります。人工エージェントが現実の物理世界と人間社会に置かれた場合にのみ、人工エージェントは現実世界の物体間の物理的関係や、異なる知的エージェント間の社会的関係を真に理解し学習することができ、「知識と行動の統一」を達成することができます。 2) 大規模な言語モデルは自律的ではなく、訓練された発話しか真似できない「巨大なオウム」と同じように、人間が各タスクを具体的に定義する必要があります。真に自律的な知能は、「カラスの知能」に似ている必要があります。カラスは、今日の AI よりも賢いタスクを自律的に完了できます。現在の AI システムにはまだこの可能性がありません。 3) ChatGPT は、暗黙的な人間の価値観を含むテキストを含む、さまざまなテキスト データ コーパスで大規模にトレーニングされていますが、人間の価値観を理解したり、人間の価値観とコミュニケーションしたりする機能は備えていません。一貫して、道徳の羅針盤として知られるものの欠如です。 言語モデルが 9 歳児と同等の精神状態を持つ可能性があるという論文の発見に関しては、これは少し誇張されていると思います。 GPT-3.5 は、9 歳児のレベルに相当する 93% の質問に正しく答えることができるという実験テストを行っています。しかし、もしルールベースのマシンが同様のテストに合格できるとしたら、それらのマシンは心の理論を持っていると言えるでしょうか? GPT がこのテストに合格できたとしても、それはこの心の理論テストに合格する能力を反映しているだけであり、それが心の理論を持っていることを意味するものではありません。マシンが心の理論を開発したかどうかを検証するテストタスク。それは厳格かつ合法ですか?なぜ機械は心の理論なしでこれらのタスクを完了できるのでしょうか? スチュアート ラッセル: 1948 年の論文で、チューリングは巨大なルックアップ テーブルからインテリジェントなアクションを生成するという問題を提起しました。これは現実的ではありません。2000 語を生成したい場合、トランスフォーマーを利用する大規模な言語モデルのウィンドウ サイズと同様に、考えられるすべてのシーケンスを格納するには約 10^10000 のエントリを持つテーブルが必要になるからです。このようなシステムは非常に知的であるように見えるかもしれませんが、実際には精神状態と推論プロセス (古典的な人工知能システムの基本的な意味) が欠けています。 実際、ChatGPT が何らかの精神状態を持っているという証拠はなく、ましてや 9 歳児と同様の精神状態を持っているという証拠はありません。 LLM には、複雑な一般化を学習して表現する能力がありません。そのため、9 歳児が処理できるよりもはるかに多い膨大な量のテキスト データが必要になり、依然としてエラーが発生します。これは、以前のグランドマスター ゲーム (d4、c6、Nc3 など) からの同様の動きのシーケンスを認識し、そのシーケンスの次の動きを出力するチェスのプログラムに似ています。ほとんどの場合、それはチェスのマスタープレイヤーであると思われますが、ボードや駒を知らないため、または目的が相手をチェックメイトすることであるため、時折違法な動きをすることがあります。 ChatGPT は、ある程度、どの分野でもこのようなものです。本当に理解している領域があるのかどうかはわかりません。いくつかのエラーは修正される可能性がありますが、これは対数関数の値の表のエラーを修正するようなものです。 「log」を「17 ページの表の値」という意味しか理解していない人は、タイプミスを修正しても問題は解決しません。この表には「対数」の意味や定義がまだ記載されていないため、まったく推測できません。より多くのデータを追加してテーブルのサイズを拡張しても、問題の根本は解決されません。 マーク・ニッツバーグ: スチュアート、あなたは核エネルギーのような一般的な人工知能によってもたらされる実存的リスクについて私たちに最初に警告した一人です。どうしてそう思うの?これを防ぐにはどうすればよいでしょうか?松角さんは、人工知能によるどのようなリスクを最も懸念していますか? ################################## スチュアート・ラッセル: 実際、チューリングは最初に警告した人物の一人でした。彼は 1951 年にこう言いました: 「機械が一度考え始めると、すぐに私たちを追い越すでしょう。したがって、ある時点で、私たちは機械を使いこなすことができると期待する必要があります。」 なぜなら、人間よりも強力な知性が出現すると、人間は特にこれらのエージェントが間違った、または不完全な目標を持っている場合、権力を維持することは困難です。 これらのリスクを今考えるのは憂慮すべきだと思う人がいるなら、直接尋ねてみてください。人間よりも強力な知性を前に、どうやって永遠に権力を維持するのですか?ぜひ彼らの答えを聞きたいです。さらに、人工知能の分野では、証拠を示さずにこの問題を回避し、AGI の実現可能性を否定しようとする人々が依然としています。 EU 人工知能法は、人間が定義した目標を達成できる標準的な人工知能システムを定義しています。この規格は OECD から来ていると聞きましたが、OECD 関係者は、これは私の教科書の以前のバージョンから来ていると言いました。さて、私は、AI システムの 標準定義には根本的な欠陥があると考えています。なぜなら、現実世界で AI に何をしてもらいたいのかを完全に正確に表現することはできませんし、AI に望むことを正確に説明することもできないからです。現実世界でやるべきこと。未来はどのようなものになるでしょうか。。間違った目標を追求する AI システムは、私たちが望まない未来をもたらします。 ソーシャル メディアのレコメンダー システムはその一例です。レコメンダー システムはクリックスルー率やエンゲージメントを最大化しようとしますが、人間を操作することでこれを行うことを学習し、人間をより予測可能な、より予測可能な人間に変えます。一連のプロンプトを通じて、明らかに自分自身のより極端なバージョンが表示されます。 AI を「より良く」しても、人間の結果は悪化するだけです。 代わりに、1) 人間の利益のみを目的とし、2) それが何を意味するのか理解していないことを明確にする AI システムを構築する必要があります。 。 AI は人間の利益の本当の意味を理解していないため、人間の好みを制御し続けるためには、AI は人間の好みについて不確実なままでなければなりません。機械は、人間の好みがわからない場合にはシャットダウンできる必要があります。 AI の目標について不確実性がなくなると、間違いを犯すのは人間となり、機械の電源を切ることはできなくなります。 朱松春:汎用人工知能が現実になれば、長期的には人類の存在に脅威を与える可能性があります。知能進化の長い歴史を振り返ると、一般的な人工知能の誕生はほぼ必然であることが推測できます。 将来の汎用人工知能が人類に脅威をもたらすことを防ぐために、私たちは汎用知能の能力空間と価値空間を段階的に開放することができます。 私たちがロボットと対峙するとき、最初はロボットを「檻」に入れ、徐々に許可を開放していったのと同じように、現在、自動運転車が特定の道路区間に登場しています。まず、人工知能システムの適用可能な機会と行動空間を特定の領域に制限できます。機械に対する信頼が高まり、AI システムが安全で制御可能であることを確認した後、徐々に機械にスペースを与えていきます。さらに、アルゴリズムによる意思決定プロセスの透明性を促進する必要があります。一般的な人工知能の認知アーキテクチャを明示的に表現でき、それがどのように機能するかを知ることができれば、人工知能をより適切に制御できるようになります。 スチュアート ラッセル: CHAI の中心的な目標は、上記のビジョンを達成することであり、目標の不確実性を処理できる人工知能システムを構築することです 。おそらく模倣学習を除いて、既存の手法はすべて、人工知能システムの既知の固定目標を事前に想定しているため、これらの手法は再設計する必要があるかもしれません。 つまり、複数の人間と複数のマシンが対話するシステムをシミュレートしようとしています。誰もが自分の好みを持っていますが、機械は多くの人に影響を与える可能性があるため、機械の効用関数を人々の効用関数の合計として定義します。しかし、私たちは 3 つの問題に直面しています。 #最初の質問は、マシンがほとんどの人のニーズを理解して満たせるように、さまざまな人々の好みをどのように集約するかです。 。誰もが均等に重み付けされ、形式のセンスが優れているため、加算は優れた集計関数である可能性があることが示唆されており、これは経済学者のジョン ハーサニーらの研究でよく実証されています。しかし、別の視点もあるはずだ。 2 番目の質問は、選好構造の豊かさをどのように特徴付けるか、つまり、宇宙の考えられるすべての未来にわたる分布の順序をどのように特徴づけるかです。これらは非常に複雑です。データ構造は人間の脳や機械では明示的に表現されません。したがって、設定を効率的に並べ替え、分解し、結合する方法が必要です。

#3 番目の質問は、人間の行動から好みを推測し、人間の好みの可塑性を特徴付ける方法です。 時間の経過とともに好みが変わるとしたら、AI は誰のために働いているのでしょうか? 今日のあなた、それとも明日のあなた?私たちは、人工知能が簡単に達成できる世界状態に合わせて私たちの好みを変えることを望んでいません。それによって世界の多様性が失われることになります。 これは現実の世界ではごく普通のことです。たとえば、タクシーの運転手に「空港まで送って」と頼みます。これは実際には、私たちの本当の目標よりも広い目標です。 1マイル離れたところで、運転手はどのターミナルが必要か尋ねました。私たちが近づくと、運転手はどの航空会社に私たちを正しいゲートに連れて行ってくれるのか尋ねるかもしれません。 (ただし、ドアから正確に何ミリメートルというわけではありません!) したがって、特定のクラスのアルゴリズムに最適な不確実性と優先度の伝達の形式を定義する必要があります。たとえば、検索アルゴリズムはコスト関数を使用するため、マシンはその関数の境界を仮定し、2 つのアクションのシーケンスのうちどちらがより適切であるかを人間に尋ねることによって境界を調整します。 一般に、機械は人間の好みについて常に多大な不確実性を持っています。このため、この分野でよく使用される「調整」という用語は誤解を招く可能性があると思います。それは、「まず機械と人間の好みを完全に調整してから、何をするかを選択する」ことを意味すると考えます。実際にはそうではないかもしれません。 Mark Nitzberg: Songzhun さん、あなたが行った価値観調整研究を紹介してください。 Zhu Songchun: 価値の調整について語るとき、まず「価値」について議論する必要がありますが、私は現在の人工知能研究はデータ駆動型から価値駆動型に変わるべきだと考えています。人々のさまざまな知的な行動は価値によって動かされており、人々は価値をすぐに理解して学ぶことができます。例えば、椅子に座ったとき、椅子と身体との接触を力解析することで平衡状態を観察し、「快適さ」の価値を暗黙的に推測することができます。この価値は言葉では正確に説明できないかもしれませんが、椅子との対話によって表現することができます。また、服のたたみ方からも人々の美的価値を知ることができます。 #さらに、私は、価値体系には統一された一連の表現があり、現在の嗜好の豊かさは統一された価値観のマッピングによるものだと信じています。さまざまな条件で。 バスが停留所に到着するなど、状況に応じて価値は変わります。バスを待っている場合は、バスをもっと長く待ってほしいと思うかもしれません。一方、車に乗っている場合は、ドアをすぐに閉めたいと思うかもしれません。 AI システムは、私たちの好みの変化に迅速に適応できなければならないため、AI には価値主導型のコグニティブ アーキテクチャが不可欠です。 人間の認知レベルで一般的な知能を実現するために、私たちは BIGAI 研究に価値観の調整の要素を組み込み、4 つの調整を含む人間とコンピューターの対話システムを構築しました。 最初の調整は、世界についての共通理解を含む共有表現です。 2 番目の調整は、物理学の常識、因果関係の連鎖、論理など、核となる知識の共有です。 3 番目の調整は共有された社会規範であり、AI は人間社会の規範に従い、適切な行動を維持する必要があると規定されています。 4 番目の整合性は、AI が人間の倫理原則と整合する必要があるという共通の価値観です。 私たちは、リアルタイムの双方向の人間とロボットの価値の調整に関する研究を発表しました。この研究は説明可能な人工知能システムを提案します。このシステムでは、ロボット群がユーザーとのリアルタイムのインタラクションやユーザーからのフィードバックを通じてユーザーの価値目標を推測するとともに、その価値を理解するためにロボット群の意思決定プロセスを「説明」を通じてユーザーに伝えます。ロボットの判断基準となります。さらに、ユーザーの本質的な価値観の好みを推測し、最適な説明方法を予測することで、ユーザーにとって理解しやすい説明を生成します。 Mark Nitzberg: AI システムのどのような特徴から、一般的な人工知能にはつながらないという結論に至るのでしょうか? Zhu Songchun: AI が一般的な人工知能であるかどうかをどのように判断するのでしょうか? 重要な要素の 1 つは、AI をどれだけ信頼するかです。 信頼には 2 つのレベルがあります。1 つは AI の機能に対する信頼、もう 1 つは AI が人々の感情や価値観にとって有益であるかどうかに対する信頼です。 たとえば、今日の人工知能システムは写真を非常によく認識できますが、信頼を築くためには、写真が説明可能で理解できるものでなければなりません。一部のテクノロジーは非常に強力ですが、説明できない場合は信頼できないものとみなされます。これは、間違いによる代償が大きい兵器や航空システムなどの分野では特に重要です。この場合、信頼の感情的な側面がより重要になり、AI は人間から信頼されるためにどのように意思決定を行うかを説明する必要があります。したがって、人間と機械の間の反復、コミュニケーション、コラボレーションを通じて相互理解を強化し、合意に達して「正当な信頼」を生み出す必要があります。 スチュアート・ラッセル: 現在の人工知能システムは、回路が普遍性をうまく捉えることができないため、普遍的ではありません。これは、大規模な言語モデルが算術の基本的な規則を学習するのが難しいという点ですでに見てきました。私たちの最新の研究では、何百万もの例があるにもかかわらず、これまで人間に勝った人工知能囲碁システムは「大きな竜」と「生死」の概念を正しく理解できないことが判明しました。私たちはアマチュア囲碁棋士の研究者として、ある戦略を開発しました。囲碁プログラムを破った。 人工知能が人類にとって有益であると確信しているのであれば、それがどのように機能するかを知る必要があります。将来的に一般的な人工知能を実現するには、明示的な論理と確率論によってサポートされ、優れた基盤として機能する意味論的に構成可能な基板上に人工知能システムを構築する必要があります。このようなシステムを作成する可能性のある方法の 1 つは、CHAI が最近探求しようとしているものである確率的プログラミングです。松住さんがBIGAIと同じような方向性を模索しているのを見て勇気づけられました。

以上がAGI と ChatGPT については、Stuart Russell と Zhu Songchun がそう考えていますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7342

7342

9

9

1627

1627

14

14

1352

1352

46

46

1265

1265

25

25

1210

1210

29

29

Bytedance Cutting が SVIP スーパー メンバーシップを開始: 継続的な年間サブスクリプションは 499 元で、さまざまな AI 機能を提供

Jun 28, 2024 am 03:51 AM

Bytedance Cutting が SVIP スーパー メンバーシップを開始: 継続的な年間サブスクリプションは 499 元で、さまざまな AI 機能を提供

Jun 28, 2024 am 03:51 AM

このサイトは6月27日、JianyingはByteDanceの子会社であるFaceMeng Technologyによって開発されたビデオ編集ソフトウェアであり、Douyinプラットフォームに依存しており、基本的にプラットフォームのユーザー向けに短いビデオコンテンツを作成すると報告しました。 Windows、MacOS、その他のオペレーティング システム。 Jianyingは会員システムのアップグレードを正式に発表し、インテリジェント翻訳、インテリジェントハイライト、インテリジェントパッケージング、デジタルヒューマン合成などのさまざまなAIブラックテクノロジーを含む新しいSVIPを開始しました。価格的には、クリッピングSVIPの月額料金は79元、年会費は599元(当サイト注:月額49.9元に相当)、継続月額サブスクリプションは月額59元、継続年間サブスクリプションは、年間499元(月額41.6元に相当)です。さらに、カット担当者は、ユーザーエクスペリエンスを向上させるために、オリジナルのVIPに登録している人は、

Rag と Sem-Rag を使用したコンテキスト拡張 AI コーディング アシスタント

Jun 10, 2024 am 11:08 AM

Rag と Sem-Rag を使用したコンテキスト拡張 AI コーディング アシスタント

Jun 10, 2024 am 11:08 AM

検索強化生成およびセマンティック メモリを AI コーディング アシスタントに組み込むことで、開発者の生産性、効率、精度を向上させます。 JanakiramMSV 著者の EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG から翻訳。基本的な AI プログラミング アシスタントは当然役に立ちますが、ソフトウェア言語とソフトウェア作成の最も一般的なパターンに関する一般的な理解に依存しているため、最も適切で正しいコードの提案を提供できないことがよくあります。これらのコーディング アシスタントによって生成されたコードは、彼らが解決する責任を負っている問題の解決には適していますが、多くの場合、個々のチームのコーディング標準、規約、スタイルには準拠していません。これにより、コードがアプリケーションに受け入れられるように修正または調整する必要がある提案が得られることがよくあります。

GenAI および LLM の技術面接に関する 7 つのクールな質問

Jun 07, 2024 am 10:06 AM

GenAI および LLM の技術面接に関する 7 つのクールな質問

Jun 07, 2024 am 10:06 AM

AIGC について詳しくは、51CTOAI.x コミュニティ https://www.51cto.com/aigc/Translator|Jingyan Reviewer|Chonglou を参照してください。これらの質問は、インターネット上のどこでも見られる従来の質問バンクとは異なります。既成概念にとらわれずに考える必要があります。大規模言語モデル (LLM) は、データ サイエンス、生成人工知能 (GenAI)、および人工知能の分野でますます重要になっています。これらの複雑なアルゴリズムは人間のスキルを向上させ、多くの業界で効率とイノベーションを推進し、企業が競争力を維持するための鍵となります。 LLM は、自然言語処理、テキスト生成、音声認識、推奨システムなどの分野で幅広い用途に使用できます。 LLM は大量のデータから学習することでテキストを生成できます。

微調整によって本当に LLM が新しいことを学習できるようになるのでしょうか: 新しい知識を導入すると、モデルがより多くの幻覚を生成する可能性があります

Jun 11, 2024 pm 03:57 PM

微調整によって本当に LLM が新しいことを学習できるようになるのでしょうか: 新しい知識を導入すると、モデルがより多くの幻覚を生成する可能性があります

Jun 11, 2024 pm 03:57 PM

大規模言語モデル (LLM) は巨大なテキスト データベースでトレーニングされ、そこで大量の現実世界の知識を取得します。この知識はパラメータに組み込まれており、必要なときに使用できます。これらのモデルの知識は、トレーニングの終了時に「具体化」されます。事前トレーニングの終了時に、モデルは実際に学習を停止します。モデルを調整または微調整して、この知識を活用し、ユーザーの質問により自然に応答する方法を学びます。ただし、モデルの知識だけでは不十分な場合があり、モデルは RAG を通じて外部コンテンツにアクセスできますが、微調整を通じてモデルを新しいドメインに適応させることが有益であると考えられます。この微調整は、ヒューマン アノテーターまたは他の LLM 作成物からの入力を使用して実行され、モデルは追加の実世界の知識に遭遇し、それを統合します。

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

編集者 |ScienceAI 質問応答 (QA) データセットは、自然言語処理 (NLP) 研究を促進する上で重要な役割を果たします。高品質の QA データ セットは、モデルの微調整に使用できるだけでなく、大規模言語モデル (LLM) の機能、特に科学的知識を理解し推論する能力を効果的に評価することもできます。現在、医学、化学、生物学、その他の分野をカバーする多くの科学 QA データ セットがありますが、これらのデータ セットにはまだいくつかの欠点があります。まず、データ形式は比較的単純で、そのほとんどが多肢選択式の質問であり、評価は簡単ですが、モデルの回答選択範囲が制限され、科学的な質問に回答するモデルの能力を完全にテストすることはできません。対照的に、自由回答型の Q&A

SOTA パフォーマンス、厦門マルチモーダルタンパク質-リガンド親和性予測 AI 手法、初めて分子表面情報を結合

Jul 17, 2024 pm 06:37 PM

SOTA パフォーマンス、厦門マルチモーダルタンパク質-リガンド親和性予測 AI 手法、初めて分子表面情報を結合

Jul 17, 2024 pm 06:37 PM

編集者 | KX 医薬品の研究開発の分野では、タンパク質とリガンドの結合親和性を正確かつ効果的に予測することが、医薬品のスクリーニングと最適化にとって重要です。しかし、現在の研究では、タンパク質とリガンドの相互作用における分子表面情報の重要な役割が考慮されていません。これに基づいて、アモイ大学の研究者らは、初めてタンパク質の表面、3D 構造、配列に関する情報を組み合わせ、クロスアテンション メカニズムを使用して異なるモダリティの特徴を比較する、新しいマルチモーダル特徴抽出 (MFE) フレームワークを提案しました。アライメント。実験結果は、この方法がタンパク質-リガンド結合親和性の予測において最先端の性能を達成することを実証しています。さらに、アブレーション研究は、この枠組み内でのタンパク質表面情報と多峰性特徴の位置合わせの有効性と必要性を実証しています。 「S」で始まる関連研究

あなたが知らない機械学習の 5 つの流派

Jun 05, 2024 pm 08:51 PM

あなたが知らない機械学習の 5 つの流派

Jun 05, 2024 pm 08:51 PM

機械学習は人工知能の重要な分野であり、明示的にプログラムしなくてもコンピューターにデータから学習して能力を向上させる機能を提供します。機械学習は、画像認識や自然言語処理から、レコメンデーションシステムや不正行為検出に至るまで、さまざまな分野で幅広く応用されており、私たちの生活様式を変えつつあります。機械学習の分野にはさまざまな手法や理論があり、その中で最も影響力のある 5 つの手法は「機械学習の 5 つの流派」と呼ばれています。 5 つの主要な学派は、象徴学派、コネクショニスト学派、進化学派、ベイジアン学派、およびアナロジー学派です。 1. 象徴主義は、象徴主義とも呼ばれ、論理的推論と知識の表現のためのシンボルの使用を強調します。この学派は、学習は既存の既存の要素を介した逆演繹のプロセスであると信じています。

SKハイニックスは8月6日に12層HBM3E、321層NANDなどのAI関連新製品を展示する。

Aug 01, 2024 pm 09:40 PM

SKハイニックスは8月6日に12層HBM3E、321層NANDなどのAI関連新製品を展示する。

Aug 01, 2024 pm 09:40 PM

8月1日の本サイトのニュースによると、SKハイニックスは本日(8月1日)ブログ投稿を発表し、8月6日から8日まで米国カリフォルニア州サンタクララで開催されるグローバル半導体メモリサミットFMS2024に参加すると発表し、多くの新世代の製品。フューチャー メモリおよびストレージ サミット (FutureMemoryandStorage) の紹介。以前は主に NAND サプライヤー向けのフラッシュ メモリ サミット (FlashMemorySummit) でしたが、人工知能技術への注目の高まりを背景に、今年はフューチャー メモリおよびストレージ サミット (FutureMemoryandStorage) に名前が変更されました。 DRAM およびストレージ ベンダー、さらに多くのプレーヤーを招待します。昨年発売された新製品SKハイニックス