Transformer は強化学習においてどこまで発展しましたか?清華大学、北京大学などが共同でTransformRLのレビューを発表

強化学習 (RL) は、逐次的な意思決定のための数学的形式を提供し、深層強化学習 (DRL) も近年大きな進歩を遂げています。ただし、サンプル効率の問題により、現実世界における深層強化学習手法の広範な適用が妨げられています。この問題を解決するための効果的なメカニズムは、DRL フレームワークに誘導バイアスを導入することです。

深層強化学習では、関数近似器が非常に重要です。ただし、教師あり学習 (SL) のアーキテクチャ設計と比較して、DRL のアーキテクチャ設計の問題はまだほとんど研究されていません。 RL アーキテクチャに関する既存の作業のほとんどは、教師あり/半教師あり学習コミュニティによって推進されています。たとえば、DRL で高次元画像に基づいて入力を処理する場合、一般的なアプローチは、畳み込みニューラル ネットワーク (CNN) [LeCun et al., 1998; Mnih et al., 2015] を導入し、部分的な可観測性 (部分的な可観測性) に対処することです。画像に対する一般的なアプローチは、リカレント ニューラル ネットワーク (RNN) を導入することです [Hochreiter および Schmidhuber、1997; Hausknecht および Stone、2015]。

近年、Transformer アーキテクチャ [Vaswani et al., 2017] は CNN や RNN よりも優れたパフォーマンスを示しており、ますます多くの SL タスクで学習パラダイムとなっています [Devlin]ら、2018; Dosovitskiy ら、2020; Dong ら、2018]。 Transformer アーキテクチャは、長距離の依存関係のモデリングをサポートし、優れたスケーラビリティを備えています [Khan et al., 2022]。 SL の成功に触発されて、人々は Transformer を強化学習に適用することに強い関心を持ち、Transformer の利点を RL の分野に適用することを望んでいます。

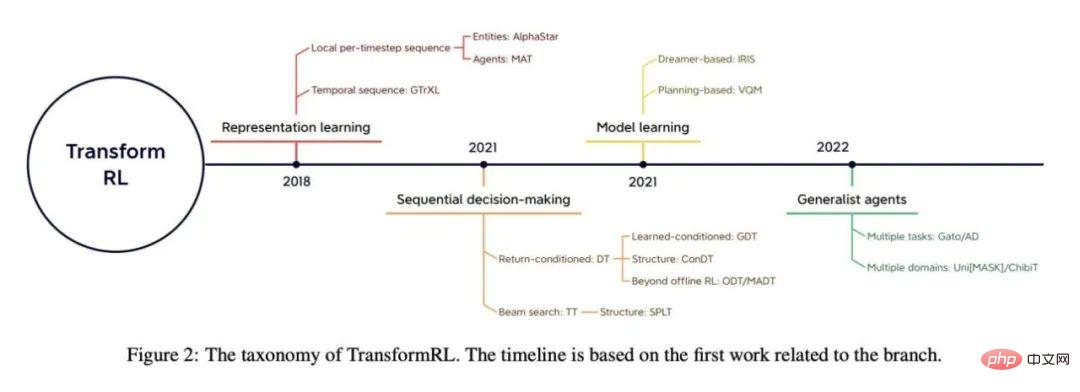

RL での Transformer の使用は、2018 年の Zambaldi らによる研究にまで遡ることができ、そこでは自己注意メカニズムを使用して状態表現間の関係を構造化しました。推論。その後、多くの研究者が、自己注意を表現学習に適用して、より良いポリシー学習のためにエンティティ間の関係を抽出しようとしました [Vinyals et al., 2019; Baker et al., 2019]。

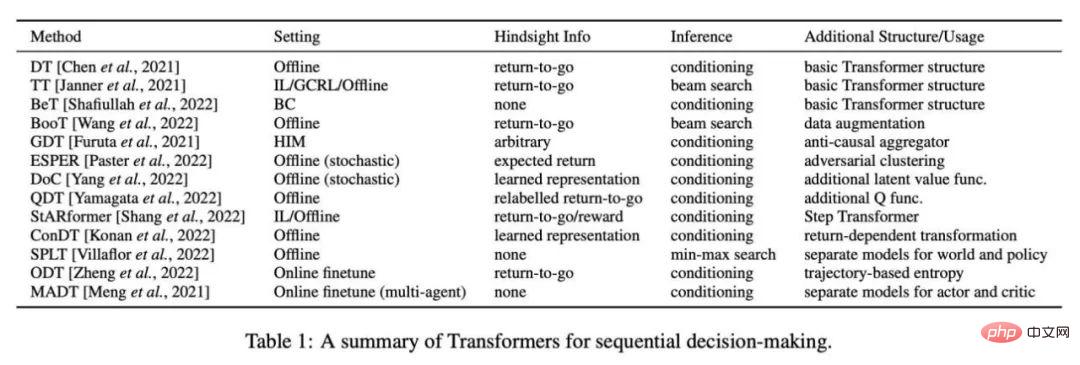

以前の研究では、表現学習に Transformer を使用することに加えて、部分的な可観測性の問題に対処するために多時間依存関係をキャプチャするために Transformer も使用していました [Parisotto et al., 2020; Parisotto and Salakhutdinov, 2021年】。 Offline RL [Levine et al., 2020] は、オフラインの大規模データセットを使用できる機能で注目を集めています。オフライン RL に触発された最近の研究では、Transformer 構造が逐次的な意思決定のモデルとして直接使用でき [Chen et al., 2021; Janner et al., 2021]、複数のタスクや分野に一般化できることが示されています [Lee et al.] ., 2022;Carroll et al., 2022]。

実際、Transformer を強化学習の関数近似器として使用すると、次のようないくつかの特別な課題に直面します。

- 強化学習のトレーニングエージェントのデータは通常、現在のポリシーの関数であるため、Transformer の学習時に非定常性が生じます。

- 既存の RL アルゴリズムは、通常、トレーニング中の設計の選択に非常に敏感です。モデル アーキテクチャとモデル容量 [Henderson et al., 2018];

- Transformer ベースのアーキテクチャは、多くの場合、高性能コンピューティングとメモリのコストによって制限され、トレーニングと推論の両方がRL 学習プロセスは高価です。

たとえば、ビデオ ゲーム用 AI では、サンプル生成の効率 (トレーニングのパフォーマンスに大きく影響します) は、RL ポリシー ネットワークと評価ネットワークに依存します (バリューネットワーク)[Ye et al., 2020a; Berner et al., 2019]。

強化学習分野の発展をより促進するために、清華大学、北京大学、知源人工知能研究所、テンセントの研究者が共同で強化学習に関する記事を発表しました。 Transformer (つまり、TransformRL) のレビュー ペーパーでは、現在の既存の手法と課題を要約し、今後の開発の方向性について説明しています。著者は、TransformRL が強化学習の可能性を刺激する上で重要な役割を果たすと信じています。

#論文アドレス: https://arxiv.org/pdf/2301.03044.pdf

- 第 2 章では、RL と Transformer の背景知識を紹介し、次にその 2 つがどのように組み合わされるかを簡単に紹介します;

- 第 3 章では、ネットワーク アーキテクチャの進化について説明しますRL におけるトランスフォーマー アーキテクチャと、RL におけるトランスフォーマー アーキテクチャの広範な探索を長い間妨げてきた課題について説明します。 ##第 4 章では、著者は RL におけるトランスフォーマーを分類し、現在の代表的な手法を要約して説明します。

- 第 5 章では、将来の研究の可能性のある方向性を要約し、指摘します。

RL におけるネットワーク アーキテクチャ

TransformRL の分類方法を紹介する前に、この論文では RL におけるネットワーク アーキテクチャ設計の初期の進歩をレビューし、既存の課題を要約します。著者は、Transformer は深層強化学習 (DRL) の開発に貢献する高度なニューラル ネットワーク アーキテクチャであると信じています。

関数近似器のアーキテクチャ

Deep Q-Network の創設以来 [Mnih et al., 2015 年] セックスワークの出現以来、DRL エージェントのネットワーク アーキテクチャに関して多くの努力が払われてきました。強化学習におけるネットワーク アーキテクチャの改善は、主に 2 つのカテゴリに分類されます。1 つのタイプは、新しい構造を設計し、RL 帰納バイアスを組み合わせて、トレーニング戦略や価値関数の難しさを軽減するものです。たとえば、[Wang et al. 2016] は、一方のネットワークが状態値関数に使用され、もう一方のネットワークが状態関連アクションの利点関数に使用される、誘導バイアスを組み合わせた決闘ネットワーク アーキテクチャを提案しました。

もう 1 つのタイプは、一般的に使用されるニューラル ネットワーク技術 (正則化、スキップ接続、バッチ正規化など) が RL に適用できるかどうかを研究することです。たとえば、[Ota et al. 2020] は、オンライン特徴抽出器を使用して状態表現を強化しながら入力次元を増やすと、DRL アルゴリズムのパフォーマンスとサンプル効率の向上に役立つ可能性があることを発見しました。 [Sinha et al. 2020] は、効率的な学習のための残余接続と、データ処理の不平等問題を緩和するための帰納的バイアスを使用する、DRL エージェント用の高密度アーキテクチャを提案しました。 [Ota et al. 2021] は、DenseNet [Huang et al., 2017] と分離表現学習を使用して、大規模ネットワークにおける情報の流れと勾配を改善しています。最近、Transformer の優れたパフォーマンスにより、研究者は Transformer アーキテクチャをポリシー最適化アルゴリズムに適用しようとしましたが、通常の Transformer 設計では RL タスクで理想的なパフォーマンスを達成できないことがわかりました [Parisotto et al., 2020]。

課題

Transformer ベースのアーキテクチャは、ここ数年で SL 分野で大きな進歩を遂げてきましたが、何年もの間、トランスフォーマーを RL に適用するのは簡単ではありません。実際、いくつかの特有の課題があります。RL の観点から見ると、既存の RL アルゴリズムはディープ ニューラル ネットワークのアーキテクチャに非常に敏感であることが多くの研究で指摘されています [Henderson et al., 2018; Engstrom et al., 2019; Andrychowicz 他、2020]。まず、RL におけるデータ収集とポリシー最適化の間のパラダイムの切り替えにより、トレーニングが不安定になります。第 2 に、RL アルゴリズムは多くの場合、トレーニング中に行われた設計の選択に非常に敏感です。 [Emmons et al. 2021] は、モデル アーキテクチャと正則化を慎重に選択することが DRL エージェントのパフォーマンスにとって重要であることを示しています。

Transformer の観点から見ると、Transformer ベースのアーキテクチャは、メモリ フットプリントが大きく、遅延が長いという問題があり、効率的な展開と推論が妨げられます。最近、元の Transformer アーキテクチャの計算効率とメモリ効率の向上を中心に多くの研究が行われていますが、この研究のほとんどは SL ドメインに焦点を当てています。

RL の分野では、Parisotto と Salakhutdinov が、Transformer の大きな推論遅延を回避するために、大容量の Transformer に基づく学習者モデルを小容量のアクター モデルに変換することを提案しました。ただし、このアプローチはメモリと計算の点で依然として高価です。現在、効率的または軽量のトランスフォーマーは、RL コミュニティによって十分に検討されていません。

強化学習における Transformer

Transformer は、ほとんどの教師あり学習研究の基本モデルとなっていますが、RL コミュニティでは長い間広く使用されていませんでした。前述の課題に対処します。実際、TransformRL の初期の試みのほとんどでは、状態表現の学習やメモリ情報の提供に Transformer を使用し、同時に時間差分学習やポリシー最適化などのエージェント学習には標準の RL アルゴリズムを使用していました。したがって、関数近似器としての Transformer の導入にも関わらず、これらの手法は依然として従来の RL フレームワークによる課題を抱えています。最近まで、オフライン RL により、大規模なオフライン データから最適なポリシーを学習することが可能でした。オフライン RL に触発された最近の研究では、RL 問題を固定エクスペリエンスを備えた条件付きシーケンス モデリング問題としてさらに扱います。これにより、従来の RL におけるブートストラップ エラーの課題を回避でき、Transformer アーキテクチャの強力なシーケンシャル モデリング機能を解放できるようになります。

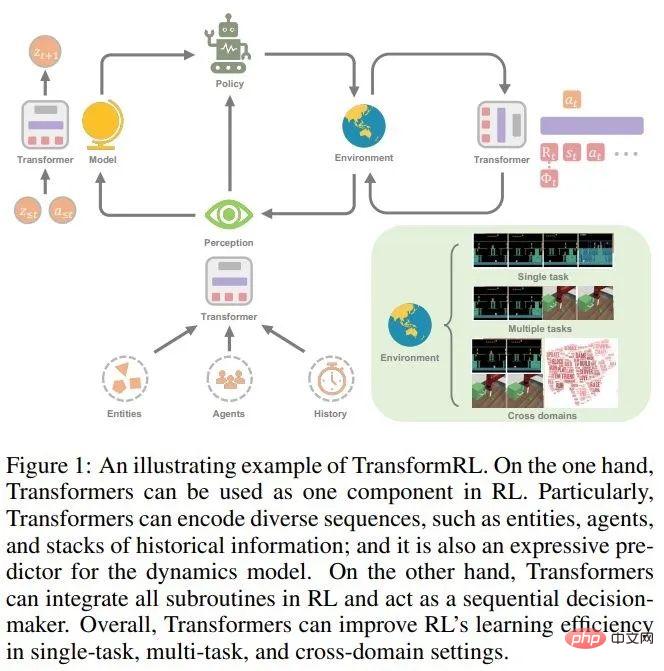

この論文では、TransformRL の進歩をレビューし、既存のメソッドを分類別に示します。著者らは既存の手法を、表現学習、モデル学習、逐次意思決定、汎用エージェントの 4 つのカテゴリに分類しています。図 2 に、関連する分類の概要を示します。

#表現学習のためのトランスフォーマー

検討中RL タスクの逐次的な性質を考慮すると、Transformer エンコーダ モジュールを使用するのが合理的です。実際、RL タスクでは、タイムステップごとのローカル シーケンス (マルチエンティティ シーケンス [Vinyals et al., 2019; Baker et al., 2019])、マルチエージェント シーケンス [Wen et al., 2019] など、さまざまなシーケンスを処理する必要があります。 、2022])、時系列([Parisotto et al.、2020; Banino et al.、2021])など。

タイムステップごとのローカル シーケンス エンコーダー

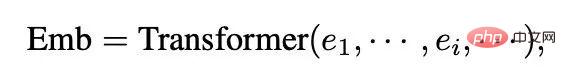

このメソッドは初期の段階で注目に値しました。これは、エージェントが観察するさまざまな数のエンティティに関する複雑な情報を処理するためのトランスフォーマーの使用に反映されています。 [Zambaldi et al., 2018a] は最初に、構造化された観察の関係推論をキャプチャするためにマルチヘッド ドット積アテンションを使用することを提案し、次に AlphaStar [Vinyals et al., 2019] がそれを困難なマルチエージェント環境 (StarCraft II) で実装しました。複数のエンティティの観察。エンティティ トランスフォーマと呼ばれるこのメカニズムでは、観察は次の形式でエンコードされます:

ここで、e_i はエンティティ i のエージェントの観察を表します。観察全体から直接、またはエンティティ トークナイザーによって与えられます。

後続の作業により、エンティティの Transformer メカニズムが強化されます。 [Hu et al. 2020] は、アクションをさまざまなエンティティに明示的に関連付け、ポリシー解釈のためのアテンション メカニズムを活用する、互換性のあるデカップリング戦略を提案しました。挑戦的なワンショットの視覚的模倣を達成するために、Dasari と Gupta [2021] は Transformer を使用して、タスク固有の要素に焦点を当てた表現を学習しました。

観測全体に散在するエンティティと同様に、一部の研究では、Transformer を利用して他のローカルなタイムステップごとのシーケンスを処理します。 Tang と Ha [2021] は、Transformer の注意メカニズムを利用して知覚シーケンスを処理し、順列不変の入力戦略を構築します。互換性のないマルチタスク RL では、[Kurin et al., 2020] は、Transformer を使用して形態学的ドメインの知識を抽出することを提案しました。

Timing Encoder

同時に、Transformer を使用することも合理的です。タイミングシーケンスを処理します。テンポラル エンコーダがストレージ アーキテクチャとして使用されます。

以前の研究では、[Mishra et al. 2018] はバニラ Transformer を使用して時系列シーケンスを処理できず、一部の特定のタスクではランダム ポリシーよりもパフォーマンスがさらに悪いことがわかりました。 Gated Transformer-XL (GTrXL) [Parisotto et al.、2020] は、軌跡を処理するストレージ アーキテクチャとして Transformer を使用する最初の効率的なソリューションです。 GTrXL は、Identity Map Reordering を通じて Transformer-XL アーキテクチャ [Dai et al., 2019] を変更し、連続入力から Transformer 出力への「スキップ」パスを提供します。これは、最初から安定したトレーニング プロセスを形成するのに役立ちます。 [Loynd et al. 2020] は長期依存関係のためのメモリ ベクトル ショートカット メカニズムを提案し、[Irie et al. 2021] はパフォーマンスを向上させるために線形トランスフォーマーと高速ウェイト プログラマーを組み合わせました。 [Melo 2022] は、ストレージベースのメタ RL のストレージ回復をシミュレートするためにセルフアテンション メカニズムを使用することを提案しました。

Transformer は、ストレージが増加しパラメータ サイズが増加するにつれて LSTM/RNN よりも優れたパフォーマンスを発揮しますが、RL ではデータ効率が良くありません。その後の研究では、いくつかの補助的な自己教師ありタスクを利用して学習を促進するか [Banino et al., 2021]、事前にトレーニングされた Transformer アーキテクチャを時間エンコーダとして使用します [Li et al., 2022; Fan et al., 2022]。

モデル学習用の Transformer

Transformer をシーケンス埋め込み用のエンコーダーとして使用することに加えて、Transformer のアーキテクチャは次のとおりです。モデルベースのアルゴリズムにおける環境モデルのバックボーンとしても使用されます。単一ステップの観察とアクションを条件とする予測とは異なり、Transformer を使用すると、環境モデルは特定の長さの履歴情報を条件とする遷移を予測できます。

実際、Dreamer とそれに続くアルゴリズム [Hafner et al., 2020, 2021; Seo et al., 2022] の成功は、部分的に観察可能な環境や、記憶 歴史的情報に基づく世界モデルの利点は、メカニズムのタスクで実証されます。歴史情報に基づいた世界モデルは、抽象的な情報を捕捉する観測エンコーダと潜在空間の変換を学習する変換モデルで構成されます。

RNN の代わりに Transformer アーキテクチャを使用して、歴史ベースの世界モデルを構築する研究が行われています。 [Chen et al. 2022] Dreamer の RNN ベースのリカレント状態空間モデル (RSSM) を、Transformer ベースのモデル TSSM (Transformer State-Space Model) に置き換えます。 IRIS (Imagination with autoRegression over an Inner Speech) [Micheli et al., 2022] は、Dreamer のような KL バランシングを行わずにロールアウト エクスペリエンスの自己回帰学習を通じて Transformer ベースの世界モデルを学習し、Atari に実装されています [Bellemare et al., 2013]そして良い結果を達成しました。

さらに、計画に Transformer ベースの世界モデルを使用しようとする研究もあります。 [Ozair et al. 2021] は、確率的タスクを完了するために Transformer 変換モデルを使用した計画の有効性を検証しました。 [Sun et al. 2022] は、手続き型タスクの視覚ベースの計画に効果的な、ターゲット条件付き Transformer 変換モデルを提案しました。

RNN と Transformer は両方とも、履歴情報に基づいて世界モデルを学習するのに適しています。しかし、[Micheli et al. 2022] は、Transformer アーキテクチャが Dreamer と比較してデータ効率の高い世界モデルであることを発見しました。 TSSM の実験結果は、Transformer アーキテクチャが長期記憶を必要とするタスクで良好にパフォーマンスすることを示しています。

逐次意思決定のためのトランスフォーマー

従来の RL アルゴリズムに高性能アルゴリズムとして統合されることに加えて、アーキテクチャ、トランスフォーマー 逐次意思決定モデルとして直接使用することもできます。これは、RL が、条件付きシーケンス モデリング問題、すなわち、高い報酬をもたらすアクションのシーケンスを生成する問題とみなすことができるためです。

Transformer のシーケンス予測における優れた精度を考慮して、Bootstrapped Transformer (BooT) [Wang et al., 2022] が提案されました。ブートストラップ Transformer を通じてデータを生成しながら、逐次的な意思決定のためにデータを最適化します。データ拡張用のブートストラップ Transformer を使用すると、オフライン データ セットの数と対象範囲を拡張できるため、パフォーマンスが向上します。具体的には、BooT はさまざまなデータ生成スキームとブートストラップ スキームを比較して、BooT がどのようにポリシー学習を促進するかを分析します。結果は、追加の制約なしで、基礎となる MDP と一致するデータを生成できることを示しています。

汎用エージェント用トランス

Decision Transformer は、オフライン データ上のさまざまなタスクで大きな役割を果たしています。一部の研究者は、Transformer を使用して、CV や NLP の分野のように、汎用エージェントが複数の異なるタスクや問題を解決できるようにできないか検討し始めています。

複数のタスクに一般化する

一部の研究者は CV と NLP を活用します。そのアイデアは次のとおりです。大規模なデータセットを事前トレーニングし、大規模なマルチタスクデータセットから一般的な戦略を抽象化することを試みます。 Multi-Game Decision Transformer (MGDT) [Lee et al., 2022] は、専門家データと非専門家データで構成される多様なデータセットで DT を学習し、一連のパラメーターを使用して人間に近いパフォーマンスを達成する DT の変種です。アタリゲーム。非エキスパートレベルのデータセットでエキスパートレベルのパフォーマンスを得るために、MGDTは、エキスパートレベルのリターンツーゴー事後分布をリターンツーゴー事前分布から計算し、それに従って計算するエキスパートアクション推論メカニズムを設計しました。ベイズ公式のデフォルトのエキスパート復帰確率。

同様に、Switch Trajectory Transformer (SwitchTT) [Lin et al.、2022] は TT のマルチタスク拡張であり、スパース アクティベーション モデルを利用して FFN 層をハイブリッドに置き換えます。効率的なマルチタスクのオフライン学習を実現するエキスパート層。さらに、SwitchTT は分散軌道値推定器を使用して、値推定の不確実性をモデル化します。これら 2 つの機能強化により、SwitchTT はパフォーマンスとトレーニング速度の点で TT よりも大幅に向上しています。 MGDT と SwitchTT は、複数のタスクとさまざまなパフォーマンス レベルのポリシーから収集した経験を活用して、一般的なポリシーを学習します。ただし、大規模なマルチタスク データセットの構築は簡単ではありません。

通常、インターネットからの膨大なデータと単純な手動ラベル付けを使用する CV や NLP の大規模データセットとは異なり、RL の逐次意思決定データには常にアクション情報が不足しており、マークしやすい。したがって、[Baker et al. 2022] は、アクション情報のない大規模オンライン データを使用して、Transformer ベースの逆動的モデル (IDM) を学習する半教師ありスキームを提案しました。このモデルは、過去と将来の観察を活用して行動情報を予測し、大量のオンライン ビデオ データにラベルを付けることができます。 IDM は、手動でラベル付けされたアクションを含む小規模なデータセットで学習され、十分に正確です。

NLP の既存の研究の多くは、新しいタスクに適応する際のプロンプトの有効性を証明しており、一部の研究では、DT 手法に基づくプロンプト テクノロジーを利用して迅速な適応を実現しています。 Prompt-based Decision Transformer (Prompt-DT) [Xu et al., 2022] は、少数ショットのデモンストレーション データセットから一連の変換をプロンプトとしてサンプリングし、少数ショット戦略をオフラインのメタ RL タスクに一般化します。 [Reed et al. 2022] は、プロンプトベースのアーキテクチャをさらに活用して、自然言語、画像、時間的意思決定、およびマルチモーダル データをカバーする非常に大規模なデータセットに対する自己回帰シーケンス モデリングを通じて一般エージェント (Gato) を学習します。 Gato は、テキスト生成や意思決定など、さまざまなドメインのさまざまなタスクを実行できます。

[Laskin et al. 2022] は、シングルタスク RL アルゴリズム学習プロセスのエピソード全体にわたるシーケンスで Transformer をトレーニングするためのアルゴリズム蒸留 (AD) を提案しました。したがって、新しいタスクであっても、Transformer は自己回帰生成プロセス中にポリシーを徐々に改善する方法を学習できます。

#より広い分野に一般化する

複数のタスクに一般化することに加えて、Transformer はは、逐次的な意思決定に関連するさまざまな領域で使用できる強力な「ユニバーサル」モデルでもあります。 NLP のマスク言語モデリング [Devlin et al., 2018] テクノロジーに触発され、[Carroll et al. 2022] は、一般的に使用されるさまざまな研究分野をマスク推論に統合する Uni [MASK] を提案しました 行動クローニング、オフライン RL、GCRL を含む問題、過去/未来の推論、動的予測。 Uni [MASK] は、タスク固有のマスク、ランダム マスク、微調整されたバリアントなど、さまざまなマスク スキームを比較します。結果は、ランダム マスクでトレーニングされた単一の Transformer が任意の推論タスクを解決できることを示しています。

さらに、[Reid et al. 2022] は、言語データセットまたは言語モダリティを含むマルチモーダル データセットで事前トレーニングされた Transformer を使用して DT を微調整することが有益であることを発見しました。これは、非 RL ドメインからの知識であっても、トランスフォーマーを通じて RL トレーニングに使用できることを示しています。

興味のある読者は、論文の原文を読んで研究の詳細を学ぶことができます。

以上がTransformer は強化学習においてどこまで発展しましたか?清華大学、北京大学などが共同でTransformRLのレビューを発表の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

1660

1660

14

14

1417

1417

52

52

1311

1311

25

25

1261

1261

29

29

1234

1234

24

24

ビットコインの価値はいくらですか

Apr 28, 2025 pm 07:42 PM

ビットコインの価値はいくらですか

Apr 28, 2025 pm 07:42 PM

ビットコインの価格は20,000ドルから30,000ドルの範囲です。 1。ビットコインの価格は2009年以来劇的に変動し、2017年には20,000ドル近くに達し、2021年にはほぼ60,000ドルに達しました。2。価格は、市場需要、供給、マクロ経済環境などの要因の影響を受けます。 3.取引所、モバイルアプリ、ウェブサイトを通じてリアルタイム価格を取得します。 4。ビットコインの価格は非常に不安定であり、市場の感情と外部要因によって駆動されます。 5.従来の金融市場と特定の関係を持ち、世界の株式市場、米ドルの強さなどの影響を受けています。6。長期的な傾向は強気ですが、リスクを慎重に評価する必要があります。

2025年のトップ10の通貨取引プラットフォームのどれがトップ10の通貨取引プラットフォームの1つです

Apr 28, 2025 pm 08:12 PM

2025年のトップ10の通貨取引プラットフォームのどれがトップ10の通貨取引プラットフォームの1つです

Apr 28, 2025 pm 08:12 PM

2025年の世界の上位10の暗号通貨取引所には、Binance、Okx、Gate.io、Coinbase、Kraken、Huobi、Bitfinex、Kucoin、Bittrex、Poloniexが含まれます。これらはすべて、高い取引量とセキュリティで知られています。

世界のトップ10の通貨取引プラットフォームのどれがトップ10の通貨取引プラットフォームの最新バージョンです

Apr 28, 2025 pm 08:09 PM

世界のトップ10の通貨取引プラットフォームのどれがトップ10の通貨取引プラットフォームの最新バージョンです

Apr 28, 2025 pm 08:09 PM

世界の上位10の暗号通貨取引プラットフォームには、Binance、Okx、Gate.io、Coinbase、Kraken、Huobi Global、Bitfinex、Bittrex、Kucoin、Poloniexが含まれます。これらはすべて、さまざまな取引方法と強力なセキュリティ対策を提供します。

復号化GATE.IO戦略のアップグレード:Memebox 2.0でCrypto Asset Managementを再定義する方法は?

Apr 28, 2025 pm 03:33 PM

復号化GATE.IO戦略のアップグレード:Memebox 2.0でCrypto Asset Managementを再定義する方法は?

Apr 28, 2025 pm 03:33 PM

Memebox 2.0は、革新的なアーキテクチャとパフォーマンスのブレークスルーを通じて、暗号資産管理を再定義します。 1)3つの主要な問題点を解決します。資産サイロ、収入の減少、セキュリティと利便性のパラドックスです。 2)インテリジェントアセットハブ、動的リスク管理およびリターンエンハンスメントエンジン、クロスチェーン移動速度、平均降伏率、およびセキュリティインシデント応答速度が向上します。 3)ユーザーに、ユーザー価値の再構築を実現し、資産の視覚化、ポリシーの自動化、ガバナンス統合を提供します。 4)生態学的なコラボレーションとコンプライアンスの革新により、プラットフォームの全体的な有効性が向上しました。 5)将来的には、スマート契約保険プール、予測市場統合、AI主導の資産配分が開始され、引き続き業界の発展をリードします。

トップ10の仮想通貨取引アプリは何ですか?最新のデジタル通貨交換ランキング

Apr 28, 2025 pm 08:03 PM

トップ10の仮想通貨取引アプリは何ですか?最新のデジタル通貨交換ランキング

Apr 28, 2025 pm 08:03 PM

Binance、OKX、Gate.ioなどの上位10のデジタル通貨交換は、システムを改善し、効率的な多様化したトランザクション、厳格なセキュリティ対策を改善しました。

トップ通貨取引プラットフォームは何ですか?トップ10の最新の仮想通貨交換

Apr 28, 2025 pm 08:06 PM

トップ通貨取引プラットフォームは何ですか?トップ10の最新の仮想通貨交換

Apr 28, 2025 pm 08:06 PM

現在、上位10の仮想通貨交換にランクされています。1。Binance、2。Okx、3。Gate.io、4。CoinLibrary、5。Siren、6。HuobiGlobal Station、7。Bybit、8。Kucoin、9。Bitcoin、10。BitStamp。

推奨される信頼できるデジタル通貨取引プラットフォーム。世界のトップ10のデジタル通貨交換。 2025

Apr 28, 2025 pm 04:30 PM

推奨される信頼できるデジタル通貨取引プラットフォーム。世界のトップ10のデジタル通貨交換。 2025

Apr 28, 2025 pm 04:30 PM

推奨される信頼できるデジタル通貨取引プラットフォーム:1。OKX、2。Binance、3。Coinbase、4。Kraken、5。Huobi、6。Kucoin、7。Bitfinex、8。Gemini、9。Bitstamp、10。Poloniex、これらのプラットフォームは、セキュリティ、ユーザーエクスペリエンス、ユーザーエクスペリエンス、ユーザーエクスペリエンス、ユーザーエクスペリエンスのデジタルエクスペリエンス、デジタルエクスペリエンスのデジタルエクスペリエンス、デジタルエクスペリエンスのために知られています。

CでChronoライブラリを使用する方法は?

Apr 28, 2025 pm 10:18 PM

CでChronoライブラリを使用する方法は?

Apr 28, 2025 pm 10:18 PM

CでChronoライブラリを使用すると、時間と時間の間隔をより正確に制御できます。このライブラリの魅力を探りましょう。 CのChronoライブラリは、時間と時間の間隔に対処するための最新の方法を提供する標準ライブラリの一部です。 Time.HとCtimeに苦しんでいるプログラマーにとって、Chronoは間違いなく恩恵です。コードの読みやすさと保守性を向上させるだけでなく、より高い精度と柔軟性も提供します。基本から始めましょう。 Chronoライブラリには、主に次の重要なコンポーネントが含まれています。STD:: Chrono :: System_Clock:現在の時間を取得するために使用されるシステムクロックを表します。 STD :: Chron