Transformer を汎用コンピュータとして使用することで、コンテキスト学習アルゴリズムを実行することもでき、非常に想像力に富んだ研究です。

Transformer はさまざまな機械学習タスクで人気の選択肢となり、良好な結果を達成していますが、他にどのように使用できるでしょうか?優れた想像力を持つ研究者は、実際にそれをプログラマブル コンピューターの設計に使用したいと考えています。

##この論文の著者はプリンストン大学とウィスコンシン大学の出身で、タイトルは「プログラマブル コンピュータとしてのループ変圧器」です。 " そしてその目的は、Transformer を使用して汎用コンピューターを実装する方法を模索していることです。

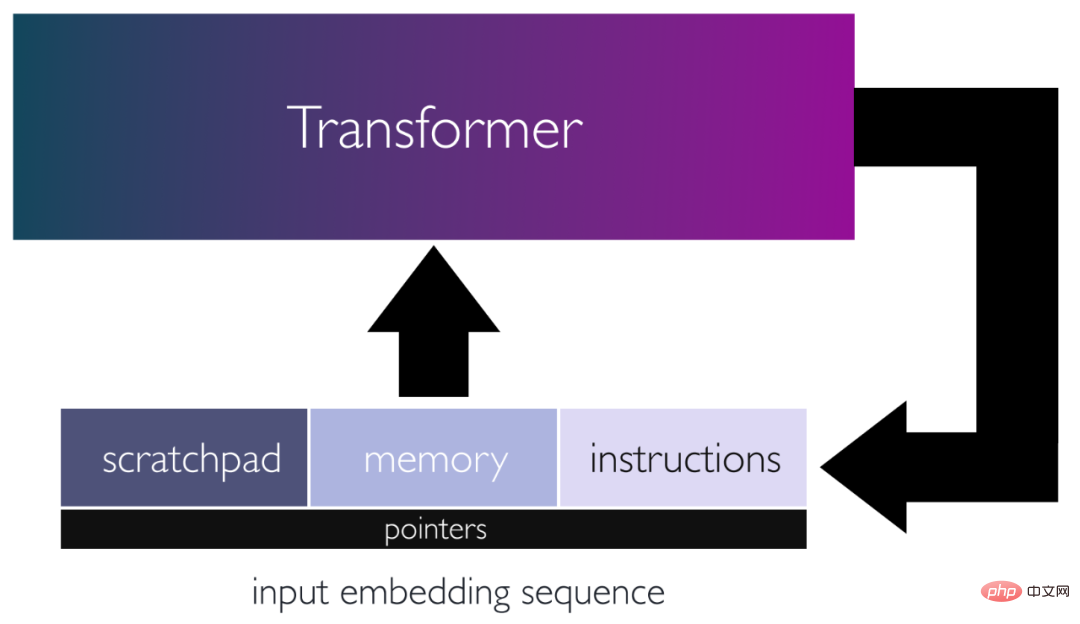

具体的には、著者らは、変圧器ネットワークを特定の重みでプログラムし、ループ内に配置することで、変圧器ネットワークを汎用コンピュータとして使用するためのフレームワークを提案しています。このフレームワークでは、入力シーケンスはパンチカードとして機能し、データの読み取り/書き込みのための命令とメモリで構成されます。

著者らは、一定数のエンコーダ層で基本的な計算ブロックをシミュレートできることを実証しました。これらの構成要素を使用して、小型の命令セット コンピューターをシミュレートしました。これにより、ループされた 13 層トランスフォーマーによって実行できるプログラムに反復アルゴリズムをマッピングできるようになりました。これらは、この変換器が、その入力に基づいて、バックプロパゲーションを使用して、基本的な計算機、基本的な線形代数ライブラリ、およびコンテキスト内学習アルゴリズムをどのようにシミュレートできるかを示しています。この研究は、アテンション メカニズムの多用途性を強調し、浅いトランスフォーマーでも本格的な汎用プログラムを実行できることを示しています。

論文の概要Transformer (TF) は、さまざまな機械学習タスクで一般的な選択肢となっており、自然言語処理などの分野の多くの問題で成果を上げています。およびコンピュータービジョンの最先端の結果。 Transformer の成功の主な理由は、アテンション メカニズムを通じて高次の関係と長距離の依存関係をキャプチャできることです。これにより、TF はコンテキスト情報をモデル化できるようになり、機械翻訳や言語モデリングなどのタスクでより効果的になり、Transformer は常に他の方法よりも優れたパフォーマンスを発揮します。

GPT-3 (175B パラメータ) や PaLM (540B パラメータ) など、数千億のパラメータを持つ言語モデルは、多くの自然言語で最先端のパフォーマンスを達成しています。言語処理タスク。興味深いことに、これらの大規模言語モデル (LLM) の一部は、インコンテキスト学習 (ICL) も実行でき、短いプロンプトといくつかの例に基づいて特定のタスクをオンザフライで適応および実行できます。 LLM の ICL 機能はトレーニングしなくても利用できるため、これらの大規模なモデルは重みを更新せずに新しいタスクを効率的に実行できます。

驚くべきことに、LLM は ICL を通じてアルゴリズム タスクと推論を実行できます。[Nye et al. [2021]、Wei et al. [2022c]、Lewkowycz et al. [2022]、 Wei et al. [2022b]、Zhou et al. [2022]] などがその実現可能性を証明しています。 [Zhou et al. [2022]] などによる研究では、マルチビット加算アルゴリズムといくつかの加算例を含むプロンプトが与えられた場合、LLM が未知のユースケースで加算演算を正常に実行できることが実証されています。これらの結果は、LLM が、あたかも自然言語をコードとして解釈するかのように、アルゴリズム原理に基づいて、推論時に指定された入力に対して事前に指示されたコマンドを実行できることを示しています。

Transformer が十分な深さのチューリング マシンまたはアテンション層間の再帰的リンクをシミュレートできるという証拠があります [Pérez et al. [2021]、Pérez et al. [2019]、Wei et al. .[2022a]]。これは、入力によって指定されたアルゴリズム命令に正確に従う Transformer ネットワークの可能性を示しています。ただし、これらの構造は比較的一般的なものであり、特定のアルゴリズム タスクを実行できる Transformer の作成方法については深く理解できません。

ただし、よりプロフェッショナルな設計により、TF はより高度なプログラムを実行できます。たとえば、[Weiss et al. [2021]] は、単純な選択および集計コマンドをインデックス入力トークンにマッピングする計算モデルとプログラミング言語を設計しました。この言語を使用すると、トークンのカウント、並べ替え、ヒストグラムの作成、Dyck-k 言語の識別など、さまざまな興味深いアルゴリズムを作成できます。 Restricted Access Sequence Processing Language (RASP) で書かれたプログラムは、通常、プログラムのサイズに応じてサイズが変化する Transformer ネットワークにマッピングできます。

別の研究では、線形回帰モデルを動的に学習するための最適化アルゴリズムとして使用する Transformer モデルの重みを選択し、トレーニング データを入力として与えられた推論時に暗黙的な操作を実行する方法を実証しました。これらの方法は通常、学習アルゴリズムの反復回数に比例した数の層を必要とし、単一の損失関数とモデルのアンサンブルに限定されます。

チューリング マシンの抽象計算をシミュレートする Transformer モデル、RASP などの言語に特化したコマンド、および ICL に固有のアルゴリズムをプログラミングする機能は、多用途のプログラマブル コンピューターとしての Transformer ネットワークの可能性を際立たせます。

著者の研究の目的は、この有望な見通しを探求し、アテンション メカニズムが命令セット アーキテクチャにインスピレーションを得た汎用コンピュータをどのようにシミュレートできるかを明らかにすることです。

プログラマブル コンピュータとしてのトランスフォーマー

この記事では、著者らは、トランスフォーマー ネットワークを特定の重みでハードコーディングし、ループ内に配置することで作成できることを示します。複雑なアルゴリズムとプログラムをシミュレートします。著者らは、入力シーケンス、非線形関数、関数呼び出し、プログラム カウンター、条件分岐などの編集操作など、基本的な計算ブロックをシミュレートするリバース エンジニアリングによってこれを実現しました。著者らの論文は、単一ループまたは再帰を使用して Transformer の出力シーケンスを入力に連結し、それによって深いモデルの必要性を回避することの重要性を示しています。

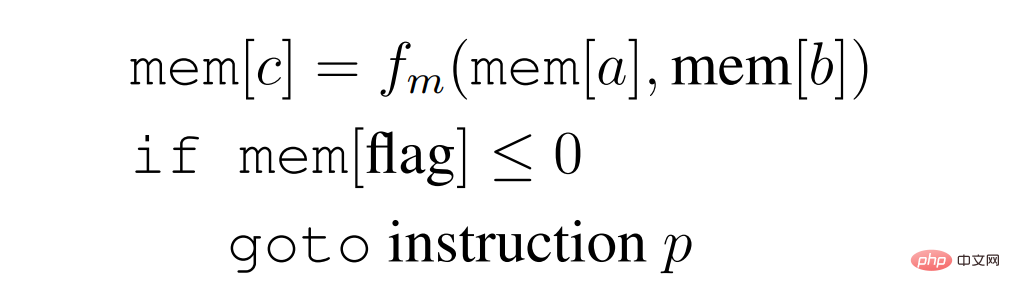

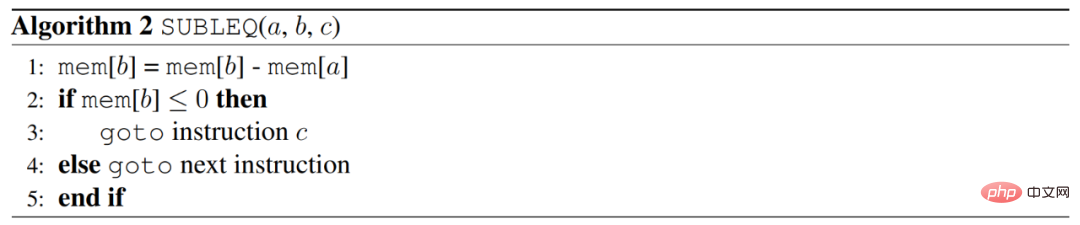

論文アドレス: https://arxiv.org/pdf/2301.13196.pdf ##著者は、SUBLEQ (A,B,C) と呼ばれる単一命令の一般的なバージョンで書かれたプログラムを実行できるトランスフォーマーを設計することでこれを実現しました。つまり、ゼロ以下の場合は減算とブランチを結合します。 SUBLEQ は、1 命令セット コンピューター (OISC) を定義する単一命令言語です。 SUBLEQ は 3 つのメモリアドレスオペランドで構成されており、実行時にはメモリアドレス A の値からメモリアドレス B の値が減算され、その結果が B に格納されます。 B の結果が 0 以下の場合はアドレス C にジャンプし、それ以外の場合は次の命令の実行を継続します。しかし、この命令は汎用コンピュータを定義します。

作者は、SUBLEQ のようなプログラムを実装する明示的な Transformer を構築します。作者はそれを FLEQ と呼びます。

# 形式のより柔軟な単一命令です。

## ここで、f_m は、ネットワークにハードコードできる一連の関数 (行列乗算/非線形関数/多項式など) から選択できます。 FLEQ プログラムを実行できるループ Transformer の深さは、プログラムの深さやコードの行数には依存せず、単一の FLEQ 命令を実装するのに必要な深さ (一定) に依存します。これは、CPU の動作と同様に、入力シーケンスに対してループ内で Transformer を実行することによって実現されます。

## ここで、f_m は、ネットワークにハードコードできる一連の関数 (行列乗算/非線形関数/多項式など) から選択できます。 FLEQ プログラムを実行できるループ Transformer の深さは、プログラムの深さやコードの行数には依存せず、単一の FLEQ 命令を実装するのに必要な深さ (一定) に依存します。これは、CPU の動作と同様に、入力シーケンスに対してループ内で Transformer を実行することによって実現されます。

著者はこのフレームワークを使用して、推論中に基本的な計算機、基本的な線形代数ライブラリ (行列の転置、乗算、逆行列、べき乗反復) を含むさまざまな関数をシミュレートする機能を実証します。 ICL は、暗黙的に完全に接続されたネットワーク上でバックプロパゲーションを実装します。入力シーケンスまたはプロンプトはパンチカードのように機能し、Transformer が実行する必要がある命令を含むと同時に、プログラムで使用される変数を保存および処理するためのスペースを提供します。これらの手順を実行するために使用される Transformer ネットワークはすべて、深さが 13 以下であり、これらすべてのモデルの重み行列が提供されます。次の定理は、著者の主な発見を要約したものです:

定理 1: 汎用コンピューターをシミュレートできる、13 層未満の循環トランスフォーマーが存在します (記事のセクション 5) 、基本的な計算機 (記事のセクション 7)、近似行列反転やべき乗反復などの数値線形代数手法 (記事のセクション 8)、ニューラル ネットワークに基づく ICL アルゴリズム (SGD など) (記事のセクション 9) )。

著者の研究は、アテンション メカニズムの柔軟性と単一ループの重要性を強調しています。これにより、複雑な反復アルゴリズムをシミュレートし、一般的なプログラムを実行できるモデルの設計が可能になります。さらに、Transformer モデルが複雑な数学的およびアルゴリズム的なタスクを効率的に実行できることを実証しました。 GPT-3 などの最新のトランスフォーマーは、さまざまなタスクを実行するときに同様の内部サブルーチンを使用すると考えられます。これらのモデル固有の手法やアルゴリズムの機能は、関数呼び出しと同様に、コンテキストに沿った例や説明が与えられると、ある程度理解できます。ただし、作成者が構造を設計した方法は、現実世界の言語モデルがトレーニングされる方法とはまったく似ていないため、この仮定は慎重に扱う必要があります。 著者らは、自分たちの研究が、注意メカニズムの可能性とアルゴリズム命令を実行する言語モデルの能力についてのさらなる研究を促進することを望んでいます。著者が提案した設計は、特定のアルゴリズム タスクを実行するために必要な Transformer ネットワークの最小サイズを決定するのに役立ちます。さらに、著者らは、その発見が、特定のアルゴリズム タスクを達成するために、より小規模なリバース エンジニアリングされた Transformer ネットワークを活用することによって、言語モデルをトレーニングする能力を強化する方法の開発に役立つことを期待しています。 Transformer ネットワークを使用して一般的なコンピューティング フレームワークを構築するには、特殊なコンピューティング ブロックが必要です。これらのブロックを組み立てて、目的の最終機能を作成します。以下では、Transformer レイヤーが実行できるさまざまな操作に焦点を当てます。これらの操作は、より複雑なルーチンやアルゴリズムを作成するための基礎となります。これらの操作は相互運用できるように設計されており、近似順列行列の生成やシグモイド関数による一般関数の近似など、さまざまなタスクを実行する Attend の機能を活用します。 一般的なコンピューティング用の Transformer モジュールの構築

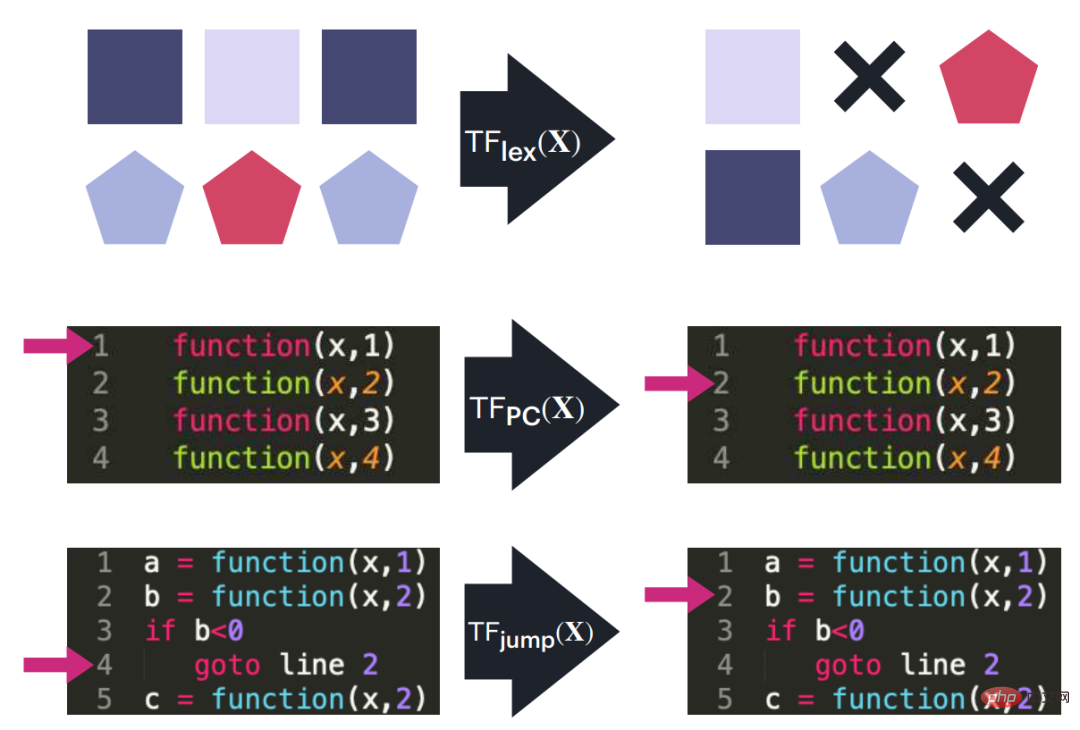

# 図 2: 小型命令セット コンピューターを実装するためのビルディング ブロックとして使用される 3 つの Transformer ブロック回路図。これらのブロックは、入力シーケンスでの編集操作 (あるブロックから別のブロックへの移動やコピーなど)、プログラム カウンタの追跡、指定された条件が満たされた場合のプログラム カウンタ ジャンプの実行を処理します。

#位置エンコーディング、プログラム カウンタ、およびデータ ポインタ

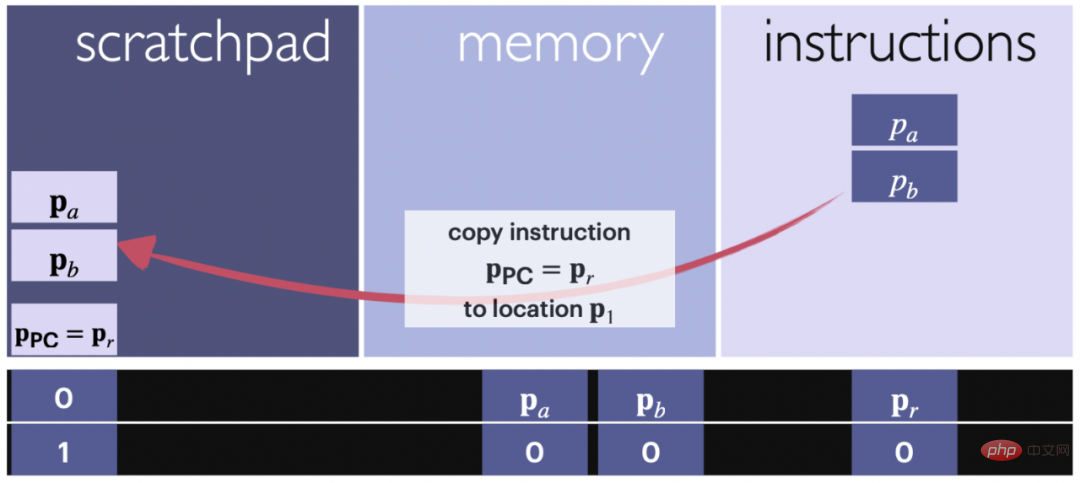

通常、Transformer は実行する必要があります。反復アルゴリズム または一連のコマンドを実行します。これを実現するために、作成者はコマンドをループするプログラム カウンターを使用します。カウンタには、次のコマンドが保存される場所のコードが含まれています。さらに、コマンドには、コマンドが読み書きする必要があるデータの場所を指すデータ ポインターが含まれる場合があります。プログラム カウンタとデータ ポインタは両方とも、前の段落で説明したのと同じ位置エンコーディングを使用します。

##読み取り/書き込み: 一時レジスタとの間でデータと命令をコピーします

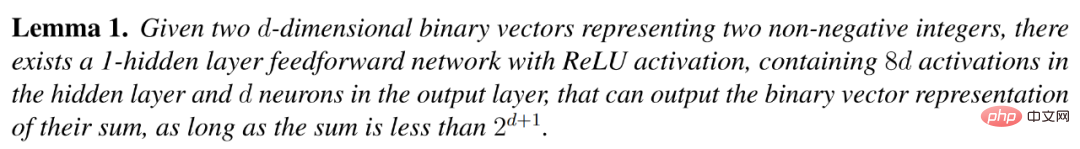

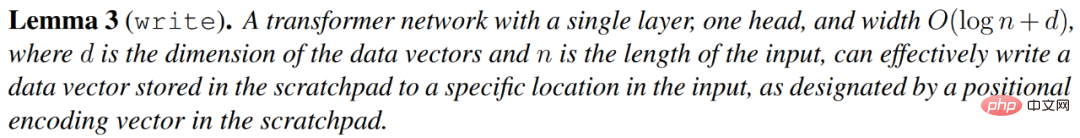

#次の補題は、プログラム カウンターが指すコマンド、または現在のコマンドで指定された場所にあるデータをスクラッチパッドにコピーできることを示しています。さらに計算。プログラム カウンタの位置は通常、スクラッチパッドの内容の直下にありますが、任意に変更できます。計算全体を通じて特定の位置に保持すると、構造を適切に整理するのに役立ちます。

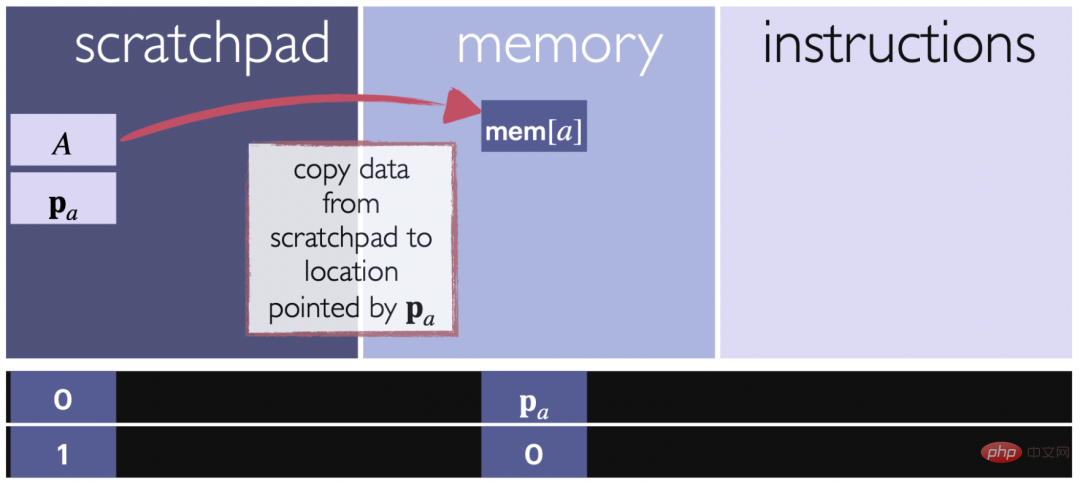

次の補題は、スクラッチパッドに格納されているベクトル v は、スクラッチパッド自体によって指定されているメモリ内の指定された場所にコピーできることを説明しています。これにより、データをスクラッチパッドからメモリ内の特定の場所に転送して、さらに使用したり保存したりできるようになります。

# 図 4: 書き込み操作の概略図。矢印は、データのブロックがスクラッチパッドからメモリに割り当てられた入力セクション内の指定された場所にコピーされていることを示します。位置エンコーディングは、ターゲットの位置を追跡し、データが正しいメモリ位置に書き込まれることを保証するために使用されます。

条件分岐 #このパートでは、条件を評価し、条件が true の場合にプログラム カウンタを指定された位置に設定し、条件が false の場合にプログラム カウンタを 1 つインクリメントする条件付き分岐命令を実装します。

コマンドの形式は次のとおりです。mem[a]≤0 の場合、i に進みます。ここで、mem[a] は、メモリ部分の位置の値です。入力シーケンス。このコマンドは、不等号の判定とプログラム カウンタの変更の 2 つの部分で構成されます。

ユニバーサル単一命令セット コンピューターのシミュレーション

SUBLEQ トランスフォーマーMavaddat と Parhami が復帰1988 2001 年に、命令が存在し、あらゆるコンピュータ プログラムをこの命令のインスタンス化からなるプログラムに変換できることが実証されました。この命令のバリエーションとして SUBLEQ があり、異なるレジスタまたはメモリ位置にアクセスできます。

SUBLEQ の仕組みはシンプルです。メモリ内の 2 つのレジスタにアクセスし、その内容の差分を取得してレジスタの 1 つに戻します。結果が負の場合は、事前に定義された別のコード行にジャンプするか、現在の行の次の命令に進みます。 SUBLEQ プログラムを実行するために構築されたコンピューターは、単一命令セット コンピューターと呼ばれ、汎用コンピューターです。つまり、無限のメモリにアクセスできる場合、それはチューリング完全になります。

#以下では、特定の命令セットで書かれたプログラムを実行できるループ Transformer の構築について説明します。 Transformer は、入力のメモリ部分をメモリ レジスタとして使用し、コマンド部分をコード/命令の行として使用して、コードの行、メモリの場所、およびプログラム カウンターを追跡します。一時レジスタは、各命令、読み出し、書き込み、条件分岐操作などに伴う加算やポインタを記録するために使用されます。

#以下では、特定の命令セットで書かれたプログラムを実行できるループ Transformer の構築について説明します。 Transformer は、入力のメモリ部分をメモリ レジスタとして使用し、コマンド部分をコード/命令の行として使用して、コードの行、メモリの場所、およびプログラム カウンターを追跡します。一時レジスタは、各命令、読み出し、書き込み、条件分岐操作などに伴う加算やポインタを記録するために使用されます。

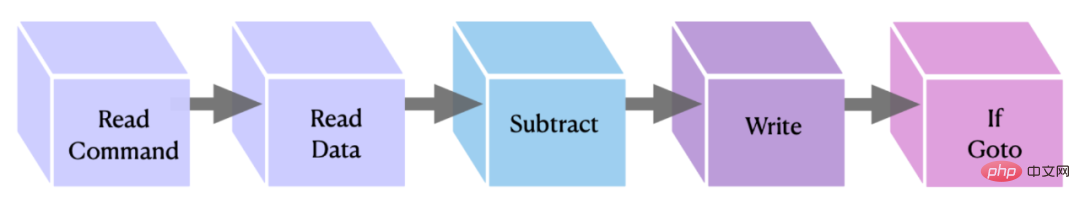

# 図 5: OISC 命令ブロックの実装をグラフィカルに表現。最初の 2 つのブロックはデータ/コマンドをスクラッチパッドに転送し、2 番目と 3 番目のブロックは減算を実行して結果を保存し、最後のブロックは命令を完了する if goto コマンドを実行します。

# 図 5: OISC 命令ブロックの実装をグラフィカルに表現。最初の 2 つのブロックはデータ/コマンドをスクラッチパッドに転送し、2 番目と 3 番目のブロックは減算を実行して結果を保存し、最後のブロックは命令を完了する if goto コマンドを実行します。

FLEQ: より柔軟なアテンションベースのコンピューター

このセクションでは、著者が FLEQ を紹介します。紹介すると、これは SUBLEQ を一般化したもので、より柔軟な縮小命令セット コンピューターを定義します。この暗黙的な追加命令セットは、SUBLEQ のより高度なバージョンに基づいており、複数の機能を同じ Transformer ネットワークに実装できます。著者らは、FLEQ という用語を、それが定義する命令、言語、および注意ベースのコンピュータを指すために使用しています。

FLEQ は、単純な減算よりも一般的な関数を生成することで、行列の乗算、平方根計算、活性化関数などの複雑なアルゴリズムを実装できるように設計されています。

アテンションベースのコンピュータ実行サイクル。ループ Transformer の各反復で、プログラム カウンターに基づいて入力内の命令セットから命令がフェッチされます。次に、命令がスクラッチパッドにコピーされます。実装される関数に応じて、関数の結果をローカルに記録するために異なる関数ブロックの場所が使用されます。結果が計算されると、その結果は命令によって提供された指定されたメモリ位置にコピーされて戻されます。

実行サイクルは、前のセクションの単一命令セット コンピューター (OISC) のサイクルと似ていますが、主な違いは、各命令に対して事前に実行される命令のリストから選択できることです。 -selected 関数: 関数は、行列、ベクトル、スカラーなどの任意の配列として入力を受け取ります。

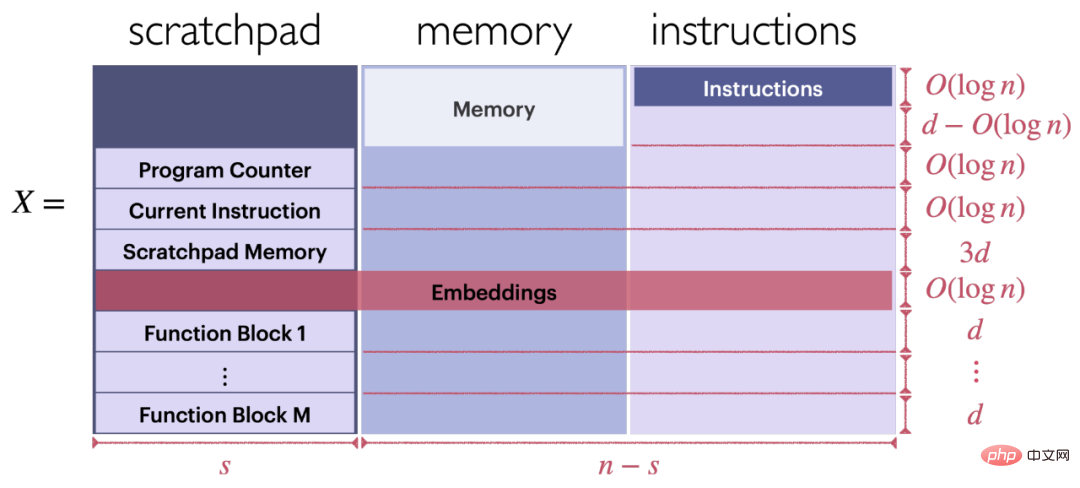

#入力シーケンスの形式。図 6 に示すように、ループ Transformer の入力 X は、一連の FLEQ 命令で構成されるプログラムを実行できます (X は一時レジスタ、メモリ、命令の 3 つの部分で構成されます)。

Transformer ベースの機能ブロックの形式。図 6 に示すように、各機能ブロックは入力 X の左下部分にあります。

#図 6: FLEQ コマンドを実行するための入力 X の構造

技術的な詳細と例については、元の論文を参照してください。以上がTransformer を汎用コンピュータとして使用することで、コンテキスト学習アルゴリズムを実行することもでき、非常に想像力に富んだ研究です。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7504

7504

15

15

1378

1378

52

52

78

78

11

11

19

19

54

54

Stable Diffusion 3 の論文がついに公開され、アーキテクチャの詳細が明らかになりましたが、Sora の再現に役立つでしょうか?

Mar 06, 2024 pm 05:34 PM

Stable Diffusion 3 の論文がついに公開され、アーキテクチャの詳細が明らかになりましたが、Sora の再現に役立つでしょうか?

Mar 06, 2024 pm 05:34 PM

StableDiffusion3 の論文がついに登場しました!このモデルは2週間前にリリースされ、Soraと同じDiT(DiffusionTransformer)アーキテクチャを採用しており、リリースされると大きな話題を呼びました。前バージョンと比較して、StableDiffusion3で生成される画像の品質が大幅に向上し、マルチテーマプロンプトに対応したほか、テキスト書き込み効果も向上し、文字化けが発生しなくなりました。 StabilityAI は、StableDiffusion3 はパラメータ サイズが 800M から 8B までの一連のモデルであると指摘しました。このパラメーター範囲は、モデルを多くのポータブル デバイス上で直接実行できることを意味し、AI の使用を大幅に削減します。

座標系の変換を本当にマスターしましたか?自動運転と切り離せないマルチセンサーの問題

Oct 12, 2023 am 11:21 AM

座標系の変換を本当にマスターしましたか?自動運転と切り離せないマルチセンサーの問題

Oct 12, 2023 am 11:21 AM

最初のパイロットおよび重要な記事では、主に自動運転技術で一般的に使用されるいくつかの座標系と、それらの間の相関と変換を完了し、最終的に統合環境モデルを構築する方法を紹介します。ここでの焦点は、車両からカメラの剛体への変換 (外部パラメータ)、カメラから画像への変換 (内部パラメータ)、および画像からピクセル単位への変換を理解することです。 3D から 2D への変換には、対応する歪み、変換などが発生します。要点:車両座標系とカメラ本体座標系を平面座標系とピクセル座標系に書き換える必要がある 難易度:画像の歪みを考慮する必要がある 歪み補正と歪み付加の両方を画面上で補正する2. はじめに ビジョンシステムには、ピクセル平面座標系 (u, v)、画像座標系 (x, y)、カメラ座標系 ()、世界座標系 () の合計 4 つの座標系があります。それぞれの座標系には関係性があり、

自動運転と軌道予測についてはこの記事を読めば十分です!

Feb 28, 2024 pm 07:20 PM

自動運転と軌道予測についてはこの記事を読めば十分です!

Feb 28, 2024 pm 07:20 PM

自動運転では軌道予測が重要な役割を果たしており、自動運転軌道予測とは、車両の走行過程におけるさまざまなデータを分析し、将来の車両の走行軌跡を予測することを指します。自動運転のコアモジュールとして、軌道予測の品質は下流の計画制御にとって非常に重要です。軌道予測タスクには豊富な技術スタックがあり、自動運転の動的/静的知覚、高精度地図、車線境界線、ニューラル ネットワーク アーキテクチャ (CNN&GNN&Transformer) スキルなどに精通している必要があります。始めるのは非常に困難です。多くのファンは、できるだけ早く軌道予測を始めて、落とし穴を避けたいと考えています。今日は、軌道予測に関するよくある問題と入門的な学習方法を取り上げます。関連知識の紹介 1. プレビュー用紙は整っていますか? A: まずアンケートを見てください。

DualBEV: BEVFormer および BEVDet4D を大幅に上回る、本を開いてください!

Mar 21, 2024 pm 05:21 PM

DualBEV: BEVFormer および BEVDet4D を大幅に上回る、本を開いてください!

Mar 21, 2024 pm 05:21 PM

この論文では、自動運転においてさまざまな視野角 (遠近法や鳥瞰図など) から物体を正確に検出するという問題、特に、特徴を遠近法 (PV) 空間から鳥瞰図 (BEV) 空間に効果的に変換する方法について検討します。 Visual Transformation (VT) モジュールを介して実装されます。既存の手法は、2D から 3D への変換と 3D から 2D への変換という 2 つの戦略に大別されます。 2D から 3D への手法は、深さの確率を予測することで高密度の 2D フィーチャを改善しますが、特に遠方の領域では、深さ予測に固有の不確実性により不正確さが生じる可能性があります。 3D から 2D への方法では通常、3D クエリを使用して 2D フィーチャをサンプリングし、Transformer を通じて 3D と 2D フィーチャ間の対応のアテンション ウェイトを学習します。これにより、計算時間と展開時間が増加します。

初のマルチビュー自動運転シーンビデオ生成世界モデル | DrivingDiffusion: BEV データとシミュレーションの新しいアイデア

Oct 23, 2023 am 11:13 AM

初のマルチビュー自動運転シーンビデオ生成世界モデル | DrivingDiffusion: BEV データとシミュレーションの新しいアイデア

Oct 23, 2023 am 11:13 AM

著者の個人的な考えの一部 自動運転の分野では、BEV ベースのサブタスク/エンドツーエンド ソリューションの開発に伴い、高品質のマルチビュー トレーニング データとそれに対応するシミュレーション シーンの構築がますます重要になってきています。現在のタスクの問題点に対応して、「高品質」は 3 つの側面に分離できます。 さまざまな次元のロングテール シナリオ: 障害物データ内の近距離車両、車両切断中の正確な進行角、車線などラインデータ 曲率の異なるカーブやランプ・合流・合流などの撮影が難しいシーン。これらは多くの場合、大量のデータ収集と複雑なデータ マイニング戦略に依存しており、コストがかかります。 3D 真の値 - 一貫性の高い画像: 現在の BEV データ取得は、センサーの設置/校正、高精度マップ、再構成アルゴリズム自体のエラーの影響を受けることがよくあります。これが私を導いた

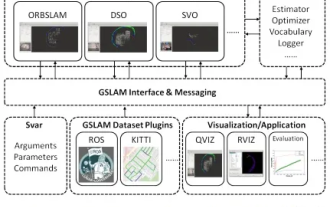

GSLAM | 一般的な SLAM アーキテクチャとベンチマーク

Oct 20, 2023 am 11:37 AM

GSLAM | 一般的な SLAM アーキテクチャとベンチマーク

Oct 20, 2023 am 11:37 AM

19 年前の論文を突然発見 GSLAM: A General SLAM Framework and Benchmark オープンソース コード: https://github.com/zdzhaoyong/GSLAM 全文に直接アクセスして、この作品の品質を感じてください ~ 1 抽象的な SLAM テクノロジー近年多くの成功を収め、多くのハイテク企業の注目を集めています。ただし、既存または新たなアルゴリズムへのインターフェイスを使用して、速度、堅牢性、移植性に関するベンチマークを効果的に実行する方法は依然として問題です。この論文では、GSLAM と呼ばれる新しい SLAM プラットフォームを提案します。これは、評価機能を提供するだけでなく、研究者が独自の SLAM システムを迅速に開発するための有用な方法を提供します。

「Minecraft」が AI の街に変わり、NPC の住人が本物の人間のようにロールプレイ

Jan 02, 2024 pm 06:25 PM

「Minecraft」が AI の街に変わり、NPC の住人が本物の人間のようにロールプレイ

Jan 02, 2024 pm 06:25 PM

この四角い男性は、目の前にいる「招かれざる客」の正体について考えながら眉をひそめていることに注意してください。彼女が危険な状況にあることが判明し、これに気づくと、彼女は問題を解決するための戦略を見つけるためにすぐに頭の中で探索を始めました。最終的に、彼女は現場から逃走し、できるだけ早く助けを求め、直ちに行動を起こすことにしました。同時に、反対側の人も彼女と同じことを考えていた……『マインクラフト』では、登場人物全員が人工知能によって制御されている、そんなシーンがありました。それぞれに個性的な設定があり、例えば先ほどの女の子は17歳ながら賢くて勇敢な配達員です。彼らは記憶力と思考力を持ち、Minecraft の舞台となるこの小さな町で人間と同じように暮らしています。彼らを動かすのはまったく新しいものであり、

レビュー!深いモデルの融合 (LLM/基本モデル/フェデレーテッド ラーニング/ファインチューニングなど)

Apr 18, 2024 pm 09:43 PM

レビュー!深いモデルの融合 (LLM/基本モデル/フェデレーテッド ラーニング/ファインチューニングなど)

Apr 18, 2024 pm 09:43 PM

9 月 23 日、論文「DeepModelFusion:ASurvey」が国立国防技術大学、JD.com、北京理工大学によって発表されました。ディープ モデルの融合/マージは、複数のディープ ラーニング モデルのパラメーターまたは予測を 1 つのモデルに結合する新しいテクノロジーです。さまざまなモデルの機能を組み合わせて、個々のモデルのバイアスとエラーを補償し、パフォーマンスを向上させます。大規模な深層学習モデル (LLM や基本モデルなど) での深層モデルの融合は、高い計算コスト、高次元のパラメーター空間、異なる異種モデル間の干渉など、いくつかの課題に直面しています。この記事では、既存のディープ モデル フュージョン手法を 4 つのカテゴリに分類します。 (1) 「パターン接続」。損失低減パスを介して重み空間内の解を接続し、より適切な初期モデル フュージョンを取得します。