すぐに 2,500 個のスターを獲得した Andrej Karpathy は、minGPT ライブラリを書き直しました

GPT は、人工知能分野における「暴力の美学」の代表作として、一躍脚光を浴びたと言えます。GPT の誕生当初の 1 億 1,700 万個のパラメータから、 GPT-3 の 1,750 億パラメータへの道。 GPT-3 のリリースに伴い、OpenAI は商用 API をコミュニティに公開し、GPT-3 を使用してさらに実験を試みることを誰もが奨励しています。ただし、API の使用にはアプリケーションが必要であり、アプリケーションが無駄になる可能性があります。

リソースが限られている研究者が大規模なモデルで遊ぶ楽しさを体験できるようにするために、元 Tesla AI ディレクターの Andrej Karpathy 氏が、わずか約 300 行のコードで PyTorch に基づいてこのモデルを作成しました。小さな GPT トレーニング ライブラリが開発され、minGPT と名付けられました。このminGPTは加算演算や文字レベル言語モデリングが可能であり、精度も悪くありません。

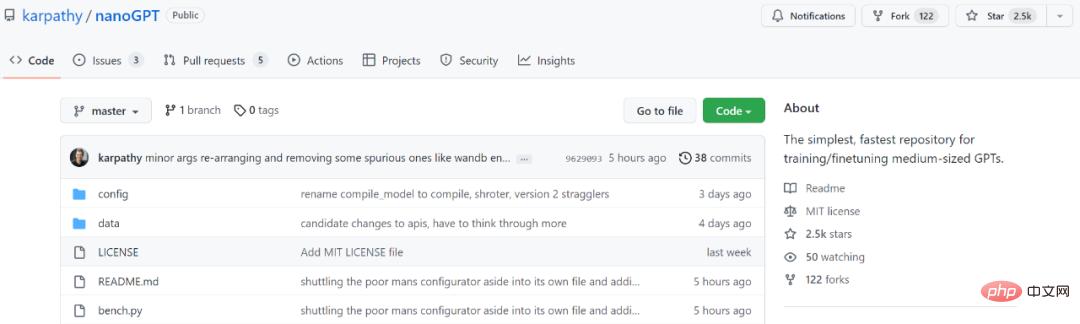

2 年後、minGPT が更新され、Karpathy は NanoGPT という名前の新しいバージョンを開始しました。このライブラリは、中型 GPT のトレーニングと微調整に使用されます。発売からわずか数日で 2.5,000 個のスターを集めました。

プロジェクトアドレス: https://github.com/karpathy/nanoGPT

Karpathy 氏はプロジェクトの紹介で次のように書いています。「NanoGPT は、中規模 GPT のトレーニングと微調整のための最もシンプルかつ最速のライブラリです。minGPT は非常に複雑なので、これは minGPT を書き直したものです」 NanoGPT はまだ開発中であり、現在 OpenWebText データセット上で GPT-2 を再現することに取り組んでいます。

NanoGPT コード設計の目標 それはシンプルであり、読みやすく、そのうち train.py は約 300 行のコード、model.py は約 300 行の GPT モデル定義で、OpenAI から GPT-2 重みをロードすることを選択できます。」

データセットをレンダリングするには、ユーザーはまずいくつかのドキュメントを単純な 1D インデックス配列にトークン化する必要があります。

$ cd data/openwebtext $ python prepare.py

これにより、train.bin と val.bin という 2 つのファイルが生成され、それぞれに GPT-2 BPE トークン ID を表す uint16 バイトの生のシーケンスが含まれます。このトレーニング スクリプトは、OpenAI が提供する GPT-2 の最小バージョン (124M バージョン) を複製しようとします。

$ python train.py

PyTorch 分散データ並列処理 (DDP) をトレーニングに使用する場合は、torchrun を使用してスクリプトを実行してください。

$ torchrun --standalone --nproc_per_node=4 train.py

コードをより効率的にするために、ユーザーはモデルからサンプリングすることもできます:

$ python sample.py

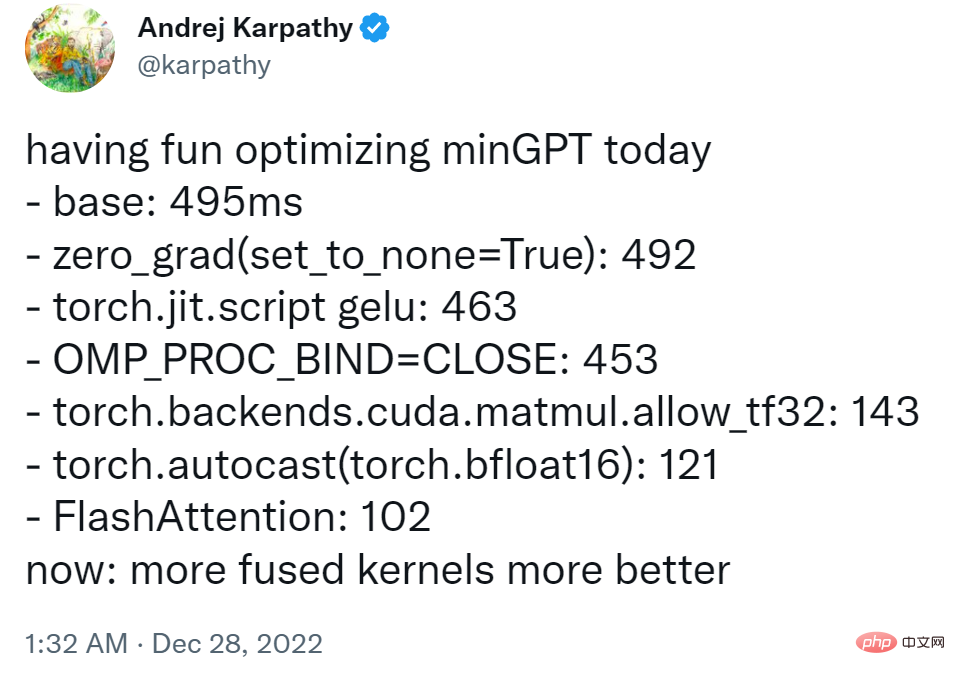

Karpathy 氏によると、プロジェクトは現在 1 です。 A100 40GB GPU での一晩のトレーニング損失は約 3.74、4 GPU でのトレーニング損失は約 3.60 です。 8 x A100 40GB ノードでのトレーニングは 400,000 反復 (約 1 日) で 3.1 atm まで低下しました。

新しいテキストで GPT を微調整する方法については、ユーザーは data/shakespeare にアクセスし、prepare.py を参照できます。 OpenWebText とは異なり、これは数秒で実行されます。微調整にかかる時間は非常に短く、たとえば 1 つの GPU でわずか数分です。以下は微調整の実行例です。

$ python train.py config/finetune_shakespeare.py

プロジェクトがオンラインになるとすぐに、誰かがすでに試し始めています:

試してみたい友達は、元のプロジェクトを参照してください。

以上がすぐに 2,500 個のスターを獲得した Andrej Karpathy は、minGPT ライブラリを書き直しましたの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7555

7555

15

15

1382

1382

52

52

83

83

11

11

28

28

96

96

カーソルAIでバイブコーディングを試してみましたが、驚くべきことです!

Mar 20, 2025 pm 03:34 PM

カーソルAIでバイブコーディングを試してみましたが、驚くべきことです!

Mar 20, 2025 pm 03:34 PM

バイブコーディングは、無限のコード行の代わりに自然言語を使用してアプリケーションを作成できるようにすることにより、ソフトウェア開発の世界を再構築しています。 Andrej Karpathyのような先見の明に触発されて、この革新的なアプローチは開発を許可します

2025年2月のトップ5 Genai発売:GPT-4.5、Grok-3など!

Mar 22, 2025 am 10:58 AM

2025年2月のトップ5 Genai発売:GPT-4.5、Grok-3など!

Mar 22, 2025 am 10:58 AM

2025年2月は、生成AIにとってさらにゲームを変える月であり、最も期待されるモデルのアップグレードと画期的な新機能のいくつかをもたらしました。 Xai’s Grok 3とAnthropic's Claude 3.7 SonnetからOpenaiのGまで

オブジェクト検出にYolo V12を使用する方法は?

Mar 22, 2025 am 11:07 AM

オブジェクト検出にYolo V12を使用する方法は?

Mar 22, 2025 am 11:07 AM

Yolo(あなたは一度だけ見ています)は、前のバージョンで各反復が改善され、主要なリアルタイムオブジェクト検出フレームワークでした。最新バージョンYolo V12は、精度を大幅に向上させる進歩を紹介します

クリエイティブプロジェクトのための最高のAIアートジェネレーター(無料&有料)

Apr 02, 2025 pm 06:10 PM

クリエイティブプロジェクトのための最高のAIアートジェネレーター(無料&有料)

Apr 02, 2025 pm 06:10 PM

この記事では、トップAIアートジェネレーターをレビューし、その機能、創造的なプロジェクトへの適合性、価値について説明します。 Midjourneyを専門家にとって最高の価値として強調し、高品質でカスタマイズ可能なアートにDall-E 2を推奨しています。

ChatGpt 4 oは利用できますか?

Mar 28, 2025 pm 05:29 PM

ChatGpt 4 oは利用できますか?

Mar 28, 2025 pm 05:29 PM

CHATGPT 4は現在利用可能で広く使用されており、CHATGPT 3.5のような前任者と比較して、コンテキストを理解し、一貫した応答を生成することに大幅な改善を示しています。将来の開発には、よりパーソナライズされたインターが含まれる場合があります

chatgptよりも優れたAIはどれですか?

Mar 18, 2025 pm 06:05 PM

chatgptよりも優れたAIはどれですか?

Mar 18, 2025 pm 06:05 PM

この記事では、Lamda、Llama、GrokのようなChatGptを超えるAIモデルについて説明し、正確性、理解、業界への影響における利点を強調しています(159文字)

次のラグモデルにミストラルOCRを使用する方法

Mar 21, 2025 am 11:11 AM

次のラグモデルにミストラルOCRを使用する方法

Mar 21, 2025 am 11:11 AM

Mistral OCR:マルチモーダルドキュメントの理解により、検索された世代の革命を起こします 検索された生成(RAG)システムはAI機能を大幅に進めており、より多くの情報に基づいた応答のために膨大なデータストアにアクセスできるようになりました

トップAIライティングアシスタントは、コンテンツの作成を後押しします

Apr 02, 2025 pm 06:11 PM

トップAIライティングアシスタントは、コンテンツの作成を後押しします

Apr 02, 2025 pm 06:11 PM

この記事では、Grammarly、Jasper、Copy.ai、Writesonic、RytrなどのトップAIライティングアシスタントについて説明し、コンテンツ作成のためのユニークな機能に焦点を当てています。 JasperがSEOの最適化に優れているのに対し、AIツールはトーンの維持に役立つと主張します