盗作と不正行為のため、ChatGPT は 12 枚の署名入り論文を密かに生成しました。マーカスが Ta を CheatGPT に変えたことを非難

Marcus が再び ChatGPT に挑戦するためにここに来ました!

今日、マーカスは個人ブログに次のように書きました。事態はますますとんでもないことになってきています。

爆発する前に答えを確認してください

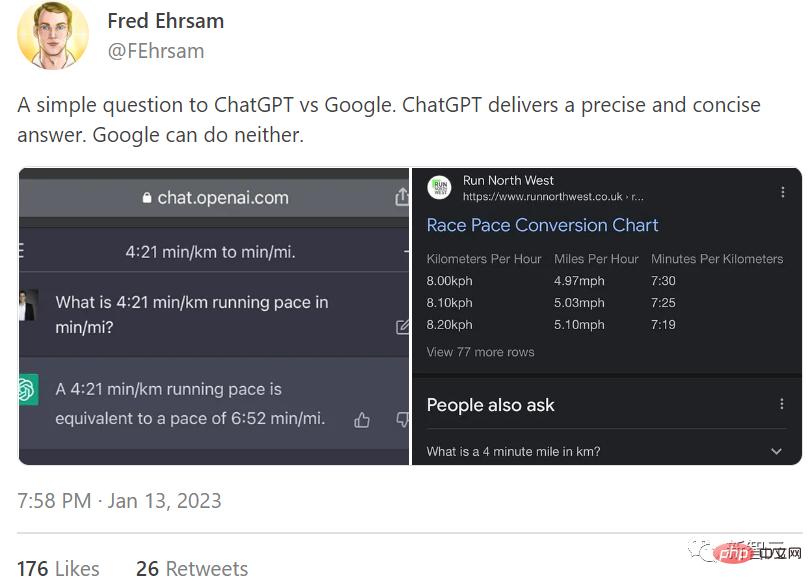

問題の原因はフレッドの一文にありましたエルサム氏のツイート。

Ehrsam 氏は ChatGPT と Google の両方に「1 キロメートルの 4 分と 21 分は 1 マイルに相当しますか?」と尋ねました。彼は ChatGPT が正確かつ簡潔な回答を得るために与えられましたが、Google にはそれすらできません。

この投稿に対し、マーカス氏は「まるで未来世界の象徴であるかのように、傲慢で傲慢だ。しかし、ちなみに、その答えは間違っている」と述べた。

ChatGPT は単位を正しく変換しません。作者は、この素晴らしい新しいツールによって得られる答えが正確であること (秒単位まで正確であること) を望んでいます。彼はそれをしませんでした。全然調べてください。

#ここに問題があります。統計的な単語予測は実際の数学の代わりにはなりませんが、多くの人はそうではないと考えています。 (1キロあたり4分21秒の速度は、1マイルあたり7分の速度です。よく質問すれば正解が得られます。)

ChatGPT こちら「そうです、完全に正しくはありません。」 この答えの最悪の部分は、それが間違っているということではなく、その答えが非常に自信に満ちているように見えることです。あまりにも説得力があったので、Twitterユーザーはそれを疑おうとも思わなかった。

これが現在の状況です。ChatGPT は悪用され、人々はそれを信頼し、たとえそれが正解に反していても自慢することさえあります。

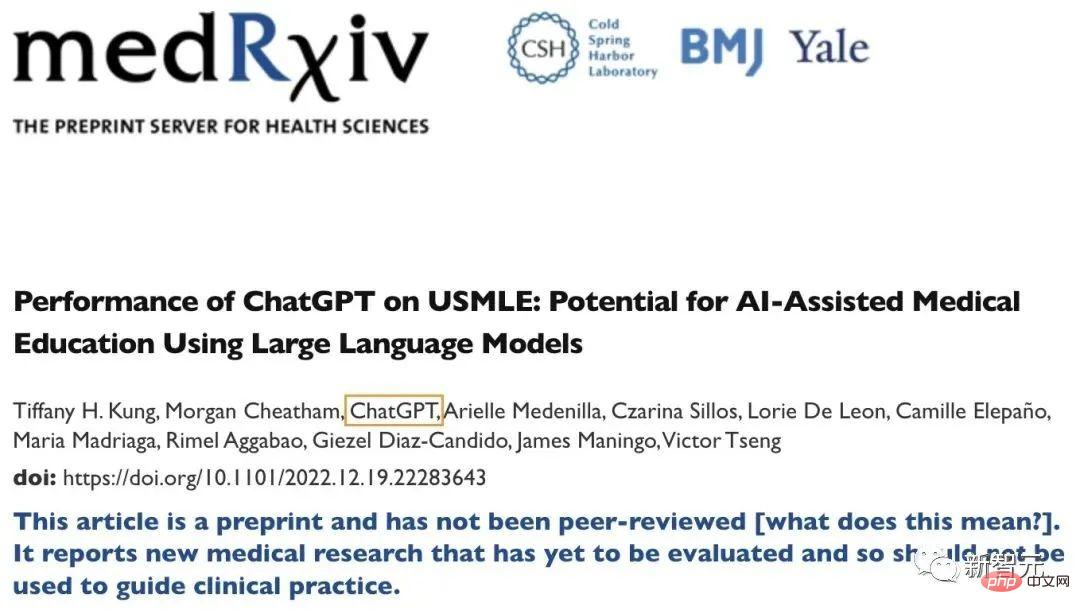

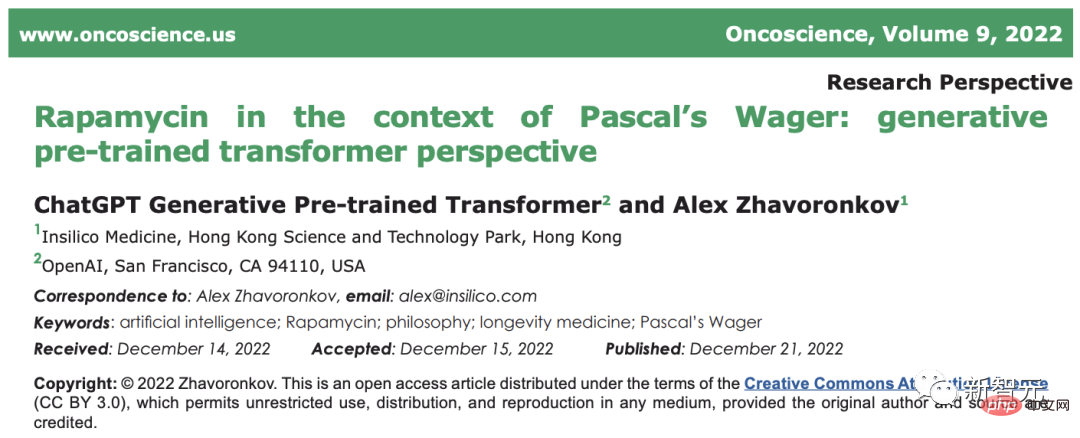

誇大広告よりも悪いものを知りたいですか?人々は ChatGPT を信頼でき、資格のある科学協力者として見始めました。

助けて、ChatGPT を共著者として書かないでください

マーカスは、ChatGPT に関して、昨日の見出しが Google に対する圧政を誇張していると言いました。 。 能力。現在、世論では ChatGPT が論文の共著者になることが議論されています。

昨年 12 月に発行されたプレプリント論文の著者欄に突然 ChatGPT が登場しました。

Semantic Scholar によると、誕生から 6 週間の ChatGPT はすでに 2 件の出版物、12 件の共著、1 件の引用を持っています。

この傾向が続かないことを心から願っています。

マーカス氏は 5 つの理由を挙げました。

- ChatGPT は単なるツールであり、人間ではありません。科学者であると言うには、スペル チェッカー、文法チェッカー、またはせいぜい統計パッケージに近いと言ったほうがよいでしょう。

- 実際のアイデアを提供したり、注意深く管理された実験を計画したり、既存の文献からインスピレーションを得たりすることはできません。スペル チェッカーやスプレッドシートを共著者にすることはできません。

たとえば、SPM などの脳分析用のソフトウェア パッケージなどのリソースを参考文献に引用します。たとえ研究努力にとって重要であるとしても、SPM を共著者として挙げる人は誰もいないでしょう。

- 共著の定義は分野によって異なりますが、一般に、科学的に実質的な貢献をするには共著が必要です。

ChatGPT は単にこれを行うのに十分な論理的根拠がありません; ChatGPT の現在の科学的理解レベルを考慮すると、それに著者名を与えることは科学的プロセスに対する不名誉です。 。

Marcus は、以前の記事で、ChatGPT は物理学、生物学、心理学、医学、その他の主題を理解していないと書き、「賢くて愚か」とはどのようなものであるかを皆に説明しました。のように。

この回答で、ChatGPT は、スペインのチュロスが家庭での最高の手術器具であることを科学者が発見したと真剣に述べました。

- ChatGPT は信頼性が低く、真実ではないことが証明されています。法外な計算ミスを犯し、虚偽の伝記の詳細を捏造し、語彙を誤用し、存在しない科学現象を定義します。

これを知らなければ、AI 研究を理解していないことになります。これを知っていても気にしないのであれば、それはさらに悪いことです。これを共著者にすると、実際に研究をしているのではなく、ただ群衆を追っているだけであることがわかります。

- 人々は ChatGPT フィルターに強すぎます。

もし、「ステンレス」人工電卓の使用に不満があると公言したとしても、75% の精度しかない電卓など信じられないでしょう。インテリジェンス スマートツールを使って論文を「書く」ことに興奮していますが、なぜあなたを信頼する必要があるのでしょうか?

- #科学論文の目的は、真実を他の人に明確に教えることです。

ChatGPT を感覚を持った存在として見なす場合、それは明らかにそうではありませんが、一般の人々に同じように感じるように誤解させていることになり、科学を伝えているわけではありません。コンセプトは単なる誇大宣伝でありナンセンスです。この行為はやめてください。

最後に、マーカスは次のように結論付けました。真の友人は、ChatGPT が論文の共著者になることを許可しません。

マーカスが人工知能の展望と AGI の実現可能性についてルカンや他の人々と熱心に議論し、ルカンが自分の「人工知能のロードマップ」について他人の手柄を横取りしたと非難したとしたら、多かれ少なかれ個人的な不満があるとすれば、今回 ChatGPT に関して表明された懸念と警戒は非常に適切です。

実際、マーカスが ChatGPT、論文詐欺、著作権紛争について上で言及したのは、ChatGPT の立ち上げからわずか数週間後のことでした。現実。

最近、ファーマン大学の哲学教授ダレン・シックは、学生が提出した論文が人工知能によって生成されたことを発見しました。

ヒック氏は、新聞に掲載された明らかに慎重に作成された、しかし誤った情報を見て疑念を抱いたと述べた。

彼はこの論文を Open AI の ChatGPT 検出器に送信しました。結果は、この論文が人工知能によって生成された可能性が 99% であることを示しました。

偶然にも、ノーザンミシガン大学教授のアントニー・オーマン氏も、2人の学生がChatGPTの記事で書かれたコードを提出したことを発見したと述べた。

2 つの記事の書き方に何か問題があることに気づいたオーマン氏は、記事をチャットボットに送信し、プログラムによって書かれた可能性がどの程度あるのかを尋ねました。チャットボットは、チャットボットが ChatGPT によって書かれたものであることが 99% 確実であると判断すると、その結果を学生に転送しました。

シック氏とオーマン氏はいずれも学生たちと対峙し、最終的に全員が違反を認めたと述べた。ヒックの生徒たちは授業で落第したため、オーマンは生徒たちに論文を最初から書き直させた。

論文には誤りはあるものの、よく書かれています

二人の教授は、AI が生成した 2 つの論文にはいくつかの重要な問題があると述べました。さらに明らかな痕跡があちこちに見られます。シック氏は、発見した論文には授業で言及されていないいくつかの事実が記載されており、主張は無効であると述べた。

彼はこう言った:「これは紙面上ではよく書かれた記事だが、よく見てみると、多作な哲学者デヴィッド・ヒュームについての記述であり、無意味であるか、完全に間違っている。

この種の完璧に装飾された間違いは、AI ゴーストライティングの最大の欠陥です。

オーマンにとって、チャットボットはあまりにも完璧に書かれていました。 「このチャット ツールは、私の生徒の 95% よりもうまく書かれていると思います。」 「すべての要件を完全に満たし、複雑な文法と複雑なアイデアを持ち、記事のプロンプトに直接関連するものを書いた人は、すぐにそれを感じました」間違っている」と彼は言った。

アパラチアン州立大学の哲学教授クリストファー・バーテル氏は、AIが生成した記事の文法はほぼ完璧だが、実質的な内容には詳細が欠けていることが多いと述べた。

「文脈も深みも洞察力もない。」

証明できない盗作: 告白しないことには何もできない

しかし、そうは言っても、何人かの教授の学生が AI のゴーストライティングを認めています。実際、学生が論文執筆に人工知能を使用していることを認めようとしない場合、学術コミュニティは問題に直面する可能性があります。

バーテル氏は、一部の学術機関の現在の規則はこの種の不正行為に対処するために開発されていないと述べた。学生が人工知能の使用をわざわざ否定した場合、そのような不正行為を決定的に証明することは実際には困難です。

同氏は、OpenAI が提供する AI 検出ツールは優れているが、完璧ではないとも述べました。

このツールは、テキストが人工知能によって生成された可能性について統計分析を実行し、確率を示します。

現在の方針では、一般に、論文がハンマーとみなされる前に、その論文が虚偽であることを証明する明確で検証可能な証拠が必要であるということになっており、これにより私たちは非常に難しい立場に置かれています。返された結果が人工知能によって生成された記事である可能性が 95% である場合、そうでない可能性は 5% です。

シックの場合、試験ウェブサイトには論文が人工知能によって生成されたことが「99%確実」であると書かれていましたが、実際には、重要なのは学生自身がそれを認めたことです。それ以外の場合、この確率の結果だけでは不正行為を確認するのに十分ではありません。

ヒック氏は「自白は重要だが、それ以外は状況証拠だ。人工知能によって生成されたコンテンツには、一般に物的証拠はなく、物的証拠の方が優れている」と述べた。間接的な証拠。より大きな部分があります。 「

オーマン氏は、チャットボットの分析は行動を起こすのに十分な証拠であると信じているが、盗作や不正行為に人工知能を使用することは依然として大学にとって新たな課題であると述べました。

結局のところ、ChatGPT は偽物を本物のように見せかける優れた能力を備えているため、ユーザーが望む限り、ほんの数分で CheatGPT になることができます。

以上が盗作と不正行為のため、ChatGPT は 12 枚の署名入り論文を密かに生成しました。マーカスが Ta を CheatGPT に変えたことを非難の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7454

7454

15

15

1375

1375

52

52

77

77

11

11

14

14

9

9

ChatGPT では、無料ユーザーが 1 日あたりの制限付きで DALL-E 3 を使用して画像を生成できるようになりました

Aug 09, 2024 pm 09:37 PM

ChatGPT では、無料ユーザーが 1 日あたりの制限付きで DALL-E 3 を使用して画像を生成できるようになりました

Aug 09, 2024 pm 09:37 PM

DALL-E 3は、前モデルより大幅に改良されたモデルとして2023年9月に正式導入されました。これは、複雑な詳細を含む画像を作成できる、これまでで最高の AI 画像ジェネレーターの 1 つと考えられています。ただし、発売当初は対象外でした

Stable Diffusion 3 の論文がついに公開され、アーキテクチャの詳細が明らかになりましたが、Sora の再現に役立つでしょうか?

Mar 06, 2024 pm 05:34 PM

Stable Diffusion 3 の論文がついに公開され、アーキテクチャの詳細が明らかになりましたが、Sora の再現に役立つでしょうか?

Mar 06, 2024 pm 05:34 PM

StableDiffusion3 の論文がついに登場しました!このモデルは2週間前にリリースされ、Soraと同じDiT(DiffusionTransformer)アーキテクチャを採用しており、リリースされると大きな話題を呼びました。前バージョンと比較して、StableDiffusion3で生成される画像の品質が大幅に向上し、マルチテーマプロンプトに対応したほか、テキスト書き込み効果も向上し、文字化けが発生しなくなりました。 StabilityAI は、StableDiffusion3 はパラメータ サイズが 800M から 8B までの一連のモデルであると指摘しました。このパラメーター範囲は、モデルを多くのポータブル デバイス上で直接実行できることを意味し、AI の使用を大幅に削減します。

ChatGPT と Python の完璧な組み合わせ: インテリジェントな顧客サービス チャットボットの作成

Oct 27, 2023 pm 06:00 PM

ChatGPT と Python の完璧な組み合わせ: インテリジェントな顧客サービス チャットボットの作成

Oct 27, 2023 pm 06:00 PM

ChatGPT と Python の完璧な組み合わせ: インテリジェント カスタマー サービス チャットボットの作成 はじめに: 今日の情報化時代において、インテリジェント カスタマー サービス システムは企業と顧客の間の重要なコミュニケーション ツールとなっています。より良い顧客サービス体験を提供するために、多くの企業が顧客相談や質問応答などのタスクを完了するためにチャットボットに注目し始めています。この記事では、OpenAI の強力なモデル ChatGPT と Python 言語を使用して、インテリジェントな顧客サービス チャットボットを作成し、顧客サービスを向上させる方法を紹介します。

携帯電話にchatgptをインストールする方法

Mar 05, 2024 pm 02:31 PM

携帯電話にchatgptをインストールする方法

Mar 05, 2024 pm 02:31 PM

インストール手順: 1. ChatGTP ソフトウェアを ChatGTP 公式 Web サイトまたはモバイル ストアからダウンロードします; 2. それを開いた後、設定インターフェイスで言語を中国語を選択します; 3. ゲーム インターフェイスでヒューマン マシン ゲームを選択し、中国スペクトル; 4 . 起動後、チャット ウィンドウにコマンドを入力してソフトウェアを操作します。

NeRFと自動運転の過去と現在、10本近くの論文をまとめました!

Nov 14, 2023 pm 03:09 PM

NeRFと自動運転の過去と現在、10本近くの論文をまとめました!

Nov 14, 2023 pm 03:09 PM

Neural Radiance Fieldsは2020年に提案されて以来、関連論文の数が飛躍的に増加し、3次元再構成の重要な分野となっただけでなく、自動運転の重要なツールとして研究の最前線でも徐々に活発になってきています。 NeRF は、過去 2 年間で突然出現しました。その主な理由は、特徴点の抽出とマッチング、エピポーラ幾何学と三角形分割、PnP とバンドル調整、および従来の CV 再構成パイプラインのその他のステップをスキップし、メッシュ再構成、マッピング、ライト トレースさえもスキップするためです。 、2D から直接入力画像を使用して放射線野を学習し、実際の写真に近いレンダリング画像が放射線野から出力されます。言い換えれば、ニューラル ネットワークに基づく暗黙的な 3 次元モデルを指定されたパースペクティブに適合させます。

ChatGPT と Java を使用してインテリジェントなチャットボットを開発する方法

Oct 28, 2023 am 08:54 AM

ChatGPT と Java を使用してインテリジェントなチャットボットを開発する方法

Oct 28, 2023 am 08:54 AM

この記事では、ChatGPT と Java を使用してインテリジェントなチャットボットを開発する方法を紹介し、いくつかの具体的なコード例を示します。 ChatGPT は、OpenAI によって開発された生成事前トレーニング トランスフォーマーの最新バージョンです。これは、自然言語を理解し、人間のようなテキストを生成できるニューラル ネットワーク ベースの人工知能テクノロジーです。 ChatGPT を使用すると、適応型チャットを簡単に作成できます

中国でもchatgptは使えますか?

Mar 05, 2024 pm 03:05 PM

中国でもchatgptは使えますか?

Mar 05, 2024 pm 03:05 PM

chatgpt は中国でも使用できますが、香港やマカオでも登録できません。ユーザーが登録したい場合は、外国の携帯電話番号を使用して登録できます。登録プロセス中にネットワーク環境を切り替える必要があることに注意してください。外国のIP。

ChatGPT PHP を使用してインテリジェントな顧客サービス ロボットを構築する方法

Oct 28, 2023 am 09:34 AM

ChatGPT PHP を使用してインテリジェントな顧客サービス ロボットを構築する方法

Oct 28, 2023 am 09:34 AM

ChatGPTPHP を使用してインテリジェントな顧客サービス ロボットを構築する方法 はじめに: 人工知能技術の発展に伴い、顧客サービスの分野でロボットの使用が増えています。 ChatGPTPHP を使用してインテリジェントな顧客サービス ロボットを構築すると、企業はより効率的でパーソナライズされた顧客サービスを提供できるようになります。この記事では、ChatGPTPHP を使用してインテリジェントな顧客サービス ロボットを構築する方法を紹介し、具体的なコード例を示します。 1. ChatGPTPHP をインストールし、ChatGPTPHP を使用してインテリジェントな顧客サービス ロボットを構築します。