機械学習の要点: 過学習を防ぐには?

実際、正則化の本質は非常に単純で、特定の目的を達成するために、特定の問題にアプリオリな制限や制約を課す手段や操作です。アルゴリズムで正則化を使用する目的は、モデルの過剰適合を防ぐことです。正則化というと、多くの学生はよく使われる L1 ノルムと L2 ノルムをすぐに思い浮かべるかもしれませんが、要約する前に、まず LP ノルムとは何かを見てみましょう。

LP ノルム

ノルムは、単純にベクトル空間の距離を表すものとして理解できますが、距離の定義は非常に抽象的です。 -否定的、再帰的、三角不等式、それは距離です。

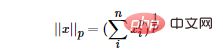

LP ノルムはノルムではなく、次のように定義される一連のノルムです:

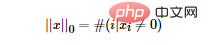

L0 ノルムを最小化することで、最も最適でないスパース特徴を見つけることができます。しかし残念なことに、L0 ノルムの最適化問題は NP 困難問題です (L0 ノルムも非凸です)。したがって、実際のアプリケーションでは、L0 の凸緩和を実行することがよくあります。L1 ノルムが L0 ノルムの最適な凸近似であることが理論的に証明されているため、通常は L0 ノルムを直接最適化する代わりに L1 ノルムが使用されます。

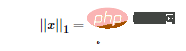

L1 ノルム LP ノルムの定義に従って、L1 ノルムの数学的形式を簡単に取得できます。

LP ノルムの定義に従って、L1 ノルムの数学的形式を簡単に取得できます。

機能選択

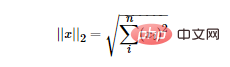

- L2 ノルム

- L2 ノルムは最もよく知られています。ユークリッド距離です。式は次のとおりです:

次の図に示すように、L1 ノルムと L2 ノルムの違いを示す PRML の古典的な図を紹介します。

次の図に示すように、L1 ノルムと L2 ノルムの違いを示す PRML の古典的な図を紹介します。

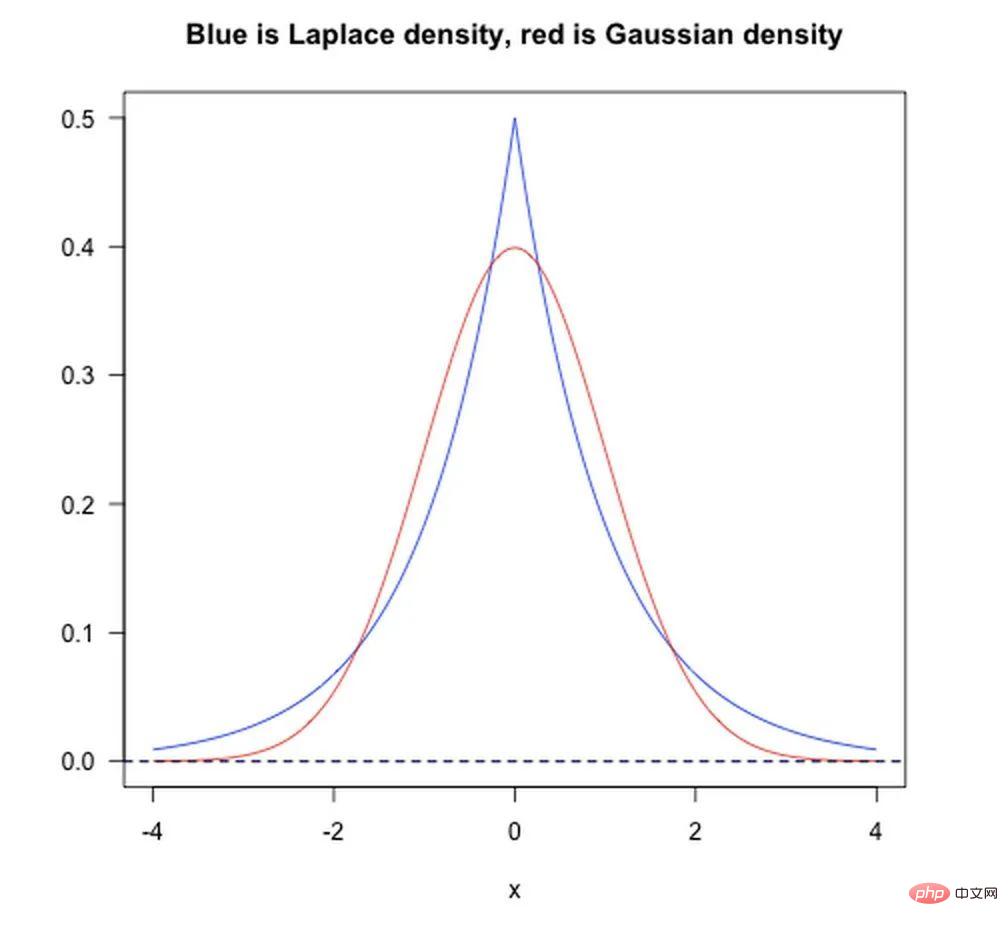

ベイズ事前の観点から見ると、モデルをトレーニングするとき、現在のトレーニング データセットのみに依存するだけでは十分ではありません。より優れた汎化機能を達成するには、多くの場合、事前項と正規項を追加する必要があります。先験的に追加することに相当します。

- L1 ノルムはラプラス事前分布を追加することと同等です;

- L2 ノルムは事前ガウス分布を追加することと同等です。

以下の図に示すように:

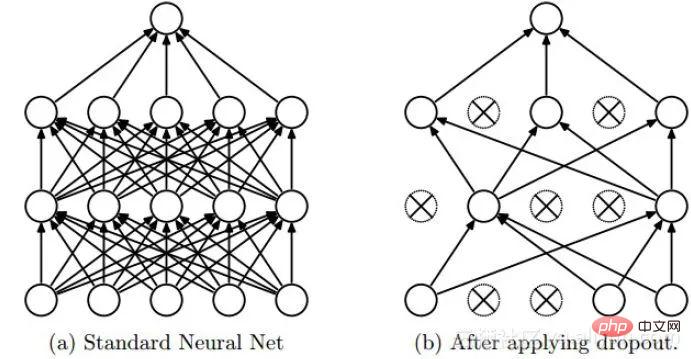

Dropout

Dropout は深層学習でよく使用される正則化手法です。そのアプローチは、DNN のトレーニング プロセス中に確率 p で一部のニューロンを破棄する、つまり、破棄されたニューロンの出力が 0 であると単純に理解できます。 Dropout は、次の図に示すようにインスタンス化できます。

- バッチ正規化

- バッチ正規化は厳密には正規化手法であり、主にネットワークの収束を加速するために使用されますが、ある程度の正則化効果もあります。

ここでは、Wei Xiushen 博士の Zhihu 回答における共変量シフトの説明への参照を示します。

注: 以下の内容は、Wei Xiushen 博士の Zhihu 回答から引用されています。統計的機械学習における古典的な前提が「ソース空間 (ソース ドメイン) とターゲット空間 (ターゲット ドメイン) のデータ分布」であることは誰もが知っています。 「(配信は)一貫している」。それらが矛盾している場合、転移学習/ドメイン適応などの新しい機械学習の問題が発生します。共変量シフトは不一致分布を仮定した分岐問題であり、ソース空間とターゲット空間の条件付き確率は一致しているが、その周辺確率が異なることを意味します。よくよく考えてみると、確かにニューラルネットワークの各層の出力は、層内演算を経ているため、その分布が各層に対応する入力信号の分布とは明らかに異なっていることが分かります。ネットワークの深さが増すにつれて差は大きくなりますが、「示す」ことができるサンプル ラベルは変化せず、共変量シフトの定義を満たします。

BN の基本的な考え方は、実際には非常に直観的です。なぜなら、非線形変換前のニューラル ネットワークの活性化入力値 (X=WU B、U は入力) は、ネットワークの深さが深くなるにつれて、その値が大きくなるからです。分布は徐々にシフトまたは変化します (つまり、上記の共変量シフト)。トレーニングの収束が遅い理由は、一般に、全体の分布が非線形関数の値の範囲の上限と下限に徐々に近づくためです (シグモイド関数の場合、活性化入力値 X=WU B が大きな負または正であることを意味します)。 value) であるため、これによりバックプロパゲーション中に低レベル ニューラル ネットワークの勾配が消失します。これが、トレーニングにおけるディープ ニューラル ネットワークの収束がますます遅くなる根本的な理由です。 BN は、特定の標準化手法を使用して、ニューラル ネットワークの各層のニューロンの入力値の分布を、平均 0、分散 1 の標準正規分布に強制的に戻します。これにより、勾配分散の問題が発生します。アクティベーション機能。したがって、BN の役割は共変量シフトを軽減することであると言うよりも、BN が勾配分散問題を軽減できると言う方が適切です。

正規化、標準化、正則化

正規化については以前に説明しましたが、ここでは正規化と標準化について簡単に説明します。正規化: 正規化の目的は、元のデータを [a, b] 間隔にマッピングするための特定のマッピング関係を見つけることです。一般に、a と b は [−1,1]、[0,1] の組み合わせになります。通常、次の 2 つのアプリケーション シナリオがあります。

数値を (0, 1) の間の小数に変換します。次元数値を無次元数値に変換します。- 一般的に使用される最小-最大正規化:

正規化と標準化の違い:

これは次のように簡単に説明できます。正規化されたスケーリングは間隔 (極値によってのみ決定される) に対して「平坦化」されますが、標準化されたスケーリングはより「弾力的」です。 「」および「動的」であり、サンプル全体の分布に大きく関係します。注:

- 正規化: スケーリングは、最大値と最小値の差にのみ関係します。

- 標準化: スケーリングは各ポイントに関連しており、分散に反映されます。これを、すべてのデータ ポイントが (平均と標準偏差を通じて) 寄与する正規化と比較してください。

なぜ標準化と正規化なのか?

- モデルの精度の向上: 正規化後、異なる次元間の特徴が数値的に比較できるようになり、分類器の精度が大幅に向上します。

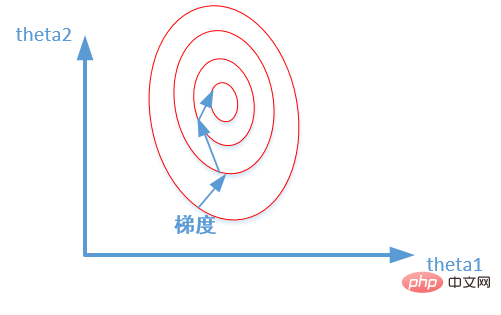

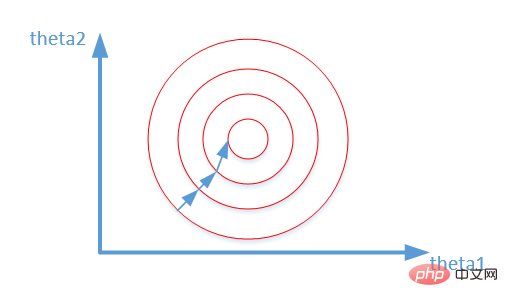

- モデルの収束を加速する: 標準化後は、最適解の最適化プロセスが明らかにスムーズになり、最適解に正確に収束しやすくなります。以下に示すように:

以上が機械学習の要点: 過学習を防ぐには?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7563

7563

15

15

1384

1384

52

52

84

84

11

11

28

28

99

99

この記事では、SHAP: 機械学習のモデルの説明について説明します。

Jun 01, 2024 am 10:58 AM

この記事では、SHAP: 機械学習のモデルの説明について説明します。

Jun 01, 2024 am 10:58 AM

機械学習とデータ サイエンスの分野では、モデルの解釈可能性が常に研究者や実務家に焦点を当ててきました。深層学習やアンサンブル手法などの複雑なモデルが広く適用されるようになったことで、モデルの意思決定プロセスを理解することが特に重要になってきました。 Explainable AI|XAI は、モデルの透明性を高めることで、機械学習モデルに対する信頼と自信を構築するのに役立ちます。モデルの透明性の向上は、複数の複雑なモデルの普及や、モデルを説明するための意思決定プロセスなどの方法によって実現できます。これらの方法には、特徴重要度分析、モデル予測間隔推定、ローカル解釈可能性アルゴリズムなどが含まれます。特徴重要度分析では、入力特徴に対するモデルの影響度を評価することで、モデルの意思決定プロセスを説明できます。モデルの予測間隔の推定

ORB-SLAM3を超えて! SL-SLAM: 低照度、重度のジッター、弱いテクスチャのシーンはすべて処理されます。

May 30, 2024 am 09:35 AM

ORB-SLAM3を超えて! SL-SLAM: 低照度、重度のジッター、弱いテクスチャのシーンはすべて処理されます。

May 30, 2024 am 09:35 AM

以前に書きましたが、今日は、深層学習テクノロジーが複雑な環境におけるビジョンベースの SLAM (同時ローカリゼーションとマッピング) のパフォーマンスをどのように向上させることができるかについて説明します。ここでは、深部特徴抽出と深度マッチング手法を組み合わせることで、低照度条件、動的照明、テクスチャの弱い領域、激しいセックスなどの困難なシナリオでの適応を改善するように設計された多用途のハイブリッド ビジュアル SLAM システムを紹介します。当社のシステムは、拡張単眼、ステレオ、単眼慣性、ステレオ慣性構成を含む複数のモードをサポートしています。さらに、他の研究にインスピレーションを与えるために、ビジュアル SLAM と深層学習手法を組み合わせる方法も分析します。公開データセットと自己サンプリングデータに関する広範な実験を通じて、測位精度と追跡堅牢性の点で SL-SLAM の優位性を実証しました。

C++ での機械学習アルゴリズムの実装: 一般的な課題と解決策

Jun 03, 2024 pm 01:25 PM

C++ での機械学習アルゴリズムの実装: 一般的な課題と解決策

Jun 03, 2024 pm 01:25 PM

C++ の機械学習アルゴリズムが直面する一般的な課題には、メモリ管理、マルチスレッド、パフォーマンスの最適化、保守性などがあります。解決策には、スマート ポインター、最新のスレッド ライブラリ、SIMD 命令、サードパーティ ライブラリの使用、コーディング スタイル ガイドラインの遵守、自動化ツールの使用が含まれます。実践的な事例では、Eigen ライブラリを使用して線形回帰アルゴリズムを実装し、メモリを効果的に管理し、高性能の行列演算を使用する方法を示します。

あなたが知らない機械学習の 5 つの流派

Jun 05, 2024 pm 08:51 PM

あなたが知らない機械学習の 5 つの流派

Jun 05, 2024 pm 08:51 PM

機械学習は人工知能の重要な分野であり、明示的にプログラムしなくてもコンピューターにデータから学習して能力を向上させる機能を提供します。機械学習は、画像認識や自然言語処理から、レコメンデーションシステムや不正行為検出に至るまで、さまざまな分野で幅広く応用されており、私たちの生活様式を変えつつあります。機械学習の分野にはさまざまな手法や理論があり、その中で最も影響力のある 5 つの手法は「機械学習の 5 つの流派」と呼ばれています。 5 つの主要な学派は、象徴学派、コネクショニスト学派、進化学派、ベイジアン学派、およびアナロジー学派です。 1. 象徴主義は、象徴主義とも呼ばれ、論理的推論と知識の表現のためのシンボルの使用を強調します。この学派は、学習は既存の既存の要素を介した逆演繹のプロセスであると信じています。

説明可能な AI: 複雑な AI/ML モデルの説明

Jun 03, 2024 pm 10:08 PM

説明可能な AI: 複雑な AI/ML モデルの説明

Jun 03, 2024 pm 10:08 PM

翻訳者 | Li Rui によるレビュー | 今日、人工知能 (AI) および機械学習 (ML) モデルはますます複雑になっており、これらのモデルによって生成される出力はブラックボックスになっており、関係者に説明することができません。 Explainable AI (XAI) は、利害関係者がこれらのモデルがどのように機能するかを理解できるようにし、これらのモデルが実際に意思決定を行う方法を確実に理解できるようにし、AI システムの透明性、信頼性、およびこの問題を解決するための説明責任を確保することで、この問題を解決することを目指しています。この記事では、さまざまな説明可能な人工知能 (XAI) 手法を検討して、その基礎となる原理を説明します。説明可能な AI が重要であるいくつかの理由 信頼と透明性: AI システムが広く受け入れられ、信頼されるためには、ユーザーは意思決定がどのように行われるかを理解する必要があります

フラッシュ アテンションは安定していますか?メタとハーバードは、モデルの重みの偏差が桁違いに変動していることを発見しました

May 30, 2024 pm 01:24 PM

フラッシュ アテンションは安定していますか?メタとハーバードは、モデルの重みの偏差が桁違いに変動していることを発見しました

May 30, 2024 pm 01:24 PM

MetaFAIR はハーバード大学と協力して、大規模な機械学習の実行時に生成されるデータの偏りを最適化するための新しい研究フレームワークを提供しました。大規模な言語モデルのトレーニングには数か月かかることが多く、数百、さらには数千の GPU を使用することが知られています。 LLaMA270B モデルを例にとると、そのトレーニングには合計 1,720,320 GPU 時間が必要です。大規模なモデルのトレーニングには、これらのワークロードの規模と複雑さにより、特有のシステム上の課題が生じます。最近、多くの機関が、SOTA 生成 AI モデルをトレーニングする際のトレーニング プロセスの不安定性を報告しています。これらは通常、損失スパイクの形で現れます。たとえば、Google の PaLM モデルでは、トレーニング プロセス中に最大 20 回の損失スパイクが発生しました。数値的なバイアスがこのトレーニングの不正確さの根本原因です。

改良された検出アルゴリズム: 高解像度の光学式リモートセンシング画像でのターゲット検出用

Jun 06, 2024 pm 12:33 PM

改良された検出アルゴリズム: 高解像度の光学式リモートセンシング画像でのターゲット検出用

Jun 06, 2024 pm 12:33 PM

01 今後の概要 現時点では、検出効率と検出結果の適切なバランスを実現することが困難です。我々は、光学リモートセンシング画像におけるターゲット検出ネットワークの効果を向上させるために、多層特徴ピラミッド、マルチ検出ヘッド戦略、およびハイブリッドアテンションモジュールを使用して、高解像度光学リモートセンシング画像におけるターゲット検出のための強化されたYOLOv5アルゴリズムを開発しました。 SIMD データセットによると、新しいアルゴリズムの mAP は YOLOv5 より 2.2%、YOLOX より 8.48% 優れており、検出結果と速度のバランスがより優れています。 02 背景と動機 リモート センシング技術の急速な発展に伴い、航空機、自動車、建物など、地表上の多くの物体を記述するために高解像度の光学式リモート センシング画像が使用されています。リモートセンシング画像の判読における物体検出

AlphaFold 3 が発売され、タンパク質とすべての生体分子の相互作用と構造をこれまでよりもはるかに高い精度で包括的に予測します。

Jul 16, 2024 am 12:08 AM

AlphaFold 3 が発売され、タンパク質とすべての生体分子の相互作用と構造をこれまでよりもはるかに高い精度で包括的に予測します。

Jul 16, 2024 am 12:08 AM

エディター | Radish Skin 2021 年の強力な AlphaFold2 のリリース以来、科学者はタンパク質構造予測モデルを使用して、細胞内のさまざまなタンパク質構造をマッピングし、薬剤を発見し、既知のあらゆるタンパク質相互作用の「宇宙地図」を描いてきました。ちょうど今、Google DeepMind が AlphaFold3 モデルをリリースしました。このモデルは、タンパク質、核酸、小分子、イオン、修飾残基を含む複合体の結合構造予測を実行できます。 AlphaFold3 の精度は、これまでの多くの専用ツール (タンパク質-リガンド相互作用、タンパク質-核酸相互作用、抗体-抗原予測) と比較して大幅に向上しました。これは、単一の統合された深層学習フレームワーク内で、次のことを達成できることを示しています。