ChatGPT を全員に提供するという夢がもうすぐ実現しますか?

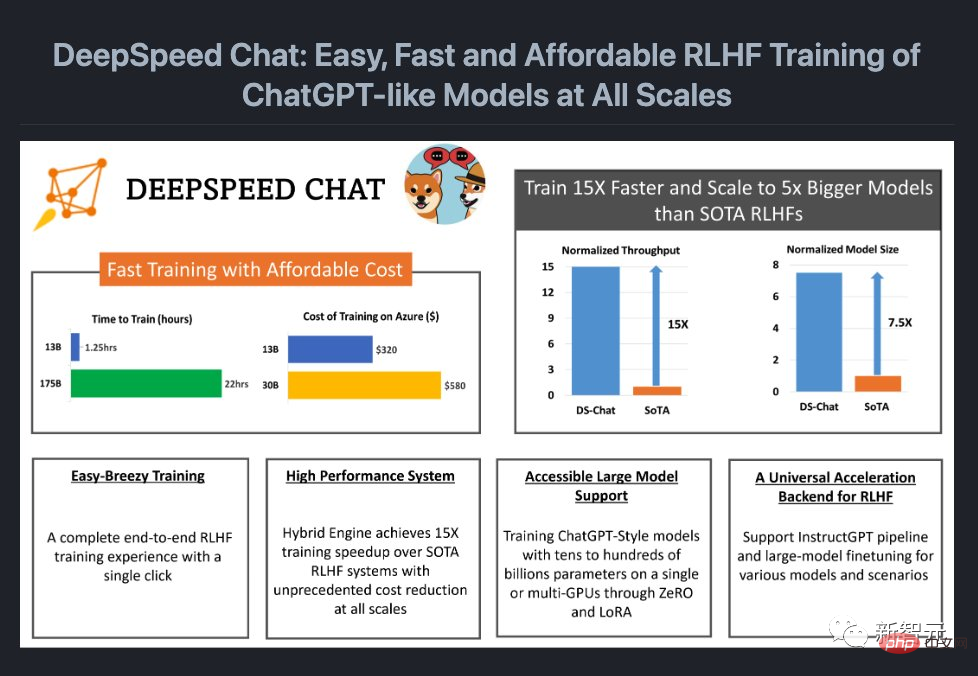

たった今、Microsoft はモデル トレーニングに完全な RLHF プロセスを追加できるシステム フレームワーク、DeepSpeed Chat をオープンソース化しました。

言い換えれば、あらゆるサイズの高品質な ChatGPT のようなモデルが簡単に手に入るようになりました。

プロジェクト アドレス: https://github.com/microsoft/DeepSpeed

ロック解除ワンクリックで 1,000 億レベルの ChatGPT を 15 回簡単に保存ご存知のとおり、OpenAI はオープンではないため、オープンソース コミュニティは、より多くの人が利用できるようにするために LLaMa と Alpaca を次々と立ち上げてきました。 ChatGPT のようなモデル、Vicuna、Databricks-Dolly などのモデルを使用します。

ただし、エンドツーエンドの RLHF スケール システムがないため、ChatGPT のようなモデルの現在のトレーニングは依然として非常に困難です。 DeepSpeed Chatの登場はまさにこの「バグ」を補ってくれます。

さらに素晴らしいのは、DeepSpeed Chat によってコストが大幅に削減されたことです。

以前は、高価なマルチ GPU セットアップは多くの研究者の能力を超えており、マルチ GPU クラスターにアクセスできたとしても、既存の方法では数千億のパラメーター ChatGPT モデルを処理する余裕がありませんでした。トレーニング。

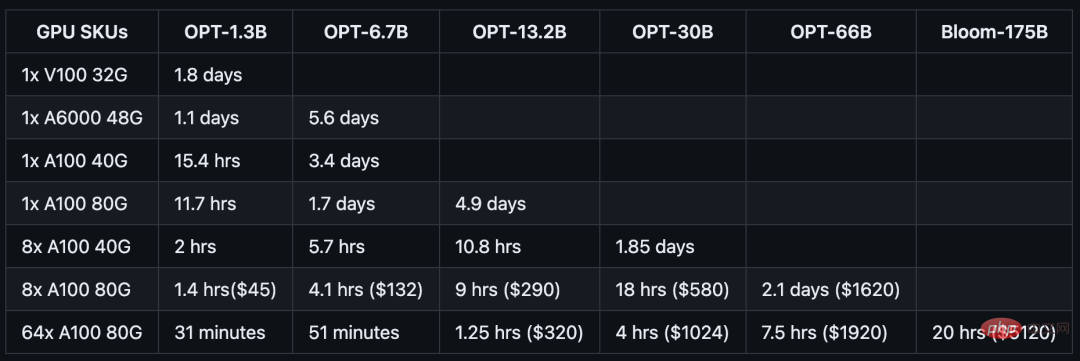

現在、わずか 1,620 ドルで、ハイブリッド エンジン DeepSpeed-HE を使用して OPT-66B モデルを 2.1 日でトレーニングできます。

マルチノード、マルチ GPU システムを使用する場合、DeepSpeed-HE は、OPT-13B モデルを 1.25 時間でトレーニングするのに 320 米ドルを費やし、 OPT-13B モデルのトレーニングには 1.25 時間未満、OPT-175B モデルのトレーニングには 1 日かかります。

元メタ AI 専門家であるエルヴィス氏は、これは大きな出来事だと興奮しながらそれを転送し、DeepSpeed Chat が ColossalChat とどのように比較されるかについて興味を示しました。

DeepSpeed-Chat によるトレーニング後の質疑応答では、13 億パラメータ版「ChatGPT」が非常に高いパフォーマンスを発揮しました。質問の文脈を理解できるだけでなく、提供された回答も関連性があります。

最初の ChatGPT を生成するコード

最初の ChatGPT を生成するコード

git clone https://github.com/microsoft/DeepSpeed.git cd DeepSpeed pip install . git clone https://github.com/microsoft/DeepSpeedExamples.git cd DeepSpeedExamples/applications/DeepSpeed-Chat/ pip install -r requirements.txt

チームは、コンシューマーグレードの GPU でテストできる 1.3B モデル用のトレーニング サンプルを特別に用意しました。最も素晴らしいのは、昼休みから戻ってくると、すべての準備が整っていることです。

python train.py --actor-model facebook/opt-1.3b --reward-model facebook/opt-350m --num-gpus 1

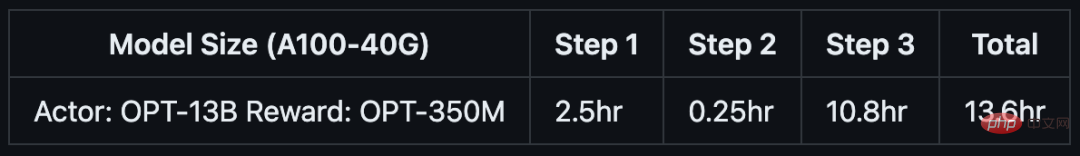

如果你只有半天的时间,以及一台服务器节点,则可以通过预训练的OPT-13B作为actor模型,OPT-350M作为reward模型,来生成一个130亿参数的类ChatGPT模型:

python train.py --actor-model facebook/opt-13b --reward-model facebook/opt-350m --num-gpus 8

单DGX节点,搭载了8个NVIDIA A100-40G GPU:

如果你可以使用多节点集群或云资源,并希望训练一个更大、更高质量的模型。那么只需基于下面这行代码,输入你想要的模型大小(如66B)和GPU数量(如64):

python train.py --actor-model facebook/opt-66b --reward-model facebook/opt-350m --num-gpus 64

8个DGX节点,每个节点配备8个NVIDIA A100-80G GPU:

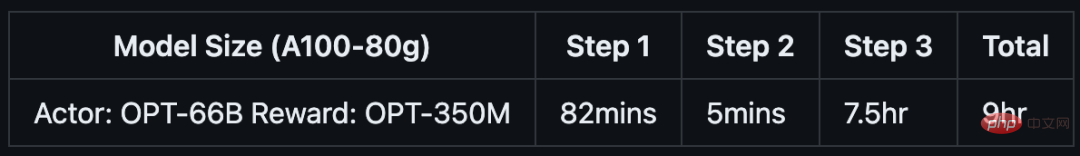

具体来说,针对不同规模的模型和硬件配置,DeepSpeed-RLHF系统所需的时间和成本如下:

DeepSpeed Chat是一种通用系统框架,能够实现类似ChatGPT模型的端到端RLHF训练,从而帮助我们生成自己的高质量类ChatGPT模型。

DeepSpeed Chat具有以下三大核心功能:

1. 简化ChatGPT类型模型的训练和强化推理体验

开发者只需一个脚本,就能实现多个训练步骤,并且在完成后还可以利用推理API进行对话式交互测试。

2. DeepSpeed-RLHF模块

DeepSpeed-RLHF复刻了InstructGPT论文中的训练模式,并提供了数据抽象和混合功能,支持开发者使用多个不同来源的数据源进行训练。

3. DeepSpeed-RLHF系统

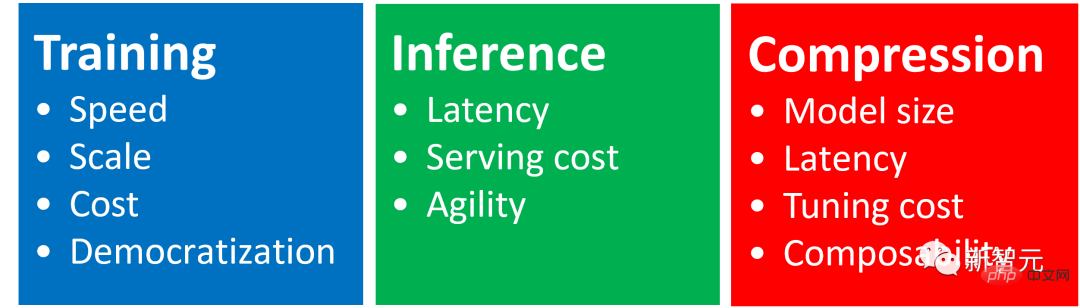

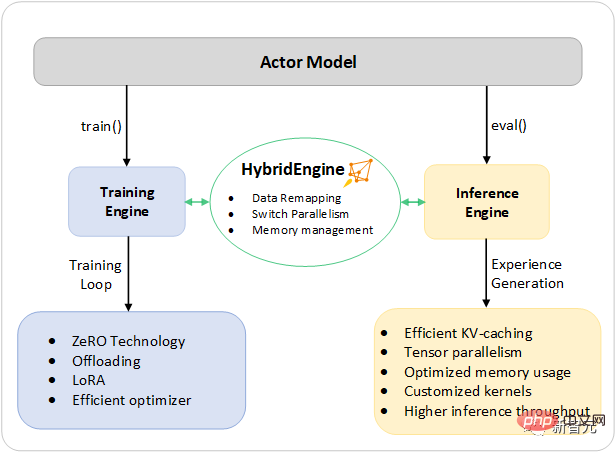

团队将DeepSpeed的训练(training engine)和推理能力(inference engine) 整合成了一个统一的混合引擎(DeepSpeed Hybrid Engine or DeepSpeed-HE)中,用于RLHF训练。由于,DeepSpeed-HE能够无缝地在推理和训练模式之间切换,因此可以利用来自DeepSpeed-Inference的各种优化。

DeepSpeed-RLHF系统在大规模训练中具有无与伦比的效率,使复杂的RLHF训练变得快速、经济并且易于大规模推广:

DeepSpeed-HE比现有系统快15倍以上,使RLHF训练快速且经济实惠。

例如,DeepSpeed-HE在Azure云上只需9小时即可训练一个OPT-13B模型,只需18小时即可训练一个OPT-30B模型。这两种训练分别花费不到300美元和600美元。

DeepSpeed-HE は、数千億のパラメータを持つトレーニング モデルをサポートし、マルチノード マルチ GPU システムで実行できます。優れた拡張性を発揮します。

したがって、130 億個のパラメータを持つモデルでも、わずか 1.25 時間でトレーニングできます。 1,750 億個のパラメータを持つモデルの場合、DeepSpeed-HE を使用したトレーニングには 1 日もかかりません。

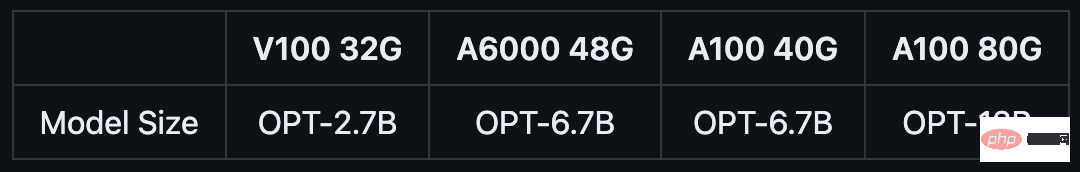

単一 GPU、DeepSpeed-HE だけが複数のモデルのトレーニングをサポートできます130億のパラメータを持ちます。これにより、マルチ GPU システムにアクセスできないデータ サイエンティストや研究者は、軽量の RLHF モデルだけでなく、さまざまな使用シナリオに対応する大規模で強力なモデルも簡単に作成できるようになります。

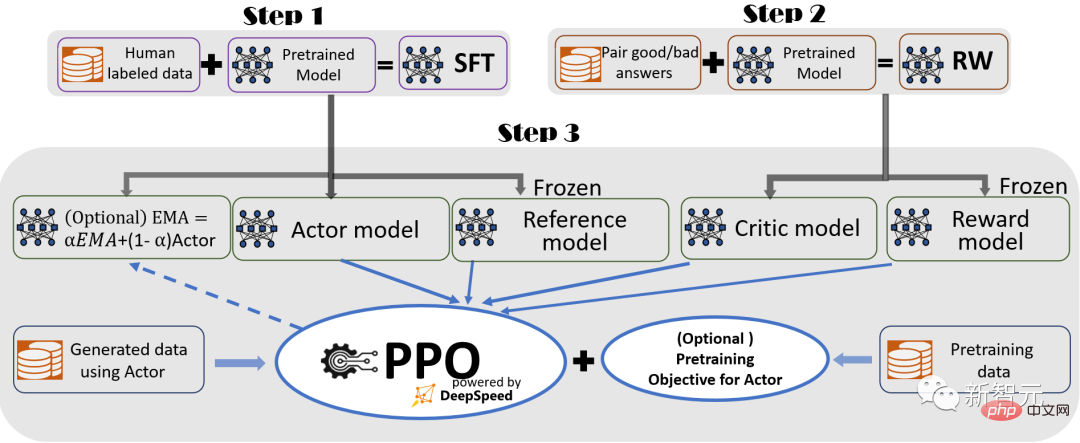

シームレスなトレーニング エクスペリエンスを提供するために、研究者は InstructGPT に従い、それを DeepSpeed で使用しました。 Chat It には、完全なエンドツーエンドのトレーニング プロセスが含まれています。

DeepSpeed-Chat の RLHF トレーニング プロセス図 (いくつかのオプション機能を含む)

このプロセスは 3 つの主要なステップで構成されます。

教師あり微調整 (SFT)、微調整に対する主要な人間の回答を使用します。事前トレーニングされた言語モデルを調整して、さまざまなクエリに応答します。

報酬モデルの微調整。同じクエリに対する複数の回答に対する人間による評価を含むデータセットでトレーニングされます。独立した (通常は SFT より小さい) 報酬モデル (RW)。

RLHF トレーニング このステップでは、近似ポリシー最適化 ( PPO) アルゴリズム: 報酬フィードバックはさらに微調整されます。

ステップ 3 では、研究者はモデルの品質向上に役立つ 2 つの追加関数も提供します:

-Exponential Moving Average (EMA) ) コレクションでは、最終評価のために EMA ベースのチェックポイントを選択できます。

- ハイブリッド トレーニング。トレーニング前の目標 (つまり、次の単語の予測) と PPO の目標を組み合わせて、公開ベンチマーク (SQuAD2.0 など) でのパフォーマンスの低下を防ぎます。

EMA とハイブリッド トレーニングは、トレーニングを妨げないため、他のオープンソース フレームワークでは無視されることが多い 2 つのトレーニング機能です。

ただし、InstructGPT によると、EMA チェックポイントは従来の最終トレーニング モデルよりも応答品質が向上する傾向があり、ハイブリッド トレーニングはモデルがトレーニング前のベースライン解決能力を維持するのに役立ちます。

したがって、研究者は、ユーザーが InstructGPT で説明されているトレーニング体験を十分に得ることができるように、これらの機能をユーザーに提供します。

# InstructGPT 論文との一貫性が高いことに加えて、研究者は、開発者がさまざまなデータ リソースを使用して独自の RLHF モデルをトレーニングできるようにする機能も提供しています。#データ抽象化とハイブリッド機能:

ガイド付き RLHF パイプラインのステップ 1 と 2 を示します。これは、大規模モデルの従来の微調整と同様であり、ZeRO ベースの最適化と柔軟な並列処理によって駆動されます。 DeepSpeed トレーニング スケールとスピードを達成するための戦略の組み合わせ。 パイプラインのステップ 3 は、パフォーマンスへの影響という点で最も複雑な部分です。 各反復では、次の 2 つのステージを効果的に処理する必要があります: a) トレーニング入力を生成するために、トークン/エクスペリエンスの生成に使用される推論ステージ、b) アクターと重みを更新するトレーニング ステージ報酬モデルの概要、およびそれらの間の対話とスケジュール設定。 これには 2 つの大きな問題があります: (1) 複数の SFT モデルと RW モデルを第 3 ステージ全体で実行する必要があるため、メモリのコストがかかります; (2) 応答生成ステージの速度が遅くなります。正しく加速しないと、第 3 ステージ全体の速度が大幅に低下します。 さらに、研究者が第 3 段階で追加した 2 つの重要な機能である指数移動平均 (EMA) 収集とハイブリッド トレーニングでは、追加のメモリとトレーニングのコストが発生します。 DeepSpeed ハイブリッド エンジン

#これらの課題に対処するために、研究者たちは、DeepSpeed のトレーニングと推論のすべてのシステム機能を統合インフラストラクチャに統合しました。つまりハイブリッドエンジンです。

高速トレーニング モードにはオリジナルの DeepSpeed エンジンを利用し、生成/評価モードには DeepSpeed 推論エンジンを簡単に適用して、RLHF の第 3 段階により良いソリューションを提供します。トレーニング 高速トレーニングシステム。

以下の図に示すように、DeepSpeed トレーニング エンジンと推論エンジンの間の移行はシームレスです。推論の実行時に、アクター モデルの一般的な評価モードとトレーニング モードを有効にすることで、 DeepSpeed は、モデルをより高速に実行し、システム全体のスループットを向上させるために、さまざまな最適化を選択しました。

##RLHF プロセスの最も時間のかかる部分を加速する DeepSpeed ハイブリッド エンジン設計

RLHF トレーニングのエクスペリエンス生成フェーズの推論実行プロセス中、DeepSpeed ハイブリッド エンジンは、高度に最適化された推論 CUDA コアとテンソル並列を使用しながら、軽量のメモリ管理システムを使用して KV キャッシュと中間結果を処理します。コンピューティングでは、既存のソリューションと比較して、スループット (1 秒あたりのトークン数) が大幅に向上しました。

トレーニング中に、ハイブリッド エンジンは、DeepSpeed の ZeRO シリーズ テクノロジーや低次適応 (LoRA) などのメモリ最適化テクノロジーを有効にします。

研究者がこれらのシステムの最適化を設計および実装する方法は、それらを相互に互換性を持たせ、統合されたハイブリッド エンジンの下で最高のトレーニング効率を提供するために組み合わせることができるようにすることです。

ハイブリッド エンジンは、トレーニングおよび推論中にモデルの分割をシームレスに変更して、テンソル並列ベースの推論と ZeRO ベースのトレーニング シャーディング メカニズムをサポートできます。

メモリ システムを再構成して、すべてのモードでメモリの可用性を最大化することもできます。

これにより、メモリ割り当てのボトルネックが回避され、大きなバッチ サイズをサポートできるため、パフォーマンスが大幅に向上します。

要約すると、ハイブリッド エンジンは最新の RLHF トレーニングの限界を押し広げ、RLHF ワークロードに比類のない規模とシステム効率を提供します。

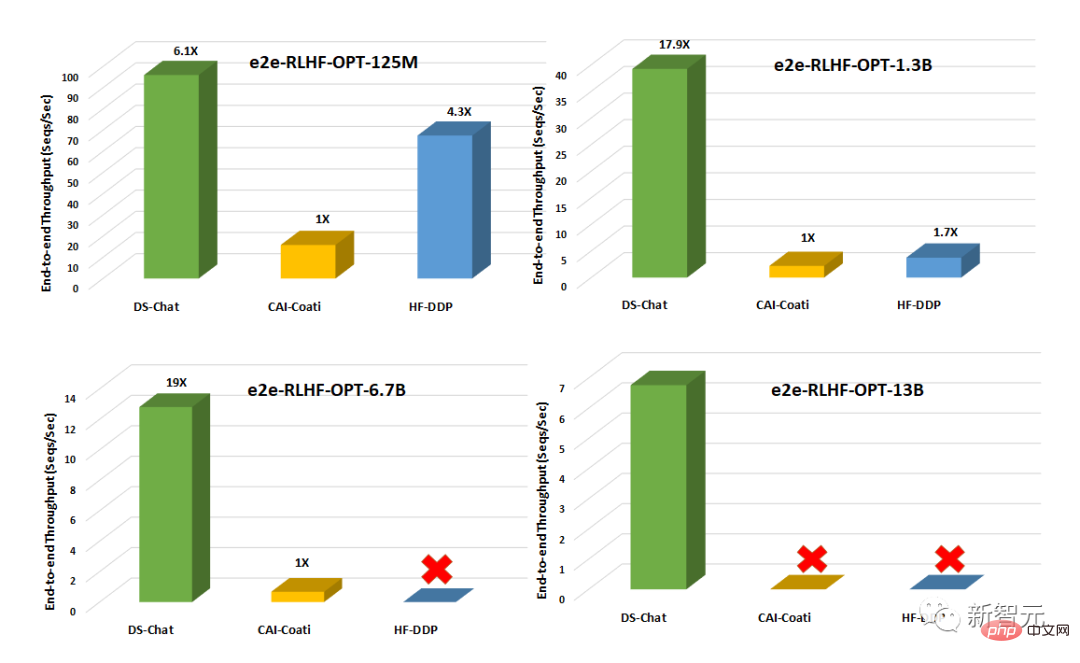

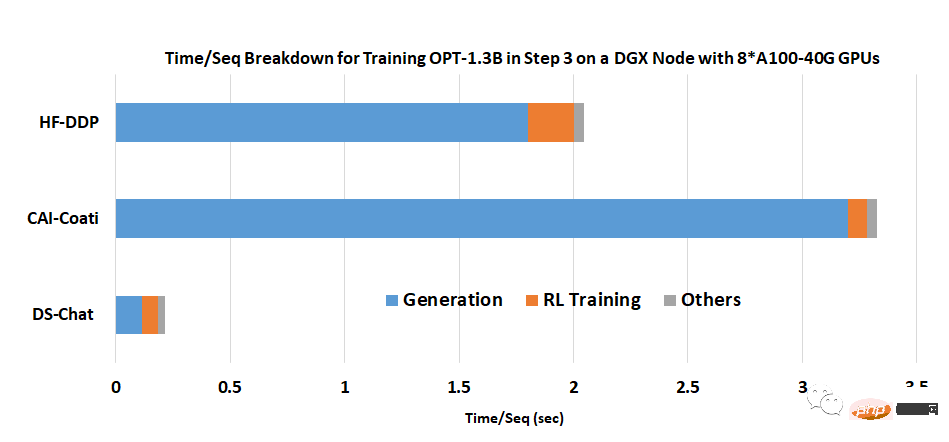

Colossal-AIやHuggingFace-DDPなどの既存システムとの比較DeepSpeed - チャットのスループットは桁違いで、同じレイテンシー バジェットでより大きなアクター モデルをトレーニングしたり、より低いコストで同様のサイズのモデルをトレーニングしたりできます。

たとえば、DeepSpeed は、単一 GPU で RLHF トレーニングのスループットを 10 倍以上向上させます。 CAI-Coati と HF-DDP は両方とも 1.3B モデルを実行できますが、DeepSpeed は同じハードウェア上で 6.5B モデルを実行でき、これは直接 5 倍です。

単一ノード上の複数の GPU では、DeepSpeed-Chat はシステム スループット (HF-) の点で CAI-Coati より 6 ~ 19 倍高速です。 DDPは1.4~10.5倍高速化されます。

チームは、DeepSpeed-Chat がこのような優れた結果を達成できる主な理由の 1 つは、生成中にハイブリッド エンジンによって提供される加速であると述べました。段階。

以上が誰もが ChatGPT を持っています。 Microsoft DeepSpeed Chat が衝撃的にリリースされ、数千億の大規模モデルをワンクリックで RLHF トレーニングできるの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。