マルチモダリティが再び統合されました! Meta が自己教師ありアルゴリズム data2vec 2.0 をリリース: トレーニング効率が最大 16 倍向上!

近年の人工知能分野における進歩のほとんどは、BERT で提案された MLM (マスク言語モデル) などの自己教師あり学習によって推進されています。テキスト内の単語をマスキングすることで、ラベルのない大量のテキスト データをモデルのトレーニングに使用できるようになり、それ以来、大規模な事前トレーニング モデルの新時代が開かれました。ただし、自己教師あり学習アルゴリズムには明らかな制限もあり、通常、単一モダリティ (画像、テキスト、音声など) のデータにのみ適しており、大量のデータから学習するには大量の計算能力が必要です。対照的に、人間は現在の AI モデルよりもはるかに効率的に学習し、さまざまな種類のデータから学習できます。

2022 年 1 月、Meta AI は自己教師あり学習フレームワーク data2vec # をリリースしました。 ## では、3 つのモーダル データ (音声、ビジュアル、テキスト) をフレームワークを通じて統合し、マルチモダリティを統合する傾向があります。 最近 Meta AI がリリースされました data2cec 2.0 バージョン 、主にパフォーマンスの点で前世代が向上しています。同じ精度で、トレーニング速度は他のアルゴリズムよりも最大 16 倍速くなります。 ################################################ #紙リンク:

https://ai.facebook.com/research/publications/e  ビジョンスピーチと言語のためのコンテキスト化されたターゲット表現による効率的な自己教師あり学習

ビジョンスピーチと言語のためのコンテキスト化されたターゲット表現による効率的な自己教師あり学習

コードリンク: https://github.com/faceboo kresearch/fairseq/tree/main/examples/data2vec

data2vec 1.0現時点で最も多くのことが言われています機械学習モデルは依然として教師あり学習モデルに基づいており、ターゲット データにラベルを付けるには専門のアノテーターが必要ですが、一部のタスク (地球上の何千もの人間の言語など) では、ラベル付きデータを収集するのは現実的ではありません。 対照的に、自己教師あり学習では、何が正しくて何が間違っているかをモデルに伝える必要はありませんが、機械が学習できるようになります。世界、音声とテキストの構造を観察することによるイメージ。

関連する研究結果は、音声 (wave2vec 2.0 など)、コンピュータ ビジョン (マスクされたオートエンコーダなど)、自然言語処理 (BERT など) を促進してきました。他の分野。

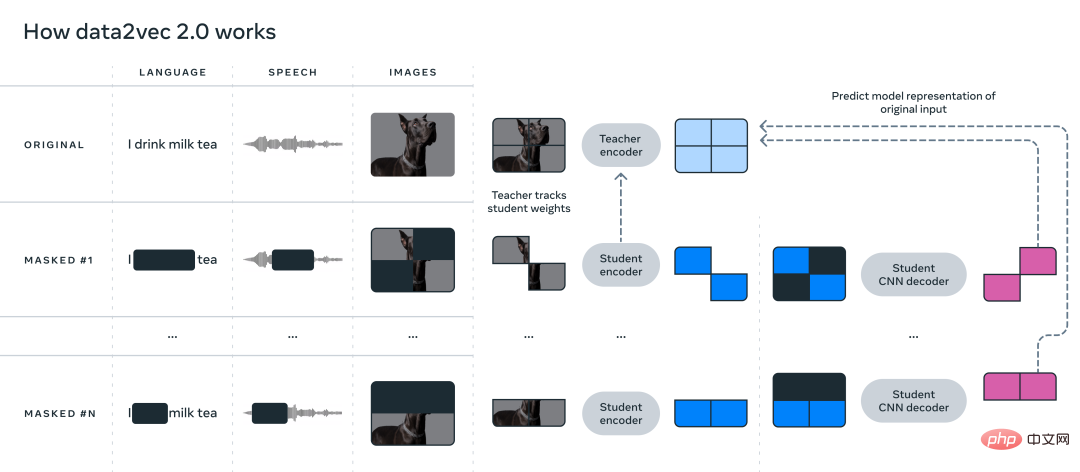

data2vec の主なアイデアは、まず教師ネットワークを構築し、最初に画像、テキスト、または音声からターゲット表現を計算することです。 。次に、データがマスクされて入力の一部がわかりにくくなり、このプロセスが生徒ネットワークで繰り返され、教師モデルによって取得された表現が予測されます。

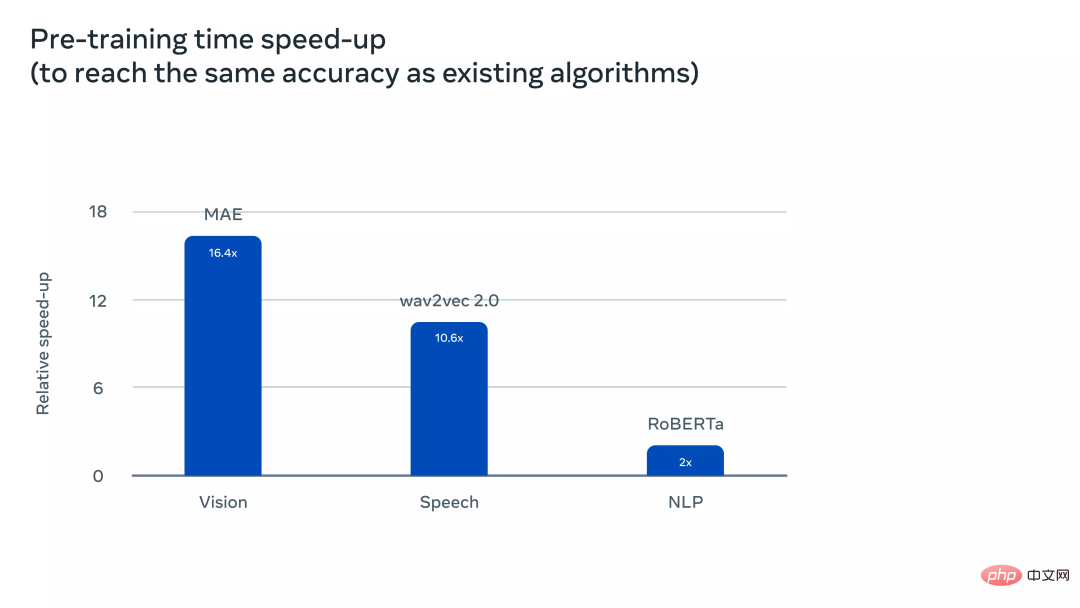

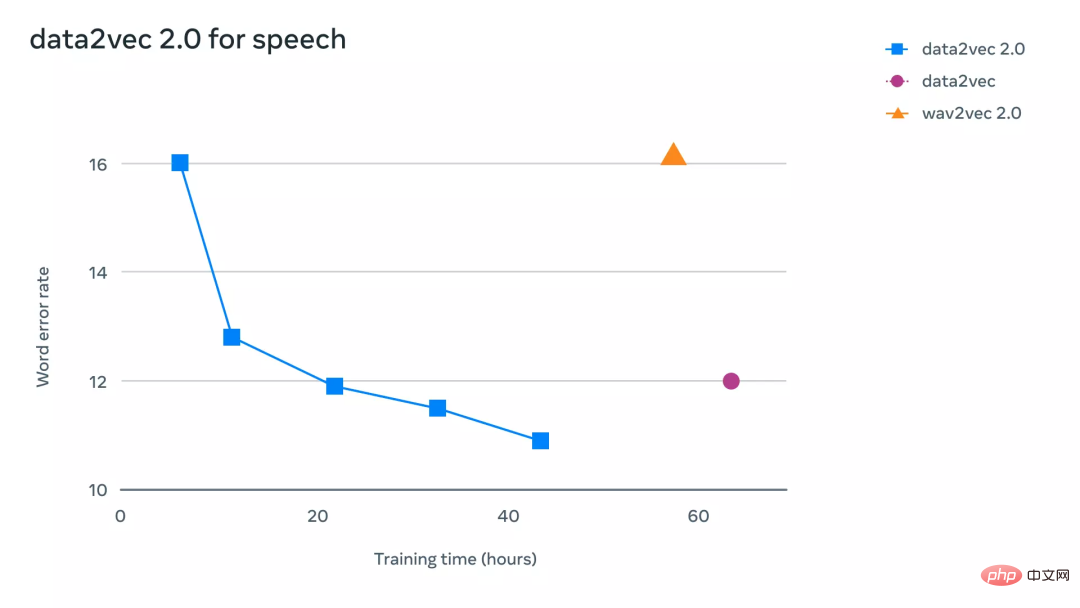

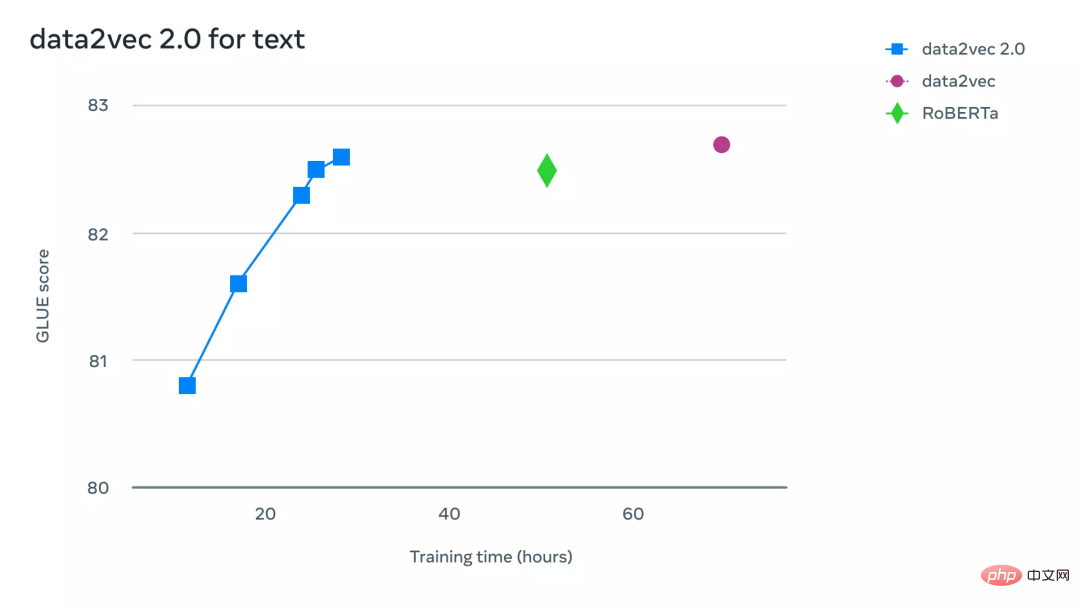

言い換えると、スチューデント モデルは、「不完全な入力情報」を受け入れながら、「完全な入力データ」の表現のみを予測できます。 2 つのモデルの一貫性を確保するために、2 つのモデルのパラメーターは共有されますが、教師モデルのパラメーターはトレーニングの初期段階でより速く更新されます。 実験結果に関しては、data2vec は音声、視覚、テキスト、その他のタスクにおいてベースライン モデルと比較してパフォーマンスが大幅に向上しました。 data2vec は、一般的な自己教師あり学習フレームワークは、音声、視覚、言語という 3 つのモーダル データの学習を統合します。data2vec2.0 によって解決される主な問題点は、自己教師ありモデルの構築にはトレーニングを完了するために大量の GPU コンピューティング パワーが必要であることです。元の data2vec アルゴリズムと同様に、data2vec 2.0 は、画像内のピクセル、テキスト セグメント内の単語、または音声を予測するのではなく、データのコンテキスト化された表現、またはニューラル ネットワークのレイヤーを予測します。 他の一般的なアルゴリズムとは異なり、これらのいわゆるターゲット表現はコンテキストに依存します。つまり、アルゴリズムは全体をトレーニング例が考慮されます。 たとえば、モデルは、bank を含む文全体に基づいて単語 Bank の表現を学習し、その推定を容易にします。言葉の正しい意味。具体的に「金融機関」を指すのか「川沿いの土地」を指すのかを区別するなど。研究者らは、コンテキスト化された目標により、より充実した学習タスクが促進され、data2vec 2.0 が他のアルゴリズムよりも速く学習できるようになると考えています。 data2vec 2.0 は、次の 3 つの方法で元の data2vec アルゴリズムの効率を向上させます。 #1. 特定のトレーニング例のターゲット表現を構築し、その表現をマスクされたバージョンで再利用します。マスクされたバージョンでは、トレーニング例のさまざまな部分がランダムに非表示になります。両方のバージョンで学習した表現はスチューデント モデルに入力され、異なるマスク バージョンに対して同じコンテキスト化されたターゲット表現を予測し、ターゲット表現の作成に必要な計算量を効果的に償却します。 2. マスクされたオートエンコーダー (MAE) と同様に、学生モデルのエンコーダー ネットワークは機能しません。トレーニングの例 (空白)。画像実験では、セクションの約 80% が空白であったため、計算サイクルが大幅に節約されました。 3. Transformer ネットワークに依存せず、多層畳み込みネットワークに依存する、より効果的なデコーダー モデルを使用します。 。 実験セクションdata2vec 2.0 が data2vec や他の同様のアルゴリズムに比べてどれほど効率的であるかをより直観的に理解するために、コンピューター ビジョンの研究者は、 、音声、テキストタスクに関連するベンチマークについて広範な実験が行われています。実験では、最終的な精度とモデルの事前トレーニングに必要な時間を主に考慮し、実験環境は同じハードウェア (GPU モデル、番号など) 上でアルゴリズムの実行速度を測定しました。 コンピュータ ビジョン タスクについて、研究者らは、モデルが画像を学習できるデータセットである標準 ImageNet-1K 画像分類ベンチマークで data2vec 2.0 を評価しました。表現。実験結果では、data2vec 2.0 はマスクされたオートエンコーダー (MAE) の精度と同等でありながら、16 倍高速であることが示されています。 data2vec 2.0 アルゴリズムの実行時間を長くし続けると、より高い精度を達成でき、それでも MAE よりも高速になります。 音声タスクに関して、研究者はLibriLanguage音声認識ベンチマークでテストしたところ、wave2vec 2.0よりも11倍以上正確でした。 自然言語処理タスクについて、研究者は一般言語理解評価 (GLUE) ベンチマークで data2vec 2.0 を評価し、トレーニング時間の半分しか必要としませんでした。 BERT を再実装した RoBERTa と同じ精度を達成できます。 data2vec 2.0

以上がマルチモダリティが再び統合されました! Meta が自己教師ありアルゴリズム data2vec 2.0 をリリース: トレーニング効率が最大 16 倍向上!の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

ブートストラップリストのサイズを変更する方法は?

Apr 07, 2025 am 10:45 AM

ブートストラップリストのサイズを変更する方法は?

Apr 07, 2025 am 10:45 AM

ブートストラップリストのサイズは、リスト自体ではなく、リストを含むコンテナのサイズに依存します。 BootstrapのグリッドシステムまたはFlexBoxを使用すると、コンテナのサイズを制御することで、リスト項目を間接的に変更します。

ブートストラップリストのネストを実装する方法は?

Apr 07, 2025 am 10:27 AM

ブートストラップリストのネストを実装する方法は?

Apr 07, 2025 am 10:27 AM

ブートストラップのネストされたリストでは、スタイルを制御するためにブートストラップのグリッドシステムを使用する必要があります。まず、外層< ul>を使用します。および< li>リストを作成するには、内側のレイヤーリストを< div class =" row>に巻き付けます。 and< div class =" col-md-6">内側のレイヤーリストに、内側の層リストが行の幅の半分を占めることを指定します。このように、内側のリストは正しいものを持つことができます

ブートストラップリストにアイコンを追加する方法は?

Apr 07, 2025 am 10:42 AM

ブートストラップリストにアイコンを追加する方法は?

Apr 07, 2025 am 10:42 AM

アイコンをブートストラップリストに追加する方法:アイコンライブラリ(Font Awesomeなど)が提供するクラス名を使用して、アイコンをリストアイテム< li>に直接詰めます。 Bootstrapクラスを使用して、アイコンとテキストを調整します(たとえば、d-flex、Justify-content-wether、align-Items-center)。ブートストラップタグコンポーネント(バッジ)を使用して、数字またはステータスを表示します。アイコンの位置(Flex-Direction:Row-Reverse;)を調整し、スタイル(CSSスタイル)を制御します。一般的なエラー:アイコンは表示されません(違います

vue.jsのストリングをオブジェクトに変換するためにどのような方法が使用されますか?

Apr 07, 2025 pm 09:39 PM

vue.jsのストリングをオブジェクトに変換するためにどのような方法が使用されますか?

Apr 07, 2025 pm 09:39 PM

vue.jsのオブジェクトに文字列を変換する場合、標準のjson文字列にはjson.parse()が推奨されます。非標準のJSON文字列の場合、文字列は正規表現を使用して処理し、フォーマットまたはデコードされたURLエンコードに従ってメソッドを削減できます。文字列形式に従って適切な方法を選択し、バグを避けるためにセキュリティとエンコードの問題に注意してください。

Bootstrapのグリッドシステムを表示する方法

Apr 07, 2025 am 09:48 AM

Bootstrapのグリッドシステムを表示する方法

Apr 07, 2025 am 09:48 AM

Bootstrapのメッシュシステムは、コンテナ(コンテナ)、行(行)、およびcol(列)の3つのメインクラスで構成されるレスポンシブレイアウトを迅速に構築するためのルールです。デフォルトでは、12列のグリッドが提供され、各列の幅はCol-MD-などの補助クラスを通じて調整でき、それにより、さまざまな画面サイズのレイアウト最適化を実現できます。オフセットクラスとネストされたメッシュを使用することにより、レイアウトの柔軟性を拡張できます。グリッドシステムを使用する場合は、各要素が正しいネスト構造を持っていることを確認し、パフォーマンスの最適化を検討してページの読み込み速度を改善します。詳細な理解と実践によってのみ、ブートストラップグリッドシステムを習熟させることができます。

ブートストラップ5のリストスタイルでどのような変更が加えられましたか?

Apr 07, 2025 am 11:09 AM

ブートストラップ5のリストスタイルでどのような変更が加えられましたか?

Apr 07, 2025 am 11:09 AM

Bootstrap 5リストスタイルの変更は、主に詳細の最適化とセマンティック改善が原因です。これには、以下を含みます。リストスタイルはセマンティクスを強調し、アクセシビリティと保守性を向上させます。

ブートストラップリストは垂直にどのように配置されますか?

Apr 07, 2025 am 11:21 AM

ブートストラップリストは垂直にどのように配置されますか?

Apr 07, 2025 am 11:21 AM

Bootstrap自体は、直接的な垂直リスト機能を提供せず、メカニズムを使用して巧妙に実装する必要があります。Flexbox:「D-Flex Flex-Column」クラスをリストの親コンテナに追加して、リストアイテムを垂直に配置します。ラスターシステムと組み合わせる:複雑なコンテンツを含むリストアイテムの列幅を設定し、レイアウトをより細かく制御します。ブートストラップのラスターコア「行」および「col」クラスを使用して、フローティングまたはポジショニング方法の使用を避けるように注意してください。

VUEでエクスポートデフォルトによってエクスポートされたコンポーネントを登録する方法

Apr 07, 2025 pm 06:24 PM

VUEでエクスポートデフォルトによってエクスポートされたコンポーネントを登録する方法

Apr 07, 2025 pm 06:24 PM

質問:エクスポートデフォルトを通じてエクスポートされるVUEコンポーネントを登録する方法は?回答:3つの登録方法があります。グローバル登録:vue.component()メソッドを使用して、グローバルコンポーネントとして登録します。ローカル登録:現在のコンポーネントとそのサブコンポーネントでのみ利用可能なコンポーネントオプションに登録します。動的登録:vue.component()メソッドを使用して、コンポーネントが読み込まれた後に登録します。