NLP の分野では、大規模言語モデル (LLM) がさまざまな自然言語タスクの共通インターフェイスとして機能してきました。入力と出力をテキストに変換できる限り、LLM ベースのインターフェイスをタスクに適応させることができます。たとえば、サマリー タスクはドキュメントを取り込み、サマリー情報を出力します。したがって、入力ドキュメントを要約言語モデルに入力し、要約を生成できます。

NLP タスクにおける LLM の適用は成功しているにもかかわらず、研究者は画像や音声などのマルチモーダル データに対して LLM をネイティブに使用することに依然として苦労しています。知能の基本的な構成要素として、マルチモーダルな知覚は、知識の獲得と現実世界への対処の両方において、一般的な人工知能を実現するために必要な条件です。さらに重要なことは、マルチモーダル入力のロックを解除することで、マルチモーダル ロボティクス、ドキュメント インテリジェンス、ロボット工学など、より価値の高い分野での言語モデルの適用を大幅に拡大できることです。

したがって、Microsoft チームは、論文「必要なのは言語だけではない: 認識と言語の調整」で マルチモーダル大規模言語を紹介しました。モデル」モデル (MLLM) - KOSMOS-1 は、一般的なモダリティを認識し、指示に従い (つまり、ゼロショット学習)、コンテキスト内で学習 (つまり、数ショット学習) することができます。研究の目標は、モデルが見て会話できるように、知覚を LLM と一致させることです。研究者らは、METALMの手法に従ってKOSMOS-1をゼロから訓練した(論文「言語モデルは汎用インターフェースである」を参照)。

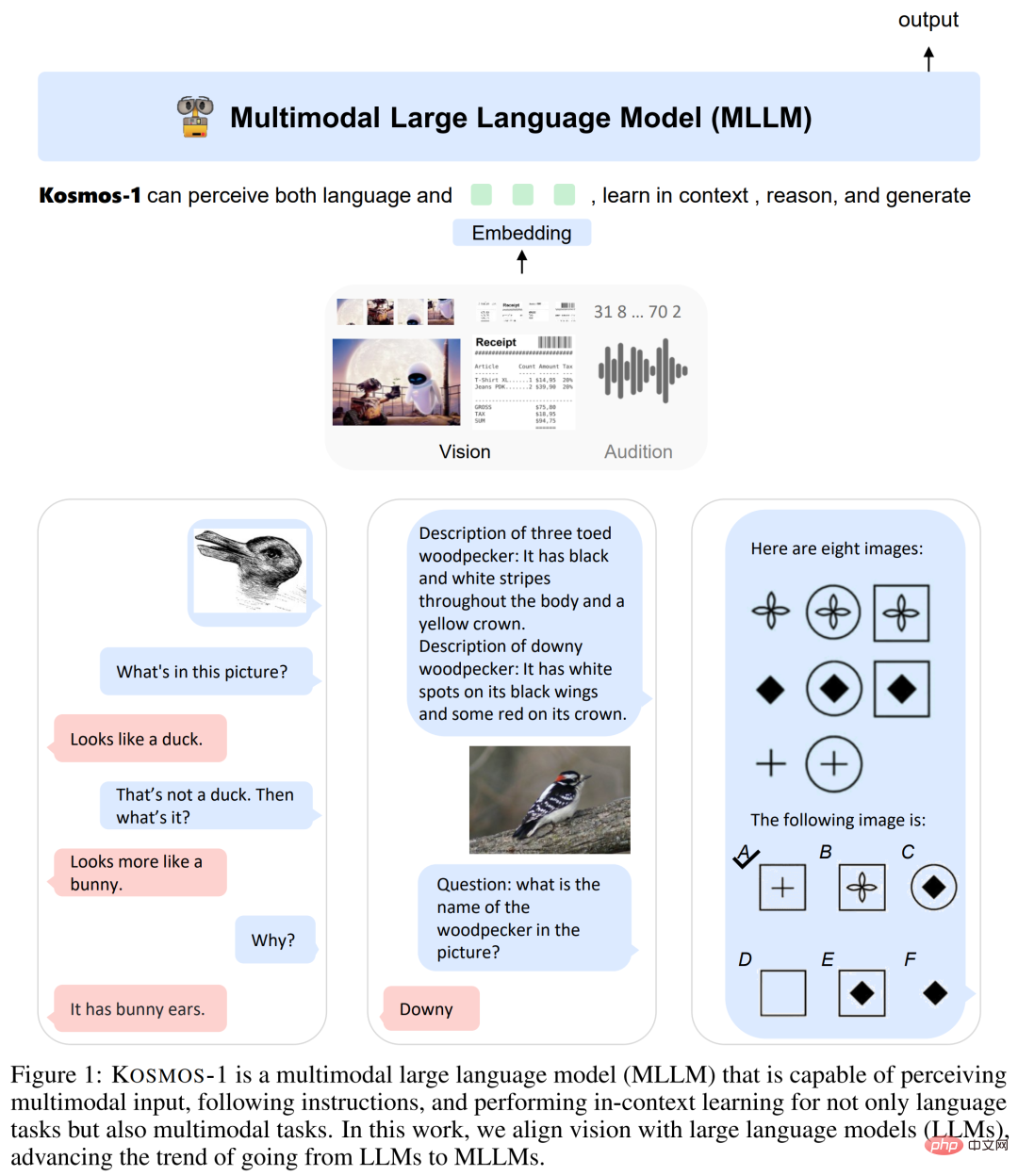

以下の図 1 に示すように、研究者は Transformer ベースの言語モデルを一般的なインターフェイスとして使用し、それを認識モジュールに接続します。彼らは、テキスト データ、任意にインターリーブされた画像とテキスト、画像とキャプションのペアを含む Web スケールのマルチモーダル コーパスでモデルをトレーニングしました。さらに、研究者らは純粋な言語データを送信することで、クロスモーダルな指示に従う能力を調整しました。

最後に、KOSMOS-1 モデルは、以下の表 1 に示すように、ゼロショット学習設定および少数ショット学習設定での言語、知覚言語、および視覚タスクをネイティブにサポートします。

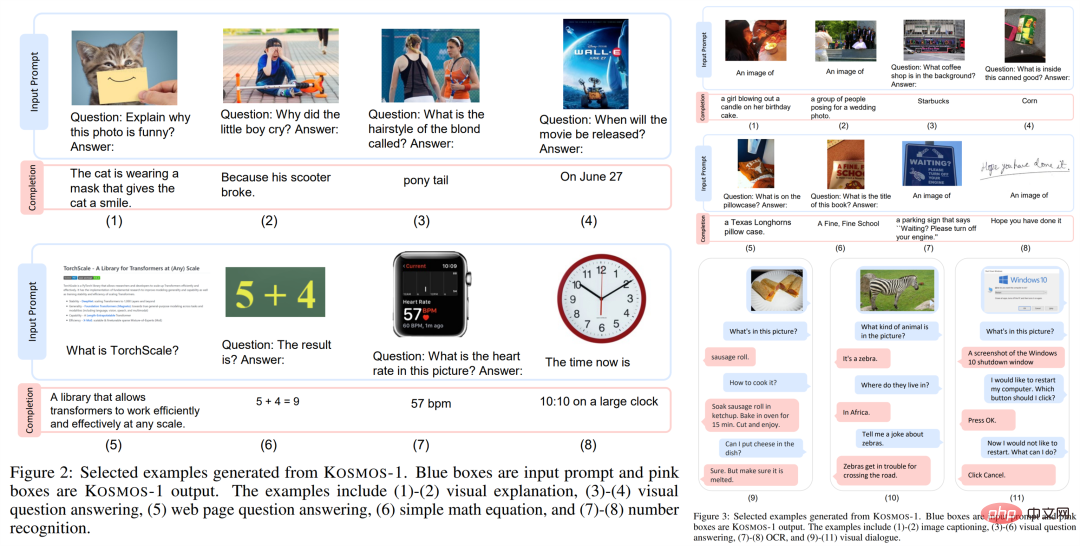

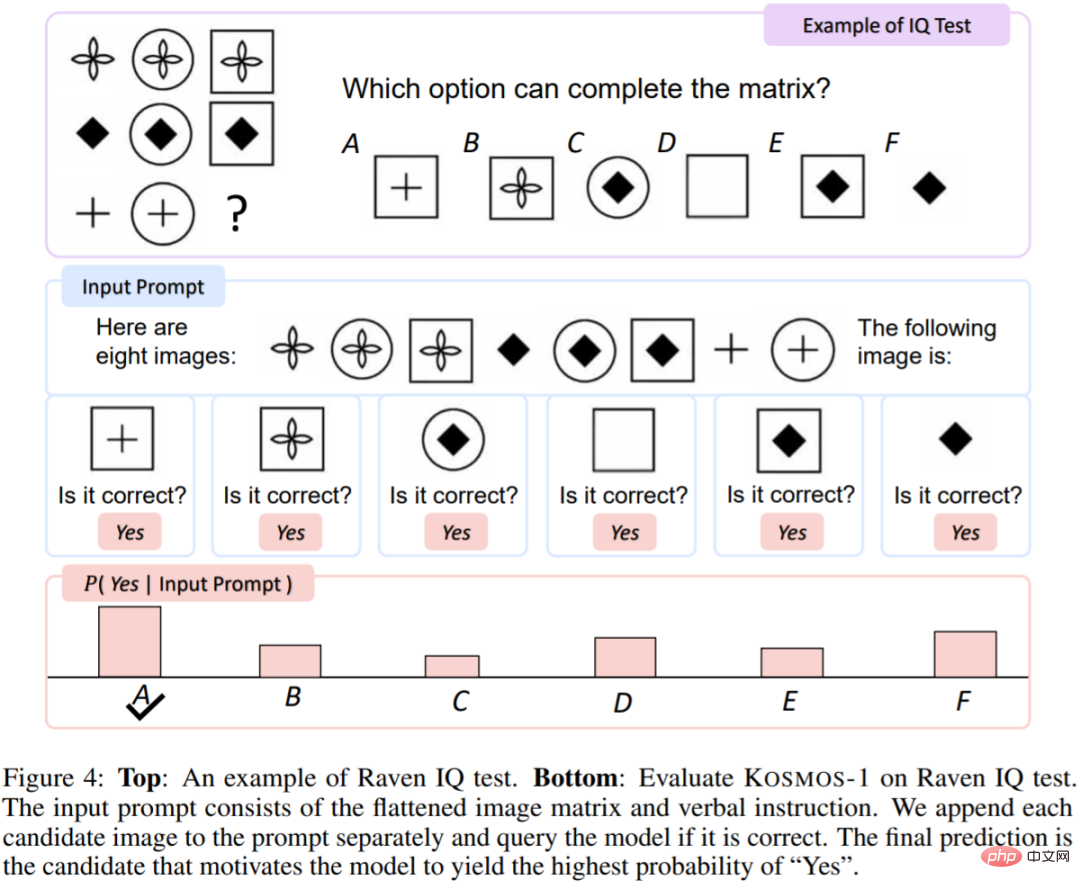

KOSMOS-1 モデルは、さまざまな自然言語タスクに加えて、視覚的な対話、視覚的な説明、視覚的な質問応答、画像の字幕、簡単な数式、OCR、ゼロショット画像分類と説明。 彼らはまた、MLLM の非言語的推論能力を評価するために、レイブンのプログレッシブ マトリックス (RPM) に基づいた IQ テスト ベンチマークを確立しました。

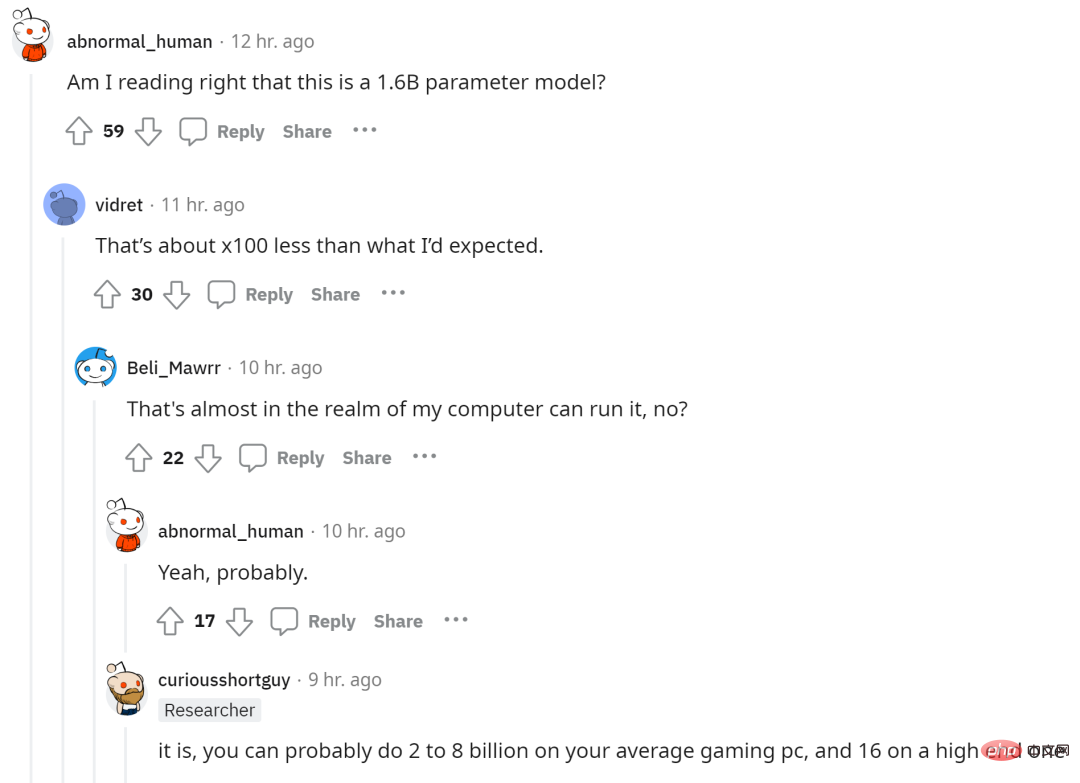

KOSMOS-1 モデルのパラメータ数は 16 億であるため、一部のネチズンは、この大規模なマルチモーダル モデルを自分のコンピュータで実行できるという希望を表明しました。

図 1 に示すように、KOSMOS-1 は、一般的なモダリティを認識し、命令に従うことができるマルチモーダルな言語モデルです。コンテキスト内で出力を生成します。具体的には、KOSMOS-1 のバックボーンは、Transformer に基づく因果言語モデルです。モデルにはテキスト以外にも他のモダリティを埋め込んで入力することができ、下図に示すように言語以外にも視覚や音声などの埋め込みも可能です。 Transformer デコーダは、マルチモーダル入力の一般的なインターフェイスとして機能します。モデルがトレーニングされると、KOSMOS-1 は、ゼロショットおよびフューショット設定での言語タスクおよびマルチモーダル タスクでも評価できます。

トランスフォーマー デコーダーは統一された方法でモダリティを認識し、入力情報は特別なトークンを含むシーケンスに平坦化されます。たとえば、 はシーケンスの始まりを示し、 はシーケンスの終わりを示します。特別なトークン

#埋め込みモジュールは、テキスト トークンおよびその他の入力モダリティをベクトル表現にエンコードします。 、この研究ではルックアップ テーブルを使用して埋め込みにマッピングします。連続信号モダリティ (画像や音声など) の場合、入力は離散コードとして表すこともできます。

その後、取得された入力シーケンスの埋め込みが Transformer ベースのデコーダーに供給されます。次に、因果モデルが自己回帰的にシーケンスを処理し、次のトークンが生成されます。要約すると、MLLM フレームワークは、入力がベクトルとして表現されている限り、さまざまなデータ型を柔軟に処理できます。

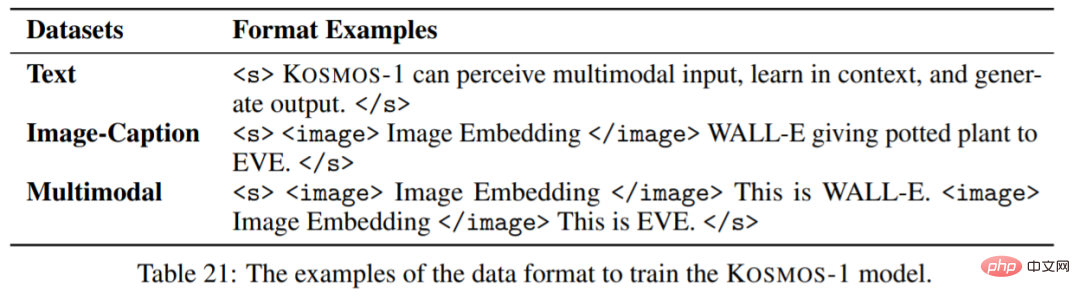

モデル トレーニング最初はトレーニング データ セットです。データセットには、テキスト コーパス、画像と字幕のペア、画像とテキストのクロス データセットが含まれます。具体的には、テキスト コーパスには The Pile と Common Crawl (CC) が含まれ、画像とキャプションのペアには英語の LAION-2B、LAION-400M、COYO-700M、および Conceptual Captions が含まれ、画像とテキストのクロスマルチモーダル データ セットは Common Crawl から取得されます。スナップショット。

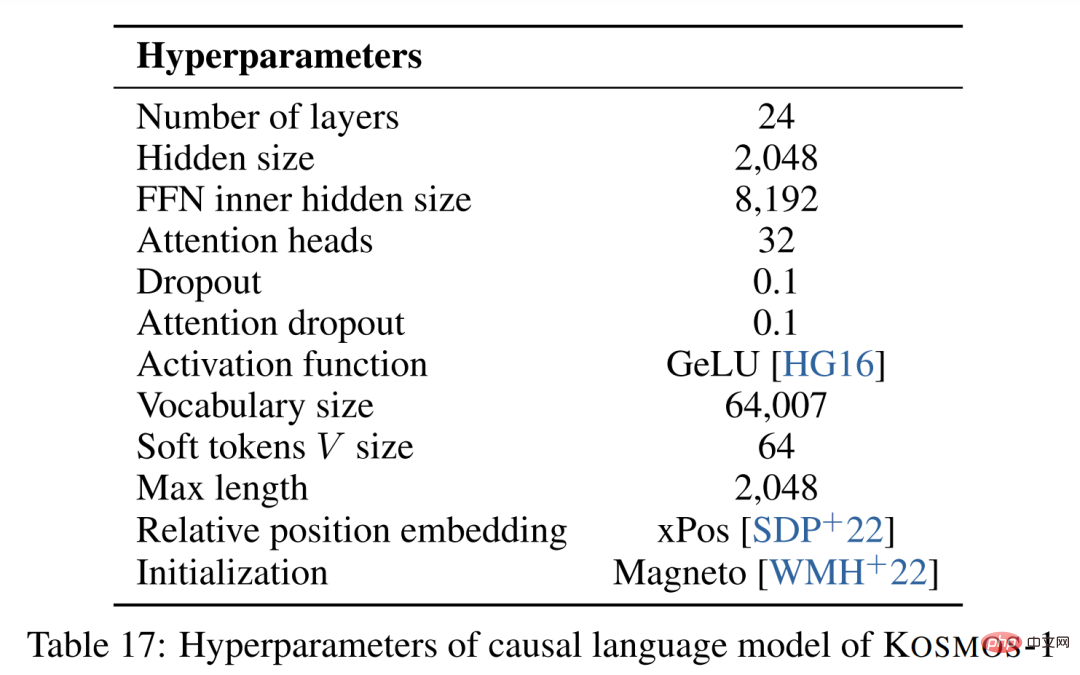

データセットがあり、次にトレーニング設定があります。 MLLM コンポーネントには、24 のレイヤー、2048 の隠れ次元、8192 の FFN、32 のアテンション ヘッド、および 1.3B のパラメーター サイズが含まれています。より良いモデルの収束を可能にするために、1024 の特徴次元を持つ事前トレーニングされた CLIP ViT-L/14 モデルから画像表現が取得されます。画像はトレーニング中に 224 × 224 の解像度に前処理され、さらに、最後のレイヤーを除くすべての CLIP モデル パラメーターはトレーニング中にフリーズされます。 KOSMOS-1 のパラメータの総数は約 1.6B です。

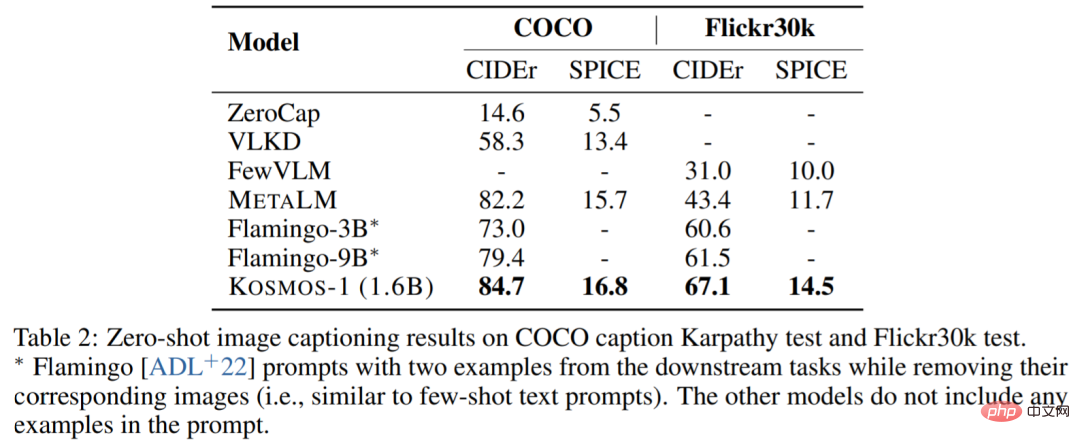

#画像の字幕。 次の表は、COCO および Flickr30k でのさまざまなモデルのゼロサンプルのパフォーマンスを示しています。 KOSMOS-1は他のモデルと比べて大きな成果を上げており、パラメータ数がFlamingoよりもはるかに少ないにもかかわらず性能も良好です。

次の表は、いくつかのサンプルのパフォーマンスの比較を示しています。

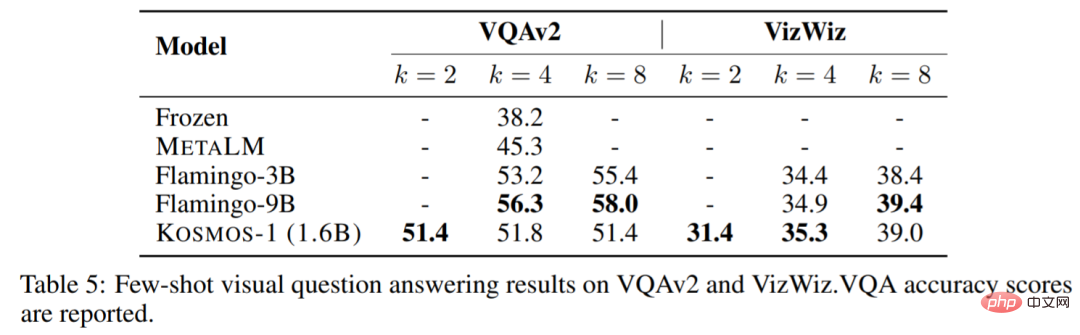

次の表は、いくつかのサンプルのパフォーマンスの比較を示しています。

##

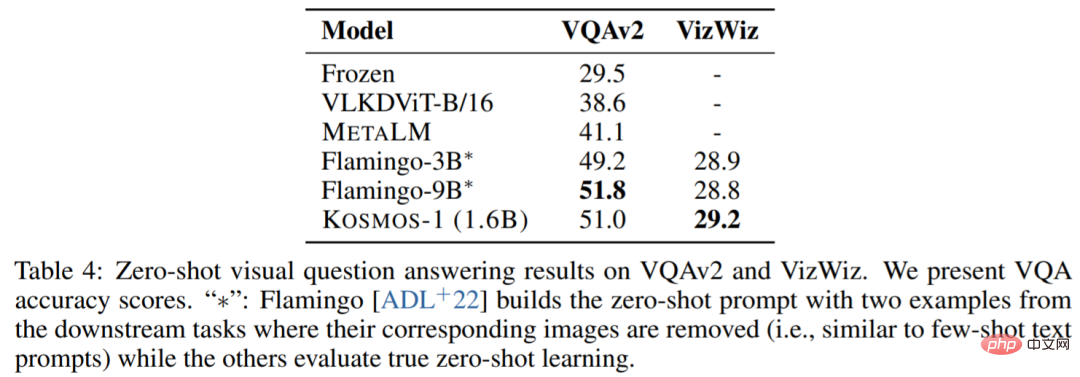

ビジュアル Q&A。 KOSMOS-1 は、Flamingo-3B および Flamingo-9B モデルよりも高い精度と堅牢性を備えています:

次の表は、いくつかのサンプルのパフォーマンスの比較を示しています:

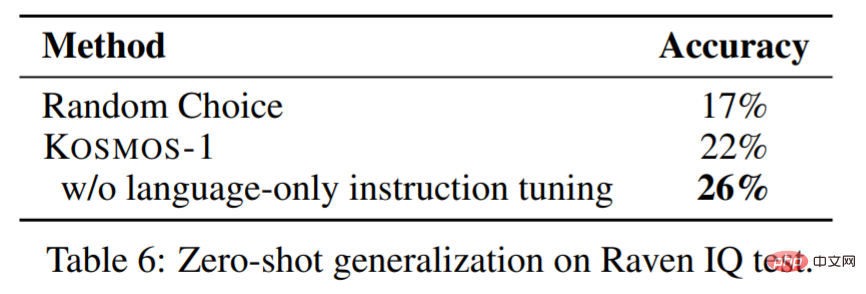

#表 6 は、IQ テスト データセットの評価結果を示しています。 KOSMOS-1は、非言語環境で抽象的な概念的パターンを認識し、複数の選択肢の中から後続の要素を推論することができます。私たちの知る限り、モデルがこのようなゼロサンプルの Raven IQ テストを実行できたのはこれが初めてです。

#表 6 は、IQ テスト データセットの評価結果を示しています。 KOSMOS-1は、非言語環境で抽象的な概念的パターンを認識し、複数の選択肢の中から後続の要素を推論することができます。私たちの知る限り、モデルがこのようなゼロサンプルの Raven IQ テストを実行できたのはこれが初めてです。

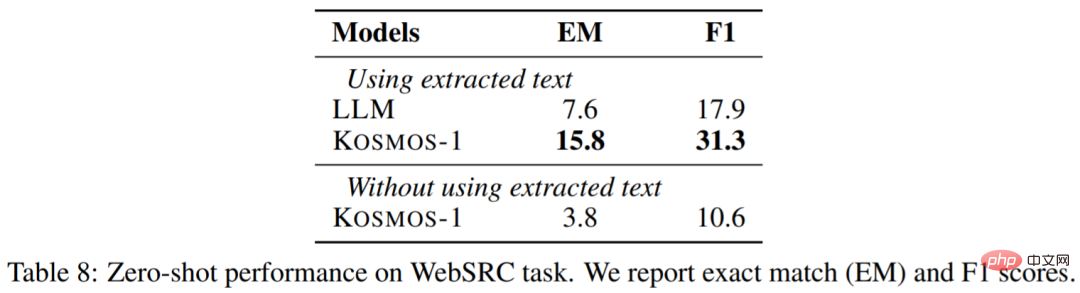

Web Q&A は、Web ページからの質問に対する回答を見つけることを目的としています。モデルがテキストの意味論と構造の両方を理解する必要があります。結果は次のとおりです。

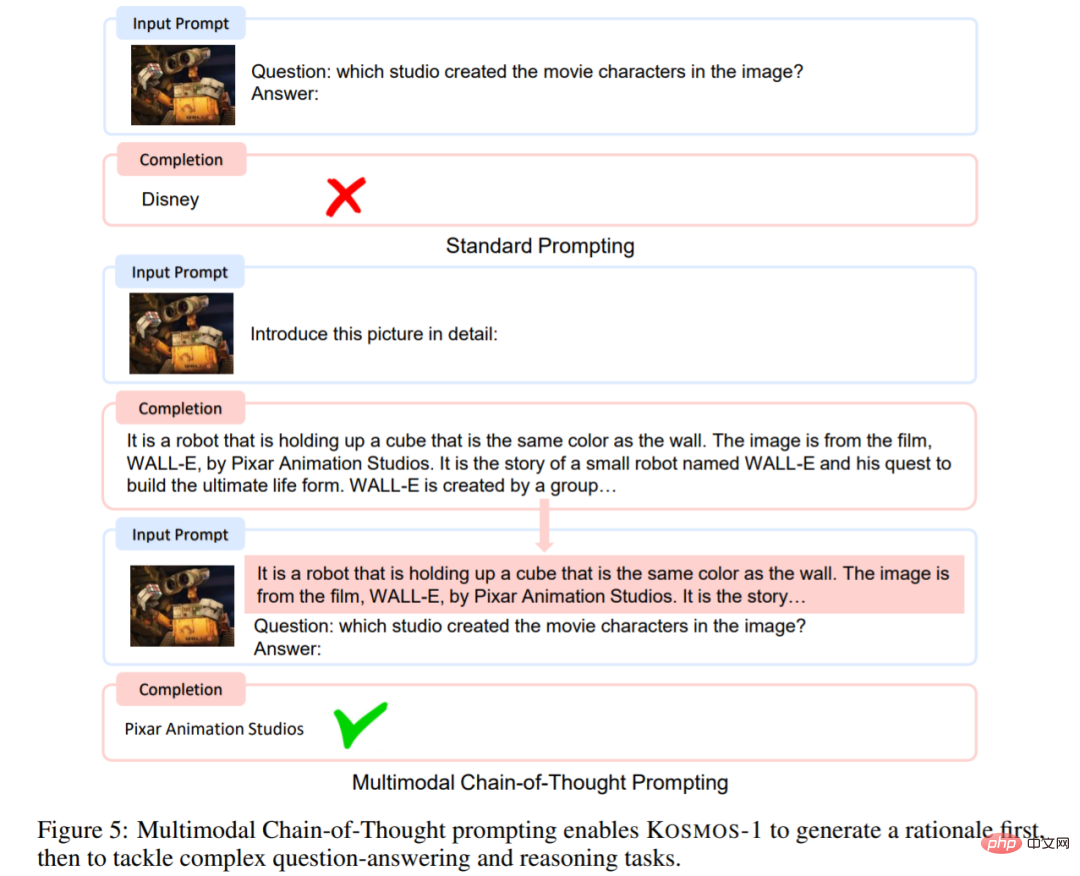

##マルチモーダルな思考チェーン プロンプト。

##マルチモーダルな思考チェーン プロンプト。

思考の連鎖のプロンプトに触発されて、この記事ではこの点に関する実験を実施しました。図 5 に示すように、この記事では言語認識タスクを 2 つのステップに分解します。最初の段階で画像が与えられると、最終結果を生成するための要件を満たす出力を生成するようにモデルをガイドするためにキューが使用されます。

表 9 からわかるように、マルチモーダル思考連鎖プロンプトのスコアは 72.9 ポイントです。標準プロンプトよりも高い スコア 5.8 ポイント:

さらに実験的な内容については、元の論文を参照してください。

以上がMicrosoft マルチモーダル ChatGPT が登場しますか?写真を見て質問に答える、IQ テストなどのタスクを処理するための 16 億のパラメータ。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。