「太極拳」に基づくテンセント広告モデルのトレーニングコスト最適化実践

#近年、ビッグデータ拡大モデルは、AI 分野におけるモデリングの標準パラダイムとなっています。広告シーンでは、大規模なモデルはより多くのモデルパラメータとより多くのトレーニングデータを使用し、モデルはより強力な記憶能力と一般化能力を備えているため、広告効果を向上させるための余地がさらに広がります。ただし、トレーニング プロセスで大規模なモデルに必要なリソースも急激に増加しており、ストレージとコンピューティングのプレッシャーが機械学習プラットフォームにとって大きな課題となっています。

Tencent Taiji Machine Learning Platform はコスト削減と効率向上のソリューションを模索し続けており、オフライン トレーニング シナリオの広告にハイブリッド展開リソースを使用してリソース コストを大幅に削減し、Tencent Advertising に 50 W コアを提供しますTencent Advertising のオフライン モデル トレーニング リソースのコストを 30% 削減すると同時に、一連の最適化手法により、コロケーション リソースの安定性は通常のリソースと同等になります。

1. はじめに

近年、NLP 分野におけるさまざまなビッグデータの注文を席巻する大規模モデルの大成功により、ビッグデータの拡大モデルが A AI ドメインにおけるモデリングの標準パラダイム。検索、広告、レコメンデーションのモデリングも例外ではありません。あらゆる場面で数千億のパラメータを使用する T サイズ モデルが、主要な予測シナリオの標準となっています。大規模なモデル機能は、主要テクノロジー間の軍拡競争の焦点にもなっています企業。

広告シーンでは、大規模なモデルはより多くのモデルパラメータを使用し、より多くのトレーニングデータを使用します。モデルはより強力な記憶能力と汎化能力を備えているため、広告効果が向上します。上向きに持ち上げると、より多くの可能性が広がります空間。ただし、トレーニング プロセスで大規模なモデルに必要なリソースも急激に増加しており、ストレージとコンピューティングのプレッシャーが機械学習プラットフォームにとって大きな課題となっています。同時に、プラットフォームがサポートできる実験の数はアルゴリズムの反復効率に直接影響を与えるため、より多くの実験リソースをより低コストで提供する方法がプラットフォームの取り組みの焦点です。

Tencent Taiji Machine Learning Platform はコスト削減と効率向上のソリューションを模索し続けており、オフライン トレーニング シナリオの広告にハイブリッド展開リソースを使用してリソース コストを大幅に削減し、Tencent Advertising に 50 W コアを提供しますTencent Advertising のオフライン モデル トレーニング リソースのコストを 30% 削減すると同時に、一連の最適化手法により、コロケーション リソースの安定性は通常のリソースと同等になります。

2, Taiji Machine Learning Platform の概要

Taiji Machine Learning Platform は、ユーザーが集中できるようにすることに尽力しています。ビジネス AI の問題解決とアプリケーションの詳細については、アルゴリズム エンジニアが AI アプリケーション プロセスにおける特徴処理、モデル トレーニング、モデル サービスなどのエンジニアリング問題を解決するためのワンストップ ソリューションをご覧ください。現在、企業内広告、検索、ゲーム、テンセントカンファレンス、テンセントクラウドなどの主要ビジネスをサポートしている。

Taiji Advertising Platform は、Taiji Advertising System によって設計された、モデルのトレーニングとオンライン推論を統合した高性能機械学習プラットフォームであり、数兆のパラメーター モデルのトレーニングと推論機能を備えています。現在、このプラットフォームはテンセントの広告リコール、ラフランキング、ファインランキング、数十のモデルトレーニングとオンライン推論をサポートしており、同時にTaijiプラットフォームはワンストップの特徴登録、サンプル補足記録、モデルトレーニング、モデル評価、オンラインを提供します。テスト機能が大幅に向上し、開発者の効率が向上します。

- トレーニング プラットフォーム: 現在、モデル トレーニングは CPU と GPU の 2 つのトレーニング モードをサポートしており、自社開発の効率的な演算子と混合精度を使用します。 3D 並列技術やその他のテクノロジーにより、業界のオープンソース システムと比較してトレーニング速度が 1 桁高速化されます。

- 推論フレームワーク: Taiji が独自に開発した HCF (Heterogeneous Computing Framework) ヘテロジニアス コンピューティング フレームワーク (ハードウェア層、コンパイル層、ソフトウェアを通じて)レイヤージョイントの最適化により、究極のパフォーマンスの最適化が実現します。

#3. コスト最適化の具体的な実施

(1) 全体計画の紹介

太極拳プラットフォームの継続的な開発に伴い、タスクの数と種類は日々増加しており、必要なリソースも増加しています。コストを削減し、効率を高めるために、太極拳プラットフォームは、一方ではプラットフォームのパフォーマンスを向上させ、トレーニング速度を向上させますが、他方では、増大するリソース需要を満たすために、より安価なリソースも探しています。

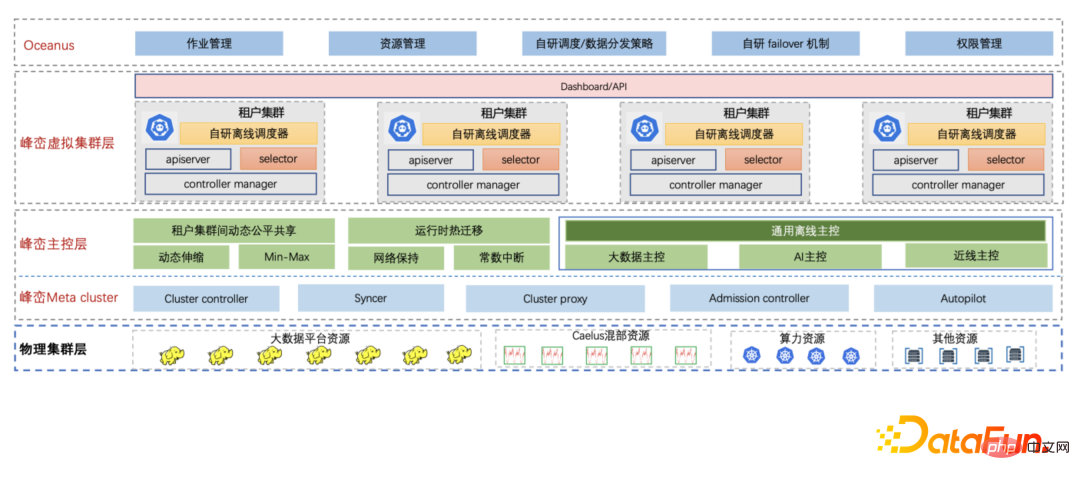

Fengluan - Tencent の社内クラウドネイティブ ビッグ データ プラットフォームは、クラウドネイティブ テクノロジを使用して会社のビッグデータ アーキテクチャ全体をアップグレードします。ビッグデータ ビジネスの継続的に増大するリソース需要に対応するために、Fengluan はコロケーション リソースを導入しました。これにより、リソース需要を満たすだけでなく、リソース コストも大幅に削減できます。 Fengluan は、さまざまなシナリオにおけるコロケーション リソース向けの一連のソリューションを提供し、不安定なコロケーション リソースをビジネスにとって透過的な安定したリソースに変えます。 Fengluan のコロケーション機能は、次の 3 種類のコロケーション リソースをサポートします。

- オンラインのアイドル リソースを再利用します。オンライン リソースの山と谷、リソース使用量の過大評価、およびクラスター リソースの断片化により、クラスター リソースの使用率は低く、アイドル状態のリソースが多数存在します。 Fengluan は、これらの一時的なアイドル リソースを利用してビッグ データ タスクを実行し、現在、オンライン広告、ストレージ、ソーシャル エンターテイメント、ゲームなどのシナリオにそれらを展開しています。

- #オフライン リソースの柔軟な貸し出し。ビッグデータプラットフォーム上の一部のタスクには潮汐現象があり、ビッグデータクラスターのリソース使用率が低い日中、Fengluanは一部のリソースの一時的な柔軟な貸し出しをサポートし、ピーク前にこれらのリソースを回収します。ビッグデータクラスターが到着します。このシナリオは、休日や大規模なプロモーション中に一時的に大量のリソースを必要とするオンライン タスクの問題を解決するのに非常に適しています。Fengluan は現在、春節や 618 などの主要な休日をサポートしています。

- #コンピューティング リソースを再利用します。コンピューティング リソースは、低品質 CVM の形式でマイカ マシンのアイドル リソースからマイニングされます。いわゆる低品質 CVM とは、マイカ マシン上でより低い CPU 優先順位で CVM 仮想マシンを起動することを指します。この仮想マシンは、他の仮想マシンによってリアルタイムでプリエンプトされる可能性があります。 Fengluan は、基盤となるコンピューティング能力によって提供されるリソース情報に基づいて、スケジューリング、過負荷保護、コンピューティング能力の移行などの面で多くの最適化を行っており、現在、数百万コアのビッグデータ タスクがコンピューティング能力リソース上で安定して実行されています。

同時に、Fengluan は、異なる都市や地域からの基盤となるコロケーション リソースによって引き起こされる分散特性を保護するために、クラウドネイティブの仮想クラスター テクノロジーを導入しました。 。 Taiji プラットフォームは、さまざまな基盤となるコロケーション リソースに対応する Fengluan テナント クラスターに直接接続されており、テナント クラスターは独立した完全なクラスターの観点を持ち、Taiji プラットフォームもシームレスに接続できます。

オンラインのアイドル リソース

Fengluan は、Caelus フルシナリオのオフライン コロケーション ソリューションを自社開発しました。オンライン操作とオフライン操作をコロケーションすることで、オンライン マシンのアイドル リソースを最大限に活用し、パフォーマンスを向上させます。オフライン操作のリソース コストを削減しながら、オンラインのマシン リソースを活用します。

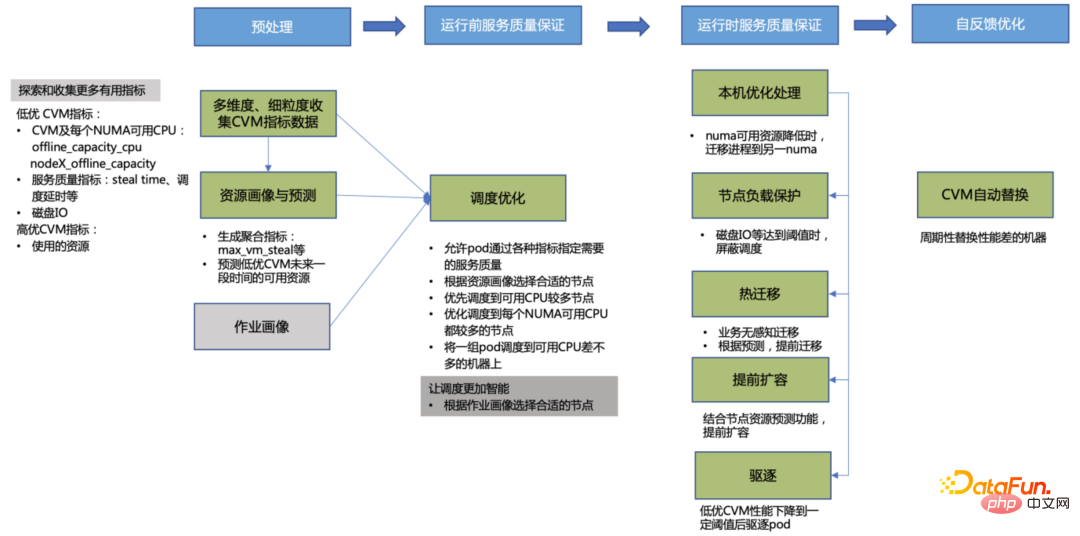

下図に示すように、Caelus の基本的なアーキテクチャであり、各コンポーネントとモジュールが相互に連携して、さまざまな面でコロケーションの品質を保証します。

まず第一に、Caelus はオンライン運用のサービス品質をあらゆる面で保証しますが、これはコロケーションの重要な前提条件の 1 つでもあります。たとえば、迅速な干渉検出と処理を通じてです。このメカニズムでは、オンライン サービスの品質、タイムリーな処理を積極的に感知し、ビジネスの特定の干渉検出要件をサポートするプラグイン拡張方法をサポートします。全次元のリソース分離、柔軟なリソース管理戦略などを通じて、オンライン サービスの優先度は高くなります。確保されています。

第二に、Caelus は、リソースの競合を避けるために、コロケーション リソースやオフライン ジョブ ポートレートを通じて適切なリソースをジョブにマッチングすること、オフライン ジョブのエビクション戦略の最適化とエビクションの優先順位付けなど、さまざまな側面でオフライン ジョブの SLO を保証します。正常な終了をサポートし、戦略は柔軟で制御可能です。ビッグデータのオフライン ジョブのほとんどは短時間 (数分、場合によっては数秒) ですが、ほとんどの太極拳ジョブは実行に時間がかかります (数時間、場合によっては数日)。長期的なリソース予測とジョブ ポートレートを通じて、実行時間やリソース要件が異なるジョブに適したリソースを見つけるためのスケジューリングをより適切にガイドできるようになり、数時間または数日間実行した後にジョブが削除されてジョブ ステータスが失われることを回避できます。資源と時間の無駄。オフライン ジョブを削除する必要がある場合、最初にランタイム ライブ マイグレーションを使用してジョブ インスタンスをあるマシンから別のマシンに移行しますが、メモリ ステータスと IP は変更されません。ジョブへの影響はほとんどなく、パフォーマンスが大幅に向上します。仕事の効率性、SLO。コロケーション リソースをより有効に活用するために、Caelus にはさらに多くの機能もあります。詳細については、Caelus のフルシナリオ オフライン コロケーション ソリューションを参照してください。( https://www.php.cn/link/caaeb10544b465034f389991efc90877 )。

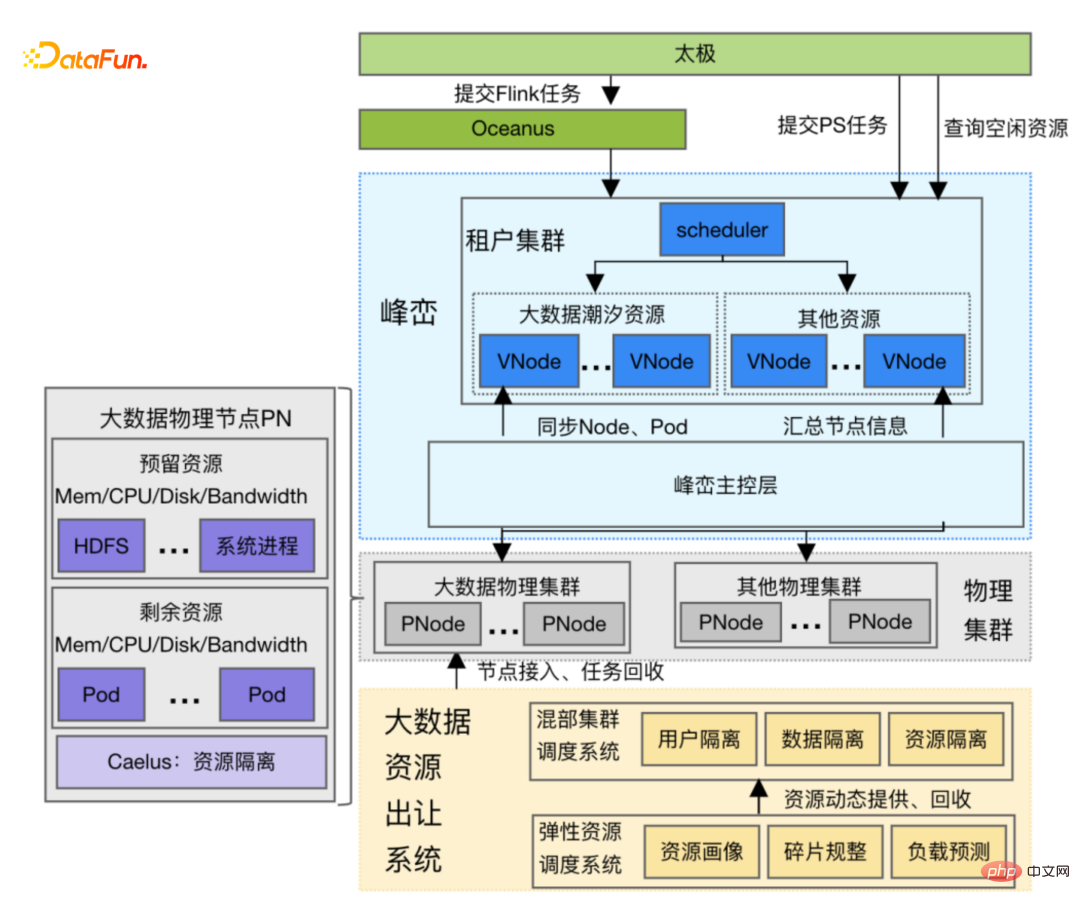

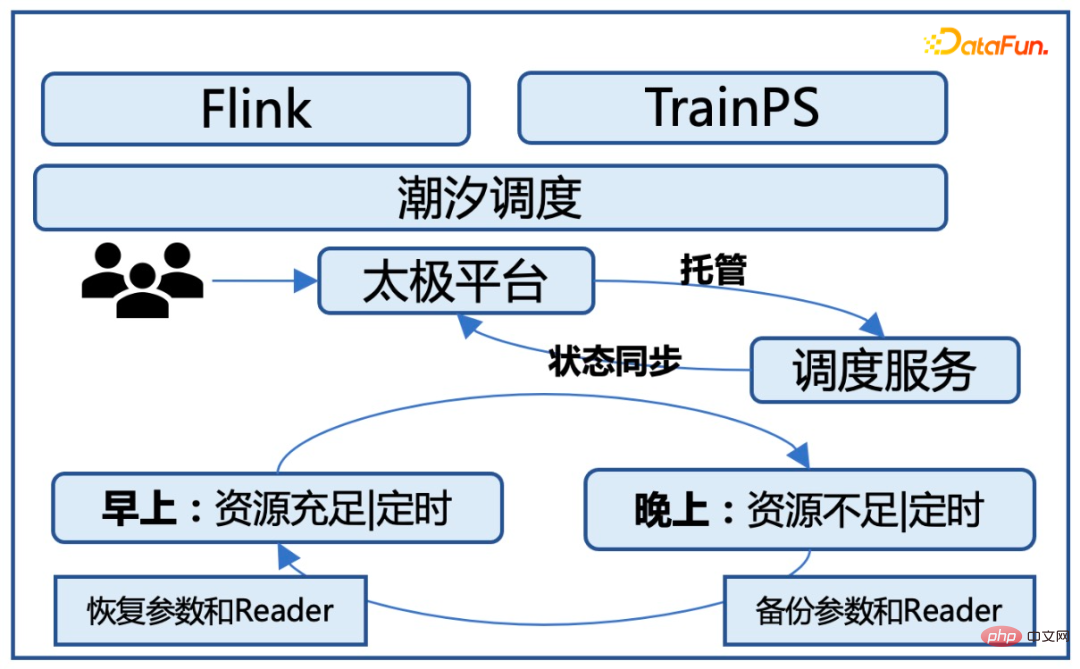

#潮汐資源

ビッグデータ タスクは一般に、潮汐期間中に比較的大規模になります。夜間はタスクが少ないため、Fengluan は日中に使用されていないビッグデータ リソースの一部を Taiji プラットフォームに転送し、夜間にこれらのリソースをリサイクルします。 Tidal リソースの特徴は、ノード上のビッグ データ タスクがほぼ完全に終了しているにもかかわらず、ビッグ データ ストレージ サービス HDFS がノード上に保持されており、太極拳ジョブの実行時に HDFS サービスが影響を受けることがないことです。 Taiji プラットフォームが潮汐資源を使用する場合、Fengluan プラットフォームとの合意に達する必要があります。Fengluan プラットフォームは、一定時点の履歴データに基づいてノードのバッチを事前にスクリーニングします。ビッグデータ タスクが正常に終了した後、新しいノードが参加したことを Taiji プラットフォームに通知すると、Taiji プラットフォームはテナント クラスターがさらにタスクを送信し始めます。借用時間が到来する前に、Fengluan は Taiji Platform に一部のノードをリサイクルする必要があることを通知し、Taiji Platform は順序立ててノードを返却します。

##下の図に示すように、潮汐資源の採掘、管理、利用には分業と複数のシステムの協力が必要です。

- ビッグデータ リソース転送システム: このシステムは、各マシンのさまざまなジョブ実行条件とクラスターの稼働データに基づいた機械学習アルゴリズムに基づいています。特定のリソース要件を満たし、実行中のジョブへの影響を最小限に抑えるためにオフラインにするのに最適なマシン ノードを見つけて、これらのノードへの新しいジョブのスケジュールを禁止し、ノード上で実行中のジョブの実行が終了するまで待機して、削減効果を最大限に高めます。ビッグデータ運用への影響。

- Caelus コロケーション システム: 転送システムによって空いたマシン リソースではビッグ データ ジョブは実行されなくなりましたが、 HDFS サービスは、データの読み取りおよび書き込みサービスも提供します。 HDFSサービスを保護するために、Caelusコロケーションシステムが導入されており、HDFSをオンラインサービスとして使用し、Caelusの一連のオンラインサービス保証方法(影響の有無の検出など)を通じてHDFSサービスの品質が影響を受けないことを保証します。 HDFS 主要指標を通じて)。

- 仮想クラスターを通じて Tide リソースを使用する: これらの転送されたマシン リソースは、Fengluan によって均一に管理およびスケジュールされ、仮想クラスターとして使用されます。このメソッドは Taiji プラットフォームに提供され、K8S ネイティブ インターフェイスを提供します。これにより、基礎となるリソースの違いが上位のプラットフォームから保護され、アプリケーションが同じ方法でリソースを使用できるようになります。

- アプリケーション層ブレークポイント再開トレーニングに接続しました: 潮汐資源はビッグデータ ジョブを実行するために夜間にリサイクルされます。リサイクルの影響を軽減するために、ピーク層とアプリケーション層のブレークポイント再開トレーニング機能が開放され、トレーニングを中断することなくリソースの切り替えが実現され、切り替え後のビジネスの継続運用には影響がありません。

コンピューティング リソース

コンピューティング リソースの特徴は、ビジネスに専用の CVM を提供することです。ビジネスユーザーにとっては比較的フレンドリーです。ただし、コンピューティング リソースを使用する際の課題は、マイカ マシン レベルの低品質 CVM の CPU リソースがいつでもオンライン CVM によって抑制されるため、コンピューティング リソースが非常に不安定になることです。

- コンピューティング能力 マシンの不安定性: 断片化したリソースの統合、コンピュータ ルームの電力不足などにより、コンピューティング マシンがオフラインになる可能性があります。

- コンピューティング リソースの優先度が低い: 通常の CVM マシンのサービス品質が影響を受けないようにするため、コンピューティング リソース上のジョブの優先度は最も低く、無条件でジョブに割り当てられます。高品質のリソースを使用すると、パフォーマンスが非常に不安定になります。

- 高いエビクション頻度: さまざまな理由 (不十分なコンピューティング リソースのパフォーマンス、不十分なディスク領域、ディスクのスタックなど) によってポッドのアクティブなエビクションがトリガーされ、ポッドが失敗する可能性が高くなります。

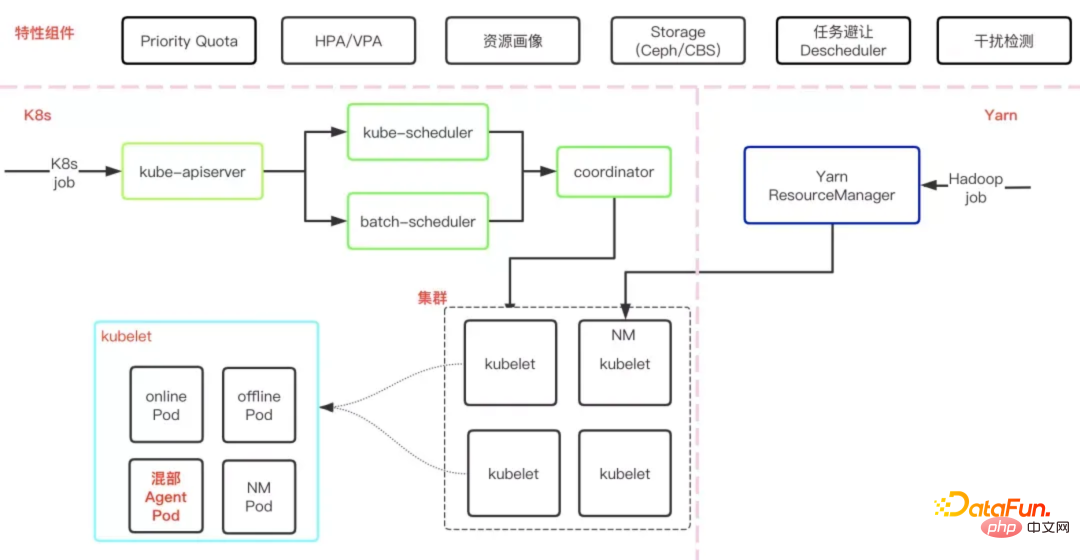

コンピューティングパワーリソースの不安定性の問題を解決するために、ピークアンドマウンテンメインコントロール層を通じてさまざまな機能が拡張され、コンピューティングパワーリソースが多面的に最適化されます。コンピューティング能力の安定性を向上させる :

##① リソースのポートレートと予測: 探索と収集さまざまなマシン パフォーマンス インジケーターと、将来の低品質 CVM の利用可能なリソースを予測する集約インジケーターを生成します。この情報は、スケジューラによってポッドをスケジュールするために使用され、エビクション コンポーネントはポッドのリソース要件を満たすためにポッドをエビクトするために使用されます。

② スケジュールの最適化: 太極拳運営のサービス品質を確保するために、運営のニーズに基づいてスケジュール戦略をさらに最適化します。リソースの特性を活かし、動作パフォーマンスが2倍以上向上しました。

###- 同じ都市のスケジューリング: PST ジョブとトレーニング ジョブを同じ都市の同じコンピューター ルームにスケジュールし、ジョブ インスタンス間のネットワーク遅延と、同じ都市のネットワーク帯域幅のコストを最小限に抑えます。も低くなり、コストダウンに貢献します。

- 単一マシンのスケジューリングの最適化: リソース予測の結果と CPU スティールタイムなどの指標を組み合わせて、コアをバインドするジョブのパフォーマンスがより高い CPU を選択します。仕事のパフォーマンスをより向上させるために。

- 階層スケジューリング: すべての管理リソースに自動的にラベルを付けて分類し、ジョブ マネージャーなどの災害復旧要件の高いジョブを比較的安定したリソースになるように自動的にスケジュールします。

- スケジューリング パラメーターの調整: リソースのポートレートと予測データに基づいて、スケジューラーはジョブのパフォーマンスと安定性が向上したノードに優先順位を付けます。さらに、一貫性のないステップによって引き起こされるエシュロンの有効期限の問題を解決するために、同じジョブのインスタンスが同様のパフォーマンスを持つマシンにスケジュールされます。

#③ランタイム サービスの品質保証

- アクティブ エビクション フェーズでは、リソースの不安定性やアプリケーションの障害に対処するために、ビジネスを基本的に認識できないようにするランタイム ホット マイグレーションが導入されます。ポッドのエビクションにより強制終了される問題を解決し、ランタイム ホット マイグレーションを実装し、さまざまなシナリオのニーズを満たすさまざまなホット マイグレーション戦略を提供します。現在のオンライン データによると、移行優先戦略を使用した場合、メモリが大きいコンテナの場合、ライブ マイグレーションの中断時間は 10 秒を超えています。また、メモリ サイズに関係なく一定の割り込み時間を実装しました (リカバリファースト戦略)。現在、毎日 20,000 を超えるポッドがアクティブに正常に移行されており、クラスター間のホット マイグレーションがサポートされているため、エビクションの影響が大幅に軽減されます。

- エビクション戦略を最適化してエビクションの影響を最小限に抑えます。各マシンがエビクションされるたびに、エビクション後に開始されたポッドが優先され、マシンへの影響を回避します。すでに開始されています 各タスクは、単一タスクの上流と下流のエビクションを回避するために、一度に 1 つのノードのみをエビクトし、タスク レベルの再起動が発生します。ポッドがエビクトされると、上位層の Flink フレームワークとリンクして、Flink に積極的に通知します。迅速なシングルポイントリカバリを実現します。

④ セルフフィードバックの最適化: リソース ポートレートを通じて、パフォーマンスの低いマシンを定期的に交換し、基盤となるプラットフォームに接続して、 CVM のスムーズな切り離しにより、Fengluan はビジネスに影響を与えることなくアプリケーション インスタンスを 1 つずつ移行できるようになり、インスタンスへの影響が軽減されます。

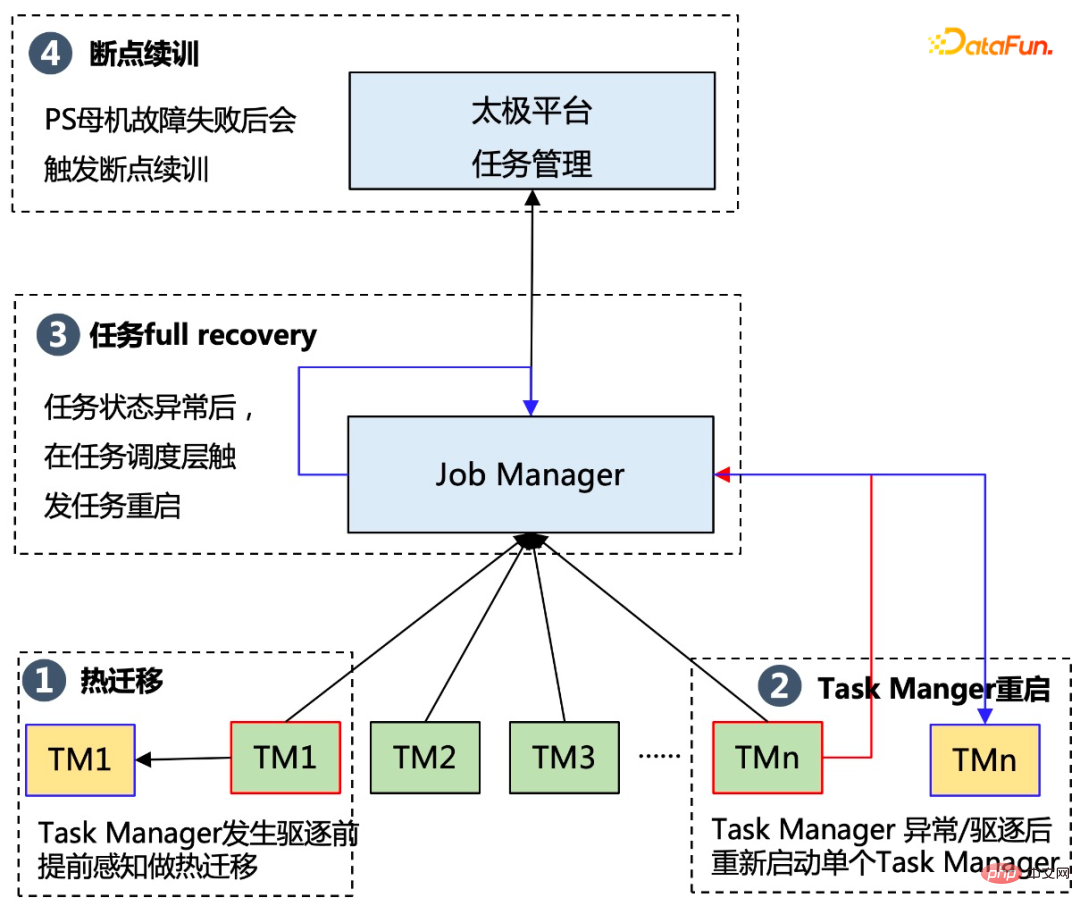

#⑤ Flink 層の災害復旧機能を改善し、シングルポイント再起動と階層的スケジューリングをサポートします

#TM (タスクManager) のシングルポイント再起動機能は、タスクの失敗によって DAG 全体が失敗することを防ぎ、コンピューティング能力のプリエンプティブ機能に適切に適応できます。階層スケジューリングにより、ギャング スケジューリングによって引き起こされる過度のジョブ待機が回避され、過剰なアプリケーションの無駄が回避されます。 TM ポッド。

(3) アプリケーション層最適化ソリューション

ビジネスフォールトトレランス

オフライントレーニングタスクでは、次のことを行う必要があります。安価なリソースの大前提は、リソース上の元のタスクの通常の動作に影響を与えられないことです。そのため、コロケーション リソースには次のような重要な課題があります。コロケーション リソースはほとんどが一時的なリソースです。頻繁にオフラインになります;

- コロケーション リソースは無条件に高品質のリソースに負け、その結果マシンのパフォーマンスが非常に不安定になります;

- コロケーション リソース 自動エビクション メカニズムにより、ノードとポッドの障害の可能性も大幅に増加します。

コロケーション リソース上でタスクを安定して実行できるようにするために、プラットフォームでは 3 つの-レベルのフォールト トレランス戦略。具体的には、解決策は次のとおりです:

- ホット マイグレーション テクノロジ: タスク マネージャーが削除されそうになる前に事前に感知し、対応するタスク マネージャーを別のポッドに移行します。同時に、メモリ圧縮、ストリーミング同時実行、クロスクラスターのホット マイグレーションなど。サーマル マイグレーションの成功率を継続的に最適化する機能。

- タスク マネージャーの再起動: タスク内のタスク マネージャーが例外またはエビクションにより失敗した場合、タスク全体は失敗せずに直接終了しますが、最初にタスク マネージャーのステータスが保存されます。 . を実行し、タスク マネージャーを再起動すると、タスク全体が失敗する可能性が低くなります。

- タスクの完全回復: Flink ステータスの異常によりタスクが回復不能な状態になった場合、ジョブ マネージャーの安定性を確保するためにジョブ マネージャーの再起動がトリガーされます。 、プラットフォームは安定性の高い独立したリソースにデプロイされ、通常のタスクのステータスを保証します。

- ブレークポイント継続トレーニング: 以前のフォールト トレランス戦略が失敗した場合、プラットフォームは履歴内の特定の ckpt に基づいてタスクを再開します。

ビジネス層の耐障害性により、コロケーション リソース上で実行されるタスクの安定性は、開始時の 90% 未満から終了時には 99.5% まで向上しました。 . 基本および通常の専用リソース 上記のタスクの安定性は変わりません。

タスク潮汐スケジュール

潮汐資源の要件を考慮すると、オフライン トレーニング タスクは日中にのみ使用でき、提供する必要があります。夜間のオンライン ビジネス用途のため、太極拳プラットフォームは、リソースの可用性に基づいて日中にトレーニング タスクを自動的に開始する必要があり、夜間にタスクのコールド バックアップを作成し、同時に対応するトレーニング タスクを停止する必要があります。同時に、各タスクのスケジュールの優先度はタスク管理キューによって管理され、夜間に開始された新しいタスクは自動的にキュー状態になり、翌朝の新しいタスクの開始を待ちます。

コアチャレンジ:

- 潮汐現象: 資源は次の期間に使用できます。当日はオフラインタスク用に提供され、夜間にリサイクルする必要があります。

- リソースの動的な変化: 日中もリソースは不安定であり、いつでも変化します。通常、午前中はリソースが少なく、その後はリソースが少なくなります。資源は徐々に増加し、夜には資源がピークに達します。

解決策:

- リソースを意識したスケジューリング戦略: 朝のリソースが徐々に増加する間、潮汐スケジューリングサービスは、リソースの変化を感知し、リソースのステータスを追跡して、トレーニングを継続するタスクを開始する必要があります。

- モデルの自動バックアップ機能: 夜間にリソースをリサイクルする前に、現在のプラットフォームで実行されているすべてのタスクを段階的にバックアップする必要があるため、システムに負担がかかります。プラットフォームのストレージと帯域幅。プラットフォーム上に数百のタスクがあり、各タスクのコールド バックアップのサイズは数百 G から数テラバイトの範囲であるため、非常に大きくなります。コールド バックアップが同時に実行される場合は、数百テラバイトのデータを短時間で送信および保存する必要があるため、ストレージとネットワークの両方が大きな課題となるため、合理的なスケジューリング戦略を立てて、モデルを段階的に保存する必要があります。

- インテリジェントなリソース スケジューリング機能: 従来のトレーニングと比較して、タイダル スケジューリングには、リソースが夜間にリサイクルされるときやタスクが毎日新しく開始されるときに、各タスクのモデルのバックアップが含まれます。朝のオーバーヘッドは追加のオーバーヘッドです。この追加のオーバーヘッドを削減するには、スケジュールを立てるときに、どのタスクが同じ日に完了できるか、どのタスクを複数日に渡って実行する必要があるかを評価する必要があります。同じ日にタスクが確実に完了するように、優先的により多くのリソースを割り当てます。

#これらの最適化により、タスクが潮汐資源上で安定して実行でき、基本的にビジネス層を認識しないことが保証されます。同時に、タスクの実行速度は大きな影響を受けず、タスクの開始および停止のスケジューリングによって生じる追加のオーバーヘッドは 10% 以内に制御されます。

4. オンライン効果と将来展望

Taiji のオフライン ハイブリッド配信最適化ソリューションは、Tencent の広告シナリオに実装されており、Tencent の広告オフライン モデルに全天候型の 30 W コアを提供します。毎日の調査とトレーニング 混合展開リソース、20W コア潮汐リソース、広告リコールのサポート、大まかなランキング、詳細なランキングのマルチシナリオ モデル トレーニング。リソース コストに関しては、同じ計算負荷のタスクの場合、ハイブリッド デプロイメントのリソース コストは通常のリソースの 70% になります。最適化後、システムの安定性と物理クラスター タスクの成功率は基本的に同じになります。

今後も、一方では、ハイブリッド コンピューティング リソース、特にハイブリッド コンピューティング リソースのアプリケーションの使用を増やし続ける一方で、当社のオンライン ビジネスも強化していきます。 GPU ベースになりつつあるため、混合リソース アプリケーションでは、従来の CPU リソースに加えて、オフライン トレーニング中にオンライン GPU リソースも使用されるようになります。

今日の共有はこれで終わりです。皆さんありがとうございました。

以上が「太極拳」に基づくテンセント広告モデルのトレーニングコスト最適化実践の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

1667

1667

14

14

1426

1426

52

52

1328

1328

25

25

1273

1273

29

29

1255

1255

24

24

PHPのビッグデータ構造処理スキル

May 08, 2024 am 10:24 AM

PHPのビッグデータ構造処理スキル

May 08, 2024 am 10:24 AM

ビッグ データ構造の処理スキル: チャンキング: データ セットを分割してチャンクに処理し、メモリ消費を削減します。ジェネレーター: データ セット全体をロードせずにデータ項目を 1 つずつ生成します。無制限のデータ セットに適しています。ストリーミング: ファイルやクエリ結果を 1 行ずつ読み取ります。大きなファイルやリモート データに適しています。外部ストレージ: 非常に大規模なデータ セットの場合は、データをデータベースまたは NoSQL に保存します。

2024 年の AEC/O 業界の 5 つの主要な開発トレンド

Apr 19, 2024 pm 02:50 PM

2024 年の AEC/O 業界の 5 つの主要な開発トレンド

Apr 19, 2024 pm 02:50 PM

AEC/O(Architecture, Engineering & Construction/Operation)とは、建設業界における建築設計、工学設計、建設、運営を提供する総合的なサービスを指します。 2024 年、AEC/O 業界は技術の進歩の中で変化する課題に直面しています。今年は先進技術の統合が見込まれ、設計、建設、運用におけるパラダイムシフトが到来すると予想されています。これらの変化に対応して、業界は急速に変化する世界のニーズに適応するために、作業プロセスを再定義し、優先順位を調整し、コラボレーションを強化しています。 AEC/O 業界の次の 5 つの主要なトレンドが 2024 年の主要テーマとなり、より統合され、応答性が高く、持続可能な未来に向けて進むことが推奨されます: 統合サプライ チェーン、スマート製造

C++開発経験の共有:C++ビッグデータプログラミングの実践経験

Nov 22, 2023 am 09:14 AM

C++開発経験の共有:C++ビッグデータプログラミングの実践経験

Nov 22, 2023 am 09:14 AM

インターネット時代においてビッグデータは新たなリソースとなり、ビッグデータ分析技術の継続的な向上に伴い、ビッグデータプログラミングの需要がますます高まっています。広く使用されているプログラミング言語として、ビッグ データ プログラミングにおける C++ の独自の利点がますます顕著になってきています。以下では、C++ ビッグ データ プログラミングにおける私の実践的な経験を共有します。 1. 適切なデータ構造の選択 適切なデータ構造を選択することは、効率的なビッグ データ プログラムを作成する上で重要です。 C++ には、配列、リンク リスト、ツリー、ハッシュ テーブルなど、使用できるさまざまなデータ構造があります。

58 ポートレート プラットフォームの構築におけるアルゴリズムの適用

May 09, 2024 am 09:01 AM

58 ポートレート プラットフォームの構築におけるアルゴリズムの適用

May 09, 2024 am 09:01 AM

1. 58 Portraits プラットフォーム構築の背景 まず、58 Portraits プラットフォーム構築の背景についてお話ししたいと思います。 1. 従来のプロファイリング プラットフォームの従来の考え方ではもはや十分ではありません。ユーザー プロファイリング プラットフォームを構築するには、複数のビジネス分野からのデータを統合して、ユーザーの行動や関心を理解するためのデータ マイニングも必要です。最後に、ユーザー プロファイル データを効率的に保存、クエリ、共有し、プロファイル サービスを提供するためのデータ プラットフォーム機能も必要です。自社構築のビジネス プロファイリング プラットフォームとミドルオフィス プロファイリング プラットフォームの主な違いは、自社構築のプロファイリング プラットフォームは単一のビジネス ラインにサービスを提供し、オンデマンドでカスタマイズできることです。ミッドオフィス プラットフォームは複数のビジネス ラインにサービスを提供し、複雑な機能を備えていることです。モデリングを提供し、より一般的な機能を提供します。 2.58 中間プラットフォームのポートレート構築の背景のユーザーのポートレート 58

Go言語にビッグデータフレームワークがない理由と解決策についてのディスカッション

Mar 29, 2024 pm 12:24 PM

Go言語にビッグデータフレームワークがない理由と解決策についてのディスカッション

Mar 29, 2024 pm 12:24 PM

今日のビッグデータ時代において、データの処理と分析はさまざまな産業の発展を支える重要な役割を果たしています。 Go言語は、開発効率が高くパフォーマンスに優れたプログラミング言語として、ビッグデータ分野で徐々に注目を集めています。しかし、Go 言語は Java や Python などの他の言語と比較してビッグ データ フレームワークのサポートが比較的不十分であり、一部の開発者に問題を引き起こしていました。この記事では、Go 言語にビッグ データ フレームワークが存在しない主な理由を調査し、対応する解決策を提案し、具体的なコード例で説明します。 1.Go言語

入門ガイド: Go 言語を使用したビッグデータの処理

Feb 25, 2024 pm 09:51 PM

入門ガイド: Go 言語を使用したビッグデータの処理

Feb 25, 2024 pm 09:51 PM

オープンソースのプログラミング言語として、Go 言語は近年徐々に注目を集め、使用されるようになりました。そのシンプルさ、効率性、強力な同時処理機能によりプログラマーに好まれています。ビッグ データ処理の分野でも、Go 言語は大きな可能性を秘めており、大量のデータを処理し、パフォーマンスを最適化し、さまざまなビッグ データ処理ツールやフレームワークとうまく統合できます。この記事では、Go 言語によるビッグデータ処理の基本的な概念とテクニックをいくつか紹介し、具体的なコード例を通して Go 言語の使用方法を示します。

AI、デジタルツイン、ビジュアライゼーション...2023 Yizhiwei 秋の製品発表会のハイライト!

Nov 14, 2023 pm 05:29 PM

AI、デジタルツイン、ビジュアライゼーション...2023 Yizhiwei 秋の製品発表会のハイライト!

Nov 14, 2023 pm 05:29 PM

Yizhiweiの2023年秋の新製品発表会は無事終了しました!カンファレンスのハイライトを一緒に振り返りましょう! 1. インテリジェントで包括的なオープン性がデジタルツインの生産性を高める Kangaroo Cloud の共同創設者で Yizhiwei の CEO である Ning Haiyuan 氏は開会の挨拶で次のように述べました: 「3 つのコア機能」「インテリジェントで包括的なオープン性」という 3 つのコアキーワードに焦点を当て、さらに「デジタルツインを生産力にする」という開発目標を提案しました。 2. EasyTwin: より使いやすい新しいデジタル ツイン エンジンを探索します。 1. 0.1 から 1.0 まで、デジタル ツイン フュージョン レンダリング エンジンを探索し続け、成熟した 3D 編集モード、便利なインタラクティブ ブループリント、大規模なモデル アセットを備えたより良いソリューションを実現します。

ビッグデータの分野での Java の応用を探る: Hadoop、Spark、Kafka、その他のテクノロジー スタックについて理解する

Dec 26, 2023 pm 02:57 PM

ビッグデータの分野での Java の応用を探る: Hadoop、Spark、Kafka、その他のテクノロジー スタックについて理解する

Dec 26, 2023 pm 02:57 PM

Java ビッグ データ テクノロジ スタック: Hadoop、Spark、Kafka などのビッグ データ分野における Java のアプリケーションを理解します。データ量が増加し続けるにつれて、今日のインターネット時代ではビッグ データ テクノロジが注目のトピックになっています。ビッグデータの分野では、Hadoop、Spark、Kafka などのテクノロジーの名前をよく耳にします。これらのテクノロジーは重要な役割を果たしており、広く使用されているプログラミング言語である Java もビッグデータの分野で大きな役割を果たしています。この記事では、Java のアプリケーション全般に焦点を当てます。