テクノロジー周辺機器

テクノロジー周辺機器

AI

AI

BERT から ChatGPT まで、北杭大学を含む 9 つのトップ研究機関の包括的なレビュー: 私たちが長年にわたって一緒に追求してきた「事前トレーニング基本モデル」

BERT から ChatGPT まで、北杭大学を含む 9 つのトップ研究機関の包括的なレビュー: 私たちが長年にわたって一緒に追求してきた「事前トレーニング基本モデル」

BERT から ChatGPT まで、北杭大学を含む 9 つのトップ研究機関の包括的なレビュー: 私たちが長年にわたって一緒に追求してきた「事前トレーニング基本モデル」

ChatGPT のショット数が少ないシナリオとショット数がゼロのシナリオにおける驚くべきパフォーマンスにより、研究者は「事前トレーニング」が正しい方法であるとの確信を深めました。

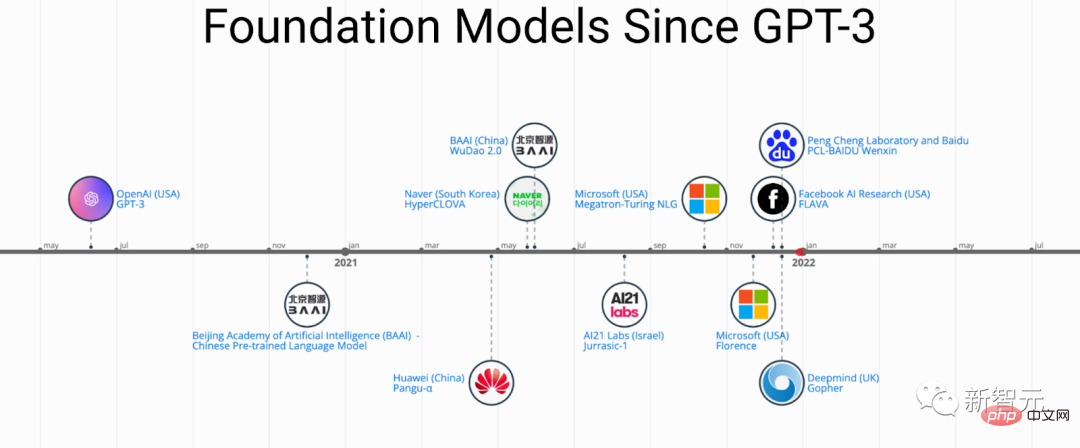

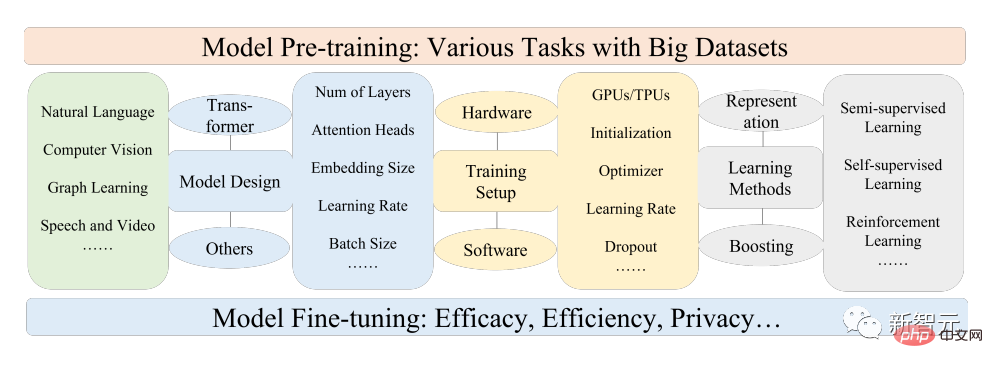

事前トレーニング済み基盤モデル (PFM) は、さまざまなデータ モード、つまり大規模データ、BERT、GPT-3、Pre に基づくさまざまなダウンストリーム タスクの基礎であると考えられています。 MAE、DALLE-E、ChatGPT などのトレーニング済みの基本モデルは、ダウンストリーム アプリケーションに適切なパラメーター初期化を提供するようにトレーニングされています。

PFM の背後にある事前トレーニングのアイデアは、大規模なモデルの適用において重要な役割を果たします。再帰的モジュールは特徴抽出にさまざまな方法を使用し、生成事前トレーニング (GPT) 方法では、Transformer を特徴抽出器として使用して、大規模なデータ セットに対して自己回帰トレーニングを実行します。

PFM はさまざまな分野で大きな成功を収めているため、近年発表された論文では多数の手法、データセット、評価指標が提案されています。 BERT: ChatGPT の開発プロセスを追跡する包括的なレビュー。

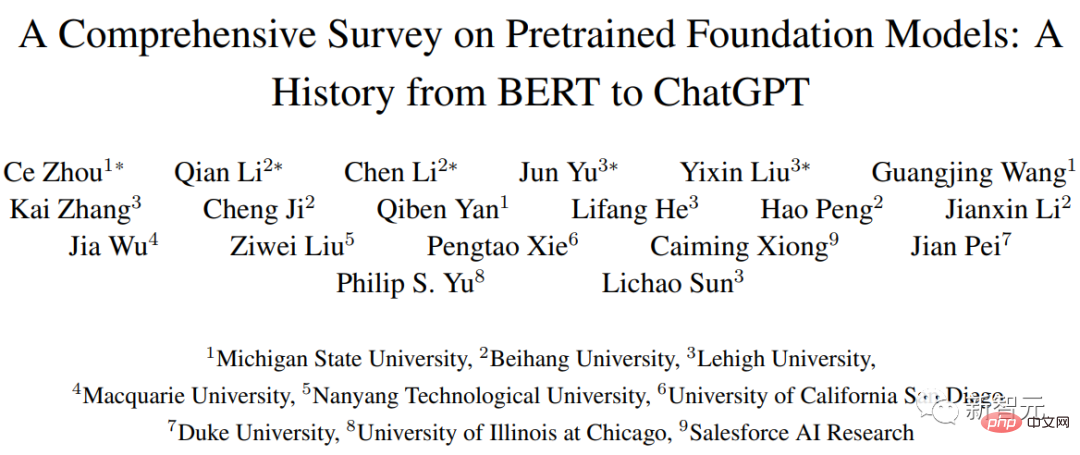

最近、北航大学、ミシガン州立大学、リーハイ大学、南洋工業大学、デューク大学、その他多くの国内外の有名な大学や企業の研究者が共同で、 -prediction 基本モデルのトレーニングに関するこのレビューでは、テキスト、画像、グラフの分野における最近の研究の進歩と、現在および将来の課題と機会を提供します。

論文リンク: https://arxiv.org/pdf/2302.09419.pdf

研究まず、自然言語処理、コンピューター ビジョン、グラフ学習の基本コンポーネントと既存の事前トレーニングを確認し、次に他のデータ モデル用の高度な PFM と、データの品質と量を考慮した統合 PFM について説明し、PFM の基本原理について説明します。 、モデルの効率と圧縮、セキュリティとプライバシーなど、この記事では最後に、将来の研究の方向性、課題、未解決の問題など、いくつかの重要な結論を列挙しています。

BERT から ChatGPT へ

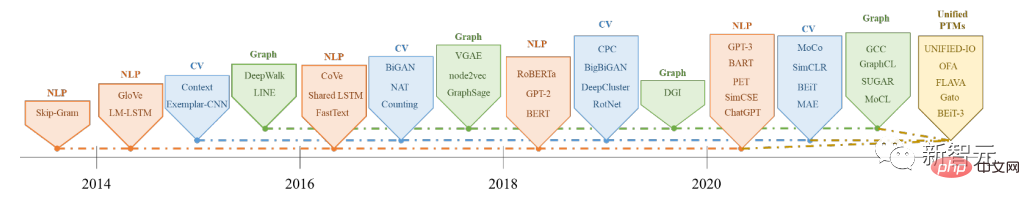

事前トレーニングされた基本モデル (PFM) は、ビッグデータ時代の人工知能システム構築の重要な部分です自然言語処理 (NLP)、コンピューター ビジョン (CV)、グラフ学習 (GL) の 3 つの主要な人工知能分野は、広く研究され、応用されています。

PFM は、さまざまな分野内またはクロスドメイン タスクで有効な一般的なモデルであり、テキスト分類、テキスト生成、画像などのさまざまな学習タスクにおける特徴表現の学習に大きな可能性を示します。分類、物体検出、グラフ分類など

PFM は、大規模なコーパスを使用して複数のタスクをトレーニングしたり、同様の小規模なタスクを微調整したりする際に優れたパフォーマンスを示し、迅速なデータ処理の開始を可能にします。

PFM と事前トレーニング

PFM は事前トレーニング テクノロジに基づいており、大量のデータとタスクを使用して、一般的なモデルをトレーニングします。これは、さまざまなダウンストリーム アプリケーションで簡単に微調整できます。

事前トレーニングのアイデアは、CV タスクにおける転移学習から生まれました。CV 分野での事前トレーニングの有効性を認識した後、人々は事前トレーニング テクニックを次の目的で使用し始めました。他のフィールドのモデルのパフォーマンスを向上させます。事前トレーニング手法を NLP 分野に適用すると、十分にトレーニングされた言語モデル (LM) によって、長期的な依存関係や階層関係など、下流のタスクに有益な豊富な知識を取得できます。

さらに、NLP の分野における事前トレーニングの大きな利点は、ラベルのないテキスト コーパスからトレーニング データを取得できること、つまり、データ量が無制限であることです。トレーニング前のプロセス データでのトレーニングの。

初期の事前トレーニングは、NNLM や Word2vec などの静的手法であり、異なるセマンティック環境に適応するのが困難でしたが、その後の研究者は、BERT や Word2vec などの動的な事前トレーニング テクノロジを提案しました。 XLネットは待ってください。

NLP、CV、GL の分野における PFM の歴史と進化

に基づく事前トレーニング テクノロジー PFM は大規模なコーパスを使用して一般的な意味表現を学習します。これらの先駆的な研究の導入により、さまざまな PFM が登場し、下流のタスクやアプリケーションに適用されています。

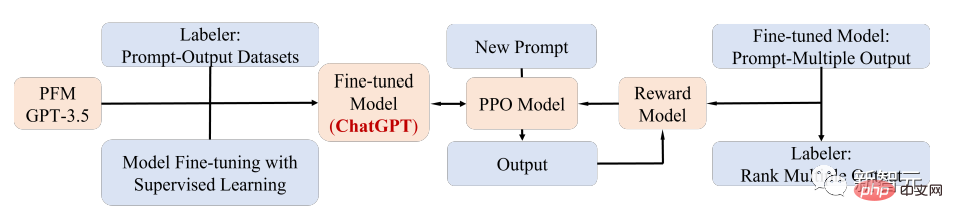

PFM アプリケーションのわかりやすい例は、最近人気のある ChatGPT です。

ChatGPT は、生成的な事前トレーニング済みの Transformer、つまり、テキストの混合コーパスでトレーニングした後の GPT-3.5 です。 ChatGPT は、大規模な LM と人間の意図を一致させるための現在最も有望な方法である、ヒューマン フィードバックによる強化学習 (RLHF) テクノロジーを使用します。

ChatGPT の優れたパフォーマンスは、各タイプの PFM のトレーニング パラダイムの変革、つまり、強化学習 ( RL)、迅速な調整と思考の連鎖、そして最終的には一般的な人工知能に向けて。

この記事では、研究者は主に、比較的成熟した研究分類方法でもあるテキスト、画像、グラフに関連する PFM をレビューします。

- 研究者は、NLP、CV、および GL の開発における PFM に関する最新の研究結果を追跡しました。これら 3 つの主要なアプリケーション領域における一般的な PFM 設計と事前トレーニング方法についてしっかりと要約、議論し、反映させています。

- 音声やビデオなどの他のマルチメディア分野における PFM の開発を要約し、統合 PFM、モデルの効率と圧縮など、PFM に関するより深いトピックについてさらに説明します。 、セキュリティとプライバシーも同様です。

- さまざまなモダリティにおけるさまざまなタスクに対する PFM のレビューを通じて、ビッグデータ時代の非常に大規模なモデルに関する将来の研究の主な課題と機会について説明します。 , PFM に基づいた新世代の協調的かつ対話型インテリジェンスの開発を導きます。

以上がBERT から ChatGPT まで、北杭大学を含む 9 つのトップ研究機関の包括的なレビュー: 私たちが長年にわたって一緒に追求してきた「事前トレーニング基本モデル」の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

1664

1664

14

14

1423

1423

52

52

1318

1318

25

25

1268

1268

29

29

1248

1248

24

24

ChatGPT では、無料ユーザーが 1 日あたりの制限付きで DALL-E 3 を使用して画像を生成できるようになりました

Aug 09, 2024 pm 09:37 PM

ChatGPT では、無料ユーザーが 1 日あたりの制限付きで DALL-E 3 を使用して画像を生成できるようになりました

Aug 09, 2024 pm 09:37 PM

DALL-E 3は、前モデルより大幅に改良されたモデルとして2023年9月に正式導入されました。これは、複雑な詳細を含む画像を作成できる、これまでで最高の AI 画像ジェネレーターの 1 つと考えられています。ただし、発売当初は対象外でした

携帯電話にchatgptをインストールする方法

Mar 05, 2024 pm 02:31 PM

携帯電話にchatgptをインストールする方法

Mar 05, 2024 pm 02:31 PM

インストール手順: 1. ChatGTP ソフトウェアを ChatGTP 公式 Web サイトまたはモバイル ストアからダウンロードします; 2. それを開いた後、設定インターフェイスで言語を中国語を選択します; 3. ゲーム インターフェイスでヒューマン マシン ゲームを選択し、中国スペクトル; 4 . 起動後、チャット ウィンドウにコマンドを入力してソフトウェアを操作します。

ChatGPT と Python の完璧な組み合わせ: インテリジェントな顧客サービス チャットボットの作成

Oct 27, 2023 pm 06:00 PM

ChatGPT と Python の完璧な組み合わせ: インテリジェントな顧客サービス チャットボットの作成

Oct 27, 2023 pm 06:00 PM

ChatGPT と Python の完璧な組み合わせ: インテリジェント カスタマー サービス チャットボットの作成 はじめに: 今日の情報化時代において、インテリジェント カスタマー サービス システムは企業と顧客の間の重要なコミュニケーション ツールとなっています。より良い顧客サービス体験を提供するために、多くの企業が顧客相談や質問応答などのタスクを完了するためにチャットボットに注目し始めています。この記事では、OpenAI の強力なモデル ChatGPT と Python 言語を使用して、インテリジェントな顧客サービス チャットボットを作成し、顧客サービスを向上させる方法を紹介します。

ChatGPT と Java を使用してインテリジェントなチャットボットを開発する方法

Oct 28, 2023 am 08:54 AM

ChatGPT と Java を使用してインテリジェントなチャットボットを開発する方法

Oct 28, 2023 am 08:54 AM

この記事では、ChatGPT と Java を使用してインテリジェントなチャットボットを開発する方法を紹介し、いくつかの具体的なコード例を示します。 ChatGPT は、OpenAI によって開発された生成事前トレーニング トランスフォーマーの最新バージョンです。これは、自然言語を理解し、人間のようなテキストを生成できるニューラル ネットワーク ベースの人工知能テクノロジーです。 ChatGPT を使用すると、適応型チャットを簡単に作成できます

ChatGPT PHP を使用してインテリジェントな顧客サービス ロボットを構築する方法

Oct 28, 2023 am 09:34 AM

ChatGPT PHP を使用してインテリジェントな顧客サービス ロボットを構築する方法

Oct 28, 2023 am 09:34 AM

ChatGPTPHP を使用してインテリジェントな顧客サービス ロボットを構築する方法 はじめに: 人工知能技術の発展に伴い、顧客サービスの分野でロボットの使用が増えています。 ChatGPTPHP を使用してインテリジェントな顧客サービス ロボットを構築すると、企業はより効率的でパーソナライズされた顧客サービスを提供できるようになります。この記事では、ChatGPTPHP を使用してインテリジェントな顧客サービス ロボットを構築する方法を紹介し、具体的なコード例を示します。 1. ChatGPTPHP をインストールし、ChatGPTPHP を使用してインテリジェントな顧客サービス ロボットを構築します。

ChatGPT と Python の完璧な組み合わせ: リアルタイム チャットボットの構築

Oct 28, 2023 am 08:37 AM

ChatGPT と Python の完璧な組み合わせ: リアルタイム チャットボットの構築

Oct 28, 2023 am 08:37 AM

ChatGPT と Python の完璧な組み合わせ: リアルタイム チャットボットの構築 はじめに: 人工知能技術の急速な発展に伴い、チャットボットはさまざまな分野でますます重要な役割を果たしています。チャットボットは、ユーザーが即時にパーソナライズされた支援を提供できると同時に、企業に効率的な顧客サービスを提供するのに役立ちます。この記事では、OpenAI の ChatGPT モデルと Python 言語を使用してリアルタイム チャット ロボットを作成する方法と、具体的なコード例を紹介します。 1.チャットGPT

中国でもchatgptは使えますか?

Mar 05, 2024 pm 03:05 PM

中国でもchatgptは使えますか?

Mar 05, 2024 pm 03:05 PM

chatgpt は中国でも使用できますが、香港やマカオでも登録できません。ユーザーが登録したい場合は、外国の携帯電話番号を使用して登録できます。登録プロセス中にネットワーク環境を切り替える必要があることに注意してください。外国のIP。

ChatGPT Python API 使用ガイド: 音声チャットボットの実装

Oct 28, 2023 am 08:16 AM

ChatGPT Python API 使用ガイド: 音声チャットボットの実装

Oct 28, 2023 am 08:16 AM

ChatGPTPython API 使用ガイド: ボイス チャット ロボットの実装 はじめに: 人工知能テクノロジーの継続的な開発と普及に伴い、さまざまなアプリケーション シナリオでボイス チャット ロボットの需要が増加しています。 OpenAI のオープン ソース ChatGPT は強力な自然言語処理モデルを提供しており、ChatGPTPython API を使用することで、音声対話機能を備えたチャットボットを簡単に実装できます。この記事ではChatGPTの特徴と使い方を3回に分けて紹介します。