AI が「Minecraft」のプレイをゼロから学習、DeepMind AI の一般化が画期的な進歩をもたらす

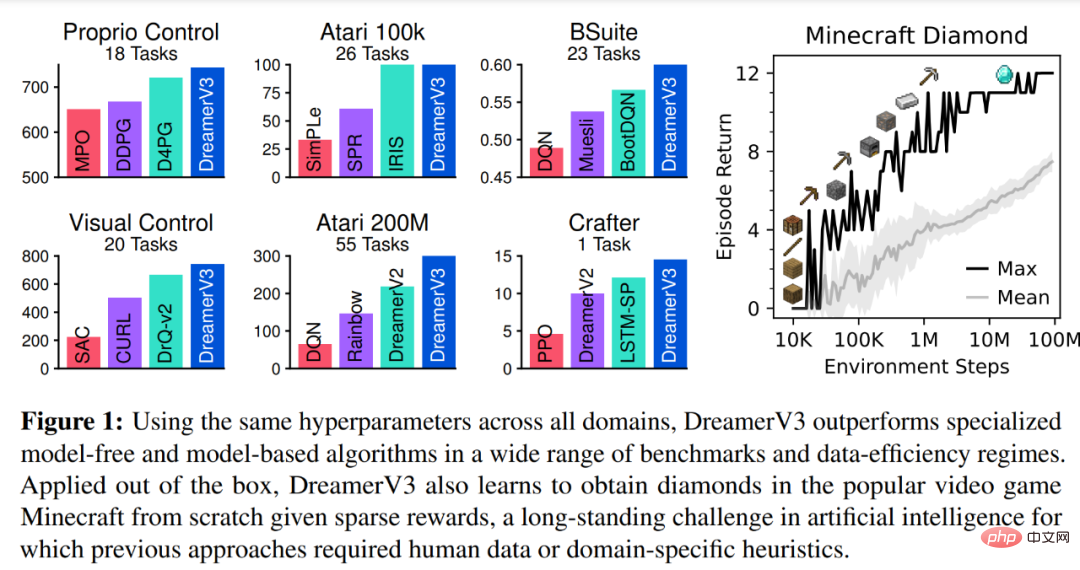

一般知能は複数の分野の課題を解決する必要があります。強化学習アルゴリズムにはこの可能性があると考えられていますが、新しいタスクに適応させるために必要なリソースと知識によって妨げられてきました。 DeepMind の新しい研究では、研究者らは、固定ハイパーパラメータを使用した幅広い領域で以前の手法を上回る、一般的でスケーラブルなワールド モデル ベースのアルゴリズムである DreamerV3 を実証しています。

DreamerV3 は、連続アクションと離散アクション、視覚的入力と低次元入力、2D と 3D の世界、さまざまなデータ量、報酬頻度、報酬レベルなどのドメインに準拠しています。 DreamerV3 は、人間のデータや積極的な教育を必要とせずに、Minecraft でダイヤモンドをゼロから収集する最初のアルゴリズムであることは言及する価値があります。 。研究者らは、このような一般的なアルゴリズムは強化学習の広範な応用を可能にし、難しい意思決定の問題にも拡張できる可能性があると述べている。

ダイヤモンドは、ゲーム「Minecraft」で最も人気のあるアイテムの 1 つです。ゲーム内で最も希少なアイテムの 1 つであり、ゲーム内のほとんどのアイテムの作成に使用できます。 . 最も強力な道具、武器、防具。ダイヤモンドは岩石の最も深い層でのみ発見されるため、産出量は少ないです。

DreamerV3 は、人によるデモやクラスの手動作成を必要とせずに、Minecraft でダイヤモンドを収集する最初のアルゴリズムです。 このビデオでは、ゲーム時間 17 日あたり 3,000 万の環境ステップ内で発生した最初のダイヤモンドの収集を示しています。

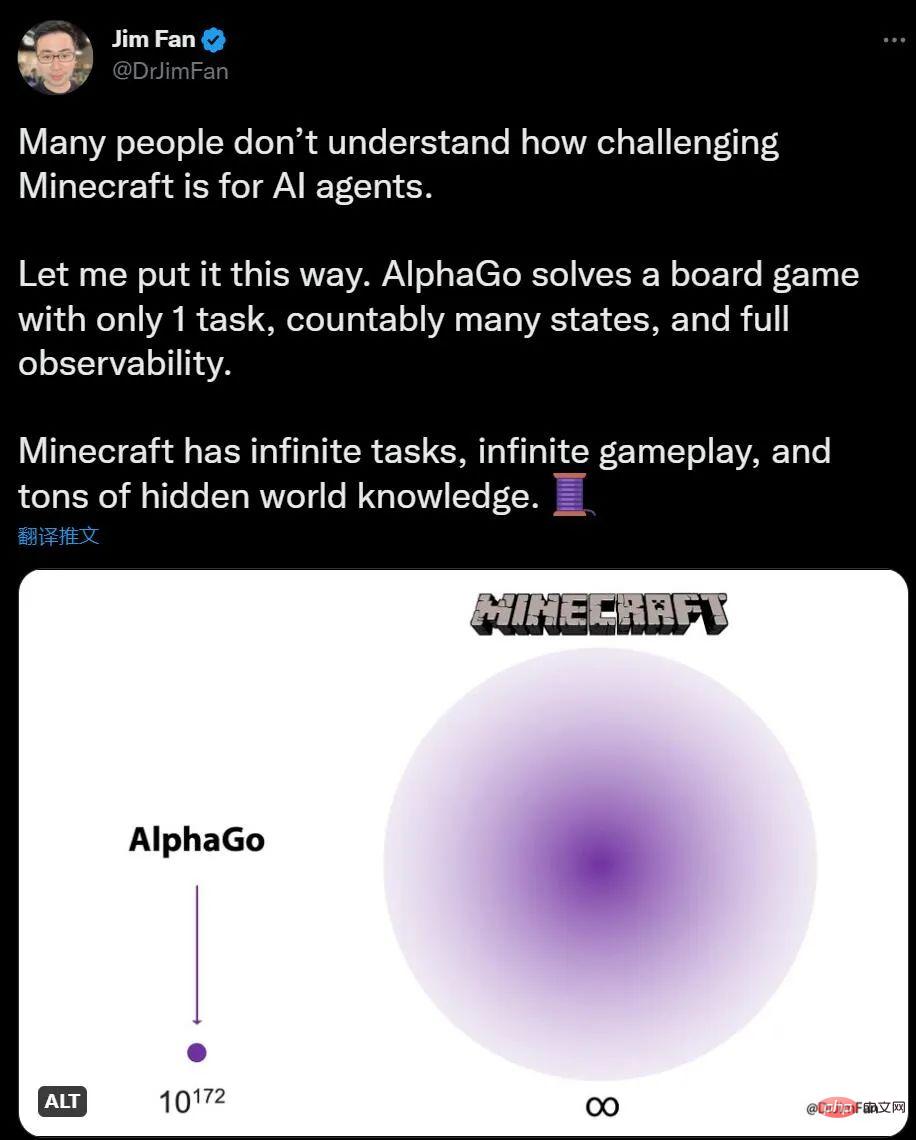

AI による Minecraft のプレイについてまったくご存じない方のために、NVIDIA AI 科学者のジム ファン氏は、囲碁をプレイする AlphaGo と比較して、Minecraft のタスクの数は無制限であり、環境の変化も無制限であると述べています。 、知識にも隠された情報があります。

人間にとって、Minecraft で探索したり建築したりするのは興味深いものですが、Go は少し複雑に思えますが、AI にとってはその逆です。 AlphaGo は 6 年前に人間のチャンピオンを破りましたが、現在では Minecraft の人間のマスターと競合できるアルゴリズムは存在しません。

すでに 2019 年の夏に、Minecraft の開発会社は、ゲーム内でダイヤモンドを見つけることができる AI アルゴリズムに報酬を提供する「ダイヤモンド チャレンジ」を提案しました。 、提出 660 を超えるエントリーのうち、この任務を遂行できた AI は 1 つもありませんでした。

しかし、DreamerV3 の出現により、この状況は変わりました。Diamond は、複雑な探索と計画を必要とする、高度に組み合わされた長期的なタスクです。新しいアルゴリズムは、人工的なデータの支援なしでこれを達成できます。 . ケースのダイヤモンドを集めます。効率には改善の余地があるかもしれませんが、AI エージェントがダイヤモンドを一から収集する方法を学習できるようになったという事実は、重要なマイルストーンです。 DreamerV3 メソッドの概要論文「ワールド モデルによる多様なドメインのマスタリング」:

論文リンク: https://arxiv.org/abs/2301.04104v1

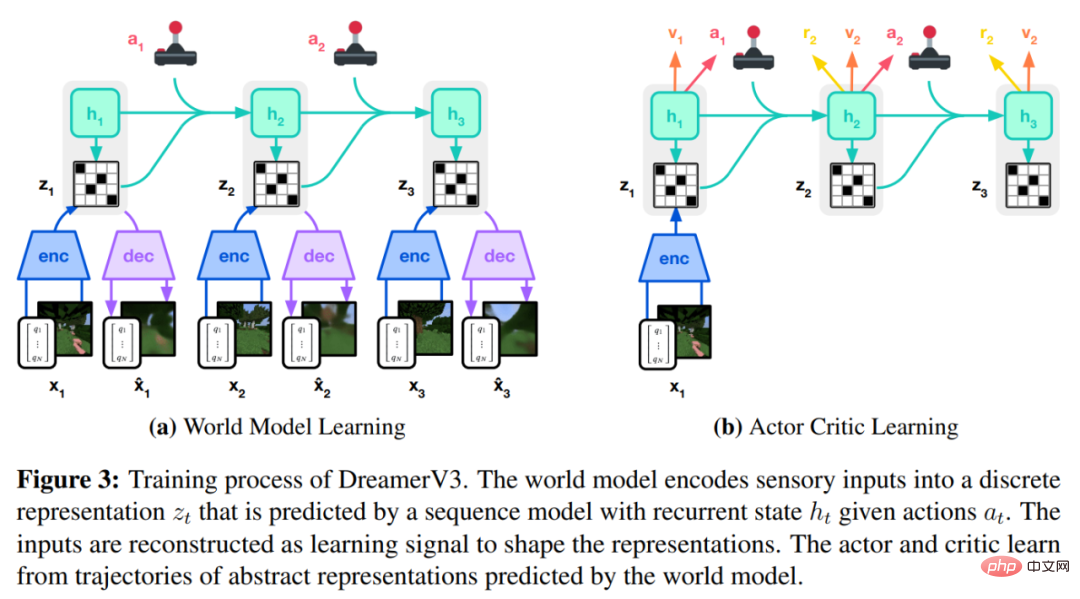

DreamerV3 アルゴリズムは 3 つのニューラル ネットワーク、つまりワールド モデル (ワールドモデル)、評論家、俳優。 3 つのニューラル ネットワークは、勾配を共有せずにリプレイ エクスペリエンスに基づいて同時にトレーニングされます。下の図 3(a) はワールド モデルの学習を示し、図 (b) は Actor Critic の学習を示します。

クロスドメインの成功を達成するには、これらのコンポーネントがさまざまな信号振幅に適応し、ターゲット全体で項のバランスを確実にとる必要があります。学習は同じドメイン内の同様のタスクだけでなく、固定ハイパーパラメータを使用して異なるドメイン間でも行われるため、これは困難です。

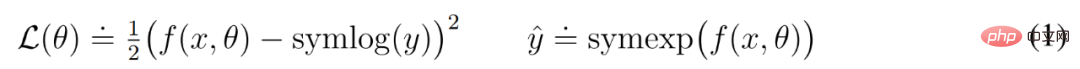

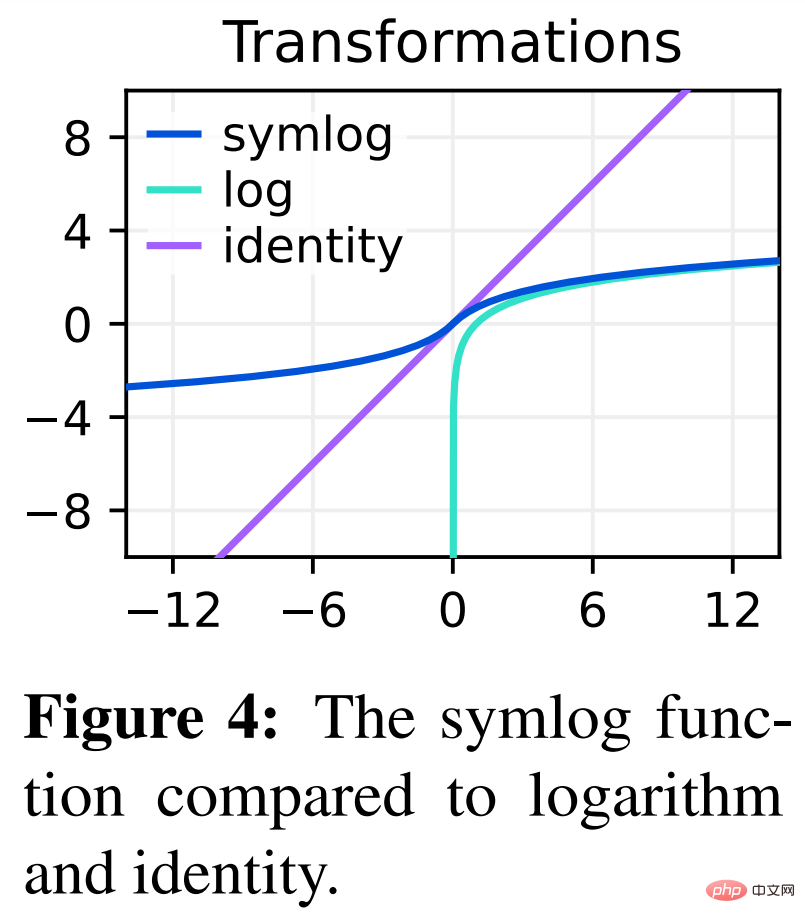

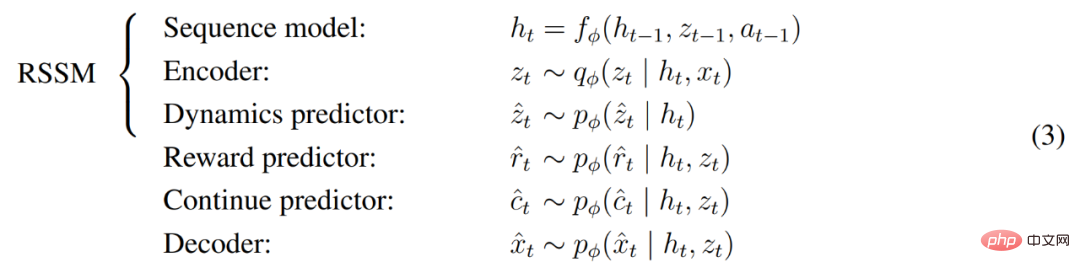

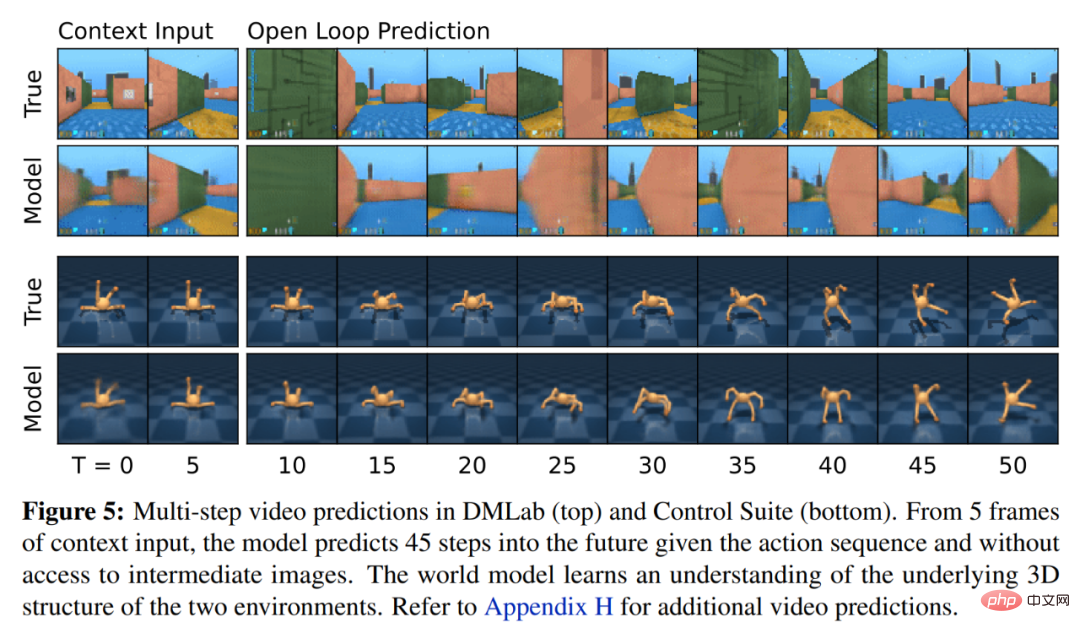

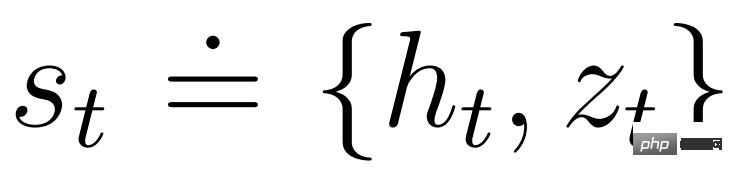

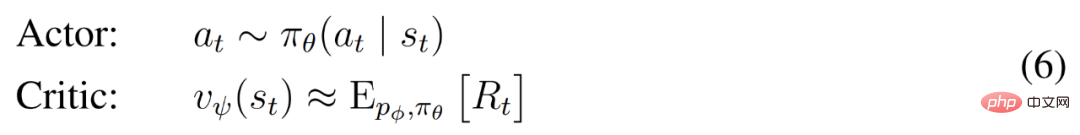

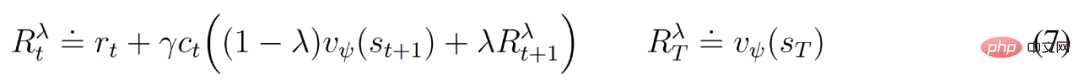

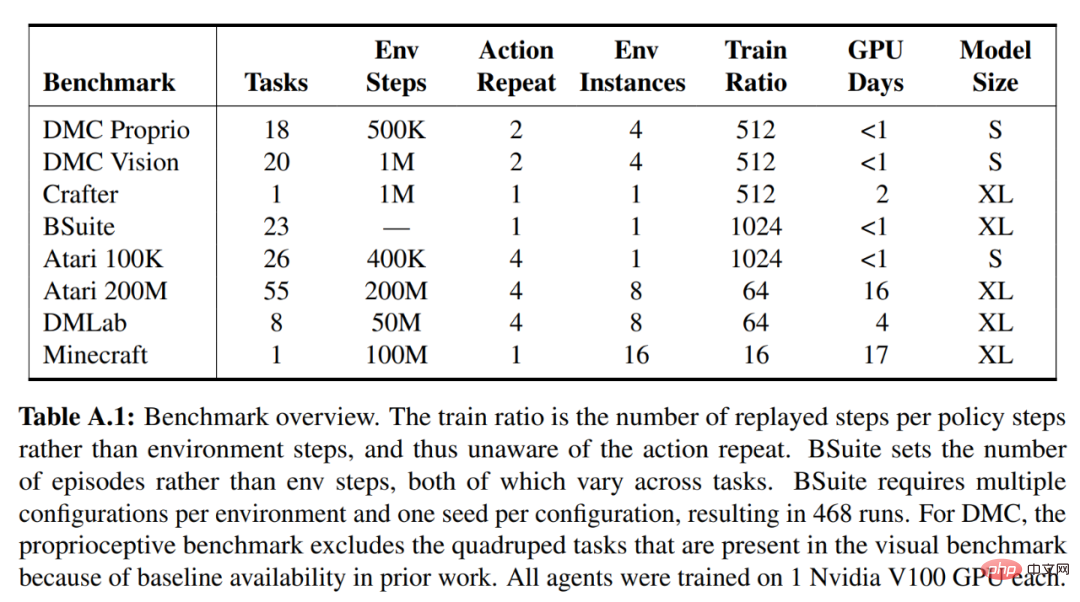

シンログ予測 #入力を再構築し、報酬と値を予測することは、そのスケールがドメインごとに異なる可能性があるため、困難です。大きなターゲットを予測するために二乗損失を使用すると発散が生じますが、絶対損失とフーバー損失は学習を停滞させます。一方、運用統計に基づく正規化目標では、最適化に非定常性が導入されます。したがって、DeepMind は、この問題の簡単な解決策として symlog 予測を提案します。 これを行うために、入力 x とパラメーター θ を持つニューラル ネットワーク f (x, θ) は、ターゲット y の変換されたバージョンを予測することを学習します。ネットワークの予測 y^ を読み取るために、DeepMind は以下の式 (1) に示すように逆変換を使用します。 以下の図 4 からわかるように、負の値を持つターゲットは、変換として対数を使用して予測できません。 したがって、DeepMind は、symlog という名前の対称対数族から関数を変換として選択し、symexp 関数を逆関数として使用します。 symlog 関数は、大きな正および負の値のサイズを圧縮します。 DreamerV3 は、デコーダ、報酬予測器、およびクリティカルで symlog 予測を使用し、エンコーダの入力を圧縮するために symlog 関数も使用します。 世界モデルの学習 世界モデルは、自動エンコーディングを通じて感覚入力のコンパクトな表現を学習し、表現に対する将来の報酬を予測します。計画を実行するための潜在的な行動。 上の図 3 に示すように、DeepMind はワールド モデルをリカレント状態空間モデル (RSSM) として実装します。まず、エンコーダが感覚入力 x_t をランダム表現 z_t にマッピングし、その後、再発状態 h_t を持つシーケンス モデルが、過去のアクション a_t−1 を考慮したこれらの表現のシーケンスを予測します。 h_t と z_t の連結によりモデル状態が形成され、そこから報酬 r_t とエピソード継続性フラグ c_t ∈ {0, 1} が予測され、以下の式 (3) に示すように、情報表現を保証するために入力が再構築されます。 # 以下の図 5 は、世界の長期ビデオ予測を視覚化したものです。エンコーダとデコーダは、視覚入力には畳み込みニューラル ネットワーク (CNN) を使用し、低次元入力には多層パーセプトロン (MLP) を使用します。動的予測子、報酬予測子、持続性予測子も MLP であり、これらの表現はソフトマックス分布のベクトルからサンプリングされます。 DeepMind は、サンプリング ステップでパススルー グラデーションを使用します。 俳優批評家の学習 俳優批評家のニューラル ネットワークは、世界モデル 抽象的なシーケンスで学習された行動を予測します。 DeepMind は、環境との対話中に、事前計画を必要とせずに、アクター ネットワークからサンプリングすることによってアクションを選択します。 アクターと批評家はモデル状態 再生された入力の表現から開始して、動的予測子とアクターは予期されるモデル状態のシーケンス s_1 を生成します。 :T 、アクション a_1:T 、報酬 r_1:T 、および継続フラグ c_1:T 。予測期間外の報酬のリターンを推定するために、DeepMind は期待されるリターンと価値を統合するブートストラップされた λ リターンを計算します。 DeepMind は、固定ハイパーパラメーターの下でさまざまなドメイン (150 以上のタスク) にわたる DreamerV3 の汎用性とスケーラビリティを評価するために広範な実証研究を実施し、既存の SOTA メソッドと比較しました。比較のための文献。 DreamerV3 は、挑戦的なビデオ ゲーム Minecraft にも適用されました。 DreamerV3 の場合、DeepMind は確率的トレーニング戦略のパフォーマンスを直接レポートし、決定論的戦略による個別の評価実行を回避することでセットアップを簡素化します。すべての DreamerV3 エージェントは Nvidia V100 GPU でトレーニングされます。以下の表 1 は、ベンチマークの概要を示しています。 DreamerV3 の汎用性を評価するために、DeepMind は、連続および離散アクション、ビジョン、低次元入力を含む 7 つのドメインで広範な実証評価を実施しました。 、密な報酬と疎な報酬、さまざまな報酬スケール、2D 世界と 3D 世界、手続き型生成。以下の図 1 の結果では、すべてのベンチマークで固定ハイパーパラメーターを使用しながら、DreamerV3 がすべてのドメインで強力なパフォーマンスを達成し、そのうち 4 つで以前のすべてのアルゴリズムを上回っていることがわかります。 #技術的な詳細と実験結果については、元の論文を参照してください。

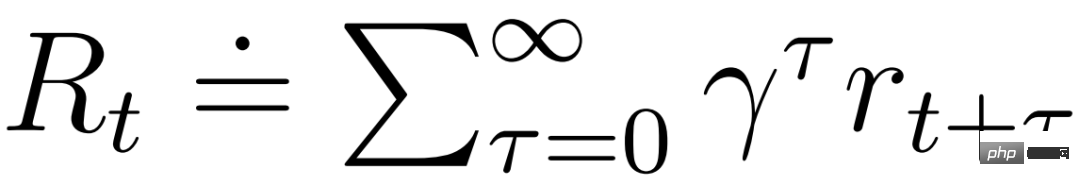

で動作し、ワールド モデルによって学習されたマルコフ表現の恩恵を受けることができます。アクターの目標は、モデル状態ごとに割引係数 γ = 0.997 で期待収益

で動作し、ワールド モデルによって学習されたマルコフ表現の恩恵を受けることができます。アクターの目標は、モデル状態ごとに割引係数 γ = 0.997 で期待収益  # を最大化することです。予測範囲 T = 16 を超える報酬を考慮するために、批評家は現在のアクターの行動を考慮して各状態の報酬を予測する方法を学習します。

# を最大化することです。予測範囲 T = 16 を超える報酬を考慮するために、批評家は現在のアクターの行動を考慮して各状態の報酬を予測する方法を学習します。

実験結果

以上がAI が「Minecraft」のプレイをゼロから学習、DeepMind AI の一般化が画期的な進歩をもたらすの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7569

7569

15

15

1386

1386

52

52

87

87

11

11

28

28

108

108

vscodeのヘッダーファイルを定義する方法

Apr 15, 2025 pm 09:09 PM

vscodeのヘッダーファイルを定義する方法

Apr 15, 2025 pm 09:09 PM

ビジュアルスタジオコードを使用してヘッダーファイルを定義する方法は?ヘッダーファイルを作成し、.hまたは.hpp接尾辞名(クラス、関数、変数など)を使用してヘッダーファイルにシンボルを宣言し、#includeディレクティブを使用してプログラムをコンパイルして、ソースファイルにヘッダーファイルを含めます。ヘッダーファイルが含まれ、宣言された記号が利用可能になります。

Visual StudioコードでCを使用していますか

Apr 15, 2025 pm 08:03 PM

Visual StudioコードでCを使用していますか

Apr 15, 2025 pm 08:03 PM

VSコードでCを書くことは実行可能であるだけでなく、効率的でエレガントです。重要なのは、コードの完了、構文の強調表示、デバッグなどの関数を提供する優れたC/C拡張機能をインストールすることです。 VSコードのデバッグ機能は、バグをすばやく見つけるのに役立ちますが、Printf出力は昔ながらのデバッグ方法です。さらに、動的メモリの割り当ての場合、メモリリークを防ぐためにリターン値をチェックしてメモリを解放する必要があり、これらの問題のデバッグはVSコードで便利です。 VSコードはパフォーマンスの最適化に直接役立つことはできませんが、コードパフォーマンスを簡単に分析するための優れた開発環境を提供します。優れたプログラミング習慣、読みやすさ、保守性も非常に重要です。とにかく、VSコードはです

DockerはYamlを使用します

Apr 15, 2025 am 07:21 AM

DockerはYamlを使用します

Apr 15, 2025 am 07:21 AM

YAMLは、Docker用のコンテナ、画像、サービスの構成に使用されます。構成するには、コンテナの場合は、docker-compose.ymlの名前、画像、ポート、および環境変数を指定します。画像、基本的な画像、ビルドコマンド、およびデフォルトのコマンドがDockerFileで提供されます。サービスの場合は、Docker-Compose.service.ymlの名前、ミラー、ポート、ボリューム、および環境変数を設定します。

Dockerがパブリックイメージを管理するために使用するプラットフォーム

Apr 15, 2025 am 07:06 AM

Dockerがパブリックイメージを管理するために使用するプラットフォーム

Apr 15, 2025 am 07:06 AM

Docker Imageホスティングプラットフォームは、Docker画像の管理と保存に使用されるため、開発者やユーザーが事前に構築されたソフトウェア環境に簡単にアクセスして使用できます。一般的なプラットフォームには以下が含まれます。DockerHub:Dockerが正式にメンテナンスし、巨大なミラーライブラリがあります。 GitHubコンテナレジストリ:GitHubエコシステムを統合します。 Googleコンテナレジストリ:Google Cloud Platformがホストしています。 Amazon Elastic Containerレジストリ:AWSがホスト。 quay.io:赤い帽子

Dockerはどのような根本的なテクノロジーを使用していますか?

Apr 15, 2025 am 07:09 AM

Dockerはどのような根本的なテクノロジーを使用していますか?

Apr 15, 2025 am 07:09 AM

Dockerは、コンテナエンジン、ミラー形式、ストレージドライバー、ネットワークモデル、コンテナオーケストールツール、オペレーティングシステム仮想化、コンテナレジストリを使用して、コンテナ化機能をサポートし、軽量でポータブルで自動化されたアプリケーションの展開と管理を提供します。

どちらが優れているか、VSCODEまたはVisual Studio

Apr 15, 2025 pm 08:36 PM

どちらが優れているか、VSCODEまたはVisual Studio

Apr 15, 2025 pm 08:36 PM

特定のニーズとプロジェクトのサイズに応じて、最も適切なIDE:大規模プロジェクト(特にC#、C)と複雑なデバッグ:Visual Studioを選択します。小規模プロジェクト、迅速なプロトタイピング、低い構成マシン:VSコード、軽量、高速スタートアップ速度、低リソースの利用、および非常に高いスケーラビリティ。最終的には、VSコードとVisual Studioを試して体験することで、最良のソリューションを見つけることができます。最良の結果を得るために両方を使用することを検討することもできます。

DockerはMacVlanを使用します

Apr 15, 2025 am 06:57 AM

DockerはMacVlanを使用します

Apr 15, 2025 am 06:57 AM

DockerのMacVlanは、コンテナが独自のMACアドレスを持つことができるLinuxカーネルモジュールであり、ネットワークの分離、パフォーマンスの改善、物理ネットワークとの直接的な相互作用を可能にします。 MacVLANを使用するには次のことが必要です。1。カーネルモジュールをインストールします。 2。MacVlanネットワークを作成します。 3. IPアドレスセグメントを割り当てます。 4.コンテナの作成時にMacVlanネットワークを指定します。 5.接続を確認します。

vscodeはKotlinを実行できます

Apr 15, 2025 pm 06:57 PM

vscodeはKotlinを実行できます

Apr 15, 2025 pm 06:57 PM

VSコードでKotlinを実行するには、次の環境構成が必要です:Java Development Kit(JDK)とKotlin Compiler Kotlin関連プラグイン(VSコード用のKotlin LanguageやKotlin Extensionなど)Kotlinファイルを作成し、テスト用のコードを実行して、環境構成が成功するようにします