チューリング賞受賞者ジェフリー・ヒントン: 私の 50 年間のディープラーニングのキャリアと研究方法

彼は正式にコンピュータのコースを受講したことはありません。ケンブリッジ大学の学部生として生理学と物理学を学びました。この期間中、彼は哲学に転向しましたが、最終的には学士号を取得しました。心理学の学位. 学位; 彼は勉強するのに疲れて一度は大工になったが、挫折に遭遇した後、エディンバラ大学に戻り、「人気のない専攻」である人工知能の博士号を取得した; 彼の苦手な数学が彼に感じさせた教授になってからも、神経科学や計算科学のわからないところはいつも大学院生にアドバイスを求めていました。

学術的な道は驚異的であるように見えますが、最後に笑ったのはジェフリー ヒントンでした。彼は「深層学習のゴッドファーザー」として知られ、世界で最高の栄誉を獲得しました。コンピュータサイエンスの分野で名誉ある「チューリング賞」を受賞。

ヒントンは英国の裕福な科学者の家庭に生まれましたが、学術的なキャリアと生涯を通じて経験した浮き沈みは豊かで奇妙なものでした。 。

彼の父親、ハワード・エベレスト・ヒントンは英国の昆虫学者、母親のマーガレットは教師で、二人とも共産主義者でした。彼の叔父は経済用語「国民総生産」を発明した有名な経済学者のコリン・クラークであり、曾祖父は有名な論理学者ジョージ・ブールであり、彼のブール代数の発明は現代のコンピューターサイエンスの基礎を築きました。

ヒントンは科学者という裕福な家系の影響を受け、幼い頃から独立した思考力と粘り強さを持ち、一族の名誉を継承する責任を担ってきました。母親から「学者になるか、負け犬になるか」という二者択一を与えられた彼に、あえて横たわる道を選ぶ理由はなく、大学時代は苦労しながらも学業を終えた。

1973 年、彼はイギリスのエディンバラ大学でランガー ヒギンズの下で人工知能の博士号取得を目指しましたが、当時はニューラル ネットワークを信じる人はほとんどいなかったので、彼の理論は信じていませんでした。指導者は彼にこの技術の研究をやめるよう説得した。彼の周囲の疑念は、ニューラル ネットワークに対する彼の確固たる信念を揺るがすには十分ではなく、その後 10 年間、彼はバックプロパゲーション アルゴリズムとボルツマン マシンを次々と提案しましたが、深層学習についてはさらに数十年待たなければなりませんでした。彼の研究はその時までに広く知られることになるだろう。

博士課程を卒業した後、ヒントンは人生で苦難も経験しました。最初の妻ロス(分子生物学者)とともに渡米し、カーネギーメロン大学で教職を得たが、レーガン政権への不満や、人工知能研究は基本的に米国省の支援を受けていたことなどから、ディフェンス、彼らは1987年にカナダに行き、ヒントンはトロント大学のコンピュータサイエンス学部で教鞭をとり、CIFARのカナダ高等研究所で機械および脳学習プロジェクトの研究を始めました。

残念ながら、1994 年に妻のロスが卵巣癌で亡くなり、ヒントンは 2 人の幼い子供を一人で育てることになり、そのうちの 1 人は ADHD やその他の学習障害を患っていました。その後、現在の妻ジャッキー(美術史家)と再婚したが、同様の危機が再び迫り、ジャッキーも数年前にガンを患った。

彼自身も重度の腰椎疾患を患っており、普通の人のように座ることができず、ほとんどの時間立って仕事をしなければなりません。なぜなら、彼は離陸時と着陸時に直立して座らなければならないため、他の場所で学術レポートを作成する能力も制限されるからです。

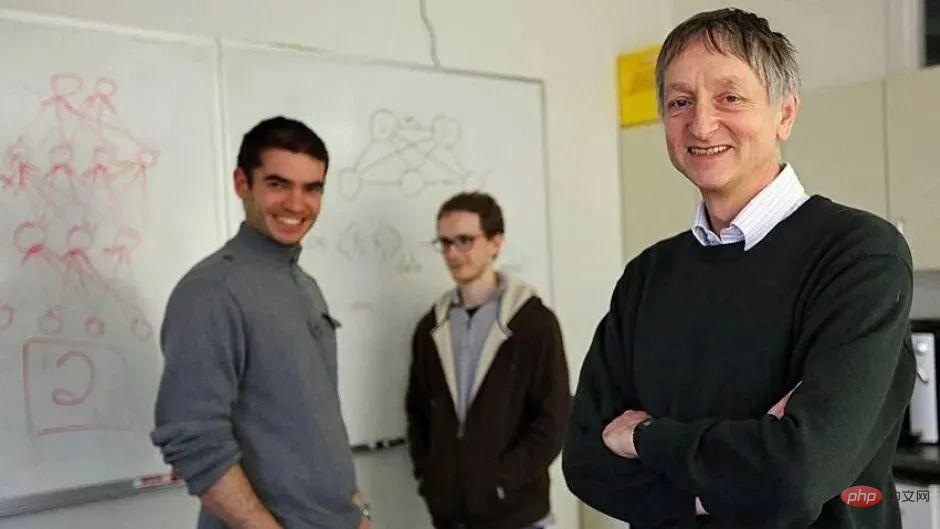

##左から右へ、イリヤ・サツケヴァー、アレックス・クリジェフスキー、ジェフリー・ヒントン

ほぼ半世紀にわたるテクノロジーへの粘り強さと生活の鍛錬を経て、ついに 2012 年の夜明けが明けました。彼とその生徒である Alex Krizhevsky 氏と Ilya Sutskever 氏によって提案された AlexNet は業界に衝撃を与え、コンピュータ ビジョンの分野を再構築し、新しいサービスを立ち上げました。ディープラーニングの黄金時代のラウンド。

また、2012 年末に、彼と 2 人の学生はトリオ会社 DNN-research を設立し、4,400 万米ドルという「法外な価格」で Google に売却しました。また、学者から Google の副社長およびエンジニアリング フェローに転身しました。

2019 年、コンピュータ サイエンス以外の背景を持つ AI 教授ヒントンは、ヨシュア ベンジオ、ヤン ルカンとともにチューリング賞を受賞しました。

数々の苦難を乗り越え、74歳の「ディープラーニングのゴッドファーザー」は今もAI研究の最前線で戦い続けている。他の学者たちも受け入れ、実現していないものは率直に認めます。何はともあれ、ディープラーニングの台頭から10年経った今でも、このテクノロジーはそのエネルギーを放出し続けると信じており、次のブレークスルーポイントを考え、模索している。

それでは、ニューラル ネットワークに対する彼の確固たる信念はどこから来るのでしょうか?ディープラーニングが「壁にぶつかっている」という現在の懐疑論の中で、同氏はAI開発の次の段階をどのように見ているのだろうか。彼は若い世代のAI研究者にどんなメッセージを送っていますか?

最近、Pieter Abbeel が主催する The Robot Brains Podcast で、ヒントンは自身の学術的キャリア、ディープラーニングの将来と研究経験、そして DNN 研究のオークションについて非常に率直に語りました。裏話。彼が言いたかったことは次のとおりです。

8 歳のヒントン

私にとって最も大きな影響を与えたのは、幼少期に受けた教育です。私の家族は無宗教で、父は共産主義者ですが、私立学校での科学教育の方が優れていると考え、私が7歳のとき、父は私を学費の高いキリスト教系の私立学校に行かせるよう主張しました。私以外の全員が子供たちを信じています。神の中で。

家に帰ってすぐ家族に宗教なんてナンセンスと言われました もちろん自意識が強いせいか自分では信じられず気づきました神への信仰は間違っていたと考え、他人に質問する習慣を身につけてください。もちろん、何年も経って、彼らは当初の信念が間違っていたことに気づき、神は実際には存在しないかもしれないことに気づきます。

しかし、今、信仰を持てと言えば、信仰は大切です。皮肉に聞こえるかもしれませんが、私たちは科学研究を信じる必要があります。 you are たとえ間違っていても、正しい道を歩き続けることができる。

1 1970 年代、私はニューラル ネットワーク「孤独な戦士」を研究しました

私の学歴は非常に豊富です。ケンブリッジ大学の 1 年生のとき、私は物理学と生理学を同時に専攻した唯一の学生でした。これにより、その後の科学研究のキャリアにおいて、科学と工学における一定の基礎が築かれました。

しかし、数学が苦手だったので物理の勉強は断念しましたが、人生の意味についてとても興味があったので、哲学を勉強することにしました。ある程度の成果が出たので、心理学を読んで勉強し直しました。

ケンブリッジでの最後の年はとても難しくて不幸だったので、試験が終わるとすぐに中退し、大工として働きました。実際、私は他のことをするよりも大工になるほうが好きです。

高校生の頃、昼間の授業が終わると家に帰って大工仕事をするのが一番幸せな瞬間でした。私はゆっくりと大工になりましたが、半年ほど働いた後、大工には見た目以上の仕事があるにもかかわらず、大工が稼ぐお金は生計を立てるには少なすぎることに気づきました。装飾の方が楽だし、すぐにお金が入ってくるので、大工として働きながら、装飾のアルバイトもしています。あなたが上級大工でない限り、大工として稼ぐお金は装飾ほど良いものではありません。

ある日、本当に優秀な大工さんに出会うまで、自分がこの仕事に向いていないことに気づきませんでした。石炭会社から暗く湿気の多い地下室用の扉の製作を依頼された大工さんは、特殊な環境を考慮し、湿気による木の変形を補うために木材を逆向きに配置したという、今までにない工夫をしました。以前考えた方法。手鋸を使って木片を正方形に切ることもできます。彼は私にこう説明してくれました。「木材を正方形に切りたいなら、鋸と木材を部屋の位置に合わせなければなりません。」

当時、私は彼にあまりにも遅れをとっていると感じたので、人工知能を学ぶために学校に戻ったほうがいいのかもしれないと思いました。

その後、私はニューラル ネットワークの博士号取得のためにエディンバラ大学に行きました。指導教官は有名なクリストファー ロングート ヒギンズ教授でした。 30代で水素化ホウ素の構造を解明し、ノーベル賞を受賞するところでした、本当にすごいですね。今でも彼が何を研究していたのかは分かりませんが、量子力学に関係しているということだけは分かっていますが、この研究の事実根拠は「恒等演算子の回転は360度ではなく720度である」ということです。

彼は以前はニューラル ネットワークとホログラムの関係に非常に興味を持っていましたが、私がエディンバラ大学に到着した後、主に勉強のため、突然ニューラル ネットワークへの興味を失ってしまいました。彼はウィノグラード(アメリカのコンピュータ科学者)の論文を読んで、ニューラルネットワークには発展の見込みがなく、記号人工知能に転換すべきであると完全に確信し、その論文は彼に大きな影響を与えました。

実は彼は私の研究の方向性が合わず、賞を取りやすい研究をして欲しいとのことでしたが、それでも自分の方向性をしっかり持ってくださいと言ってくれる良い人でした。ニューラルネットワークを勉強してください。

マービン・ミンスキーとシーモア・パパート

1970年代初頭、誰もが私に尋ねましたが、マービン・ミンスキーとシーモア・パパートは二人とも、ニューラルネットワークには暗い未来があると言っていますが、なぜ彼らはそうし続けるのですか?正直に言うと寂しいです。

1973 年、私は初めてグループでスピーチをしました。その内容は、ニューラル ネットワークを使用して実際の再帰を行う方法についてでした。最初のプロジェクトで、ニューラル ネットワークにグラフを描画させたい場合、グラフを複数の部分に分割し、グラフのこれらの部分は同様のニューラル ハードウェアで描画できることを発見しました。その場合、グラフ全体を保存するニューラル センターは次のようになります。グラフィック全体の位置、方向、サイズを覚えておく必要があります。

グラフを描画しているニューラル ネットワークが突然実行を停止し、別のニューラル ネットワークを使用してグラフの描画を続行したい場合は、グラフと作業が進行した後、描画作業を続けることができます。難しいのは、これらの機能をニューラルネットワークにどのように実現させるかです。明らかに、ニューロンをコピーするだけでは十分ではないため、リアルタイムで適応し、高速な重み付けを通じて作業の進行状況を記録するシステムを設計したいと考えています。このようにして、関連する状態を復元することで、タスクを続行できます。

そこで、高度な呼び出しの再帰と同じニューロンと重みを再利用することで、真の再帰呼び出しを可能にするニューラル ネットワークのセットを作成しました。しかし、私は話すのが苦手なので、何を言っているのか誰も理解できないと感じています。

彼らは、明らかに Lisp 再帰を使用できるのに、なぜニューラル ネットワークで再帰を実行する必要があるのかと言いました。彼らが知らないのは、ニューラル ネットワークが再帰などを実装できない限り、解決できない問題が山ほどあるということです。さて、これがまた興味深い問題になってきたので、この問題が 50 年前の骨董品になるまでもう 1 年待って、それから高速重みに関する研究論文を書くつもりです。

当時、誰もがニューラル ネットワークに反対していたわけではありません。 1950 年代に戻ると、フォン ノイマンやチューリングなどの研究者はまだニューラル ネットワークを信じていました。二人とも脳の仕組みに非常に興味を持っていました。特にチューリングはニューラル ネットワークの強化を信じていました。自分の研究の方向性に自信を与えてくれました。

彼らが若くして亡くなったのは残念です。もし彼らがあと数年生きられたら、彼らの知恵はこの分野の発展に影響を与えるのに十分でしょう。英国はすでに計画を立てているかもしれません。この点で画期的な進歩があり、おそらく人工知能の登場により、現在の状況は大きく変わるでしょう。

2 純粋な学者から Google 社員へGoogle で働く主な理由は、息子が障害を持っており、息子のためにお金を稼がなければならないからです。

2012 年、Coursera で講義を行うことで多額の収益が得られると感じ、ニューラル ネットワーク関連のコースを開設しました。初期のCourseraソフトウェアは使いにくく、ソフトウェアの操作も苦手でイライラすることがよくありました。

当初、私はトロント大学と合意に達し、これらのコースで収益が得られれば、大学は講師に資金の一部を寄付することにしました。具体的なシェア比率は明言されませんでしたが、半々くらいではないかという意見もありましたので、快く引き受けさせていただきました。

コースの録画プロセス中に、学校にビデオの録画を依頼しましたが、「ビデオの作成にどれくらいの費用がかかるか知っていますか?」と尋ねられました。私自身もビデオを作成しているため、そうしていますが、学校はまだ何のサポートも提供していません。しかし、私が授業を始めた後(私はすでに窮地に陥っていました)、校長は私にも誰にも相談せずに、お金はすべて学校が持ち、私には一銭も入らないと一方的に決めました。当初の契約書。

彼らは私に授業を録画するよう求め、それが私の教育業務の一部であると言ったものの、実際にはそれは私の指導範囲には属しておらず、私が以前に行った関連講義に基づいた単なるコースでした。したがって、その後の教育活動でCourseraを再度使用することはありませんでした。その出来事で私はとても腹が立ったので、別のキャリアを追求することを考え始めました。

現在、多くの企業が突然私たちにオリーブの枝を差し出し、多額の資金を提供してくださったり、会社設立を支援してくださったりしました。調査内容は非常に興味深いものです。

州政府からすでに研究助成金が与えられているため、余分なお金を稼ぐ必要はなくなり、自分たちの研究に集中できます。しかし、学校からお金をだまし取られた経験から、もっとお金を稼ぎたいと思うようになり、後に設立されたばかりの DNN リサーチを競売にかけました。

この取引は、2012 年 12 月の NIPS (神経情報処理システム会議) 中に発生しました。会議はタホ湖畔のエンターテイメント会場で開催されました。地下室と地下室でライトが輝いていました。上半身裸のギャンブラーたちが煙の充満した部屋で「あなたは25,000ドル勝った、これはすべてあなたのものだ」と叫んでいた…一方、上の階ではある会社が競売にかけられていた。

まるで映画の中で演技しているようで、ソーシャルメディアで見たものとまったく同じで、本当に素晴らしかったです。会社を競売にかけた理由は、会社自体の価値が分からなかったので知財弁護士に相談したところ、プロの交渉人を直接雇って会社と交渉する方法の2つがあると言われました。大企業は交渉をしますが、これは不愉快な事態に遭遇する可能性があります; 2 つ目はオークションを開始することです。

私の知る限り、当社のような中小企業がオークションを実施するのは史上初めてです。私が最終的に Gmail 経由で入札したのは、その夏に Google で働いていて、Google がユーザーの電子メールを無作為に盗むつもりはないことを知っていたからであり、今でもそう思っています。しかし、マイクロソフトは私たちの決定に不満を表明しました。

オークション プロセスは次のとおりです。オークションに参加する企業は、入札を Gmail 経由で当社に送信する必要があります。その後、当社はその入札を Gmail のタイムスタンプとともに他の参加者に送信します。開始価格は 500,000 ドルでしたが、その後誰かが 100 万ドルを入札しました。私たちは入札額が上がるのを見てとてもうれしく、私たちが思っていたよりもはるかに高い価値があることに気づきました。入札が一定のレベル(当時は天文学的だと考えていました)に達すると、私たちは Google で働くことに傾き、オークションを中止しました。

Google で働くことは正しい選択でした。ここで 9 年間働いています。ここで10年働いたら賞をくれるはずですが、そこまで長く働いている人は数えるほどしかいません。

人々は他の会社よりも Google で働くことを好みますし、私もそう思います。私がこの会社を好きな主な理由は、Google Brain チームが素晴らしいからです。私は大規模な学習システムの構築方法の研究と、脳の動作メカニズムの研究に重点を置いています。Google Brain には、大規模なシステムの研究に必要な豊富なリソースがあるだけでなく、多くの優れた才能とコミュニケーションし、学ぶことができます。

私もそのようなストレートな性格の人間の一人ですが、ジェフ・ディーンは賢い人なので、彼と仲良くなれるのはとても嬉しいことです。彼は私に基礎的な研究をして新しいアルゴリズムを考え出すよう求めていました。私はそれが大好きでした。私は大規模なチームをまとめるのが苦手ですが、その代わり言語認識の精度を1パーセントでも向上させたいという気持ちがあり、この分野に新たな革命を起こすことがずっとやりたいと思っていました。

3 ディープ ラーニングの次の重要事項

ディープ ラーニングの開発は、大量のデータと強力なコンピューティング能力を備えた大規模ネットワークにおける確率的勾配降下法に依存しています。 、ランダムな非アクティブ化 (ドロップアウト) や現在の多くの研究など、いくつかのアイデアはよりよく根付いていますが、これらすべては強力なコンピューティング能力、大量のデータ、確率的勾配降下法から切り離すことはできません。

ディープラーニングはボトルネックに直面しているとよく言われますが、実際には前進しています。懐疑的な人は、ディープラーニングで今何ができないのかを書き留めてほしいと思います。今から 5 年後には、ディープラーニングでこれらのことができることが証明されるでしょう。

もちろん、これらのタスクは厳密に定義する必要があります。例えば、ヘクター・レベスク氏(トロント大学コンピューターサイエンス教授)は典型的なAI人材であり、彼自身も非常に優秀です。ヘクターは、ウィノグラード文という標準を確立しました。その一例は、「トロフィーは小さすぎるため、スーツケースには入りません。トロフィーは大きすぎるため、スーツケースには入りません。」です。

#これら 2 つの文をフランス語に翻訳したい場合は、最初のケースでは「それ」がスーツケースを指しており、2 番目のケースでは「それ」がトロフィーを指していることを理解する必要があります。彼らはフランス語では異なる性別であり、初期のニューラル ネットワークの機械翻訳はランダムであったため、機械が上記の文をフランス語に翻訳したとき、機械は性別を正しく識別できませんでした。しかし、この状況は改善されつつあり、少なくともヘクターはニューロンを非常に明確に定義し、ニューロンが何ができるかを指摘しました。完璧ではありませんが、少なくともランダムな翻訳よりははるかに優れています。懐疑論者がこのような疑問をもっと提起してくれることを願っています。ディープ ラーニングの非常に成功したパラダイムは、今後も繁栄し続けると思います。目的関数の勾配に基づいて多数の実数値パラメータを調整しますが、おそらくそうではありません。バックプロパゲーション メカニズムを使用して勾配を取得しますが、目的関数はより局所的で拡散する場合があります。

私の個人的な推測では、次の大きな AI イベントは間違いなくスパイク ニューラル ネットワークの学習アルゴリズムになるでしょう。パルスを実行するかどうかの離散的な決定と、いつパルスを実行するかの連続的な決定を解決できるため、パルス時間を使用して興味深い計算を実行できますが、これは非インパルス性ニューラル ネットワークでは実際には実行が困難です。これまでスパイキング ニューラル ネットワークの学習アルゴリズムを深く研究できなかったことは、私の研究者としてのキャリアの大きな後悔でした。

AGI を勉強するつもりはありませんし、AGI ビジョンの背景にはさまざまな問題があるため、AGI が何であるかを定義することは避けようとしていますが、パラメーターを使用してニューロンの数を拡張するだけです。またはニューロンの接続はまだ一般的な人工知能を可能にしていません。

AGI は、人間と同じくらい賢い、人間に似たインテリジェント ロボットを構想しています。知能が必ずしもこのように発達するとは思いませんが、より共生的な形で発達することを願っています。おそらく私たちはインテリジェントなコンピューターを設計することになると思いますが、それらは人間のように自律的ではありません。彼らの目的が他人を殺すことであるなら、おそらく彼らは自律的でなければなりませんが、私たちがその方向に行かないことを願っています。

4 研究の直観を信じ、好奇心に突き動かされる

考え方は人それぞれ異なり、自分自身の思考プロセスを必ずしも理解できるとは限りません。私は直感に従うのが好きで、研究をするときはアナロジーを使用することを好みます。人間の推論の基本的な方法は、大きなベクトルの中で適切な特徴を使用してアナロジーを行うことに基づいていると信じており、私自身もそうしています。私はよくコンピュータで研究結果を何度もテストして、何がうまくいき、何がうまくいかないかを確認します。確かに物事の根底にある数理を理解して基礎研究をすることは大切ですし、議論することも必要ですが、それは私のやりたいことではありません。

小さなテストをしてみましょう: NIPS カンファレンスで 2 つの講演がある場合、1 つは、既知の結論を証明するために新しいスマートでエレガントな方法を使用することに関するもので、もう 1 つは、新しい強力な学習アルゴリズムですが、アルゴリズムの背後にあるロジックは現時点では不明です。

これら 2 つの講義のうち 1 つを選択して出席する必要がある場合、どちらを選びますか? 2 回目の講義に比べて、1 回目の講義のほうが受け入れやすいかもしれません。人々は既知のことを証明するための新しい方法に興味があるようですが、私は 2 回目の講義に行きます。結局のところ、ニューラル ネットワークの分野では、ほとんどすべての講義がそれは、従来の推論ではなく、数学的推論を行う際の人々の瞬間的な直観から来ています。

では、自分の直感を信じる必要がありますか?私には基準があります。あなたには優れた直感があるか、そうでないかのどちらかです。勘が鋭くないなら何をやっても大丈夫ですが、勘が鋭いなら自分の直感を信じて正しいと思うことをやるべきです。

もちろん、鋭い直観力は世界に対する理解と多大な努力から生まれます。同じことに対して多くの経験を積むと、直感が養われます。

私は軽度の躁うつ病に苦しんでおり、通常 2 つの状態の間をさまよっています。適度な自己批判は非常に創造的になりますが、極度の自己批判は軽度のうつ病になります。しかし、これは単一の感情よりも効率的だと思います。イライラしたときは、当たり前のことを無視して、何か面白くてエキサイティングな発見が待っていると確信して、先に進んでください。問題に直面して不意を突かれたときは、粘り強く考えを明確にし、自分のアイデアの質を慎重に検討する必要があります。 この感情の交替のおかげで、私はよく「脳の仕組みがわかった」とみんなに話しますが、しばらくして、以前の結論が次のようなものであることに気づきがっかりしました。しかし、ウィリアム・ブレイクの詩の 2 行のように、「神聖な心に喜びと悲しみを織り交ぜる」ように、物事はこうなるはずです。 科学研究の仕事も同様だと思いますが、成功しても興奮せず、失敗しても悔しくない人は、本当の意味での研究者ではありません。 私の研究キャリアにおいて、一部のアルゴリズムを完全に理解できないと感じることはありますが、本当に迷ったり絶望したりしたことはありません。私の意見では、最終結果がどのようなものであっても、やるべきことは常にあると思います。優秀な研究者は常にやりたいことがたくさんありますが、時間がありません。 私がトロント大学で教えていたとき、コンピューター サイエンスを専攻する学部生は非常に優秀で、コンピューター サイエンスを副専攻する認知科学を専攻する学部生もたくさんいることに気づきました。 「非常に良い成績を収めました。一部の学生はテクノロジーが苦手ですが、それでも研究では良い仕事をしています。彼らはコンピュータサイエンスが大好きで、人間の認知がどのように形成されるかを本当に理解したいと思っています。彼らは無限の興味を持っています。」 ブレイク・リチャーズ (モントリオール神経研究所の助教授) のような科学者は、どのような問題を解決したいのかを正確に知っており、その方向に進むだけです。今日、多くの科学者は自分が何をしたいのか分かっていません。 振り返ってみると、若い人たちは単にスキルを学ぶのではなく、自分の興味のある方向性を見つけるべきだと思います。自分の興味に突き動かされて、自分が望む答えを見つけるために必要な知識を率先して習得します。これは、やみくもにテクノロジーを学ぶよりも重要です。 今思うと、若いころにもっと数学を勉強しておけばよかった、そうしておけば線形代数はもっと簡単だったのに。 数学はよく絶望的な気分にさせるので、一部の論文を読むのが難しくなり、特に多くの記号を理解するのが難しくなります。本当に大きな挑戦なので、あまり本を読みません。 . 複数の論文。神経科学についてはテリー・セジナウスキー先生(計算神経学教授)に、コンピュータサイエンスについては大学院生に解説していただくことが多いです。研究が実現可能かどうかを証明するために数学を使用する必要があるとき、私は常に適切な方法を見つけます。 研究を行うことで世界をより良い場所にするという考えは素晴らしいですが、私は人間の創造性の上限を探求するのがさらに楽しいです。脳がどのように機能するのかを本当に理解したいと思っています。うまく機能するとしても、脳の仕組みを理解するためにニューラルネットワークをスパイクするための学習アルゴリズムなど、いくつかの新しいアイデアが必要だと私は考えています。 私は、最高の研究活動は多数の大学院生グループによって行われ、豊富なリソースが提供されるものだと信じています。科学研究の仕事には、若々しい活力、終わりのないモチベーション、そして研究に対する強い関心が必要です。 最高の基礎研究を行うには、好奇心に突き動かされなければなりません。そうして初めて、明らかな障害を無視して、達成される結果を見積もる意欲が湧くでしょう。一般的な勉強であれば、創造性は最も重要なことではありません。 大勢の賢い人々が何に取り組んでいるのかを把握し、さまざまな調査を行うことは常に良い考えです。特定の分野ですでにある程度の進歩を遂げている場合、他の新しいアイデアは必要ありません。成功するには、既存の研究をさらに深く掘り下げるだけで済みます。ただし、大きなハードウェアを構築するなど、新しいアイデアに取り組みたい場合は、それも素晴らしいことですが、前途は少し険しいかもしれません。

以上がチューリング賞受賞者ジェフリー・ヒントン: 私の 50 年間のディープラーニングのキャリアと研究方法の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7480

7480

15

15

1377

1377

52

52

77

77

11

11

19

19

33

33

ORB-SLAM3を超えて! SL-SLAM: 低照度、重度のジッター、弱いテクスチャのシーンはすべて処理されます。

May 30, 2024 am 09:35 AM

ORB-SLAM3を超えて! SL-SLAM: 低照度、重度のジッター、弱いテクスチャのシーンはすべて処理されます。

May 30, 2024 am 09:35 AM

以前に書きましたが、今日は、深層学習テクノロジーが複雑な環境におけるビジョンベースの SLAM (同時ローカリゼーションとマッピング) のパフォーマンスをどのように向上させることができるかについて説明します。ここでは、深部特徴抽出と深度マッチング手法を組み合わせることで、低照度条件、動的照明、テクスチャの弱い領域、激しいセックスなどの困難なシナリオでの適応を改善するように設計された多用途のハイブリッド ビジュアル SLAM システムを紹介します。当社のシステムは、拡張単眼、ステレオ、単眼慣性、ステレオ慣性構成を含む複数のモードをサポートしています。さらに、他の研究にインスピレーションを与えるために、ビジュアル SLAM と深層学習手法を組み合わせる方法も分析します。公開データセットと自己サンプリングデータに関する広範な実験を通じて、測位精度と追跡堅牢性の点で SL-SLAM の優位性を実証しました。

Stable Diffusion 3 の論文がついに公開され、アーキテクチャの詳細が明らかになりましたが、Sora の再現に役立つでしょうか?

Mar 06, 2024 pm 05:34 PM

Stable Diffusion 3 の論文がついに公開され、アーキテクチャの詳細が明らかになりましたが、Sora の再現に役立つでしょうか?

Mar 06, 2024 pm 05:34 PM

StableDiffusion3 の論文がついに登場しました!このモデルは2週間前にリリースされ、Soraと同じDiT(DiffusionTransformer)アーキテクチャを採用しており、リリースされると大きな話題を呼びました。前バージョンと比較して、StableDiffusion3で生成される画像の品質が大幅に向上し、マルチテーマプロンプトに対応したほか、テキスト書き込み効果も向上し、文字化けが発生しなくなりました。 StabilityAI は、StableDiffusion3 はパラメータ サイズが 800M から 8B までの一連のモデルであると指摘しました。このパラメーター範囲は、モデルを多くのポータブル デバイス上で直接実行できることを意味し、AI の使用を大幅に削減します。

自動運転と軌道予測についてはこの記事を読めば十分です!

Feb 28, 2024 pm 07:20 PM

自動運転と軌道予測についてはこの記事を読めば十分です!

Feb 28, 2024 pm 07:20 PM

自動運転では軌道予測が重要な役割を果たしており、自動運転軌道予測とは、車両の走行過程におけるさまざまなデータを分析し、将来の車両の走行軌跡を予測することを指します。自動運転のコアモジュールとして、軌道予測の品質は下流の計画制御にとって非常に重要です。軌道予測タスクには豊富な技術スタックがあり、自動運転の動的/静的知覚、高精度地図、車線境界線、ニューラル ネットワーク アーキテクチャ (CNN&GNN&Transformer) スキルなどに精通している必要があります。始めるのは非常に困難です。多くのファンは、できるだけ早く軌道予測を始めて、落とし穴を避けたいと考えています。今日は、軌道予測に関するよくある問題と入門的な学習方法を取り上げます。関連知識の紹介 1. プレビュー用紙は整っていますか? A: まずアンケートを見てください。

1 つの記事で理解: AI、機械学習、ディープラーニングのつながりと違い

Mar 02, 2024 am 11:19 AM

1 つの記事で理解: AI、機械学習、ディープラーニングのつながりと違い

Mar 02, 2024 am 11:19 AM

今日の急速な技術変化の波の中で、人工知能 (AI)、機械学習 (ML)、および深層学習 (DL) は輝かしい星のようなもので、情報技術の新しい波をリードしています。これら 3 つの単語は、さまざまな最先端の議論や実践で頻繁に登場しますが、この分野に慣れていない多くの探検家にとって、その具体的な意味や内部のつながりはまだ謎に包まれているかもしれません。そこで、まずはこの写真を見てみましょう。ディープラーニング、機械学習、人工知能の間には密接な相関関係があり、進歩的な関係があることがわかります。ディープラーニングは機械学習の特定の分野であり、機械学習

DualBEV: BEVFormer および BEVDet4D を大幅に上回る、本を開いてください!

Mar 21, 2024 pm 05:21 PM

DualBEV: BEVFormer および BEVDet4D を大幅に上回る、本を開いてください!

Mar 21, 2024 pm 05:21 PM

この論文では、自動運転においてさまざまな視野角 (遠近法や鳥瞰図など) から物体を正確に検出するという問題、特に、特徴を遠近法 (PV) 空間から鳥瞰図 (BEV) 空間に効果的に変換する方法について検討します。 Visual Transformation (VT) モジュールを介して実装されます。既存の手法は、2D から 3D への変換と 3D から 2D への変換という 2 つの戦略に大別されます。 2D から 3D への手法は、深さの確率を予測することで高密度の 2D フィーチャを改善しますが、特に遠方の領域では、深さ予測に固有の不確実性により不正確さが生じる可能性があります。 3D から 2D への方法では通常、3D クエリを使用して 2D フィーチャをサンプリングし、Transformer を通じて 3D と 2D フィーチャ間の対応のアテンション ウェイトを学習します。これにより、計算時間と展開時間が増加します。

超強い!深層学習アルゴリズムのトップ 10!

Mar 15, 2024 pm 03:46 PM

超強い!深層学習アルゴリズムのトップ 10!

Mar 15, 2024 pm 03:46 PM

2006 年にディープ ラーニングの概念が提案されてから、ほぼ 20 年が経過しました。ディープ ラーニングは、人工知能分野における革命として、多くの影響力のあるアルゴリズムを生み出してきました。では、ディープラーニングのトップ 10 アルゴリズムは何だと思いますか?私の考えでは、ディープ ラーニングのトップ アルゴリズムは次のとおりで、いずれもイノベーション、アプリケーションの価値、影響力の点で重要な位置を占めています。 1. ディープ ニューラル ネットワーク (DNN) の背景: ディープ ニューラル ネットワーク (DNN) は、多層パーセプトロンとも呼ばれ、最も一般的なディープ ラーニング アルゴリズムです。最初に発明されたときは、コンピューティング能力のボトルネックのため疑問視されていました。最近まで長年にわたる計算能力、データの爆発的な増加によって画期的な進歩がもたらされました。 DNN は、複数の隠れ層を含むニューラル ネットワーク モデルです。このモデルでは、各層が入力を次の層に渡し、

CNN と Transformer のハイブリッド モデルを使用してパフォーマンスを向上させる方法

Jan 24, 2024 am 10:33 AM

CNN と Transformer のハイブリッド モデルを使用してパフォーマンスを向上させる方法

Jan 24, 2024 am 10:33 AM

畳み込みニューラル ネットワーク (CNN) と Transformer は、さまざまなタスクで優れたパフォーマンスを示した 2 つの異なる深層学習モデルです。 CNN は主に、画像分類、ターゲット検出、画像セグメンテーションなどのコンピューター ビジョン タスクに使用されます。畳み込み演算を通じて画像上の局所的な特徴を抽出し、プーリング演算を通じて特徴の次元削減と空間的不変性を実行します。対照的に、Transformer は主に、機械翻訳、テキスト分類、音声認識などの自然言語処理 (NLP) タスクに使用されます。セルフアテンション メカニズムを使用してシーケンス内の依存関係をモデル化し、従来のリカレント ニューラル ネットワークにおける逐次計算を回避します。これら 2 つのモデルは異なるタスクに使用されますが、シーケンス モデリングでは類似点があるため、

AlphaFold 3 が発売され、タンパク質とすべての生体分子の相互作用と構造をこれまでよりもはるかに高い精度で包括的に予測します。

Jul 16, 2024 am 12:08 AM

AlphaFold 3 が発売され、タンパク質とすべての生体分子の相互作用と構造をこれまでよりもはるかに高い精度で包括的に予測します。

Jul 16, 2024 am 12:08 AM

エディター | Radish Skin 2021 年の強力な AlphaFold2 のリリース以来、科学者はタンパク質構造予測モデルを使用して、細胞内のさまざまなタンパク質構造をマッピングし、薬剤を発見し、既知のあらゆるタンパク質相互作用の「宇宙地図」を描いてきました。ちょうど今、Google DeepMind が AlphaFold3 モデルをリリースしました。このモデルは、タンパク質、核酸、小分子、イオン、修飾残基を含む複合体の結合構造予測を実行できます。 AlphaFold3 の精度は、これまでの多くの専用ツール (タンパク質-リガンド相互作用、タンパク質-核酸相互作用、抗体-抗原予測) と比較して大幅に向上しました。これは、単一の統合された深層学習フレームワーク内で、次のことを達成できることを示しています。