テクノロジー周辺機器

テクノロジー周辺機器

AI

AI

ChatGPT の中国語版のトレーニングはそれほど難しくありません。A100 がなくても、オープンソースの Alpaca-LoRA+RTX 4090 を使用して行うことができます。

ChatGPT の中国語版のトレーニングはそれほど難しくありません。A100 がなくても、オープンソースの Alpaca-LoRA+RTX 4090 を使用して行うことができます。

ChatGPT の中国語版のトレーニングはそれほど難しくありません。A100 がなくても、オープンソースの Alpaca-LoRA+RTX 4090 を使用して行うことができます。

2023年、チャットボット分野に残るのは「OpenAIのChatGPT」と「その他」の2陣営のみとなりそうだ。

ChatGPT は強力ですが、OpenAI がそれをオープンソース化することはほぼ不可能です。 「その他」陣営のパフォーマンスは低かったが、しばらく前に Meta によってオープンソース化された LLaMA など、多くの人々がオープンソースに取り組んでいます。

LLaMA は、パラメータ数が 70 億から 650 億に及ぶ一連のモデルの総称です。その中でも、パラメータ数 130 億の LLaMA モデルは、パラメータを上回る性能を発揮します。ほとんどのベンチマークでは、1,750 億の量の GPT-3 が使用されます。ただし、命令チューニング(命令チューニング)を行っていないモデルのため、生成効果は悪いです。

モデルのパフォーマンスを向上させるために、スタンフォード大学の研究者が命令の微調整作業を完了するのを支援し、Alpaca と呼ばれる新しい 70 億パラメータ モデル (LLaMA 7B に基づく) をトレーニングしました。 。具体的には、OpenAI の text-davinci-003 モデルに、Alpaca のトレーニング データとして 52K の命令に従うサンプルを自己命令方式で生成するよう依頼しました。実験結果は、アルパカの多くの行動が text-davinci-003 と類似していることを示しています。言い換えれば、パラメータがわずか 7B の軽量モデル Alpaca のパフォーマンスは、GPT-3.5 などの非常に大規模な言語モデルのパフォーマンスに匹敵します。

一般の研究者にとって、これは実用的で安価な微調整方法ですが、それでも大量の計算が必要です (著者はこう述べています)彼らは 8 台の 80GB A100 で 3 時間かけて微調整しました)。さらに、Alpaca のシード タスクはすべて英語であり、収集されるデータも英語であるため、トレーニング済みモデルは中国語用に最適化されていません。

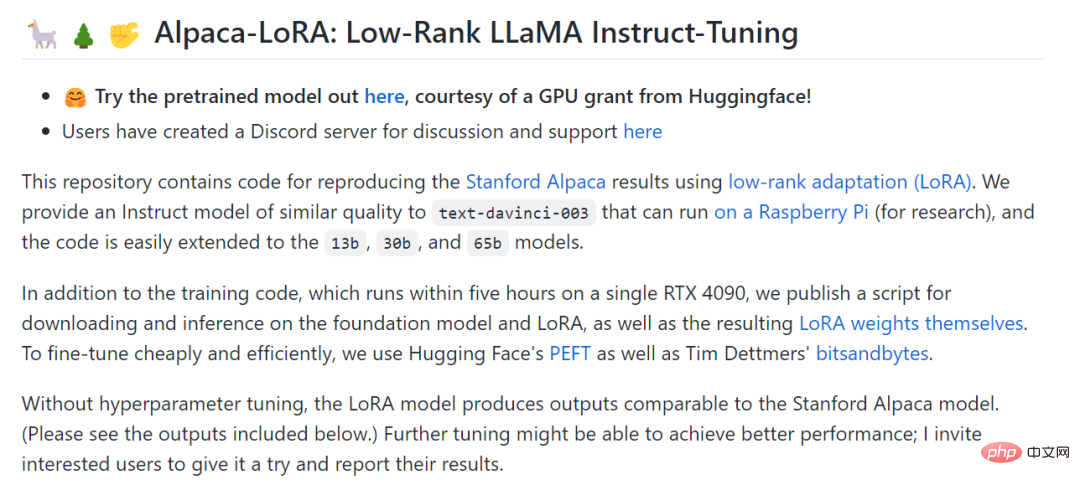

微調整のコストをさらに削減するために、スタンフォード大学の別の研究者である Eric J. Wang は、LoRA (低ランク適応) テクノロジーを使用して Alpaca の結果を再現しました。 。具体的には、Eric J. Wang 氏は RTX 4090 グラフィックス カードを使用して Alpaca と同等のモデルをわずか 5 時間でトレーニングし、そのようなモデルのコンピューティング能力要件を消費者レベルまで削減しました。さらに、モデルは Raspberry Pi 上で実行できます (研究用)。

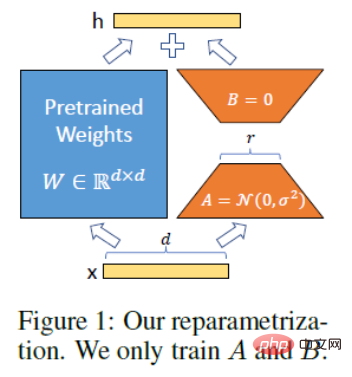

LoRA の技術原則。 LoRA のアイデアは、元の PLM の隣にバイパスを追加し、次元削減を実行してから次元操作を実行して、いわゆる固有ランクをシミュレートすることです。トレーニング中、PLM のパラメーターは固定され、次元削減行列 A と次元強化行列 B のみがトレーニングされます。モデルの入力次元と出力次元は変更されず、出力中に BA と PLM のパラメーターが重ね合わされます。 A をランダムなガウス分布で初期化し、B を 0 行列で初期化し、トレーニングの開始時にバイパス行列がまだ 0 行列であることを確認します (引用元: https://finisky.github.io/lora/)。 LoRA の最大の利点は、高速でメモリ使用量が少ないため、消費者グレードのハードウェアで実行できることです。

Eric J. Wang によって投稿された Alpaca-LoRA プロジェクト。

プロジェクトアドレス: https://github.com/tloen/alpaca-lora

自分自身を訓練したいクラス向けこれは、ChatGPT モデル (ChatGPT の中国語版を含む) を使用しているものの、トップレベルのコンピューティング リソースを持たない研究者にとって、間違いなく大きな驚きです。したがって、Alpaca-LoRA プロジェクトの出現後、プロジェクトに関連するチュートリアルとトレーニング結果が次々と作成されており、この記事ではそれらのいくつかを紹介します。

Alpaca-LoRA を使用して LLaMA を微調整する方法

Alpaca-LoRA プロジェクトで、著者は、微調整を安価かつ効率的に実行するために次のように述べました。 、彼らはHugging FaceのPEFTを使用しました。 PEFT は、さまざまな Transformer ベースの言語モデルを取得し、LoRA を使用してそれらを微調整できるライブラリ (LoRA はサポートされているテクノロジの 1 つ) です。利点は、小規模なハードウェアで、より小さな (おそらくコンポーザブルな) 出力で、モデルを安価かつ効率的に微調整できることです。

最近のブログで、数名の研究者が、Alpaca-LoRA を使用して LLaMA を微調整する方法を紹介しました。

Alpaca-LoRA を使用する前に、いくつかの前提条件を満たしている必要があります。 1 つ目は GPU の選択です。LoRA のおかげで、NVIDIA T4 や 4090 コンシューマ GPU などの低スペック GPU で微調整を完了できるようになりました。さらに、LLaMA の重みは公開されていないため、申請する必要もあります。

前提条件が満たされたので、次のステップは Alpaca-LoRA の使用方法です。まず、Alpaca-LoRA リポジトリのクローンを作成する必要があります。コードは次のとおりです。

git clone https://github.com/daanelson/alpaca-lora cd alpaca-lora

次に、LLaMA の重みを取得します。ダウンロードした重み値を unconverted-weights という名前のフォルダーに保存します。フォルダー階層は次のとおりです:

unconverted-weights ├── 7B │ ├── checklist.chk │ ├── consolidated.00.pth │ └── params.json ├── tokenizer.model └── tokenizer_checklist.chk

重みが保存されたら、次のコマンドを使用して PyTorch に重みを追加します。チェックポイントはトランスフォーマーと互換性のある形式に変換されます:

cog run python -m transformers.models.llama.convert_llama_weights_to_hf --input_dir unconverted-weights --model_size 7B --output_dir weights

最終的なディレクトリ構造は次のようになります:

weights ├── llama-7b └── tokenizermdki

上記を処理しますステップ 3: Cog のインストール:

sudo curl -o /usr/local/bin/cog -L "https://github.com/replicate/cog/releases/latest/download/cog_$(uname -s)_$(uname -m)" sudo chmod +x /usr/local/bin/cog

4 番目のステップは、モデルを微調整することです。デフォルトでは、微調整スクリプトで構成された GPU は弱いですが、 GPU のパフォーマンスを向上させるには、finetune.py で MICRO_BATCH_SIZE を 32 または 64 に増やすことができます。さらに、データセットを調整するディレクティブがある場合は、finetune.py の DATA_PATH を編集して独自のデータセットを指すようにできます。この操作では、データ形式が alpaca_data_cleaned.json と同じであることが保証される必要があることに注意してください。次に、微調整スクリプトを実行します。

cog run python finetune.py

微調整プロセスには、40GB A100 GPU では 3.5 時間かかり、性能の低い GPU ではさらに時間がかかりました。

最後のステップは、Cog を使用してモデルを実行することです:

$ cog predict -i prompt="Tell me something about alpacas." Alpacas are domesticated animals from South America. They are closely related to llamas and guanacos and have a long, dense, woolly fleece that is used to make textiles. They are herd animals and live in small groups in the Andes mountains. They have a wide variety of sounds, including whistles, snorts, and barks. They are intelligent and social animals and can be trained to perform certain tasks.

チュートリアルの作成者は、上記のステップを完了すると、

- 独自のデータ セットを持ち込み、独自の LoRA を微調整する (LLaMA を微調整するなど)アニメのキャラクターのように話す。参照: https://replicate.com/blog/fine-tune-llama-to-speak-like-homer-simpson

- モデルをクラウド プラットフォームにデプロイします;

- Stable Diffusion LoRA などの他の LoRA と組み合わせて画像フィールドに適用します。

- Alpaca データ セット (または他のデータ セットを使用します) ) 更新された大規模な LLaMA モデルを微調整し、そのパフォーマンスを確認します。これは PEFT と LoRA を使用すれば可能ですが、より大きな GPU が必要になります。

Alpaca-LoRA 派生プロジェクト

Alpaca のパフォーマンスは GPT 3.5 に匹敵しますが、シード タスクはすべて英語であり、収集されたデータも英語です。英語なので、トレーニング済みモデルは中国語に適していません。中国語での対話モデルの有効性を高めるために、より優れたプロジェクトをいくつか見てみましょう。

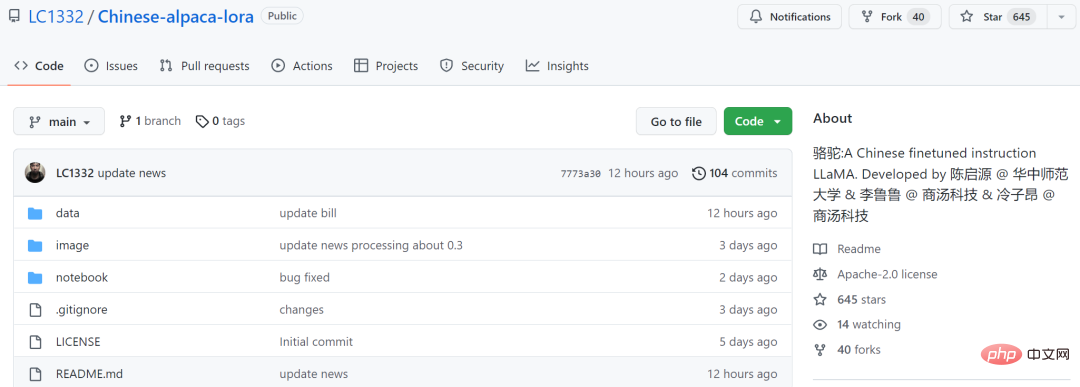

1 つ目は、華中師範大学およびその他の機関の 3 人の個人開発者によるオープンソースの中国語モデル Luotuo (Luotuo) です。このプロジェクトは、LLaMA、Stanford Alpaca、Alpaca LoRA に基づいています。 , ニホンアルパカ - LoRAが完了すると、カード1枚で訓練展開が完了できる。興味深いことに、LLaMA (ラマ) とアルパカ (アルパカ) の両方が偶蹄目 - ラクダ科に属しているため、彼らはモデルをラクダと名付けました。そういう意味でもこの名前は期待できます。

このモデルは、Meta のオープンソース LLaMA に基づいており、Alpaca と Alpaca-LoRA の 2 つのプロジェクトを参照して中国語でトレーニングされました。

# プロジェクトアドレス: https://github.com/LC1332/ Chinese-alpaca-lora

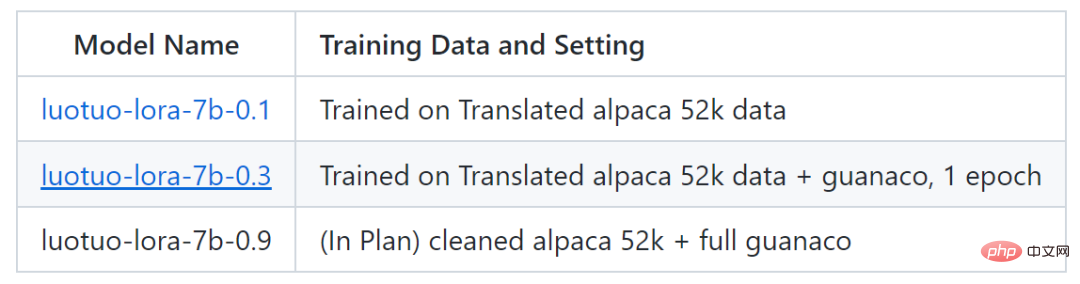

# #現在、このプロジェクトは luotuo-lora-7b-0.1 と luotuo-lora-7b-0.3 の 2 つのモデルをリリースしており、別のモデルも計画されています:

##以下は効果表示です:

##以下は効果表示です:

#ただし luotuo-lora-7b-0.1 (0.1) 、luotuo-lora-7b-0.3 (0.3) にはまだギャップがあります。ユーザーが華中師範大学の住所を尋ねたとき、0.1 は間違って答えました:

単純な会話だけでなく、保険関連の分野でモデルの最適化を行った人もいます。この Twitter ユーザーによると、Alpaca-LoRA プロジェクトの助けを借りて、中国の保険の質問と回答のデータを入力したところ、最終的な結果は良好でした。

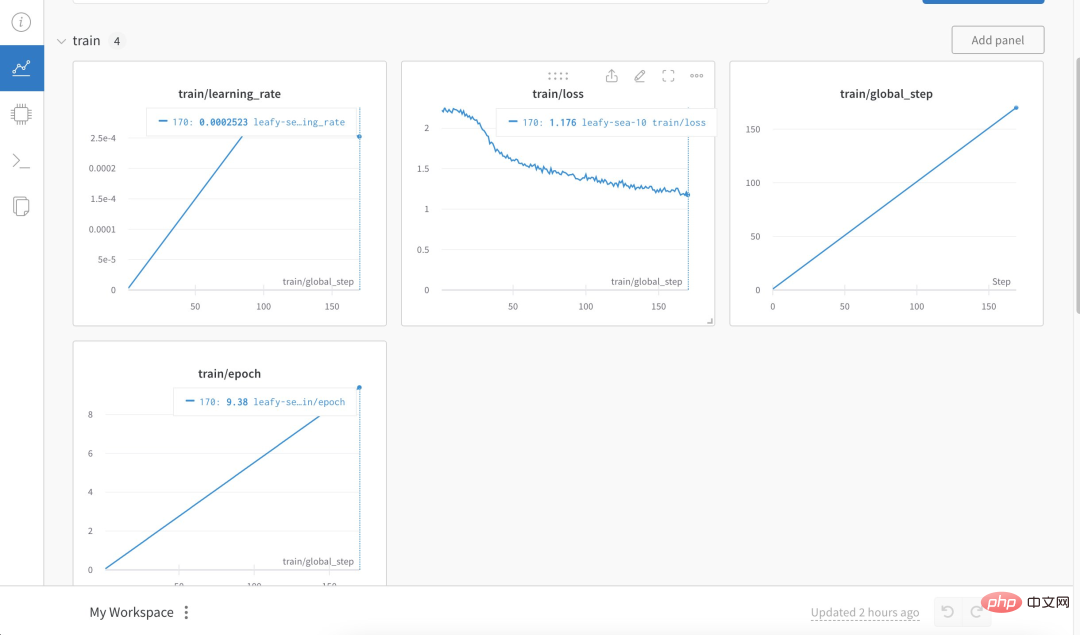

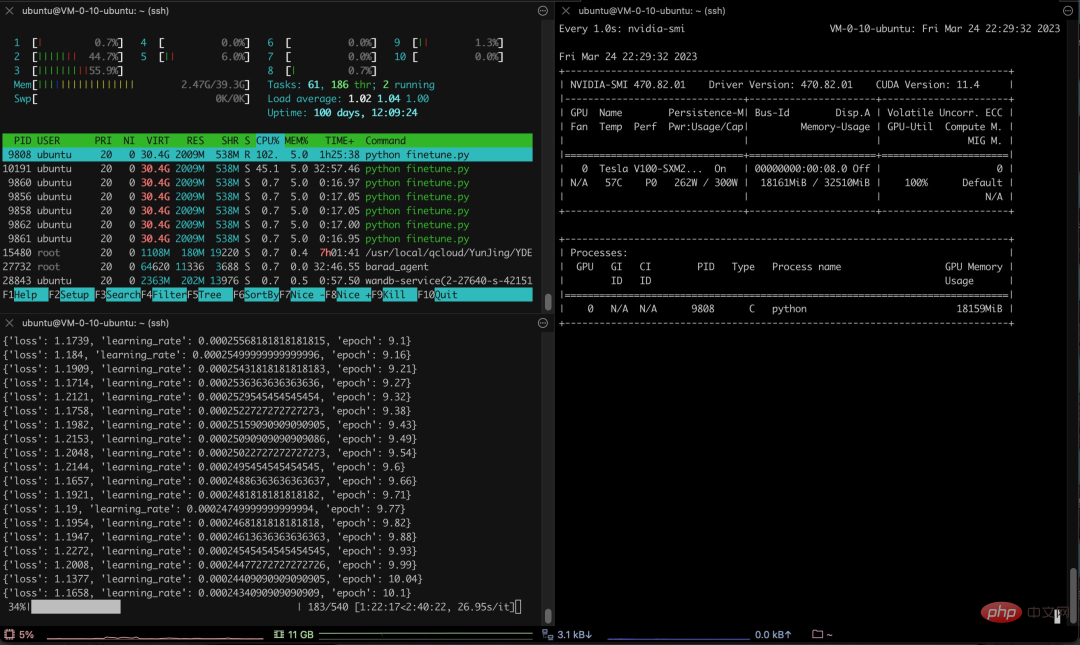

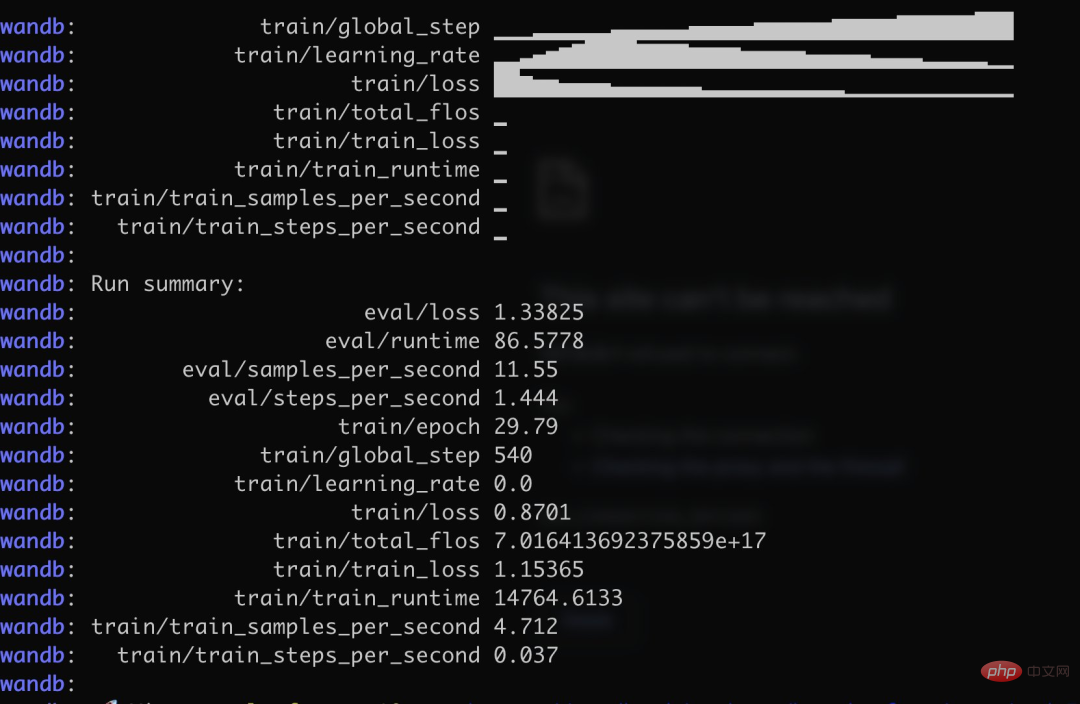

具体的には、著者は 3,000 を超える中国語の質問と回答の保険コーパスを使用して、Alpaca LoRa の中国語版をトレーニングしました。実装プロセスでは LoRa メソッドを使用し、Alpaca 7B モデルを微調整しました。 、所要時間は 240 分、最終損失は 0.87 でした。 ####################################################################### 以下はトレーニングのプロセスと結果です:

# #テスト結果は次のことを示しています。 1. トレーニング コーパスに関連するコンテンツは、おおよそ合理的な応答を返すことができますが、それがナンセンスでない場合に限ります。 2. コーパスに関連しないコンテンツは、特定のコーパス内のデータに対して強制的に応答します。 3. 論理的推論と数学的計算にはこの機能がありません。

この結果を見たネチズンは、職を失うと叫びました。

最後に、さらに多くの中国語対話モデルが追加されることを楽しみにしています。

以上がChatGPT の中国語版のトレーニングはそれほど難しくありません。A100 がなくても、オープンソースの Alpaca-LoRA+RTX 4090 を使用して行うことができます。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7503

7503

15

15

1377

1377

52

52

78

78

11

11

19

19

54

54

世界で最も強力なオープンソース MoE モデルが登場。GPT-4 に匹敵する中国語機能を備え、価格は GPT-4-Turbo のわずか 1% 近くです

May 07, 2024 pm 04:13 PM

世界で最も強力なオープンソース MoE モデルが登場。GPT-4 に匹敵する中国語機能を備え、価格は GPT-4-Turbo のわずか 1% 近くです

May 07, 2024 pm 04:13 PM

従来のコンピューティングを超える能力を備えているだけでなく、より低コストでより効率的なパフォーマンスを実現する人工知能モデルを想像してみてください。これは SF ではありません。世界で最も強力なオープンソース MoE モデルである DeepSeek-V2[1] が登場しました。 DeepSeek-V2 は、経済的なトレーニングと効率的な推論の特徴を備えた強力な専門家混合 (MoE) 言語モデルです。これは 236B のパラメータで構成されており、そのうち 21B は各マーカーをアクティブにするために使用されます。 DeepSeek67B と比較して、DeepSeek-V2 はパフォーマンスが優れていると同時に、トレーニング コストを 42.5% 節約し、KV キャッシュを 93.3% 削減し、最大生成スループットを 5.76 倍に高めます。 DeepSeek は一般的な人工知能を研究する会社です

AI が数学研究を破壊する!フィールズ賞受賞者で中国系アメリカ人の数学者が上位 11 件の論文を主導 | テレンス・タオが「いいね!」しました

Apr 09, 2024 am 11:52 AM

AI が数学研究を破壊する!フィールズ賞受賞者で中国系アメリカ人の数学者が上位 11 件の論文を主導 | テレンス・タオが「いいね!」しました

Apr 09, 2024 am 11:52 AM

AI は確かに数学を変えつつあります。最近、この問題に細心の注意を払っている陶哲軒氏が『米国数学協会会報』(米国数学協会会報)の最新号を送ってくれた。 「機械は数学を変えるのか?」というテーマを中心に、多くの数学者が意見を述べ、そのプロセス全体は火花に満ち、ハードコアで刺激的でした。著者には、フィールズ賞受賞者のアクシャイ・ベンカテシュ氏、中国の数学者鄭楽軍氏、ニューヨーク大学のコンピューター科学者アーネスト・デイビス氏、その他業界で著名な学者を含む強力な顔ぶれが揃っている。 AI の世界は劇的に変化しています。これらの記事の多くは 1 年前に投稿されたものです。

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas は正式に電動ロボットの時代に突入します!昨日、油圧式アトラスが歴史の舞台から「涙ながらに」撤退したばかりですが、今日、ボストン・ダイナミクスは電動式アトラスが稼働することを発表しました。ボストン・ダイナミクス社は商用人型ロボットの分野でテスラ社と競争する決意を持っているようだ。新しいビデオが公開されてから、わずか 10 時間ですでに 100 万人以上が視聴しました。古い人が去り、新しい役割が現れるのは歴史的な必然です。今年が人型ロボットの爆発的な年であることは間違いありません。ネットユーザーは「ロボットの進歩により、今年の開会式は人間のように見え、人間よりもはるかに自由度が高い。しかし、これは本当にホラー映画ではないのか?」とコメントした。ビデオの冒頭では、アトラスは仰向けに見えるように地面に静かに横たわっています。次に続くのは驚くべきことです

MLP に代わる KAN は、オープンソース プロジェクトによって畳み込みまで拡張されました

Jun 01, 2024 pm 10:03 PM

MLP に代わる KAN は、オープンソース プロジェクトによって畳み込みまで拡張されました

Jun 01, 2024 pm 10:03 PM

今月初め、MIT やその他の機関の研究者らは、MLP に代わる非常に有望な代替案である KAN を提案しました。 KAN は、精度と解釈可能性の点で MLP よりも優れています。また、非常に少数のパラメーターを使用して、多数のパラメーターを使用して実行する MLP よりも優れたパフォーマンスを発揮できます。たとえば、著者らは、KAN を使用して、より小規模なネットワークと高度な自動化で DeepMind の結果を再現したと述べています。具体的には、DeepMind の MLP には約 300,000 個のパラメーターがありますが、KAN には約 200 個のパラメーターしかありません。 KAN は、MLP が普遍近似定理に基づいているのに対し、KAN はコルモゴロフ-アーノルド表現定理に基づいているのと同様に、強力な数学的基礎を持っています。以下の図に示すように、KAN は

Google は大喜び: JAX のパフォーマンスが Pytorch や TensorFlow を上回りました! GPU 推論トレーニングの最速の選択肢となる可能性があります

Apr 01, 2024 pm 07:46 PM

Google は大喜び: JAX のパフォーマンスが Pytorch や TensorFlow を上回りました! GPU 推論トレーニングの最速の選択肢となる可能性があります

Apr 01, 2024 pm 07:46 PM

Google が推進する JAX のパフォーマンスは、最近のベンチマーク テストで Pytorch や TensorFlow のパフォーマンスを上回り、7 つの指標で 1 位にランクされました。また、テストは最高の JAX パフォーマンスを備えた TPU では行われませんでした。ただし、開発者の間では、依然として Tensorflow よりも Pytorch の方が人気があります。しかし、将来的には、おそらくより大規模なモデルが JAX プラットフォームに基づいてトレーニングされ、実行されるようになるでしょう。モデル 最近、Keras チームは、ネイティブ PyTorch 実装を使用して 3 つのバックエンド (TensorFlow、JAX、PyTorch) をベンチマークし、TensorFlow を使用して Keras2 をベンチマークしました。まず、主流のセットを選択します

FisheyeDetNet: 魚眼カメラに基づいた最初のターゲット検出アルゴリズム

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: 魚眼カメラに基づいた最初のターゲット検出アルゴリズム

Apr 26, 2024 am 11:37 AM

目標検出は自動運転システムにおいて比較的成熟した問題であり、その中でも歩行者検出は最も初期に導入されたアルゴリズムの 1 つです。ほとんどの論文では非常に包括的な研究が行われています。ただし、サラウンドビューに魚眼カメラを使用した距離認識については、あまり研究されていません。放射状の歪みが大きいため、標準のバウンディング ボックス表現を魚眼カメラに実装するのは困難です。上記の説明を軽減するために、拡張バウンディング ボックス、楕円、および一般的な多角形の設計を極/角度表現に探索し、これらの表現を分析するためのインスタンス セグメンテーション mIOU メトリックを定義します。提案された多角形モデルの FisheyeDetNet は、他のモデルよりも優れたパフォーマンスを示し、同時に自動運転用の Valeo 魚眼カメラ データセットで 49.5% の mAP を達成しました。

テスラのロボットは工場で働く、マスク氏:手の自由度は今年22に達する!

May 06, 2024 pm 04:13 PM

テスラのロボットは工場で働く、マスク氏:手の自由度は今年22に達する!

May 06, 2024 pm 04:13 PM

テスラのロボット「オプティマス」の最新映像が公開され、すでに工場内で稼働可能となっている。通常の速度では、バッテリー(テスラの4680バッテリー)を次のように分類します:公式は、20倍の速度でどのように見えるかも公開しました - 小さな「ワークステーション」上で、ピッキング、ピッキング、ピッキング:今回は、それがリリースされたハイライトの1つビデオの内容は、オプティマスが工場内でこの作業を完全に自律的に行い、プロセス全体を通じて人間の介入なしに完了するというものです。そして、オプティマスの観点から見ると、自動エラー修正に重点を置いて、曲がったバッテリーを拾い上げたり配置したりすることもできます。オプティマスのハンドについては、NVIDIA の科学者ジム ファン氏が高く評価しました。オプティマスのハンドは、世界の 5 本指ロボットの 1 つです。最も器用。その手は触覚だけではありません

DualBEV: BEVFormer および BEVDet4D を大幅に上回る、本を開いてください!

Mar 21, 2024 pm 05:21 PM

DualBEV: BEVFormer および BEVDet4D を大幅に上回る、本を開いてください!

Mar 21, 2024 pm 05:21 PM

この論文では、自動運転においてさまざまな視野角 (遠近法や鳥瞰図など) から物体を正確に検出するという問題、特に、特徴を遠近法 (PV) 空間から鳥瞰図 (BEV) 空間に効果的に変換する方法について検討します。 Visual Transformation (VT) モジュールを介して実装されます。既存の手法は、2D から 3D への変換と 3D から 2D への変換という 2 つの戦略に大別されます。 2D から 3D への手法は、深さの確率を予測することで高密度の 2D フィーチャを改善しますが、特に遠方の領域では、深さ予測に固有の不確実性により不正確さが生じる可能性があります。 3D から 2D への方法では通常、3D クエリを使用して 2D フィーチャをサンプリングし、Transformer を通じて 3D と 2D フィーチャ間の対応のアテンション ウェイトを学習します。これにより、計算時間と展開時間が増加します。