データ サイエンスに非常に役立つ 9 つの Python ライブラリ

この記事では、panda、scikit-learn、matplotlib などのより一般的なライブラリではなく、データ サイエンス タスク用の Python ライブラリをいくつか見ていきます。 panda や scikit-learn などのライブラリは機械学習タスクでよく使用されますが、この分野の他の Python 製品を理解することは常に有益です。

1. Wget

インターネットからデータを抽出することは、データ サイエンティストの重要なタスクの 1 つです。 Wget は、インターネットから非対話型ファイルをダウンロードするために使用できる無料のユーティリティです。 HTTP、HTTPS、および FTP プロトコルに加えて、HTTP のプロキシを介したファイルの取得もサポートしています。非対話型であるため、ユーザーがログインしていなくてもバックグラウンドで動作できます。したがって、次回 Web サイトまたはページ上のすべての画像をダウンロードしたい場合は、wget が役に立ちます。

インストール:

$ pip install wget

例:

import wget url = 'http://www.futurecrew.com/skaven/song_files/mp3/razorback.mp3' filename = wget.download(url) 100% [................................................] 3841532 / 3841532 filename 'razorback.mp3'

2. Pendulum

Python で日付と時刻を扱うときにイライラする人には、Pendulum が最適です。あなた。これは日時操作を簡素化する Python パッケージです。これは、Python のネイティブ クラスの単純な置き換えです。より深い学習についてはドキュメントを参照してください。

インストール:

$ pip install pendulum

例:

import pendulum dt_toronto = pendulum.datetime(2012, 1, 1, tz='America/Toronto') dt_vancouver = pendulum.datetime(2012, 1, 1, tz='America/Vancouver') print(dt_vancouver.diff(dt_toronto).in_hours()) 3

3. 不均衡学習

各クラスのサンプル数が基本的に同様に、ほとんどの分類アルゴリズムは、データのバランスをとる必要がある場合に最適に機能します。ただし、実際のケースのほとんどは不均衡なデータセットであり、機械学習アルゴリズムの学習フェーズとその後の予測に大きな影響を与えます。幸いなことに、このライブラリはこの問題を解決するように設計されています。これは scikit-learn と互換性があり、scikit-lear-contrib プロジェクトの一部です。次回不均衡なデータセットに遭遇したときにこれを使用してみてください。

インストール:

$ pip install -U imbalanced-learn # 或者 $ conda install -c conda-forge imbalanced-learn

例:

使用方法と使用例についてはドキュメントを参照してください。

4. FlashText

NLP タスクでは、テキスト データのクリーニングでは、多くの場合、文内のキーワードを置き換えたり、文からキーワードを抽出したりする必要があります。通常、これは正規表現を使用して実行できますが、検索される用語の数が数千に達する場合、これは面倒になる可能性があります。 Python の FlashText モジュールは FlashText アルゴリズムに基づいており、この状況に適した代替手段を提供します。 FlashText の優れた点は、検索語の数に関係なく実行時間が同じであることです。詳細については、こちらをご覧ください。

インストール:

$ pip install flashtext

例:

キーワードの抽出

from flashtext import KeywordProcessor

keyword_processor = KeywordProcessor()

# keyword_processor.add_keyword(<unclean name>, <standardised name>)

keyword_processor.add_keyword('Big Apple', 'New York')

keyword_processor.add_keyword('Bay Area')

keywords_found = keyword_processor.extract_keywords('I love Big Apple and Bay Area.')

keywords_found

['New York', 'Bay Area']キーワードの置換

keyword_processor.add_keyword('New Delhi', 'NCR region')

new_sentence = keyword_processor.replace_keywords('I love Big Apple and new delhi.')

new_sentence

'I love New York and NCR region.'

Fuzzywuzzy5. fuzzywuzzy

#このライブラリの名前は奇妙に聞こえますが、fuzzywuzzy は文字列マッチングに関して非常に便利なライブラリです。文字列一致度やトークン一致度の計算などの操作が簡単に実装でき、異なるデータベースに格納されているレコードの照合も簡単に行えます。 インストール:$ pip install fuzzywuzzy

from fuzzywuzzy import fuzz

from fuzzywuzzy import process

# 简单匹配度

fuzz.ratio("this is a test", "this is a test!")

97

# 模糊匹配度

fuzz.partial_ratio("this is a test", "this is a test!")

100pip install pyflux

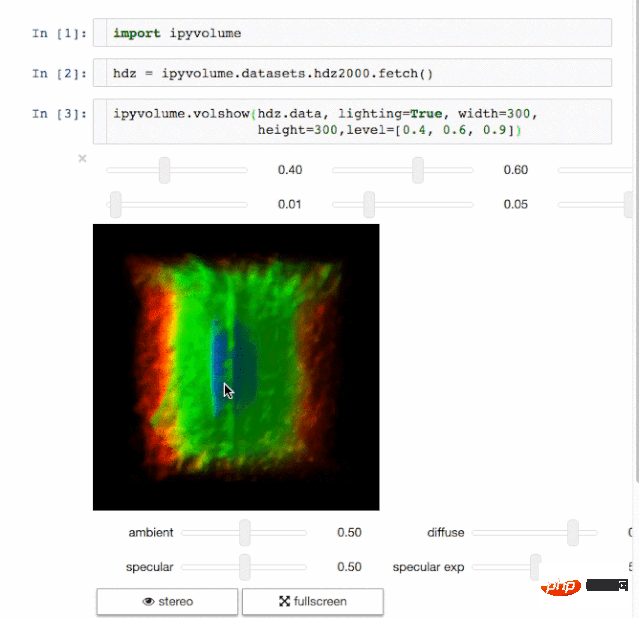

$ pip install ipyvolume

$ conda install -c conda-forge ipyvolume

pip install dash==0.29.0# 核心 dash 后端 pip install dash-html-components==0.13.2# HTML 组件 pip install dash-core-components==0.36.0# 增强组件 pip install dash-table==3.1.3# 交互式 DataTable 组件(最新!)

九、Gym

OpenAI 的 Gym 是一款用于增强学习算法的开发和比较工具包。它兼容任何数值计算库,如 TensorFlow 或 Theano。Gym 库是测试问题集合的必备工具,这个集合也称为环境 —— 你可以用它来开发你的强化学习算法。这些环境有一个共享接口,允许你进行通用算法的编写。

安装

pip install gym

例子这个例子会运行CartPole-v0环境中的一个实例,它的时间步数为 1000,每一步都会渲染整个场景。

总结

以上这些有用的数据科学 Python 库都是我精心挑选出来的,不是常见的如 numpy 和 pandas 等库。如果你知道其它库,可以添加到列表中来,请在下面的评论中提一下。另外别忘了先尝试运行一下它们。

以上がデータ サイエンスに非常に役立つ 9 つの Python ライブラリの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7552

7552

15

15

1382

1382

52

52

83

83

11

11

22

22

95

95

HTML:それはプログラミング言語か何か他のものですか?

Apr 15, 2025 am 12:13 AM

HTML:それはプログラミング言語か何か他のものですか?

Apr 15, 2025 am 12:13 AM

htmlisnotaprogramminglanguage; itisamarkuplanguage.1)htmlStructuresandformatswebcontentusingtags.2)ItworkswithcsssssssssdjavascriptforInteractivity、強化を促進します。

PHPおよびPython:コードの例と比較

Apr 15, 2025 am 12:07 AM

PHPおよびPython:コードの例と比較

Apr 15, 2025 am 12:07 AM

PHPとPythonには独自の利点と短所があり、選択はプロジェクトのニーズと個人的な好みに依存します。 1.PHPは、大規模なWebアプリケーションの迅速な開発とメンテナンスに適しています。 2。Pythonは、データサイエンスと機械学習の分野を支配しています。

CentosのPytorchのGPUサポートはどのようにサポートされていますか

Apr 14, 2025 pm 06:48 PM

CentosのPytorchのGPUサポートはどのようにサポートされていますか

Apr 14, 2025 pm 06:48 PM

Pytorch GPUアクセラレーションを有効にすることで、CentOSシステムでは、PytorchのCUDA、CUDNN、およびGPUバージョンのインストールが必要です。次の手順では、プロセスをガイドします。CUDAおよびCUDNNのインストールでは、CUDAバージョンの互換性が決定されます。NVIDIA-SMIコマンドを使用して、NVIDIAグラフィックスカードでサポートされているCUDAバージョンを表示します。たとえば、MX450グラフィックカードはCUDA11.1以上をサポートする場合があります。 cudatoolkitのダウンロードとインストール:nvidiacudatoolkitの公式Webサイトにアクセスし、グラフィックカードでサポートされている最高のCUDAバージョンに従って、対応するバージョンをダウンロードしてインストールします。 cudnnライブラリをインストールする:

Python vs. JavaScript:コミュニティ、ライブラリ、リソース

Apr 15, 2025 am 12:16 AM

Python vs. JavaScript:コミュニティ、ライブラリ、リソース

Apr 15, 2025 am 12:16 AM

PythonとJavaScriptには、コミュニティ、ライブラリ、リソースの観点から、独自の利点と短所があります。 1)Pythonコミュニティはフレンドリーで初心者に適していますが、フロントエンドの開発リソースはJavaScriptほど豊富ではありません。 2)Pythonはデータサイエンスおよび機械学習ライブラリで強力ですが、JavaScriptはフロントエンド開発ライブラリとフレームワークで優れています。 3)どちらも豊富な学習リソースを持っていますが、Pythonは公式文書から始めるのに適していますが、JavaScriptはMDNWebDocsにより優れています。選択は、プロジェクトのニーズと個人的な関心に基づいている必要があります。

Dockerの原則の詳細な説明

Apr 14, 2025 pm 11:57 PM

Dockerの原則の詳細な説明

Apr 14, 2025 pm 11:57 PM

DockerはLinuxカーネル機能を使用して、効率的で孤立したアプリケーションランニング環境を提供します。その作業原則は次のとおりです。1。ミラーは、アプリケーションを実行するために必要なすべてを含む読み取り専用テンプレートとして使用されます。 2。ユニオンファイルシステム(UnionFS)は、違いを保存するだけで、スペースを節約し、高速化する複数のファイルシステムをスタックします。 3.デーモンはミラーとコンテナを管理し、クライアントはそれらをインタラクションに使用します。 4。名前空間とcgroupsは、コンテナの分離とリソースの制限を実装します。 5.複数のネットワークモードは、コンテナの相互接続をサポートします。これらのコア概念を理解することによってのみ、Dockerをよりよく利用できます。

PHP:サーバー側のスクリプト言語の紹介

Apr 16, 2025 am 12:18 AM

PHP:サーバー側のスクリプト言語の紹介

Apr 16, 2025 am 12:18 AM

PHPは、動的なWeb開発およびサーバー側のアプリケーションに使用されるサーバー側のスクリプト言語です。 1.PHPは、編集を必要とせず、迅速な発展に適した解釈言語です。 2。PHPコードはHTMLに組み込まれているため、Webページの開発が簡単になりました。 3。PHPプロセスサーバー側のロジック、HTML出力を生成し、ユーザーの相互作用とデータ処理をサポートします。 4。PHPは、データベースと対話し、プロセスフォームの送信、サーバー側のタスクを実行できます。

CentosでPytorchの分散トレーニングを操作する方法

Apr 14, 2025 pm 06:36 PM

CentosでPytorchの分散トレーニングを操作する方法

Apr 14, 2025 pm 06:36 PM

Pytorchの分散トレーニングでは、Centosシステムでトレーニングには次の手順が必要です。Pytorchのインストール:PythonとPipがCentosシステムにインストールされていることです。 CUDAバージョンに応じて、Pytorchの公式Webサイトから適切なインストールコマンドを入手してください。 CPUのみのトレーニングには、次のコマンドを使用できます。PipinstalltorchtorchtorchvisionTorchaudioGPUサポートが必要な場合は、CUDAとCUDNNの対応するバージョンがインストールされ、インストールに対応するPytorchバージョンを使用してください。分散環境構成:分散トレーニングには、通常、複数のマシンまたは単一マシンの複数GPUが必要です。場所

CentosでPytorchバージョンを選択する方法

Apr 14, 2025 pm 06:51 PM

CentosでPytorchバージョンを選択する方法

Apr 14, 2025 pm 06:51 PM

PytorchをCentosシステムにインストールする場合、適切なバージョンを慎重に選択し、次の重要な要因を検討する必要があります。1。システム環境互換性:オペレーティングシステム:Centos7以上を使用することをお勧めします。 Cuda and Cudnn:PytorchバージョンとCudaバージョンは密接に関連しています。たとえば、pytorch1.9.0にはcuda11.1が必要ですが、pytorch2.0.1にはcuda11.3が必要です。 CUDNNバージョンは、CUDAバージョンとも一致する必要があります。 Pytorchバージョンを選択する前に、互換性のあるCUDAおよびCUDNNバージョンがインストールされていることを確認してください。 Pythonバージョン:Pytorch公式支店