200億パラメータの大規模モデルの単一マシントレーニング: Cerebrasが新記録を樹立

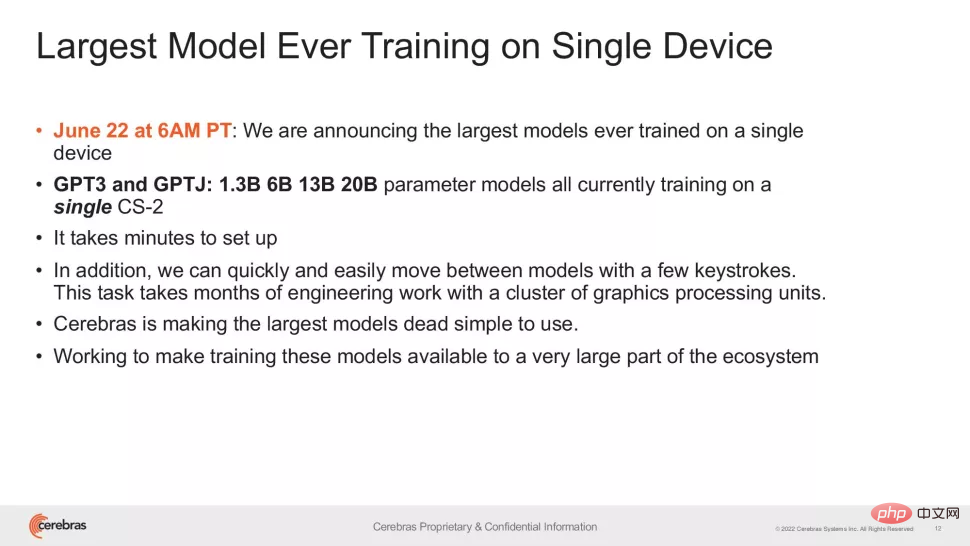

今週、チップスタートアップの Cerebras は、単一のコンピューティング デバイスで 100 億を超えるパラメーターを使用して NLP (自然言語処理) 人工知能モデルをトレーニングするという新たなマイルストーンを発表しました。

Cerebras によってトレーニングされた AI モデルの量は、前例のない 200 億パラメータに達しており、すべて複数のアクセラレータにわたってワークロードを拡張する必要はありません。この成果は、インターネット上で最も人気のあるテキストから画像への AI 生成モデル、OpenAI の 120 億パラメータの大規模モデル DALL-E を満たすのに十分です。

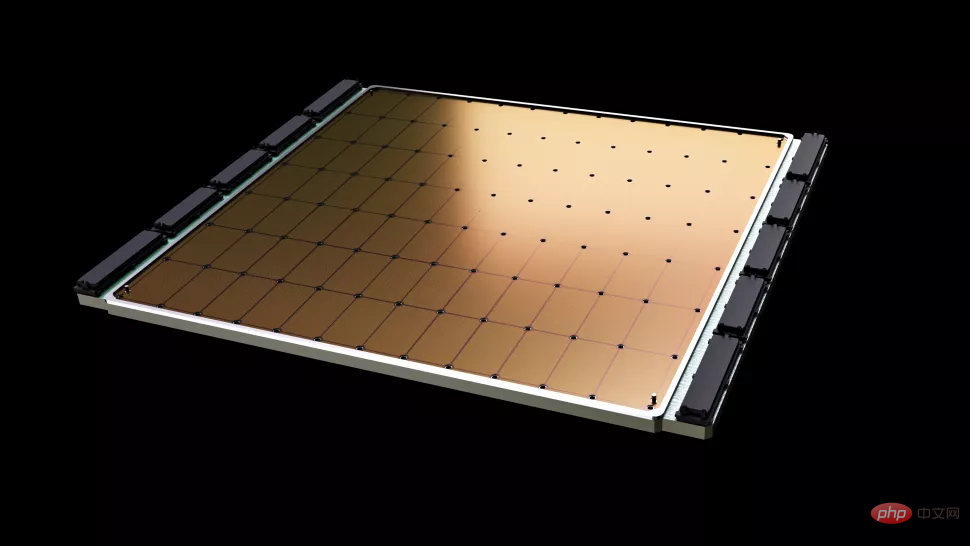

#Cerebras の新しい仕事で最も重要なことは、インフラストラクチャとソフトウェアの複雑さの要件が軽減されることです。この会社が提供するチップ、Wafer Scale Engine-2 (WSE2) は、その名前が示すように、TSMC の 7 nm プロセスの単一のウエハ全体にエッチングされており、その領域は通常、数百の主流チップを収容するのに十分な大きさです。 2.6兆個のトランジスタ、85万個のAIコンピューティングコアと40GBの統合キャッシュを搭載し、パッケージング後の消費電力は15kWにもなります。

Wafer Scale Engine-2 は、ウエハーのサイズに近く、iPad よりも大きいです。

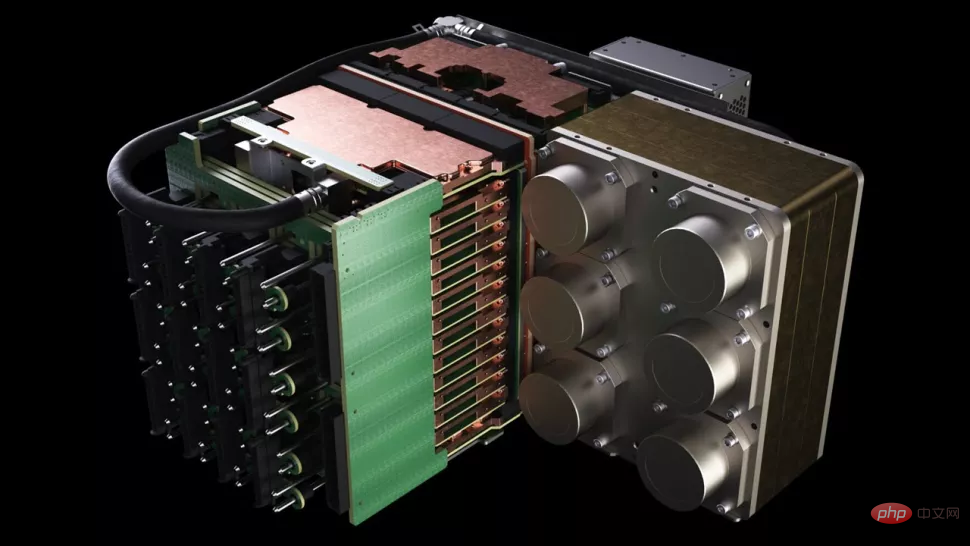

Cerebras の 1 台のマシンは、サイズの点ではすでにスーパーコンピューターに似ていますが、1 つのチップに最大 200 億のパラメータを保持する NLP モデルは依然として大幅に優れています。数千の GPU でのトレーニングのコストと、それに関連するハードウェアとスケーリングの要件を削減し、同時にモデルを分割するという技術的な困難を排除します。後者は「NLP ワークロードの最も苦痛な側面の 1 つ」であり、場合によっては「完了するまでに数か月かかる」とセレブラス氏は述べています。

これは、処理される各ニューラル ネットワークだけでなく、各 GPU とそれらを結び付けるネットワークの仕様にも固有のカスタマイズされた問題です。これらの要素を設定する必要があります。最初のトレーニング セッションの前に事前に作成されており、システム間で移植することはできません。

# Cerebras の CS-2 は、Wafer Scale Engine-2 チップを含むスタンドアロンのスーパーコンピューティング クラスターです。電源、メモリ、ストレージのサブシステム。

#200 億のパラメータのおおよそのレベルはどれくらいですか?人工知能の分野では、大規模な事前学習モデルは、最近さまざまなテクノロジー企業や機関が開発に力を入れている方向性であり、OpenAI の GPT-3 は、記事全体を書くことができ、十分な作業を実行できる NLP モデルです。人間の読者を欺く 1,750 億という驚異的なパラメーターを使用した数学的演算と変換。昨年末に発売された DeepMind の Gopher は、パラメータ数の記録的な数を 2,800 億に引き上げました。

最近、Google Brain は、Switch Transformer という 1 兆を超えるパラメータを使用してモデルをトレーニングしたとさえ発表しました。

「NLP の分野では、大規模なモデルの方がパフォーマンスが良いことが証明されています。しかし、伝統的に、これらの大規模なモデルの分解を完了するためのリソースと専門知識を持っている企業はわずか数社だけです。モデル、それを何百、何千ものグラフィックス処理装置に分散させるという大変な作業が必要です」とセレブラス社のCEO兼共同創設者であるアンドリュー・フェルドマン氏は語った。 「その結果、大規模な NLP モデルをトレーニングできる企業はほとんどありません。費用も時間もかかり、他の業界では利用できません。」

現在、Cerebras のアプローチは、 GPT-3XL 1.3B、GPT-J 6B、GPT-3 13B、GPT-NeoX 20B モデルのアプリケーションのしきい値を下げることで、AI エコシステム全体が数分で大規模なモデルを構築し、単一の CS-2 システムでトレーニングできるようになります。

#ただし、フラッグシップ CPU のクロック速度と同様、パラメーターの数は 1 つの要素にすぎません。大規模モデルのパフォーマンスにおける指標。最近では、DeepMindが今年4月に提案したChinchillaが、従来のわずか700億個のパラメータでGPT-3やGopherを上回ったなど、パラメータを削減しながらより良い結果を達成した研究もある。

この種の研究の目標は、もちろん、より賢く働くことであり、懸命に働くことではありません。したがって、Cerebras の成果は、人々が最初に目にするものよりも重要です。この研究は、チップ製造の現在のレベルがますます複雑になるモデルに適応できるという自信を与えてくれます。また、同社は、特殊なチップをコアとして持つシステムがサポートされていると述べています。」数千億、さらには数兆のパラメータを持つモデル。

単一チップ上でトレーニング可能なパラメータの数が爆発的に増加しているのは、Cerebras のウェイト ストリーミング テクノロジーに依存しています。このテクノロジーは、計算とメモリのフットプリントを分離し、AI ワークロードで急速に増加するパラメータの数に基づいてメモリを任意のスケールで拡張できるようにします。これにより、セットアップ時間が数か月から数分に短縮され、GPT-J や GPT-Neo などのモデル間の切り替えが可能になります。研究者が述べたように、「数回のキーストロークだけで実行できます。」

「Cerebras は、大規模な言語モデルを低コストで便利な方法で実行できる機能を人々に提供し、その可能性を広げます」 「これは、エキサイティングなインテリジェンスの新時代です。これは、数千万ドルを費やすことができない組織に、大規模なモデルで競争するための簡単かつ安価な方法を提供します」と Intersect360 Research の主任研究責任者である Dan Olds 氏は述べています。 「大規模なデータセットで GPT-3 および GPT-J レベルのモデルをトレーニングする CS-2 顧客からの新しいアプリケーションや発見を非常に楽しみにしています。」

以上が200億パラメータの大規模モデルの単一マシントレーニング: Cerebrasが新記録を樹立の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7560

7560

15

15

1384

1384

52

52

84

84

11

11

28

28

98

98

Bytedance Cutting が SVIP スーパー メンバーシップを開始: 継続的な年間サブスクリプションは 499 元で、さまざまな AI 機能を提供

Jun 28, 2024 am 03:51 AM

Bytedance Cutting が SVIP スーパー メンバーシップを開始: 継続的な年間サブスクリプションは 499 元で、さまざまな AI 機能を提供

Jun 28, 2024 am 03:51 AM

このサイトは6月27日、JianyingはByteDanceの子会社であるFaceMeng Technologyによって開発されたビデオ編集ソフトウェアであり、Douyinプラットフォームに依存しており、基本的にプラットフォームのユーザー向けに短いビデオコンテンツを作成すると報告しました。 Windows、MacOS、その他のオペレーティング システム。 Jianyingは会員システムのアップグレードを正式に発表し、インテリジェント翻訳、インテリジェントハイライト、インテリジェントパッケージング、デジタルヒューマン合成などのさまざまなAIブラックテクノロジーを含む新しいSVIPを開始しました。価格的には、クリッピングSVIPの月額料金は79元、年会費は599元(当サイト注:月額49.9元に相当)、継続月額サブスクリプションは月額59元、継続年間サブスクリプションは、年間499元(月額41.6元に相当)です。さらに、カット担当者は、ユーザーエクスペリエンスを向上させるために、オリジナルのVIPに登録している人は、

Rag と Sem-Rag を使用したコンテキスト拡張 AI コーディング アシスタント

Jun 10, 2024 am 11:08 AM

Rag と Sem-Rag を使用したコンテキスト拡張 AI コーディング アシスタント

Jun 10, 2024 am 11:08 AM

検索強化生成およびセマンティック メモリを AI コーディング アシスタントに組み込むことで、開発者の生産性、効率、精度を向上させます。 JanakiramMSV 著者の EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG から翻訳。基本的な AI プログラミング アシスタントは当然役に立ちますが、ソフトウェア言語とソフトウェア作成の最も一般的なパターンに関する一般的な理解に依存しているため、最も適切で正しいコードの提案を提供できないことがよくあります。これらのコーディング アシスタントによって生成されたコードは、彼らが解決する責任を負っている問題の解決には適していますが、多くの場合、個々のチームのコーディング標準、規約、スタイルには準拠していません。これにより、コードがアプリケーションに受け入れられるように修正または調整する必要がある提案が得られることがよくあります。

微調整によって本当に LLM が新しいことを学習できるようになるのでしょうか: 新しい知識を導入すると、モデルがより多くの幻覚を生成する可能性があります

Jun 11, 2024 pm 03:57 PM

微調整によって本当に LLM が新しいことを学習できるようになるのでしょうか: 新しい知識を導入すると、モデルがより多くの幻覚を生成する可能性があります

Jun 11, 2024 pm 03:57 PM

大規模言語モデル (LLM) は巨大なテキスト データベースでトレーニングされ、そこで大量の現実世界の知識を取得します。この知識はパラメータに組み込まれており、必要なときに使用できます。これらのモデルの知識は、トレーニングの終了時に「具体化」されます。事前トレーニングの終了時に、モデルは実際に学習を停止します。モデルを調整または微調整して、この知識を活用し、ユーザーの質問により自然に応答する方法を学びます。ただし、モデルの知識だけでは不十分な場合があり、モデルは RAG を通じて外部コンテンツにアクセスできますが、微調整を通じてモデルを新しいドメインに適応させることが有益であると考えられます。この微調整は、ヒューマン アノテーターまたは他の LLM 作成物からの入力を使用して実行され、モデルは追加の実世界の知識に遭遇し、それを統合します。

GenAI および LLM の技術面接に関する 7 つのクールな質問

Jun 07, 2024 am 10:06 AM

GenAI および LLM の技術面接に関する 7 つのクールな質問

Jun 07, 2024 am 10:06 AM

AIGC について詳しくは、51CTOAI.x コミュニティ https://www.51cto.com/aigc/Translator|Jingyan Reviewer|Chonglou を参照してください。これらの質問は、インターネット上のどこでも見られる従来の質問バンクとは異なります。既成概念にとらわれずに考える必要があります。大規模言語モデル (LLM) は、データ サイエンス、生成人工知能 (GenAI)、および人工知能の分野でますます重要になっています。これらの複雑なアルゴリズムは人間のスキルを向上させ、多くの業界で効率とイノベーションを推進し、企業が競争力を維持するための鍵となります。 LLM は、自然言語処理、テキスト生成、音声認識、推奨システムなどの分野で幅広い用途に使用できます。 LLM は大量のデータから学習することでテキストを生成できます。

Kuaishou バージョンの Sora「Ke Ling」がテスト用に公開されています。120 秒以上のビデオを生成し、物理学をより深く理解し、複雑な動きを正確にモデル化できます。

Jun 11, 2024 am 09:51 AM

Kuaishou バージョンの Sora「Ke Ling」がテスト用に公開されています。120 秒以上のビデオを生成し、物理学をより深く理解し、複雑な動きを正確にモデル化できます。

Jun 11, 2024 am 09:51 AM

何?ズートピアは国産AIによって実現するのか?ビデオとともに公開されたのは、「Keling」と呼ばれる新しい大規模な国産ビデオ生成モデルです。 Sora も同様の技術的ルートを使用し、自社開発の技術革新を多数組み合わせて、大きく合理的な動きをするだけでなく、物理世界の特性をシミュレートし、強力な概念的結合能力と想像力を備えたビデオを制作します。データによると、Keling は、最大 1080p の解像度で 30fps で最大 2 分の超長時間ビデオの生成をサポートし、複数のアスペクト比をサポートします。もう 1 つの重要な点は、Keling は研究所が公開したデモやビデオ結果のデモンストレーションではなく、ショートビデオ分野のリーダーである Kuaishou が立ち上げた製品レベルのアプリケーションであるということです。さらに、主な焦点は実用的であり、白紙小切手を書かず、リリースされたらすぐにオンラインに移行することです。Ke Ling の大型モデルは Kuaiying でリリースされました。

あなたが知らない機械学習の 5 つの流派

Jun 05, 2024 pm 08:51 PM

あなたが知らない機械学習の 5 つの流派

Jun 05, 2024 pm 08:51 PM

機械学習は人工知能の重要な分野であり、明示的にプログラムしなくてもコンピューターにデータから学習して能力を向上させる機能を提供します。機械学習は、画像認識や自然言語処理から、レコメンデーションシステムや不正行為検出に至るまで、さまざまな分野で幅広く応用されており、私たちの生活様式を変えつつあります。機械学習の分野にはさまざまな手法や理論があり、その中で最も影響力のある 5 つの手法は「機械学習の 5 つの流派」と呼ばれています。 5 つの主要な学派は、象徴学派、コネクショニスト学派、進化学派、ベイジアン学派、およびアナロジー学派です。 1. 象徴主義は、象徴主義とも呼ばれ、論理的推論と知識の表現のためのシンボルの使用を強調します。この学派は、学習は既存の既存の要素を介した逆演繹のプロセスであると信じています。

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

編集者 |ScienceAI 質問応答 (QA) データセットは、自然言語処理 (NLP) 研究を促進する上で重要な役割を果たします。高品質の QA データ セットは、モデルの微調整に使用できるだけでなく、大規模言語モデル (LLM) の機能、特に科学的知識を理解し推論する能力を効果的に評価することもできます。現在、医学、化学、生物学、その他の分野をカバーする多くの科学 QA データ セットがありますが、これらのデータ セットにはまだいくつかの欠点があります。まず、データ形式は比較的単純で、そのほとんどが多肢選択式の質問であり、評価は簡単ですが、モデルの回答選択範囲が制限され、科学的な質問に回答するモデルの能力を完全にテストすることはできません。対照的に、自由回答型の Q&A

AI スタートアップ企業は一斉に OpenAI に転職し、イリヤが去った後にセキュリティ チームが再編成されました。

Jun 08, 2024 pm 01:00 PM

AI スタートアップ企業は一斉に OpenAI に転職し、イリヤが去った後にセキュリティ チームが再編成されました。

Jun 08, 2024 pm 01:00 PM

先週、社内の辞任と社外からの批判が相次ぐ中、OpenAIは内外のトラブルに見舞われた。 - 未亡人姉妹への侵害が世界中で白熱した議論を巻き起こした - 「覇権条項」に署名した従業員が次々と暴露 - ネットユーザーがウルトラマンの「」をリストアップ噂の払拭: Vox が入手した漏洩情報と文書によると、アルトマンを含む OpenAI の上級幹部はこれらの株式回収条項をよく認識しており、承認しました。さらに、OpenAI には、AI セキュリティという深刻かつ緊急の課題が直面しています。最近、最も著名な従業員2名を含むセキュリティ関連従業員5名が退職し、「Super Alignment」チームが解散したことで、OpenAIのセキュリティ問題が再び注目を集めている。フォーチュン誌は OpenA を報じた。