テクノロジー周辺機器

テクノロジー周辺機器

AI

AI

AIの発展は70年後の統一をもたらすのか? Ma Yi、Cao Ying、Shen Xiangyang の最新 AI レビュー: 知能生成の基本原理と「標準モデル」を探る

AIの発展は70年後の統一をもたらすのか? Ma Yi、Cao Ying、Shen Xiangyang の最新 AI レビュー: 知能生成の基本原理と「標準モデル」を探る

AIの発展は70年後の統一をもたらすのか? Ma Yi、Cao Ying、Shen Xiangyang の最新 AI レビュー: 知能生成の基本原理と「標準モデル」を探る

人工知能は 70 年にわたって発展しており、テクニカル指標は常に更新されていますが、「知能」とは一体何なのか、またそれがどのように出現し、発展していくのかについては未だに答えがありません。

最近、マー・イー教授は、コンピューター科学者のシェン・シャンヤン博士および神経科学者の曹英教授と協力して、知能の出現と発達に関する研究レビューを発表し、研究を理論的に解明したいと考えています。統合して人工知能モデルの理解と解釈可能性を向上させます。

論文リンク: http://arxiv.org/abs/2207.04630

で紹介されました。記事 2 つの基本原則: 倹約と自己一貫性。

著者は、これが人工的であれ自然的であれ、知性の台頭の基礎であると信じています。古典文献にはこれら 2 つの原則のそれぞれについて数多くの議論と詳細が記載されていますが、この記事ではこれら 2 つの原則を完全に測定可能かつ計算可能な方法で再解釈します。

これらの 2 つの最初の原則に基づいて、著者らは効率的な計算フレームワーク、つまり現代の深層ネットワークと多くの人工知能の実践を統合し説明する圧縮閉ループ転写を導き出します。

- 何を学ぶべきか: データから何を学ぶべきか、そして学習の質をどのように測定するか?

- 学習方法: 効率的かつ効果的なコンピューティング フレームワークを通じて、このような学習目標を達成するにはどうすればよいでしょうか?

「何を学ぶか」という最初の質問については、単純性の原則により次のようになります。

学生の学習目標インテリジェントシステムとは、外界の観測データから低次元構造を発見し、それらを最もコンパクトかつ構造化された方法で再編成して表現することから学びます。 これは「オッカムの剃刀」の原則です。必要な場合以外はエンティティを追加しないでください。この原則がなければ、インテリジェンスは不可能です。外界の観測データが低次元構造を持たない場合、学習や記憶に値するものは何もなく、良好な一般化や予測は不可能です。

また、インテリジェントシステムでは、エネルギー、空間、時間、材料などの資源をできる限り節約する必要があり、この原理は「圧縮原理」と呼ばれることもあります。ただし、インテリジェンスの節約は、最適な圧縮を達成することではなく、効率的な計算手段を通じて観測データの最もコンパクトで構造化された表現を取得することです。

では、シンプルさを測定するにはどうすればよいでしょうか?

一般的な高次元モデルの場合、一般的に使用される多くの数学的または統計的な「尺度」の計算コストは指数関数的であり、低次元構造のデータ分布の場合も同様です。最尤法、KL ダイバージェンス、相互情報量、ジェンセン・シャノン距離、ワッサーシュタイン距離など。

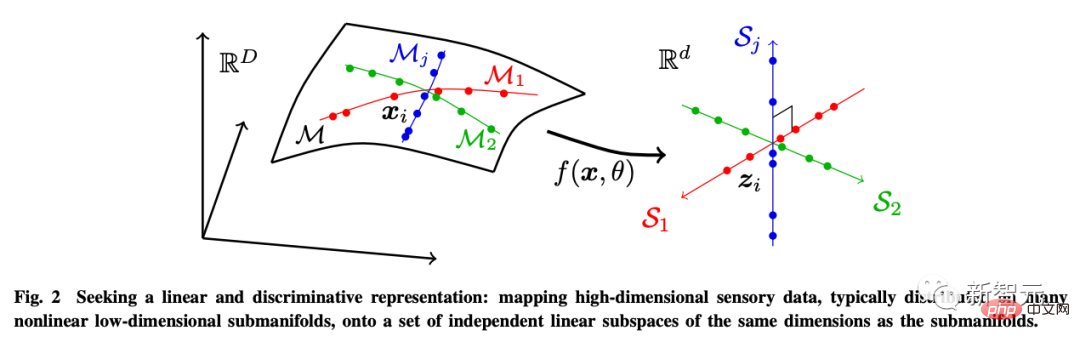

著者は、学習の目的は実際には、元の高次元入力から低次元表現を取得するためのマッピング (通常は非線形) を確立することであると考えています。

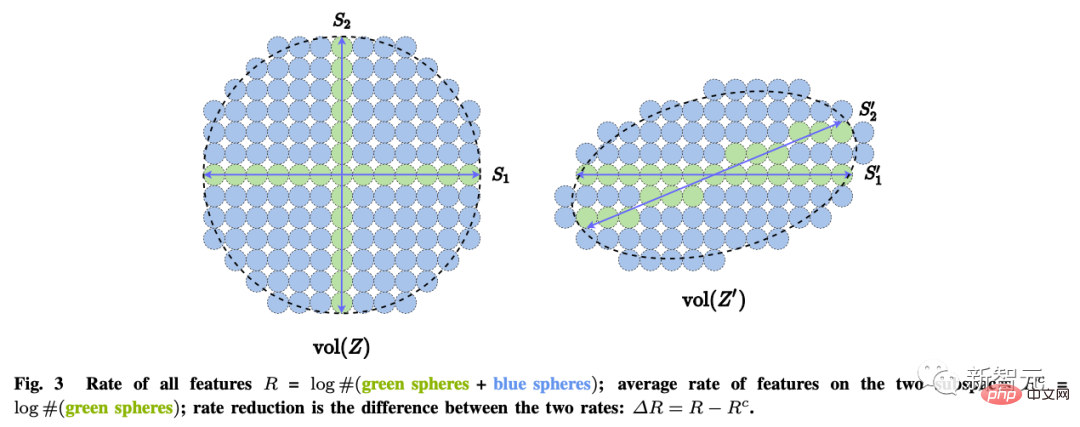

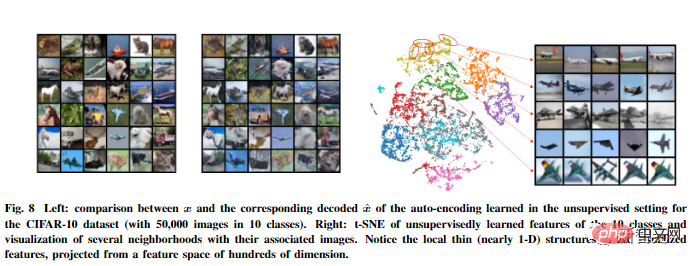

この目的のために、著者は 3 つのサブ目標を達成するために線形判別表現 (LDR) を導入します。 圧縮: 高次元の感覚データ x を低次元表現 z にマッピングします;

線形化: 非線形サブサーフェスに分布する各タイプのオブジェクトを線形部分空間にマッピングします; スパース化:異なるカテゴリを相互に独立した、または関連性の低い部分空間にマッピングします。

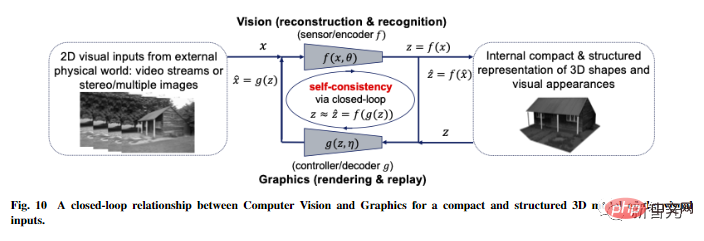

「学習方法」という 2 番目の質問については、自己一貫性の原則により次のようになります。

自律型インテリジェント システムは、観察されたデータと再生成されたデータの内部表現の差異を最小限に抑えることにより、外界の観察に対して最も自己矛盾のないモデルを模索します。

倹約の原則だけでは、学習されたモデルが外界のデータに関するすべての重要な情報を確実に捕捉できるわけではありません。たとえば、クロスエントロピーを最小限に抑えて各カテゴリを 1 次元のワンホット ベクトルにマッピングすることは、倹約の一形態とみなすことができます。

優れた分類器を学習する可能性がありますが、学習された特徴がシングルトンに崩壊する可能性もあります (ニューラル崩壊とも呼ばれます)。このような学習された特徴には、元のデータを再生成するのに十分な情報が含まれなくなります。

より一般的な LDR モデルを考慮したとしても、コーディング レートの差を最大化するだけでは、環境特徴空間の正しい次元を自動的に決定することはできません。

特徴空間の次元が低すぎる場合、学習されたモデルはデータと一致せず、高すぎる場合、モデルが過剰に一致する可能性があります。

より一般的には、知覚学習は特定のタスクの学習とは異なると主張します。知覚の目標は、何が知覚されているかについて予測可能なすべてを学習することです。

アインシュタインはかつてこう言いました:「物事はシンプルに保つべきですが、シンプルすぎてもいけません。」

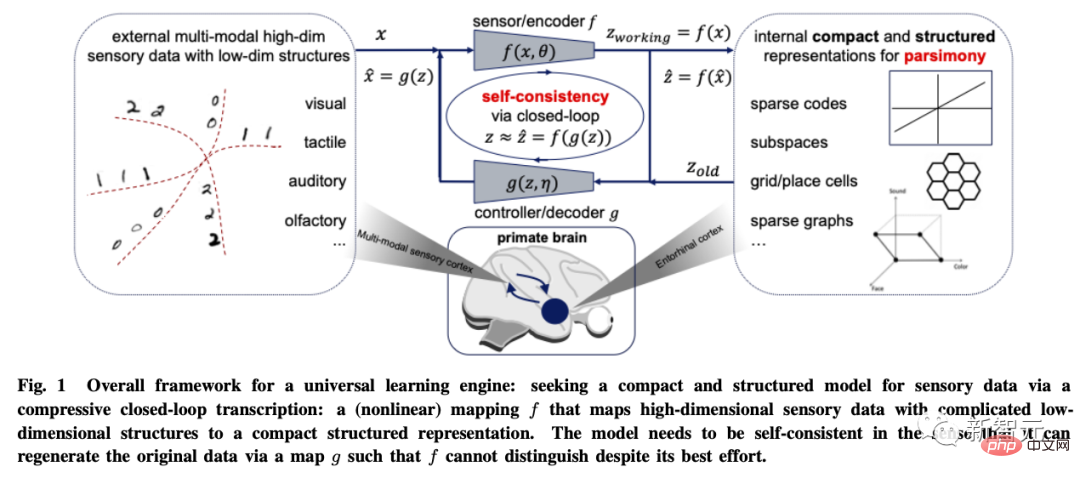

ユニバーサル学習エンジン

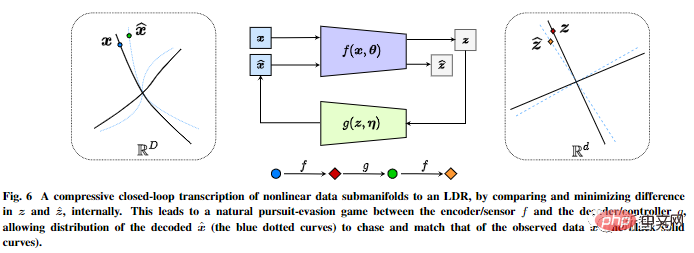

これら 2 つの原則に基づいて、この記事では、例として視覚画像データ モデリングを使用して、圧縮閉ループ転写フレームワークを導き出します。

非線形データ サブフロー パターンの圧縮閉ループ転写を内部で実行し、内部表現の違いを比較して最小限に抑えることで LDR を実現します。

エンコーダー/センサーとデコーダー/コントローラー間のチェイス アンド フライト ゲームにより、デコードされた表現によって生成されたデータの分布を追跡し、観察された実際のデータ分布と一致させることができます。

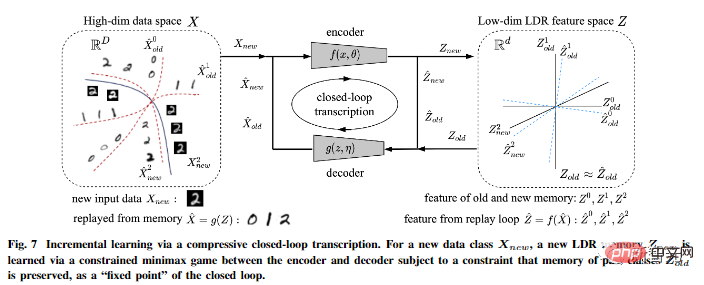

さらに、著者は、圧縮された閉ループ転写が増分学習を効果的に実行できることを指摘しました。

新しいデータ クラスの LDR モデルは、エンコーダーとデコーダーの間の制約付きゲームを通じて学習できます。過去に学習したクラスの記憶は自然に学習でき、制約として保持されます。ゲーム、つまり、閉ループ転写の「固定点」として。

この記事では、このフレームワークの普遍性についてさらに推測的なアイデアを提案し、それを 3 つの次元に拡張します。強化学習、およびその神経科学、数学、高度な知能への影響の予測。

以上がAIの発展は70年後の統一をもたらすのか? Ma Yi、Cao Ying、Shen Xiangyang の最新 AI レビュー: 知能生成の基本原理と「標準モデル」を探るの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7526

7526

15

15

1378

1378

52

52

81

81

11

11

21

21

74

74

カーソルAIでバイブコーディングを試してみましたが、驚くべきことです!

Mar 20, 2025 pm 03:34 PM

カーソルAIでバイブコーディングを試してみましたが、驚くべきことです!

Mar 20, 2025 pm 03:34 PM

バイブコーディングは、無限のコード行の代わりに自然言語を使用してアプリケーションを作成できるようにすることにより、ソフトウェア開発の世界を再構築しています。 Andrej Karpathyのような先見の明に触発されて、この革新的なアプローチは開発を許可します

2025年2月のトップ5 Genai発売:GPT-4.5、Grok-3など!

Mar 22, 2025 am 10:58 AM

2025年2月のトップ5 Genai発売:GPT-4.5、Grok-3など!

Mar 22, 2025 am 10:58 AM

2025年2月は、生成AIにとってさらにゲームを変える月であり、最も期待されるモデルのアップグレードと画期的な新機能のいくつかをもたらしました。 Xai’s Grok 3とAnthropic's Claude 3.7 SonnetからOpenaiのGまで

オブジェクト検出にYolo V12を使用する方法は?

Mar 22, 2025 am 11:07 AM

オブジェクト検出にYolo V12を使用する方法は?

Mar 22, 2025 am 11:07 AM

Yolo(あなたは一度だけ見ています)は、前のバージョンで各反復が改善され、主要なリアルタイムオブジェクト検出フレームワークでした。最新バージョンYolo V12は、精度を大幅に向上させる進歩を紹介します

ChatGpt 4 oは利用できますか?

Mar 28, 2025 pm 05:29 PM

ChatGpt 4 oは利用できますか?

Mar 28, 2025 pm 05:29 PM

CHATGPT 4は現在利用可能で広く使用されており、CHATGPT 3.5のような前任者と比較して、コンテキストを理解し、一貫した応答を生成することに大幅な改善を示しています。将来の開発には、よりパーソナライズされたインターが含まれる場合があります

クリエイティブプロジェクトのための最高のAIアートジェネレーター(無料&有料)

Apr 02, 2025 pm 06:10 PM

クリエイティブプロジェクトのための最高のAIアートジェネレーター(無料&有料)

Apr 02, 2025 pm 06:10 PM

この記事では、トップAIアートジェネレーターをレビューし、その機能、創造的なプロジェクトへの適合性、価値について説明します。 Midjourneyを専門家にとって最高の価値として強調し、高品質でカスタマイズ可能なアートにDall-E 2を推奨しています。

O1対GPT-4O:OpenAIの新しいモデルはGPT-4Oよりも優れていますか?

Mar 16, 2025 am 11:47 AM

O1対GPT-4O:OpenAIの新しいモデルはGPT-4Oよりも優れていますか?

Mar 16, 2025 am 11:47 AM

OpenaiのO1:12日間の贈り物は、これまでで最も強力なモデルから始まります 12月の到着は、世界の一部の地域で雪片が世界的に減速し、雪片がもたらされますが、Openaiは始まったばかりです。 サム・アルトマンと彼のチームは12日間のギフトを立ち上げています

Google' s Gencast:Gencast Mini Demoを使用した天気予報

Mar 16, 2025 pm 01:46 PM

Google' s Gencast:Gencast Mini Demoを使用した天気予報

Mar 16, 2025 pm 01:46 PM

Google Deepmind's Gencast:天気予報のための革新的なAI 天気予報は、初歩的な観察から洗練されたAI駆動の予測に移行する劇的な変化を受けました。 Google DeepmindのGencast、グラウンドブレイク

chatgptよりも優れたAIはどれですか?

Mar 18, 2025 pm 06:05 PM

chatgptよりも優れたAIはどれですか?

Mar 18, 2025 pm 06:05 PM

この記事では、Lamda、Llama、GrokのようなChatGptを超えるAIモデルについて説明し、正確性、理解、業界への影響における利点を強調しています(159文字)