この大きなモデルは、数式や参考文献を使用して論文を単独で「書く」ことができます。試用版は現在オンラインになっています。

近年、さまざまな主題分野の研究の進歩に伴い、科学文献やデータが爆発的に増加しており、学術研究者が大量の情報から有用な洞察を発見することがますます困難になっています。通常、人は科学知識を得るために検索エンジンを利用しますが、検索エンジンは科学知識を自律的に整理することができません。

今回、Meta AI の研究チームは、科学知識を保存、組み合わせ、推論できる新しい大規模言語モデルである Gaoptica を提案しました。

- #紙のアドレス: https://gaoptica.org/static/paper.pdf

- トライアルアドレス: https://gaoptica.org/

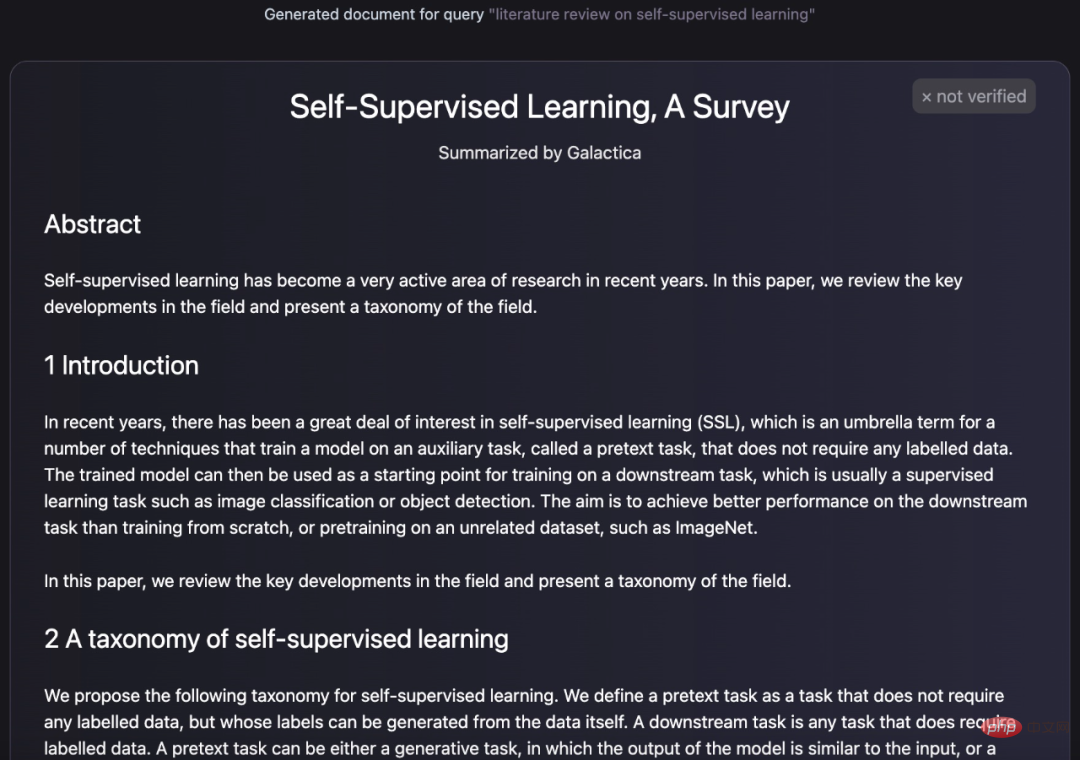

Gaoptica モデルはどのくらい強力ですか?それ自体でレビュー論文を要約して要約します:

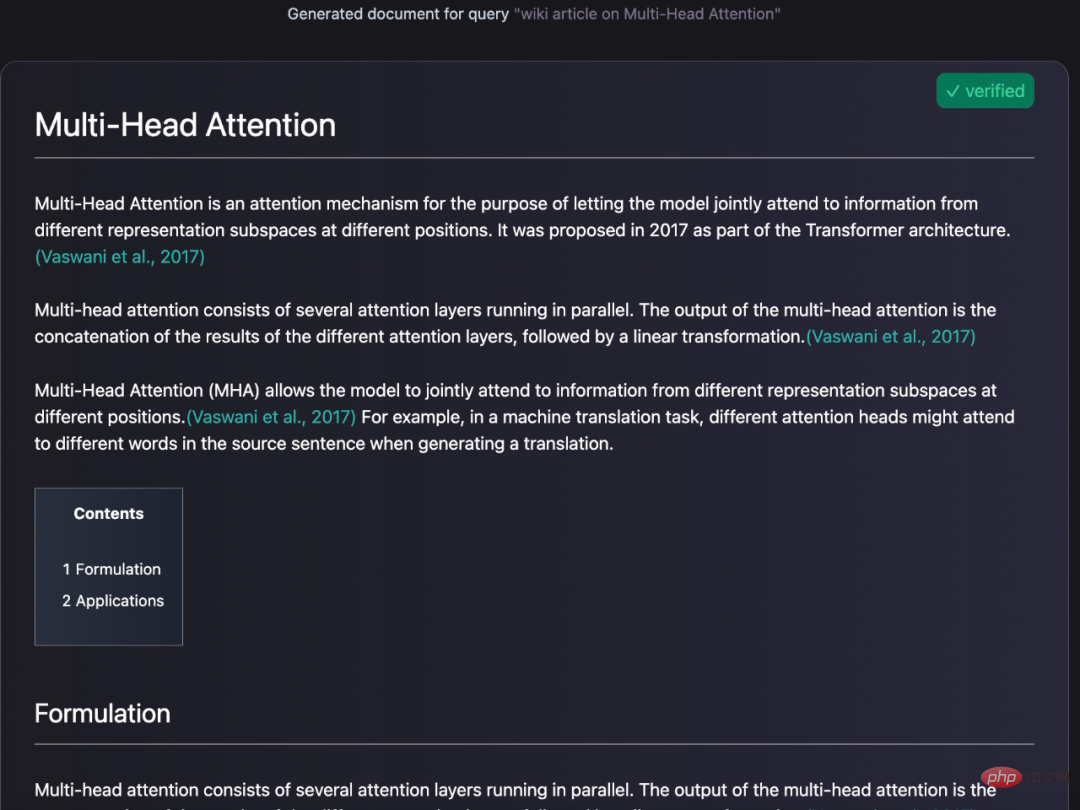

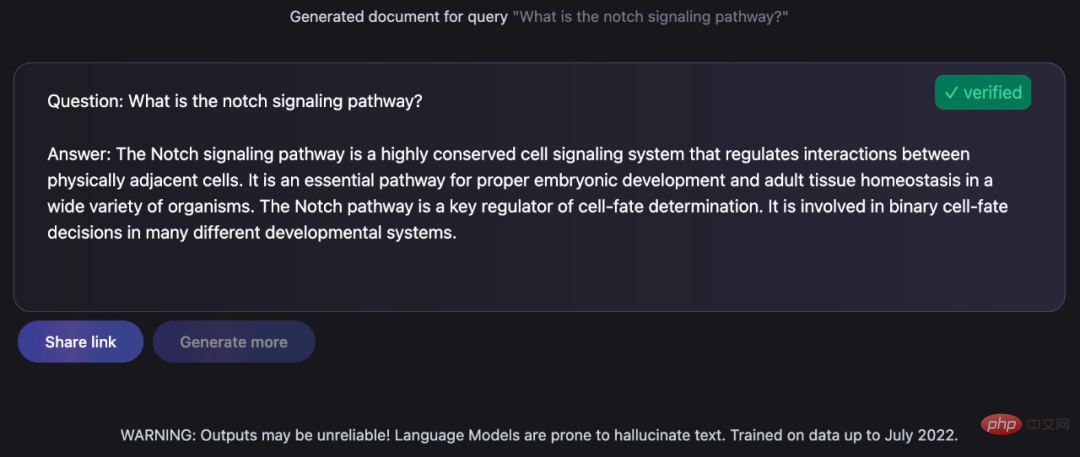

# 尋ねられた質問に対して知識豊富な回答をしてください:

# 尋ねられた質問に対して知識豊富な回答をしてください:

これらのタスクは人類学者 A にとって依然として必要です。困難な任務でしたが、ギャラクティカは非常にうまくやり遂げました。チューリング賞受賞者のヤン・ルカン氏も次のように賞賛のツイートをした:

これらのタスクは人類学者 A にとって依然として必要です。困難な任務でしたが、ギャラクティカは非常にうまくやり遂げました。チューリング賞受賞者のヤン・ルカン氏も次のように賞賛のツイートをした:

# ギャラクティカ モデルの具体的な詳細を見てみましょう。

モデルの概要

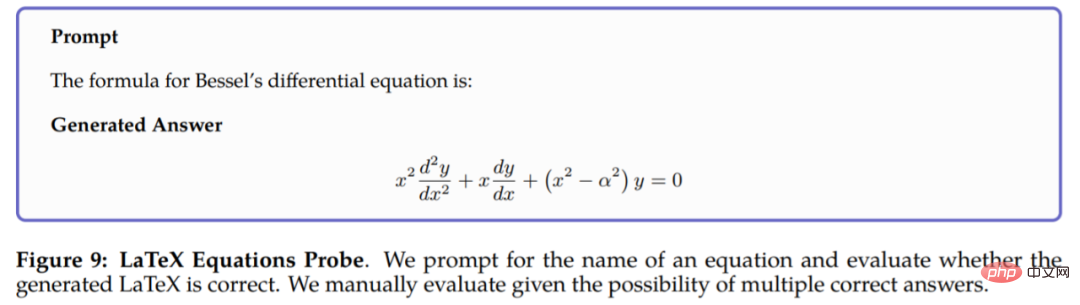

ギャラクティカ モデルは、4,800 万件以上の記事を含む、論文、参考資料、知識ベース、その他多くのソースからなる大規模な科学コーパスでトレーニングされています。 、教科書や配布資料、何百万もの化合物やタンパク質に関する知識、科学ウェブサイト、百科事典など。キュレーションされていない Web クローラーベースのテキストに依存する既存の言語モデルとは異なり、Galaxy のトレーニングに使用されるコーパスは高品質で高度にキュレーションされています。この研究では、過剰適合することなく複数のエポックに対してモデルをトレーニングし、トークンを繰り返し使用することで上流および下流のタスクのパフォーマンスが向上しました。ギャラクティカは、さまざまな科学的タスクにおいて既存のモデルよりも優れた性能を発揮します。 LaTeX 方程式などの技術的知識の探索タスクでは、Galaxy と GPT-3 のパフォーマンスは 68.2% 対 49.0% でした。ギャラクティカは推論にも優れており、数学的な MMLU ベンチマークではチンチラを大幅に上回っています。

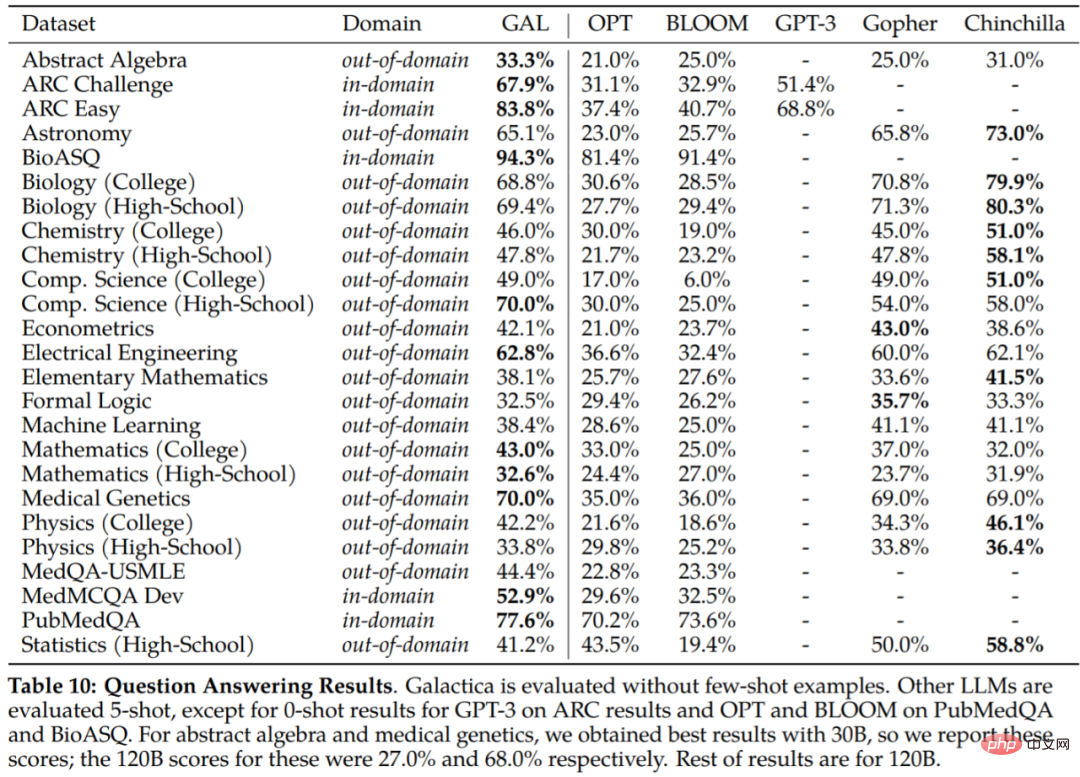

Galatica は、一般的なコーパスでトレーニングされていないにもかかわらず、BIG ベンチでも BLOOM や OPT-175B よりも優れたパフォーマンスを発揮します。さらに、PubMedQA や MedMCQA 開発などの下流タスクで 77.6% と 52.9% という新たな最高パフォーマンスを達成しました。

簡単に言うと、この研究では、内部の仕組みを模倣するために、段階的な推論を特別なトークンにカプセル化しています。これにより、ギャラクティカのトライアル インターフェイスで以下に示すように、研究者は自然言語を使用してモデルと対話できるようになります。

Galaxy では、テキスト生成に加えて、化学式やタンパク質配列を含むマルチモーダル タスクも実行できることは言及する価値があります。創薬分野への貢献となります。

実装の詳細

この記事のコーパスには、論文、参考文献、百科事典、その他の科学資料に由来する 1,060 億個のトークンが含まれています。この研究には、自然言語リソース(論文、参考書)と自然界の配列(タンパク質配列、化学形態)の両方が含まれていると言えます。コーパスの詳細を表 1 および表 2 に示します。

コーパスを取得したので、次のステップはデータを操作する方法です。一般に、トークン化の設計は非常に重要です。たとえば、タンパク質配列がアミノ酸残基で記述されている場合は、文字ベースのトークン化が適切です。トークン化を実現するために、この研究ではさまざまなモダリティで特殊なトークン化を実行しました。具体的な例は次のとおりです (これに限定されません):

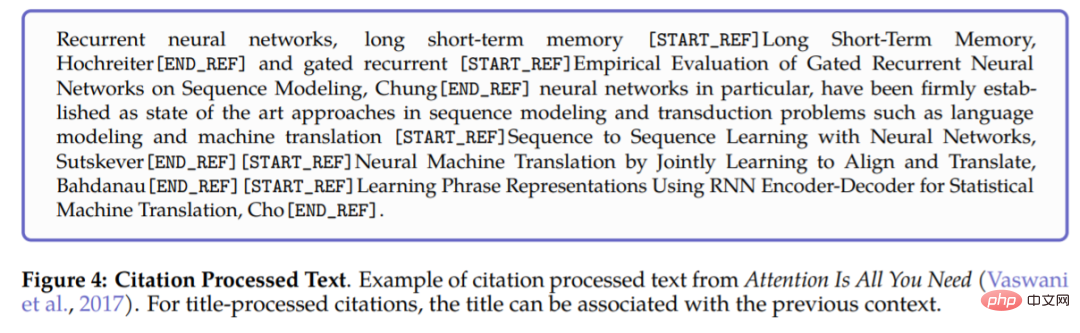

- 参照: 特別な参照トークン [START_REF] および [END_REF] を使用して参照をラップします。

- 段階的推論: 作業メモリ トークンを使用して、段階的推論をカプセル化し、内部の作業メモリ コンテキストをシミュレートします;

- 数値: 数値を個別のトークンに分割します。たとえば、737612.62 → 7,3,7,6,1,2,.,6,2;

- SMILES 式: シーケンスを [START_SMILES] と [END_SMILES] で囲み、文字ベースのトークン化を適用します。同様に、この研究では [START_I_SMILES] と [END_I_SMILES] を使用して異性体の SMILES を表します。例: C(C(=O)O)N→C, (,C,(,=,O,),O,),N;

- DNA シーケンス: 適用one 各ヌクレオチド塩基をトークンとして扱う文字ベースのトークン化。開始トークンは [START_DNA] と [END_DNA] です。たとえば、CGGTACCCTC→C、G、G、T、A、C、C、C、T、C。

# 以下の図 4 は、論文への参照を処理する例を示しています。参照を処理するときは、グローバル識別子と特殊トークン [START_REF] および [END_REF] を使用して参照の場所を表します。

#データセットが処理された後の次のステップは、それを実装する方法です。 Galatica は、Transformer アーキテクチャに基づいて次の変更を加えました:

- GeLU アクティベーション: さまざまなサイズのモデルに GeLU アクティベーションを使用します;

- コンテキスト ウィンドウ: 異なるサイズのモデルの場合、長さ 2048 のコンテキスト ウィンドウを使用します;

- バイアスなし: PaLM に従い、高密度カーネルまたはレイヤー仕様ではバイアスは使用されません;

- 学習場所の埋め込み: 学習場所の埋め込みがモデルに使用されます;

- 語彙: BPE を使用して、50,000 のトークンを含む語彙を構築します。

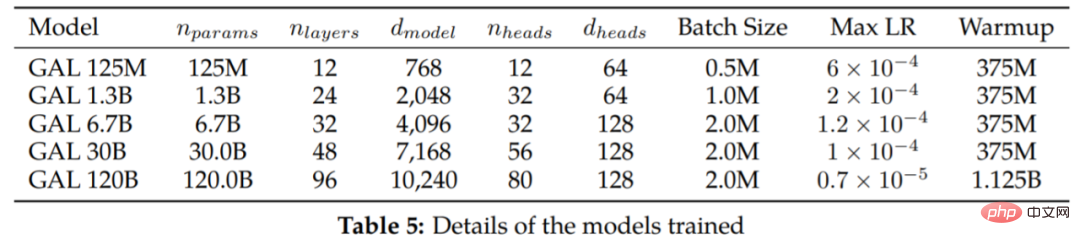

#表 5 に、さまざまなサイズのモデルとトレーニング ハイパーパラメーターを示します。

#実験

#実験

重複したトークンは無害とみなされます

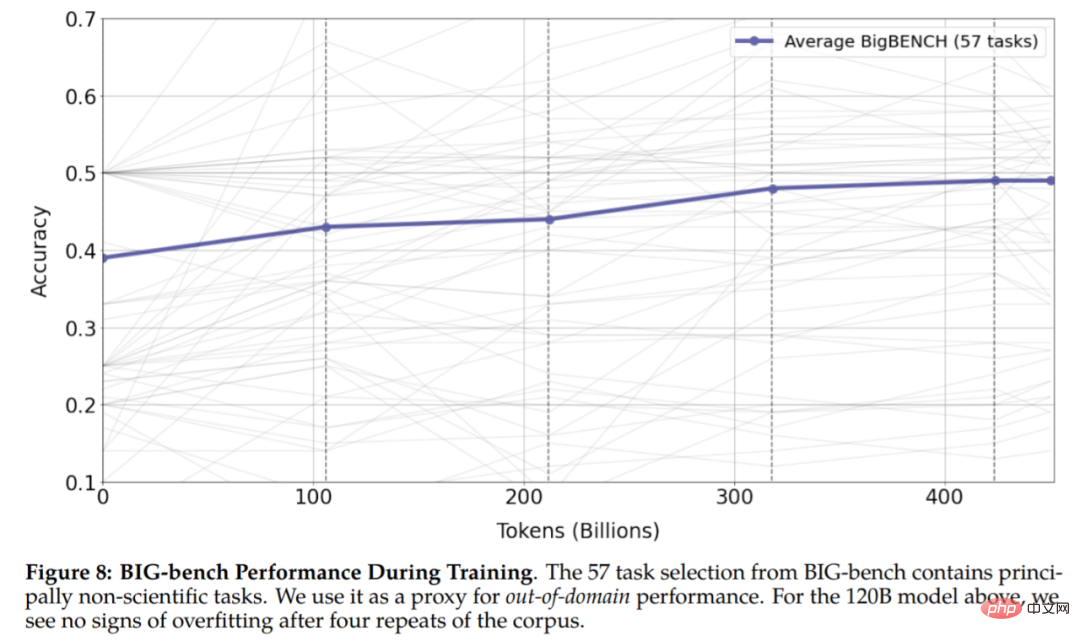

図 6 からわかるように、トレーニングの 4 エポックの後、検証損失は減少し続けています。 120B パラメータを持つモデルは、5 番目のエポックの開始時にのみオーバーフィットを開始します。既存の調査では、トークンの重複がパフォーマンスに悪影響を与える可能性があることが示されているため、これは予想外のことでした。この研究では、30B モデルと 120B モデルが時代ごとに二重の減少効果を示し、検証損失が横ばい (または上昇) に続いて減少することもわかりました。この効果は各エポックの後に強くなり、特にトレーニング終了時の 120B モデルで顕著になります。図 8 の結果は、実験に過剰適合の兆候がないことを示しており、トークンを繰り返すことで下流タスクと上流タスクのパフォーマンスが向上する可能性があることを示しています。

数式を入力するのが遅すぎます。プロンプトを使用すると、LaTeX を生成できます:

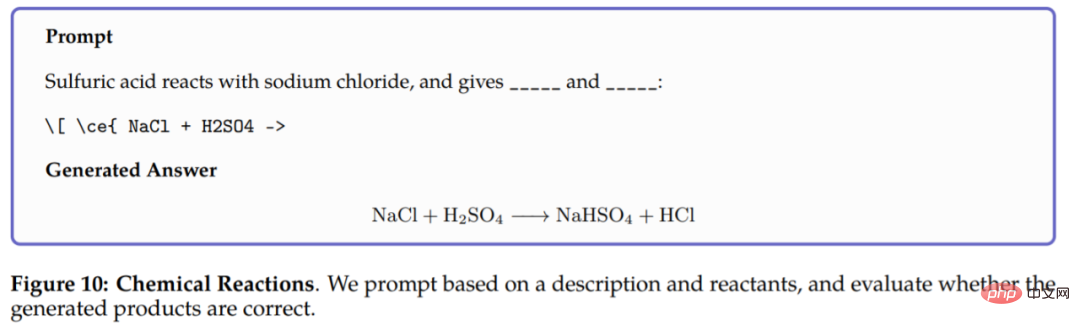

化学反応では、Galaxy は化学方程式 LaTeX の反応生成物を予測する必要があります。モデルは反応物のみに基づくことができます。推論すると、結果は次のようになります:

化学反応では、Galaxy は化学方程式 LaTeX の反応生成物を予測する必要があります。モデルは反応物のみに基づくことができます。推論すると、結果は次のようになります:

いくつかの追加の結果を表 7 に示します。

いくつかの追加の結果を表 7 に示します。

# #

ギャラクティカの推理力。この研究は最初に MMLU 数学ベンチマークで評価され、評価結果が表 8 に報告されています。ギャラクティカは、より大きな基本モデルと比較して強力なパフォーマンスを発揮し、より小さな 30B ギャラクティカ モデルであっても、トークンを使用するとチンチラのパフォーマンスが向上するようです。

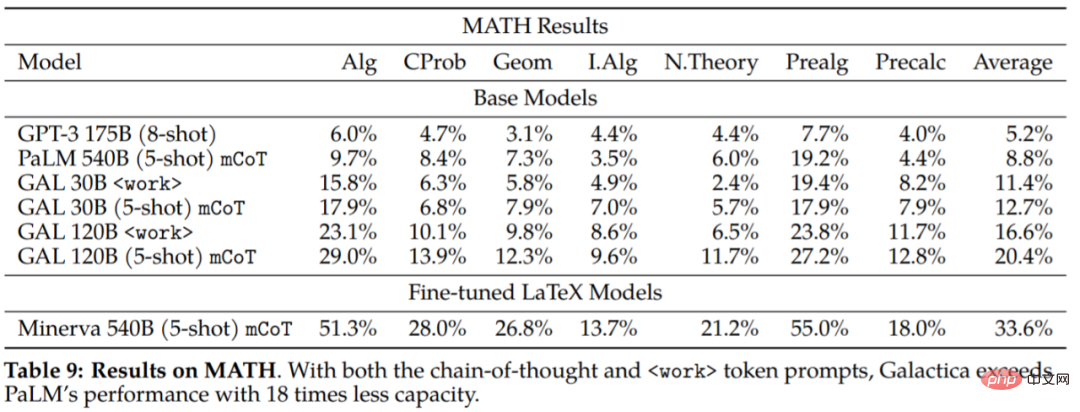

この研究では、Galaxy の推論機能をさらに調査するために MATH データセットも評価しました。

実験結果から、思考の連鎖とプロンプトの点で、Galaxy は基本的な PaLM モデルよりもはるかに優れていると結論付けました。これは、数学的タスクを処理するには、Galaxy がより良い選択肢であることを示唆しています。

#下流タスクの評価結果を表 10 に示します。 Galatica は他の言語モデルを大幅に上回り、ほとんどのタスク (Gopher 280B) でより大きなモデルを上回ります。チンチラと比べてパフォーマンスの差は大きく、チンチラは一部の課題、特に高校の科目や、数学的で記憶力をそれほど必要としない課題でより優れているようでした。対照的に、ギャラクティカは数学や大学院レベルのタスクでより良いパフォーマンスを発揮する傾向があります。

この研究では、入力された文脈に基づいて引用を予測するチンチラの能力、つまり科学文献を整理するチンチラの能力も評価されました。結果は次のとおりです。

その他の実験内容については、元の論文を参照してください。

以上がこの大きなモデルは、数式や参考文献を使用して論文を単独で「書く」ことができます。試用版は現在オンラインになっています。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7552

7552

15

15

1382

1382

52

52

83

83

11

11

22

22

95

95

Centosシャットダウンコマンドライン

Apr 14, 2025 pm 09:12 PM

Centosシャットダウンコマンドライン

Apr 14, 2025 pm 09:12 PM

Centos Shutdownコマンドはシャットダウンし、構文はシャットダウン[オプション]時間[情報]です。オプションは次のとおりです。-hシステムをすぐに停止します。 -pシャットダウン後に電源をオフにします。 -r再起動; -t待機時間。時間は、即時(現在)、数分(分)、または特定の時間(HH:mm)として指定できます。追加の情報をシステムメッセージに表示できます。

Centosのgitlabのバックアップ方法は何ですか

Apr 14, 2025 pm 05:33 PM

Centosのgitlabのバックアップ方法は何ですか

Apr 14, 2025 pm 05:33 PM

Centosシステムの下でのGitlabのバックアップと回復ポリシーデータセキュリティと回復可能性を確保するために、Gitlab on Centosはさまざまなバックアップ方法を提供します。この記事では、いくつかの一般的なバックアップ方法、構成パラメーター、リカバリプロセスを詳細に紹介し、完全なGitLabバックアップと回復戦略を確立するのに役立ちます。 1.手動バックアップGitlab-RakeGitlabを使用:バックアップ:コマンドを作成して、マニュアルバックアップを実行します。このコマンドは、gitlabリポジトリ、データベース、ユーザー、ユーザーグループ、キー、アクセスなどのキー情報をバックアップします。デフォルトのバックアップファイルは、/var/opt/gitlab/backupsディレクトリに保存されます。 /etc /gitlabを変更できます

CentOS HDFS構成をチェックする方法

Apr 14, 2025 pm 07:21 PM

CentOS HDFS構成をチェックする方法

Apr 14, 2025 pm 07:21 PM

CENTOSシステムでHDFS構成をチェックするための完全なガイドこの記事では、CENTOSシステム上のHDFSの構成と実行ステータスを効果的に確認する方法をガイドします。次の手順は、HDFSのセットアップと操作を完全に理解するのに役立ちます。 Hadoop環境変数を確認します。最初に、Hadoop環境変数が正しく設定されていることを確認してください。端末では、次のコマンドを実行して、Hadoopが正しくインストールおよび構成されていることを確認します。HDFS構成をチェックするHDFSファイル:HDFSのコア構成ファイルは/etc/hadoop/conf/ディレクトリにあります。使用

CentosでのZookeeperのパフォーマンスを調整する方法は何ですか

Apr 14, 2025 pm 03:18 PM

CentosでのZookeeperのパフォーマンスを調整する方法は何ですか

Apr 14, 2025 pm 03:18 PM

CENTOSでのZookeeperパフォーマンスチューニングは、ハードウェア構成、オペレーティングシステムの最適化、構成パラメーターの調整、監視、メンテナンスなど、複数の側面から開始できます。特定のチューニング方法を次に示します。SSDはハードウェア構成に推奨されます。ZookeeperのデータはDISKに書き込まれます。十分なメモリ:頻繁なディスクの読み取りと書き込みを避けるために、Zookeeperに十分なメモリリソースを割り当てます。マルチコアCPU:マルチコアCPUを使用して、Zookeeperが並行して処理できるようにします。

CentosでPytorchモデルを訓練する方法

Apr 14, 2025 pm 03:03 PM

CentosでPytorchモデルを訓練する方法

Apr 14, 2025 pm 03:03 PM

CentOSシステムでのPytorchモデルの効率的なトレーニングには手順が必要であり、この記事では詳細なガイドが提供されます。 1。環境の準備:Pythonおよび依存関係のインストール:Centosシステムは通常Pythonをプリインストールしますが、バージョンは古い場合があります。 YumまたはDNFを使用してPython 3をインストールし、PIP:sudoyumupdatepython3(またはsudodnfupdatepython3)、pip3install-upgradepipをアップグレードすることをお勧めします。 cuda and cudnn(GPU加速):nvidiagpuを使用する場合は、cudatoolをインストールする必要があります

CentosのPytorchのGPUサポートはどのようにサポートされていますか

Apr 14, 2025 pm 06:48 PM

CentosのPytorchのGPUサポートはどのようにサポートされていますか

Apr 14, 2025 pm 06:48 PM

Pytorch GPUアクセラレーションを有効にすることで、CentOSシステムでは、PytorchのCUDA、CUDNN、およびGPUバージョンのインストールが必要です。次の手順では、プロセスをガイドします。CUDAおよびCUDNNのインストールでは、CUDAバージョンの互換性が決定されます。NVIDIA-SMIコマンドを使用して、NVIDIAグラフィックスカードでサポートされているCUDAバージョンを表示します。たとえば、MX450グラフィックカードはCUDA11.1以上をサポートする場合があります。 cudatoolkitのダウンロードとインストール:nvidiacudatoolkitの公式Webサイトにアクセスし、グラフィックカードでサポートされている最高のCUDAバージョンに従って、対応するバージョンをダウンロードしてインストールします。 cudnnライブラリをインストールする:

Dockerの原則の詳細な説明

Apr 14, 2025 pm 11:57 PM

Dockerの原則の詳細な説明

Apr 14, 2025 pm 11:57 PM

DockerはLinuxカーネル機能を使用して、効率的で孤立したアプリケーションランニング環境を提供します。その作業原則は次のとおりです。1。ミラーは、アプリケーションを実行するために必要なすべてを含む読み取り専用テンプレートとして使用されます。 2。ユニオンファイルシステム(UnionFS)は、違いを保存するだけで、スペースを節約し、高速化する複数のファイルシステムをスタックします。 3.デーモンはミラーとコンテナを管理し、クライアントはそれらをインタラクションに使用します。 4。名前空間とcgroupsは、コンテナの分離とリソースの制限を実装します。 5.複数のネットワークモードは、コンテナの相互接続をサポートします。これらのコア概念を理解することによってのみ、Dockerをよりよく利用できます。

Centosの下でPytorchバージョンを選択する方法

Apr 14, 2025 pm 02:51 PM

Centosの下でPytorchバージョンを選択する方法

Apr 14, 2025 pm 02:51 PM

CentOSでPytorchバージョンを選択する場合、次の重要な要素を考慮する必要があります。1。CUDAバージョンの互換性GPUサポート:NVIDIA GPUを使用してGPU加速度を活用したい場合は、対応するCUDAバージョンをサポートするPytorchを選択する必要があります。 NVIDIA-SMIコマンドを実行することでサポートされているCUDAバージョンを表示できます。 CPUバージョン:GPUをお持ちでない場合、またはGPUを使用したくない場合は、PytorchのCPUバージョンを選択できます。 2。PythonバージョンPytorch