DeepMind の新しい研究: トランスフォーマーは人間の介入なしで自らを改善できる

現在、Transformers はシーケンス モデリング用の強力なニューラル ネットワーク アーキテクチャになっています。事前トレーニングされたトランスフォーマーの注目すべき特性は、キュー調整またはコンテキスト学習を通じて下流のタスクに適応する能力です。大規模なオフライン データセットで事前トレーニングした後、大規模トランスフォーマーはテキスト補完、言語理解、画像生成の下流タスクに効率的に一般化することが示されています。

最近の研究では、オフライン強化学習 (RL) を逐次予測問題として扱うことで、トランスフォーマーがオフライン データからポリシーを学習できることが示されました。 Chen et al. (2021) の研究では、トランスフォーマーが模倣学習を通じてオフライン RL データからシングルタスク ポリシーを学習できることが示され、その後の研究では、トランスフォーマーが同一ドメイン設定とクロスドメイン設定の両方でマルチタスク ポリシーを抽出できることが示されました。これらの研究はすべて、一般的なマルチタスク ポリシーを抽出するためのパラダイムを示しています。つまり、まず大規模で多様な環境相互作用データ セットを収集し、次に逐次モデリングを通じてデータからポリシーを抽出します。模倣学習を通じてオフライン RL データからポリシーを学習するこの方法は、オフライン ポリシー蒸留 (Offline Policy Distillation) またはポリシー蒸留 (Policy Distillation、PD) と呼ばれます。

PD はシンプルさとスケーラビリティを提供しますが、その大きな欠点の 1 つは、生成されたポリシーが環境との対話を追加しても徐々に改善されないことです。たとえば、Google のジェネラリスト エージェントである Multi-Game Decision Transformers は、多くの Atari ゲームをプレイできるリターン条件付きポリシーを学習しましたが、DeepMind のジェネラリスト エージェントである Gato は、コンテキスト タスク推論を通じてさまざまな問題の解決策を学習しました。残念ながら、どちらのエージェントも試行錯誤を通じて状況に応じてポリシーを改善することはできません。したがって、PD メソッドは強化学習アルゴリズムではなくポリシーを学習します。

最近の DeepMind の論文で、研究者らは、PD が試行錯誤によって改善できなかった理由は、トレーニングに使用されたデータが学習の進行状況を示すことができなかったためであると仮説を立てました。現在の方法は、学習を含まないデータ (例: 蒸留による固定エキスパート ポリシー) からポリシーを学習するか、学習を含むデータ (例: RL エージェントのリプレイ バッファ) からポリシーを学習しますが、後者のコンテキスト サイズ (小さすぎる) ポリシーの改善点を把握できません。

論文アドレス: https://arxiv.org/pdf/2210.14215.pdf ##研究者らの主な観察は、RL アルゴリズムのトレーニングにおける学習の逐次的な性質により、原理的には強化学習自体を因果系列予測問題としてモデル化できるということです。具体的には、トランスフォーマーのコンテキストが学習更新によってもたらされるポリシー改善を含めるのに十分な長さである場合、固定ポリシーを表すことができるだけでなく、状態に焦点を当ててポリシー改善アルゴリズムを表すこともできるはずです。 、前のエピソードのアクション、報酬。

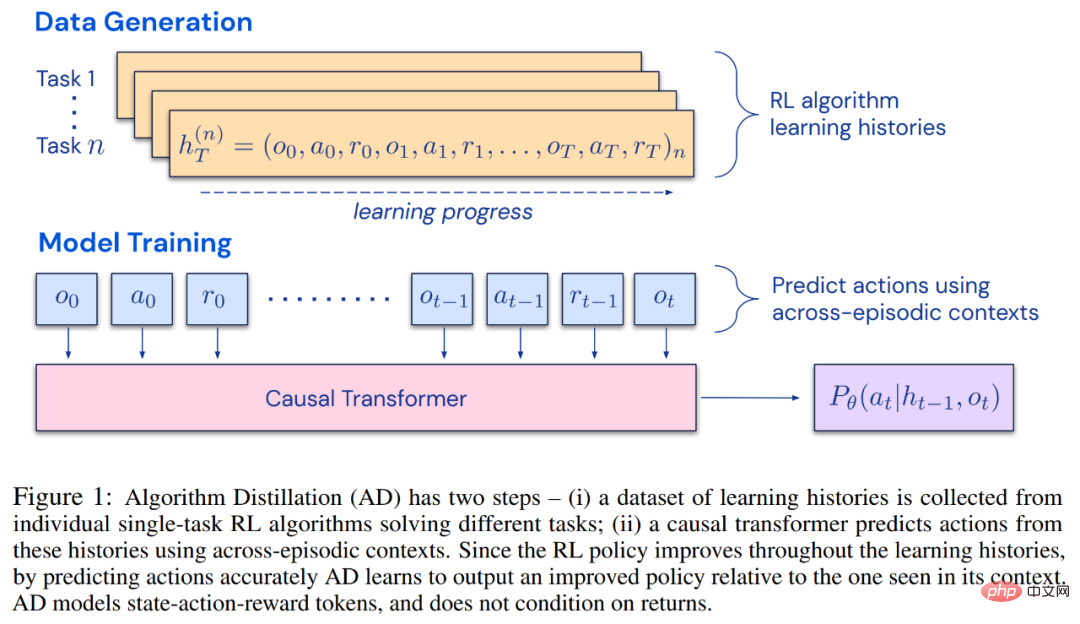

これにより、任意の RL アルゴリズムを模倣学習を通じてトランスフォーマーなどの十分に強力なシーケンス モデルに蒸留でき、これらのモデルをコンテキスト RL アルゴリズムに変換できる可能性が開かれます。 研究者らは、RL アルゴリズム学習履歴における因果シーケンス予測損失を最適化することにより、コンテキスト戦略を学習するための改良された演算子であるアルゴリズム蒸留 (AD) を提案しました。以下の図 1 に示すように、AD は 2 つの部分で構成されます。まず、多数の個別タスクに関する RL アルゴリズムのトレーニング履歴を保存することによって、大規模なマルチタスク データセットが生成されます。次に、トランスフォーマー モデルが、以前の学習履歴をコンテキストとして使用してアクションを因果的にモデル化します。ポリシーはソース RL アルゴリズムのトレーニング中に改善され続けるため、AD はトレーニング履歴の任意の時点でのアクションを正確にモデル化するために、改善された演算子を学習する必要があります。重要なのは、トレーニング データの改善を捉えるために、トランスフォーマー コンテキストが十分に大きい (つまり、エピソード全体にわたって) 必要があることです。

研究者らは、勾配ベースの RL アルゴリズムを模倣するのに十分な大きさのコンテキストを持つ因果変換器を使用することで、AD が新しいタスクを完全に強化できると述べました。文脈の中で勉強してください。私たちは、DMLab のピクセルベースの Watermaze など、探索を必要とする多くの部分的に観察可能な環境で AD を評価し、AD が文脈探索、時間的信頼度の割り当て、一般化が可能であることを示しました。さらに、AD によって学習されたアルゴリズムは、トランスフォーマーのトレーニング ソース データを生成したアルゴリズムよりも効率的です。

研究者らは、勾配ベースの RL アルゴリズムを模倣するのに十分な大きさのコンテキストを持つ因果変換器を使用することで、AD が新しいタスクを完全に強化できると述べました。文脈の中で勉強してください。私たちは、DMLab のピクセルベースの Watermaze など、探索を必要とする多くの部分的に観察可能な環境で AD を評価し、AD が文脈探索、時間的信頼度の割り当て、一般化が可能であることを示しました。さらに、AD によって学習されたアルゴリズムは、トランスフォーマーのトレーニング ソース データを生成したアルゴリズムよりも効率的です。

最後に、AD は、模倣損失を使用してオフライン データを順次モデル化することで、コンテキスト強化学習を実証する最初の手法であることは注目に値します。

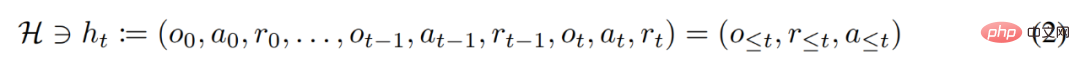

強化学習エージェントは、その有効期間中、複雑なアクションを適切に実行する必要があります。知的エージェントの場合、その環境、内部構造、実行に関係なく、過去の経験に基づいて完成したものとみなすことができます。それは次の形式で表現できます:

研究者はまた、「長い歴史に条件付けされた」戦略をアルゴリズムとみなして、次のように結論付けました。

として表します。学習履歴はアルゴリズム  で表されるため、特定のタスク

で表されるため、特定のタスク  生成されました。

生成されました。

#研究者は、O、A、R などの確率変数を表すためにラテン語の大文字を使用し、それに対応する小文字の o、α を使用します。 、r 。彼らは、アルゴリズムを長期的な履歴条件付きポリシーとみなすことにより、学習履歴を生成するアルゴリズムは、アクションの行動複製を実行することによってニューラル ネットワークに変換できるという仮説を立てました。次に、この研究では、エージェントに行動クローンを使用したシーケンス モデルの生涯学習を提供し、長期履歴を行動分布にマッピングするアプローチを提案しています。

#研究者は、O、A、R などの確率変数を表すためにラテン語の大文字を使用し、それに対応する小文字の o、α を使用します。 、r 。彼らは、アルゴリズムを長期的な履歴条件付きポリシーとみなすことにより、学習履歴を生成するアルゴリズムは、アクションの行動複製を実行することによってニューラル ネットワークに変換できるという仮説を立てました。次に、この研究では、エージェントに行動クローンを使用したシーケンス モデルの生涯学習を提供し、長期履歴を行動分布にマッピングするアプローチを提案しています。

実際の実装

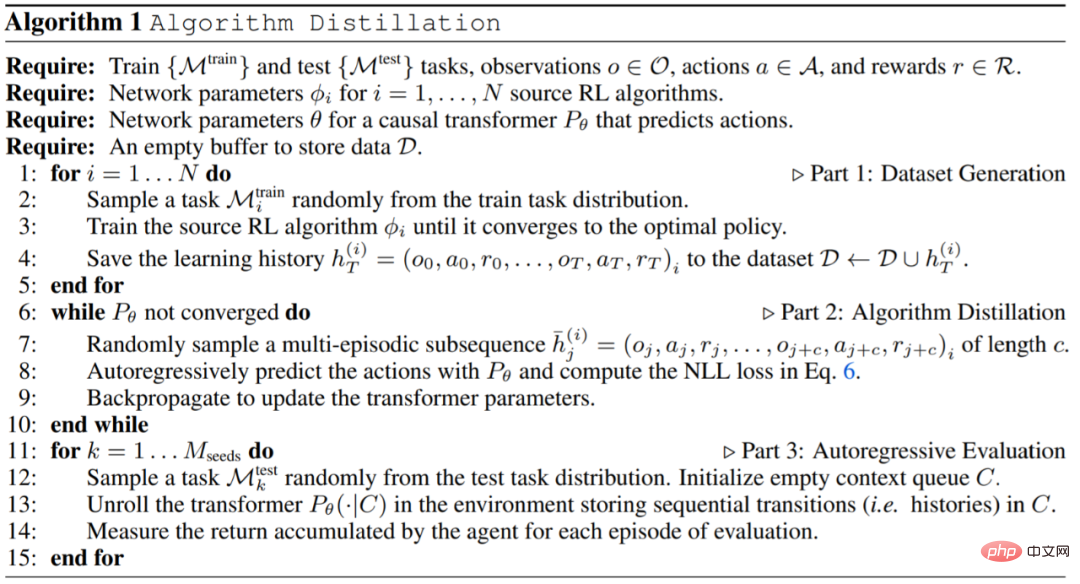

実際には、この研究ではアルゴリズム蒸留 (AD) を 2 段階のプロセスとして実装します。まず、多くの異なるタスクに対して個別の勾配ベースの RL アルゴリズムを実行することによって、学習履歴データセットが収集されます。次に、複数のエピソードのコンテキストを含むシーケンス モデルがトレーニングされ、歴史上のアクションが予測されます。具体的なアルゴリズムは次のとおりです。

実験

実験では、使用する環境が、からは取得できない多くのタスクをサポートしている必要があります。推論は観察から簡単に行うことができ、エピソードは十分に短いため、エピソード間の因果変換を効率的にトレーニングできます。この研究の主な目的は、以前の研究と比較して、AD 強化がコンテキスト内でどの程度学習されるかを調査することでした。実験ではAD、ED(Expert Distillation)、RL^2などを比較しました。

AD、ED、RL^2 の評価結果を図 3 に示します。この研究では、AD と RL^2 の両方が、トレーニング分布からサンプリングされたタスクに関して状況に応じて学習できるのに対し、ED は学習できないことがわかりました。ただし、分布内で評価される場合、ED はランダムな推測よりも優れています。

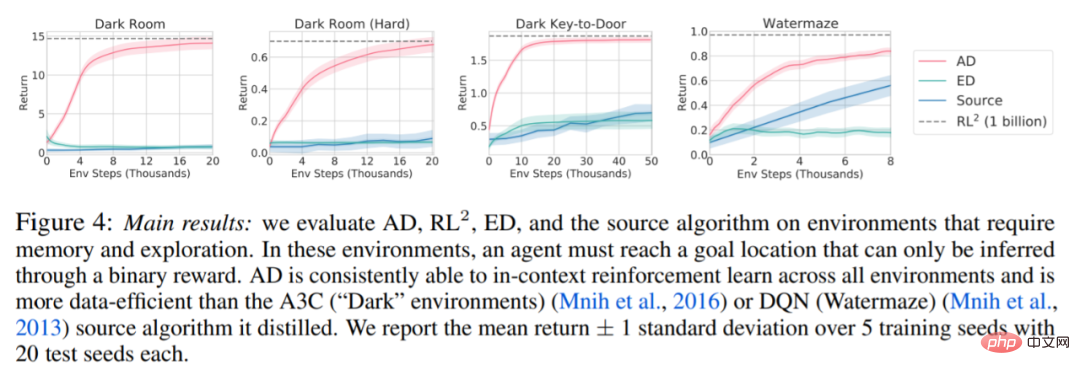

以下の図 4 に関して、研究者は一連の質問に答えました。 AD は文脈強化学習を示しますか?結果は、AD 文脈強化学習はあらゆる環境で学習できるのに対し、ED はほとんどの状況で文脈を探索して学習できないことを示しています。

#AD はピクセルベースの観察から学習できますか?結果は、AD が文脈依存 RL を介してエピソード回帰を最大化するのに対し、ED は学習に失敗することを示しています。

AD ソース データを生成したアルゴリズムよりも効率的な RL アルゴリズムを学習することは可能ですか?結果は、AD のデータ効率がソース アルゴリズム (A3C および DQN) よりも大幅に高いことを示しています。

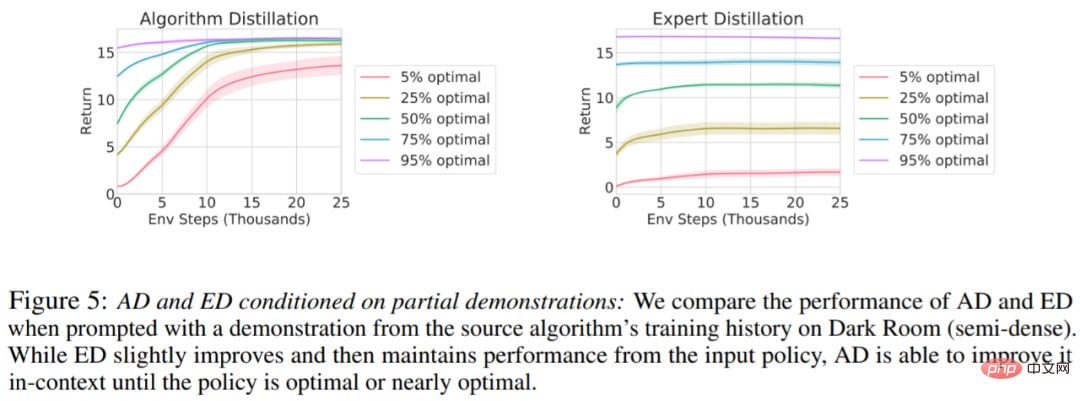

デモで AD を高速化することはできますか?この質問に答えるために、この調査では、ソース アルゴリズムの履歴に沿ったさまざまな時点でのサンプリング戦略をテスト セット データに保持し、この戦略データを使用して AD と ED のコンテキストを事前に設定し、両方のメソッドを実行します。暗室のコンテキストでの結果を図 5 にプロットします。 ED は入力ポリシーのパフォーマンスを維持しますが、AD は最適に近づくまでコンテキスト内の各ポリシーを改善します。重要なのは、入力戦略が最適化されるほど、AD は最適化に達するまで高速に改善されます。

詳細については、原論文を参照してください。

以上がDeepMind の新しい研究: トランスフォーマーは人間の介入なしで自らを改善できるの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7756

7756

15

15

1643

1643

14

14

1399

1399

52

52

1293

1293

25

25

1234

1234

29

29

ddrescue を使用して Linux 上のデータを回復する

Mar 20, 2024 pm 01:37 PM

ddrescue を使用して Linux 上のデータを回復する

Mar 20, 2024 pm 01:37 PM

DDREASE は、ハード ドライブ、SSD、RAM ディスク、CD、DVD、USB ストレージ デバイスなどのファイル デバイスまたはブロック デバイスからデータを回復するためのツールです。あるブロック デバイスから別のブロック デバイスにデータをコピーし、破損したデータ ブロックを残して正常なデータ ブロックのみを移動します。 ddreasue は、回復操作中に干渉を必要としないため、完全に自動化された強力な回復ツールです。さらに、ddasue マップ ファイルのおかげでいつでも停止および再開できます。 DDREASE のその他の主要な機能は次のとおりです。 リカバリされたデータは上書きされませんが、反復リカバリの場合にギャップが埋められます。ただし、ツールに明示的に指示されている場合は切り詰めることができます。複数のファイルまたはブロックから単一のファイルにデータを復元します

オープンソース!ゾーイデプスを超えて! DepthFM: 高速かつ正確な単眼深度推定!

Apr 03, 2024 pm 12:04 PM

オープンソース!ゾーイデプスを超えて! DepthFM: 高速かつ正確な単眼深度推定!

Apr 03, 2024 pm 12:04 PM

0.この記事は何をするのですか?私たちは、多用途かつ高速な最先端の生成単眼深度推定モデルである DepthFM を提案します。従来の深度推定タスクに加えて、DepthFM は深度修復などの下流タスクでも最先端の機能を実証します。 DepthFM は効率的で、いくつかの推論ステップ内で深度マップを合成できます。この作品について一緒に読みましょう〜 1. 論文情報タイトル: DepthFM: FastMonocularDepthEstimationwithFlowMatching 著者: MingGui、JohannesS.Fischer、UlrichPrestel、PingchuanMa、Dmytr

Excelのフィルター機能を複数条件で使う方法

Feb 26, 2024 am 10:19 AM

Excelのフィルター機能を複数条件で使う方法

Feb 26, 2024 am 10:19 AM

Excel で複数の条件によるフィルタリングを使用する方法を知る必要がある場合は、次のチュートリアルで、データを効果的にフィルタリングおよび並べ替えできるようにするための手順を説明します。 Excel のフィルタリング機能は非常に強力で、大量のデータから必要な情報を抽出するのに役立ちます。設定した条件でデータを絞り込み、条件に合致した部分のみを表示することができ、データ管理を効率化できます。フィルター機能を利用すると、目的のデータを素早く見つけることができ、データの検索や整理の時間を節約できます。この機能は、単純なデータ リストに適用できるだけでなく、複数の条件に基づいてフィルタリングすることもできるため、必要な情報をより正確に見つけることができます。全体として、Excel のフィルタリング機能は非常に実用的です。

Google は大喜び: JAX のパフォーマンスが Pytorch や TensorFlow を上回りました! GPU 推論トレーニングの最速の選択肢となる可能性があります

Apr 01, 2024 pm 07:46 PM

Google は大喜び: JAX のパフォーマンスが Pytorch や TensorFlow を上回りました! GPU 推論トレーニングの最速の選択肢となる可能性があります

Apr 01, 2024 pm 07:46 PM

Google が推進する JAX のパフォーマンスは、最近のベンチマーク テストで Pytorch や TensorFlow のパフォーマンスを上回り、7 つの指標で 1 位にランクされました。また、テストは最高の JAX パフォーマンスを備えた TPU では行われませんでした。ただし、開発者の間では、依然として Tensorflow よりも Pytorch の方が人気があります。しかし、将来的には、おそらくより大規模なモデルが JAX プラットフォームに基づいてトレーニングされ、実行されるようになるでしょう。モデル 最近、Keras チームは、ネイティブ PyTorch 実装を使用して 3 つのバックエンド (TensorFlow、JAX、PyTorch) をベンチマークし、TensorFlow を使用して Keras2 をベンチマークしました。まず、主流のセットを選択します

DeepMind ロボットが卓球をすると、フォアハンドとバックハンドが空中に滑り出し、人間の初心者を完全に打ち負かしました

Aug 09, 2024 pm 04:01 PM

DeepMind ロボットが卓球をすると、フォアハンドとバックハンドが空中に滑り出し、人間の初心者を完全に打ち負かしました

Aug 09, 2024 pm 04:01 PM

でももしかしたら公園の老人には勝てないかもしれない?パリオリンピックの真っ最中で、卓球が注目を集めています。同時に、ロボットは卓球のプレーにも新たな進歩をもたらしました。先ほど、DeepMind は、卓球競技において人間のアマチュア選手のレベルに到達できる初の学習ロボット エージェントを提案しました。論文のアドレス: https://arxiv.org/pdf/2408.03906 DeepMind ロボットは卓球でどれくらい優れていますか?おそらく人間のアマチュアプレーヤーと同等です: フォアハンドとバックハンドの両方: 相手はさまざまなプレースタイルを使用しますが、ロボットもそれに耐えることができます: さまざまなスピンでサーブを受ける: ただし、ゲームの激しさはそれほど激しくないようです公園の老人。ロボット、卓球用

iPhoneのセルラーデータインターネット速度が遅い:修正

May 03, 2024 pm 09:01 PM

iPhoneのセルラーデータインターネット速度が遅い:修正

May 03, 2024 pm 09:01 PM

iPhone のモバイル データ接続に遅延や遅い問題が発生していませんか?通常、携帯電話の携帯インターネットの強度は、地域、携帯ネットワークの種類、ローミングの種類などのいくつかの要因によって異なります。より高速で信頼性の高いセルラー インターネット接続を実現するためにできることがいくつかあります。解決策 1 – iPhone を強制的に再起動する 場合によっては、デバイスを強制的に再起動すると、携帯電話接続を含む多くの機能がリセットされるだけです。ステップ 1 – 音量を上げるキーを 1 回押して放します。次に、音量小キーを押して、もう一度放します。ステップ 2 – プロセスの次の部分は、右側のボタンを押し続けることです。 iPhone の再起動が完了するまで待ちます。セルラーデータを有効にし、ネットワーク速度を確認します。もう一度確認してください 修正 2 – データ モードを変更する 5G はより優れたネットワーク速度を提供しますが、信号が弱い場合はより適切に機能します

テスラのロボットは工場で働く、マスク氏:手の自由度は今年22に達する!

May 06, 2024 pm 04:13 PM

テスラのロボットは工場で働く、マスク氏:手の自由度は今年22に達する!

May 06, 2024 pm 04:13 PM

テスラのロボット「オプティマス」の最新映像が公開され、すでに工場内で稼働可能となっている。通常の速度では、バッテリー(テスラの4680バッテリー)を次のように分類します:公式は、20倍の速度でどのように見えるかも公開しました - 小さな「ワークステーション」上で、ピッキング、ピッキング、ピッキング:今回は、それがリリースされたハイライトの1つビデオの内容は、オプティマスが工場内でこの作業を完全に自律的に行い、プロセス全体を通じて人間の介入なしに完了するというものです。そして、オプティマスの観点から見ると、自動エラー修正に重点を置いて、曲がったバッテリーを拾い上げたり配置したりすることもできます。オプティマスのハンドについては、NVIDIA の科学者ジム ファン氏が高く評価しました。オプティマスのハンドは、世界の 5 本指ロボットの 1 つです。最も器用。その手は触覚だけではありません

超知性の生命力が覚醒する!しかし、自己更新 AI の登場により、母親はデータのボトルネックを心配する必要がなくなりました。

Apr 29, 2024 pm 06:55 PM

超知性の生命力が覚醒する!しかし、自己更新 AI の登場により、母親はデータのボトルネックを心配する必要がなくなりました。

Apr 29, 2024 pm 06:55 PM

世界は狂ったように大きなモデルを構築していますが、インターネット上のデータだけではまったく不十分です。このトレーニング モデルは「ハンガー ゲーム」のようであり、世界中の AI 研究者は、データを貪欲に食べる人たちにどのように餌を与えるかを心配しています。この問題は、マルチモーダル タスクで特に顕著です。何もできなかった当時、中国人民大学学部のスタートアップチームは、独自の新しいモデルを使用して、中国で初めて「モデル生成データフィード自体」を実現しました。さらに、これは理解側と生成側の 2 つの側面からのアプローチであり、両方の側で高品質のマルチモーダルな新しいデータを生成し、モデル自体にデータのフィードバックを提供できます。モデルとは何ですか? Awaker 1.0 は、中関村フォーラムに登場したばかりの大型マルチモーダル モデルです。チームは誰ですか?ソフォンエンジン。人民大学ヒルハウス人工知能大学院の博士課程学生、ガオ・イージャオ氏によって設立されました。