20 年の IT ベテランが ChatGPT を使用してドメイン知識を作成する方法を共有します

著者 | Cui Hao

査読者| Chonglou

要約

革新的なテクノロジー アップグレード、ChatGPT 4.0 のリリースは AI 全体に衝撃を与えました業界。現在、ChatGPT は、コンピュータが日常の自然言語の質問を認識して答えることができるだけでなく、業界データをモデル化することで、より正確なソリューションを提供することもできます。この記事では、ChatGPT のアーキテクチャ原則 とその開発見通し を深く理解するとともに、その使用方法についても紹介します。業界データをトレーニングするための ChatGPT の API。この新しく有望な分野を一緒に探索し、AI の新時代を築きましょう。

#ChatGPT 4.0 のリリースChatGPT 4.0 が正式にリリースされました。 ChatGPT のこのバージョンでは、飛躍的な革新が導入されており、以前の ChatGPT 3.5 と比較して、モデルのパフォーマンスと速度が大幅に向上しています。 ChatGPT 4.0 がリリースされる前から、多くの人が ChatGPT に注目し、自然言語処理の分野におけるその重要性を認識していました。ただし、3.5 および以前の バージョンでは、ChatGPT のトレーニング データが主に一般的なドメインに集中しているため、ChatGPT の制限が依然として存在します。言語モデルが異なるため、特定の業界に関連したコンテンツを生成するのは困難です。しかし、ChatGPT 4.0 のリリースにより、独自の業界データをトレーニングするために ChatGPT 4.0 を使用する人が増え、さまざまな業界で広く使用されるようになりました。 これにより、ますます多くの人が ChatGPT に注目し、使用するようになりました。次に、アーキテクチャの原則、開発の見通し、業界データのトレーニングにおける ChatGPT の応用について紹介します。 ChatGPT の機能

ChatGPT## アーキテクチャ# は、自然言語処理技術である深層学習ニューラル ネットワークに基づいており、その原理は、事前にトレーニングされた大規模な言語モデルを使用してテキストを生成することです。自然言語を理解して生成します。 ChatGPT のモデル原理は、教師なし言語モデリング技術を使用してトレーニングされ、次の単語の確率分布を予測して連続テキストを生成する Transformer ネットワークに基づいています。使用されるパラメータには、ネットワークの層の数、各層のニューロンの数、ドロップアウト確率、バッチ サイズなどが含まれます。学習の範囲には、一般的な言語モデルとドメイン固有の言語モデルが含まれます。ドメイン一般モデルはさまざまなテキストの生成に使用でき、ドメイン固有モデルは特定のタスクに合わせて微調整および最適化できます。 OpenAI は、GPT-3 のトレーニング データとして大量のテキスト データを使用します。具体的には、45 TB を超える英語テキスト データと、Web テキスト、電子書籍、百科事典、Wikipedia、フォーラム、ブログなどを含むその他の言語データが使用されました。また、Common Crawl、WebText、BooksCorpus などの非常に大規模なデータ セットも使用しました。これらのデータ セットには数兆の単語と数十億の異なる文が含まれており、モデルのトレーニングに非常に豊富な情報を提供します。

非常に多くのコンテンツを学習する必要があるため、使用されるコンピューティング能力もかなりのものになります。

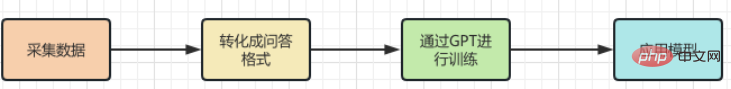

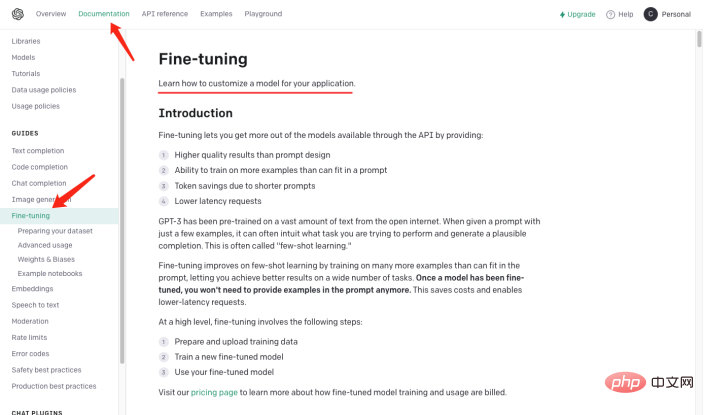

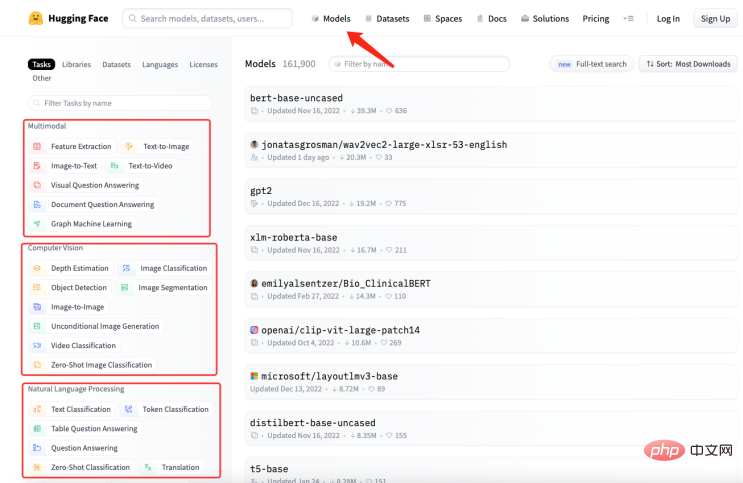

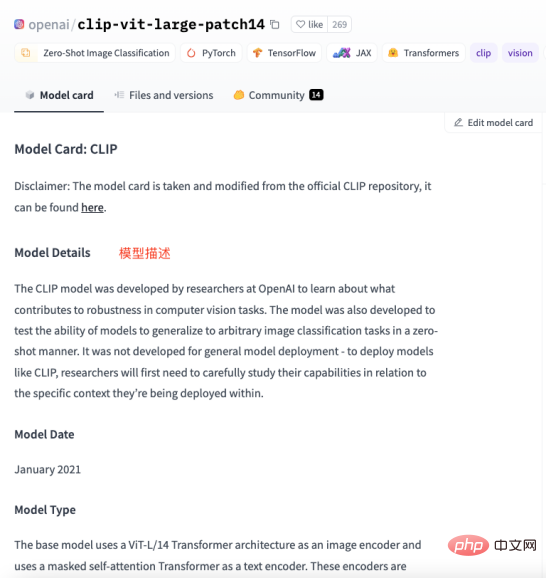

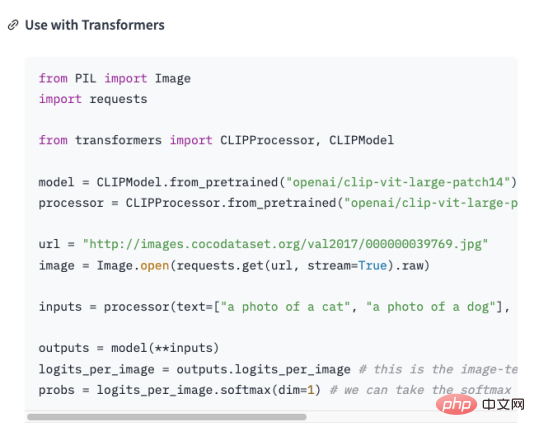

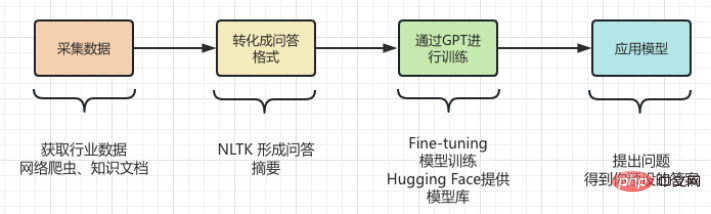

ChatGPT は比較的高いコンピューティング能力を消費し、トレーニングに大量の GPU リソースを必要とします。 2020 年の OpenAI による技術レポートによると、GPT-3 はトレーニング中に約 175 億個のパラメータと 28,500 個の TPU v3 プロセッサを消費しました。 #上記の紹介から# 、ChatGPT には強力な機能があり、必要な機能も# であることがわかりました。 # 膨大な計算とリソースの消費、トレーニング#this 大規模な言語モデル 高額なコストが必要です。 #しかし、このような高コストで作成された AIGC ツールは、## 存在します#制限##,##特定の専門分野についての知識がありません 参加してください。たとえば、医学や法律などの専門分野に関しては、ChatGPT は正確な回答を生成できません。これは、ChatGPT の学習データはインターネット上の一般的なコーパスから取得したものであり、特定分野の専門用語や知識が含まれていないためです。したがって、特定の専門分野で ChatGPT のパフォーマンスを向上させたい場合は、その分野の専門コーパスをトレーニングに使用する必要があります。Knowledge" ChatGPT を教えて、 を学習します。 しかし、ChatGPT は私たちを失望させませんでした。 ChatGPT を特定の業界に適用する場合、まずその業界の専門的なデータを抽出し、前処理を行う必要があります。具体的には、データのクリーニング、重複排除、セグメンテーション、ラベル付けなどの一連の処理を行う必要があります。その後、処理されたデータはフォーマットされ、ChatGPT モデルの入力要件を満たすデータ形式に変換されます。その後、ChatGPT の API インターフェイスを使用して、処理されたデータをトレーニング用のモデルに入力できます。トレーニングにかかる時間とコストは、データ量とコンピューティング能力によって異なります。トレーニングが完了したら、モデルを実際のシナリオに適用してユーザーの質問に答えることができます。 ChatGPT を使用して専門分野の知識をトレーニングしましょう。 実際、専門分野で知識ベースを確立することは難しくありません。 業界データ # を質疑応答形式 # その後 自然言語処理 (NLP) テクノロジーを使用して質問と回答の形式をモデル化します 質問の質問に答えます。 OpenAI の GPT-3 API の使用 (GPT3 例)いくつかの例を提供するだけで、提供された質問に基づいて回答を生成できる質問と回答のモデルを作成できます。 GPT-3 API を使用して質問と回答モデルを作成する一般的な手順は次のとおりです。 : 。# は、開発者プラン、実稼働プラン、カスタム プランなど、さまざまなタイプの API サブスクリプション プランを提供します。各プランは異なる機能と API アクセスを提供し、価格も異なります。 はこの記事の焦点ではないため、ここでは詳しく説明しません。 データセットの作成上記の手順から、2 段階の変換が行われますQ&A形式にすることは私たちにとって挑戦でした。 には # があると仮定します。 # を GPT,## に教える必要があります#そして、この知識を、関連する質問に答える モデルに変換します。 次に、次の形式に変換する必要があります。: ##もちろん、単に質問と回答の形式にまとめるだけでは十分ではなく、以下に示すように GPT が理解できる形式にする必要があります。 : 実際には、質問 # の後に「\n\n」## が追加されます。 、、回答 の後に「\n##」を追加しました###################。 質問と回答の形式を迅速に生成するモデル # が問題を解決します質問と回答形式の、新しい質問がまた出てきました。業界の知識を質問と回答形式に整理するにはどうすればよいでしょうか。 多くの場合、インターネットから大量のドメイン知識をクロールしたり、大量のドメイン文書を見つけたりしますが、どのような場合でも、文書を入力するのが最も便利です。 . .ただし、正規表現や手動の方法を使用して大量のテキストを質問と回答の形式に処理するのは明らかに非現実的です。 したがって、というメソッドを導入する必要があります。 自動要約には、抽出的自動要約と生成的自動要約の 2 種類があります。抽出型自動要約は原文から最も代表的な文を抽出して要約を生成するのに対し、生成的自動要約はモデル学習により原文から重要な情報を抽出し、その情報に基づいて要約を生成します。 自動要約は、入力されたテキストから質問と回答のモードを生成することです。 #問題が明確になったら、次のステップはツールをインストールすることです。 NLTK Natural Language Toolkitの略で、主に自然言語処理の分野で使われるPythonライブラリです。これには、テキストの前処理、品詞タグ付け、固有表現認識、構文分析、感情分析など、自然言語を処理するためのさまざまなツールとライブラリが含まれています。 #テキストを NLTK に渡すだけで、NLTK がデータの前処理操作を実行します。テキスト。ストップワードの削除、単語の分割、品詞のタグ付けなどが含まれます。前処理後、NLTK のテキスト要約生成モジュールを使用して要約を生成できます。単語頻度に基づくもの、TF-IDF に基づくものなど、さまざまなアルゴリズムを選択できます。概要を生成する際、質問テンプレートを組み合わせて質問と回答の概要を生成することができ、生成された概要がより読みやすく理解しやすくなります。同時に、要約の微調整も可能で、文章が一貫していない、回答が不正確であるなどを調整することができます。 #次のコードを見てください。#:# ####################### #nltk をインポート テキストを入力してください #text = """Natural Language Toolkit (NLTK) は、次のような人間の言語データ処理の問題を解決するために使用される Python ライブラリのセットです。 ##分詞 構文解析 ##感情分析 セマンティック分析 ##音声認識 テキスト生成など "" # 概要の生成 文 = nltk.sent_tokenize(text) ##summary = " ".join(sentences[:2]) # 最初の 2 つの文を要約として取得します print("概要:", 概要) ## ################################## # 生成された概要を使用して、Fine-t#早速、モデルを入手してください ##tokenizer = AutoTokenizer.from_pretrained("t5-base ") text = "要約: "概要 # 入力形式の構築 ##inputs = tokenizer(text、return_tensors="pt"、padding=True)

#model_name = "最初のモデル" #qa = パイプライン("質問応答", モデル=モデル名, トークナイザー=モデル名) context = "NLTK は何に使用されますか?" # 回答すべき質問 ##answer = qa(questinotallow=context, cnotallow= text["input_ids"]) print("質問:", context) print("答え: ", 答え["答え"]) # 出力結果は次のとおりです。 ##要約: Natural Language Toolkit (NLTK) は、次のような人間の言語データ処理の問題を解決するために使用される Python ライブラリのセットです。 - 単語のセグメンテーション -品詞のタグ付け #質問 : NLTK何に使用されますか? 答え:自然言語処理ツールキット # ############################# 上記のコードは、nltk.sent_tokenize メソッドを使用して入力テキストの概要を抽出します。つまり、質問と回答をフォーマットします。次に、、 は F# # を呼び出します。 ine-tuning の AutoModelForSeq2SeqLM.from_pretrained メソッドはそれをモデル化し、次に「first-model」という名前のモデルを変更して保存します。最後に、トレーニングされたモデルを呼び出して結果をテストします。 上記は単に通過するだけではありませんNLTK 質問と回答の概要を生成するには、F## も使用する必要があります。 #ine- tuning 関数。 Fine-tuning は、事前トレーニングされたモデルに基づいており、少量のラベル付きデータを通じてモデルを微調整します。特定のタスクに適応します#。 実際には、# は、元のモデルを使用してデータをインストールし、モデルを形成することです。もちろん、内部の設定を調整することもできます。モデルの結果 (隠れ層の設定やパラメータなど)ここでは、その最も単純な関数 #, を使用します。 Fine-tuning について詳しくは、以下の画像をご覧ください。 注意してください。 :AutoModelForSeq2SeqLM クラスは、事前トレーニング済みモデル「t5-base」から TOKenizer とモデルを読み込みます。 AutoTokenizer は、適切な # を自動的に選択してロードできる、Hugging Face Transformers ライブラリのクラスです。 ##Tオケナイザー。 T オケナイザーの機能は、入力テキストを、後続のモデル入力のためにモデルが理解できる形式にエンコードすることです。 AutoModelForSeq2SeqLM は、事前トレーニングされたモデルに基づいて適切なシーケンスを自動的に選択してシーケンス モデルにロードする、Hugging Face Transformers ライブラリのクラスでもあります。ここでは、T5 アーキテクチャに基づくシーケンスツーシーケンス モデルが、要約や翻訳などのタスクに使用されます。事前トレーニングされたモデルを読み込んだ後、このモデルを F 微調整またはタスク関連の出力の生成に使用できます。 Fine-##チューニングとハギング#を含む、上記のモデリング コードについて説明しました。 ##「顔」に関する部分はわかりにくいかもしれません。理解を助けるための例を次に示します。 あなたは料理をしたいと思っていますが、材料(業界知識)はすでにあるのに、作り方がわからない。そこで あなたはシェフの友人 にアドバイスを求め、自分が持っている材料 (業界の知識) とどのような料理を作りたいかを伝えます。料理人 (解決済みの質問)、あなたの友人 は、彼の経験と知識に基づいて ## を教えてくれます (一般的な質問)モデル) #いくつかの提案を提供してください、このプロセスはFineです-チューニング (業界の知識をトレーニング用の一般的なモデルに組み込む) 。 あなたの 友人の経験と知識 は 事前トレーニングされたモデル、業界の知識と解決すべき問題を入力し、事前トレーニングされたモデルを使用する必要があります。 モデル もちろん、調味料の内容や調理の火力など、細かく調整することができ、業界の課題解決を目的としています。 。 そして、Hugging Face はレシピの倉庫です (コード内の「t5-base」はRecipe) には、魚風味の細切り豚肉、クンパオチキン、茹でた豚肉のスライスなど、多くの定義されたレシピ (モデル) が含まれています。これらの既製のレシピを使用して、提供された材料と調理する必要がある料理に基づいてレシピを作成できます。これらのレシピを調整してトレーニングするだけで、 shape が独自のレシピになります。これからは、, 独自のレシピを使って料理をすることができます (業界の問題を解決できます)。 自分に合ったモデルを選択するにはどうすればよいですか? Hugging Face のモデル ライブラリで必要なモデルを検索できます。下図のように、ハグフェイスの公式サイトで「モデル」をクリックするとモデルの分類が表示され、検索ボックスを使用してモデル名を検索することもできます。 #以下の図に示すように、各モデル ページには、モデルの説明、使用例、事前トレーニング重みのダウンロード リンク、その他の関連情報が表示されます。 。 ここでは、収集、変換、トレーニング、全員への利用に至るまでの業界知識のプロセス全体を説明します。以下の図に示すように: ##Cui Hao は、51CTO コミュニティ編集者、シニア アーキテクトであり、ソフトウェア開発とアーキテクチャで 18 年の経験があり、分散アーキテクチャで 10 年の経験があります。 ChatGPT は専門分野でどのような応用が可能ですか?

##人工知能の歴史とは何ですか? \n\n人工知能は 1950 年代に誕生し、コンピューターが人間のように考え、行動できるようにする方法を研究することを目的としたコンピューター サイエンスの一分野です。 \n

## テスト モデル

微調整と顔のハグにはどのような関係がありますか?

##データの収集: Web クローラーとナレッジ ドキュメントを介して業界の知識を抽出し、文字列などのテキストを生成します。

以上が20 年の IT ベテランが ChatGPT を使用してドメイン知識を作成する方法を共有しますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7465

7465

15

15

1376

1376

52

52

77

77

11

11

18

18

19

19

ChatGPT では、無料ユーザーが 1 日あたりの制限付きで DALL-E 3 を使用して画像を生成できるようになりました

Aug 09, 2024 pm 09:37 PM

ChatGPT では、無料ユーザーが 1 日あたりの制限付きで DALL-E 3 を使用して画像を生成できるようになりました

Aug 09, 2024 pm 09:37 PM

DALL-E 3は、前モデルより大幅に改良されたモデルとして2023年9月に正式導入されました。これは、複雑な詳細を含む画像を作成できる、これまでで最高の AI 画像ジェネレーターの 1 つと考えられています。ただし、発売当初は対象外でした

Bytedance Cutting が SVIP スーパー メンバーシップを開始: 継続的な年間サブスクリプションは 499 元で、さまざまな AI 機能を提供

Jun 28, 2024 am 03:51 AM

Bytedance Cutting が SVIP スーパー メンバーシップを開始: 継続的な年間サブスクリプションは 499 元で、さまざまな AI 機能を提供

Jun 28, 2024 am 03:51 AM

このサイトは6月27日、JianyingはByteDanceの子会社であるFaceMeng Technologyによって開発されたビデオ編集ソフトウェアであり、Douyinプラットフォームに依存しており、基本的にプラットフォームのユーザー向けに短いビデオコンテンツを作成すると報告しました。 Windows、MacOS、その他のオペレーティング システム。 Jianyingは会員システムのアップグレードを正式に発表し、インテリジェント翻訳、インテリジェントハイライト、インテリジェントパッケージング、デジタルヒューマン合成などのさまざまなAIブラックテクノロジーを含む新しいSVIPを開始しました。価格的には、クリッピングSVIPの月額料金は79元、年会費は599元(当サイト注:月額49.9元に相当)、継続月額サブスクリプションは月額59元、継続年間サブスクリプションは、年間499元(月額41.6元に相当)です。さらに、カット担当者は、ユーザーエクスペリエンスを向上させるために、オリジナルのVIPに登録している人は、

Rag と Sem-Rag を使用したコンテキスト拡張 AI コーディング アシスタント

Jun 10, 2024 am 11:08 AM

Rag と Sem-Rag を使用したコンテキスト拡張 AI コーディング アシスタント

Jun 10, 2024 am 11:08 AM

検索強化生成およびセマンティック メモリを AI コーディング アシスタントに組み込むことで、開発者の生産性、効率、精度を向上させます。 JanakiramMSV 著者の EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG から翻訳。基本的な AI プログラミング アシスタントは当然役に立ちますが、ソフトウェア言語とソフトウェア作成の最も一般的なパターンに関する一般的な理解に依存しているため、最も適切で正しいコードの提案を提供できないことがよくあります。これらのコーディング アシスタントによって生成されたコードは、彼らが解決する責任を負っている問題の解決には適していますが、多くの場合、個々のチームのコーディング標準、規約、スタイルには準拠していません。これにより、コードがアプリケーションに受け入れられるように修正または調整する必要がある提案が得られることがよくあります。

微調整によって本当に LLM が新しいことを学習できるようになるのでしょうか: 新しい知識を導入すると、モデルがより多くの幻覚を生成する可能性があります

Jun 11, 2024 pm 03:57 PM

微調整によって本当に LLM が新しいことを学習できるようになるのでしょうか: 新しい知識を導入すると、モデルがより多くの幻覚を生成する可能性があります

Jun 11, 2024 pm 03:57 PM

大規模言語モデル (LLM) は巨大なテキスト データベースでトレーニングされ、そこで大量の現実世界の知識を取得します。この知識はパラメータに組み込まれており、必要なときに使用できます。これらのモデルの知識は、トレーニングの終了時に「具体化」されます。事前トレーニングの終了時に、モデルは実際に学習を停止します。モデルを調整または微調整して、この知識を活用し、ユーザーの質問により自然に応答する方法を学びます。ただし、モデルの知識だけでは不十分な場合があり、モデルは RAG を通じて外部コンテンツにアクセスできますが、微調整を通じてモデルを新しいドメインに適応させることが有益であると考えられます。この微調整は、ヒューマン アノテーターまたは他の LLM 作成物からの入力を使用して実行され、モデルは追加の実世界の知識に遭遇し、それを統合します。

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

編集者 |ScienceAI 質問応答 (QA) データセットは、自然言語処理 (NLP) 研究を促進する上で重要な役割を果たします。高品質の QA データ セットは、モデルの微調整に使用できるだけでなく、大規模言語モデル (LLM) の機能、特に科学的知識を理解し推論する能力を効果的に評価することもできます。現在、医学、化学、生物学、その他の分野をカバーする多くの科学 QA データ セットがありますが、これらのデータ セットにはまだいくつかの欠点があります。まず、データ形式は比較的単純で、そのほとんどが多肢選択式の質問であり、評価は簡単ですが、モデルの回答選択範囲が制限され、科学的な質問に回答するモデルの能力を完全にテストすることはできません。対照的に、自由回答型の Q&A

SOTA パフォーマンス、厦門マルチモーダルタンパク質-リガンド親和性予測 AI 手法、初めて分子表面情報を結合

Jul 17, 2024 pm 06:37 PM

SOTA パフォーマンス、厦門マルチモーダルタンパク質-リガンド親和性予測 AI 手法、初めて分子表面情報を結合

Jul 17, 2024 pm 06:37 PM

編集者 | KX 医薬品の研究開発の分野では、タンパク質とリガンドの結合親和性を正確かつ効果的に予測することが、医薬品のスクリーニングと最適化にとって重要です。しかし、現在の研究では、タンパク質とリガンドの相互作用における分子表面情報の重要な役割が考慮されていません。これに基づいて、アモイ大学の研究者らは、初めてタンパク質の表面、3D 構造、配列に関する情報を組み合わせ、クロスアテンション メカニズムを使用して異なるモダリティの特徴を比較する、新しいマルチモーダル特徴抽出 (MFE) フレームワークを提案しました。アライメント。実験結果は、この方法がタンパク質-リガンド結合親和性の予測において最先端の性能を達成することを実証しています。さらに、アブレーション研究は、この枠組み内でのタンパク質表面情報と多峰性特徴の位置合わせの有効性と必要性を実証しています。 「S」で始まる関連研究

AIなどの市場を開拓するグローバルファウンドリーズがタゴール・テクノロジーの窒化ガリウム技術と関連チームを買収

Jul 15, 2024 pm 12:21 PM

AIなどの市場を開拓するグローバルファウンドリーズがタゴール・テクノロジーの窒化ガリウム技術と関連チームを買収

Jul 15, 2024 pm 12:21 PM

7月5日のこのウェブサイトのニュースによると、グローバルファウンドリーズは今年7月1日にプレスリリースを発行し、自動車とインターネットでの市場シェア拡大を目指してタゴール・テクノロジーのパワー窒化ガリウム(GaN)技術と知的財産ポートフォリオを買収したことを発表した。モノと人工知能データセンターのアプリケーション分野で、より高い効率とより優れたパフォーマンスを探求します。生成 AI などのテクノロジーがデジタル世界で発展を続ける中、窒化ガリウム (GaN) は、特にデータセンターにおいて、持続可能で効率的な電力管理のための重要なソリューションとなっています。このウェブサイトは、この買収中にタゴール・テクノロジーのエンジニアリングチームがGLOBALFOUNDRIESに加わり、窒化ガリウム技術をさらに開発するという公式発表を引用した。 G

SKハイニックスは8月6日に12層HBM3E、321層NANDなどのAI関連新製品を展示する。

Aug 01, 2024 pm 09:40 PM

SKハイニックスは8月6日に12層HBM3E、321層NANDなどのAI関連新製品を展示する。

Aug 01, 2024 pm 09:40 PM

8月1日の本サイトのニュースによると、SKハイニックスは本日(8月1日)ブログ投稿を発表し、8月6日から8日まで米国カリフォルニア州サンタクララで開催されるグローバル半導体メモリサミットFMS2024に参加すると発表し、多くの新世代の製品。フューチャー メモリおよびストレージ サミット (FutureMemoryandStorage) の紹介。以前は主に NAND サプライヤー向けのフラッシュ メモリ サミット (FlashMemorySummit) でしたが、人工知能技術への注目の高まりを背景に、今年はフューチャー メモリおよびストレージ サミット (FutureMemoryandStorage) に名前が変更されました。 DRAM およびストレージ ベンダー、さらに多くのプレーヤーを招待します。昨年発売された新製品SKハイニックス