ディープ ニューラル ネットワーク (DNN) は、融資の承認、求職の申し込み、裁判所の保釈の承認などを決定するために使用されます。人々の利益や生死にかかわる決断 (高速道路での急停止など) に密接に関係している場合、単に予測スコアを生成するのではなく、これらの決断を説明することが重要です。

説明可能な人工知能 (XAI) の研究は、最近反事実例の概念に焦点を当てています。アイデアは単純です。まず、予想される出力を持つ反事実の例をいくつか作成し、それらを元のネットワークにフィードします。次に、隠れ層ユニットを読み取って、ネットワークが他の出力を生成した理由を説明します。より正式には:

「変数 V にはそれに関連付けられた値 (v1, v2, ...) があるため、分数 p が返されます。V に値 (v'1 がある場合) 、v '2、...)、その他すべての変数は変更されず、スコア p' が返されます。"

以下はより具体的な例です:

「あなたの年収が 30,000 ポンドだったので、融資を拒否されました。年収が 45,000 ポンドであれば、融資を受けることができます。」

しかし、 Browne と Swift による論文 [1] (以下、B&W) は最近、反事実の例は、入力に対して小さく観察できない摂動を実行することによって生成された、わずかに意味のある敵対的な例にすぎず、その結果、ネットワークがそれらを高い信頼度で誤分類することを示しました。

さらに、反事実の例は、正しい予測を得るためにいくつかの特徴がどのようなものであるべきかを「説明」していますが、「ブラックボックスを開けない」、つまりアルゴリズムがどのように機能するかを説明していません。 。 の。記事は続けて、反事実の例は解釈可能性に対する解決策を提供せず、「意味論がなければ説明はできない」と主張している。

実際、この記事はさらに強力な提案をしています:

1) 存在すると想定されているものを抽出する方法を見つけるか、ネットワークの隠れ層のセマンティクスは、

2) のいずれかで失敗を認めています。

そして、Walid S. Saba 自身も (1) については悲観的、つまり残念ながら失敗を認めており、その理由は次のとおりです。

一般大衆は「意味論なしには説明できない」という B&W の見解に完全に同意していますが、しかし、ディープ ニューラル ネットワークの隠れ層表現のセマンティクスを解釈して深層学習システムの満足のいく説明を生成するという希望は、30 年以上前に Fodor と Pylyshyn によって概説された理由により実現されていないと著者らは考えています [2] 。

Walid S. Saba 氏は次のように主張しました: 問題がどこにあるかを説明する前に、純粋に拡張的なモデル (ニューラル ネットワークなど) では系統性を説明できず、構成性がモデル化されるのは、派生可能な構文と対応するセマンティクスを持つシンボリック構造を認識しません。

したがって、ニューラル ネットワークの表現は、実際には解釈可能なものに対応する「シンボル」ではなく、分散され、相関し、連続した数値そのものであり、それ自体は何の意味も持ちません。概念的に説明できます。

簡単に言えば、ニューラル ネットワークの部分記号表現自体は、人間が概念的に理解できるものを指しません (隠れたユニット自体は、形而上学的な意味のオブジェクトを表すことができません)。むしろ、これは通常、何らかの顕著な特徴 (猫のひげなど) を一緒に表す一連の隠れた単位です。

しかし、まさにこれが、ニューラル ネットワークが解釈可能性を達成できない理由です。つまり、いくつかの隠れた特徴の組み合わせが決定不可能であるためです。組み合わせが (何らかの線形結合関数によって) 完了すると、単一のユニットになります。は失われます(以下に示します)。

著者は、Fodor と Pylysyn が次の結論に達した理由について論じています。 NN は体系的な (したがって解釈可能な) 推論をモデル化できません [2]。

シンボリック システムには、構成要素の意味に基づいて複合語の意味を計算する、明確に定義された組み合わせ意味関数があります。しかし、この組み合わせは可逆的です。つまり、その出力を生成する (入力) コンポーネントをいつでも取得できます。これはまさに、記号システムでは、コンポーネントがどのように組み立てられるかのマップを含む「構文構造」にアクセスできるためです。 NN ではこれはどれも当てはまりません。ベクトル (テンソル) が NN で結合されると、その分解を決定することはできません (ベクトル (スカラーを含む) を分解する方法は無限です!)

これがなぜなのかを説明すると、問題 本質的には、解釈可能性を実現するために DNN でセマンティクスを抽出するという B&W の提案を考えてみましょう。 B&W では、次のガイドラインに従うことをお勧めします。

通常、ホイールキャップを活性化する隠れニューロン 41435 の活性化値が 0.32 であるため、入力画像には「アーキテクチャ」というラベルが付けられています。隠れニューロン 41435 の活性化値が 0.87 の場合、入力画像には「車」というラベルが付けられます。

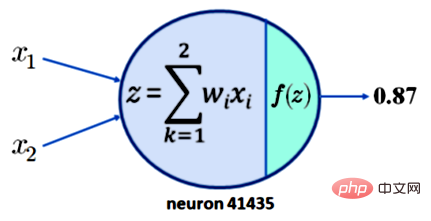

なぜこれが解釈可能性につながらないのかを理解するには、ニューロン 41435 の活性化が 0.87 であることを要求するだけでは十分ではないことに注意してください。簡単にするために、ニューロン 41435 には x1 と x2 の 2 つの入力だけがあると仮定します。現在の結果を以下の図 1 に示します。

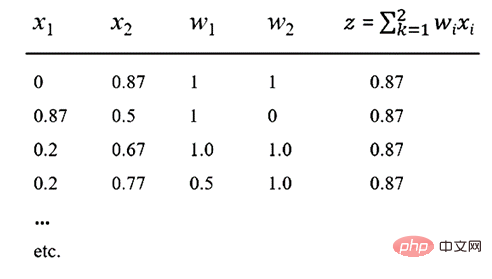

#ここで、活性化関数 f が一般的な ReLU 関数であると仮定すると、z = 0.87 の出力を生成できます。これは、下表に示す x1、x2、w1、w2 の値に対して、0.87 の出力が得られることを意味します。

#表の注: 複数の入力方法により、値 0.87

# # が生成される場合があります。 # 上の表を見ると、0.87 の出力を生成する x1、x2、w1、および w2 の線形結合が無数にあることが簡単にわかります。ここで重要な点は、NN の構成性は不可逆的であるため、意味のあるセマンティクスをニューロンまたはニューロンの集合から取得することはできないということです。

3. DNN の構成性は不可逆的です[2]############=> DNN は (XAI なしでは) 説明できません############終わり 。 ############ところで、DNN の構成性が不可逆であるという事実は、特により高度な推論が必要な場合に、解釈可能な予測を生成できないこと以外にも影響を及ぼします。 (NLU)。 ############特に、このようなシステムでは、子供が (### ### ###) のようなテンプレートだけから無限の数の文を解釈する方法をどのようにして学習できるのかを実際には説明できません。なぜなら、「ジョン」、「近所の女の子」、「いつも T シャツを着てここに来る男の子」などはすべて ### のインスタンス化の可能性があるだけでなく、「クラシック ロック」、「名声」、「メアリーのおばあちゃん」も同様だからです。 「」、「ビーチで走っている」などは、すべて ### の例として考えられます。 ############このようなシステムには「記憶」がなく、その構成を元に戻すことはできないため、理論上、この単純な構造を学習するには無数の例が必要です。 [編集者注: この点はまさにチョムスキーの構造言語学に対する疑問であり、したがって、半世紀以上にわたって言語学に影響を与えてきた変革的な生成文法を開始しました。 ]######

最後に、著者は、30 年以上前に、Fodor と Pylyshyn [2] が認知アーキテクチャとしての NN に対する批判を提起したことを強調します - 彼らは、なぜ NN が体系性、生産性、構成を構築できないのかを示しました。これは「意味論的」なことについて語るのに必要なことですが、この説得力のある批判には完全に答えられたことはありません。

AI における説明可能性の問題を解決する必要性が重要になるにつれ、統計的パターン認識が人工知能の進歩の限界とどのように同一視されるかを示した古典的な論文を再検討する必要があります。

以上がニューラル ネットワークの解釈可能性の問題: 30 年前の NN 批判を再考するの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。