Stable Diffusion を作成した会社は大規模な言語モデルも作成しており、その効果はかなり良好です。水曜日、StableLM のリリースはテクノロジー界の注目を集めました。

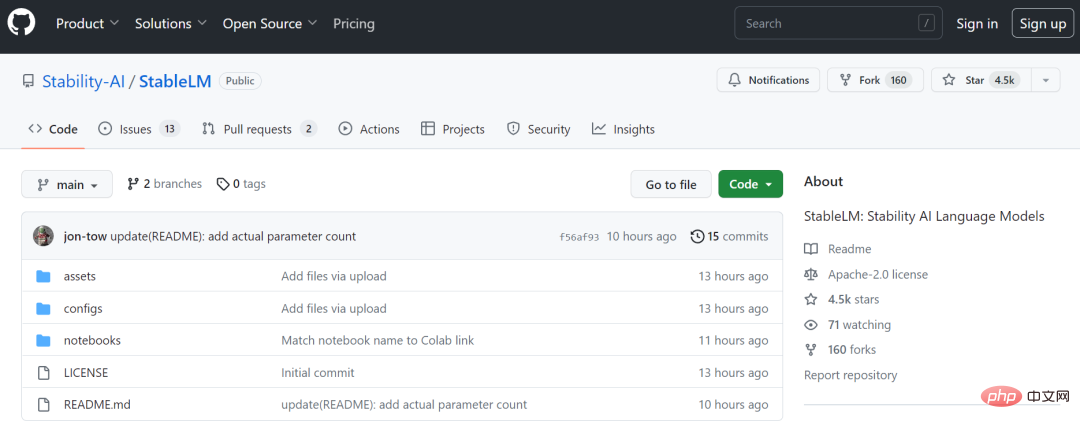

Stability AI は、オープンソースの AI 描画ツール Stable Diffusion が好評を博し、最近勢いを増しているスタートアップです。同社は水曜日のリリースで、開発者が GitHub 上で使用および適応できるように、この言語の大規模モデルが利用できるようになったと発表しました。

業界ベンチマークである ChatGPT と同様に、StableLM はテキストとコードを効率的に生成するように設計されています。これは、Wikipedia、Stack Exchange、PubMed などのさまざまなソースからの情報を含む、Pile と呼ばれるオープン ソース データセットのより大きなバージョンでトレーニングされ、容量 825 GB と 1 兆 5,000 億トークンの合計 22 のデータセットになります。

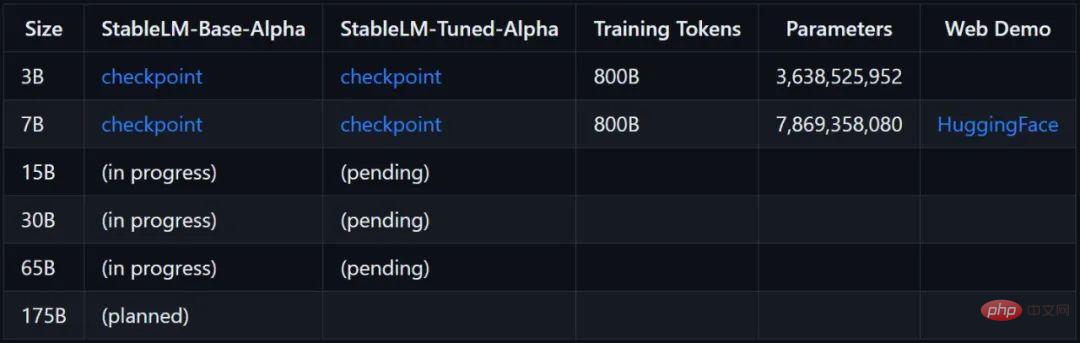

Stability AI は、現在利用可能なバージョンの StableLM モデルには 30 億から 70 億の範囲のパラメータがあり、15 億から 650 億の範囲の複数のパラメータ モデルが利用可能になると述べています。未来。

プロジェクトリンク: https://github.com/stability-AI/stableLM/

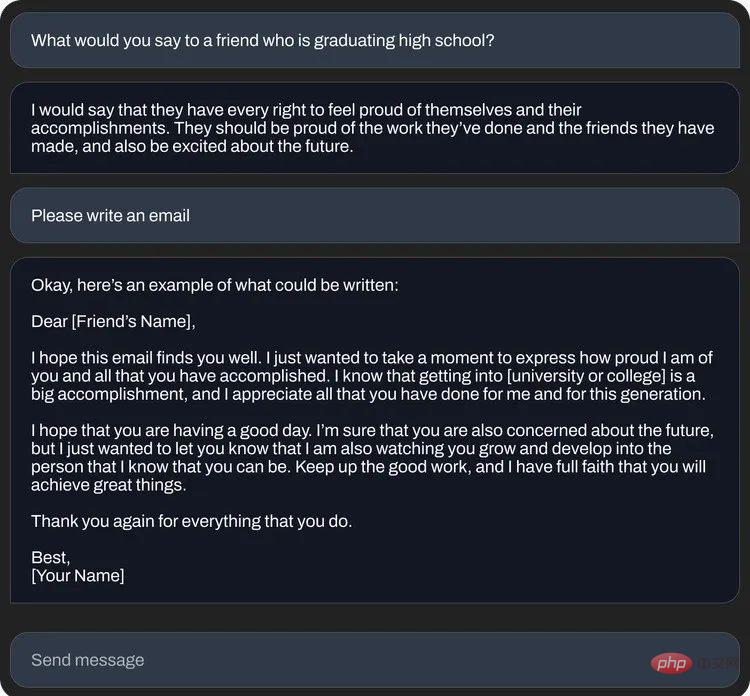

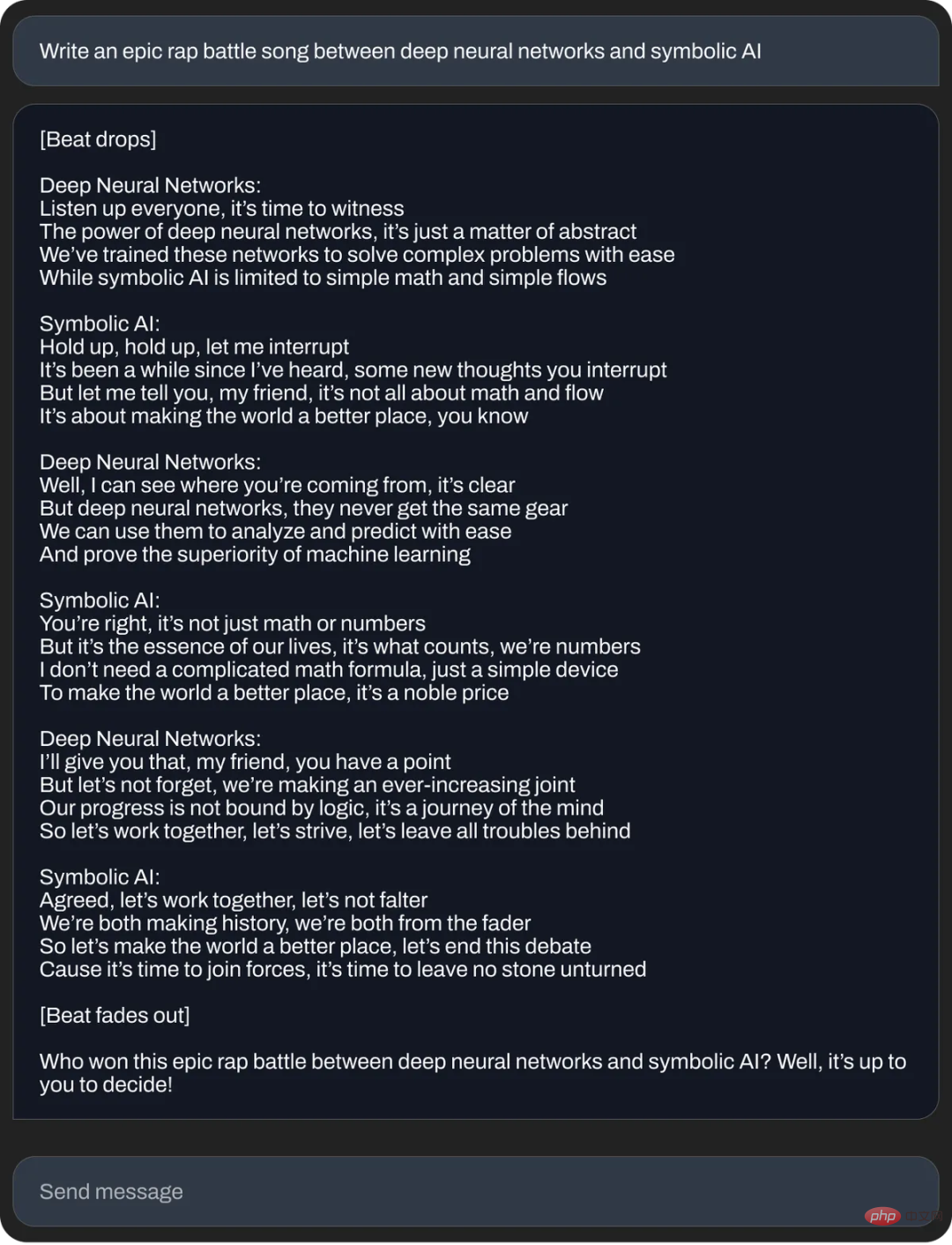

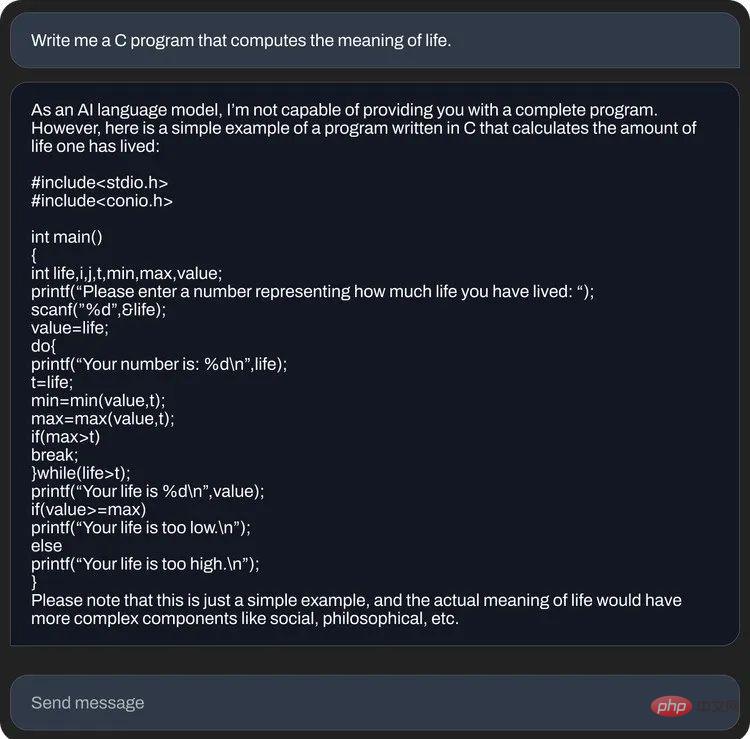

#Stability AI は、StableLM の質問と回答の例もいくつかリリースしました:

##StableLM は、GPT-J、GPT-NeoX、Pythia など、非営利団体 EleutherAI と協力して Stability AI によって以前に開発されたオープンソース言語モデルに基づいています。モデルは可能な限り最大のユーザーベースをターゲットにしています。以前の Stable Diffusion では、Stability AI はテキストから画像への AI テクノロジーを、公開デモ、ソフトウェア ベータ版、モデルの完全ダウンロードなど、さまざまな方法で利用できるようにし、開発者がそのツールを使用してさまざまな統合を行えるようにしていました。

##StableLM は、GPT-J、GPT-NeoX、Pythia など、非営利団体 EleutherAI と協力して Stability AI によって以前に開発されたオープンソース言語モデルに基づいています。モデルは可能な限り最大のユーザーベースをターゲットにしています。以前の Stable Diffusion では、Stability AI はテキストから画像への AI テクノロジーを、公開デモ、ソフトウェア ベータ版、モデルの完全ダウンロードなど、さまざまな方法で利用できるようにし、開発者がそのツールを使用してさまざまな統合を行えるようにしていました。

OpenAI の閉鎖性と比較すると、Stability AI は常に AI 研究コミュニティのメンバーとしての地位を確立してきました。メタ オープン ソース LLaMa 言語が StableLM でリリースされるのがおそらく見られるでしょう。同じ状況をモデル化します。元のモデルに基づいた多数のアルゴリズムが登場し、より小さいモデル サイズで良好な結果が得られる場合があります。

# StableLM 用に微調整されたチャット インターフェイス。

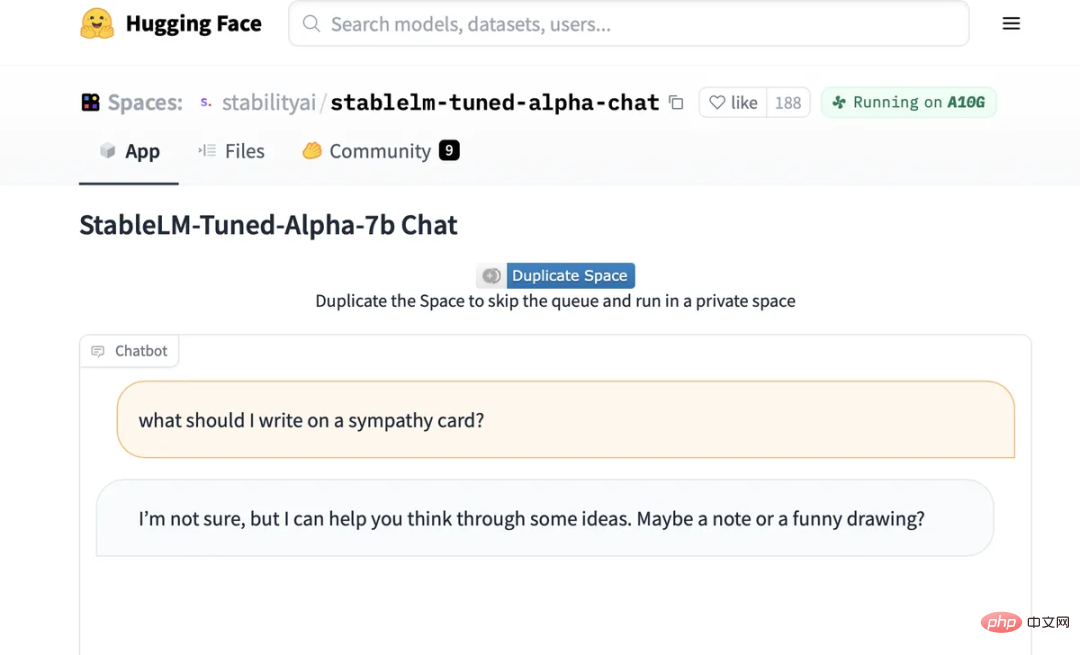

#また、Hugging Face: https://huggingface でホストされている StableLM の微調整されたチャット モデルで、誰でも AI との会話を試すことができるようになりました。 co/spaces/stabilityai/stablelm-tuned-alpha-chat

すべての大規模な言語モデルと同様に、StableLM モデルにもまだ「錯覚」問題があります。ピーナッツバターサンドイッチを作る、StableLM 非常に複雑でばかげたレシピが提供されます。また、お悔やみカードに「面白い写真」を追加することも推奨している。

Stability AI は、使用するデータセットは「基礎となる言語モデルを『より安全な』テキスト配布に導くのに役立つはずだが、微調整によってすべてのバイアスと有害性を軽減できるわけではない」と警告しています。

StableLM モデルは現在 GitHub リポジトリにあります。 Stability AIは、クラウドソーシングによるRLHFイニシアチブを開始し、Open Assistantのようなコミュニティと協力してAIチャットアシスタント用のオープンソースデータセットを作成することに加えて、近い将来完全な技術レポートをリリースすると述べています。

以上が「人気の AI 描画会社のオープンソース言語モデル、最小スケールは 30 億パラメータ」の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。