世界初の真のオープンソース ChatGPT 大型モデルである Dolly 2.0 は商用利用のために自由に変更可能

誰もが知っているように、ChatGPT に関しては OpenAI はオープンではありません。Meta からオープンソース化されている Yangtuo シリーズ モデルも、データ セットなどの問題により「学術研究アプリケーションに限定されています」。方法を制限する場合、100% オープンソースに焦点を当てた大きなモデルが登場します。

4 月 12 日、Databricks は Dolly 2.0 をリリースしました。これは、2 週間前にリリースされた ChatGPT のような人間の対話性 (命令に従う) 大規模言語モデル (LLM) の別の新しいバージョンです。

Databricks によれば、Dolly 2.0 は業界初のオープンソースで、指令に準拠した LLM であり、同じくオープンソースであり、透明で自由に利用できるデータセットに基づいて微調整されています。 。これは、Dolly 2.0 を使用して、API アクセスに料金を支払ったり、サードパーティとデータを共有したりすることなく、商用アプリケーションを構築できることを意味します。

- # プロジェクトリンク: https://huggingface.co/databricks/dolly-v2-12b

- #データセット: https://github.com/databrickslabs/dolly/tree/master/data # # Databricks CEO の Ali Ghodsi 氏によると、商用目的で使用できる大規模なモデルは他にもありますが、「Dolly 2.0 のように話しかけることはできません。」そして、Dolly 2.0 モデルに基づいて、ユーザーはトレーニング データを変更および改善できます。オープンソースライセンスの下で無料で利用できるためです。したがって、独自のバージョンのドリーを作成できます。

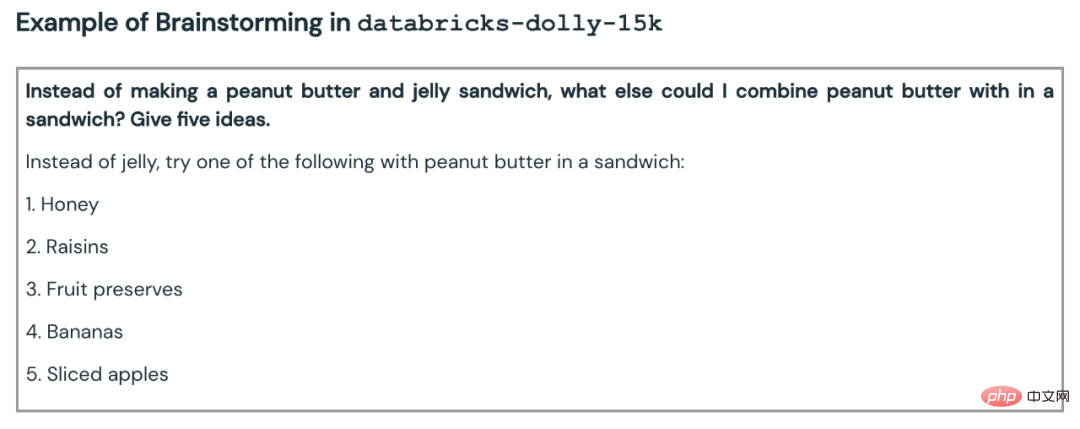

Databricks は、Dolly 2.0 が微調整された databricks-dolly-15k というデータセットもリリースしました。これは、数千人の Databricks 従業員によって生成された 15,000 件を超えるレコードのコーパスです。Databricks はこれを「初のオープンソースで人間が生成した命令コーパスであり、特に大規模な言語で ChatGPT の魔法のような対話性を実証できるように設計されています」# と呼んでいます。

##Dolly 2.0 の誕生の経緯

過去 2 か月で、産業界と学界は OpenAI に追いつき、指示に従う ChatGPT のようなツールの波を提案してきました。モデル、これらのバージョンは、多くの定義によりオープン ソースとみなされます (または、ある程度のオープン性または制限されたアクセスを提供します)。中でも最も注目を集めているのがMeta社のLLaMAで、これをきっかけにAlpaca、Koala、Vicuna、Databricks社のDolly 1.0など、さらに改良されたモデルが数多く誕生しました。しかし一方で、これらの「オープン」モデルの多くは、商用利用を制限するように設計された条件を使用してデータセットでトレーニングされているため、「産業上の制限」下にあります。たとえば、52,000 StanfordAlpaca プロジェクトの質問と回答のデータセットは、OpenAI の ChatGPT の出力でトレーニングされました。また、OpenAI の利用規約には、OpenAI のサービスを競合目的で使用できないという規則が含まれています。

Databricks は、この問題を解決する方法を考えました。新しく提案された Dolly 2.0 は、オープンソースの EleutherAI pythia モデル シリーズに基づいており、特に小規模なオープン ソースの指示レコード コーパス Fine-tuned (databricks-dolly-15k) であるこのデータセットは、Databricks の従業員によって生成され、学術アプリケーションや商用アプリケーションを含むあらゆる目的での使用、変更、拡張を許可する条件に基づいてライセンス供与されています。

これまで、ChatGPT の出力でトレーニングされたモデルは法的にグレーゾーンにありました。 「コミュニティ全体がこの問題を回避しようとしており、誰もがこれらのモデルをリリースしていますが、どれも市販されていません」とゴディ氏は語った。 「だからこそ、私たちはとても興奮しているのです。」 「他の人は皆、より大きなものに行きたがっていますが、私たちは実際にはもっと小さなものに興味を持っています」とゴディ氏はミニチュアスケールのドリーについて語った。 「第二に、私たちはすべての回答に目を通しましたが、それは高品質です。」

Ghodsi 氏は、Dolly 2.0 が「雪だるま式」効果を開始し、他のプレイヤーがゲームの分野に参加できるようになると信じていると述べました。人工知能が人々に加わり、他の選択肢を考え出します。同氏は、商業利用の制限が克服すべき大きなハードルであると説明し、「ついにこの問題を回避する方法を見つけたので、私たちは今興奮しています。これらの15,000の問題を現実の世界に適用する人々が現れることを保証します。そこにあるすべてのモデル」つまり、これらのモデルのどれだけが突然少し魔法のようになり、それらと対話できるようになるかがわかります。」

Hand Rubbing データセット

Dolly 2.0 モデルの重みをダウンロードするには、Databricks Hugging Face ページにアクセスし、databricks-labs の Dolly リポジトリにアクセスして databricks-dolly-15k データセットをダウンロードします。 。

「databricks-dolly-15k」データセットには、人間が生成した高品質のプロンプト/応答ペアが 15,000 個含まれています。2023 年に 5,000 人以上の Databricks 従業員によって作成されました。 3 月と 4 月の は、大規模な言語モデルをチューニングするための手順を提供するように特別に設計されています。これらのトレーニング記録は自然で表現力豊かで、ブレーンストーミングやコンテンツ生成から情報の抽出や要約まで、幅広い行動を表すように設計されています。

このデータ セットのライセンス条項 (クリエイティブ コモンズ表示 - 継承 3.0 非移植ライセンス) に従って、誰でも商用アプリケーションを含むあらゆる目的でこのデータ セットを使用、変更、または拡張できます。

現時点では、このデータセットは、最初のオープンソースで人間が生成した命令データセットです。。

なぜこのようなデータセットを作成するのでしょうか?チームはブログ投稿でもその理由を説明しました。

Dolly 1.0 または LLM に続くディレクティブを作成する際の重要なステップは、ディレクティブと応答のペアのデータセットでモデルをトレーニングすることです。 Dolly 1.0 のトレーニング費用は 30 ドルで、スタンフォード大学の Alpaca チームが OpenAI API を使用して作成したデータセットを使用します。

Dolly 1.0 のリリース後、多くの人からこのモデルを試してみたいという要望があり、このモデルを商用で使用したいと考えているユーザーもいます。

しかし、トレーニング データセットには ChatGPT の出力が含まれており、スタンフォード大学チームが指摘しているように、利用規約は OpenAI と競合するモデルを誰も作成できないようにしようとしています。

以前は、すべてのよく知られた指令準拠モデル (Alpaca、Koala、GPT4All、Vicuna) がこの制限の対象となり、商用利用が禁止されました。この問題を解決するために、ドリーのチームは商業利用の制限なしで新しいデータセットを作成する方法を探し始めました。

具体的には、チームは OpenAI によって発行された研究論文から、元の InstructGPT モデルが 13,000 の命令に従う動作のデモンストレーションで構成されるデータセットでトレーニングされたことを知りました。これに触発されて、彼らは Databricks の従業員が主導して、同様の結果を達成できるかどうかを確認することに着手しました。

13,000 の質問と回答を生成するのは想像以上に困難であることがわかりました。すべての回答はオリジナルである必要があり、ChatGPT や Web 上のどこからでもコピーすることはできません。そうしないと、データ セットが「汚染」されてしまいます。しかし、Databricks には 5,000 人を超える従業員がおり、LLM に非常に興味を持っていました。そこでチームは、40 人のアノテーターが OpenAI 用に作成したものよりも高品質のデータセットを作成するクラウドソーシング実験を実施しました。

もちろん、この作業には時間と労力がかかりますが、全員のモチベーションを高めるために、チームはコンテストを設定し、上位 20 人のアノテーターにはサプライズ賞品が贈られます。同時に、非常に具体的な 7 つのタスクも列挙しました:

- オープン Q&A: たとえば、「なぜ人々はコメディ映画が好きなのですか?」または「フランスの首都はどこですか?」という質問には、正解が 1 つもない場合もあれば、次のような場合もあります。助けが必要です 世界全体についての知識;

- 終了した質問と回答: これらの質問は、参考資料の 1 段落の情報のみを使用して回答できます。たとえば、原子に関する Wikipedia の段落を考えると、「原子核における陽子と中性子の比率は何ですか?」と尋ねるかもしれません。

- Wikipedia からの情報の抽出: ここで、アノテーターはWikipedia から段落をコピーし、その段落からエンティティやその他の事実情報 (重みや測定値など) を抽出します。 Wikipedia を参照し、それを短い要約に抽出するよう依頼しました。

- ブレインストーミング: このタスクでは自由な発想が必要であり、関連する可能なオプションをリストします。例: 「今週末、友達と一緒にできる楽しいアクティビティは何ですか?」;

- 分類: このタスクでは、アノテーターはカテゴリのメンバーシップについて判断するように求められます (例: 項目がリストには動物、鉱物、野菜が含まれます)、または映画レビューの雰囲気などの短い文章の属性を判断する;

- クリエイティブ ライティング: このタスクには、詩やラブレターなど。

- #ここにいくつかの例があります:

その後、チームは「スタッフの生産性の低下」を懸念してゲームを中止しました (これは当然のことです)。

商用化の実現可能性データセットがすぐに作成された後、チームは商用アプリケーションの検討を開始しました。

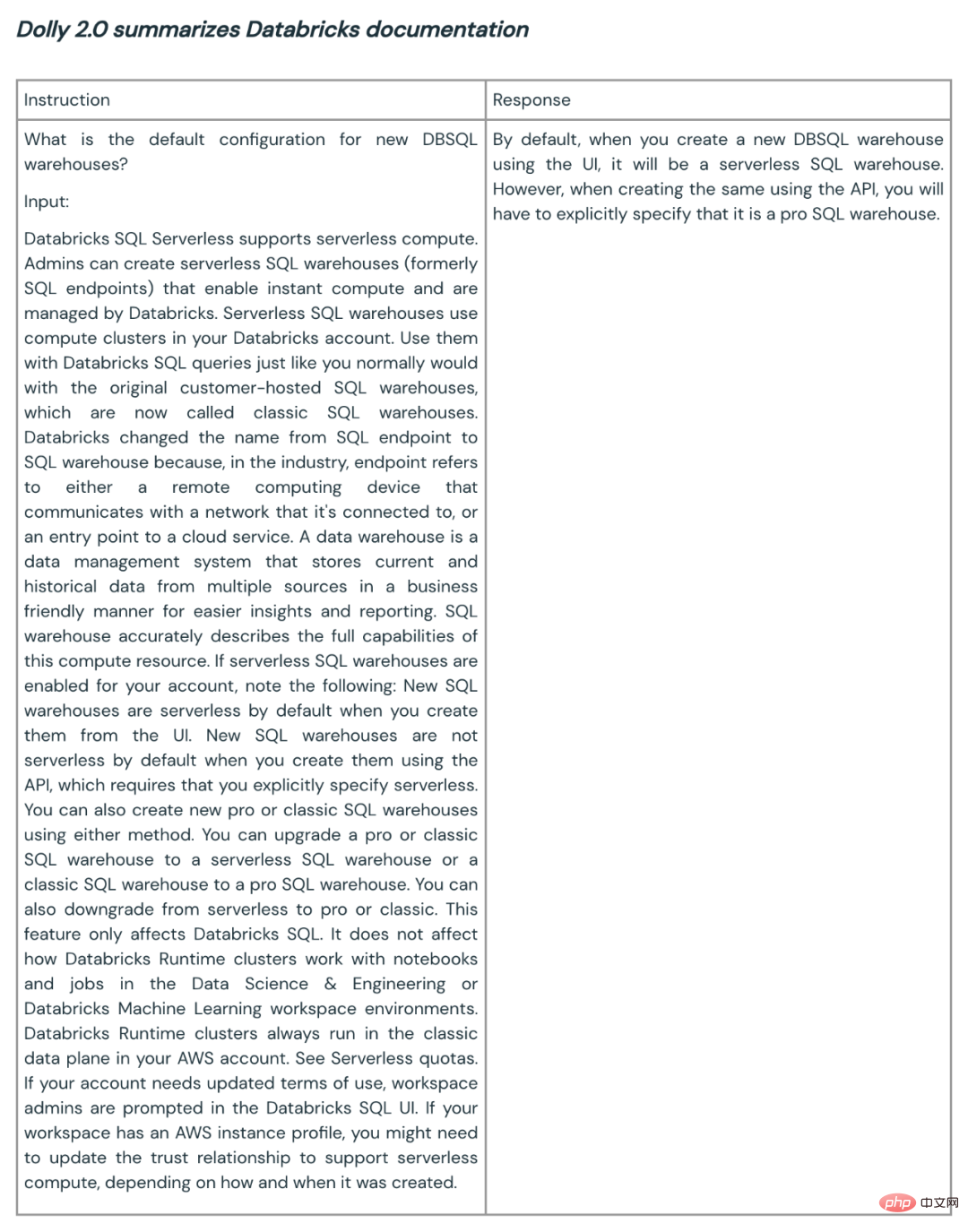

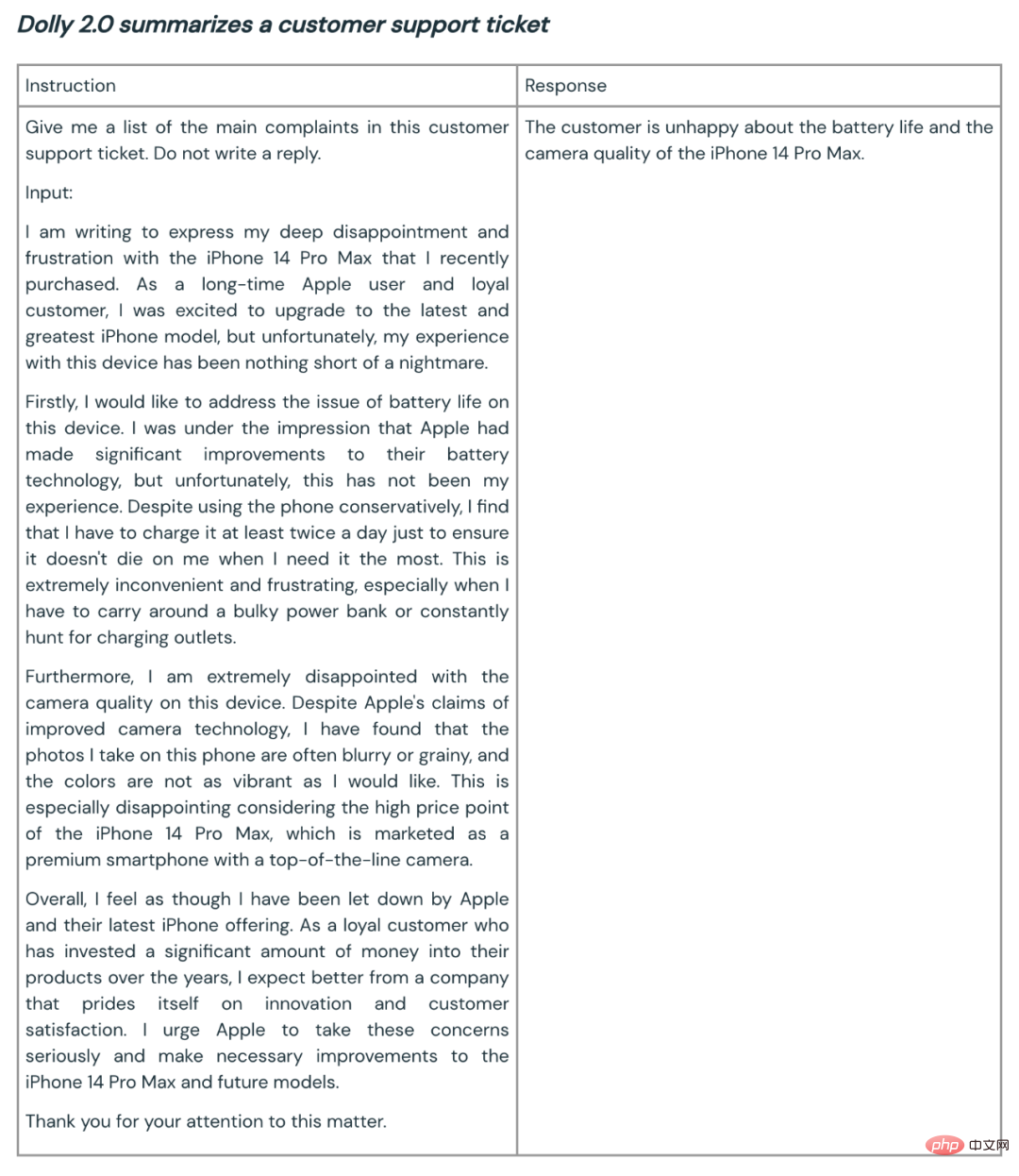

彼らは、商用利用できるオープンソース モデルを作成したいと考えていました。 databricks-dolly-15k は Alpaca (Dolly 1.0 がトレーニングされたデータセット) よりもはるかに小さいですが、EleutherAI pythia-12b に基づく Dolly 2.0 モデルは高品質の命令追従動作を示します。

今にして思えば、これは驚くべきことではありません。結局のところ、ここ数か月でリリースされた命令調整データセットの多くには合成データが含まれており、これには幻覚や事実誤認が含まれることがよくあります。一方、

databricks-dolly-15k は専門家によって生成され、高品質で、ほとんどのタスクに対する長い形式の回答が含まれています。

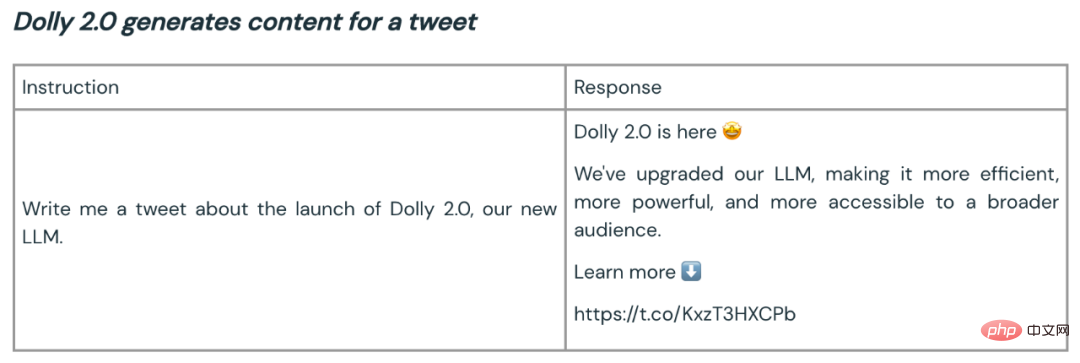

要約とコンテンツ生成に使用される Dolly 2.0 の例をいくつか示します:

Dolly 2 のオープンソースは、より優れた大規模モデルのエコシステムを構築するための良いスタートとなります。オープンソースのデータセットとモデルは、解説、研究、イノベーションを促進し、AI テクノロジーの進歩から誰もが確実に恩恵を受けることができるようにします。 Dolly チームは、新しいモデルとオープンソース データセットがその後の多くの作業の種として機能し、より強力な言語モデルの実現に役立つことを期待しています。

以上が世界初の真のオープンソース ChatGPT 大型モデルである Dolly 2.0 は商用利用のために自由に変更可能の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7698

7698

15

15

1640

1640

14

14

1393

1393

52

52

1287

1287

25

25

1229

1229

29

29

オープンソースのフリーテキスト注釈ツールのおすすめ 10 選

Mar 26, 2024 pm 08:20 PM

オープンソースのフリーテキスト注釈ツールのおすすめ 10 選

Mar 26, 2024 pm 08:20 PM

テキスト注釈は、テキスト内の特定のコンテンツにラベルまたはタグを対応させる作業です。その主な目的は、特に人工知能の分野で、より深い分析と処理のためにテキストに追加情報を提供することです。テキスト注釈は、人工知能アプリケーションの教師あり機械学習タスクにとって非常に重要です。これは、自然言語テキスト情報をより正確に理解し、テキスト分類、感情分析、言語翻訳などのタスクのパフォーマンスを向上させるために AI モデルをトレーニングするために使用されます。テキスト アノテーションを通じて、AI モデルにテキスト内のエンティティを認識し、コンテキストを理解し、新しい同様のデータが出現したときに正確な予測を行うように教えることができます。この記事では主に、より優れたオープンソースのテキスト注釈ツールをいくつか推奨します。 1.LabelStudiohttps://github.com/Hu

オープンソースの無料画像注釈ツールおすすめ 15 選

Mar 28, 2024 pm 01:21 PM

オープンソースの無料画像注釈ツールおすすめ 15 選

Mar 28, 2024 pm 01:21 PM

画像の注釈は、ラベルまたは説明情報を画像に関連付けて、画像の内容に深い意味と説明を与えるプロセスです。このプロセスは機械学習にとって重要であり、画像内の個々の要素をより正確に識別するために視覚モデルをトレーニングするのに役立ちます。画像に注釈を追加することで、コンピュータは画像の背後にあるセマンティクスとコンテキストを理解できるため、画像の内容を理解して分析する能力が向上します。画像アノテーションは、コンピュータ ビジョン、自然言語処理、グラフ ビジョン モデルなどの多くの分野をカバーする幅広い用途があり、車両が道路上の障害物を識別するのを支援したり、障害物の検出を支援したりするなど、幅広い用途があります。医用画像認識による病気の診断。この記事では主に、より優れたオープンソースおよび無料の画像注釈ツールをいくつか推奨します。 1.マケセンス

推奨: 優れた JS オープンソースの顔検出および認識プロジェクト

Apr 03, 2024 am 11:55 AM

推奨: 優れた JS オープンソースの顔検出および認識プロジェクト

Apr 03, 2024 am 11:55 AM

顔の検出および認識テクノロジーは、すでに比較的成熟しており、広く使用されているテクノロジーです。現在、最も広く使用されているインターネット アプリケーション言語は JS ですが、Web フロントエンドでの顔検出と認識の実装には、バックエンドの顔認識と比較して利点と欠点があります。利点としては、ネットワーク インタラクションの削減とリアルタイム認識により、ユーザーの待ち時間が大幅に短縮され、ユーザー エクスペリエンスが向上することが挙げられます。欠点としては、モデル サイズによって制限されるため、精度も制限されることが挙げられます。 js を使用して Web 上に顔検出を実装するにはどうすればよいですか? Web 上で顔認識を実装するには、JavaScript、HTML、CSS、WebRTC など、関連するプログラミング言語とテクノロジに精通している必要があります。同時に、関連するコンピューター ビジョンと人工知能テクノロジーを習得する必要もあります。 Web 側の設計により、次の点に注意してください。

スタンフォード大学の「バーチャルタウン」と「ウエストワールド」から着想を得た25種類のAIエージェントのソースコードが公開

Aug 11, 2023 pm 06:49 PM

スタンフォード大学の「バーチャルタウン」と「ウエストワールド」から着想を得た25種類のAIエージェントのソースコードが公開

Aug 11, 2023 pm 06:49 PM

「ウエストワールド」に慣れている視聴者は、このショーが未来の世界にある巨大なハイテク成人向けテーマパークを舞台としていることを知っています。ロボットは人間と同様の行動能力を持ち、見聞きしたものを記憶し、核となるストーリーラインを繰り返すことができます。これらのロボットは毎日リセットされ、初期状態に戻ります。スタンフォード大学の論文「Generative Agents: Interactive Simulacra of Human Behavior」の発表後、このシナリオは映画やテレビシリーズに限定されなくなりました。AI はこれを再現することに成功しました。スモールヴィルの「バーチャルタウン」のシーン》概要図用紙アドレス:https://arxiv.org/pdf/2304.03442v1.pdf

Alibaba 7B マルチモーダル文書理解の大規模モデルが新しい SOTA を獲得

Apr 02, 2024 am 11:31 AM

Alibaba 7B マルチモーダル文書理解の大規模モデルが新しい SOTA を獲得

Apr 02, 2024 am 11:31 AM

マルチモーダル文書理解機能のための新しい SOTA!アリババの mPLUG チームは、最新のオープンソース作品 mPLUG-DocOwl1.5 をリリースしました。これは、高解像度の画像テキスト認識、一般的な文書構造の理解、指示の遵守、外部知識の導入という 4 つの主要な課題に対処するための一連のソリューションを提案しています。さっそく、その効果を見てみましょう。複雑な構造のグラフをワンクリックで認識しMarkdown形式に変換:さまざまなスタイルのグラフが利用可能:より詳細な文字認識や位置決めも簡単に対応:文書理解の詳しい説明も可能:ご存知「文書理解」 「」は現在、大規模な言語モデルの実装にとって重要なシナリオです。市場には文書の読み取りを支援する多くの製品が存在します。その中には、主にテキスト認識に OCR システムを使用し、テキスト処理に LLM と連携する製品もあります。

Llama 70B を実行するシングル カードはデュアル カードより高速、Microsoft は FP6 を A100 オープンソースに強制導入

Apr 29, 2024 pm 04:55 PM

Llama 70B を実行するシングル カードはデュアル カードより高速、Microsoft は FP6 を A100 オープンソースに強制導入

Apr 29, 2024 pm 04:55 PM

FP8 以下の浮動小数点数値化精度は、もはや H100 の「特許」ではありません。 Lao Huang は誰もが INT8/INT4 を使用できるようにしたいと考え、Microsoft DeepSpeed チームは NVIDIA からの公式サポートなしで A100 上で FP6 の実行を開始しました。テスト結果は、A100 での新しい方式 TC-FPx の FP6 量子化が INT4 に近いか、場合によってはそれよりも高速であり、後者よりも精度が高いことを示しています。これに加えて、エンドツーエンドの大規模モデルのサポートもあり、オープンソース化され、DeepSpeed などの深層学習推論フレームワークに統合されています。この結果は、大規模モデルの高速化にも即座に影響します。このフレームワークでは、シングル カードを使用して Llama を実行すると、スループットはデュアル カードのスループットの 2.65 倍になります。 1つ

1.3ミリ秒には1.3ミリ秒かかります。清華社の最新オープンソース モバイル ニューラル ネットワーク アーキテクチャ RepViT

Mar 11, 2024 pm 12:07 PM

1.3ミリ秒には1.3ミリ秒かかります。清華社の最新オープンソース モバイル ニューラル ネットワーク アーキテクチャ RepViT

Mar 11, 2024 pm 12:07 PM

論文のアドレス: https://arxiv.org/abs/2307.09283 コードのアドレス: https://github.com/THU-MIG/RepViTRepViT は、モバイル ViT アーキテクチャで優れたパフォーマンスを発揮し、大きな利点を示します。次に、この研究の貢献を検討します。記事では、主にモデルがグローバル表現を学習できるようにするマルチヘッド セルフ アテンション モジュール (MSHA) のおかげで、軽量 ViT は一般的に視覚タスクにおいて軽量 CNN よりも優れたパフォーマンスを発揮すると述べられています。ただし、軽量 ViT と軽量 CNN のアーキテクチャの違いは十分に研究されていません。この研究では、著者らは軽量の ViT を効果的なシステムに統合しました。

リリースされたばかりの!ワンクリックでアニメ風の画像を生成するオープンソース モデル

Apr 08, 2024 pm 06:01 PM

リリースされたばかりの!ワンクリックでアニメ風の画像を生成するオープンソース モデル

Apr 08, 2024 pm 06:01 PM

最新の AIGC オープンソース プロジェクト、AnimagineXL3.1 をご紹介します。このプロジェクトは、アニメをテーマにしたテキストから画像へのモデルの最新版であり、より最適化された強力なアニメ画像生成エクスペリエンスをユーザーに提供することを目的としています。 AnimagineXL3.1 では、開発チームは、モデルのパフォーマンスと機能が新たな高みに達することを保証するために、いくつかの重要な側面の最適化に重点を置きました。まず、トレーニング データを拡張して、以前のバージョンのゲーム キャラクター データだけでなく、他の多くの有名なアニメ シリーズのデータもトレーニング セットに含めました。この動きによりモデルの知識ベースが充実し、さまざまなアニメのスタイルやキャラクターをより完全に理解できるようになります。 AnimagineXL3.1 では、特別なタグと美学の新しいセットが導入されています