自動運転における 2D および 3D 視覚認識アルゴリズムの詳細な説明

環境認識は自動運転における最初のリンクであり、車両と環境の間のリンクです。自動運転システムの全体的なパフォーマンスは、知覚システムの品質に大きく依存します。現在、環境認識技術の主流は 2 つの技術ルートがあります:

① ビジョン主導のマルチセンサー融合ソリューション (代表的なのはテスラ)

② ライダー主導、その他のセンサー支援された技術ソリューション、Google、Baidu などの代表的な代表者。

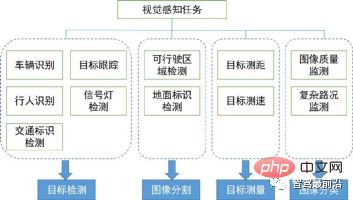

環境認知における主要な視覚認知アルゴリズムを紹介し、そのタスク範囲と技術分野を下図に示します。以下で 2D および 3D 視覚認識アルゴリズムのコンテキストと方向性を確認します。

#2D 視覚認識

このセクションでは、まず、広く使用されているいくつかのタスクから始めて 2D 視覚認識アルゴリズムを紹介します。これには、画像またはビデオベースの 2D オブジェクトの検出と追跡、2D シーンのセマンティック セグメンテーションが含まれます。近年、ディープラーニングは視覚のさまざまな分野に浸透し、良好な成果を上げているため、いくつかの古典的なディープラーニングアルゴリズムを整理しました。1. ターゲットの検出

1.1 2 段階の検出

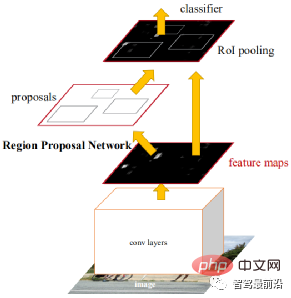

2 段階とは、目標を達成するための 2 つの方法を指します。検出には物体の領域を抽出する処理と、CNNによる領域の分類・同定の2つの処理があるため、候補領域(領域提案)に基づく物体検出とも呼ばれます。代表的なアルゴリズムとしては、R-CNNシリーズ(R-CNN、Fast R-CNN、Faster R-CNN)などがあります。より高速な R-CNN は、初のエンドツーエンド検出ネットワークです。第 1 段階では、領域候補ネットワーク (RPN) を使用して特徴マップに基づいて候補フレームを生成し、ROIPooling を使用して候補特徴のサイズを調整します。第 2 段階では、完全接続レイヤーを使用して洗練された分類と回帰。 アンカーのアイデアは、計算の難しさを軽減し、速度を上げるためにここで提案されています。特徴マップの各位置により、さまざまなサイズとアスペクト比のアンカーが生成され、オブジェクト フレーム回帰の参照として使用されます。アンカーの導入により、回帰タスクは比較的小さな変更のみを処理できるため、ネットワークの学習が容易になります。以下の図は Faster R-CNN のネットワーク構成図です。

1.2 一段階検出

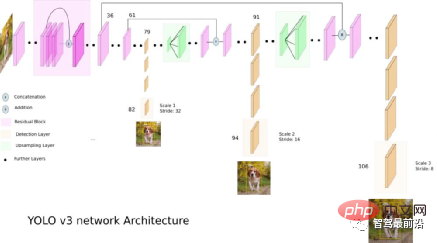

二段階アルゴリズムと比較して、一段階アルゴリズムでは、ターゲット検出を達成するために特徴を 1 回抽出するだけで済みます。の方が高速ですが、一般に精度はわずかに低くなります。このタイプのアルゴリズムの先駆者は YOLO であり、その後 SSD や Retinanet によって改良されました。YOLO を提案したチームは、これらのパフォーマンス向上に役立つトリックを YOLO アルゴリズムに統合し、その後 YOLOv2 ~ YOLOv5 の 4 つの改良バージョンを提案しました。 YOLO は 2 段階のターゲット検出アルゴリズムに比べて予測精度は劣りますが、実行速度が速いため、業界の主流となっています。以下の図はYOLO v3のネットワーク構成図です。

1.3 アンカーフリー検出 (アンカー検出なし)

このタイプの方法は、通常、オブジェクトをいくつかのキー ポイントとして表します。 CNN は、これらのキーポイントの位置を返すために使用されます。キーポイントは、オブジェクトフレームの中心点 (CenterNet)、コーナーポイント (CornerNet)、または代表点 (RepPoints) です。 CenterNet は、ターゲット検出問題を中心点予測問題に変換します。つまり、ターゲットを表すためにターゲットの中心点を使用し、ターゲットの中心点のオフセット、幅、高さを予測することによってターゲットの長方形のフレームを取得します。ヒートマップは分類情報を表し、カテゴリごとに個別のヒートマップが生成されます。各ヒートマップでは、特定の座標にターゲットの中心点が含まれる場合、ターゲットにキー ポイントが生成されます。キー ポイント全体をガウス円を使用して表現します。具体的な詳細は次の図に示されています。

1.4 変圧器の検出

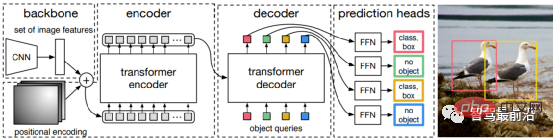

一段階ターゲット検出であろうと二段階ターゲット検出であろうと、アンカーが使用されるかどうかにかかわらず、アテンションメカニズムは十分に活用されていません。この状況に対応して、Relation Net と DETR は Transformer を使用して、ターゲット検出の分野にアテンション メカニズムを導入します。 Relation Net は、Transformer を使用して異なるターゲット間の関係をモデル化し、関係情報を機能に組み込み、機能の強化を実現します。 DETR は Transformer に基づいた新しいターゲット検出アーキテクチャを提案し、ターゲット検出の新時代を切り開きます。次の図は DETR のアルゴリズム プロセスです。最初に CNN を使用して画像の特徴を抽出し、次に Transformer を使用してグローバルな空間関係をモデル化します。最後に、 の出力は、二部グラフ マッチング アルゴリズムを通じて手動の注釈と照合されます。

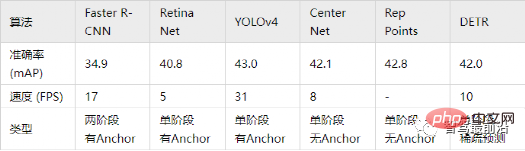

以下の表の精度は MS COCO データベースの mAP を指標として使用し、速度は FPS によって測定されます。上記のアルゴリズムの一部と比較すると、ネットワークの構造設計にはさまざまな選択肢があり (入力サイズの違い、バックボーン ネットワークの違いなど)、各アルゴリズムの実装ハードウェア プラットフォームも異なるため、精度と速度を完全に比較することはできません。あくまで大まかな結果ですのでご参考までに。

2. ターゲット追跡

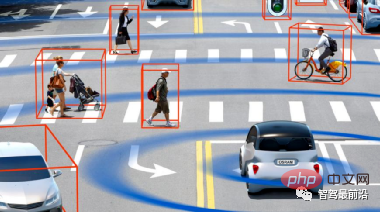

自動運転アプリケーションでは、入力はビデオ データであり、追跡する必要があるターゲットが多数あります。車両、歩行者、自転車などに注意してください。したがって、これは典型的な複数オブジェクト追跡タスク (MOT) です。 MOT タスクでは、現在最も一般的なフレームワークは Tracking-by-Detection であり、そのプロセスは次のとおりです:

① ターゲット検出器は、単一フレーム画像上のターゲット フレーム出力を取得します。 #② 検出された各ターゲットの特徴 (通常は視覚的特徴と動きの特徴を含む) を抽出します。

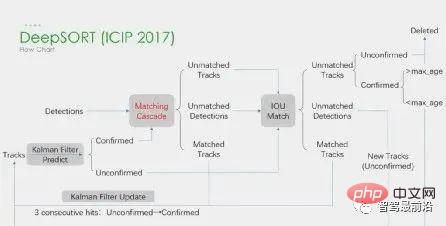

##③ 特徴に基づいて隣接するフレームからのターゲット検出間の類似性を計算し、それらが同じターゲットからのものである確率を決定します。④ 隣接するフレーム内のターゲット検出を照合し、同じターゲットからのオブジェクトに同じ ID を割り当てます。 ディープラーニングは上記の 4 つのステップで適用されますが、最初の 2 つのステップが主要なステップです。ステップ 1 では、深層学習の適用は主に高品質の物体検出器を提供することであるため、一般に精度の高い方法が選択されます。 SORTは、Faster R-CNNに基づく物体検出手法であり、カルマンフィルターアルゴリズムのハンガリーアルゴリズムを使用することで、複数物体追跡の速度を大幅に向上させ、SOTAの精度を実現しており、実用的に広く使用されているアルゴリズムでもあります。 。ステップ 2 では、深層学習のアプリケーションは主に CNN を使用してオブジェクトの視覚的特徴を抽出します。 DeepSORTの最大の特徴は、外観情報を追加し、ReIDモジュールを借用して深層学習の特徴を抽出し、IDスイッチの数を削減することです。全体的なフローチャートは次のとおりです。#さらに、同時検出と追跡のフレームワークもあります。代表的な CenterTrack などは、以前紹介した 1 段階のアンカーレス検出アルゴリズム CenterNet から派生したものです。 CenterNet と比較すると、CenterTrack は前のフレームの RGB イメージとオブジェクト中心のヒートマップを追加入力として追加し、前後のフレーム間の関連付けのための Offset ブランチを追加します。マルチステージの検出による追跡と比較して、CenterTrack はネットワークを使用して検出および照合ステージを実装するため、MOT の速度が向上します。

3. セマンティック セグメンテーション

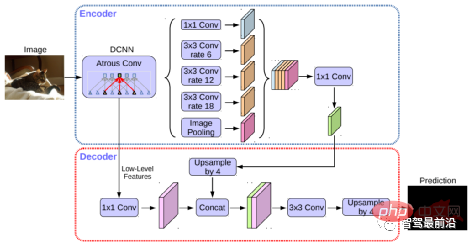

セマンティック セグメンテーションは、自動運転の車線境界線検出タスクと走行可能領域検出タスクの両方で使用されます。代表的なアルゴリズムとしてはFCN、U-Net、DeepLabシリーズなどがあります。 DeepLab は、拡張コンボリューションと ASPP (Atrous Spatial Pyramid Pooling) 構造を使用して、入力画像に対してマルチスケール処理を実行します。最後に、従来のセマンティック セグメンテーション手法で一般的に使用されている条件付きランダム フィールド (CRF) を使用して、セグメンテーション結果を最適化します。以下の図は DeepLab v3 のネットワーク構造です。

#近年の STDC アルゴリズムは、U-Net アルゴリズムの複雑なデコーダ構造を取り除き、FCN アルゴリズムと同様の構造を採用しています。しかし同時に、ネットワーク ダウンサンプリングのプロセスで、ARM モジュールを使用して異なるレイヤーの特徴マップからの情報を継続的に融合することで、単一ピクセルの関係のみを考慮する FCN アルゴリズムの欠点を回避します。 STDC アルゴリズムは速度と精度のバランスが取れており、自動運転システムのリアルタイム要件を満たすことができると言えます。アルゴリズムの流れを以下の図に示します。

3D視覚認識

このセクションでは、自動運転に不可欠な3Dシーン認識について紹介します。なぜなら、奥行き情報や対象物の三次元サイズなどは二次元知覚では得られず、自動運転システムが周囲の環境を正しく判断するための鍵となる情報だからです。 3D 情報を取得する最も直接的な方法は、LiDAR を使用することです。ただし、LiDARにはコストが高い、車載グレードの製品の量産が難しい、天候の影響が大きいなどの欠点もあります。したがって、カメラのみに基づいた 3D 知覚は依然として非常に意味があり、価値のある研究方向です. 次に、単眼と両眼に基づいたいくつかの 3D 知覚アルゴリズムを整理します。

1. 単眼 3D 認識

単一のカメラ画像に基づいて 3D 環境を認識することは不適切な問題ですが、幾何学的な仮定 (たとえば、地上のピクセルなど)、解決に役立つ事前知識または追加情報(深度推定など)。今回は、自動運転を実現するための2つの基本タスク(3Dターゲット検出と深度推定)から関連アルゴリズムを紹介します。

1.1 3D ターゲット検出

#表現変換 (疑似ライダー): 視覚センサーによる他の周囲車両の検出は通常、次の場合に行われます。オクルージョンや距離測定不能などの問題が発生した場合は、透視図を鳥瞰図表現に変換できます。ここでは 2 つの変換方法を紹介します。 1 つ目は、すべてのピクセルが地面にあり、カメラの外部パラメータが正確であることを前提とした逆遠近マッピング (IPM) です。このとき、ホモグラフィー変換を使用して画像を BEV に変換し、次に、 YOLO ネットワークは、ターゲットの地上フレームを検出するために使用されます。 2 つ目は直交特徴変換 (OFT) で、ResNet-18 を使用して遠近感のある画像特徴を抽出します。次いで、投影されたボクセル領域にわたって画像ベースの特徴を蓄積することによって、ボクセルベースの特徴が生成される。

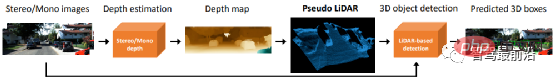

その後、ボクセル フィーチャは垂直に折り畳まれて、直交する地表フィーチャが生成されます。最後に、ResNet に似た別のトップダウン ネットワークが 3D オブジェクト検出に使用されます。これらの方法は、地面に近い車両と歩行者にのみ適しています。交通標識や信号機などの非地上ターゲットの場合、3D 検出のための深度推定を通じて擬似点群を生成できます。擬似 LiDAR は、まず深度推定結果を使用して点群を生成し、次に LIDAR ベースの 3D ターゲット検出器を直接適用して 3D ターゲット フレームを生成します。アルゴリズム フローは、次の図に示されています。

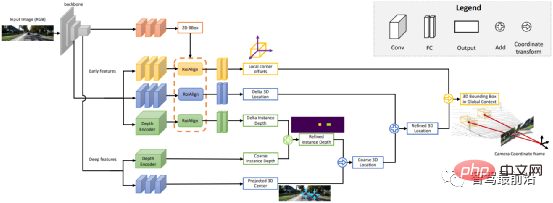

# ポイントと 3D モデル:車両や歩行者などの検出対象の大きさや形状は比較的固定的で既知であるため、これらを事前知識として利用して車両の 3D 情報を推定することができます。ターゲット。 DeepMANTA は、この方向における先駆的な作品の 1 つです。まず、Faster RNN などのいくつかのターゲット検出アルゴリズムを使用して 2D ターゲット フレームを取得し、ターゲットのキー ポイントも検出します。次に、これらの 2D ターゲット フレームとキー ポイントがデータベース内のさまざまな 3D 車両 CAD モデルと照合され、最も類似性の高いモデルが 3D ターゲット検出の出力として選択されます。 MonoGRNet は、単眼 3D ターゲット検出を 2D ターゲット検出、インスタンス レベルの深度推定、投影された 3D 中心推定、およびローカル コーナー回帰の 4 つのステップに分割することを提案しており、アルゴリズム フローは次の図に示されています。このタイプの方法は、ターゲットが比較的固定された形状モデルを持っていることを前提としています。これは車両にとっては一般に満足ですが、歩行者にとっては比較的困難です。

2D/3D 幾何学的制約: 3D 中心の投影と大まかなインスタンスの深さを回帰し、両方を使用して大まかな 3D 位置を推定します。先駆的な研究は Deep3DBox で、最初に 2D ターゲット ボックス内の画像特徴を使用してターゲットのサイズと方向を推定します。次に、中心点の 3D 位置が 2D/3D 幾何拘束によって解決されます。この制約は、画像上の 3D ターゲット フレームの投影が 2D ターゲット フレームに密接に囲まれている、つまり 3D ターゲット フレームの少なくとも 1 つのコーナー ポイントが 2D ターゲット フレームの両側に存在するということです。事前に予測されたサイズと方向をカメラのキャリブレーション パラメーターと組み合わせることで、中心点の 3D 位置を計算できます。 2D ターゲット ボックスと 3D ターゲット ボックスの間の幾何学的制約を次の図に示します。 Shift R-CNN は、Deep3DBox に基づいて、以前に取得した 2D ターゲット ボックス、3D ターゲット ボックス、およびカメラ パラメーターを入力として組み合わせ、完全に接続されたネットワークを使用して、より正確な 3D 位置を予測します。

3DBox を直接生成: この方法は、密な 3D ターゲット候補ボックスから開始し、2D 画像上の特徴に基づいてすべての候補ボックスにスコアを付けます。スコアの高い候補ボックスが最終出力となります。ターゲット検出における従来のスライディング ウィンドウ法にある程度似ています。代表的な Mono3D アルゴリズムは、まず、ターゲットの以前の位置 (Z 座標は地上) とサイズに基づいて、密な 3D 候補ボックスを生成します。これらの 3D 候補フレームが画像座標に投影された後、2D 画像上の特徴を統合することによってスコア付けされ、CNN を通じて 2 回目のスコアリングが実行されて、最終的な 3D ターゲット フレームが取得されます。

M3D-RPN は、2D および 3D アンカーを定義するアンカーベースのメソッドです。 2D アンカーは画像上の高密度サンプリングを通じて取得され、3D アンカーはトレーニング セット データの事前知識 (ターゲットの実際のサイズの平均など) を通じて決定されます。 M3D-RPN は、標準畳み込みと深度認識畳み込みの両方も使用します。前者は空間不変性を持ち、後者は画像の行 (Y 座標) を複数のグループに分割し、各グループは異なるシーンの深度に対応し、異なるコンボリューション カーネルで処理されます。上記の高密度サンプリング方法は、非常に多くの計算を必要とします。 SS3D は、画像内の各関連オブジェクトの冗長表現と対応する不確実性推定値を出力する CNN と 3D バウンディング ボックス オプティマイザーを含む、より効率的な単一ステージ検出を使用します。 FCOS3D も 1 段階の検出方法であり、回帰ターゲットは、3D ターゲット フレームの中心を 2D 画像に投影することによって得られる追加の 2.5D 中心 (X、Y、深さ) を追加します。

1.2 奥行き推定

前述の 3D ターゲット検出であっても、2D から 3D に及ぶ自動運転の知覚セマンティック セグメンテーションの別の重要なタスクであっても、詳細または、疎または密の深度情報が適用されます。単眼奥行き推定の重要性は自明であり、その入力は画像であり、出力は各ピクセルに対応するシーンの奥行き値からなる同じサイズの画像です。入力はビデオ シーケンスにすることもでき、カメラまたはオブジェクトの動きによってもたらされる追加情報を使用して深度推定の精度を向上させます。教師あり学習と比較して、単眼奥行き推定の教師なし方法は、困難なグラウンド トゥルース データ セットの構築を必要とせず、実装の難易度も低くなります。単眼奥行き推定の教師なし方法は、単眼ビデオ シーケンスに基づく方法と、同期されたステレオ画像ペアに基づく 2 つのタイプに分類できます。

前者は、移動するカメラと静止したシーンを前提としています。後者の方法では、Garg らはまず、画像再構成に同時にステレオ補正された両眼画像ペアを使用することを試み、両眼判定によって左右のビューの姿勢関係が得られ、比較的理想的な効果が得られました。これに基づいて、ゴダールらは精度をさらに向上させるために左右の一貫性制約を使用しましたが、層ごとのダウンサンプリングによって高度な特徴を抽出して受容野を増加させる一方で、特徴の解像度も常に低下しており、粒度も低下しています。は常に失われ、詳細なディテールの処理とエッジの明瞭さに影響を与えます。

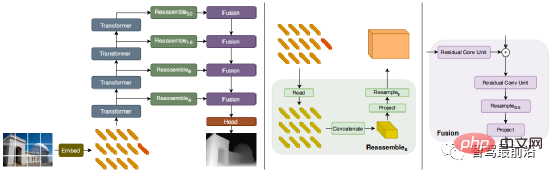

この問題を軽減するために、Godard らはフル解像度のマルチスケール損失を導入し、低テクスチャ領域でのブラック ホールとテクスチャ複製によって生じるアーティファクトを効果的に低減しました。ただし、この精度の向上にはまだ限界があります。最近、すべての段階で大域的な受容野を取得することを目的としたいくつかの Transformer ベースのモデルが無限の流れで出現しており、これは集中的な深度推定タスクにも非常に適しています。教師あり DPT では、ローカルな予測精度とグローバルな予測の一貫性を同時に確保するために、Transformer とマルチスケール構造を使用することが提案されており、次の図はネットワーク構造図です。

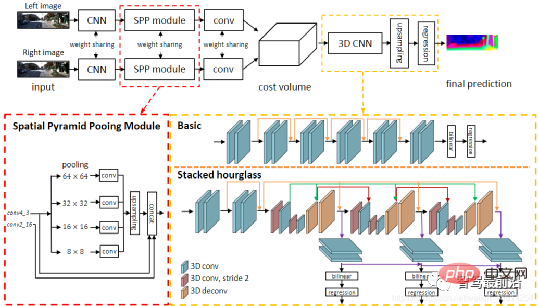

2. 両眼視による 3D 認識

両眼視は視点変換による曖昧さを解決できるため、理論的にはそうであると言われています。 3D認識の精度を向上させることができます。ただし、双眼システムにはハードウェアとソフトウェアの点で比較的高い要件があります。ハードウェア的には、正確に登録された 2 台のカメラが必要であり、車両の運行中に登録の精度を確保する必要があります。ソフトウェア的には、アルゴリズムは 2 台のカメラからのデータを同時に処理する必要があり、計算の複雑さが高く、アルゴリズムのリアルタイム性を保証するのが困難です。単眼に比べて、両眼の仕事は比較的少なくなります。次に、3Dターゲット検出と奥行き推定の2つの側面からも簡単に紹介します。

2.1 3D ターゲット検出

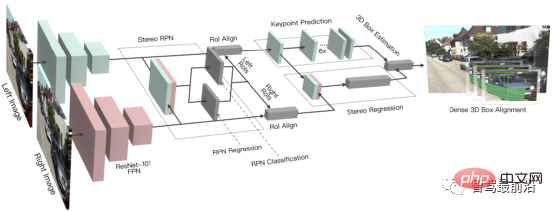

3DOP は 2 段階の検出手法であり、Fast R-CNN 手法を 3D 分野に拡張したものです。まず、両眼画像を使用して深度マップが生成されます。深度マップは点群に変換され、グリッド データ構造に定量化されます。これは、3D ターゲットの候補フレームを生成するための入力として使用されます。以前に紹介した疑似 LiDAR と同様に、(単眼、両眼、または低線数の LiDAR からの) 高密度深度マップが点群に変換され、点群ターゲット検出の分野のアルゴリズムが適用されます。 DSGN は、ステレオ マッチングを利用して平面スキャン ボリュームを構築し、3D ジオメトリとセマンティック情報をエンコードするためにそれらを 3D ジオメトリに変換します。これは、ステレオ マッチングと高度なオブジェクト認識のためにピクセル レベルの特徴を抽出できるエンドツーエンドのフレームワークです。 、シーンの深度の推定と 3D オブジェクトの検出を同時に行うことができます。ステレオ R-CNN は、ステレオ入力用に Faster R-CNN を拡張し、左右のビュー内のオブジェクトを同時に検出して関連付けます。 RPN の後に追加のブランチが追加され、まばらなキーポイント、視点、オブジェクト サイズを予測し、左右のビューの 2D 境界ボックスを結合して、粗い 3D オブジェクト境界ボックスを計算します。次に、左右の関心領域の領域ベースのフォトメトリック位置合わせを使用して、正確な 3D バウンディング ボックスが復元されます。下の図はそのネットワーク構造です。

2.2 奥行き推定

両眼奥行き推定の原理は非常に単純です。つまり、同じもの間の距離に基づいています。左右のビュー上の 3D 点 ピクセル距離 d (2 台のカメラが同じ高さにあると仮定しているため、水平方向の距離のみが考慮されます)、つまり視差、カメラの焦点距離 f、 2台のカメラ間の距離B(基線長)から3D点の奥行きを推定します。式は次のようになり、視差を推定することで奥行きを計算できます。次に、他の画像上でピクセルごとに一致する点を見つけるだけです。

以上が自動運転における 2D および 3D 視覚認識アルゴリズムの詳細な説明の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7532

7532

15

15

1379

1379

52

52

82

82

11

11

21

21

82

82

自動運転シナリオにおけるロングテール問題を解決するにはどうすればよいでしょうか?

Jun 02, 2024 pm 02:44 PM

自動運転シナリオにおけるロングテール問題を解決するにはどうすればよいでしょうか?

Jun 02, 2024 pm 02:44 PM

昨日の面接で、ロングテール関連の質問をしたかと聞かれたので、簡単にまとめてみようと思いました。自動運転のロングテール問題とは、自動運転車におけるエッジケース、つまり発生確率が低い考えられるシナリオを指します。認識されているロングテール問題は、現在、単一車両のインテリジェント自動運転車の運用設計領域を制限している主な理由の 1 つです。自動運転の基礎となるアーキテクチャとほとんどの技術的問題は解決されており、残りの 5% のロングテール問題が徐々に自動運転の開発を制限する鍵となってきています。これらの問題には、さまざまな断片的なシナリオ、極端な状況、予測不可能な人間の行動が含まれます。自動運転におけるエッジ シナリオの「ロング テール」とは、自動運転車 (AV) におけるエッジ ケースを指します。エッジ ケースは、発生確率が低い可能性のあるシナリオです。これらの珍しい出来事

CLIP-BEVFormer: BEVFormer 構造を明示的に監視して、ロングテール検出パフォーマンスを向上させます。

Mar 26, 2024 pm 12:41 PM

CLIP-BEVFormer: BEVFormer 構造を明示的に監視して、ロングテール検出パフォーマンスを向上させます。

Mar 26, 2024 pm 12:41 PM

上記および筆者の個人的な理解: 現在、自動運転システム全体において、認識モジュールが重要な役割を果たしている。道路を走行する自動運転車は、認識モジュールを通じてのみ正確な認識結果を得ることができる。下流の規制および制御モジュール自動運転システムでは、タイムリーかつ正確な判断と行動決定が行われます。現在、自動運転機能を備えた自動車には通常、サラウンドビューカメラセンサー、ライダーセンサー、ミリ波レーダーセンサーなどのさまざまなデータ情報センサーが搭載されており、さまざまなモダリティで情報を収集して正確な認識タスクを実現しています。純粋な視覚に基づく BEV 認識アルゴリズムは、ハードウェア コストが低く導入が容易であるため、業界で好まれており、その出力結果はさまざまな下流タスクに簡単に適用できます。

C++ での機械学習アルゴリズムの実装: 一般的な課題と解決策

Jun 03, 2024 pm 01:25 PM

C++ での機械学習アルゴリズムの実装: 一般的な課題と解決策

Jun 03, 2024 pm 01:25 PM

C++ の機械学習アルゴリズムが直面する一般的な課題には、メモリ管理、マルチスレッド、パフォーマンスの最適化、保守性などがあります。解決策には、スマート ポインター、最新のスレッド ライブラリ、SIMD 命令、サードパーティ ライブラリの使用、コーディング スタイル ガイドラインの遵守、自動化ツールの使用が含まれます。実践的な事例では、Eigen ライブラリを使用して線形回帰アルゴリズムを実装し、メモリを効果的に管理し、高性能の行列演算を使用する方法を示します。

nuScenes の最新 SOTA | SparseAD: スパース クエリは効率的なエンドツーエンドの自動運転に役立ちます。

Apr 17, 2024 pm 06:22 PM

nuScenes の最新 SOTA | SparseAD: スパース クエリは効率的なエンドツーエンドの自動運転に役立ちます。

Apr 17, 2024 pm 06:22 PM

先頭と開始点に書かれている エンドツーエンドのパラダイムでは、統一されたフレームワークを使用して自動運転システムのマルチタスクを実現します。このパラダイムの単純さと明確さにも関わらず、サブタスクにおけるエンドツーエンドの自動運転手法のパフォーマンスは、依然としてシングルタスク手法に比べてはるかに遅れています。同時に、以前のエンドツーエンド手法で広く使用されていた高密度鳥瞰図 (BEV) 機能により、より多くのモダリティやタスクに拡張することが困難になります。ここでは、スパース検索中心のエンドツーエンド自動運転パラダイム (SparseAD) が提案されています。このパラダイムでは、スパース検索は、高密度の BEV 表現を使用せずに、空間、時間、タスクを含む運転シナリオ全体を完全に表します。具体的には、統合されたスパース アーキテクチャが、検出、追跡、オンライン マッピングなどのタスク認識のために設計されています。さらに、重い

エンドツーエンドおよび次世代の自動運転システムと、エンドツーエンドの自動運転に関する誤解について話しましょう。

Apr 15, 2024 pm 04:13 PM

エンドツーエンドおよび次世代の自動運転システムと、エンドツーエンドの自動運転に関する誤解について話しましょう。

Apr 15, 2024 pm 04:13 PM

この 1 か月間、いくつかのよく知られた理由により、私は業界のさまざまな教師やクラスメートと非常に集中的な交流をしてきました。この交換で避けられない話題は当然、エンドツーエンドと人気の Tesla FSDV12 です。この機会に、現時点での私の考えや意見を整理し、皆様のご参考とご議論に役立てたいと思います。エンドツーエンドの自動運転システムをどのように定義するか、またエンドツーエンドで解決することが期待される問題は何でしょうか?最も伝統的な定義によれば、エンドツーエンド システムとは、センサーから生の情報を入力し、関心のある変数をタスクに直接出力するシステムを指します。たとえば、画像認識では、従来の特徴抽出 + 分類子方式と比較して、CNN はエンドツーエンドと言えます。自動運転タスクでは、各種センサー(カメラ/LiDAR)からのデータを入力

FisheyeDetNet: 魚眼カメラに基づいた最初のターゲット検出アルゴリズム

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: 魚眼カメラに基づいた最初のターゲット検出アルゴリズム

Apr 26, 2024 am 11:37 AM

目標検出は自動運転システムにおいて比較的成熟した問題であり、その中でも歩行者検出は最も初期に導入されたアルゴリズムの 1 つです。ほとんどの論文では非常に包括的な研究が行われています。ただし、サラウンドビューに魚眼カメラを使用した距離認識については、あまり研究されていません。放射状の歪みが大きいため、標準のバウンディング ボックス表現を魚眼カメラに実装するのは困難です。上記の説明を軽減するために、拡張バウンディング ボックス、楕円、および一般的な多角形の設計を極/角度表現に探索し、これらの表現を分析するためのインスタンス セグメンテーション mIOU メトリックを定義します。提案された多角形モデルの FisheyeDetNet は、他のモデルよりも優れたパフォーマンスを示し、同時に自動運転用の Valeo 魚眼カメラ データセットで 49.5% の mAP を達成しました。

C++sort 関数の基礎となる原則とアルゴリズムの選択を調べる

Apr 02, 2024 pm 05:36 PM

C++sort 関数の基礎となる原則とアルゴリズムの選択を調べる

Apr 02, 2024 pm 05:36 PM

C++sort 関数の最下層はマージ ソートを使用し、その複雑さは O(nlogn) で、クイック ソート、ヒープ ソート、安定したソートなど、さまざまなソート アルゴリズムの選択肢を提供します。

オックスフォード大学の最新情報!ミッキー:2D画像を3D SOTAでマッチング! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

オックスフォード大学の最新情報!ミッキー:2D画像を3D SOTAでマッチング! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

前に書かれたプロジェクトのリンク: https://nianticlabs.github.io/mickey/ 2 枚の写真が与えられた場合、それらの写真間の対応関係を確立することで、それらの間のカメラのポーズを推定できます。通常、これらの対応は 2D 対 2D であり、推定されたポーズはスケール不定です。いつでもどこでもインスタント拡張現実などの一部のアプリケーションでは、スケール メトリクスの姿勢推定が必要なため、スケールを回復するために外部深度推定器に依存します。この論文では、3D カメラ空間でのメトリックの対応を予測できるキーポイント マッチング プロセスである MicKey を提案します。画像全体の 3D 座標マッチングを学習することで、相対的なメトリックを推測できるようになります。