GPT-3 を使用してビジネス ニーズを満たすエンタープライズ チャットボットを構築する

背景

チャットボットまたはカスタマー サービス アシスタントは、インターネット上のテキストまたは音声を通じてユーザーに配信することでビジネス価値を達成することを目的とした AI ツールです。チャットボットの開発は、単純なロジックに基づいた初期のロボットから、自然言語理解 (NLU) に基づいた現在の人工知能に至るまで、ここ数年で急速に進歩しました。後者については、チャットボットを構築する際によく使われるフレームワークやライブラリとしては、海外のRASA、Dialogflow、Amazon Lexなどのほか、国内の大手企業であるBaidu、iFlytekなどが挙げられます。これらのフレームワークは、自然言語処理 (NLP) と NLU を統合して、入力テキストを処理し、意図を分類し、応答を生成するための適切なアクションをトリガーできます。

ラージ言語モデル (LLM) の出現により、これらのモデルを直接使用して、完全に機能するチャットボットを構築できるようになりました。有名な LLM の例の 1 つは、OpenAI の Generative Pre-trained Transformer 3 (GPT-3: chatgpt は gpt 微調整とヒューマン フィードバック モデルの追加に基づいています) です。これは、ダイアログまたはセッション データを使用してモデルを微調整でき、自然な会話のようなテキスト。この機能により、カスタム チャットボットの構築に最適です。

今日は、GPT-3 モデルを微調整して独自のシンプルな会話型チャットボットを構築する方法について説明します。

通常、顧客サービスの会話記録、チャット ログ、映画の字幕などのビジネス会話の例のデータセットに基づいてモデルを微調整する必要があります。微調整プロセスでは、この会話データによりよく適合するようにモデルのパラメーターが調整され、チャットボットがユーザー入力をよりよく理解して応答できるようになります。

GPT-3 を微調整するには、事前トレーニングされたモデルと微調整ツールを提供する Hugging Face の Transformers ライブラリを使用できます。このライブラリには、さまざまなサイズと機能のいくつかの GPT-3 モデルが用意されています。モデルが大きいほど、処理できるデータが多くなり、精度が高くなる可能性があります。ただし、今回は簡単のため、少量のコードを記述するだけで微調整が実現できる OpenAI インターフェースを使用します。

次のステップでは、OpenAI GPT-3 を使用して微調整を実装します。データ セットはここから入手できます。申し訳ありませんが、また外部データ セットを使用しました。このような処理されたデータは実際にはほとんどありません。中国のセットです。

1. Open API キーの作成

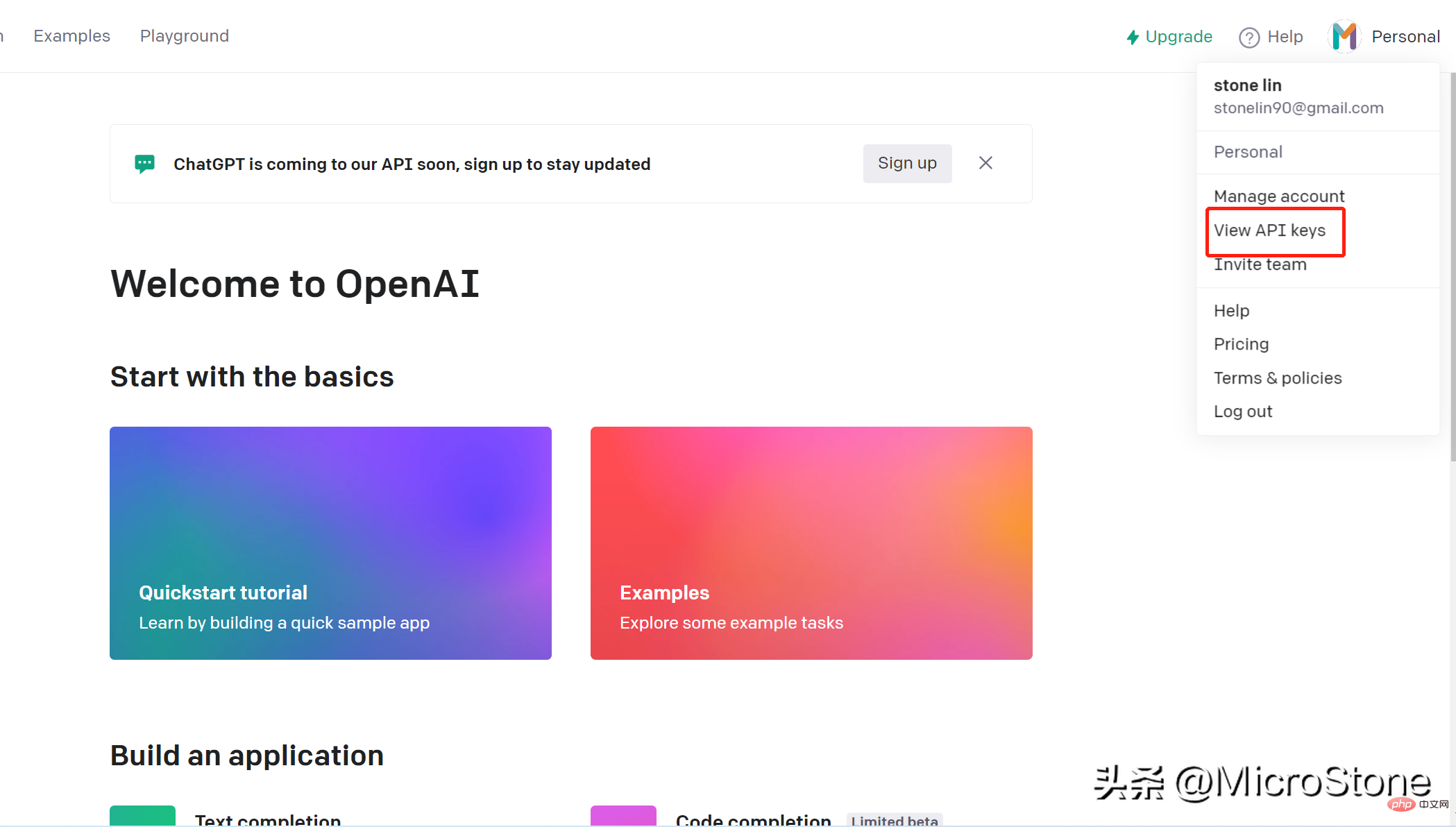

アカウントの作成は非常に簡単で、このリンクを開くだけです。 openai キーを介して OpenAI 上のモデルにアクセスできます。 API キーを作成する手順は次のとおりです。

- アカウントにログインします

- ページの右上隅に移動し、アカウント名をクリックし、ドロップダウンして、 [ View API Key] をクリックします。

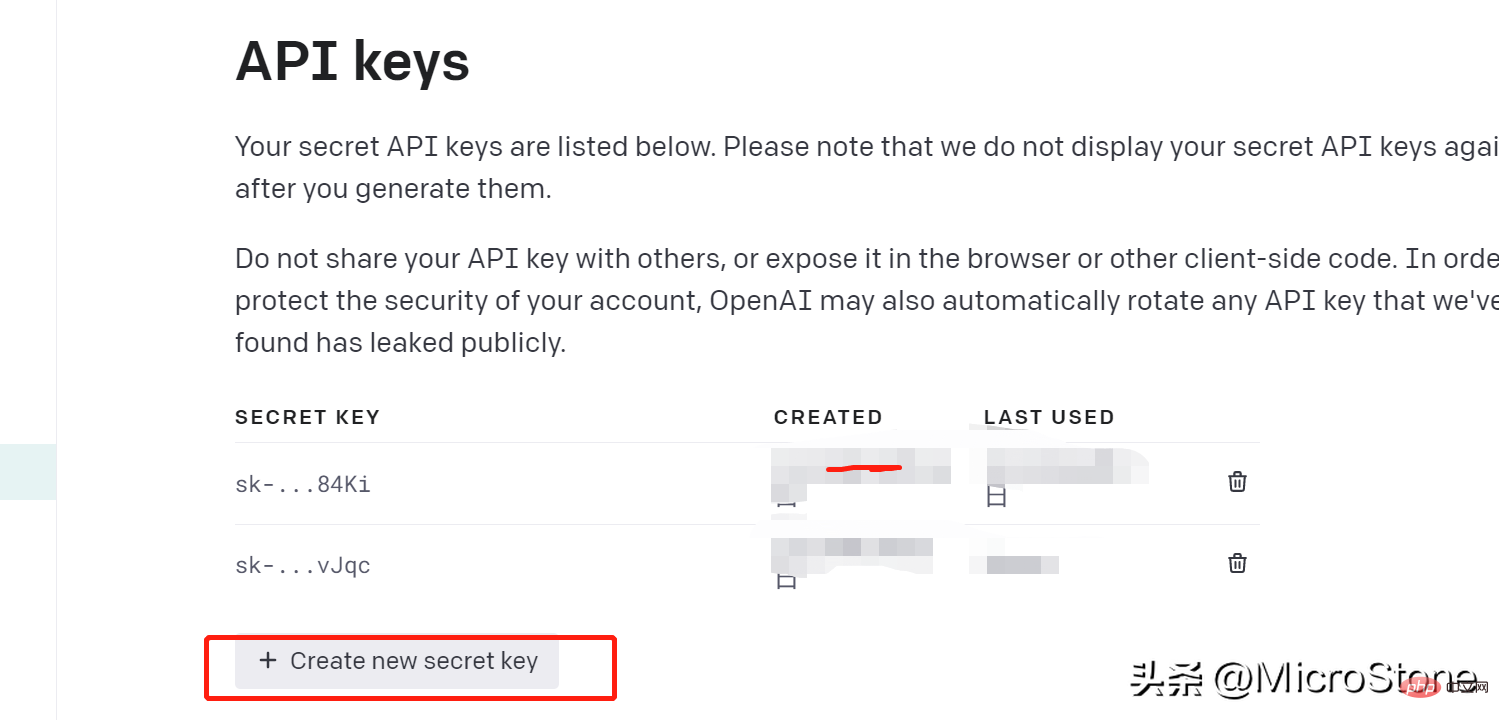

- [Create New Key] をクリックして、生成されたキーを すぐにコピーすることを忘れないでください。を覚えて保存してください。そうしないと、 は再びそれを表示できなくなります。

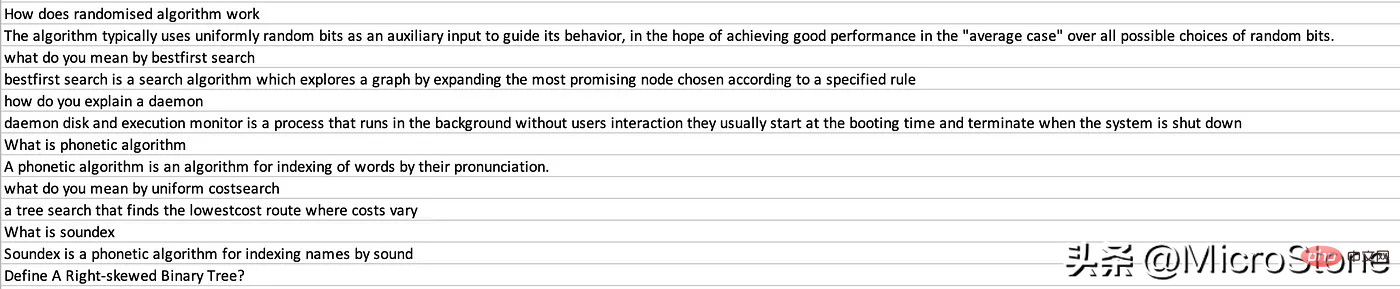

#2. データの準備

API キーを作成したので、微調整モデル用のデータの準備を開始できます。ここでデータセットを表示できます。

ステップ 1:

OpenAI ライブラリをインストールする pip install openai

インストール後、データをロードできます:

import os

import json

import openai

import pandas as pd

from dotenv import load_dotenv

load_dotenv()

os.environ['OPENAI_API_KEY'] = os.getenv('OPENAI_KEY')

openai.api_key = os.getenv('OPENAI_KEY')

data = pd.read_csv('data/data.csv')

new_df = pd.DataFrame({'Interview AI': data['Text'].iloc[::2].values, 'Human': data['Text'].iloc[1::2].values})

print(new_df.head(5))質問を Interview AI 列にロードし、対応する回答を Human 列にロードします。 OPENAI_API_KEYを保存するための環境変数 .env ファイルも作成する必要があります。

次に、データを GPT-3 標準に変換します。ドキュメントによると、データが 2 つのキーを持つ JSONL 形式であることを確認してください。これは重要です: プロンプト、例:complete

{ "prompt" :"<prompt text>" ,"completion" :"<ideal generated text>" }

{ "prompt" :"<prompt text>" ,"completion" :"<ideal generated text>" }上記に適合するようにデータセットを再構築し、基本的にデータ フレーム内の各行をループして配置します。テキストを人間に割り当て、インタビュー AI テキストを完了に割り当てます。

output = []

for index, row in new_df.iterrows():

print(row)

completion = ''

line = {'prompt': row['Human'], 'completion': row['Interview AI']}

output.append(line)

print(output)

with open('data/data.jsonl', 'w') as outfile:

for i in output:

json.dump(i, outfile)

outfile.write('n')prepare_data コマンドを使用します。プロンプトが表示されたらいくつかの質問が表示されます。Y または N で回答できます。

os.system("openai tools fine_tunes.prepare_data -f 'data/data.jsonl' ")最後に、data_prepared.jsonl という名前のファイルがディレクトリにダンプされます。

3. 楽しいチューニング モデル

モデルを楽しくチューニングするには、1 行のコマンドを実行するだけです:

os .system( "openai api fine_tunes.create -t 'data/data_prepared.jsonl' -m davinci " )

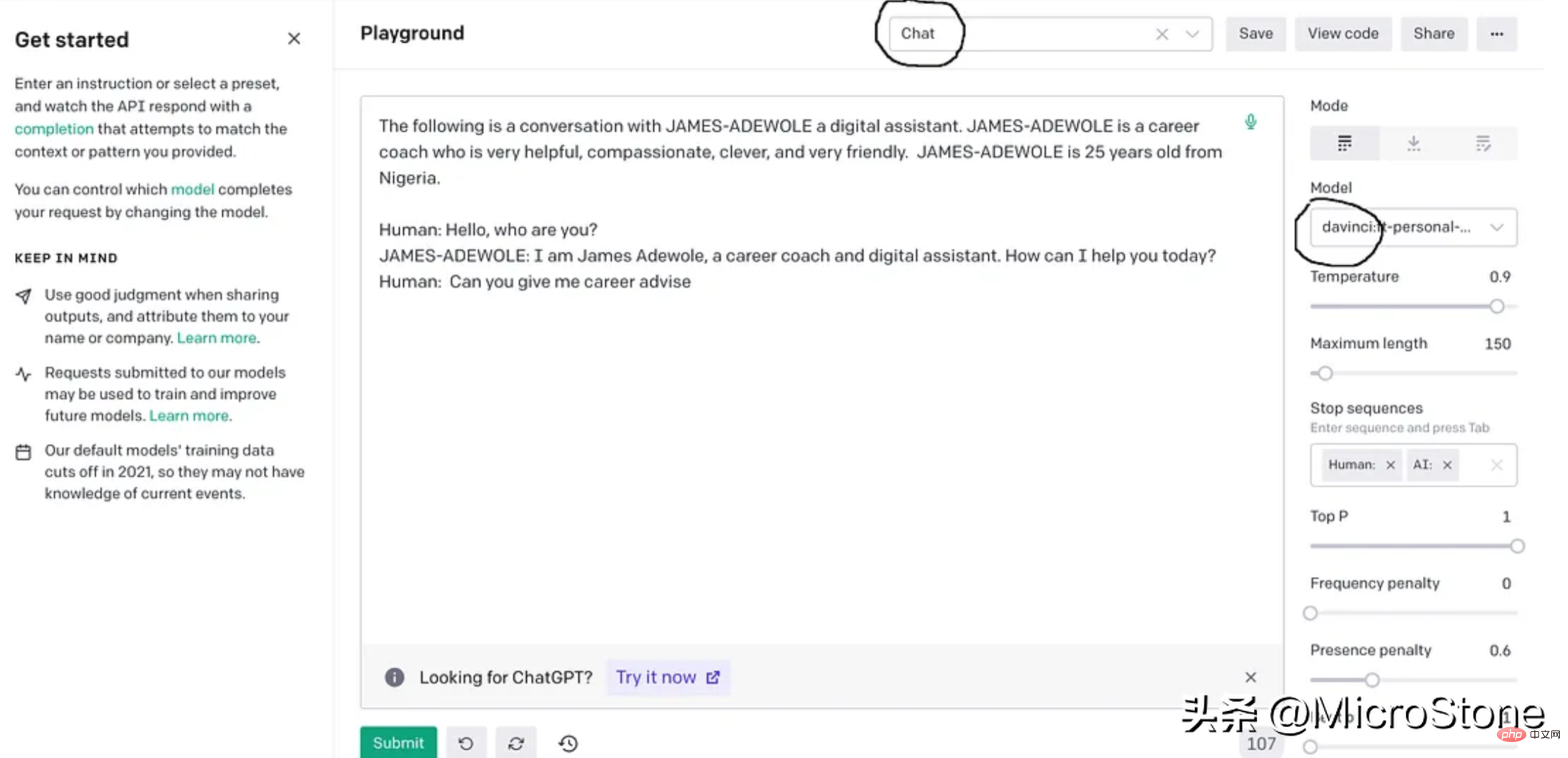

这基本上使用准备好的数据从 OpenAI 训练davinci模型,fine-tuning后的模型将存储在用户配置文件下,可以在模型下的右侧面板中找到。

4、模型调试

我们可以使用多种方法来验证我们的模型。可以直接从 Python 脚本、OpenAI Playground 来测试,或者使用 Flask 或 FastAPI 等框构建 Web 服务来测试。

我们先构建一个简单的函数来与此实验的模型进行交互。

def generate_response(input_text):

response = openai.Completion.create(

engine="davinci:ft-personal-2023-01-25-19-20-17",

prompt="The following is a conversation with DSA an AI assistant. "

"DSA is an interview bot who is very helpful and knowledgeable in data structure and algorithms.nn"

"Human: Hello, who are you?n"

"DSA: I am DSA, an interview digital assistant. How can I help you today?n"

"Human: {}nDSA:".format(input_text),

temperature=0.9,

max_tokens=150,

top_p=1,

frequency_penalty=0.0,

presence_penalty=0.6,

stop=["n", " Human:", " DSA:"]

)

return response.choices[0].text.strip()

output = generate_response(input_text)

print(output)把它们放在一起。

import os

import json

import openai

import pandas as pd

from dotenv import load_dotenv

load_dotenv()

os.environ['OPENAI_API_KEY'] = os.getenv('OPENAI_KEY')

openai.api_key = os.getenv('OPENAI_KEY')

data = pd.read_csv('data/data.csv')

new_df = pd.DataFrame({'Interview AI': data['Text'].iloc[::2].values, 'Human': data['Text'].iloc[1::2].values})

print(new_df.head(5))

output = []

for index, row in new_df.iterrows():

print(row)

completion = ''

line = {'prompt': row['Human'], 'completion': row['Interview AI']}

output.append(line)

print(output)

with open('data/data.jsonl', 'w') as outfile:

for i in output:

json.dump(i, outfile)

outfile.write('n')

os.system("openai tools fine_tunes.prepare_data -f 'data/data.jsonl' ")

os.system("openai api fine_tunes.create -t 'data/data_prepared.jsonl' -m davinci ")

def generate_response(input_text):

response = openai.Completion.create(

engine="davinci:ft-personal-2023-01-25-19-20-17",

prompt="The following is a conversation with DSA an AI assistant. "

"DSA is an interview bot who is very helpful and knowledgeable in data structure and algorithms.nn"

"Human: Hello, who are you?n"

"DSA: I am DSA, an interview digital assistant. How can I help you today?n"

"Human: {}nDSA:".format(input_text),

temperature=0.9,

max_tokens=150,

top_p=1,

frequency_penalty=0.0,

presence_penalty=0.6,

stop=["n", " Human:", " DSA:"]

)

return response.choices[0].text.strip()示例响应:

input_text = "what is breadth first search algorithm" output = generate_response(input_text)

The breadth-first search (BFS) is an algorithm for discovering all the reachable nodes from a starting point in a computer network graph or tree data structure

结论

GPT-3 是一种强大的大型语言生成模型,最近火到无边无际的chatgpt就是基于GPT-3上fine-tuning的,我们也可以对GPT-3进行fine-tuning,以构建适合我们自己业务的聊天机器人。fun-tuning过程调整模型的参数可以更好地适应业务对话数据,让机器人更善于理解和响应业务的需求。经过fine-tuning的模型可以集成到聊天机器人平台中以处理用户交互,还可以为聊天机器人生成客服回复习惯与用户交互。整个实现可以在这里找到,数据集可以从这里下载。

以上がGPT-3 を使用してビジネス ニーズを満たすエンタープライズ チャットボットを構築するの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7569

7569

15

15

1386

1386

52

52

87

87

11

11

28

28

107

107

開発者にとって必須の 5 つの AI ツール、お見逃しなく!

Dec 04, 2023 pm 02:25 PM

開発者にとって必須の 5 つの AI ツール、お見逃しなく!

Dec 04, 2023 pm 02:25 PM

今日のペースが速く、競争が激しい時代では、作業効率と製品品質の向上が特に重要になっています。ソフトウェア開発者は、時代の先を行くために最新のツールを常に活用する必要もあります。この記事では、2023 年に開発者にとって必須となる 5 種類の人工知能ツールをまとめました。 OpenAI の GPT モデルに基づくインテリジェントなコード補完ツール。コンテキストやユーザーの習慣に基づいてコード補完コンテンツを予測できるため、コーディング効率が向上します。 TabNine は、Visual などのさまざまな主流の統合開発環境 (IDE) およびエディターをサポートしています。

小紅書、AIチャットボット「ダヴィンチ」のテストを開始

Jan 15, 2024 pm 12:42 PM

小紅書、AIチャットボット「ダヴィンチ」のテストを開始

Jan 15, 2024 pm 12:42 PM

小紅書は人工知能機能を追加することで製品の充実に取り組んでおり、国内メディアの報道によると、小紅書はメインアプリで「Davinci」と呼ばれるAIアプリケーションを社内でテストしているという。このアプリケーションは、旅行ガイド、グルメガイド、地理的および文化的知識、ライフスキル、個人の成長、心理的構築などを含む、インテリジェントな質疑応答などの AI チャット サービスをユーザーに提供できると報告されています。はトレーニングに Meta A 製品の LLAMA モデルを使用しており、この製品は今年 9 月からテストされています。小紅書もAIのグループ会話機能の社内テストを行っていたという噂がある。この機能では、ユーザーはグループチャットでAIキャラクターを作成または紹介し、会話やインタラクションを行うことができます 画像出典:T

Deepseekの深い思考とオンライン検索は何を意味しますか

Feb 19, 2025 pm 04:09 PM

Deepseekの深い思考とオンライン検索は何を意味しますか

Feb 19, 2025 pm 04:09 PM

Deepseekaiツール詳細分析:ディープ思考とネットワーク検索機能詳細説明Deepseekは、強力なAIインテリジェントインタラクティブツールです。このツール。 Deepseekのコア機能の解釈:DeepShinking:Deepseekの「深い思考」関数は単純な情報検索ではありませんが、複雑な問題の多次元および構造化分析を実施するための巨大な事前訓練を受けた知識ベースと強力な論理的推論能力に基づいています。人間の思考パターンをシミュレートし、論理的に厳格で整理された回答を効率的かつ包括的に提供し、感情的な偏見を効果的に回避できます。インターネット検索:「インターネット検索」機能

ChatGPT と Java を使用してインテリジェントなチャットボットを開発する方法

Oct 28, 2023 am 08:54 AM

ChatGPT と Java を使用してインテリジェントなチャットボットを開発する方法

Oct 28, 2023 am 08:54 AM

この記事では、ChatGPT と Java を使用してインテリジェントなチャットボットを開発する方法を紹介し、いくつかの具体的なコード例を示します。 ChatGPT は、OpenAI によって開発された生成事前トレーニング トランスフォーマーの最新バージョンです。これは、自然言語を理解し、人間のようなテキストを生成できるニューラル ネットワーク ベースの人工知能テクノロジーです。 ChatGPT を使用すると、適応型チャットを簡単に作成できます

DeepSeekイメージジェネレーションチュートリアル

Feb 19, 2025 pm 04:15 PM

DeepSeekイメージジェネレーションチュートリアル

Feb 19, 2025 pm 04:15 PM

DeepSeek:強力なAI画像生成ツール! DeepSeek自体は画像生成ツールではありませんが、その強力なコアテクノロジーは、多くのAI塗装ツールを根本的にサポートしています。 DeepSeekを使用して画像を間接的に生成する方法を知りたいですか?読み続けてください! DeepSeekベースのAIツールで画像を生成します。次の手順では、これらのツールを使用するように導きます。AIペイントツールの起動:DeepSeekベースのAIペイントツールを検索して開きます(たとえば、「Simple AI」を検索します)。描画モードを選択します。「AI図面」または同様の関数を選択し、「アニメアバター」、「ランドスケープ」などのニーズに応じて画像タイプを選択します。

Javaを使用してAIベースのスマートチャットボットを開発する方法

Sep 21, 2023 am 10:45 AM

Javaを使用してAIベースのスマートチャットボットを開発する方法

Sep 21, 2023 am 10:45 AM

Java を使用して人工知能に基づくインテリジェント チャットボットを開発する方法 人工知能テクノロジーの継続的な開発に伴い、インテリジェント チャットボットはさまざまなアプリケーション シナリオでますます広く使用されるようになりました。人工知能に基づいたインテリジェントなチャットボットを開発すると、ユーザー エクスペリエンスが向上するだけでなく、企業の人件費も節約できます。この記事では、Java 言語を使用して人工知能に基づくインテリジェントなチャットボットを開発する方法を紹介し、具体的なコード例を示します。ボットの機能とドメインを決定する インテリジェントなチャットボットを開発する前に、まず次のことを決定する必要があります。

ChatGPT と Python の完璧な組み合わせ: リアルタイム チャットボットの構築

Oct 28, 2023 am 08:37 AM

ChatGPT と Python の完璧な組み合わせ: リアルタイム チャットボットの構築

Oct 28, 2023 am 08:37 AM

ChatGPT と Python の完璧な組み合わせ: リアルタイム チャットボットの構築 はじめに: 人工知能技術の急速な発展に伴い、チャットボットはさまざまな分野でますます重要な役割を果たしています。チャットボットは、ユーザーが即時にパーソナライズされた支援を提供できると同時に、企業に効率的な顧客サービスを提供するのに役立ちます。この記事では、OpenAI の ChatGPT モデルと Python 言語を使用してリアルタイム チャット ロボットを作成する方法と、具体的なコード例を紹介します。 1.チャットGPT

小紅書、Da Vinci AI チャットボット「Davinic」を社内でテスト

Jan 05, 2024 pm 10:57 PM

小紅書、Da Vinci AI チャットボット「Davinic」を社内でテスト

Jan 05, 2024 pm 10:57 PM

12 月 25 日の ChinaZ.com からのニュース: Tech Planet によると、Xiaohongshu はメイン APP で「Davinic」と呼ばれる AI 機能を内部テストしました。この機能は9月からテストされ、現在も継続中ですが、これもAIグループチャットに続いてXiaohongshuが立ち上げた新しいAIアプリケーションです。 「Davinic」は主にインテリジェントな質疑応答などのAIチャット機能をユーザーに提供します。 「Davinic」は、旅行ガイド、グルメガイド、地理的および文化的知識、ライフスキル、個人の成長と心理的アドバイス、およびアクティビティの推奨事項やその他の分野を含む、良い生活に関する質問と回答を提供することに重点を置いています。 「Davinic」は、Meta の LLAMA 大型モデルをベースにしています