世界最大の AI チップが大規模モデルの単一デバイス トレーニングの記録を破る、Cerebras は GPU を「抹殺」したい

この記事は Lei Feng.com から転載されたものです。転載する必要がある場合は、Lei Feng.com の公式 Web サイトにアクセスして許可を申請してください。

世界最大のアクセラレータチップCS-2ウェーハスケールエンジンの開発で有名な企業であるCerebrasは、人工知能のトレーニングに「ジャイアントコア」を使用するという重要な一歩を踏み出したと昨日発表した。同社は、世界最大の NLP (自然言語処理) AI モデルを単一チップ上でトレーニングしました。

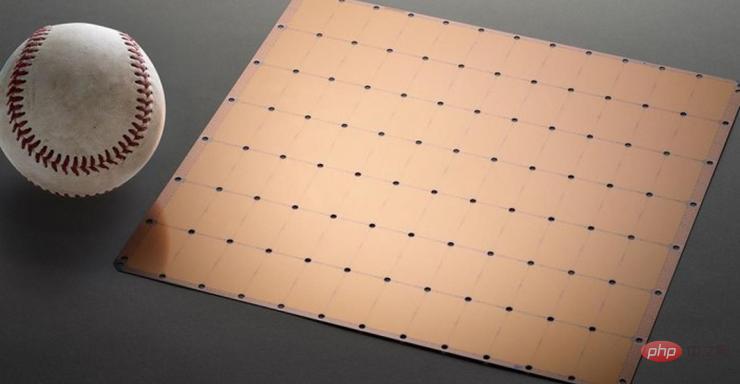

モデルには 20 億のパラメータがあり、CS-2 チップでトレーニングされています。世界最大の加速器チップは 7nm プロセスを使用し、正方形のウェハーからエッチングされます。主流のチップよりも数百倍大きく、15KWの電力があります。 2.6兆個の7nmトランジスタが統合され、85万個のコアと40GBのメモリがパッケージされています。

図 1 CS-2 ウェーハ スケール エンジン チップ

大規模 AI モデルのシングルチップ トレーニングの新記録

NLP モデルの開発は、人工知能の重要な分野です。 NLP モデルを使用すると、人工知能はテキストの意味を「理解」し、対応するアクションを実行できます。 OpenAI の DALL.E モデルは、典型的な NLP モデルです。このモデルは、ユーザーが入力したテキスト情報を画像出力に変換できます。

例えば、ユーザーが「アボカドの形をした肘掛け椅子」と入力すると、AIがこの文に対応する複数の画像を自動生成します。

写真: 情報を受け取ってAIが生成した「アボカドの形をした肘掛け椅子」の画像

それだけでなく、このモデルは、AIが種、幾何学、歴史的時代などの複雑な知識を理解できるようにすることもできます。等

しかし、これらすべてを実現するのは簡単ではありません。NLP モデルの従来の開発には、非常に高い計算能力コストと技術的閾値が伴います。

実際、数字だけを議論すると、Cerebras が開発したモデルの 20 億個のパラメータは、他のモデルと比較すると少し平凡に思えます。

前述の DALL.E モデルには 120 億のパラメータがありますが、現在最大のモデルは、DeepMind が昨年末に発表した Gopher で、2,800 億のパラメータがあります。

しかし、驚異的な数字とは別に、Cerebras が開発した NLP には大きな進歩があります。NLP モデルの開発の難しさを軽減します。

「Giant Core」はどのようにして GPU に勝つのでしょうか?

従来のプロセスによれば、NLP モデルを開発するには、開発者が巨大な NLP モデルをいくつかの機能部分に分割し、ワークロードを数百または数千のグラフィックス処理ユニットに分散する必要があります。

何千ものグラフィックス処理ユニットは、メーカーにとって莫大なコストを意味します。

技術的な問題もメーカーを悲惨にします。

モデルのスライスはカスタムの問題であり、各ニューラル ネットワーク、各 GPU、およびそれらを接続 (または相互接続) するネットワークの仕様は固有であり、システム間で移植可能ではありません。

メーカーは、最初のトレーニングの前に、これらすべての要素を明確に考慮する必要があります。

この作業は非常に複雑で、完了するまでに数か月かかる場合もあります。

セレブラス氏は、これが NLP モデル トレーニングの「最も苦痛な側面の 1 つ」であると述べました。 NLP を開発するために必要なリソースと専門知識を備えている企業はほんの一握りです。 AI 業界の他の企業にとって、NLP トレーニングは費用と時間がかかりすぎ、利用できません。

しかし、1 つのチップで 20 億のパラメーターを持つモデルをサポートできる場合、モデルのトレーニングのワークロードを分散するために大規模な GPU を使用する必要がないことを意味します。これにより、メーカーは何千もの GPU トレーニング コストと、関連するハードウェアおよびスケーリング要件を節約できます。また、ベンダーはモデルをスライスしてワークロードを数千の GPU に分散するという苦労をする必要がなくなります。

Cerebras は、モデルの品質を評価するために数値だけにこだわるわけではありません。パラメーターの数だけが基準ではありません。

セレブラスは、「巨大なコア」で生まれたモデルの「勤勉」を期待するのではなく、モデルが「賢い」ことを望んでいます。

Cerebras がパラメータ数の爆発的な増加を達成できる理由は、加重フロー技術を使用しているためです。このテクノロジーにより、計算量とメモリのフットプリントが分離され、AI ワークロードで増加する任意の数のパラメータを格納できる大きさにメモリを拡張できるようになります。

この画期的な進歩のおかげで、モデルのセットアップにかかる時間が数か月から数分に短縮されました。また、開発者は「数回のキーストローク」で GPT-J や GPT-Neo などのモデルを切り替えることができます。これにより、NLP 開発が容易になります。

これはNLPの分野に新たな変化をもたらしました。

Intersect360 Research の最高研究責任者である Dan Olds 氏は、Cerebras の成果について次のようにコメントしています。「費用対効果が高く、アクセスしやすい方法で大規模な言語モデルを大衆に提供する Cerebras の能力は、人工知能のエキサイティングな新時代を切り開きます。」

以上が世界最大の AI チップが大規模モデルの単一デバイス トレーニングの記録を破る、Cerebras は GPU を「抹殺」したいの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7710

7710

15

15

1640

1640

14

14

1394

1394

52

52

1288

1288

25

25

1232

1232

29

29

WorldCoin(WLD)価格予測2025-2031:WLDは2031年までに4ドルに達しますか?

Apr 21, 2025 pm 02:42 PM

WorldCoin(WLD)価格予測2025-2031:WLDは2031年までに4ドルに達しますか?

Apr 21, 2025 pm 02:42 PM

WorldCoin(WLD)は、独自の生体認証とプライバシー保護メカニズムを備えた暗号通貨市場で際立っており、多くの投資家の注目を集めています。 WLDは、特にOpenai人工知能技術と組み合わせて、革新的なテクノロジーを備えたAltcoinsの間で驚くほど演奏しています。しかし、デジタル資産は今後数年間でどのように振る舞いますか? WLDの将来の価格を一緒に予測しましょう。 2025年のWLD価格予測は、2025年にWLDで大幅に増加すると予想されています。市場分析は、平均WLD価格が1.31ドルに達する可能性があり、最大1.36ドルであることを示しています。ただし、クマ市場では、価格は約0.55ドルに低下する可能性があります。この成長の期待は、主にWorldCoin2によるものです。

クロスチェーントランザクションとはどういう意味ですか?クロスチェーントランザクションとは何ですか?

Apr 21, 2025 pm 11:39 PM

クロスチェーントランザクションとはどういう意味ですか?クロスチェーントランザクションとは何ですか?

Apr 21, 2025 pm 11:39 PM

クロスチェーントランザクションをサポートする交換:1。Binance、2。Uniswap、3。Sushiswap、4。CurveFinance、5。Thorchain、6。1inchExchange、7。DLNTrade、これらのプラットフォームはさまざまな技術を通じてマルチチェーン資産トランザクションをサポートします。

「ブラックマンデーセル」は、暗号通貨業界にとって厳しい日です

Apr 21, 2025 pm 02:48 PM

「ブラックマンデーセル」は、暗号通貨業界にとって厳しい日です

Apr 21, 2025 pm 02:48 PM

暗号通貨市場での突入は投資家の間でパニックを引き起こし、Dogecoin(Doge)は最も困難なヒット分野の1つになりました。その価格は急激に下落し、分散財務財務(DEFI)(TVL)の総価値が激しく減少しました。 「ブラックマンデー」の販売波が暗号通貨市場を席巻し、ドゲコインが最初にヒットしました。そのdefitVLは2023レベルに低下し、通貨価格は過去1か月で23.78%下落しました。 DogecoinのDefitVLは、主にSOSO値指数が26.37%減少したため、272万ドルの安値に低下しました。退屈なDAOやThorchainなどの他の主要なDefiプラットフォームも、それぞれ24.04%と20減少しました。

カーネルエアドロップ報酬を獲得する方法バイナンスフルプロセス戦略

Apr 21, 2025 pm 01:03 PM

カーネルエアドロップ報酬を獲得する方法バイナンスフルプロセス戦略

Apr 21, 2025 pm 01:03 PM

暗号通貨の賑やかな世界では、新しい機会が常に現れます。現在、Kerneldao(Kernel)Airdropアクティビティは多くの注目を集め、多くの投資家の注目を集めています。それで、このプロジェクトの起源は何ですか? BNBホルダーはそれからどのような利点を得ることができますか?心配しないでください、以下はあなたのためにそれを一つ一つ明らかにします。

Aavenomicsは、Aaveプロトコルトークンを変更し、Tokenの買戻しを導入するための推奨事項です。

Apr 21, 2025 pm 06:24 PM

Aavenomicsは、Aaveプロトコルトークンを変更し、Tokenの買戻しを導入するための推奨事項です。

Apr 21, 2025 pm 06:24 PM

Aavenomicsは、Aaveプロトコルトークンを変更し、Aavedaoの定足数を実装したToken Reposを導入する提案です。 Aave Project Chain(ACI)の創設者であるMarc Zellerは、これをXで発表し、契約の新しい時代をマークしていることに注目しました。 Aave Chain Initiative(ACI)の創設者であるMarc Zellerは、Aavenomicsの提案にAave Protocolトークンの変更とトークンリポジトリの導入が含まれていると発表しました。 Zellerによると、これは契約の新しい時代を告げています。 Aavedaoのメンバーは、水曜日の週に100でした。

ハイブリッドブロックチェーン取引プラットフォームとは何ですか?

Apr 21, 2025 pm 11:36 PM

ハイブリッドブロックチェーン取引プラットフォームとは何ですか?

Apr 21, 2025 pm 11:36 PM

暗号通貨交換を選択するための提案:1。流動性の要件については、優先度は、その順序の深さと強力なボラティリティ抵抗のため、Binance、gate.ioまたはokxです。 2。コンプライアンスとセキュリティ、Coinbase、Kraken、Geminiには厳格な規制の承認があります。 3.革新的な機能、Kucoinのソフトステーキング、Bybitのデリバティブデザインは、上級ユーザーに適しています。

なぜ仮想通貨価格の上昇または下落があるのですか?なぜ仮想通貨価格の上昇または下落があるのですか?

Apr 21, 2025 am 08:57 AM

なぜ仮想通貨価格の上昇または下落があるのですか?なぜ仮想通貨価格の上昇または下落があるのですか?

Apr 21, 2025 am 08:57 AM

仮想通貨価格の上昇の要因には、次のものが含まれます。1。市場需要の増加、2。供給の減少、3。刺激された肯定的なニュース、4。楽観的な市場感情、5。マクロ経済環境。衰退要因は次のとおりです。1。市場需要の減少、2。供給の増加、3。ネガティブニュースのストライキ、4。悲観的市場感情、5。マクロ経済環境。

通貨サークルでのレバレッジされた交換のランキングは

Apr 21, 2025 pm 11:24 PM

通貨サークルでのレバレッジされた交換のランキングは

Apr 21, 2025 pm 11:24 PM

2025年のレバレッジド取引、セキュリティ、ユーザーエクスペリエンスで優れたパフォーマンスを持つプラットフォームは次のとおりです。1。OKX、高周波トレーダーに適しており、最大100倍のレバレッジを提供します。 2。世界中の多通貨トレーダーに適したバイナンス、125倍の高いレバレッジを提供します。 3。Gate.io、プロのデリバティブプレーヤーに適し、100倍のレバレッジを提供します。 4。ビットゲットは、初心者やソーシャルトレーダーに適しており、最大100倍のレバレッジを提供します。 5。Kraken、安定した投資家に適しており、5倍のレバレッジを提供します。 6。Altcoinエクスプローラーに適したBybit。20倍のレバレッジを提供します。 7。低コストのトレーダーに適したKucoinは、10倍のレバレッジを提供します。 8。ビットフィネックス、シニアプレイに適しています