説明可能な人工知能システム (XAI) を構築するための 6 つの推奨 Python フレームワーク

AI は独自に意思決定できるブラック ボックスのようなものですが、その理由は人々にはわかりません。 AIモデルを構築し、データを入力し、結果を出力しますが、問題の1つは、AIがなぜそのような結論に達するのかを説明できないことです。文脈や説明なしに出力された結果をただ受け入れるのではなく、AI がどのようにして特定の結論に達するのか、その背後にある理由を理解する必要があります。

解釈可能性は人々が理解できるように設計されています:

- どのように学習されますか?

- 何が学習されますか?

- なぜ特定の入力がそのようなものになるのかa Decision?

- Is the Decision Reliable?

この記事では、解釈可能性を高めるための 6 つの Python フレームワークを紹介します。

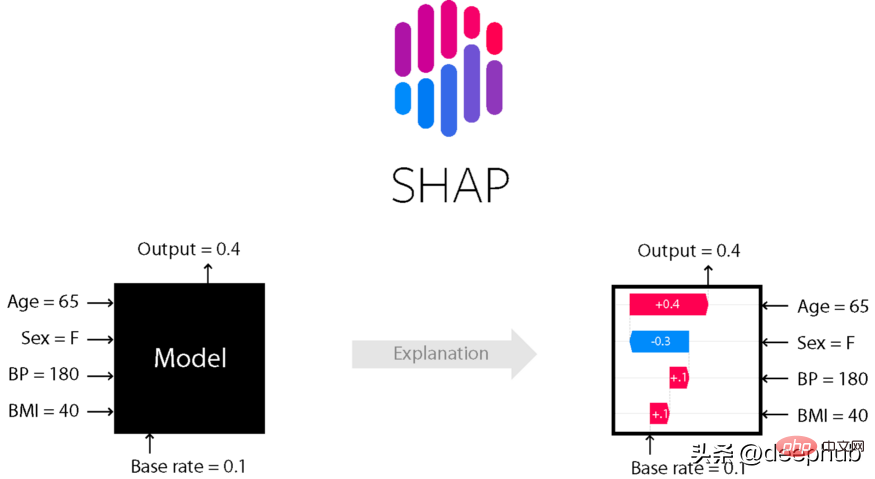

SHAP

SHapley 加算的説明 (SHApley 加算的説明) は、機械学習モデルの出力を説明するためのゲーム理論手法です。ゲーム理論とその関連拡張からの古典的な Shapley 値を利用して、最適なクレジット割り当てをローカルな解釈に関連付けます (詳細と引用については論文を参照してください)。

データセット内の各特徴のモデル予測への寄与は、Shapley 値によって説明されます。 Lundberg と Lee の SHAP アルゴリズムは 2017 年に初めて公開され、このアルゴリズムはさまざまな分野のコミュニティで広く採用されています。

pip または conda を使用して、shap ライブラリをインストールします。

# install with pippip install shap# install with condaconda install -c conda-forge shap

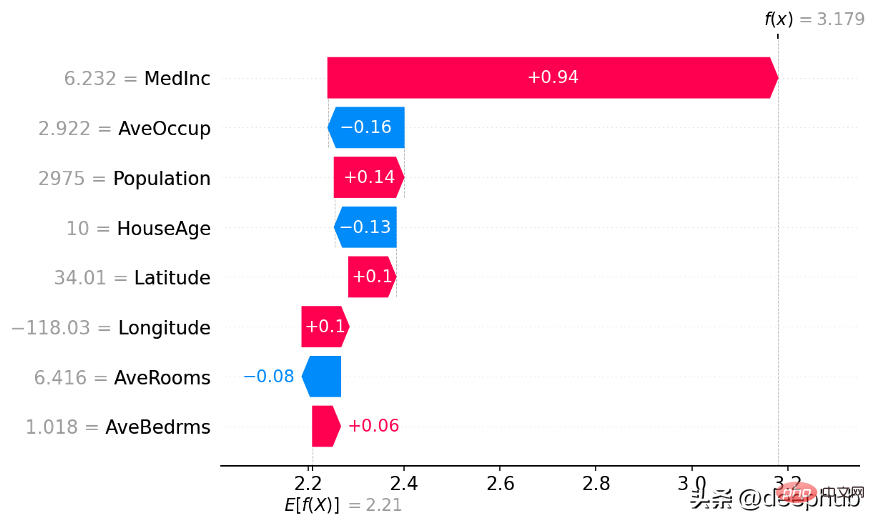

Shap ライブラリを使用してウォーターフォール チャートを作成します

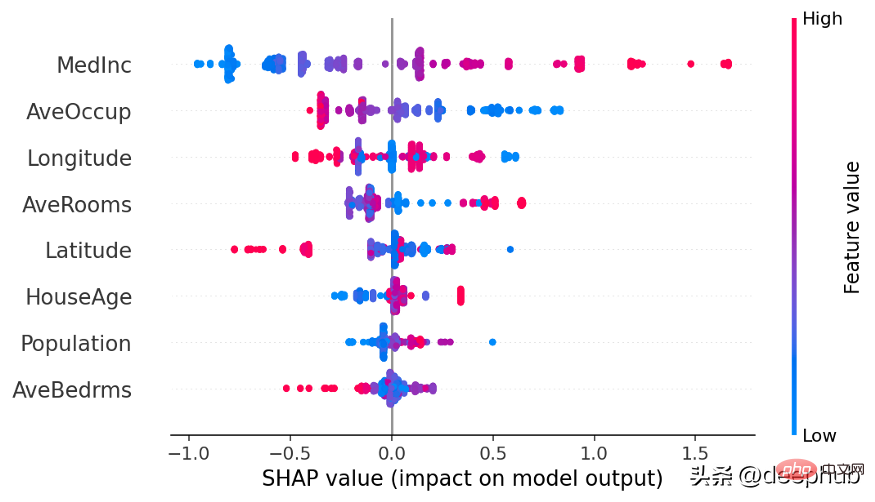

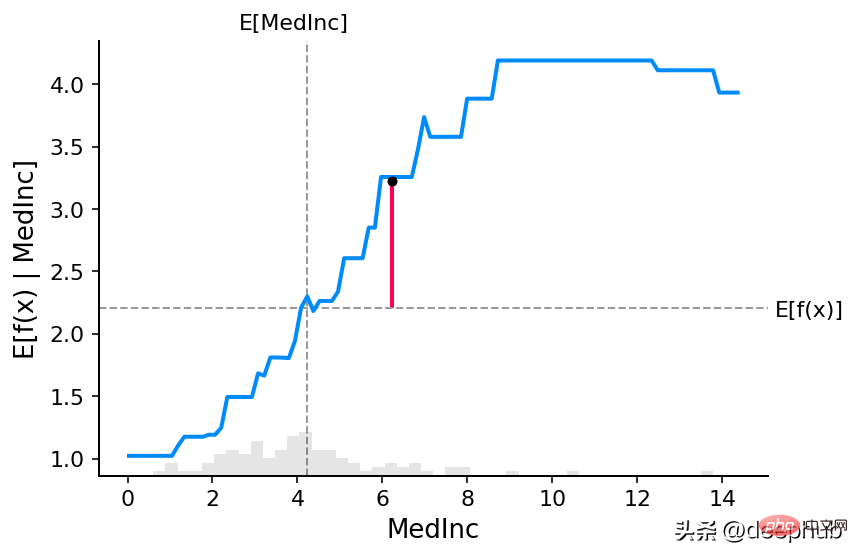

##Shap ライブラリを使用した部分依存関係グラフの構築

##Shap ライブラリを使用した部分依存関係グラフの構築

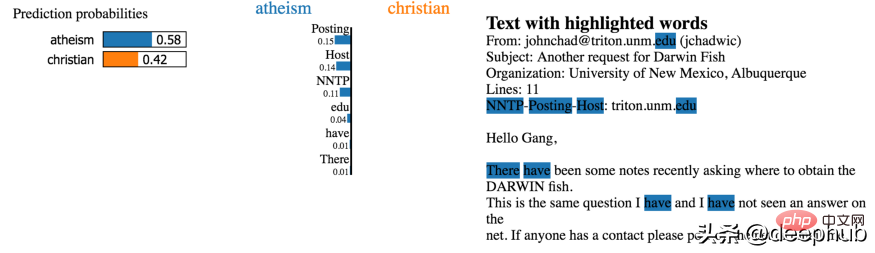

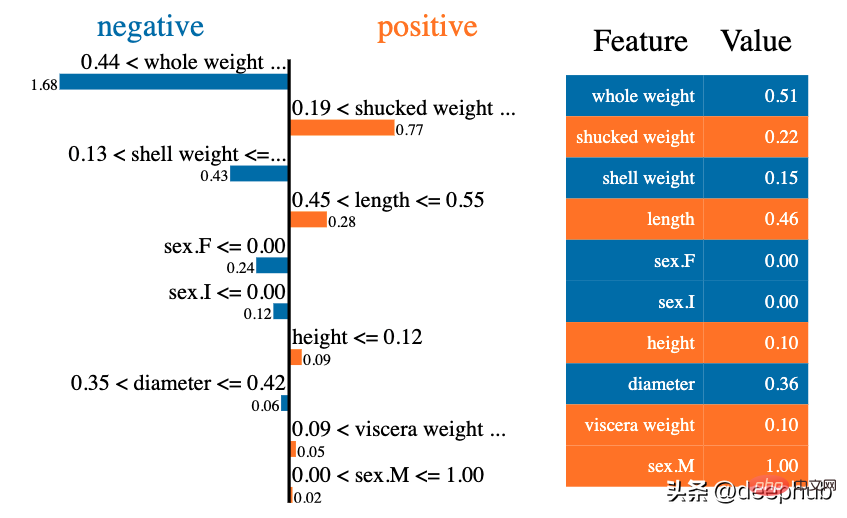

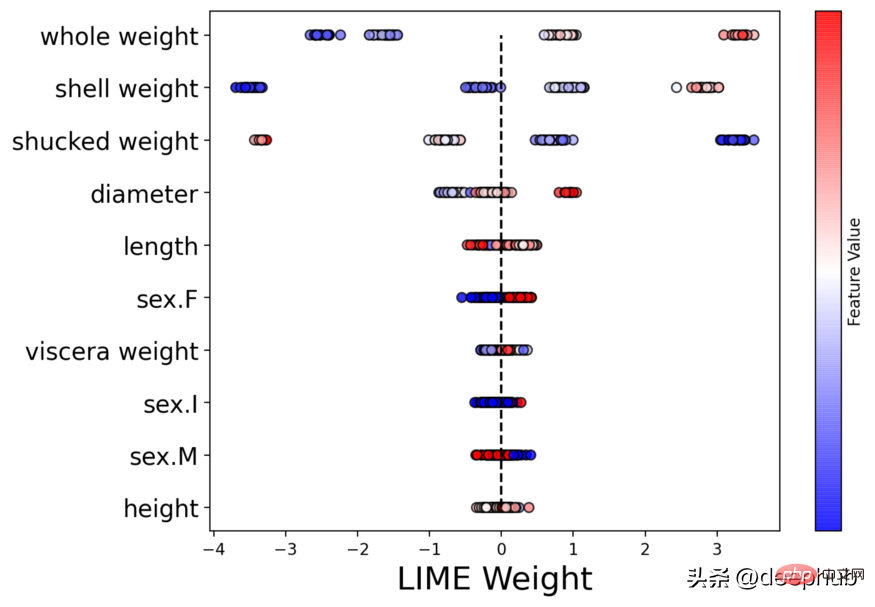

LIME

解釈可能性の分野では、最初によく知られたメソッドの 1 つは LIME です。これは、機械学習モデルがどのようなものを学習しているのか、そしてなぜ特定の方法で予測するのかを説明するのに役立ちます。 Lime は現在、表形式データ、テキスト分類子、および画像分類子の解釈をサポートしています。

モデルがそのように予測する理由を知ることは、アルゴリズムを調整する上で非常に重要です。 LIME の説明を読めば、モデルがなぜこのように動作するのかが理解できます。モデルが計画どおりに実行されない場合は、データ準備フェーズで間違いが発生した可能性があります。

#pip を使用してインストール

pip install lime

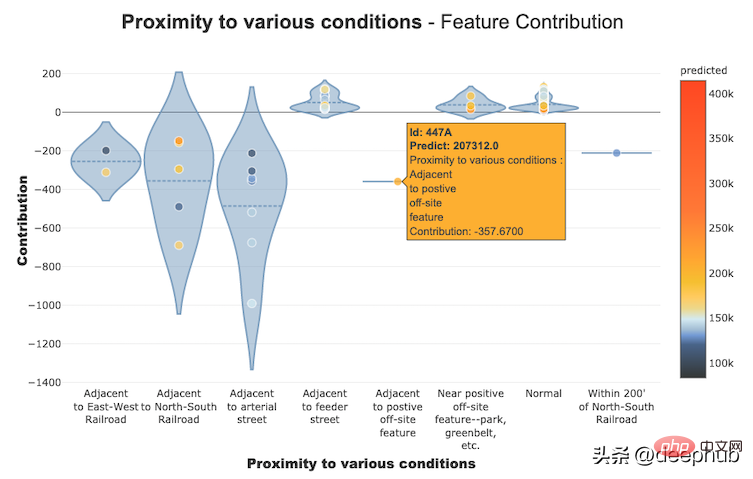

Shapash

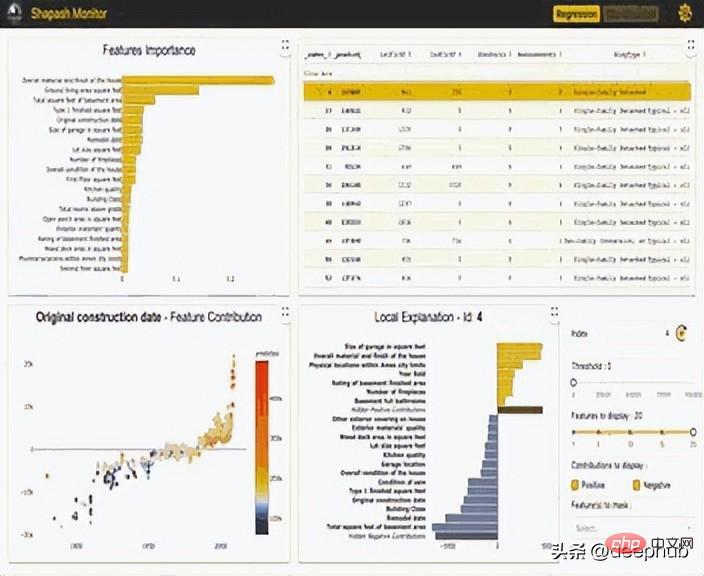

Shapash

「Shapash は、機械学習を誰にとっても解釈可能かつ理解できるようにする Python ライブラリです。Shapash は、いくつかの種類の視覚化を提供し、明確なラベルを表示します。 「誰もが理解できます。データ サイエンティストは、より簡単にモデルを理解し、結果を共有できます。エンド ユーザーは、最も標準的な概要を使用して、モデルがどのように判断したかを理解できます。」

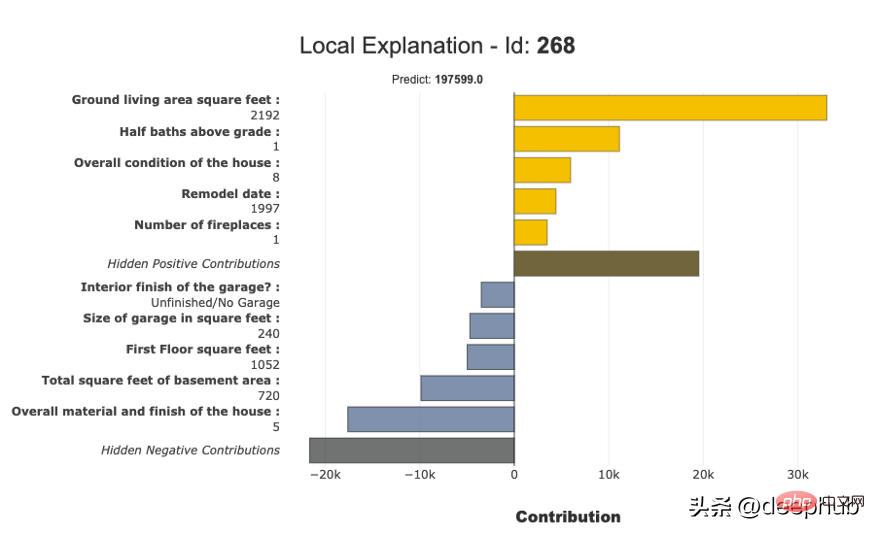

# #ストーリー、洞察、および情報を含む調査結果を表現するためデータ内のモデル、対話性、美しいグラフが不可欠です。ビジネスおよびデータ サイエンティスト/アナリストが AI/ML の結果を提示して操作するための最良の方法は、結果を視覚化して Web 上に公開することです。 Shapash ライブラリは、インタラクティブなダッシュボードを生成でき、多くの視覚化チャートのコレクションを備えています。形状/ライムの解釈可能性に関連します。 SHAP/Lime をバックエンドとして使用できるため、見栄えの良いチャートのみが提供されます。 #Shapash を使用した機能貢献グラフの構築

#Shapash を使用して構築された部分解釈グラフ

#Shapash を使用して構築された部分解釈グラフ

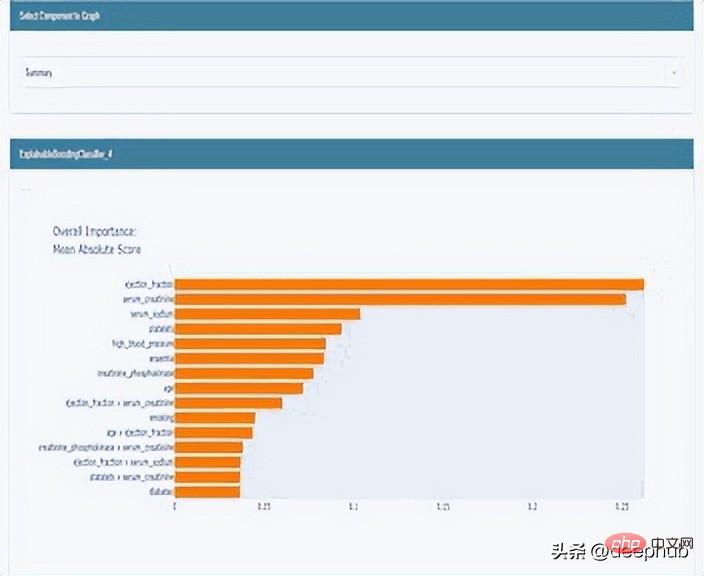

InterpretML

InterpretML は、機械学習の解釈可能性アルゴリズムを研究者に提供するオープンソースの Python パッケージです。 InterpretML は、解釈可能なモデル (グラスボックス) のトレーニングと、既存の ML パイプラインの解釈 (ブラックボックス) をサポートします。

InterpretML は、2 種類の解釈可能性を示します。グラスボックス モデル – 解釈可能性を目的に設計された機械学習モデル (例: 線形モデル、ルール リスト、一般化された加算モデル)、およびブラック ボックス解釈可能性手法 – 既存のシステムを説明するために使用されます (例: 部分依存関係、LIME)。 。統合 API を使用し、複数のメソッドをカプセル化し、組み込みの拡張可能な視覚化プラットフォームを備えたこのパッケージにより、研究者は解釈可能アルゴリズムを簡単に比較できます。 InterpretML には、説明ブースティング マシンの最初の実装も含まれています。これは、多くのブラック ボックス モデルと同じくらい正確な、強力で解釈可能なガラスボックス モデルです。

#ELI5

ELI5 は、機械学習分類器のデバッグとその予測の解釈に役立つ Python ライブラリです。現在、次の機械学習フレームワークがサポートされています:

scikit-learn- XGBoost、LightGBM CatBoost

- Keras

- ELI5 には 2 つあります。分類または回帰モデルを説明する主な方法:

- モデルの個々の予測を調べて、モデルが何を行うかを説明します。決める。

#ELI5 ライブラリを使用してグローバル ウェイトを生成する

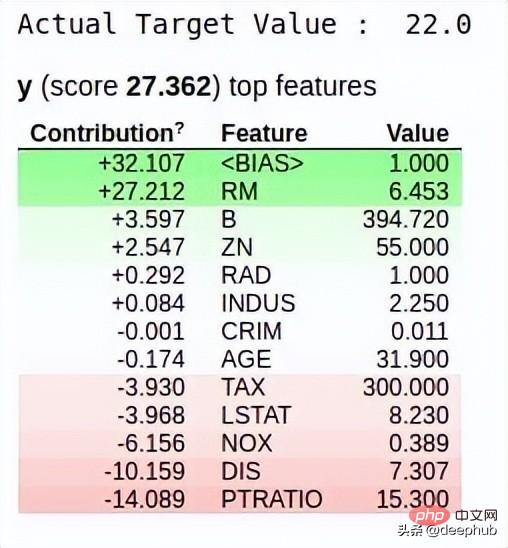

ELI5 ライブラリを使用してローカル ウェイトを生成する

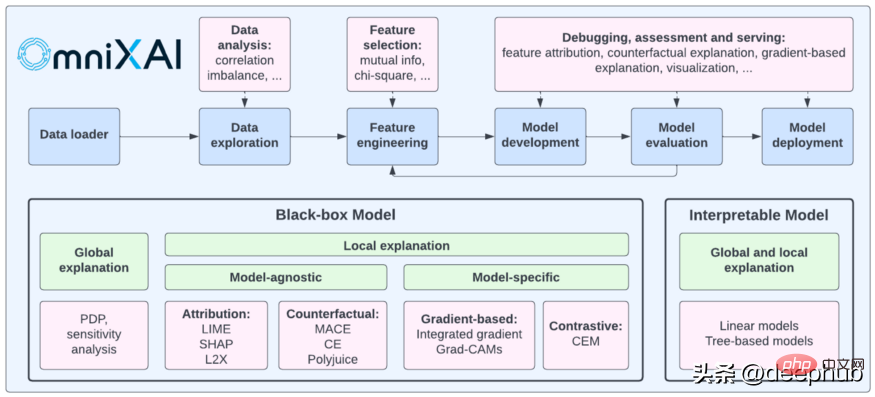

以下は、OmniXAI が提供するものと他の同様のライブラリとの比較です。

以上が説明可能な人工知能システム (XAI) を構築するための 6 つの推奨 Python フレームワークの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7488

7488

15

15

1377

1377

52

52

77

77

11

11

19

19

39

39

mysqlは支払う必要がありますか

Apr 08, 2025 pm 05:36 PM

mysqlは支払う必要がありますか

Apr 08, 2025 pm 05:36 PM

MySQLには、無料のコミュニティバージョンと有料エンタープライズバージョンがあります。コミュニティバージョンは無料で使用および変更できますが、サポートは制限されており、安定性要件が低く、技術的な能力が強いアプリケーションに適しています。 Enterprise Editionは、安定した信頼性の高い高性能データベースを必要とするアプリケーションに対する包括的な商業サポートを提供し、サポートの支払いを喜んでいます。バージョンを選択する際に考慮される要因には、アプリケーションの重要性、予算編成、技術スキルが含まれます。完璧なオプションはなく、最も適切なオプションのみであり、特定の状況に応じて慎重に選択する必要があります。

インストール後にMySQLの使用方法

Apr 08, 2025 am 11:48 AM

インストール後にMySQLの使用方法

Apr 08, 2025 am 11:48 AM

この記事では、MySQLデータベースの操作を紹介します。まず、MySQLWorkBenchやコマンドラインクライアントなど、MySQLクライアントをインストールする必要があります。 1. mysql-uroot-pコマンドを使用してサーバーに接続し、ルートアカウントパスワードでログインします。 2。CreatedAtaBaseを使用してデータベースを作成し、データベースを選択します。 3. createTableを使用してテーブルを作成し、フィールドとデータ型を定義します。 4. INSERTINTOを使用してデータを挿入し、データをクエリし、更新することでデータを更新し、削除してデータを削除します。これらの手順を習得することによってのみ、一般的な問題に対処することを学び、データベースのパフォーマンスを最適化することでMySQLを効率的に使用できます。

高負荷アプリケーションのMySQLパフォーマンスを最適化する方法は?

Apr 08, 2025 pm 06:03 PM

高負荷アプリケーションのMySQLパフォーマンスを最適化する方法は?

Apr 08, 2025 pm 06:03 PM

MySQLデータベースパフォーマンス最適化ガイドリソース集約型アプリケーションでは、MySQLデータベースが重要な役割を果たし、大規模なトランザクションの管理を担当しています。ただし、アプリケーションのスケールが拡大すると、データベースパフォーマンスのボトルネックが制約になることがよくあります。この記事では、一連の効果的なMySQLパフォーマンス最適化戦略を検討して、アプリケーションが高負荷の下で効率的で応答性の高いままであることを保証します。実際のケースを組み合わせて、インデックス作成、クエリ最適化、データベース設計、キャッシュなどの詳細な主要なテクノロジーを説明します。 1.データベースアーキテクチャの設計と最適化されたデータベースアーキテクチャは、MySQLパフォーマンスの最適化の基礎です。いくつかのコア原則は次のとおりです。適切なデータ型を選択し、ニーズを満たす最小のデータ型を選択すると、ストレージスペースを節約するだけでなく、データ処理速度を向上させることもできます。

hadidb:pythonの軽量で水平方向にスケーラブルなデータベース

Apr 08, 2025 pm 06:12 PM

hadidb:pythonの軽量で水平方向にスケーラブルなデータベース

Apr 08, 2025 pm 06:12 PM

hadidb:軽量で高レベルのスケーラブルなPythonデータベースHadIDB(HadIDB)は、Pythonで記述された軽量データベースで、スケーラビリティが高くなっています。 PIPインストールを使用してHADIDBをインストールする:PIPINSTALLHADIDBユーザー管理CREATEユーザー:CREATEUSER()メソッド新しいユーザーを作成します。 Authentication()メソッドは、ユーザーのIDを認証します。 fromhadidb.operationimportuseruser_obj = user( "admin"、 "admin")user_obj。

MongoDBデータベースパスワードを表示するNAVICATの方法

Apr 08, 2025 pm 09:39 PM

MongoDBデータベースパスワードを表示するNAVICATの方法

Apr 08, 2025 pm 09:39 PM

Hash値として保存されているため、Navicatを介してMongoDBパスワードを直接表示することは不可能です。紛失したパスワードを取得する方法:1。パスワードのリセット。 2。構成ファイルを確認します(ハッシュ値が含まれる場合があります)。 3.コードを確認します(パスワードをハードコードできます)。

mysqlはインターネットが必要ですか?

Apr 08, 2025 pm 02:18 PM

mysqlはインターネットが必要ですか?

Apr 08, 2025 pm 02:18 PM

MySQLは、基本的なデータストレージと管理のためにネットワーク接続なしで実行できます。ただし、他のシステムとのやり取り、リモートアクセス、または複製やクラスタリングなどの高度な機能を使用するには、ネットワーク接続が必要です。さらに、セキュリティ対策(ファイアウォールなど)、パフォーマンスの最適化(適切なネットワーク接続を選択)、およびデータバックアップは、インターネットに接続するために重要です。

MySQLワークベンチはMariadBに接続できますか

Apr 08, 2025 pm 02:33 PM

MySQLワークベンチはMariadBに接続できますか

Apr 08, 2025 pm 02:33 PM

MySQLワークベンチは、構成が正しい場合、MariadBに接続できます。最初にコネクタタイプとして「mariadb」を選択します。接続構成では、ホスト、ポート、ユーザー、パスワード、およびデータベースを正しく設定します。接続をテストするときは、ユーザー名とパスワードが正しいかどうか、ポート番号が正しいかどうか、ファイアウォールが接続を許可するかどうか、データベースが存在するかどうか、MariadBサービスが開始されていることを確認してください。高度な使用法では、接続プーリングテクノロジーを使用してパフォーマンスを最適化します。一般的なエラーには、不十分な権限、ネットワーク接続の問題などが含まれます。エラーをデバッグするときは、エラー情報を慎重に分析し、デバッグツールを使用します。ネットワーク構成を最適化すると、パフォーマンスが向上する可能性があります

MySQLにはサーバーが必要ですか

Apr 08, 2025 pm 02:12 PM

MySQLにはサーバーが必要ですか

Apr 08, 2025 pm 02:12 PM

生産環境の場合、パフォーマンス、信頼性、セキュリティ、スケーラビリティなどの理由により、通常、MySQLを実行するためにサーバーが必要です。サーバーには通常、より強力なハードウェア、冗長構成、より厳しいセキュリティ対策があります。小規模で低負荷のアプリケーションの場合、MySQLはローカルマシンで実行できますが、リソースの消費、セキュリティリスク、メンテナンスコストを慎重に考慮する必要があります。信頼性とセキュリティを高めるには、MySQLをクラウドまたは他のサーバーに展開する必要があります。適切なサーバー構成を選択するには、アプリケーションの負荷とデータボリュームに基づいて評価が必要です。