過去 3 年間を総括して、MIT が AI アクセラレータに関するレビュー論文を発表

過去 1 年間、新興企業も既存企業も、人工知能 (AI) および機械学習 (ML) アクセラレーターの発表、立ち上げ、展開が遅れていました。しかし、それは不合理なことではなく、加速器レポートを発行する多くの企業は、加速器の設計の調査、分析、設計、検証、比較検討と、加速器をプログラムするための技術スタックの構築に 3 ~ 4 年を費やしています。アクセラレータのアップグレード バージョンをリリースした企業の場合、開発サイクルはまだ少なくとも 2 ~ 3 年ですが、開発サイクルは短縮されていると報告されています。これらのアクセラレータの焦点は、依然としてディープ ニューラル ネットワーク (DNN) モデルの高速化にあり、そのアプリケーション シナリオは、非常に低消費電力の組み込み音声認識や画像分類から、データセンターの大規模なモデルのトレーニングにまで及びます。産業およびテクノロジー企業にとって、最新の従来型コンピューティングから機械学習ソリューションへの移行の重要な部分です。

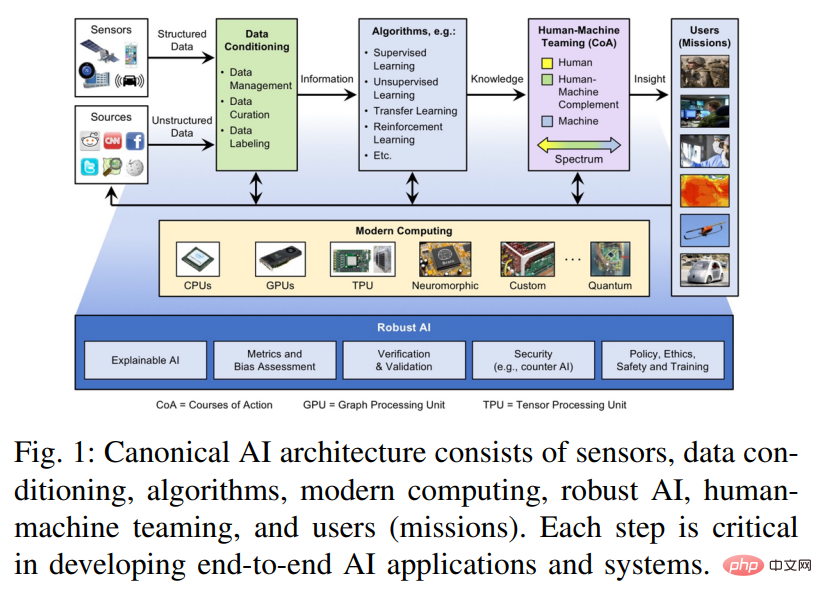

AI エコシステムは、エッジ コンピューティング、従来のハイ パフォーマンス コンピューティング (HPC)、およびハイ パフォーマンス データ分析 (HPDA) のコンポーネントを統合し、意思決定者、最前線の担当者、分析に効果的に権限を与えるために連携する必要があります。教師のエンパワーメント。図 1 は、このエンドツーエンド AI ソリューションとそのコンポーネントのアーキテクチャの概要を示しています。

このステップでは、まず元のデータをデータキュレーションする必要があり、データは融合、集約、構造化、蓄積されて情報に変換されます。データ ラングリング ステップによって生成された情報は、パターンの抽出、欠落データの補完、データ セット間の類似点の発見、および予測を行うニューラル ネットワークなどの教師ありまたは教師なしアルゴリズムへの入力として機能し、それによって入力情報を実用的な知識に変換します。この実用的な知識は人間に転送され、人間と機械のコラボレーション段階での意思決定プロセスに使用されます。人間とマシンのコラボレーション段階では、ユーザーに有用かつ重要な洞察が提供され、知識が実用的なインテリジェンスまたは洞察に変換されます。

このシステムを支えているのは最新のコンピューティング システムです。ムーアの法則のトレンドは終わりましたが、同時に、デナードの法則 (電力密度)、クロック周波数、コア数、クロック サイクルあたりの命令数、ジュールあたりの命令数 (クーミーの法則) など、多くの関連法則やトレンドが提案されています。車載アプリケーション、ロボティクス、スマートフォンで初めて登場したシステムオンチップ (SoC) のトレンドから、一般的に使用されるコア、メソッド、または機能のアクセラレータの開発と統合を通じてイノベーションが進歩し続けています。これらのアクセラレータは、深層学習プロセッサとアクセラレータの革新の爆発を含め、パフォーマンスと機能の柔軟性の間のさまざまなバランスを提供します。この記事では、多数の関連論文を読んで、これらのテクノロジの相対的な利点を探ります。これらのテクノロジは、サイズ、重量、電力に関して極端な要件がある組み込みシステムやデータセンターに人工知能を適用する場合に特に重要であるためです。

この記事は、過去 3 年間の IEEE-HPEC 論文の更新版です。過去数年と同様、この記事では引き続き、計算量が非常に多いディープ ニューラル ネットワーク (DNN) と畳み込みニューラル ネットワーク (CNN) のアクセラレータとプロセッサに焦点を当てます。多くの AI/ML エッジ アプリケーションは推論に大きく依存しているため、この記事では推論におけるアクセラレータとプロセッサの開発に焦点を当てています。この記事では、アクセラレータでサポートされるすべての数値精度タイプについて説明しますが、ほとんどのアクセラレータの最高の推論パフォーマンスは int8 または fp16/bf16 (IEEE 16 ビット浮動小数点または Google の 16 ビット Brain float) です。

論文リンク: https://arxiv.org/pdf/2210.04055.pdf

現在、AI アクセラレーターについて議論する論文が数多くあります。たとえば、この一連の調査の最初の論文では、特定の AI モデルの FPGA のピーク パフォーマンスについて説明しています。これまでの調査では FPGA が詳しく取り上げられていたため、今回の調査には含まれていません。この継続的な調査活動と記事は、AI アクセラレータの計算能力、エネルギー効率、組み込みおよびデータセンター アプリケーションでのアクセラレータを使用した計算効率など、AI アクセラレータの包括的なリストを収集することを目的としています。同時に、この記事では主に政府および産業用のセンサーおよびデータ処理アプリケーション向けのニューラル ネットワーク アクセラレータを比較しています。前年の論文に含まれている一部のアクセラレータとプロセッサは、同じ会社の新しいアクセラレータに置き換えられたか、保守されなくなったか、またはトピックに関連しなくなった可能性があるため、今年の調査から除外されました。

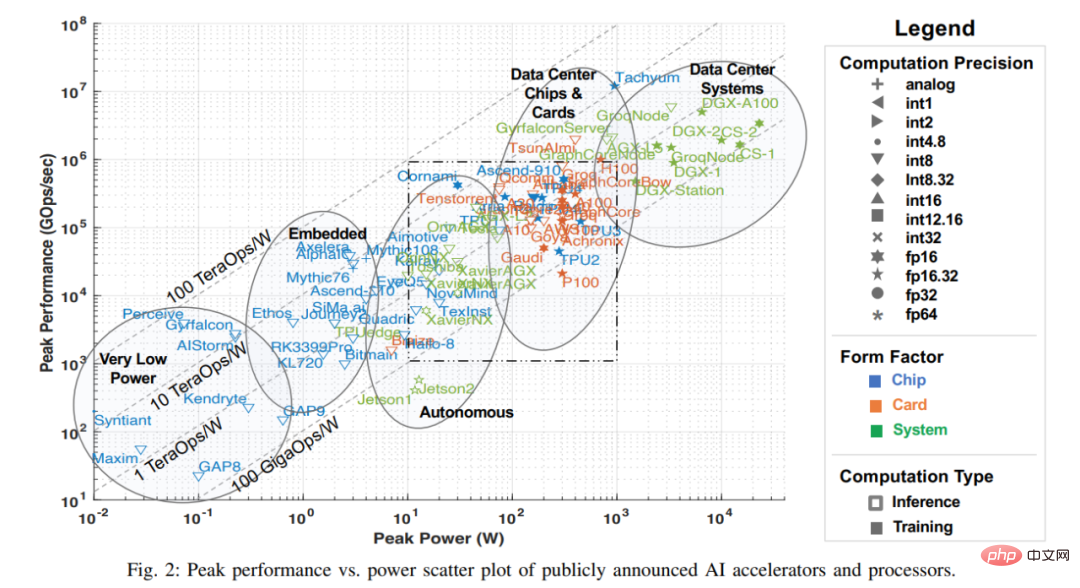

プロセッサ調査

人工知能における最近の進歩の多くは、部分的にはハードウェア パフォーマンスの向上によるもので、これにより、膨大な計算能力、特に DNN などのネットワークを必要とする機械学習アルゴリズムが可能になります。この記事の調査では、さまざまな研究論文、技術雑誌、企業発行のベンチマークなど、公開されている資料からさまざまな情報を収集しました。企業やスタートアップに関する情報(サイレント期間含む)を入手する方法は他にもありますが、本調査時点では本記事では省略しており、データは公表され次第調査対象とさせていただきます。この公開データの主要な指標を以下のグラフに示します。これは、最新のプロセッサーのピークパフォーマンスと消費電力能力を反映しています (2022 年 7 月時点)。

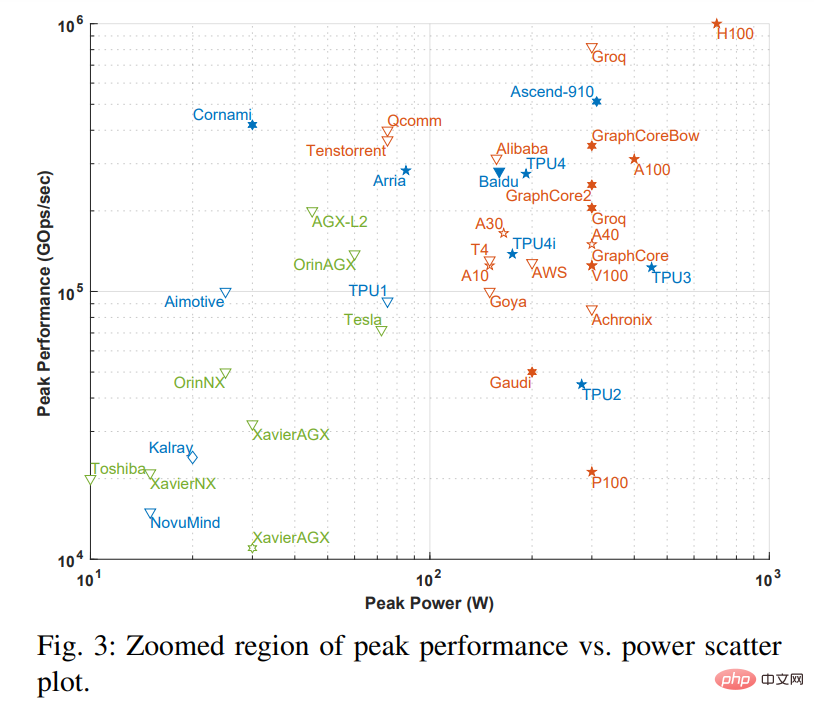

注: 図 2 の点線のボックスは、以下の図 3 に対応します。図 3 は、点線のボックスの拡大版です。

図の X 軸はピーク電力を表し、Y 軸は 1 秒あたりのピーク ギガビット操作 (GOps/s) を表します。どちらも対数スケールです。処理能力の計算精度は、int1 から int32、および fp16 から fp64 の範囲のさまざまなジオメトリで表されます。表示される精度は 2 種類あり、左側は乗算演算の精度、右側は累積加算演算の精度を表します (fp16.32 は fp16 の乗算、fp32 の累積加算を表します)。色と形状を使用して、さまざまなタイプのシステムとピーク電力を区別します。青は単一のチップを表し、オレンジはカードを表し、緑はシステム全体 (単一ノードのデスクトップおよびサーバー システム) を表します。この調査は、単一のマザーボード、単一のメモリ システムに限定されています。図のオープン ジオメトリは推論のみを実行するアクセラレータの最高のパフォーマンスを表し、ソリッド ジオメトリはトレーニングと推論の両方を実行するアクセラレータのパフォーマンスを表します。

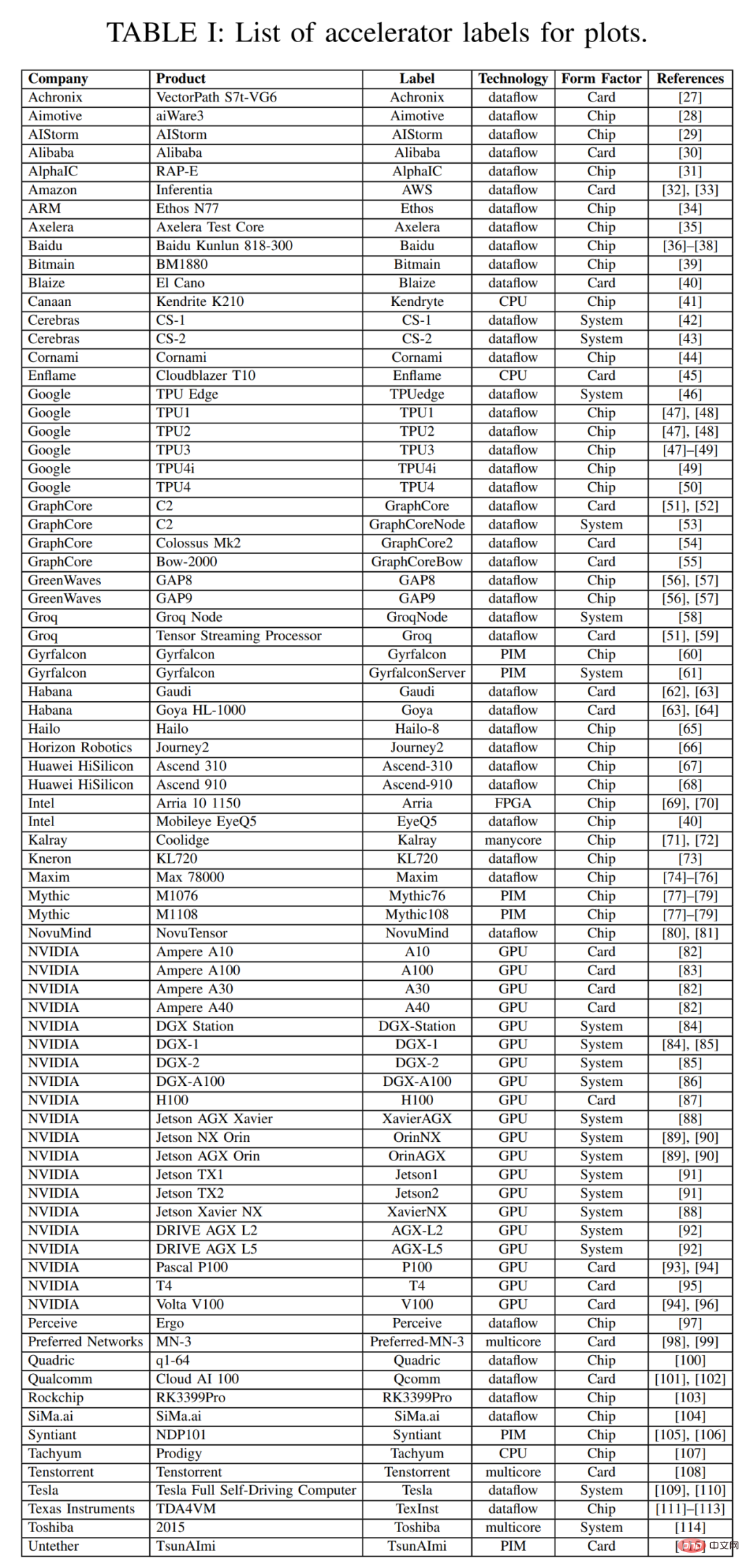

この調査では、この記事は過去 3 年間の調査データの散布図から始まります。この記事では、アクセラレータ、カード、およびシステム全体に関するいくつかの重要なメタデータを以下の表 1 にまとめています。これには、図 2 の各ポイントのラベルも含まれており、昨年の調査から得られた多くのポイントが含まれています。表 1 のほとんどの列とエントリは正確かつ明確です。しかし、Dataflow と PIM という 2 つのテクノロジー項目はおそらくそうではありません。データフロー タイプのプロセッサは、ニューラル ネットワークの推論とトレーニング用にカスタマイズされたプロセッサです。ニューラル ネットワークのトレーニングと推論計算は完全に決定論的に構築されるため、計算、メモリ アクセス、ALU 間通信が明示的/静的にプログラムされるか、計算ハードウェアに配置およびルーティングされるデータフロー処理に適しています。 Processor in Memory (PIM) アクセラレータは、処理要素とメモリ テクノロジを統合します。これらの PIM アクセラレータの中には、インプレース アナログ乗加算機能でフラッシュ メモリ回路を強化するアナログ コンピューティング テクノロジに基づいたアクセラレータもあります。この革新的なテクノロジーの詳細については、Mythic および Gyrfalcon アクセラレータ マテリアルを参照してください。

この記事では、予想されるアプリケーションに応じてアクセラレータを合理的に分類しています。図 1 では、パフォーマンスと消費電力に応じて 5 種類のアクセラレータを識別しています。超低消費電力、超小型センサー、音声処理。 、小型ドローンおよびロボット、データセンターシステム用の自動運転および自律ロボット。

ほとんどのアクセラレータの性能、機能、その他の指標は変わっていません。関連情報については、過去 2 年間の論文を参照してください。以下は過去記事に載っていないアクセラレータです。

オランダの組込みシステムスタートアップAceleraは、自社が製造する組込みテストチップにはデジタル設計機能とアナログ設計機能があり、このテストチップはデジタル設計機能の範囲をテストするためのものであると主張しています。彼らは、将来の作業でアナログ (おそらくフラッシュ) デザイン要素を追加したいと考えています。

Maxim Integrated は、超低電力アプリケーション向けの MAX78000 と呼ばれるシステムオンチップ (SoC) をリリースしました。これには、ARM CPU コア、RISC-V CPU コア、AI アクセラレータが含まれます。 ARM コアはラピッド プロトタイピングとコードの再利用に使用され、RISC-V コアは消費電力を最小限に抑えるために最適化されています。 AI アクセラレータには、1 ビット、2 ビット、4 ビット、8 ビットの整数演算をサポートする 64 個の並列プロセッサがあります。この SoC は最大電力 30mW で動作するため、低遅延のバッテリー駆動アプリケーションに適しています。

Tachyum は最近、Prodigy と呼ばれるオールインワン プロセッサをリリースしました。Prodigy の各コアは、HPC および機械学習アプリケーション向けに設計されており、128 個の高性能統合コアを備えています。周波数は5.7GHz。

NVIDIA は、Hopper (H100) と呼ばれる次世代 GPU を 2022 年 3 月にリリースしました。 Hopper には、より多くの対称マルチプロセッサ (SIMD および Tensor コア)、50% 増加したメモリ帯域幅、および 700 W の電力を備えた SXM メザニン カード インスタンスが統合されています。 (PCIe カードの電力は 450W)

過去数年にわたり、NVIDIA は自動車、ロボット工学、その他の組み込みアプリケーションに導入される Ampere アーキテクチャ GPU 用の一連のシステム プラットフォームをリリースしてきました。車載アプリケーション向けに、DRIVE AGX プラットフォームには 2 つの新しいシステムが追加されています。DRIVE AGX L2 は 45W の電力範囲でレベル 2 の自動運転を可能にし、DRIVE AGX L5 は 800W の電力範囲でレベル 5 の自動運転を可能にします。 Jetson AGX Orin と Jetson NX Orin も、ロボット工学や工場オートメーションなどに Ampere アーキテクチャ GPU を使用しており、最大ピーク電力は 60 W と 25 W です。

Graphcore は、PCIe カードに実装され、ピーク電力が約 300 W である第 2 世代アクセラレータ チップ CG200 をリリースします。昨年、Graphcore は、TSMC と提携して設計された初のウエハツーウエハ プロセッサである Bow アクセラレータも発売しました。アクセラレータ自体は前述の CG200 と同じですが、CG200 チップ全体にわたる電力とクロックの分配を大幅に改善する 2 番目のダイと組み合わせられています。これは、パフォーマンスが 40% 向上し、ワット当たりのパフォーマンスが 16% 向上したことを意味します。

2021 年 6 月、Google は第 4 世代の純粋推論 TPU4i アクセラレータの詳細を発表しました。それからほぼ 1 年後、Google は第 4 世代トレーニング アクセラレータである TPUv4 の詳細を公開しました。公式発表には詳細はほとんどありませんが、ピーク電力と関連するパフォーマンス数値は共有されています。以前の TPU バージョンと同様、TPU4 は Google Compute Cloud を通じて利用でき、内部操作に使用されます。

以下は、図 2 に示されていないアクセラレータの紹介です。各バージョンはいくつかのベンチマーク結果を公開していますが、次のように、ピーク パフォーマンスが不足しているものや、ピーク電力を公開していないものもあります。

SambaNova は昨年、再構成可能な AI アクセラレーター技術のベンチマーク結果をいくつか発表し、アルゴンヌ国立研究所と協力して応用論文も発表しましたが、詳細は明らかにしていません。公開されているソースからソリューションのパフォーマンスや電力消費量を取得します。

今年 5 月、Intel Habana Labs は、それぞれ Greco と Gaudi2 という名前の第 2 世代 Goya 推論アクセラレータと Gaudi トレーニング アクセラレータの発売を発表しました。どちらも以前のバージョンよりも数倍優れたパフォーマンスを発揮します。 Greco は 75 ワットのシングル ワイド PCIe カードですが、Gaudi2 も 650 ワットのダブル ワイド PCIe カードです (おそらく PCIe 5.0 スロットに搭載されています)。 Habana は、Gaudi2 と Nvidia A100 GPU のベンチマーク比較をいくつか公開しましたが、どちらのアクセラレータのピーク パフォーマンス数値も明らかにしていませんでした。

Esperanto は、Samsung やその他のパートナーが評価できるようにいくつかのデモ チップを作成しました。このチップは、コアごとに AI テンソル アクセラレータを備えた 1000 コア RISC-V プロセッサです。 Esperanto はいくつかのパフォーマンス数値を公開していますが、ピーク電力やピークパフォーマンスは開示していません。

Tesla AI Day で、Tesla はカスタム Dojo アクセラレータとシステムの詳細を紹介しました。同社のチップはピーク 22.6 TF FP32 パフォーマンスを備えていますが、各チップのピーク消費電力は発表されておらず、おそらくそれらの詳細は後日明らかにされるでしょう。

昨年、Centaur Technology は、AI アクセラレーターを統合した x86 CPU を発売しました。これは、4096 バイト幅の SIMD ユニットを備え、非常に競争力のあるパフォーマンスを備えています。しかし、Centaurの親会社であるVIA Technologiesは、米国に拠点を置くプロセッサエンジニアリングチームをIntelに売却した後、CNSプロセッサの開発を終了したようだ。

いくつかの観察結果と傾向図 2 には、言及する価値のある観察結果がいくつかあります。詳細は次のとおりです。

Int8 は、組み込み、自律型、およびデータセンター推論アプリケーションのデフォルトの数値精度のままです。この精度は、有理数を使用するほとんどの AI/ML アプリケーションにとって十分です。また、一部のアクセラレータは fp16 または bf16 を使用します。モデルのトレーニングでは整数表現が使用されます。

この超低電力チップには、機械学習用のアクセラレータ以外の追加機能は見つかっていません。超低電力チップおよび組み込みカテゴリでは、低電力 CPU コア、オーディオおよびビデオのアナログ デジタル コンバータ (ADC)、暗号エンジンを含むシステム オン チップ (SoC) ソリューションをリリースするのが一般的です。 、ネットワークインターフェースなど。 SoC のこれらの追加機能はピーク パフォーマンスの指標を変更しませんが、チップによって報告されるピーク電力に直接影響するため、比較する際にはこれが重要です。

組み込み部分はあまり変わっていません。これは、コンピューティング性能とピーク電力がこの分野のアプリケーションのニーズを満たすのに十分であることを意味します。

Texas Instruments を含むいくつかの企業が、過去数年間にわたって AI アクセラレータをリリースしてきました。また、NVIDIA は、前述したように、自動車およびロボット アプリケーション向けに、よりパフォーマンスの高いシステムをいくつかリリースしました。データセンターでは、PCIe v4 の 300W の電力制限を突破するために、PCIe v5 仕様が大いに期待されています。

最後に、ハイエンドのトレーニング システムが目覚ましいパフォーマンス数値を発表しているだけでなく、これらの企業は数千枚のカードを接続するための拡張性の高い相互接続テクノロジーもリリースしています。これは、Cerebras、GraphCore、Groq、Tesla Dojo、SambaNova などのデータフロー アクセラレータにとって特に重要です。これらのアクセラレータは、明示的/静的プログラミングまたはコンピューティング ハードウェアへの配置配線によってプログラムされます。このようにして、これらのアクセラレータは変圧器のような非常に大きなモデルに適合できるようになります。

詳しくは元記事をご覧ください。

以上が過去 3 年間を総括して、MIT が AI アクセラレータに関するレビュー論文を発表の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7486

7486

15

15

1377

1377

52

52

77

77

11

11

19

19

38

38

Bytedance Cutting が SVIP スーパー メンバーシップを開始: 継続的な年間サブスクリプションは 499 元で、さまざまな AI 機能を提供

Jun 28, 2024 am 03:51 AM

Bytedance Cutting が SVIP スーパー メンバーシップを開始: 継続的な年間サブスクリプションは 499 元で、さまざまな AI 機能を提供

Jun 28, 2024 am 03:51 AM

このサイトは6月27日、JianyingはByteDanceの子会社であるFaceMeng Technologyによって開発されたビデオ編集ソフトウェアであり、Douyinプラットフォームに依存しており、基本的にプラットフォームのユーザー向けに短いビデオコンテンツを作成すると報告しました。 Windows、MacOS、その他のオペレーティング システム。 Jianyingは会員システムのアップグレードを正式に発表し、インテリジェント翻訳、インテリジェントハイライト、インテリジェントパッケージング、デジタルヒューマン合成などのさまざまなAIブラックテクノロジーを含む新しいSVIPを開始しました。価格的には、クリッピングSVIPの月額料金は79元、年会費は599元(当サイト注:月額49.9元に相当)、継続月額サブスクリプションは月額59元、継続年間サブスクリプションは、年間499元(月額41.6元に相当)です。さらに、カット担当者は、ユーザーエクスペリエンスを向上させるために、オリジナルのVIPに登録している人は、

Rag と Sem-Rag を使用したコンテキスト拡張 AI コーディング アシスタント

Jun 10, 2024 am 11:08 AM

Rag と Sem-Rag を使用したコンテキスト拡張 AI コーディング アシスタント

Jun 10, 2024 am 11:08 AM

検索強化生成およびセマンティック メモリを AI コーディング アシスタントに組み込むことで、開発者の生産性、効率、精度を向上させます。 JanakiramMSV 著者の EnhancingAICodingAssistantswithContextUsingRAGandSEM-RAG から翻訳。基本的な AI プログラミング アシスタントは当然役に立ちますが、ソフトウェア言語とソフトウェア作成の最も一般的なパターンに関する一般的な理解に依存しているため、最も適切で正しいコードの提案を提供できないことがよくあります。これらのコーディング アシスタントによって生成されたコードは、彼らが解決する責任を負っている問題の解決には適していますが、多くの場合、個々のチームのコーディング標準、規約、スタイルには準拠していません。これにより、コードがアプリケーションに受け入れられるように修正または調整する必要がある提案が得られることがよくあります。

微調整によって本当に LLM が新しいことを学習できるようになるのでしょうか: 新しい知識を導入すると、モデルがより多くの幻覚を生成する可能性があります

Jun 11, 2024 pm 03:57 PM

微調整によって本当に LLM が新しいことを学習できるようになるのでしょうか: 新しい知識を導入すると、モデルがより多くの幻覚を生成する可能性があります

Jun 11, 2024 pm 03:57 PM

大規模言語モデル (LLM) は巨大なテキスト データベースでトレーニングされ、そこで大量の現実世界の知識を取得します。この知識はパラメータに組み込まれており、必要なときに使用できます。これらのモデルの知識は、トレーニングの終了時に「具体化」されます。事前トレーニングの終了時に、モデルは実際に学習を停止します。モデルを調整または微調整して、この知識を活用し、ユーザーの質問により自然に応答する方法を学びます。ただし、モデルの知識だけでは不十分な場合があり、モデルは RAG を通じて外部コンテンツにアクセスできますが、微調整を通じてモデルを新しいドメインに適応させることが有益であると考えられます。この微調整は、ヒューマン アノテーターまたは他の LLM 作成物からの入力を使用して実行され、モデルは追加の実世界の知識に遭遇し、それを統合します。

GenAI および LLM の技術面接に関する 7 つのクールな質問

Jun 07, 2024 am 10:06 AM

GenAI および LLM の技術面接に関する 7 つのクールな質問

Jun 07, 2024 am 10:06 AM

AIGC について詳しくは、51CTOAI.x コミュニティ https://www.51cto.com/aigc/Translator|Jingyan Reviewer|Chonglou を参照してください。これらの質問は、インターネット上のどこでも見られる従来の質問バンクとは異なります。既成概念にとらわれずに考える必要があります。大規模言語モデル (LLM) は、データ サイエンス、生成人工知能 (GenAI)、および人工知能の分野でますます重要になっています。これらの複雑なアルゴリズムは人間のスキルを向上させ、多くの業界で効率とイノベーションを推進し、企業が競争力を維持するための鍵となります。 LLM は、自然言語処理、テキスト生成、音声認識、推奨システムなどの分野で幅広い用途に使用できます。 LLM は大量のデータから学習することでテキストを生成できます。

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

編集者 |ScienceAI 質問応答 (QA) データセットは、自然言語処理 (NLP) 研究を促進する上で重要な役割を果たします。高品質の QA データ セットは、モデルの微調整に使用できるだけでなく、大規模言語モデル (LLM) の機能、特に科学的知識を理解し推論する能力を効果的に評価することもできます。現在、医学、化学、生物学、その他の分野をカバーする多くの科学 QA データ セットがありますが、これらのデータ セットにはまだいくつかの欠点があります。まず、データ形式は比較的単純で、そのほとんどが多肢選択式の質問であり、評価は簡単ですが、モデルの回答選択範囲が制限され、科学的な質問に回答するモデルの能力を完全にテストすることはできません。対照的に、自由回答型の Q&A

あなたが知らない機械学習の 5 つの流派

Jun 05, 2024 pm 08:51 PM

あなたが知らない機械学習の 5 つの流派

Jun 05, 2024 pm 08:51 PM

機械学習は人工知能の重要な分野であり、明示的にプログラムしなくてもコンピューターにデータから学習して能力を向上させる機能を提供します。機械学習は、画像認識や自然言語処理から、レコメンデーションシステムや不正行為検出に至るまで、さまざまな分野で幅広く応用されており、私たちの生活様式を変えつつあります。機械学習の分野にはさまざまな手法や理論があり、その中で最も影響力のある 5 つの手法は「機械学習の 5 つの流派」と呼ばれています。 5 つの主要な学派は、象徴学派、コネクショニスト学派、進化学派、ベイジアン学派、およびアナロジー学派です。 1. 象徴主義は、象徴主義とも呼ばれ、論理的推論と知識の表現のためのシンボルの使用を強調します。この学派は、学習は既存の既存の要素を介した逆演繹のプロセスであると信じています。

SOTA パフォーマンス、厦門マルチモーダルタンパク質-リガンド親和性予測 AI 手法、初めて分子表面情報を結合

Jul 17, 2024 pm 06:37 PM

SOTA パフォーマンス、厦門マルチモーダルタンパク質-リガンド親和性予測 AI 手法、初めて分子表面情報を結合

Jul 17, 2024 pm 06:37 PM

編集者 | KX 医薬品の研究開発の分野では、タンパク質とリガンドの結合親和性を正確かつ効果的に予測することが、医薬品のスクリーニングと最適化にとって重要です。しかし、現在の研究では、タンパク質とリガンドの相互作用における分子表面情報の重要な役割が考慮されていません。これに基づいて、アモイ大学の研究者らは、初めてタンパク質の表面、3D 構造、配列に関する情報を組み合わせ、クロスアテンション メカニズムを使用して異なるモダリティの特徴を比較する、新しいマルチモーダル特徴抽出 (MFE) フレームワークを提案しました。アライメント。実験結果は、この方法がタンパク質-リガンド結合親和性の予測において最先端の性能を達成することを実証しています。さらに、アブレーション研究は、この枠組み内でのタンパク質表面情報と多峰性特徴の位置合わせの有効性と必要性を実証しています。 「S」で始まる関連研究

AIなどの市場を開拓するグローバルファウンドリーズがタゴール・テクノロジーの窒化ガリウム技術と関連チームを買収

Jul 15, 2024 pm 12:21 PM

AIなどの市場を開拓するグローバルファウンドリーズがタゴール・テクノロジーの窒化ガリウム技術と関連チームを買収

Jul 15, 2024 pm 12:21 PM

7月5日のこのウェブサイトのニュースによると、グローバルファウンドリーズは今年7月1日にプレスリリースを発行し、自動車とインターネットでの市場シェア拡大を目指してタゴール・テクノロジーのパワー窒化ガリウム(GaN)技術と知的財産ポートフォリオを買収したことを発表した。モノと人工知能データセンターのアプリケーション分野で、より高い効率とより優れたパフォーマンスを探求します。生成 AI などのテクノロジーがデジタル世界で発展を続ける中、窒化ガリウム (GaN) は、特にデータセンターにおいて、持続可能で効率的な電力管理のための重要なソリューションとなっています。このウェブサイトは、この買収中にタゴール・テクノロジーのエンジニアリングチームがGLOBALFOUNDRIESに加わり、窒化ガリウム技術をさらに開発するという公式発表を引用した。 G