統合 AI 開発: Google OpenXLA はオープンソースであり、すべてのフレームワークと AI チップを統合します。

昨年 10 月の Google Cloud Next 2022 イベントで、Google は、Alibaba、AMD、Arm、Amazon、Intel、Nvidia などのテクノロジー企業が推進するオープンソース AI フレームワークに正式に協力しました。は、さまざまな機械学習フレームワークを統合することに取り組んでおり、機械学習開発者はフレームワークとハードウェアを積極的に選択できます。

水曜日、Google は OpenXLA プロジェクトが正式にオープンソースであると発表しました。

プロジェクトリンク: https://github.com/openxla/xla

複数の異なる機械学習フレームワークおよびハードウェアプラットフォームで動作する統合機械学習コンパイラーを作成することにより、OpenXLA は高速化されます。機械学習アプリケーションの配信と、コードの移植性の向上を実現します。これはAIの研究と応用にとって重要なプロジェクトであり、ジェフ・ディーンもソーシャルネットワーク上でこのプロジェクトを宣伝しました。

現在、機械学習の開発と展開は、フレームワーク、ハードウェア、ユースケースによって異なる可能性がある断片化されたインフラストラクチャの影響を受けています。この分離により、開発者の作業速度が制限され、モデルの移植性、効率性、生産性に対する障壁が生じます。

3 月 8 日、Google などは、XLA、StableHLO、IREE リポジトリを含む OpenXLA プロジェクトを開始し、これらの障壁を取り除くための大きな一歩を踏み出しました。

OpenXLA は、Alibaba、AWS、AMD、Apple、Arm、Cerebras、Google、Graphcore、Hugging Face、Intel、Meta、NVIDIA などの AI/機械学習業界のリーダーによって共同開発されたオープンソースの ML コンパイラー エコシステムです。これにより、開発者は、あらゆる主要な機械学習フレームワークからモデルをコンパイルして最適化し、効率的なトレーニングとさまざまなハードウェアでのサービスを提供できるようになります。 OpenXLA を使用する開発者は、トレーニング時間、スループット、サービス遅延、そして最終的にはリリースとコンピューティングのコストが大幅に改善されることを確認できます。

機械学習テクノロジー施設が直面する課題

AI テクノロジーが実用段階に入ると、多くの業界の開発チームが機械学習を使用して、病気の予測と予防、パーソナライズされた学習体験と調査などの現実世界の課題に取り組んでいます。ブラックホール物理学。

モデルパラメータの数が急激に増加し、ディープラーニングモデルに必要な計算量が半年ごとに倍増する中、開発者はインフラストラクチャの最大のパフォーマンスと利用率を追求しています。多くのチームが、データセンター内のエネルギー効率の高い機械学習専用の ASIC から、より高速な応答時間を提供する AI エッジ プロセッサに至るまで、さまざまなハードウェア モデルを活用しています。したがって、効率を向上させるために、これらのハードウェア デバイスはカスタマイズされた独自のアルゴリズムとソフトウェア ライブラリを使用します。

その一方で、現在使用されている複数のフレームワーク (TensorFlow、PyTorch など) にさまざまなハードウェア デバイスをブリッジするための共通のコンパイラーがなければ、機械学習を効率的に実行するために多大な労力を費やす必要があります。実際には、開発者は各ハードウェア ターゲットのモデル操作を手動で最適化する必要があります。つまり、カスタム ソフトウェア ライブラリを使用したり、デバイス固有のコードを作成したりするには、その分野の専門知識が必要になります。

これは矛盾であり、特殊なテクノロジーを使用して効率を高めると、フレームワークやハードウェア間でサイロ化された一般化できないパスが発生し、メンテナンスコストが高くなり、ひいてはベンダーロックインにつながり、マシンの進歩が遅くなります。学習の発展。

ソリューションと目標

OpenXLA プロジェクトは、ML インフラストラクチャの複雑さ全体に対応する最先端の ML コンパイラーを提供します。その中核となるのは、パフォーマンス、拡張性、移植性、柔軟性、使いやすさです。 OpenXLA により、AI の開発と提供を加速することで、現実世界における AI のより大きな可能性を実現したいと考えています。

OpenXLA の目的:

- 開発者が、専用のデバイス バックエンドと最適化にアクセスし、あらゆるフレームワークで動作する統合コンパイラー API を使用して、さまざまなハードウェア向けに好みのフレームワークでモデルを簡単にコンパイルおよび最適化できるようにします。

- 現在および新興のモデルに対して業界をリードするパフォーマンスを提供し、エッジ展開の制約を満たすために複数のホストやアクセラレータに拡張することもでき、将来的には新しいモデル アーキテクチャに昇格することもできます。

- ハードウェアでカスタマイズされたコンパイル フローの独自のユースケースに合わせて再構成できる MLIR ベースのコンポーネントを開発者に提供する、階層化されたスケーラブルな機械学習コンパイラ プラットフォームを構築します。

AI/ML リーダーのコミュニティ

機械学習インフラストラクチャにおいて私たちが今日直面している課題は膨大であり、どの組織も単独で効果的に解決することはできません。 OpenXLA コミュニティには、フレームワークからコンパイラ、ランタイム、チップに至るまで、AI スタックのさまざまなレベルで活動する開発者と業界リーダーが集まり、ML 空間で見られる断片化に対処するのに理想的です。

オープンソース プロジェクトとして、OpenXLA は次の原則を遵守します:

- 平等な地位: 個人は所属に関係なく平等に貢献します。技術的なリーダーは、最も多くの時間とエネルギーを貢献する人たちです。

- 尊重の文化: すべてのメンバーは、コミュニティ内での立場に関係なく、プロジェクトの価値観と行動規範を守ることが期待されます。

- スケーラブルで効率的なガバナンス: 小規模なチームが合意に基づいて意思決定を行い、明確だがめったに使用されないアップグレード パスを使用します。

- 透明性: すべての決定と根拠は公衆に明確に見える必要があります。

OpenXLA エコシステム: パフォーマンス、スケール、移植性

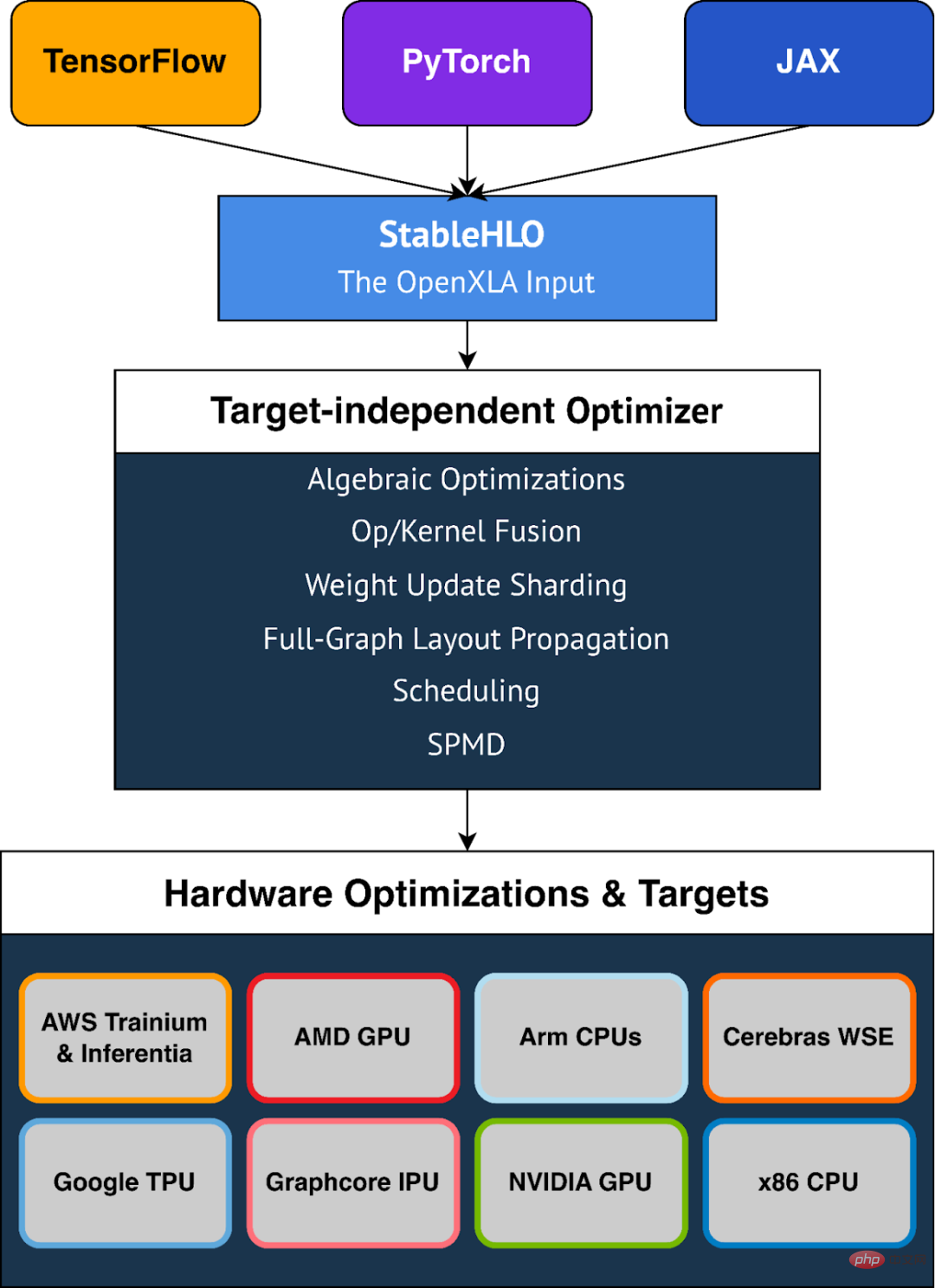

OpenXLA は、移植性を活用し、共通のコンパイラー インターフェイスを通じてすべての主要なフレームワークでサポートされるモジュラー ツールチェーンにより、機械学習開発者の障壁を取り除きます モデル表現を標準化し、ドメイン固有のコンパイラーを提供しますターゲット固有およびハードウェア固有の強力な最適化を備えています。ツールチェーンには XLA、StableHLO、IREE が含まれており、これらはすべて MLIR (機械学習モデルをハードウェア上で一貫して表現、最適化、実行できるようにするコンパイラー インフラストラクチャ) を活用しています。

OpenXLAの主なハイライト

機械学習のユースケースの範囲

OpenXLAの現在の使用法は、DeepMindのAlphaFold、GPT2、A上のSwin Transformerを含むMLユースケースの範囲をカバーしていますリババクラウド待機モデルを完全にトレーニングし、Amazon.com でマルチモーダル LLM トレーニングを実行します。 Waymo などの顧客は、車載リアルタイム推論に OpenXLA を活用しています。さらに、OpenXLA は、AMD RDNA™ 3 を搭載したローカル マシン上の Stable Diffusion サービスを最適化するために使用されます。

すぐに使える最高のパフォーマンス

OpenXLA を使用すると、開発者はデバイス固有のコードを記述することなく、モデルのパフォーマンスを簡単に高速化できます。代数式の簡素化、メモリ内データ レイアウトの最適化、ピーク メモリ使用量と通信オーバーヘッドを削減するためのスケジューリングの改善など、モデル全体の最適化機能を備えています。高度なオペレータ フュージョンとカーネル生成により、デバイスの使用率が向上し、メモリ帯域幅の要件が軽減されます。

ワークロードを簡単にスケール

効率的な並列化アルゴリズムの開発には時間がかかり、専門知識が必要です。 GSPMD のような機能を使用すると、開発者はキー テンソルのサブセットに注釈を付けるだけで済み、コンパイラはそれを使用して並列計算を自動的に生成できます。これにより、複数のハードウェア ホストおよびアクセラレータ間でモデルを分割し、効率的に並列化するために必要な多大な労力が不要になります。

移植性とオプション性

OpenXLA は、AMD および NVIDIA GPU、x86 CPU および Arm アーキテクチャ、Google TPU などの ML アクセラレータを含む、さまざまなハードウェア デバイスをすぐに使用できるサポートを提供します。 AWS Trainium と Inferentia、Graphcore IPU、Cerebras Wafer-Scale Engine など。 OpenXLA は、OpenXLA の入力形式として使用されるポータブル レイヤーである StableHLO を通じて、TensorFlow、PyTorch、および JAX もサポートしています。

柔軟性

OpenXLA は、ユーザーにモデルのホットスポットを手動で調整する柔軟性を提供します。カスタム呼び出しなどの拡張メカニズムにより、ユーザーは CUDA、HIP、SYCL、Triton、およびその他のカーネル言語でディープ ラーニング プリミティブを記述して、ハードウェア機能を最大限に活用できます。

StableHLO

StableHLO は、ML フレームワークと ML コンパイラーの間の移植性レイヤーであり、動的、量子化、スパース性の高レベル操作 (HLO) をサポートする一連の操作です。さらに、互換性を保証するために、MLIR バイトコードにシリアル化することもできます。すべての主要な ML フレームワーク (JAX、PyTorch、TensorFlow) は StableHLO を生成できます。 2023 年に、Google は PyTorch チームと緊密に連携して、PyTorch バージョン 2.0 との統合を実現する予定です。

以上が統合 AI 開発: Google OpenXLA はオープンソースであり、すべてのフレームワークと AI チップを統合します。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7694

7694

15

15

1640

1640

14

14

1393

1393

52

52

1287

1287

25

25

1229

1229

29

29

WorldCoin(WLD)価格予測2025-2031:WLDは2031年までに4ドルに達しますか?

Apr 21, 2025 pm 02:42 PM

WorldCoin(WLD)価格予測2025-2031:WLDは2031年までに4ドルに達しますか?

Apr 21, 2025 pm 02:42 PM

WorldCoin(WLD)は、独自の生体認証とプライバシー保護メカニズムを備えた暗号通貨市場で際立っており、多くの投資家の注目を集めています。 WLDは、特にOpenai人工知能技術と組み合わせて、革新的なテクノロジーを備えたAltcoinsの間で驚くほど演奏しています。しかし、デジタル資産は今後数年間でどのように振る舞いますか? WLDの将来の価格を一緒に予測しましょう。 2025年のWLD価格予測は、2025年にWLDで大幅に増加すると予想されています。市場分析は、平均WLD価格が1.31ドルに達する可能性があり、最大1.36ドルであることを示しています。ただし、クマ市場では、価格は約0.55ドルに低下する可能性があります。この成長の期待は、主にWorldCoin2によるものです。

通貨サークルでのレバレッジされた交換のランキングは

Apr 21, 2025 pm 11:24 PM

通貨サークルでのレバレッジされた交換のランキングは

Apr 21, 2025 pm 11:24 PM

2025年のレバレッジド取引、セキュリティ、ユーザーエクスペリエンスで優れたパフォーマンスを持つプラットフォームは次のとおりです。1。OKX、高周波トレーダーに適しており、最大100倍のレバレッジを提供します。 2。世界中の多通貨トレーダーに適したバイナンス、125倍の高いレバレッジを提供します。 3。Gate.io、プロのデリバティブプレーヤーに適し、100倍のレバレッジを提供します。 4。ビットゲットは、初心者やソーシャルトレーダーに適しており、最大100倍のレバレッジを提供します。 5。Kraken、安定した投資家に適しており、5倍のレバレッジを提供します。 6。Altcoinエクスプローラーに適したBybit。20倍のレバレッジを提供します。 7。低コストのトレーダーに適したKucoinは、10倍のレバレッジを提供します。 8。ビットフィネックス、シニアプレイに適しています

クロスチェーントランザクションとはどういう意味ですか?クロスチェーントランザクションとは何ですか?

Apr 21, 2025 pm 11:39 PM

クロスチェーントランザクションとはどういう意味ですか?クロスチェーントランザクションとは何ですか?

Apr 21, 2025 pm 11:39 PM

クロスチェーントランザクションをサポートする交換:1。Binance、2。Uniswap、3。Sushiswap、4。CurveFinance、5。Thorchain、6。1inchExchange、7。DLNTrade、これらのプラットフォームはさまざまな技術を通じてマルチチェーン資産トランザクションをサポートします。

Web3トレーディングプラットフォームranking_web3グローバル交換トップ10の概要

Apr 21, 2025 am 10:45 AM

Web3トレーディングプラットフォームranking_web3グローバル交換トップ10の概要

Apr 21, 2025 am 10:45 AM

Binanceは、グローバルデジタルアセット取引エコシステムの大君主であり、その特性には次のものが含まれます。1。1日の平均取引量は1,500億ドルを超え、500の取引ペアをサポートし、主流の通貨の98%をカバーしています。 2。イノベーションマトリックスは、デリバティブ市場、Web3レイアウト、教育システムをカバーしています。 3.技術的な利点は、1秒あたり140万のトランザクションのピーク処理量を伴うミリ秒のマッチングエンジンです。 4.コンプライアンスの進捗状況は、15か国のライセンスを保持し、ヨーロッパと米国で準拠した事業体を確立します。

カーネルエアドロップ報酬を獲得する方法バイナンスフルプロセス戦略

Apr 21, 2025 pm 01:03 PM

カーネルエアドロップ報酬を獲得する方法バイナンスフルプロセス戦略

Apr 21, 2025 pm 01:03 PM

暗号通貨の賑やかな世界では、新しい機会が常に現れます。現在、Kerneldao(Kernel)Airdropアクティビティは多くの注目を集め、多くの投資家の注目を集めています。それで、このプロジェクトの起源は何ですか? BNBホルダーはそれからどのような利点を得ることができますか?心配しないでください、以下はあなたのためにそれを一つ一つ明らかにします。

「ブラックマンデーセル」は、暗号通貨業界にとって厳しい日です

Apr 21, 2025 pm 02:48 PM

「ブラックマンデーセル」は、暗号通貨業界にとって厳しい日です

Apr 21, 2025 pm 02:48 PM

暗号通貨市場での突入は投資家の間でパニックを引き起こし、Dogecoin(Doge)は最も困難なヒット分野の1つになりました。その価格は急激に下落し、分散財務財務(DEFI)(TVL)の総価値が激しく減少しました。 「ブラックマンデー」の販売波が暗号通貨市場を席巻し、ドゲコインが最初にヒットしました。そのdefitVLは2023レベルに低下し、通貨価格は過去1か月で23.78%下落しました。 DogecoinのDefitVLは、主にSOSO値指数が26.37%減少したため、272万ドルの安値に低下しました。退屈なDAOやThorchainなどの他の主要なDefiプラットフォームも、それぞれ24.04%と20減少しました。

なぜ仮想通貨価格の上昇または下落があるのですか?なぜ仮想通貨価格の上昇または下落があるのですか?

Apr 21, 2025 am 08:57 AM

なぜ仮想通貨価格の上昇または下落があるのですか?なぜ仮想通貨価格の上昇または下落があるのですか?

Apr 21, 2025 am 08:57 AM

仮想通貨価格の上昇の要因には、次のものが含まれます。1。市場需要の増加、2。供給の減少、3。刺激された肯定的なニュース、4。楽観的な市場感情、5。マクロ経済環境。衰退要因は次のとおりです。1。市場需要の減少、2。供給の増加、3。ネガティブニュースのストライキ、4。悲観的市場感情、5。マクロ経済環境。

Aavenomicsは、Aaveプロトコルトークンを変更し、Tokenの買戻しを導入するための推奨事項です。

Apr 21, 2025 pm 06:24 PM

Aavenomicsは、Aaveプロトコルトークンを変更し、Tokenの買戻しを導入するための推奨事項です。

Apr 21, 2025 pm 06:24 PM

Aavenomicsは、Aaveプロトコルトークンを変更し、Aavedaoの定足数を実装したToken Reposを導入する提案です。 Aave Project Chain(ACI)の創設者であるMarc Zellerは、これをXで発表し、契約の新しい時代をマークしていることに注目しました。 Aave Chain Initiative(ACI)の創設者であるMarc Zellerは、Aavenomicsの提案にAave Protocolトークンの変更とトークンリポジトリの導入が含まれていると発表しました。 Zellerによると、これは契約の新しい時代を告げています。 Aavedaoのメンバーは、水曜日の週に100でした。