プライバシー コンピューティングにおけるフェデレーション ラーニング

データ資産は製品やサービスの設計における重要なツールとなっていますが、ユーザーデータの一元的な収集により個人のプライバシーが危険にさらされ、ひいては組織が法的リスクにさらされることになります。 2016 年から、ユーザーのプライバシーを保護しながらデータの所有権と出所を使用する方法を模索し始め、フェデレーテッド ラーニングとフェデレーテッド分析が大きな懸念事項となりました。研究範囲が拡大し続けるにつれて、フェデレーション ラーニングはモノのインターネットなどのより幅広い分野に適用され始めています。

それでは、フェデレーテッド ラーニングとは何でしょうか?

フェデレーテッド ラーニングは、中央サーバーまたはサービス プロバイダーの調整の下、複数のエンティティが協力して機械学習の問題を解決する機械学習設定です。生データはクライアントごとにローカルに保存され、交換または転送されません。代わりに、集中的なデータ更新を使用して、学習目標を達成するための即時集計が行われます。

同様に、分散したデータセットの結合情報から分析的洞察を生成することは、フェデレーション分析と呼ばれます。フェデレーテッド ラーニングで遭遇するシナリオは、フェデレーション分析にも当てはまります。

この記事では、フェデレーテッド ラーニングと分析の重要な概念を簡単に紹介します。特に、プライバシー テクノロジーを現実世界のシステムと統合する方法と、これらのテクノロジーを使用して、新しいシステムで集計された統計を通じて社会的利益を達成する方法に焦点を当てます。個人およびデータ管理者に対するリスクを最小限に抑えます。

1. プライバシー保護とフェデレーテッド ラーニング

プライバシーは本質的に、透明性とユーザーの許可、データの最小化、データの最小化、データの最小化という 3 つの主要な要素を備えた多面的な概念です。そしてデータの匿名化。

透明性とユーザーの同意はプライバシー保護の基礎です。これらは、ユーザーが自分のデータの使用を理解し、承認する方法です。プライバシー保護テクノロジーは透明性やユーザーの同意に代わるものではありませんが、どの種類のデータが使用できるか、または設計によって除外されるかを推測しやすくなり、プライバシーに関する声明の理解、検証、施行が容易になります。データ使用の主な目的は、フェデレーション学習モデルを生成し、メトリクスやユーザー データのその他の集計統計 (フェデレーテッド分析など) を計算することです。

集計に適用されるデータの最小化には、特定の計算に必要なデータのみを収集すること、すべての段階でそのデータへのアクセスを制限すること、個人データをできるだけ早く処理すること、データの保持を最小限に抑えることが含まれます。つまり、データの最小化とは、通常、暗号化、アクセス制御、安全なマルチパーティ コンピューティングおよび信頼できる実行環境などのセキュリティ メカニズムを通じて、すべてのデータへのアクセスを可能な限り最小限のグループに制限することを意味します。

データの匿名化とは、計算の最終出力では個人に固有の内容が明らかにならないことを意味します。匿名集計に使用する場合、個々のユーザーが計算に提供したデータは、最終的な集計出力にはほとんど影響を与えません。たとえば、集計統計を一般に公開する場合、特定のユーザーのデータが集計に含まれるかどうかによって、モデル パラメータを含む集計統計が大きく異なってはなりません。

つまり、データの最小化には計算の実行とデータの処理が含まれますが、データの匿名化には計算および公開される内容が含まれます。

フェデレーション ラーニングは構造的にデータの最小化を具体化します。フェデレーテッド アプローチではデータの収集と集計が分離できず、クライアント データは即座に集計するために変換および収集され、アナリストは各クライアントのメッセージにアクセスできないことに注意することが重要です。フェデレーテッド ラーニングとフェデレーテッド分析は、データ最小化の実践を具体化する一般的なフェデレーテッド コンピューティング パターンの例です。従来のアプローチは集中処理であり、デバイス上の前処理と集計をデータ収集に置き換え、ログ データの処理中にサーバー上でデータの最小化が行われます。

フェデレーテッド ラーニングとフェデレーテッド分析の目標は、匿名集計の目標と一致しています。機械学習の目標は、過剰適合せずにすべてのユーザーを正確に予測するモデルをトレーニングすることです。同様に、統計クエリの場合、目標は統計を推定することであり、特定のユーザーのデータによって大きな影響を受けるべきではありません。

フェデレーテッド ラーニングと差分プライバシーなどのプライバシー保護技術を組み合わせることで、公開された集計に十分な匿名性を確保できます。多くの場合、データの匿名性は適用されず、サービス プロバイダーによる個人の機密データへの直接アクセスは避けられませんが、これらのやり取りでは、サービス プロバイダーは意図された目的にのみデータを使用する必要があります。

2. フェデレーテッド ラーニングの重要なポイント

フェデレーテッド ラーニングの特徴は、元のデータの分散性の維持と、集約による学習です。ローカルで生成されたデータは、分布と量が異種であるため、フェデレーテッド ラーニングと従来のデータセンターベースの分散学習環境は区別されます。後者のデータは任意に分散およびクリーンアップでき、計算内のどのノードでも任意のデータにアクセスできます。実際には、コントロール センターの役割は重要であり、たとえば、固定 IP アドレスがなく、通信に中央サーバーが必要なモバイル デバイスの場合、多くの場合必要になります。

2.1 典型的なシナリオとアプリケーション

2 つのフェデレーション シナリオが特別な注目を集めています:

クライアントが多数のモバイル デバイスまたは IoT デバイスであるクロスデバイス フェデレーテッド ラーニング。

組織間のフェデレーテッド ラーニングの場合、クライアントは通常、小規模な組織、機関、またはその他のデータ アイランドです。

表 1 (Kairouz et al.10 から引用) は、FL 設定の主な特徴を要約し、クロスデバイス設定とクロスサイロ設定のいくつかの重要な違い、およびデータセンターでの分散学習との比較を強調しています。

クロスデバイスのフェデレーテッド ラーニングは、Android スマートフォンと iOS スマートフォンでそれぞれキーボード予測などの多くのアプリケーションに使用されています。組織間のフェデレーテッド ラーニングは、健康研究などの問題で使用されます。増加しているもう 1 つのアプリケーションは金融であり、WeBank、Credit Swiss、Intel などが投資しています。

典型的なフェデレーテッド ラーニング シナリオの特性を次の表で比較します。

| ##プロジェクト | #データセンターの分散学習#組織全体にわたるフェデレーテッド ラーニング | #クロスデバイスのフェデレーテッド ラーニング |

##構成 |

| 大規模なフラット データ セットでモデルをトレーニングします。クライアントはノードですクラスターまたはデータセンター内で | データ アイランド全体でモデルをトレーニングし、クライアントは異なる組織または異なる地域のデータ センターです | クライアントは大規模なモバイル デバイスまたは IoT デバイスです | データ配布 |

| データは一元的に保存され、使用できますクライアント全体のクリーニングとバランス調整。どのクライアントもデータ セットのどの部分にもアクセスできます。 | データはローカルで生成および保存され、分散化が維持されます。各クライアントは他のクライアントのデータにアクセスできず、データは独立していないか均一に分散されていません。 | #データはローカルに生成および保存され、分散性が維持されます。各クライアントは他のクライアントのデータにアクセスできず、データは独立していないか、均一に分散されていません||

オーケストレーション |

一元化されたオーケストレーション |

一元化されたオーケストレーション サービスですが、元のデータは表示されません |

一元化されたオーケストレーション サービスですが、元のデータは表示されません |

配信規模 | 1~1000 |

2~100 |

数億 |

クライアント プロパティ |

クライアントは本物で信頼でき、常に計算に参加し、計算中の状態を維持します。 |

クライアントは本物で信頼でき、常に計算に参加し、計算中の状態を維持します。 |

すべてのクライアントで利用できるわけではなく、通常は利用可能なデバイスからランダムにサンプリングされます。多数のクライアントは計算に 1 回だけ参加します。 |

2.2 フェデレーテッド ラーニング アルゴリズム

機械学習、特にディープ ラーニングは、一般にデータを大量に消費し、大量の計算を必要とするため、高品質のモデルを共同トレーニングする実現可能性は、あらかじめ決められた結論に達するのには程遠いです。フェデレーテッド ラーニング アルゴリズムは、従来の環境で機械学習モデルをトレーニングするために広く使用されている古典的な確率的勾配降下法アルゴリズムに基づいています。モデルは、トレーニング サンプルから予測までの関数であり、モデルの重みのベクトルと、予測と真の出力の間の誤差を測定する損失関数によってパラメーター化されます。トレーニング サンプルのバッチ (通常は数十から数千) をサンプリングすることにより、モデルの重みに対する損失関数の平均勾配を計算し、勾配の反対方向にモデルの重みを調整します。各反復のステップ サイズを適切に調整することにより、非凸関数であっても満足のいく収束を得ることができます。

フェデレーテッド ラーニングの拡張では、現在のモデルの重みをランダムなクライアントのグループにブロードキャストし、それぞれのクライアントにローカル データの損失勾配を計算させ、サーバー上のクライアントでこれらの勾配を平均し、グローバル モデルを更新します。重み。ただし、高精度のモデルを作成するには、通常、より多くの反復が必要です。大まかな計算によると、フェデレーテッド ラーニング環境では反復に数分かかる場合があり、これはフェデレーテッド トレーニングに 1 か月から 1 年かかる可能性があり、実用性の範囲を超えています。

フェデレーテッド ラーニングの重要なアイデアは直感的であり、確率的勾配降下の複数のステップを各デバイスでローカルに実行することで通信と起動のコストを削減し、モデルの平均更新数を削減します。各ローカル ステップの後にモデルの平均をとった場合、速度が遅すぎる可能性があります。モデルの平均が少なすぎると、発散する可能性があり、平均化によってより悪いモデルが生成される可能性があります。

モデルのトレーニングは、フェデレーテッド集計 (モデルの勾配や更新の平均) の適用に単純化できます。

2.3 一般的なワークフロー

ただし、クロスデバイスのフェデレーション ラーニングが製品チームの推進に効果的なものである場合は、実行可能なフェデレーテッド アルゴリズムを持つことが必要な出発点となります。メソッドを使用するには、さらに何かが必要です。クロスデバイスのフェデレーテッド ラーニングの場合、一般的なワークフローは通常次のとおりです。

(1) 問題の特定

通常、これは中規模 (1-デバイス上の 50MB ) モデル、デバイス上で利用可能な潜在的なトレーニング データは、データ センターで利用可能なデータよりも豊富またはより代表的です、プライバシーまたはデータを一元化したくないその他の理由がある、トレーニングに必要なフィードバック信号モデルはデバイスの入手ですぐに入手できます。

(2) モデルの開発と評価

他の機械学習タスクと同様に、正しいモデル構造とハイパーパラメーター (学習率、バッチ サイズ、正則化) を選択することが重要です。機械学習の成功。フェデレーション ラーニングでは、各ラウンドに参加するクライアントの数、実行する必要があるローカル ステップの数など、多くの新しいハイパーパラメーターが導入されるため、課題はさらに大きくなる可能性があります。一般的な開始点は、データセンター内の利用可能なエージェント データに基づくフェデレーテッド ラーニングを使用したシミュレーションであり、大まかなモデルの選択と調整が行われます。最終的な調整と評価は、実際の機器でのフェデレーテッド トレーニングを使用して実行する必要があります。評価は連携方式でも実行する必要があります。トレーニング プロセスとは独立して、候補グローバル モデルがデバイスに送信され、精度メトリクスがそれらのデバイスのローカル データセットで計算され、サーバーによって集計されます。たとえば、単純な平均などです。各クライアントのパフォーマンスとヒストグラムは両方とも重要です。これらの需要により、2 つの重要なインフラストラクチャ要件が生じます: (1) 実際のデバイスでの実行へのスムーズな移行を可能にする高性能のフェデレーション ラーニング シミュレーション インフラストラクチャの提供、(2) 複数の同時トレーニングと評価の管理を容易にするクロスデバイス インフラストラクチャ実行されたタスク。

(3) デプロイメント

ステップ 2 で高品質の候補モデルが選択されたら、通常、モデルのデプロイメントはデータセンターでトレーニングされたモデルと同じ手順に従います。追加の検証とテスト (手動による品質保証が含まれる場合があります)、以前の実稼働モデルに対するライブ A/B テスト、およびデバイス フリート全体への段階的なロールアウト (実際にモデル トレーニングに参加するデバイスよりもさらにいくつかのデバイスが含まれる場合があります) が含まれます。 。

ステップ 2 のすべての作業は、トレーニングと評価に関係するデバイスのユーザー エクスペリエンスに影響を与えないことは注目に値します。フェデレーテッド ラーニングを使用してトレーニングされたモデルでは、展開ステップが完了しない限り、ユーザーは予測を確認できません。 。この処理が機器に悪影響を及ぼさないようにすることは、インフラストラクチャの重要な課題です。たとえば、集中的な計算は、デバイスがアイドル状態でネットワークがアイドル状態のときにのみ実行される場合があります。

これらのワークフローは、スケーラブルなインフラストラクチャと API を構築する上での重大な課題を表しています。

3. Federated Computing におけるプライバシー保護

Federated Learning は、すぐに使えるさまざまなプライバシーの利点を提供します。データ最小化の原則に従って、生データはデバイス上に残り、サーバーに送信される更新は特定のターゲットに焦点を当てて、できるだけ早く集約されます。特に、非集計データはサーバーに保存されず、エンドツーエンドの暗号化により転送中のデータが保護され、復号化キーと復号化された値は両方とも RAM に一時的にのみ保存されます。システムを操作する機械学習エンジニアとアナリストは、集約されたデータのみにアクセスできます。集約はフェデレーテッド アプローチの基本的な役割であり、出力に対する単一クライアントの影響を制限することが自然になりますが、差分プライバシーなどのより正式な保証を提供することが目標の場合は、アルゴリズムを慎重に設計する必要があります。

基本的なフェデレーテッド ラーニング手法は実現可能であることが証明されており、広く採用されていますが、公平性、精度、開発速度、計算コストの間には固有のトレードオフがあるため、デフォルトで使用されるにはまだ程遠いです。緊張により、データの最小化や匿名化のアプローチが妨げられる可能性があります。したがって、構成可能なプライバシー強化技術が必要です。最終的に、プライバシー テクノロジーの導入に関する決定は、特定の分野のプライバシー、ポリシー、および法律の専門家と相談して、製品またはサービス チームによって行われます。製品は、利用可能なフェデレーテッド ラーニング システムを通じてより多くのプライバシー保護を提供でき、おそらくより重要なことに、政策専門家がプライバシーの定義と要件を時間の経過とともに強化するのに役立ちます。

フェデレーション システムのプライバシー機能を検討する場合、アクセス ポイントと脅威モデルを考慮することが役立ちます。参加者は物理デバイスまたはネットワークにアクセスできますか? FL を提供するサーバーへのルート経由または物理アクセス経由ですか?モデルとメトリクスを機械学習エンジニアにリリースしますか?最終展開モデル?情報がこのシステムを通過するにつれて、潜在的に悪意のある当事者の数は大きく異なります。したがって、プライバシーに関する声明は、完全なエンドツーエンドのシステムとして評価される必要があります。デバイス上の生データや転送中の中間計算状態を保護するために適切なセキュリティ対策が講じられていない場合、最終的に展開されたモデルにユーザー データが保存されているかどうかの保証は重要ではない可能性があります。

データの最小化は、セキュリティを強化し、データと中間結果の保持を最小限に抑えることで、デバイス、ネットワーク、サーバーに対する潜在的な脅威に対処します。モデルとメトリクスがモデル エンジニアに公開されるか、運用環境に展開される場合、匿名集約により、これらの公開された出力にアクセスする当事者から個人データが保護されます。

3.1 集計データの最小化

フェデレーション コンピューティングのいくつかの時点で、参加者は相互に適切なアクションを実行することを期待し、それらのアクションのみを実行します。たとえば、サーバーはクライアントが前処理ステップを正確に実行することを期待し、クライアントはサーバーが個々の更新が集約されるまで非公開に保つことを期待し、クライアントとサーバーの両方がデータ アナリストも展開された機械学習モデルのユーザーも個人データを抽出できないことを期待します。 。

プライバシー保護テクノロジーは、これらのコンポーネントの構造的強制をサポートし、参加者が逸脱することを防ぎます。実際、フェデレーテッド システム自体は、クライアントによって送信された更新に含まれていないクライアント データにサーバーがアクセスすることを構造的に防止するプライバシー保護テクノロジとみなすことができます。

集約ステージを例に挙げます。理想的なシステムは、完全に信頼できるサードパーティがクライアントの更新を集約し、最終的な集約のみをサーバーに表示することを想像します。実際には、このような相互に信頼できる第三者は通常、この役割を果たすために存在しませんが、さまざまな技術により、フェデレーテッド ラーニング システムがさまざまな条件下でそのような第三者をシミュレートすることができます。

たとえば、サーバーは、安全なエンクレーブ内で集約プロセスを実行できます。これは、実行しているコードをクライアントに証明するだけでなく、誰も監視できないようにする特別に構築されたハードウェアです。またはコード実行の改ざん。ただし、現時点では、クラウドであろうとコンシューマ デバイスであろうと、利用できる安全な環境は限られており、利用可能なセキュリティ環境は、いくつかの指定された属性ドメインのみを実装している可能性があります。さらに、利用可能で完全に機能する場合でも、安全な環境には、メモリや速度が非常に制限されている、サイド チャネルを通じて公開されるデータに対して脆弱である (キャッシュ タイミング攻撃など)、正しい性質を検証することが困難である、認証に依存しているなど、追加の制約が課せられる場合があります。メーカーが提供するサービス(鍵の機密保持など)など。

マルチパーティの安全な計算のための分散暗号化プロトコルを共同で使用すると、参加者が十分に正直である限り、特殊なハードウェアを必要とせずに、信頼できるサードパーティをシミュレートすることができます。任意の関数のマルチパーティによる安全な計算は、ほとんどの場合依然として計算上のハードルですが、フェデレーテッド環境でのベクトル合計のための特殊な集約アルゴリズムが開発されており、サーバーを監視し、クライアントの大部分を制御する敵対者に対してもプライバシーを維持します。クライアント終了計算に対する堅牢性:

通信効率 - クライアントごとの O (log n l) 通信 (n はユーザー数を表し、l はベクトル長を表します) 幅広いアプリケーションにおいて、Small 定数は生成する値が総トラフィックの 2 倍;

計算効率 - クライアントごとに O (log2n llogn) 回の計算

暗号的に安全な集約プロトコルは、商用フェデレーテッド コンピューティング システムに広く導入されています。プライベート アグリゲーションに加えて、プライバシー保護技術を使用して、フェデレーテッド システムの他の部分を保護できます。たとえば、安全な環境または暗号技術 (ゼロ知識証明など) により、クライアントが前処理を真実に実行したことをサーバーが信頼できることが保証されます。モデルのブロードキャスト段階でもメリットが得られます。多くの学習タスクでは、単一のクライアントはモデルのごく一部に関連するデータしか持たない可能性があります。その場合、クライアントはトレーニングのためにモデルのその部分を非公開で取得できます。再度、安全な環境を使用します。または、クライアントに関連付けられたトレーニング データを含むモデルの一部をサーバーが学習しないようにするための暗号化技術。

3.2 匿名集計の計算と検証

安全な環境とプライバシー集計技術はデータの最小化を強化できますが、匿名集計を生成するように特別に設計されたものではありません。たとえば、トレーニング中のモデルに対するユーザーの影響を制限します。実際、学習されたモデルは場合によっては機密情報を漏洩する可能性があります。

データ匿名性の標準的な方法は差分プライバシーです。データベース内のレコードを集約する一般的なプロセスでは、差分プライバシーでは、レコードの集約への寄与を制限し、適切に比例したランダムな摂動を追加する必要があります。たとえば、差分プライベート確率的勾配降下アルゴリズムでは、勾配のノルムがクリップされ、クリップされた勾配が集約され、各トレーニング エポックでガウス ノイズが追加されます。

差分プライバシー アルゴリズムは必然的に確率的であるため、特定のデータ セット上でアルゴリズムによって生成されたモデルの分布を考慮できます。直感的には、異なるレコードを持つ単一の入力データセットに対して差分プライベート アルゴリズムを実行する場合、モデル間のこの分布は似ています。形式的には、差分プライバシーはプライバシー損失パラメータ (ε, δ) によって定量化され、(ε, δ) が小さいほどプライバシーが増加することに対応します。これは、各レコードに対するモデルの感度を単に制限するだけではなく、任意のレコードの影響に比例するノイズを追加することで、出力に対する任意の 1 つのレコードの寄与をマスクするのに十分なランダム性を確保します。

クロスデバイスのフェデレーション ラーニングのシナリオでは、レコードは単一のユーザー/クライアントのすべてのトレーニング インスタンスとして定義されます。差分プライバシーはユーザーレベルまたは比例することができます。集中型構成であっても、フェデレーテッド ラーニング アルゴリズムは、ユーザーのすべてのデータから単一のモデル更新を計算し、各ユーザーの貢献をモデル更新に結び付けることが容易になるため、ユーザー レベルのプライバシーを保証したトレーニングに適しています。

クロスデバイス連合学習システムのコンテキストで正式な (ε、δ) 保証を提供することは、すべての適格なユーザーのセットが動的で事前に不明であり、参加しているユーザーがトレーニングを行っている可能性があるため、特に困難になる可能性があります。段階のどの時点においても、本番環境の連合学習システムに適したエンドツーエンドのプロトコルを構築することは、依然として解決すべき重要な問題です。

組織を超えたフェデレーション ラーニングのシナリオでは、プライバシー単位はさまざまな意味を持つ可能性があります。たとえば、参加機関がモデルの反復へのアクセスを確実にしたい場合、または最終モデルが特定の機関のデータセットがモデルのトレーニングに使用されたかどうかを判断できない場合、レコードをデータ サイロ内のすべての例として定義できます。ユーザーレベルの差分プライバシーは、組織間の設定でも依然として意味を持ちます。ただし、複数の機関が同じユーザーの記録を保持している場合、ユーザーレベルのプライバシーを強制することはより困難になる可能性があります。

これまでの差分プライバシー データ分析は、主に中央または信頼できるアグリゲーターに使用されており、生データは差分プライバシー アルゴリズムを実装する信頼できるサービス プロバイダーによって収集されます。ローカル差分プライバシーでは、完全に信頼できるアグリゲーターの必要性が回避されますが、精度が大幅に低下します。

完全に信頼された中央サーバーに依存せずに集中型差分プライバシーの有用性を復元するには、分散型差分プライバシーと呼ばれることが多いいくつかの新しい方法を使用できます。目標は、サーバーが出力を (クリア テキストで) 認識する前に、出力を別の方法で非公開にすることです。分散差分プライバシーでは、クライアントはまずアプリケーション固有の最小限のデータを計算し、ランダム ノイズでこれらのデータをわずかに混乱させ、プライバシー集約プロトコルを実行します。この場合、サーバーはプライバシー集約プロトコルの出力にのみアクセスできます。単一の顧客によって追加されたノイズは、通常、ローカルな差別化に意味のある保証を提供するには十分ではありません。ただし、プライバシー集約後、プライバシー集約プロトコルの出力は、すべてのクライアントにわたるノイズの合計に基づいて、より強力な DP 保証を提供します。プライバシー集約プロトコルで要求されるセキュリティの前提に基づいて、これはサーバーにアクセスできるユーザーにも適用されます。

正式なユーザーレベルのプライバシー保証を提供するアルゴリズムでは、モデルの感度を各ユーザーのデータに結び付けるだけでなく、その感度に比例するノイズも追加する必要があります。差分プライバシーの定義が強力な保証を提供するのに十分小さなεを持つようにするには、十分なランダム ノイズを追加する必要がありますが、小さなノイズであっても感度を制限すると、解読が大幅に低下する可能性があります。なぜなら、差分プライバシーは、どちらの側でも無制限の計算と情報へのアクセスを行う「最悪の敵対者」を想定しているからです。これらの仮定は実際には非現実的なことがよくあります。したがって、各ユーザーの影響を制限する差分プライベート アルゴリズムを使用したトレーニングには大きな利点があります。ただし、小さな ε 保証を達成するための実用的なフェデレーテッド ラーニングおよびフェデレーテッド分析アルゴリズムを設計することは、重要な研究分野です。

モデル監査手法を使用すると、差分プライバシーを使用したトレーニングの利点をさらに定量化できます。これには、モデルが過剰学習する程度やまれなトレーニング例を定量化すること、ユーザーがトレーニング中にそのテクニックを使用したかどうかを推測できる程度を定量化することが含まれます。これらの監査手法は、大きな ε を使用する場合でも有用であり、差分プライベートの最悪の場合の敵対者と、限られた計算能力と副次情報を伴う現実的な敵対者との間のギャップを定量化できます。これらは、ストレス テストの補完的な手法としても機能します。差分プライバシーに関する正式な数学的主張とは異なり、これらの監査手法は完全なエンドツーエンド システムに適用され、ソフトウェアのバグや誤ったパラメータの選択を検出する可能性があります。

4. フェデレーテッド分析

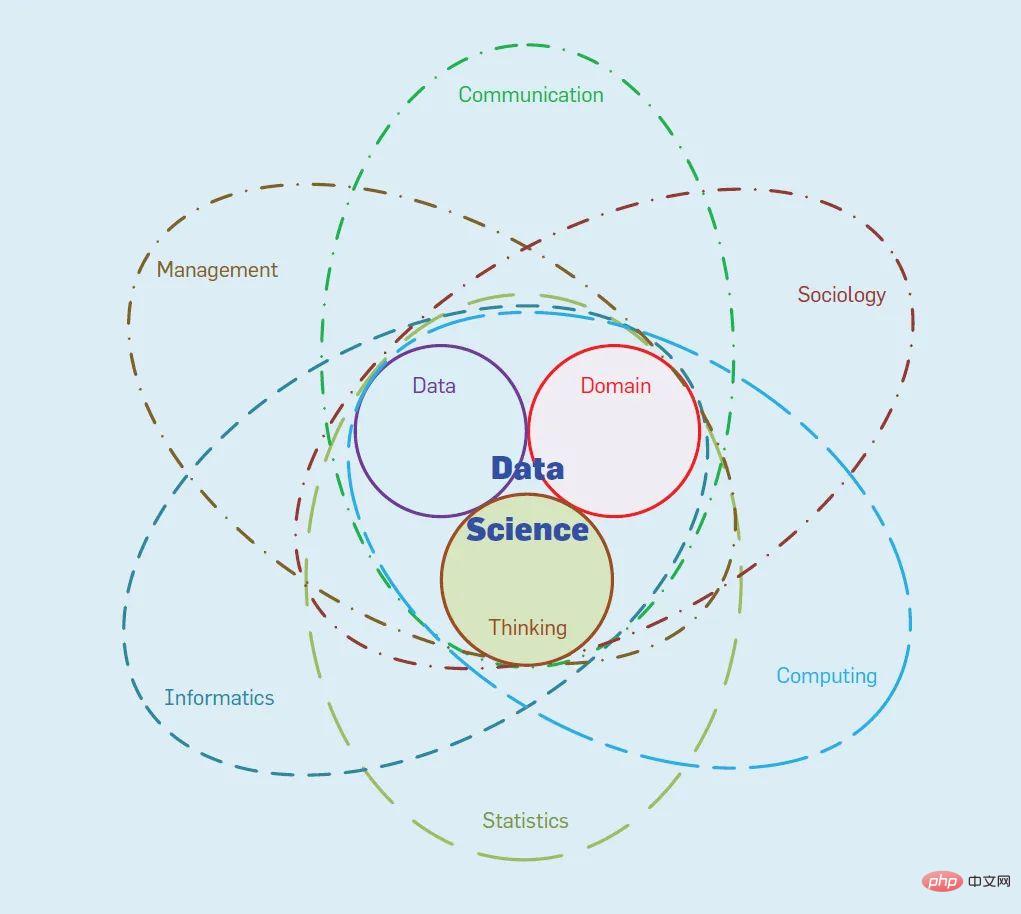

データ アナリストは、機械学習モデルの学習に加えて、データ サイエンス手法を適用してローカル ユーザー デバイス上の生データを分析することに関心を持つことがよくあります。たとえば、アナリストは、集約されたモデル メトリクス、人気の傾向とアクティビティ、または地理空間位置のヒート マップに興味があるかもしれません。これらはすべて、フェデレーション分析を使用して実現できます。フェデレーション ラーニングと同様に、フェデレーション分析は、各デバイスのデータに対してローカル計算を実行し、集計された結果のみを提供することによって機能します。ただし、フェデレーテッド ラーニングとは異なり、フェデレーテッド アナリティクスは、カウント、平均、ヒストグラム、分位数、その他の SQL のようなクエリなどの基本的なデータ サイエンスのニーズをサポートするように設計されています。

アナリストがフェデレーション分析を使用して、多くのユーザーが共有する音楽ライブラリで最も再生されている上位 10 曲を学習したいアプリケーションの場合。このタスクは、上で説明したフェデレーションおよびプライバシー技術を使用して実行できます。たとえば、クライアントは、聴いた曲をライブラリのサイズと同じ長さのバイナリ ベクトルにエンコードし、分散差分プライバシーを使用して、再生したユーザーの数を考慮して、サーバーがこれらのベクトルの 1 つの値のみを参照できるようにすることができます。各曲 の差分プライバシー ヒストグラム。

ただし、フェデレーテッド分析タスクは、いくつかの点でフェデレーテッド学習タスクとは異なります。

フェデレーション分析アルゴリズムは通常、非対話型であり、多数のクライアントが関与します。言い換えれば、フェデレーテッド ラーニング アプリケーションとは異なり、ラウンドに参加するクライアントが増えても利益が減少することはありません。したがって、フェデレーテッド分析で差分プライバシーを適用することは、各ラウンドに多数のクライアントを含めることができ、必要なラウンドが少なくなるため、それほど困難ではありません。

同じお客様が次回以降のラウンドに再度参加する必要はありません。実際、顧客の再エンゲージメントもアルゴリズムの結果に偏りをもたらす可能性があります。したがって、フェデレーション分析タスクは、個人が参加できる回数を制限するインフラストラクチャによって最適に提供されます。

フェデレーション分析タスクは多くの場合スパースであるため、効率的なプライバシー スパース集約が特に重要なトピックになります。

制限されたクライアントの参加と疎な集計はフェデレーション分析に特に関連しますが、フェデレーテッド ラーニングの問題にも適用できることは注目に値します。

5. 概要

フェデレーテッド ラーニングは、より多くの種類のデータや問題領域に適用されており、プライバシー コンピューティングの重要な方法、つまり AI のプライバシー保護方法であるとさえ考えられています。 、個人のエネルギー 制限があるため、この記事では、フェデレーテッド ラーニングにおけるパーソナライゼーション、堅牢性、公平性、およびシステム実装の課題については取り上げません。フェデレーテッド ラーニングの実践に関しては、TensorFlow Federated が良い出発点になる可能性があります。

以上がプライバシー コンピューティングにおけるフェデレーション ラーニングの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7467

7467

15

15

1376

1376

52

52

77

77

11

11

18

18

20

20

Laravelの地理空間:インタラクティブマップと大量のデータの最適化

Apr 08, 2025 pm 12:24 PM

Laravelの地理空間:インタラクティブマップと大量のデータの最適化

Apr 08, 2025 pm 12:24 PM

700万のレコードを効率的に処理し、地理空間技術を使用したインタラクティブマップを作成します。この記事では、LaravelとMySQLを使用して700万を超えるレコードを効率的に処理し、それらをインタラクティブなマップの視覚化に変換する方法について説明します。最初の課題プロジェクトの要件:MySQLデータベースに700万のレコードを使用して貴重な洞察を抽出します。多くの人は最初に言語をプログラミングすることを検討しますが、データベース自体を無視します。ニーズを満たすことができますか?データ移行または構造調整は必要ですか? MySQLはこのような大きなデータ負荷に耐えることができますか?予備分析:キーフィルターとプロパティを特定する必要があります。分析後、ソリューションに関連している属性はわずかであることがわかりました。フィルターの実現可能性を確認し、検索を最適化するためにいくつかの制限を設定しました。都市に基づくマップ検索

Vue Axiosのタイムアウトを設定する方法

Apr 07, 2025 pm 10:03 PM

Vue Axiosのタイムアウトを設定する方法

Apr 07, 2025 pm 10:03 PM

Vue axiosのタイムアウトを設定するために、Axiosインスタンスを作成してタイムアウトオプションを指定できます。グローバル設定:Vue.Prototype。$ axios = axios.create({Timeout:5000});単一のリクエストで:this。$ axios.get( '/api/users'、{timeout:10000})。

MySQLを解決する方法は開始できません

Apr 08, 2025 pm 02:21 PM

MySQLを解決する方法は開始できません

Apr 08, 2025 pm 02:21 PM

MySQLの起動が失敗する理由はたくさんあり、エラーログをチェックすることで診断できます。一般的な原因には、ポートの競合(ポート占有率をチェックして構成の変更)、許可の問題(ユーザー許可を実行するサービスを確認)、構成ファイルエラー(パラメーター設定のチェック)、データディレクトリの破損(テーブルスペースの復元)、INNODBテーブルスペースの問題(IBDATA1ファイルのチェック)、プラグインロード障害(エラーログのチェック)が含まれます。問題を解決するときは、エラーログに基づいてそれらを分析し、問題の根本原因を見つけ、問題を防ぐために定期的にデータをバックアップする習慣を開発する必要があります。

インストール後にMySQLの使用方法

Apr 08, 2025 am 11:48 AM

インストール後にMySQLの使用方法

Apr 08, 2025 am 11:48 AM

この記事では、MySQLデータベースの操作を紹介します。まず、MySQLWorkBenchやコマンドラインクライアントなど、MySQLクライアントをインストールする必要があります。 1. mysql-uroot-pコマンドを使用してサーバーに接続し、ルートアカウントパスワードでログインします。 2。CreatedAtaBaseを使用してデータベースを作成し、データベースを選択します。 3. createTableを使用してテーブルを作成し、フィールドとデータ型を定義します。 4. INSERTINTOを使用してデータを挿入し、データをクエリし、更新することでデータを更新し、削除してデータを削除します。これらの手順を習得することによってのみ、一般的な問題に対処することを学び、データベースのパフォーマンスを最適化することでMySQLを効率的に使用できます。

リモートシニアバックエンジニア(プラットフォーム)がサークルが必要です

Apr 08, 2025 pm 12:27 PM

リモートシニアバックエンジニア(プラットフォーム)がサークルが必要です

Apr 08, 2025 pm 12:27 PM

リモートシニアバックエンジニアの求人事業者:サークル場所:リモートオフィスジョブタイプ:フルタイム給与:$ 130,000- $ 140,000職務記述書サークルモバイルアプリケーションとパブリックAPI関連機能の研究開発に参加します。ソフトウェア開発ライフサイクル全体をカバーします。主な責任は、RubyonRailsに基づいて独立して開発作業を完了し、React/Redux/Relay Front-Endチームと協力しています。 Webアプリケーションのコア機能と改善を構築し、機能設計プロセス全体でデザイナーとリーダーシップと緊密に連携します。肯定的な開発プロセスを促進し、反復速度を優先します。 6年以上の複雑なWebアプリケーションバックエンドが必要です

mysqlはjsonを返すことができますか

Apr 08, 2025 pm 03:09 PM

mysqlはjsonを返すことができますか

Apr 08, 2025 pm 03:09 PM

MySQLはJSONデータを返すことができます。 json_extract関数はフィールド値を抽出します。複雑なクエリについては、Where句を使用してJSONデータをフィルタリングすることを検討できますが、そのパフォーマンスへの影響に注意してください。 JSONに対するMySQLのサポートは絶えず増加しており、最新バージョンと機能に注意を払うことをお勧めします。

酸性特性を理解する:信頼できるデータベースの柱

Apr 08, 2025 pm 06:33 PM

酸性特性を理解する:信頼できるデータベースの柱

Apr 08, 2025 pm 06:33 PM

データベース酸属性の詳細な説明酸属性は、データベーストランザクションの信頼性と一貫性を確保するための一連のルールです。データベースシステムがトランザクションを処理する方法を定義し、システムのクラッシュ、停電、または複数のユーザーの同時アクセスの場合でも、データの整合性と精度を確保します。酸属性の概要原子性:トランザクションは不可分な単位と見なされます。どの部分も失敗し、トランザクション全体がロールバックされ、データベースは変更を保持しません。たとえば、銀行の譲渡が1つのアカウントから控除されているが別のアカウントに増加しない場合、操作全体が取り消されます。 TRANSACTION; updateaccountssetbalance = balance-100wh

MySQLの主な鍵はヌルにすることができます

Apr 08, 2025 pm 03:03 PM

MySQLの主な鍵はヌルにすることができます

Apr 08, 2025 pm 03:03 PM

MySQLプライマリキーは、データベース内の各行を一意に識別するキー属性であるため、空にすることはできません。主キーが空になる可能性がある場合、レコードを一意に識別することはできません。これにより、データの混乱が発生します。一次キーとして自己挿入整数列またはUUIDを使用する場合、効率やスペース占有などの要因を考慮し、適切なソリューションを選択する必要があります。