Weibo推奨リアルタイム大型モデルの技術進化

1. 技術ルートのレビュー

##1. ビジネス シナリオと特性##Weibo APP でこのチームが担当するレコメンデーション業務には主に以下が含まれます:

① ホームページのレコメンデーションの下にあるすべてのタブ列の内容、情報フロー製品は通常、最初のタブのトラフィックの割合が比較的高くなります。

#② ホット検索は、下にスライドする情報の流れです。これは当社のビジネス シナリオでもあります。これを含む、ビデオ チャンネルなどのページ上のその他の情報フロー タブ;

③ アプリ全体でおすすめのビデオを検索またはクリックして、臨場感あふれるビデオシーン。

当社のビジネスには次の特徴があります:

(1) まず、推奨される実装の観点から: ① ビジネス シナリオは数多くあります。

② Weibo UI 上のユーザーは多様な操作とフィードバックを行うことができ、コンテンツはテキスト ページをクリックして表示することも、ストリーム内で消費することもできます。たとえば、クリックしてブロガーの個人ページに入り、クリックしてテキストページに入り、写真をクリックし、ビデオをクリックし、コメントや「いいね!」をクリックして、などです。

③ 縦長の写真、写真(1枚または複数枚)、動画(横長または複数枚)など、配布できる素材の種類は豊富です。縦型)、ホームページのおすすめ、動画)、記事などを配信できます。

(2) プロダクトポジショニングの観点から:

① サービスホットスポット:Weiboは特にホットスポット発生前後のトラフィック変化が大きく、ユーザーは同社のレコメンド商品の要件であるレコメンド内のホットコンテンツをスムーズに消費できる。

② 関係を構築する: 推奨されている Weibo でソーシャル関係を蓄積したいと考えています。

2. 技術の選択

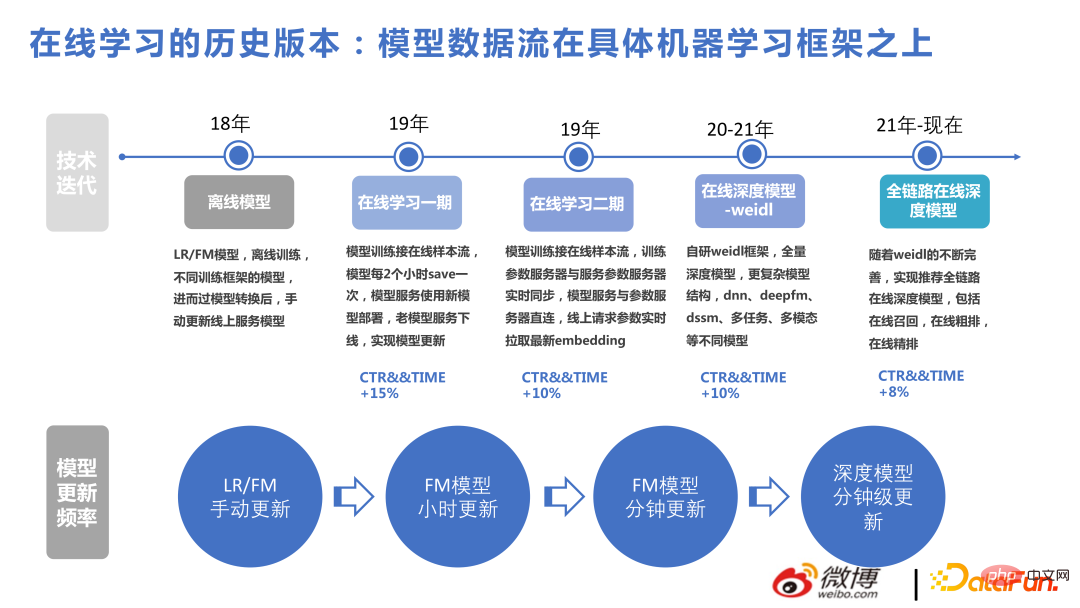

次の図は、近年の当社の技術進歩を示しています。

2018 年から 2022 年にかけてのこのチームの技術的進化は、主に大規模とリアルタイムの 2 つの側面で行われます。これに基づいて、複雑な構造を作成して、半分の労力で 2 倍の結果を達成します。

#ここでは、Weidl オンライン学習プラットフォームについて簡単に紹介します。

#

主なプロセスは次のとおりです: ユーザー動作のスプライシング サンプルがモデルの学習に使用され、フィードバックのためにユーザーに推奨事項が提供されます。設計では、より優れた柔軟性を実現するためにデータ フロー優先原則を採用しています。 KERNEL のトレーニングにどのような方法が使用されても、オフライン モデル ストレージとオンライン PS の間のリアルタイム更新部分は依然として存在します。手書きのLRでもFMでも、TensorflowでもDeepRecの学習モデルでも可能で、対応するモデルストレージは自社で構築したデータストリームの集合であり、モデルフォーマットも自社で作成しているため、複数のバックエンドは次からダウンロードできます。モデル トレーニングはオンラインで 1 分以内に更新でき、次回ユーザーが呼び出すときに新しいパラメーターを使用できます。この設計原則に基づいて、バックエンドを簡単に切り替えることができます。

Weidl は Weibo が自社開発した機械学習プラットフォームで、ブリッジ モードではさまざまな深層学習フレームワークの演算子を呼び出したり、独自の演算子に置き換えたりすることができます。演算子の計算にも非常に便利です。たとえば、以前 Tensorflow を使用していたときは、tf でメモリ割り当てと演算子の最適化を実行していましたが、2022 年後半には DeepRec に切り替える予定です。DeepRec についてさらに学習すると、以前のパフォーマンス最適化ポイントのいくつかが見つかるでしょう。 tf に基づくものは DeepRec. のものと類似しています。

次の図は、当社のビジネスにおける各技術点の貢献を誰もが理解しやすくするために、当社のチームが長年にわたって作成したいくつかのバージョンを示しています。モデルは大規模なリアルタイム レコメンデーションの問題を解決し、その後、深さに基づいて複雑な構造を作成します。結果から判断すると、オンラインのリアルタイム問題を解決するために非深度モデルを以前使用したことも大きなメリットをもたらしました。

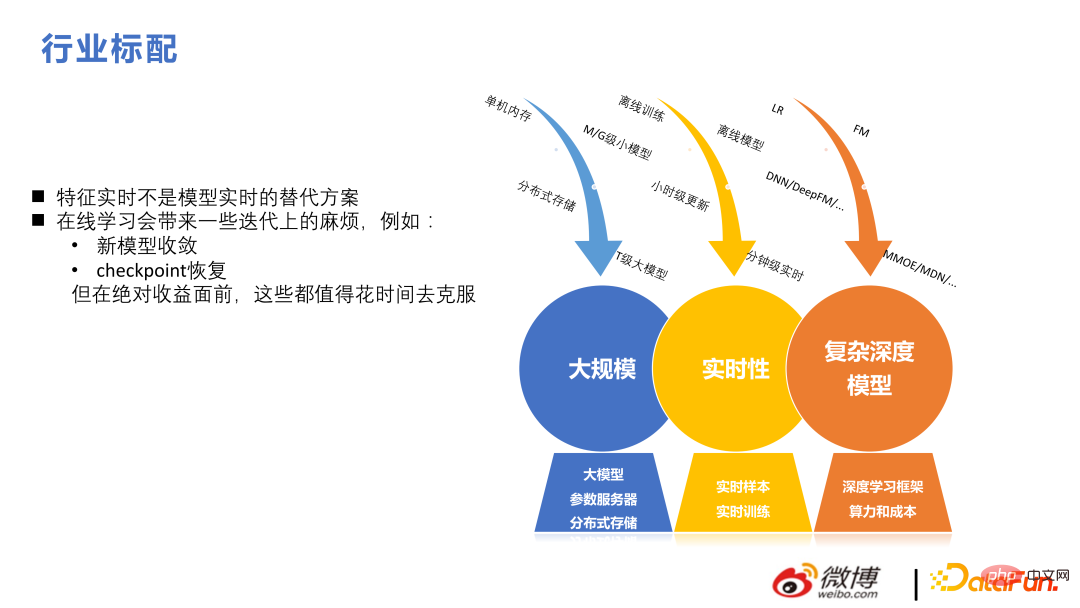

#情報フローの推奨事項は製品の推奨事項とは異なります。情報フローの推奨事項は基本的に大規模です。リアルタイムのディープ アーキテクチャ。この分野にはいくつかの困難と違いもあります。たとえば、リアルタイム機能はリアルタイム モデルの代替ではありません。レコメンデーション システムの場合、モデルが何を学習するかがより重要です。さらに、オンライン学習には反復の問題がいくつか発生します。しかし、絶対的な利益が得られる前に、それは時間の経過とともに克服される可能性があります。

#2. 大規模モデルの最近のテクノロジーの反復

この章では、ビジネス反復モデルを目標、構造、特性の側面から紹介します。

#1. 多目的の融合

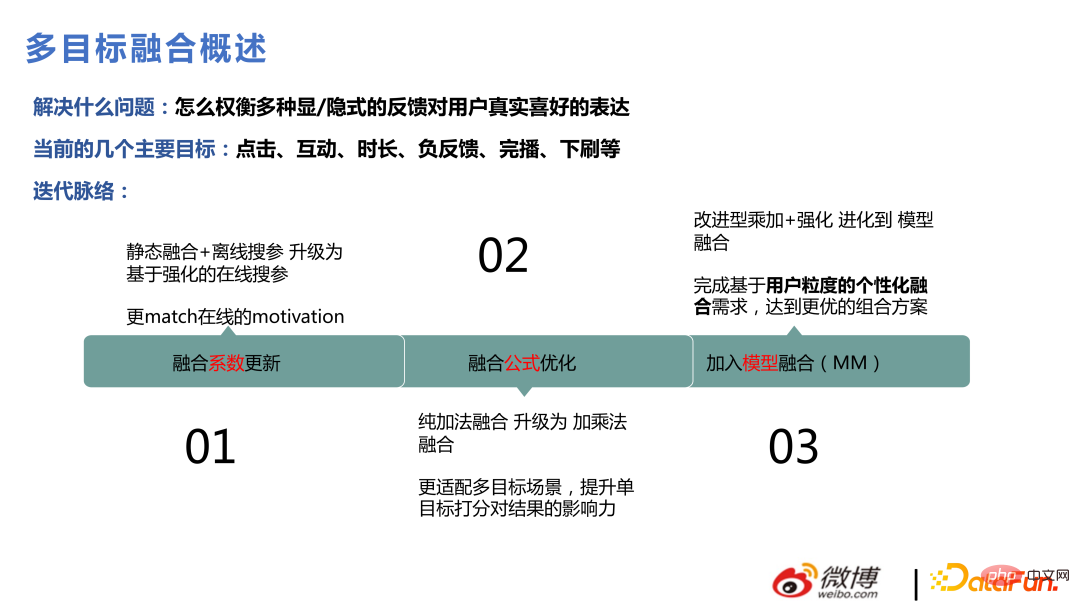

#Weibo シナリオでは多くのユーザー操作があり、ユーザーはアイテムへの愛を表現します。クリック インタラクション、継続時間、ドロップダウンなど、さまざまな種類の動作があります。それぞれの目標をモデル化して推定する必要があり、最後に全体的な統合とランキングがレコメンデーション ビジネスにとって非常に重要です。最初に行われたときは、静的融合とオフライン パラメータ検索によって行われていましたが、その後、強化学習法による動的パラメータ検索になり、その後、いくつかの融合式の最適化が行われ、その後、いくつかの出力が得られるように改良されました。モデルによるフュージョン スコア。お待ちください。

パラメータ調整を強化するための中心的な方法は #、オンライン トラフィックをいくつかの小さなトラフィック プールに分割し、現在のオンライン パラメータを使用して新しいパラメータを生成し、これらのパラメータに対するユーザーの反応を確認し、フィードバックを収集して繰り返します。中心となる部分は、CEM と ES を使用する reward の計算です。その後、独自に開発したアルゴリズムを使用して、独自のビジネス ニーズに適応しました。オンライン学習は非常に急速に変化するため、パラメーターをそれに応じて変更できない場合、大きな問題が発生します。たとえば、ビデオ コンテンツに対するみんなの好みは、金曜日の夜から土曜日の朝、日曜日の夜から月曜日の朝に変わります。変化は非常に速く、全体の変化も変化します。融合パラメータは、何かに対するユーザーの好みの変更を反映する必要があります。

#

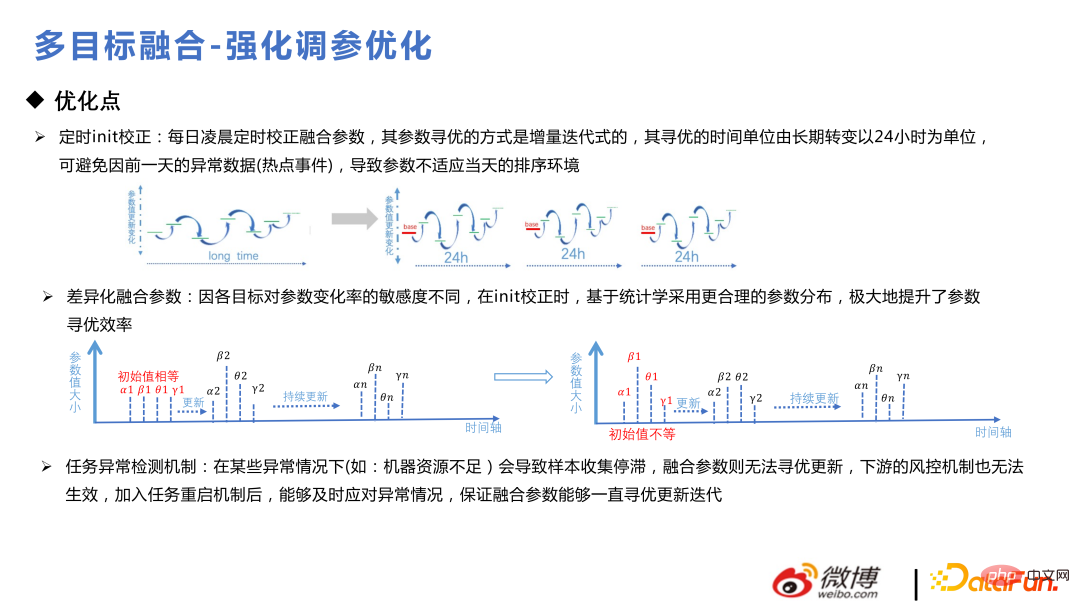

以下はモデル最適化におけるちょっとしたコツです。ユーザーは毎日周期的に使用します。毎日定期的に初期化修正を行う方が良いです。そうしないと偏った分岐に行く可能性があります。パラメータの初期化です。事前分布に従い、最初にアプリオリ分析を実行し、次に差分融合を実行するために必要なため、融合パラメータが反復的かつ一貫して更新されることを保証するために異常検出メカニズムを追加します。

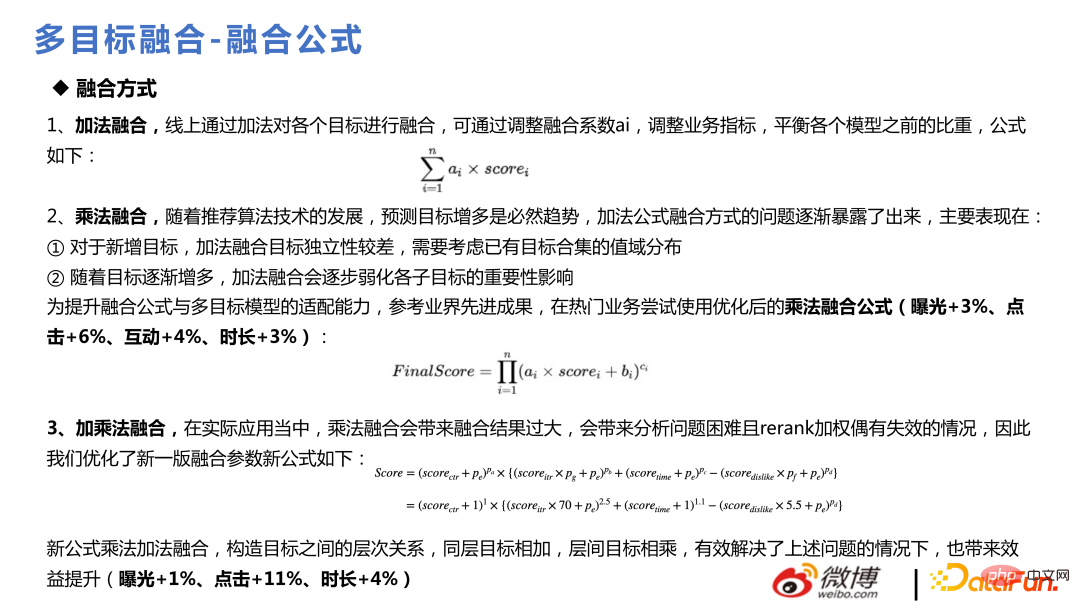

融合式は当初は加法融合を使用していましたが、当時はそれほど多くはありませんでした。ビジネス目標。目標の数が増加するにつれて、加法融合は目標の追加をサポートするには不便であり、各サブ目標の重要性が弱まることがわかります。乗法融合の式は後で使用します。効果は次の ppt に示されています:

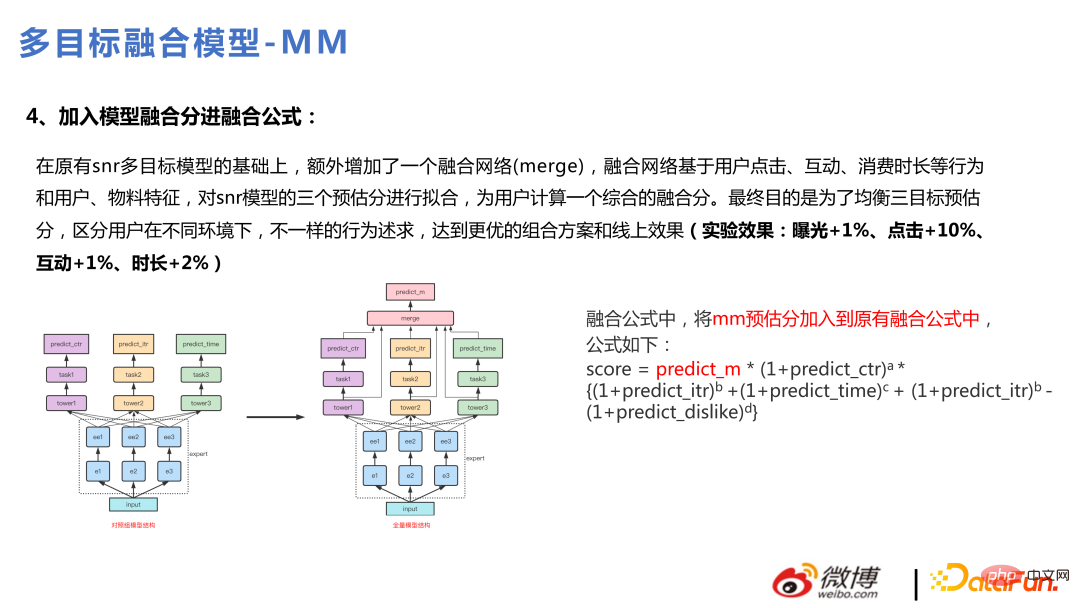

##完全バージョンをマルチタスクにアップグレードした後, こちら バージョンは、モデルを通じてターゲット フュージョンを実行するように最適化されています。モデルの融合により、多くの非線形なものをより良く捉え、より良い表現力を得ることができ、これにより、パーソナライズされた融合も実現でき、各ユーザーが異なるものを得ることができます。

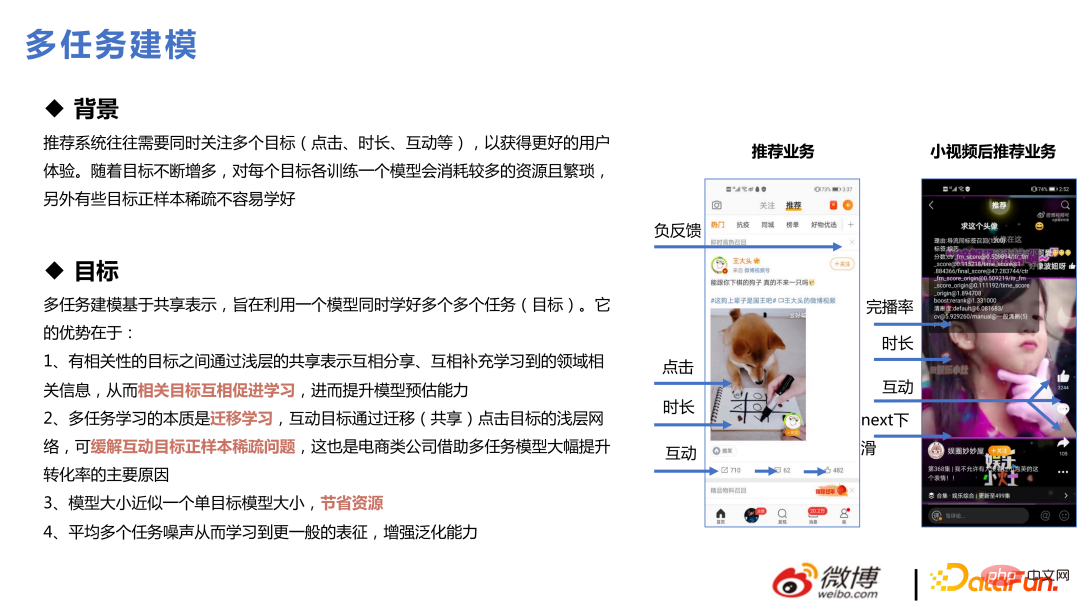

2. マルチタスク

マルチタスクは 2019 年からです。 , 2020 年に流行した概念であり、レコメンデーション システムは多くの場合、同時に複数の目標に焦点を当てる必要があります。たとえば、ビジネス シナリオには 7 つの目標があります: クリック、継続時間、インタラクション、完了、否定的なフィードバック、ホームページへのアクセス、プルダウンの更新など。ターゲットごとにモデルをトレーニングすると、より多くのリソースが消費され、面倒になります。さらに、一部のターゲットは疎であり、一部は比較的密です。モデルが別々に構築された場合、これらの疎なターゲットを適切に学習するのは一般に容易ではありません。一緒に学習することで、疎なターゲットの学習の問題を解決できます。

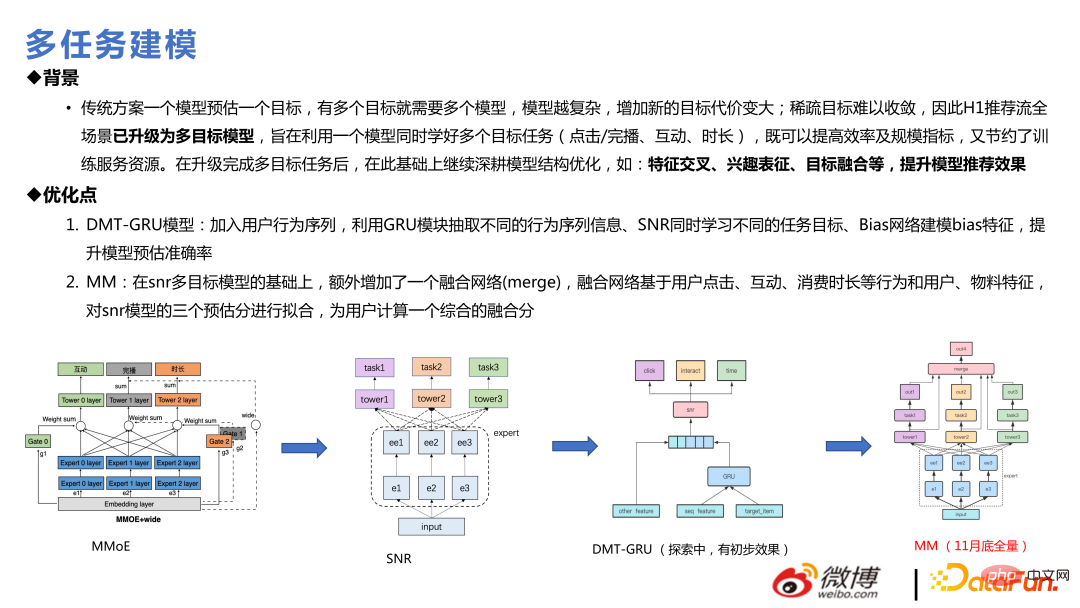

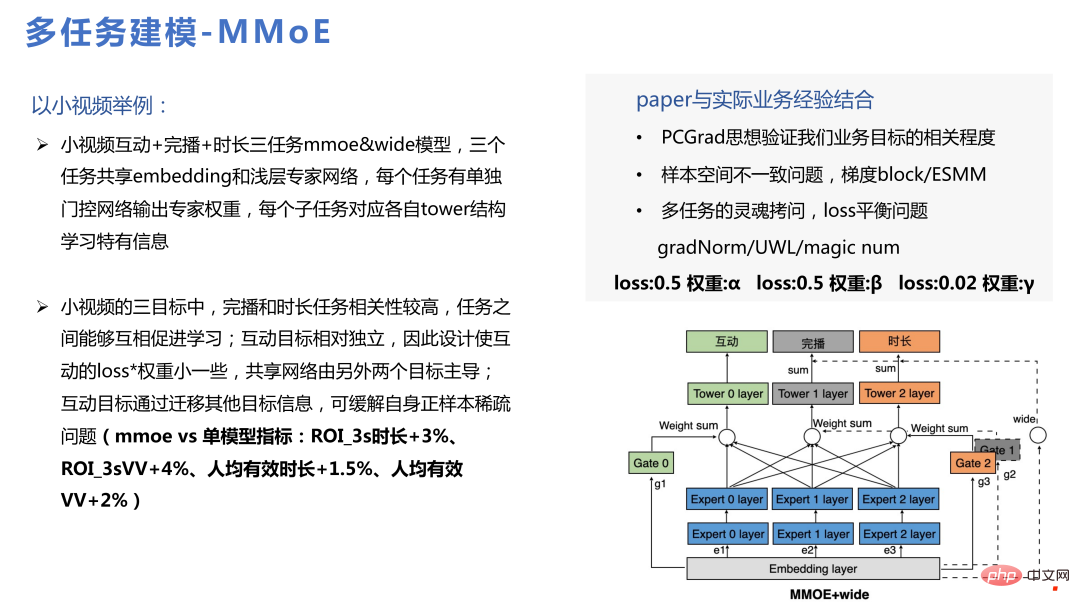

マルチタスク モデリングの入門として推奨されるのは、通常、MMOE、次に SNR、次に DMT、そして最後に全編です。 MM は実際にネットワークを統合するなどして SNR を最適化します。

#マルチタスクを実行する前に、解決すべき主な問題は次のとおりです。 複数のターゲット間さまざまな損失間の矛盾、相互にシーソー効果があるかどうか、一貫性のないサンプル空間の問題、損失バランスの問題など。実際の経験では、PCGrad 手法も UWL 手法もテスト データでは効果が現れますが、実稼働環境に拡張し、オンライン学習やトレーニングを継続すると、これらの手法の効果はより早く減衰します。オンラインインターンシップ環境全体で何らかの値を設定することは不可能ではありませんが、これがオンライン学習に関係しているのか、サンプルサイズに関係しているのかはわかりません。 MMOE 単独の効果も比較的良好です。左側には、ビジネスにおける実際の利益ポイントがいくつかあります。

#

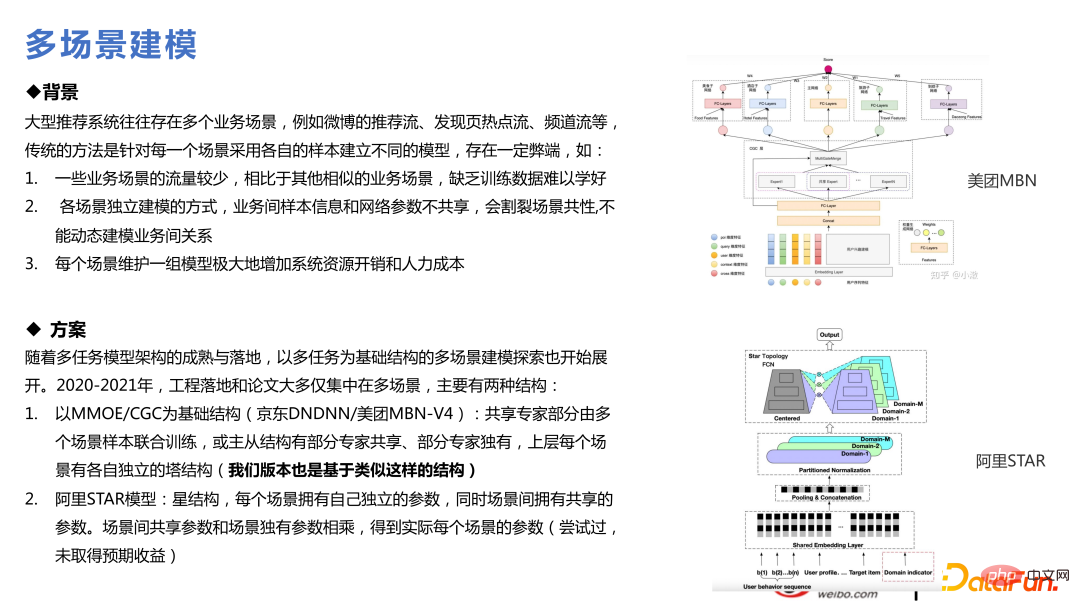

3. マルチシナリオ技術

#私たちは多くのレコメンデーションシナリオを担当しているため、何らかのマルチシナリオ技術の使用を考えるのは自然なことです。マルチタスクとは、いくつかのターゲットが比較的まばらであることを意味します。マルチシーンとは、シーンが大小さまざまであることを意味します。小さなシーンの収束は、データ量が不十分であるためにあまり良くありませんが、大きなシーンの収束はより優れています。 2 つのシーンがほぼ同じサイズの場合、真ん中にギャップが生じます。そのうちのいくつかは、ビジネスに利益をもたらす知識の伝達を伴います。これは最近の注目のトレンドでもあり、マルチタスクと多くの技術的類似点があります。

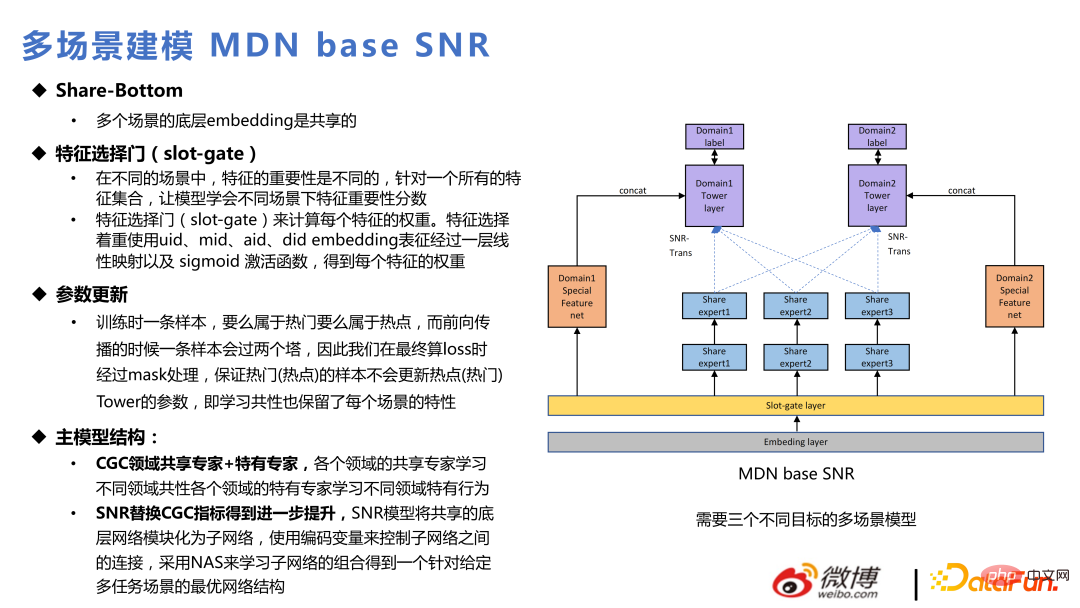

各マルチタスク モデルに基づいて、複数のシーン モデルを作成できます。 ## マルチタスク構造に関して、追加されるのは下図の Slot-gate 層で、同じ Embedding で Slot-gate を使用して、シナリオごとに異なる機能を表現します。 Slot-gate を介した出力は、エキスパート ネットワークへの接続、ターゲット タスクへの接続、または機能への接続の 3 つの部分に分割できます。

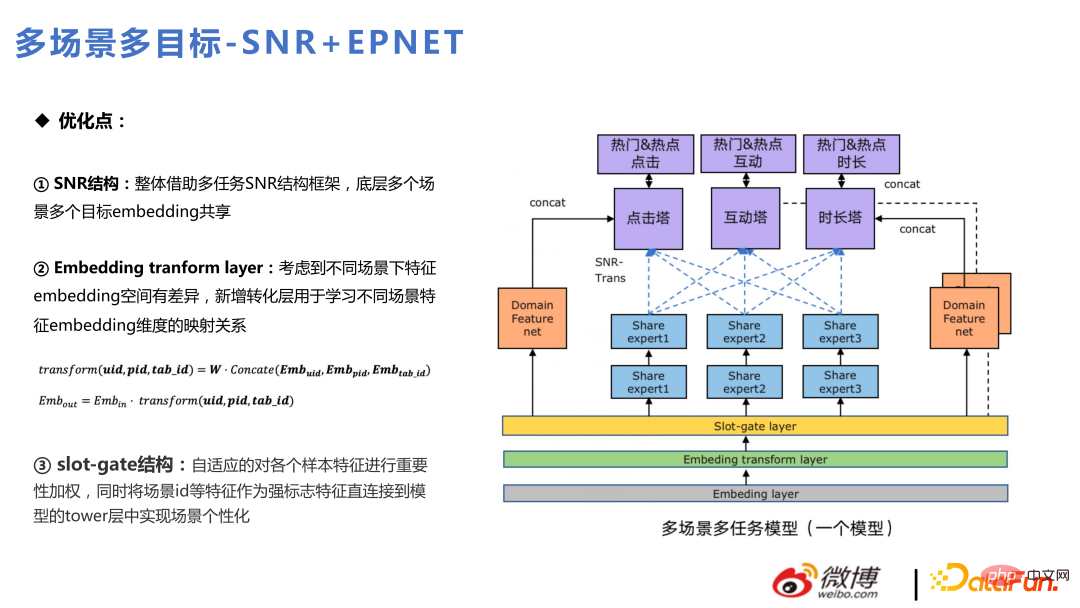

メイン モデルは、主に CGC の代わりに SNR を使用します。これは、マルチタスクの反復に沿ったものです。以下は、注目されているシナリオと人気のある 2 つの社内ビジネス シナリオに混在したマルチタスクとマルチ シナリオの現在のアプリケーションです。その中でも、ホームページの推奨は人気のストリームであり、ディスカバリー ページの推奨は注目のストリームです。

全体的な構造は SNR に似ており、クリック、インタラクション、継続時間という 3 つの目標タワーが上部にあります。これら 3 つのターゲット タワーは、2 つの人気スポットと注目のシーンに対応する 6 つのターゲットに分かれています。また、Slot-gate とは異なり、Slot-gate は特徴量の重要性を検出するのに対して、Embeding 変換層は、さまざまなシナリオでの埋め込み空間の違いを考慮して埋め込みマッピングを実行する層です。一部のフィーチャは 2 つのシーンで異なる次元を持ち、埋め込み変換レイヤーを通じて変換されます。

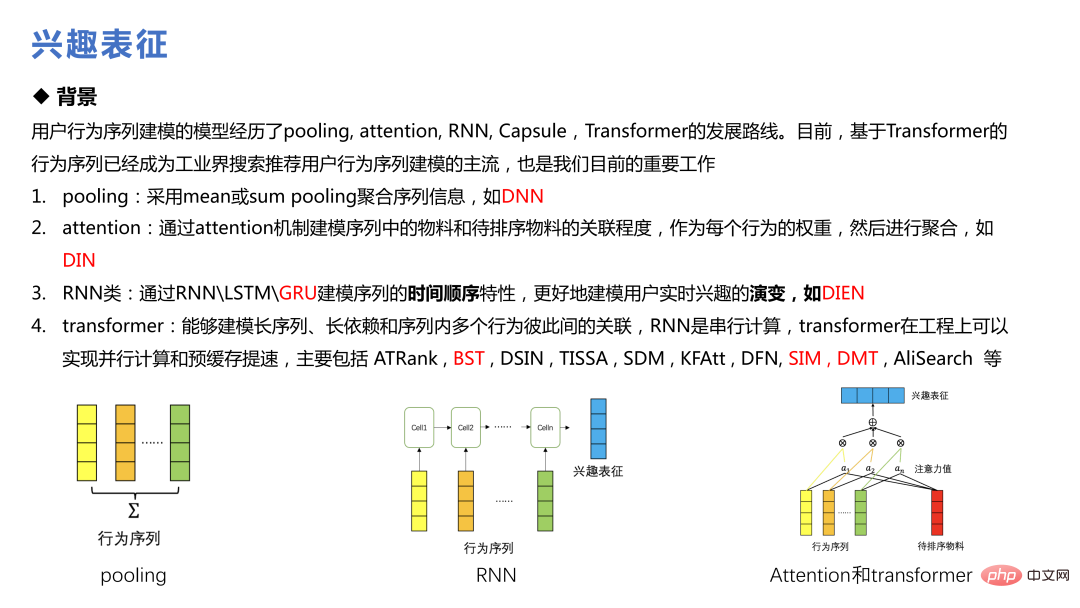

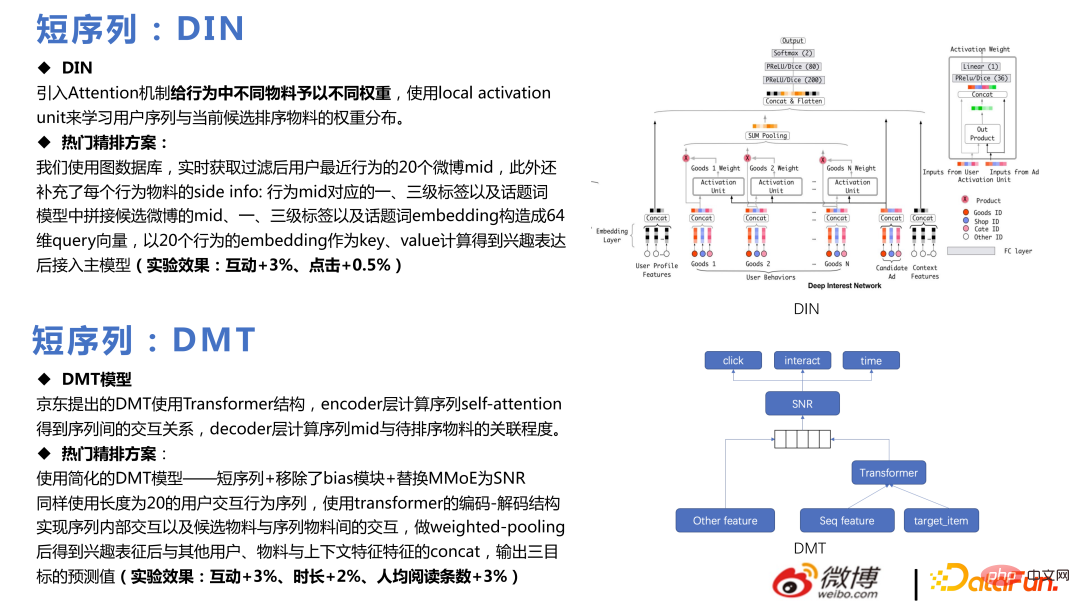

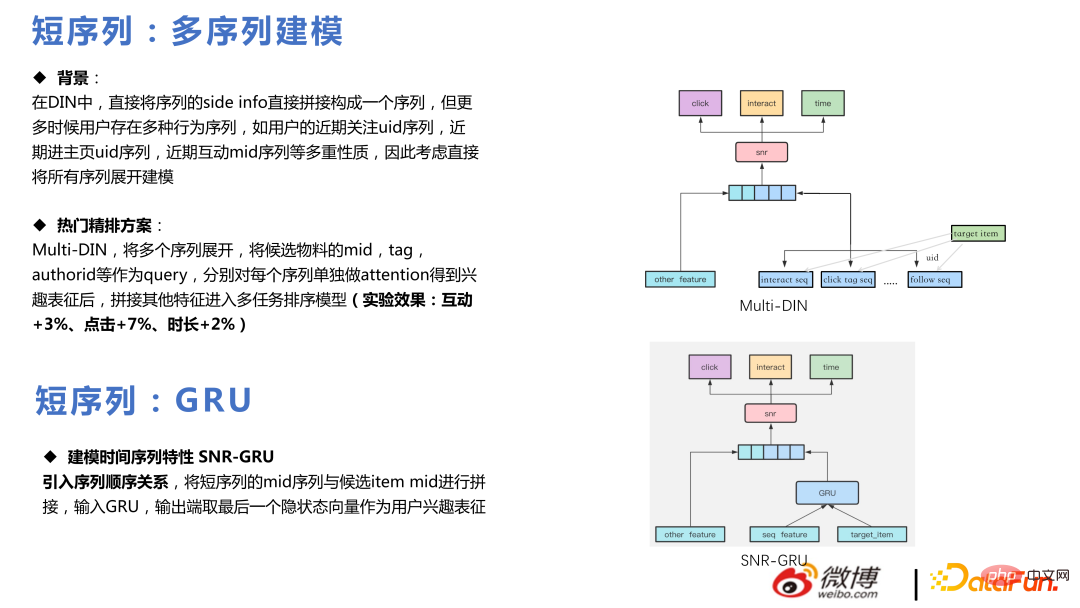

利益キャラクタリゼーションは近年よく話題になる技術で、アリババのDINからSIM、DMTに至るまで、業界におけるユーザー行動シーケンスモデリングの主流となっています。

DMT の核心は、マルチタスクで Transformer を使用することです。私たちのチームは、簡素化された DMT モデルを使用し、バイアス モジュールを削除し、MMoE を SNR に置き換えて、オンラインになりました。最終的に、一定のビジネス成果が達成されました。

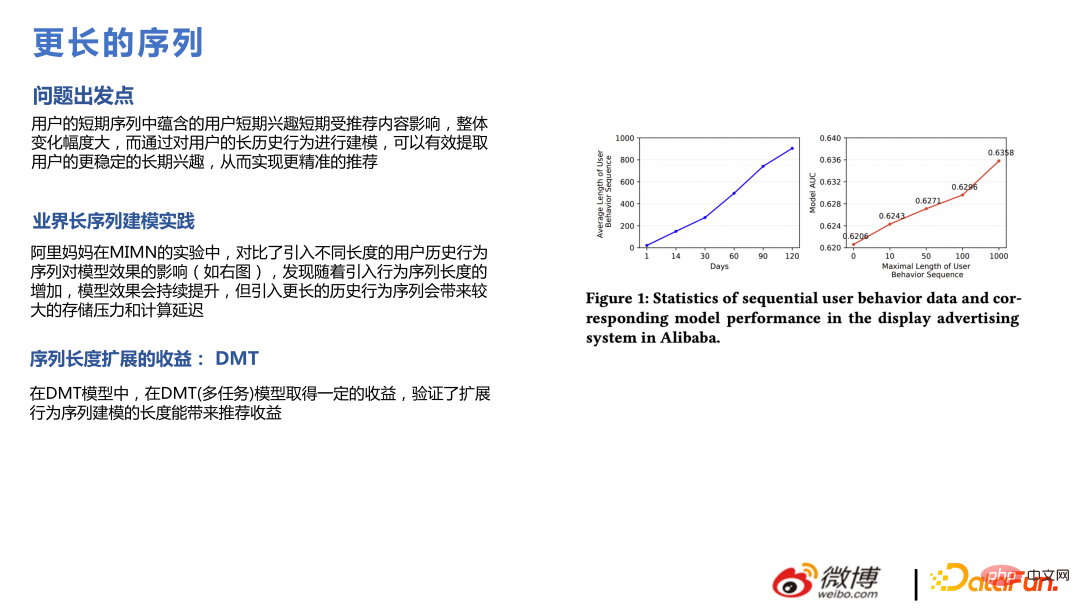

#同時に実験を行ったところ、クリックなどのシーケンスを長くできることがわかりました。 、持続時間、相互作用シーケンスなどを考慮すると、各シーケンスを 20 から 50 に拡張すると効果が向上します。これは論文の結論と一致しますが、シーケンスが長くなると、より多くの計算能力コストが必要になります。

#同時に実験を行ったところ、クリックなどのシーケンスを長くできることがわかりました。 、持続時間、相互作用シーケンスなどを考慮すると、各シーケンスを 20 から 50 に拡張すると効果が向上します。これは論文の結論と一致しますが、シーケンスが長くなると、より多くの計算能力コストが必要になります。

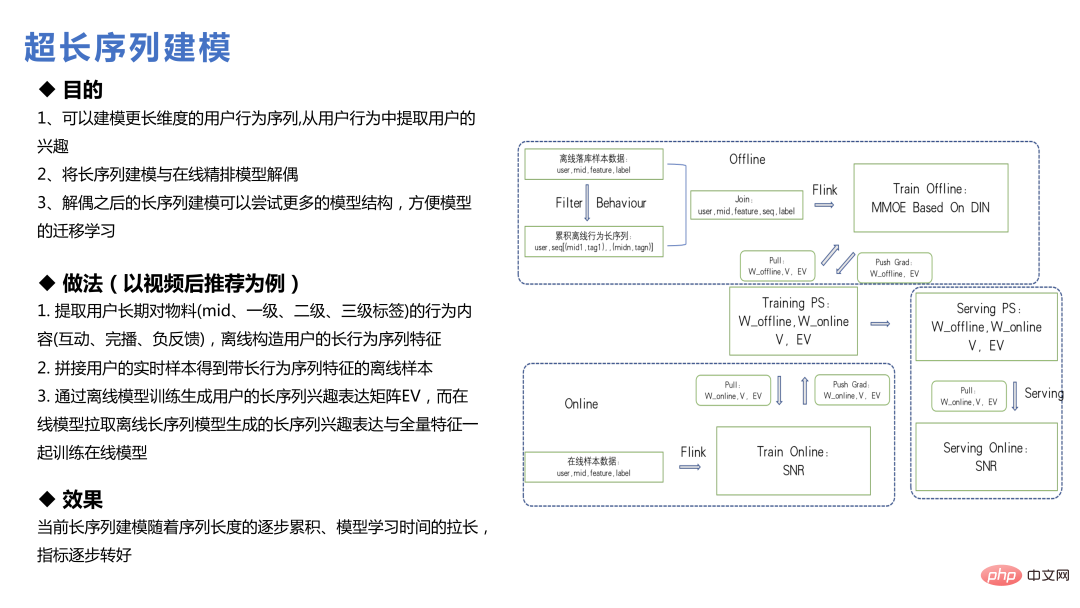

#ユーザー ライフ サイクルの超ロング シーケンス モデリングは、以前のロング シーケンス モデリングとは異なります。機能をリクエストしてデータを取得することはできません。ただし、ユーザーの長い行動シーケンスの特徴をオフラインで構築するか、いくつかの検索方法で対応する特徴を見つけて埋め込みを生成するか、メイン モデルと超長時間シーケンス モデルを別々にモデル化し、最終的に埋め込みを形成して送信します。メインモデルミドル。

Weibo ビジネスでは、超長いシーケンスの価値はそれほど高くありません。インターネット上では、ホットな検索など、誰もがすぐに注目を移すからです。 1 ~ 2 日で徐々に消えていき、情報の流れの中で 7 日前のコンテンツが配信されることは少なくなります。したがって、ユーザーの行動シーケンスが長すぎると、そのアイテムに対するユーザーの推定嗜好値がある程度弱まってしまいます。しかし、頻度の低いユーザーやリピーターの場合、この結論はある程度異なります。

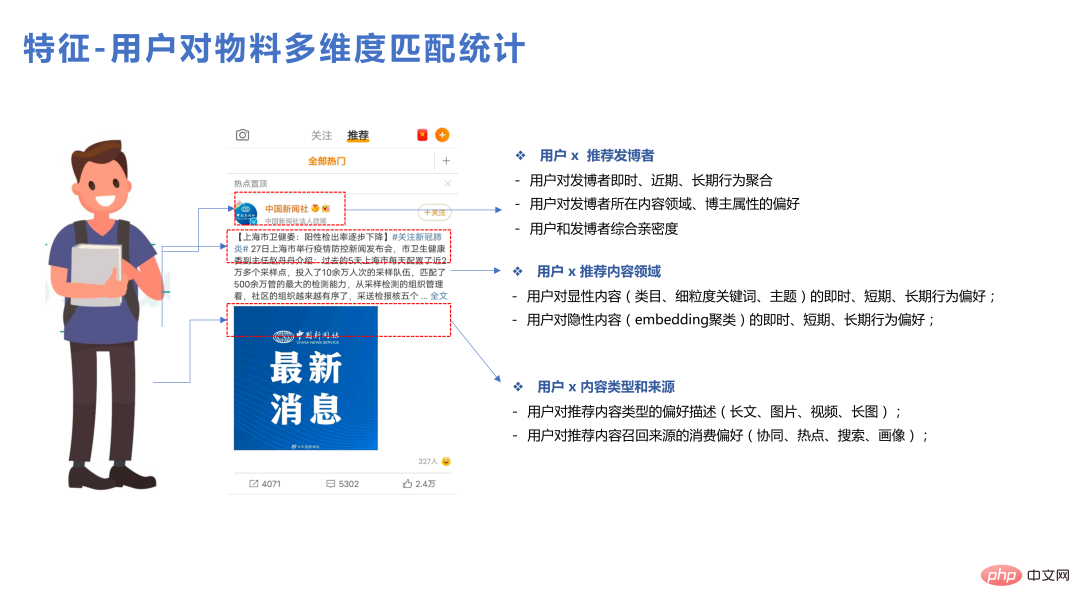

特大サイズを使用する大規模なモデルには、機能レベルでもいくつかの問題が発生します。例えば、理論的にはモデルに役立つと思われる機能があったとしても、追加した後の効果が期待どおりにならない、これもレコメンドビジネスが直面する現実です。モデルの規模が非常に大きいため、多くの ID クラス情報がモデルに追加されており、既にユーザーの好みを適切に表現していますが、この時点でいくつかの統計機能を追加するのはそれほど簡単ではない可能性があります。このチームについて話しましょう 実践で比較的使いやすい機能。

第一に、マッチング機能の効果は比較的良好です。ユーザーは、単一のマテリアル、単一のコンテンツ タイプ、およびシングルブロガー。いくつかのメリットをもたらす可能性があります。

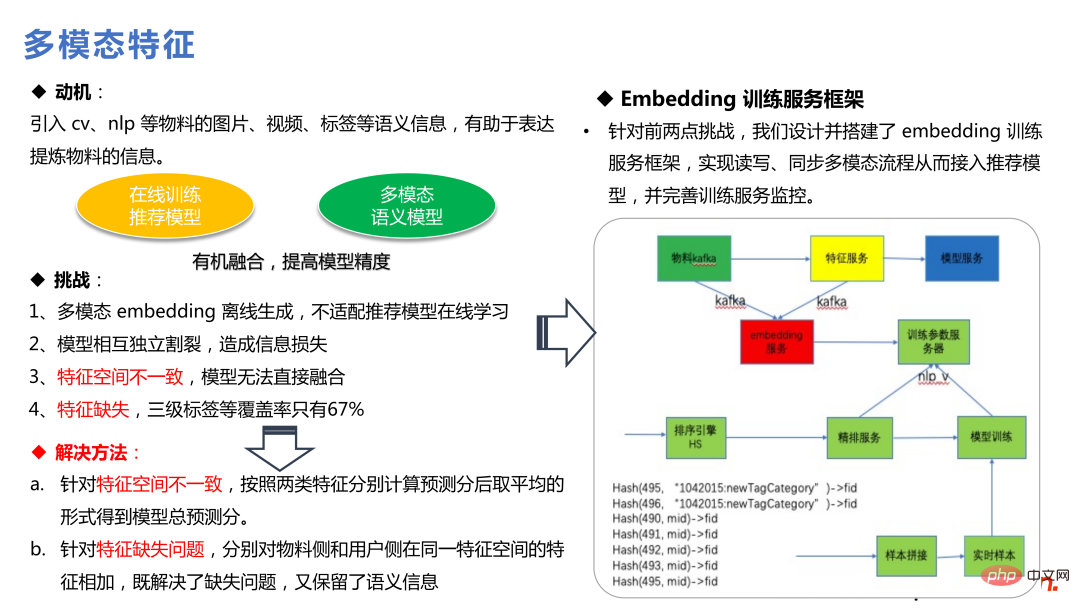

さらに、レコメンデーション モデル全体がユーザーの行動に基づいているため、マルチモーダル機能もより価値があります。システム全体でアイテムユーザーの行動が不十分である場合、より多くの事前知識を導入することで、より多くの効果が得られる可能性があります。マルチモダリティでは、NLP およびその他のテクノロジの導入を通じて一連のセマンティクスが導入され、低頻度とコールド スタートの両方に役立ちます。

さらに、レコメンデーション モデル全体がユーザーの行動に基づいているため、マルチモーダル機能もより価値があります。システム全体でアイテムユーザーの行動が不十分である場合、より多くの事前知識を導入することで、より多くの効果が得られる可能性があります。マルチモダリティでは、NLP およびその他のテクノロジの導入を通じて一連のセマンティクスが導入され、低頻度とコールド スタートの両方に役立ちます。

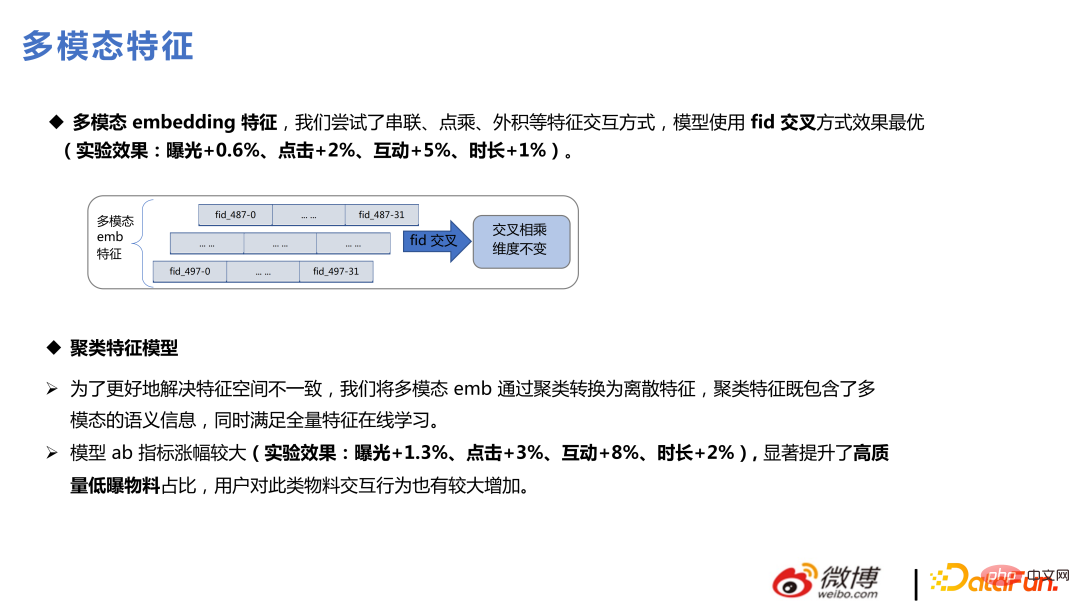

このチームは、マルチモーダル機能を導入するために 2 種類の方法を実行しました。1 つ目のタイプは、マルチモーダル埋め込みをレコメンデーション モデルに統合し、これらの埋め込みの勾配を下部で固定してから、上位の MLP Update、もう 1 つの方法は、推奨モデルに入る前にマルチモダリティを使用してクラスタリングを実行し、クラスター ID を推奨モデルに投げ込んでトレーニングすることです。これは、推奨モデルに情報を導入する簡単な方法ですが、一部のマルチ-モーダル固有のセマンティック情報も失われます。

私たちのビジネスでは上記 2 つの方法の多くを試してきました。最初の方法はモデルの複雑さが増し、多くの空間変換、特徴の重要性の検出などが必要になりますが、良い利点をもたらすことができます。 ; 2 番目の方法はクラスター ID を使用して学習し、複雑さはモデルの範囲外で、オンライン サービスは比較的単純で、効果は約 90% に達し、クラスター ID の統計を行うこともできます。 性的特徴を組み合わせると、大きな効果が得られます。

マルチモーダル機能を追加した後の最大のメリットは、高品質で低露出のマテリアルを使用できることです。コールドスタートの問題の質問です。露出が比較的少なく、モデルが完全に学習できないマテリアルを推奨することは、より多くの情報をもたらすためにマルチモーダル ボディに大きく依存することになり、これはビジネス エコロジーにとってもプラスの価値があります。

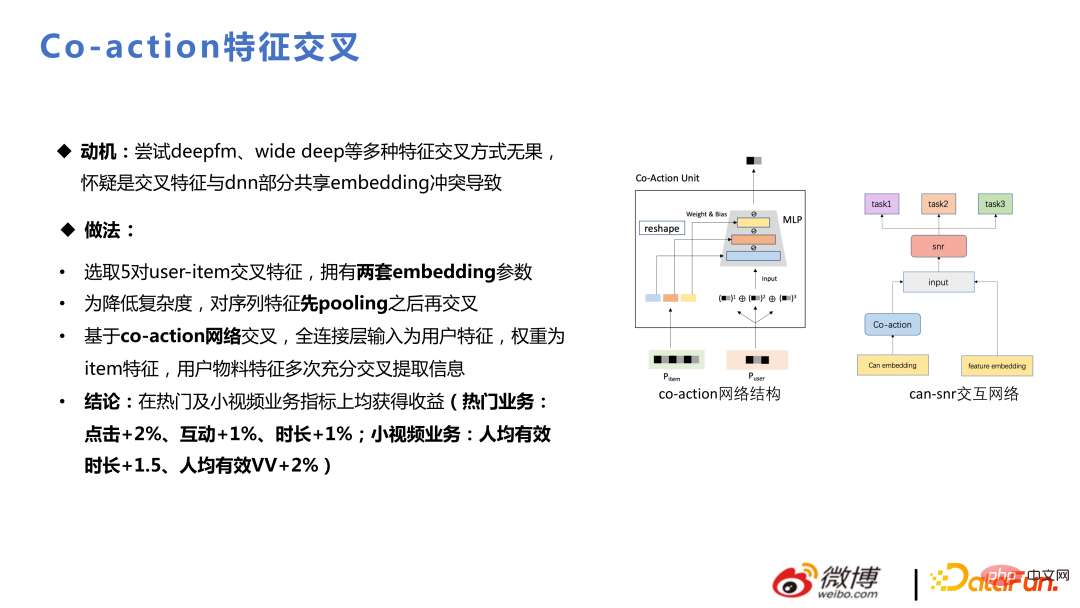

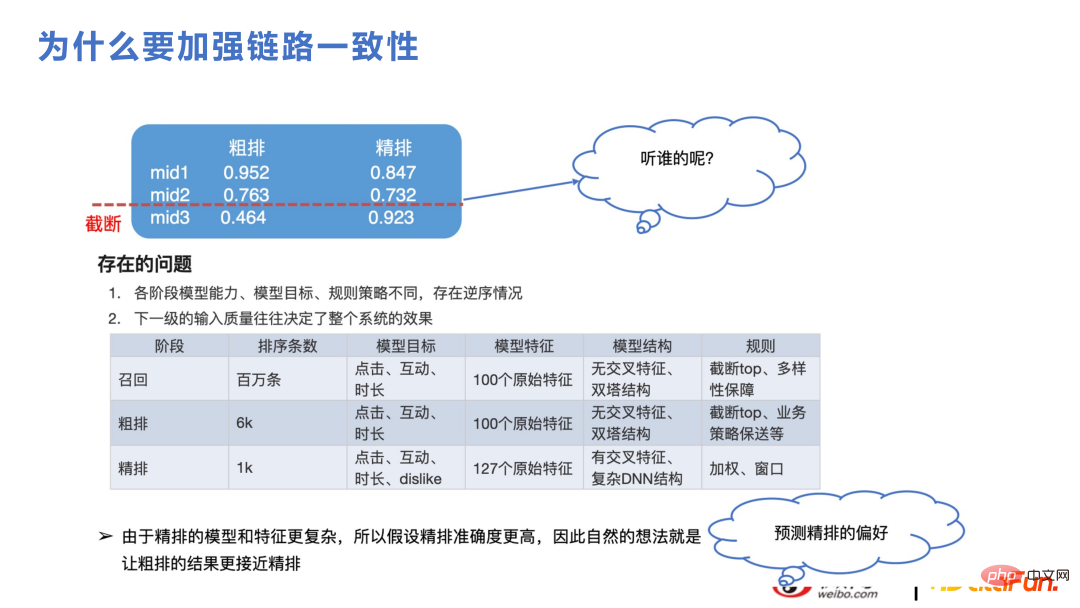

Co-action の動機は、deepfm、wide deep、およびその他の機能の交差を試すことです。この方法は効果がなく、クロス機能と DNN 部分共有埋め込みの間の競合が原因であると考えられます。コアクションは、ストレージを追加し、クロスオーバー用に別のストレージスペースを開くことに相当し、表現スペースが増加し、ビジネスでも大きな利益をもたらします。 この部分は、大まかな並べ替えと再現について説明します。レコメンデーション ビジネスの場合、数百万の候補セットを細かく分類するのにコンピューティング能力が対応できず、リコール、大まかな分類、詳細な分類に分かれていますが、ロジックは同じ問題です。例えば、下図のように、大まかな分類が切り捨てられ、最終的な細分類の内容は1,000件程度しかありませんが、大まかな分類と細分類の表現が大きく異なる場合は、細分類のスコアが高くなる可能性があります。将来、切り捨てプロセス中にコンテンツが切り捨てられます。ファインソートとラフソートでは特徴やモデル構造が異なる ラフソートは一般にベクトル検索の近似構造であるリコールフレームワークに似ている 特徴は後からクロスオーバーし、ファインソートとの差異を表現するのは自然であるモデル。一貫性が向上すれば、双方が同じ変化傾向を捉えることができるため、ビジネス指標も向上します。

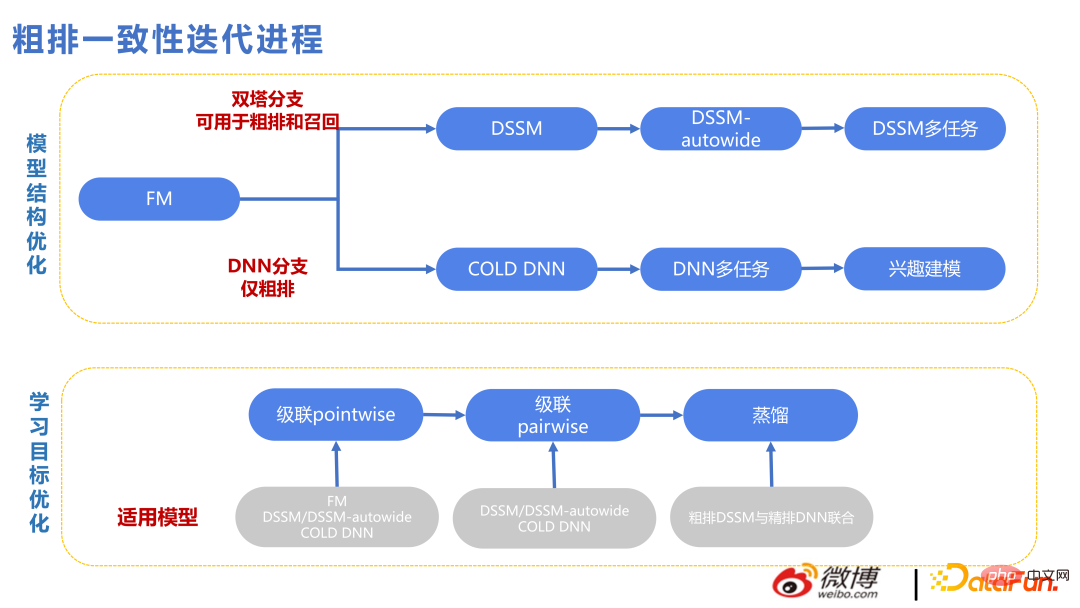

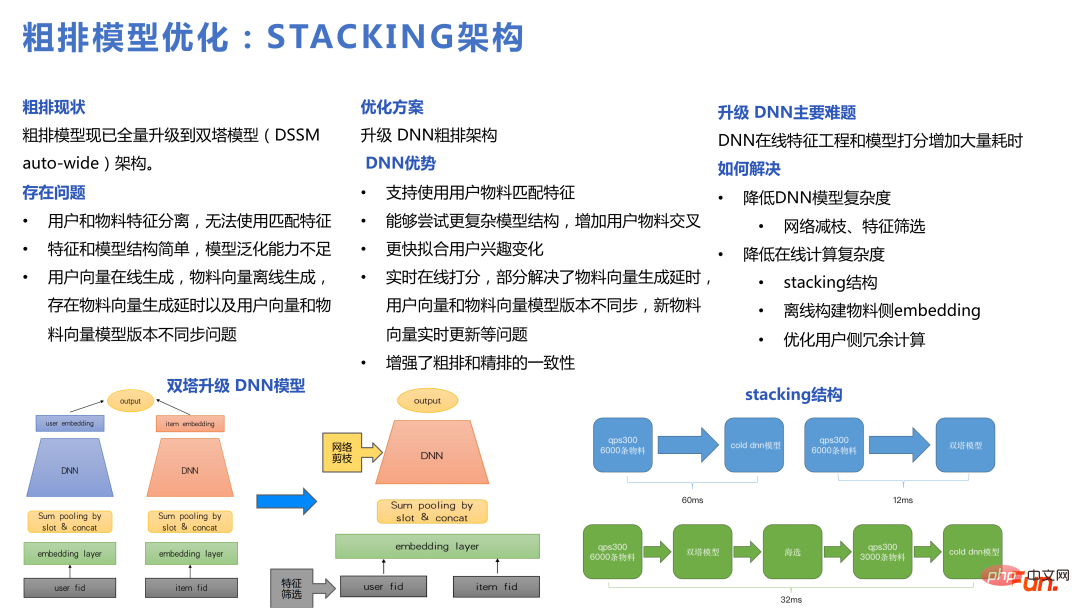

3. リンク式の一貫性

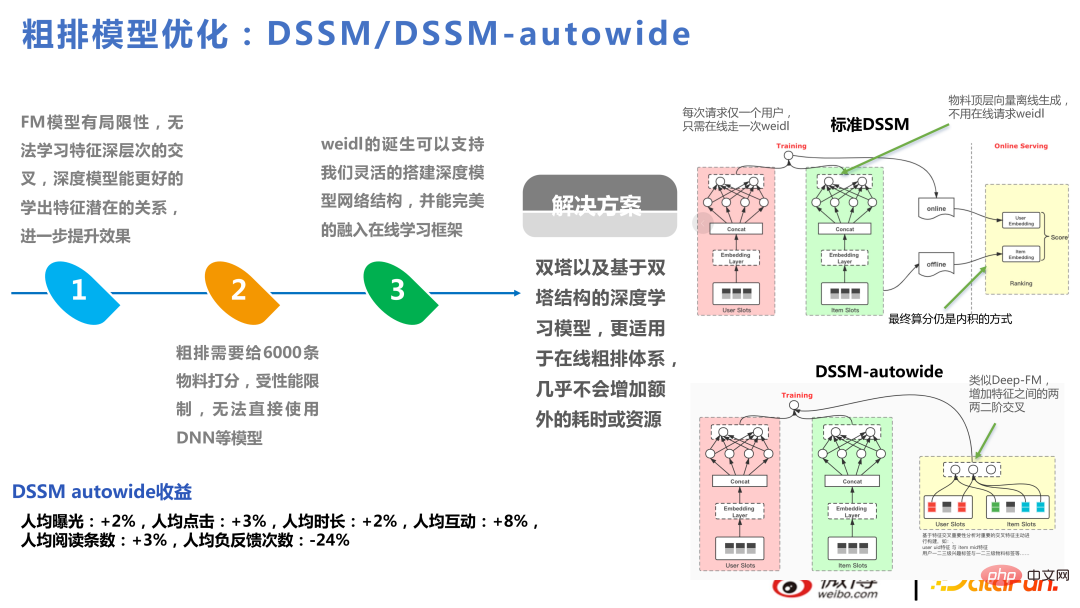

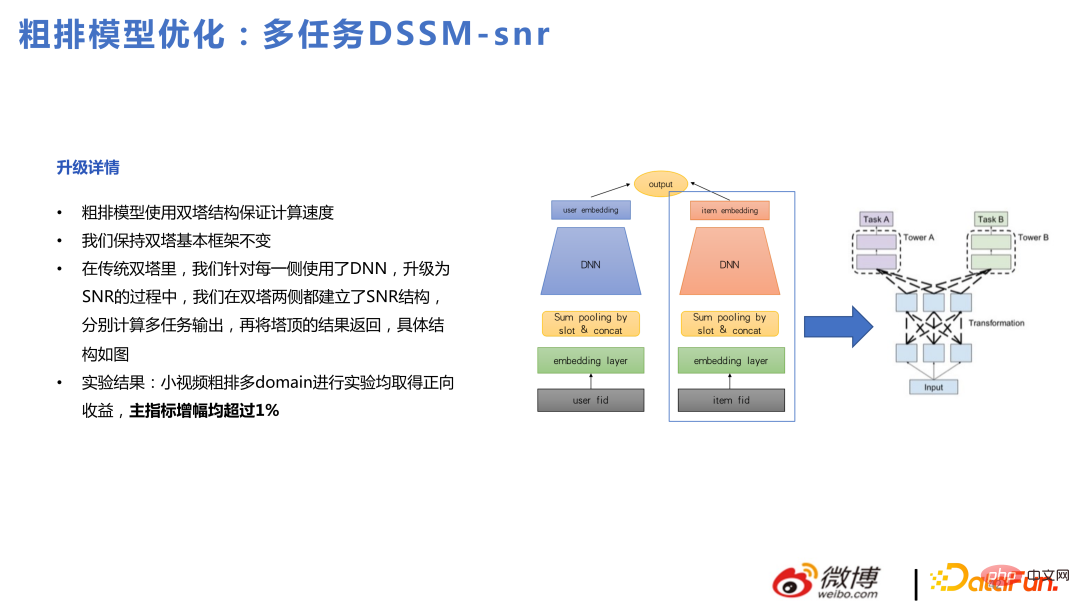

#次の図は、大まかな一貫性の反復プロセスの技術的コンテキストを示しています。 Twin Towers のテクニカル ライン、以下は DNN のテクニカル ラインです。ツイン タワーのフィーチャは比較的遅く相互作用するため、ツイン タワーのフィーチャが交差する多くの方法が追加されました。ただし、ベクトル検索法の上限は少し低すぎるため、2022 年からは大まかなソートのための DNN ブランチが設けられ、特徴スクリーニング、ネットワークの枝刈り、パフォーマンスの最適化などのエンジニアリング アーキテクチャに大きな負担がかかることになります。 , など、一度に得点できるアイテム数も以前より減りますが、スコアは良くなっているので、アイテム数が少なくても問題ありません。

DSSM-autowide は、Twin Towers をベースにした Deep-FM に似たクロスオーバーです。はビジネス指標の増加でしたが、新しいクロスオーバー手法を使用した次のプロジェクトでは、改善はそれほど顕著ではありませんでした。

したがって、ツインタワーによって得られるメリットは比較的大きいと考えています。限定。ツインタワーに基づいた大まかなマルチタスクモデルも試しましたが、それでもツインタワーの問題を回避できませんでした。

上記の問題に基づいて、この チームは DNN とレベルを使用して大まかなモデルを最適化しました。ジョイント モデルはスタッキング アーキテクチャです。

カスケード モデルは、最初にツイン タワーでフィルタリングし、次にフィルタリングして DNN モデルに切り詰めて大まかな並べ替えを行うことができます。これは、大まかな並べ替えと大まかな内部での細かい並べ替えを行うのと同じです。ソート、行。 DNN モデルに切り替えた後は、より複雑な構造をサポートし、ユーザーの関心の変化により迅速に適応できるようになります。

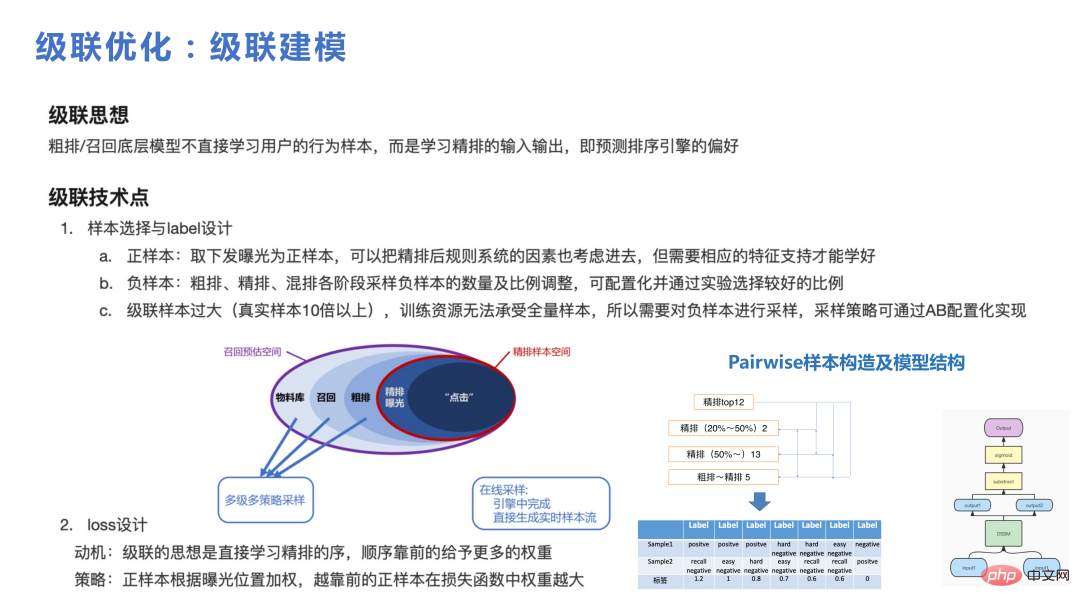

カスケードはフレームワーク内で重要な役割を果たします。カスケード モデルがなければ、小規模な候補を追跡することは困難です。セットは、ラフ DNN で使用されるより大きな候補セットから選択されます。カスケードでより重要なのは、サンプルをどのように構築するかです (以下の図を参照)。 100 万レベルの素材ライブラリから、1,000 件以内の数千件の大まかな分類と詳細な分類の素材を呼び出します。最終的には約 20 件のアイテムが公開され、ユーザーのアクション数は 1 桁でした。全体のプロセスは、大規模なものから始まりました。ライブラリをユーザーに提供し、行動ファネルプロセスを提供します。カスケードを実行するときの重要な点は、カスケード モデルから学習するために、各部分をサンプリングして、いくつかの難しいペアと比較的単純なペアを形成する必要があるということです。

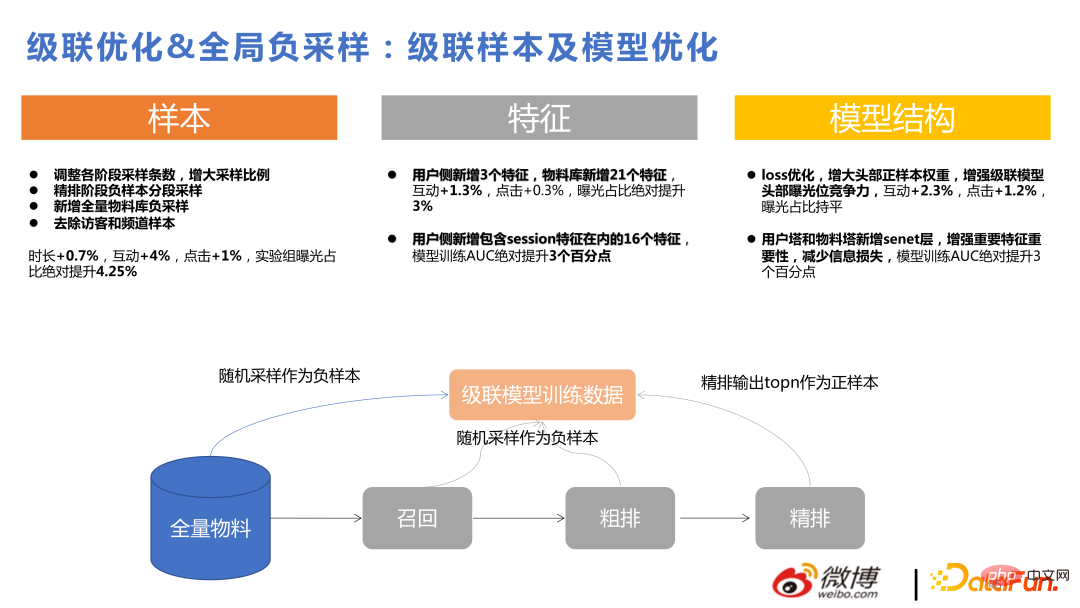

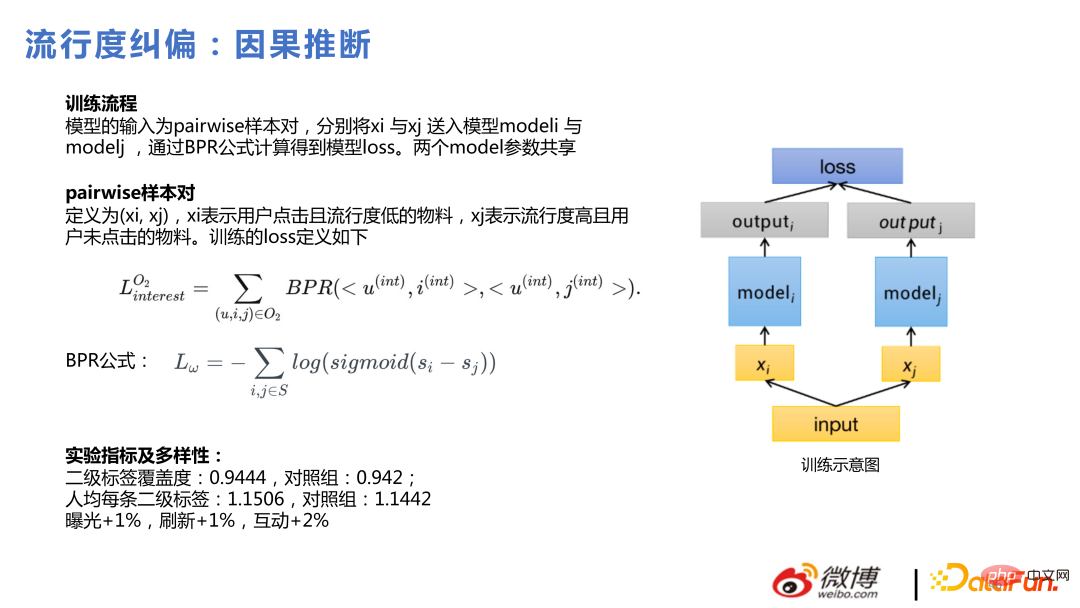

次の図は、カスケード最適化とグローバル ネガティブ サンプリングによってもたらされる利点を示しています。詳しい紹介。 # 次に、最近流行りの因果推論を紹介します。 因果推論を使用する動機は、誰もが好むものをプッシュすれば、ユーザーのクリック効果は良いだろうということですが、ユーザー自身の効果もいくつかあります。これらのニッチな素材をユーザーに推奨すると、ユーザーからも好まれます。この 2 つはユーザーにとっては同じですが、プラットフォームにとっては導入できるニッチなものほどパーソナライズされており、最初のタイプはモデルによって導出されやすいため、この問題を解決するのが因果推論です。 。 具体的な方法は、ユーザーがクリックするが人気が低い素材と、人気が高いがクリックされない素材をペアごとにグループ化することです。ユーザーは、損失モデルのトレーニングにベイジアン法を使用します。 #私たちの実践では、詳細な並べ替えよりも、大まかな並べ替えとリコールの段階で因果推論を行う方がメリットが得られやすいです。その理由は、ファインランキングモデルは比較的複雑であるためです。ファインランキングはすでに優れたパーソナライゼーション機能を備えています。しかし、ラフランキングとリコールはDNNを使用しても、それらもトリミングされたDNNです。モデル全体のパーソナライゼーション能力にはまだギャップがあります。 . パーソナライゼーション能力は比較的低いため、パーソナライゼーション能力が強い場所で因果推論を使用する場合よりも、因果推論を使用した場合の効果は明らかに明白です。

#4. その他の技術的なポイント

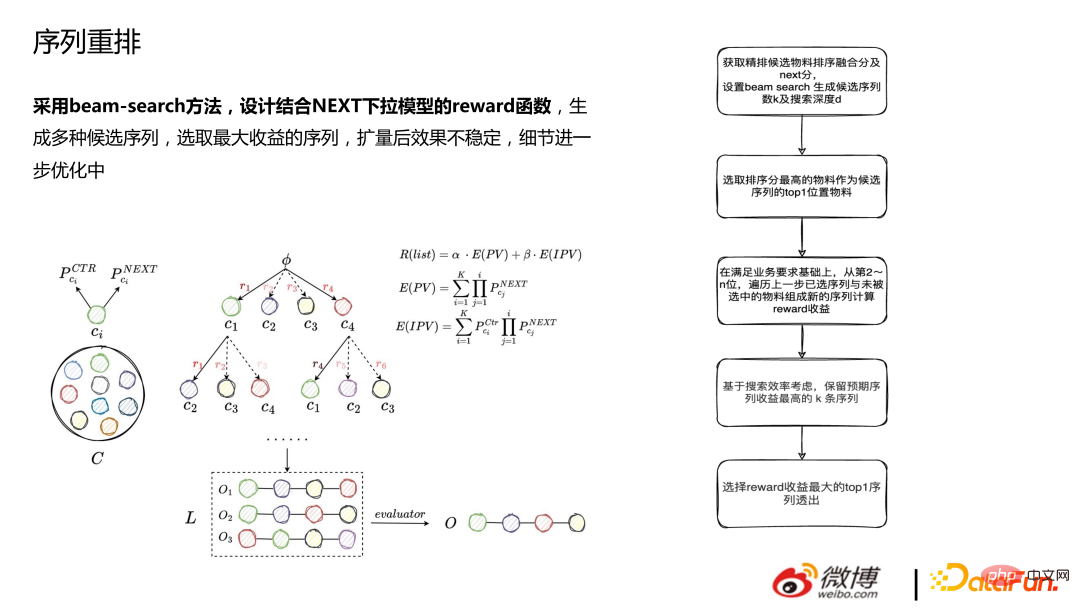

1. シーケンス再配置

再配置では、ビームサーチ法を使用し、NEXT ドロップダウン モデルと組み合わせた報酬関数を設計し、さまざまな候補シーケンスを生成し、最も大きいシーケンスを選択します。利益、拡大後 効果が不安定で詳細最適化中。

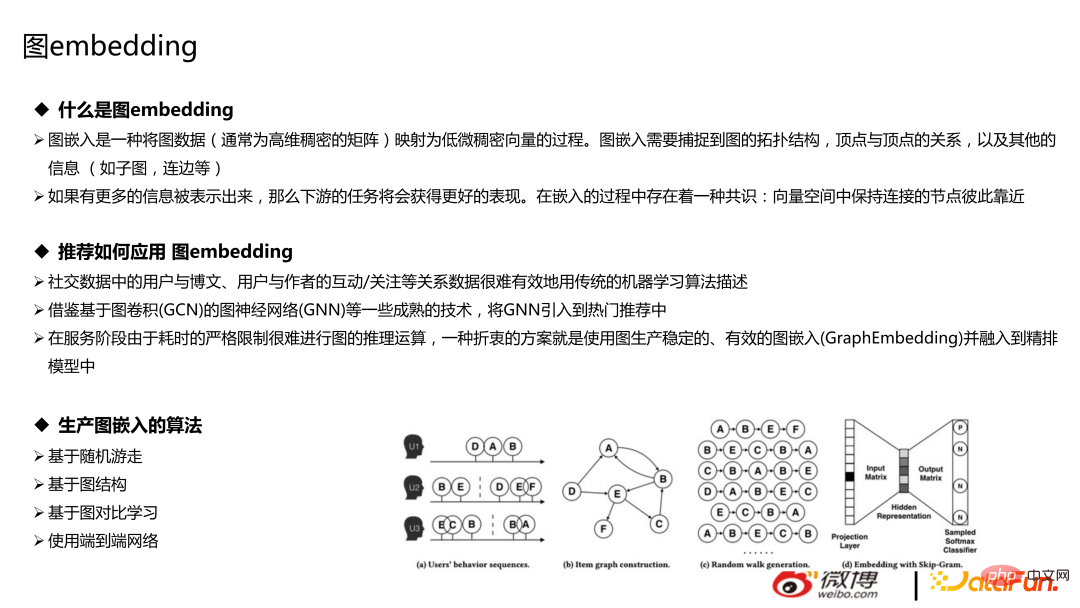

Graph テクノロジーは主に、グラフ データベースとグラフの埋め込みの 2 つの部分で構成されます。レコメンデーションには、グラフ データベースを使用する方が便利で安価です。グラフの埋め込みとは、グラフ データ (通常は高次元の密行列) を低次元の密ベクトルにマッピングする、ウォーキング クラスのノードのランダム ウォーキングのプロセスを指します。グラフの埋め込みでは、グラフのトポロジー構造、頂点間の関係、その他の情報 (サブグラフ、エッジなど) をキャプチャする必要がありますが、ここでは紹介しません。

ランダム ウォーク、グラフ構造、グラフ コントラスト学習、その他のアルゴリズムに基づくアルゴリズムを、ユーザーに推奨するために使用できます。およびブログ投稿、ユーザーと作成者間のやり取り/注意の想起。画像やテキスト、ユーザーなどを埋め込み、モデルに特徴を追加する手法が主流ですが、エンドツーエンドのネットワークを直接構築したり、レコメンデーションにGNNを利用したりするなど、最先端の試みもいくつかあります。

ランダム ウォーク、グラフ構造、グラフ コントラスト学習、その他のアルゴリズムに基づくアルゴリズムを、ユーザーに推奨するために使用できます。およびブログ投稿、ユーザーと作成者間のやり取り/注意の想起。画像やテキスト、ユーザーなどを埋め込み、モデルに特徴を追加する手法が主流ですが、エンドツーエンドのネットワークを直接構築したり、レコメンデーションにGNNを利用したりするなど、最先端の試みもいくつかあります。

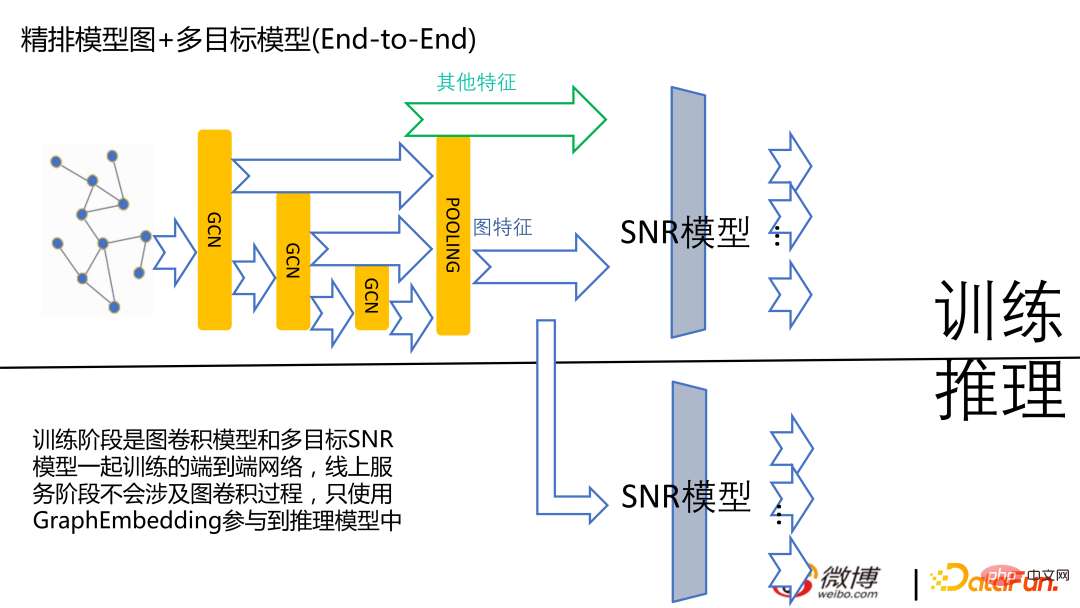

#下の図は、現在のエンドツーエンド モデルです。まだ試しています。オンラインの主流バージョンはありません。

#下の図は、現在のエンドツーエンド モデルです。まだ試しています。オンラインの主流バージョンはありません。

#次の図は、埋め込みを生成するグラフ ネットワークに基づいています。右は、アカウントのドメインに基づいて計算された類似度です。 Weibo の場合、注目の関係に基づいて埋め込みを計算することが有益です。

5. 質疑応答

Q1: おすすめ情報フローには項目がたくさんありますが、クリックせずに閲覧するだけです。ない?リストページ上のアイテムの滞留時間を通じて?

#A1: はい、情報フロー ビジネスに関しては、期間の方がより重要な最適化指標です。現在、継続時間最適化インジケーターを使用する場合、ユーザーがアプリ全体に滞在する時間を直接最適化するのは不便ですが、より最適化されるのはアイテムに滞在する時間です。期間を最適化の目標としてみなさない場合、浅い消費コンテンツを多く宣伝することが容易になります。

#Q2: トレーニング中にフェイルオーバーが発生した場合、モデルのリアルタイム更新で一貫性の問題が発生しますか?モデルの一貫性の問題にどう対処するか?

A2: 現在、推奨される学習とトレーニングは、CPU であれば非同期のものが多く、グローバル ラウンドなどを行う傾向はありません。ラウンド終了後、まとめてPS上で更新して次のラウンドを開始するのですが、パフォーマンスの問題で基本的にはやりません。リアルタイム学習であろうとオンライン学習であろうと、強い一貫性は達成できません。

トレーニング中にフェイルオーバーが発生した場合、ストリーミング トレーニングを実行している場合は、kafka や flink などのデータ ストリームに記録されます。現在のトレーニングを記録する プランがどこでトレーニングされたとしても、PS には最後のトレーニングの記録も記録されます。これは世界的な差異と同様です。

#Q3: 再現に細かい並べ替え順序を使用すると、再現モデルの反復制限が低くなりますか?

A3: 反復の上限は再現率の上限として理解できます。すると、再現率の上限は厳密なランキングを超えてはいけないことがわかります。たとえば、現在のコンピューティング能力が無限である場合、細かい並べ替えを使用して 500 万のマテリアルをスコアリングすることが、ビジネスを処理する最良の方法です。リコールへの投資がそれほど大きくない場合は、リコールの 6,000 件の中から上位 15 件を選択し、500 万件の中から上位 15 件を選択させるなど、細かい選択の中で最良の部分を見つけてもらうようにしてください。比較的近いですが、リコール モジュールの方が適切に機能します。全員がこれを理解していれば、細かい並べ替えの順序を思い出しても、オンラインでの反復回数は減りませんが、上限に近づくことになります。ただし、これは当社の見解でもあり、お客様自身のビジネスの方向性によっては、この結論が普遍的に適用できるとは限りません。

以上がWeibo推奨リアルタイム大型モデルの技術進化の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7478

7478

15

15

1377

1377

52

52

77

77

11

11

19

19

33

33

ビッグモデルアプリ Tencent Yuanbao がオンラインになりました! Hunyuan がアップグレードされ、どこにでも持ち運べるオールラウンドな AI アシスタントが作成されました

Jun 09, 2024 pm 10:38 PM

ビッグモデルアプリ Tencent Yuanbao がオンラインになりました! Hunyuan がアップグレードされ、どこにでも持ち運べるオールラウンドな AI アシスタントが作成されました

Jun 09, 2024 pm 10:38 PM

5月30日、TencentはHunyuanモデルの包括的なアップグレードを発表し、Hunyuanモデルに基づくアプリ「Tencent Yuanbao」が正式にリリースされ、AppleおよびAndroidアプリストアからダウンロードできるようになりました。前のテスト段階のフンユアン アプレット バージョンと比較して、Tencent Yuanbao は、日常生活シナリオ向けの AI 検索、AI サマリー、AI ライティングなどのコア機能を提供し、Yuanbao のゲームプレイもより豊富で、複数の機能を提供します。 、パーソナルエージェントの作成などの新しいゲームプレイ方法が追加されます。 Tencent Cloud 副社長で Tencent Hunyuan 大型モデルの責任者である Liu Yuhong 氏は、「テンセントは、最初に大型モデルを開発しようとはしません。」と述べました。 Tencent Hunyuan の大型モデルは、ビジネス シナリオにおける豊富で大規模なポーランド テクノロジーを活用しながら、ユーザーの真のニーズを洞察します。

Bytedance Beanbao 大型モデルがリリース、Volcano Engine フルスタック AI サービスが企業のインテリジェントな変革を支援

Jun 05, 2024 pm 07:59 PM

Bytedance Beanbao 大型モデルがリリース、Volcano Engine フルスタック AI サービスが企業のインテリジェントな変革を支援

Jun 05, 2024 pm 07:59 PM

Volcano Engine の社長である Tan Dai 氏は、大規模モデルを実装したい企業は、モデルの有効性、推論コスト、実装の難易度という 3 つの重要な課題に直面していると述べました。複雑な問題を解決するためのサポートとして、適切な基本的な大規模モデルが必要です。また、サービスは低コストの推論を備えているため、大規模なモデルを広く使用できるようになり、企業がシナリオを実装できるようにするためには、より多くのツール、プラットフォーム、アプリケーションが必要になります。 ——Huoshan Engine 01 社長、Tan Dai 氏。大きなビーンバッグ モデルがデビューし、頻繁に使用されています。モデル効果を磨き上げることは、AI の実装における最も重要な課題です。 Tan Dai 氏は、良いモデルは大量に使用することでのみ磨かれると指摘しました。現在、Doubao モデルは毎日 1,200 億トークンのテキストを処理し、3,000 万枚の画像を生成しています。企業による大規模モデルシナリオの実装を支援するために、バイトダンスが独自に開発した豆包大規模モデルが火山を通じて打ち上げられます。

この記事では、SHAP: 機械学習のモデルの説明について説明します。

Jun 01, 2024 am 10:58 AM

この記事では、SHAP: 機械学習のモデルの説明について説明します。

Jun 01, 2024 am 10:58 AM

機械学習とデータ サイエンスの分野では、モデルの解釈可能性が常に研究者や実務家に焦点を当ててきました。深層学習やアンサンブル手法などの複雑なモデルが広く適用されるようになったことで、モデルの意思決定プロセスを理解することが特に重要になってきました。 Explainable AI|XAI は、モデルの透明性を高めることで、機械学習モデルに対する信頼と自信を構築するのに役立ちます。モデルの透明性の向上は、複数の複雑なモデルの普及や、モデルを説明するための意思決定プロセスなどの方法によって実現できます。これらの方法には、特徴重要度分析、モデル予測間隔推定、ローカル解釈可能性アルゴリズムなどが含まれます。特徴重要度分析では、入力特徴に対するモデルの影響度を評価することで、モデルの意思決定プロセスを説明できます。モデルの予測間隔の推定

C++ での機械学習アルゴリズムの実装: 一般的な課題と解決策

Jun 03, 2024 pm 01:25 PM

C++ での機械学習アルゴリズムの実装: 一般的な課題と解決策

Jun 03, 2024 pm 01:25 PM

C++ の機械学習アルゴリズムが直面する一般的な課題には、メモリ管理、マルチスレッド、パフォーマンスの最適化、保守性などがあります。解決策には、スマート ポインター、最新のスレッド ライブラリ、SIMD 命令、サードパーティ ライブラリの使用、コーディング スタイル ガイドラインの遵守、自動化ツールの使用が含まれます。実践的な事例では、Eigen ライブラリを使用して線形回帰アルゴリズムを実装し、メモリを効果的に管理し、高性能の行列演算を使用する方法を示します。

産業ナレッジグラフの高度な実践

Jun 13, 2024 am 11:59 AM

産業ナレッジグラフの高度な実践

Jun 13, 2024 am 11:59 AM

1. 背景の紹介 まず、Yunwen Technology の開発の歴史を紹介します。 Yunwen Technology Company ...2023 年は大規模モデルが普及する時期であり、多くの企業は大規模モデルの後、グラフの重要性が大幅に低下し、以前に検討されたプリセット情報システムはもはや重要ではないと考えています。しかし、RAG の推進とデータ ガバナンスの普及により、より効率的なデータ ガバナンスと高品質のデータが民営化された大規模モデルの有効性を向上させるための重要な前提条件であることがわかり、ますます多くの企業が注目し始めています。知識構築関連コンテンツへ。これにより、知識の構築と処理がより高いレベルに促進され、探索できる技術や方法が数多く存在します。新しいテクノロジーの出現によってすべての古いテクノロジーが打ち破られるわけではなく、新旧のテクノロジーが統合される可能性があることがわかります。

Xiaomi Byteが力を合わせます! Xiao Ai の Doubao へのアクセスの大規模モデル: 携帯電話と SU7 にすでにインストールされています

Jun 13, 2024 pm 05:11 PM

Xiaomi Byteが力を合わせます! Xiao Ai の Doubao へのアクセスの大規模モデル: 携帯電話と SU7 にすでにインストールされています

Jun 13, 2024 pm 05:11 PM

6月13日のニュースによると、Byteの「Volcano Engine」公開アカウントによると、Xiaomiの人工知能アシスタント「Xiao Ai」はVolcano Engineとの協力に達し、両社はbeanbao大型モデルに基づいて、よりインテリジェントなAIインタラクティブ体験を実現するとのこと。 。 ByteDance が作成した大規模な豆包モデルは、毎日最大 1,200 億のテキスト トークンを効率的に処理し、3,000 万個のコンテンツを生成できると報告されています。 Xiaomi は、Doubao 大型モデルを使用して、独自モデルの学習能力と推論能力を向上させ、ユーザーのニーズをより正確に把握するだけでなく、より速い応答速度とより包括的なコンテンツ サービスを提供する新しい「Xiao Ai Classmate」を作成しました。たとえば、ユーザーが複雑な科学的概念について質問する場合、&ldq

説明可能な AI: 複雑な AI/ML モデルの説明

Jun 03, 2024 pm 10:08 PM

説明可能な AI: 複雑な AI/ML モデルの説明

Jun 03, 2024 pm 10:08 PM

翻訳者 | Li Rui によるレビュー | 今日、人工知能 (AI) および機械学習 (ML) モデルはますます複雑になっており、これらのモデルによって生成される出力はブラックボックスになっており、関係者に説明することができません。 Explainable AI (XAI) は、利害関係者がこれらのモデルがどのように機能するかを理解できるようにし、これらのモデルが実際に意思決定を行う方法を確実に理解できるようにし、AI システムの透明性、信頼性、およびこの問題を解決するための説明責任を確保することで、この問題を解決することを目指しています。この記事では、さまざまな説明可能な人工知能 (XAI) 手法を検討して、その基礎となる原理を説明します。説明可能な AI が重要であるいくつかの理由 信頼と透明性: AI システムが広く受け入れられ、信頼されるためには、ユーザーは意思決定がどのように行われるかを理解する必要があります

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

編集者 |ScienceAI 質問応答 (QA) データセットは、自然言語処理 (NLP) 研究を促進する上で重要な役割を果たします。高品質の QA データ セットは、モデルの微調整に使用できるだけでなく、大規模言語モデル (LLM) の機能、特に科学的知識を理解し推論する能力を効果的に評価することもできます。現在、医学、化学、生物学、その他の分野をカバーする多くの科学 QA データ セットがありますが、これらのデータ セットにはまだいくつかの欠点があります。まず、データ形式は比較的単純で、そのほとんどが多肢選択式の質問であり、評価は簡単ですが、モデルの回答選択範囲が制限され、科学的な質問に回答するモデルの能力を完全にテストすることはできません。対照的に、自由回答型の Q&A