Python での単語頻度統計とキーワード抽出に Jieba を使用する方法

1 単語頻度統計

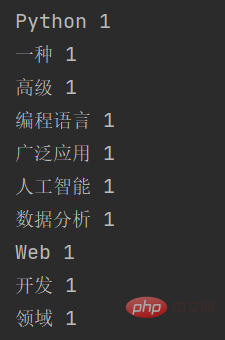

1.1 単純な単語頻度統計

1. jieba ライブラリをインポートし、テキスト

import jieba text = "Python是一种高级编程语言,广泛应用于人工智能、数据分析、Web开发等领域。"

2. セグメントを定義します。テキスト

words = jieba.cut(text)

このステップでは、テキストをいくつかの単語に分割し、ジェネレーター オブジェクト words を返します。for を使用すると、すべての単語をループできます。

3. 単語の頻度をカウントする

word_count = {}

for word in words:

if len(word) > 1:

word_count[word] = word_count.get(word, 0) + 1このステップでは、すべての単語を対象に、各単語の出現回数をカウントし、辞書に保存しますword_count。単語の頻度をカウントする場合、ストップ ワードを削除することで最適化を実行できますが、ここでは長さが 2 未満の単語を単純にフィルター処理します。

4. 結果の出力

for word, count in word_count.items():

print(word, count)

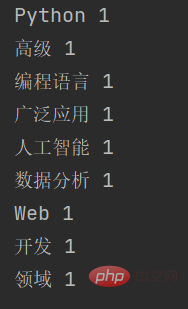

1.2 ストップワードの追加

単語の出現頻度をより正確にカウントするために、単語頻度統計における単語頻度 ストップワードを追加して、一般的だが意味のない単語を削除します。具体的な手順は次のとおりです。

ストップワード リストを定義する

import jieba # 停用词列表 stopwords = ['是', '一种', '等']

テキストを分割し、ストップワードをフィルタリングする

text = "Python是一种高级编程语言,广泛应用于人工智能、数据分析、Web开发等领域。" words = jieba.cut(text) words_filtered = [word for word in words if word not in stopwords and len(word) > 1]

ワードの頻度をカウントし、結果を出力する

word_count = {}

for word in words_filtered:

word_count[word] = word_count.get(word, 0) + 1

for word, count in word_count.items():

print(word, count)ストップ ワードを追加した後の出力結果は次のとおりです。

無効な単語 kind of が表示されていないことがわかります。

2 キーワード抽出

2.1 キーワード抽出原理

単純に単語をカウントする単語頻度統計とは異なり、jieba のキーワード抽出原理は TF-IDF (用語頻度-逆ドキュメント頻度) アルゴリズム。 TF-IDF アルゴリズムは、テキスト内の単語の重要性を測定できる、一般的に使用されるテキスト特徴抽出方法です。

具体的には、TF-IDF アルゴリズムには 2 つの部分が含まれています:

用語頻度: 単語がテキスト内に出現する回数を指し、通常は単純な統計を使用します。単語頻度、バイグラム単語頻度などの値表現。単語の頻度はテキスト内の単語の重要性を反映しますが、コーパス全体における単語の普及率は無視されます。

逆ドキュメント頻度: すべてのドキュメントに出現する単語の頻度の逆数を指し、単語の普及率を測定するために使用されます。逆文書頻度が大きいほど、単語はより一般的であり、重要度は低くなります。逆文書頻度が小さいほど、単語はよりユニークで重要度が高くなります。

TF-IDF アルゴリズムは、単語頻度と逆文書頻度を総合的に考慮してテキスト内の各単語の重要度を計算し、キーワードを抽出します。 jieba では、キーワード抽出の具体的な実装には次の手順が含まれます。

テキストに対して単語分割を実行し、単語分割結果を取得します。

テキスト内に各単語が出現する回数を数え、単語の頻度を計算します。

すべての文書内で各単語が出現する回数を数え、文書頻度の逆数を計算します。

単語頻度と逆文書頻度を総合的に考慮して、テキスト内の各単語の TF-IDF 値を計算します。

TF-IDF 値を並べ替え、最もスコアの高い単語をキーワードとして選択します。

例 :

F (用語頻度) は、文書内に出現する特定の単語の頻度を指します。計算式は次のとおりです。

T F = (文書内での単語の出現回数) / (文書内の総単語数)

たとえば、100 個の単語が含まれる文書内で、ある単語が出現するとします。 10 倍すると、単語の TF は

10 / 100 = 0.1 になります。

IDF (逆文書頻度) は、文書コレクション内で特定の単語が出現する文書の数の逆数を指します。計算式は次のとおりです。

I D F = log (文書コレクション内の文書の総数/その単語が含まれる文書の数)

たとえば、1,000 個の文書が含まれる文書コレクションでは、ある単語が 100 個の文書に出現します。そうであれば、単語の IDF は log (1000 / 100) = 1.0

TFIDF は TF と IDF を掛け合わせた結果であり、計算式は次のとおりです:

T F I D F = T F ∗ I D F

TF-IDF アルゴリズムでは、テキスト内の単語の出現のみが考慮され、単語間の相関関係は無視されることに注意してください。したがって、一部の特定のアプリケーション シナリオでは、単語ベクトル、トピック モデルなど、他のテキスト特徴抽出方法を使用する必要があります。

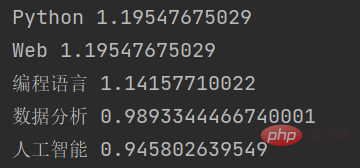

2.2 キーワード抽出コード

import jieba.analyse

# 待提取关键字的文本

text = "Python是一种高级编程语言,广泛应用于人工智能、数据分析、Web开发等领域。"

# 使用jieba提取关键字

keywords = jieba.analyse.extract_tags(text, topK=5, withWeight=True)

# 输出关键字和对应的权重

for keyword, weight in keywords:

print(keyword, weight)この例では、まず jieba.analyse モジュールをインポートし、キーワードとして抽出するテキストを定義しましたtext 。次に、jieba.analyse.extract_tags() 関数を使用してキーワードを抽出します。topK パラメータは抽出するキーワードの数を示し、withWeight パラメータは、キーワードの重み値を返すかどうかを示します。最後に、キーワード リストを反復処理して、各キーワードとそれに対応する重み値を出力します。

この関数の出力結果は次のとおりです:

ご覧のとおり、jieba は TF-IDF アルゴリズムに基づいて入力テキスト内の複数のキーワードを抽出し、各キーワードの重み値を返します。

以上がPython での単語頻度統計とキーワード抽出に Jieba を使用する方法の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7566

7566

15

15

1386

1386

52

52

87

87

11

11

28

28

105

105

PHPおよびPython:コードの例と比較

Apr 15, 2025 am 12:07 AM

PHPおよびPython:コードの例と比較

Apr 15, 2025 am 12:07 AM

PHPとPythonには独自の利点と短所があり、選択はプロジェクトのニーズと個人的な好みに依存します。 1.PHPは、大規模なWebアプリケーションの迅速な開発とメンテナンスに適しています。 2。Pythonは、データサイエンスと機械学習の分野を支配しています。

Python vs. JavaScript:コミュニティ、ライブラリ、リソース

Apr 15, 2025 am 12:16 AM

Python vs. JavaScript:コミュニティ、ライブラリ、リソース

Apr 15, 2025 am 12:16 AM

PythonとJavaScriptには、コミュニティ、ライブラリ、リソースの観点から、独自の利点と短所があります。 1)Pythonコミュニティはフレンドリーで初心者に適していますが、フロントエンドの開発リソースはJavaScriptほど豊富ではありません。 2)Pythonはデータサイエンスおよび機械学習ライブラリで強力ですが、JavaScriptはフロントエンド開発ライブラリとフレームワークで優れています。 3)どちらも豊富な学習リソースを持っていますが、Pythonは公式文書から始めるのに適していますが、JavaScriptはMDNWebDocsにより優れています。選択は、プロジェクトのニーズと個人的な関心に基づいている必要があります。

Dockerの原則の詳細な説明

Apr 14, 2025 pm 11:57 PM

Dockerの原則の詳細な説明

Apr 14, 2025 pm 11:57 PM

DockerはLinuxカーネル機能を使用して、効率的で孤立したアプリケーションランニング環境を提供します。その作業原則は次のとおりです。1。ミラーは、アプリケーションを実行するために必要なすべてを含む読み取り専用テンプレートとして使用されます。 2。ユニオンファイルシステム(UnionFS)は、違いを保存するだけで、スペースを節約し、高速化する複数のファイルシステムをスタックします。 3.デーモンはミラーとコンテナを管理し、クライアントはそれらをインタラクションに使用します。 4。名前空間とcgroupsは、コンテナの分離とリソースの制限を実装します。 5.複数のネットワークモードは、コンテナの相互接続をサポートします。これらのコア概念を理解することによってのみ、Dockerをよりよく利用できます。

ターミナルVSCODEでプログラムを実行する方法

Apr 15, 2025 pm 06:42 PM

ターミナルVSCODEでプログラムを実行する方法

Apr 15, 2025 pm 06:42 PM

VSコードでは、次の手順を通じて端末でプログラムを実行できます。コードを準備し、統合端子を開き、コードディレクトリが端末作業ディレクトリと一致していることを確認します。プログラミング言語(pythonのpython your_file_name.pyなど)に従って実行コマンドを選択して、それが正常に実行されるかどうかを確認し、エラーを解決します。デバッガーを使用して、デバッグ効率を向上させます。

Visual StudioコードはPythonで使用できますか

Apr 15, 2025 pm 08:18 PM

Visual StudioコードはPythonで使用できますか

Apr 15, 2025 pm 08:18 PM

VSコードはPythonの書き込みに使用でき、Pythonアプリケーションを開発するための理想的なツールになる多くの機能を提供できます。ユーザーは以下を可能にします。Python拡張機能をインストールして、コードの完了、構文の強調表示、デバッグなどの関数を取得できます。デバッガーを使用して、コードを段階的に追跡し、エラーを見つけて修正します。バージョンコントロールのためにGitを統合します。コードフォーマットツールを使用して、コードの一貫性を維持します。糸くずツールを使用して、事前に潜在的な問題を発見します。

Python:自動化、スクリプト、およびタスク管理

Apr 16, 2025 am 12:14 AM

Python:自動化、スクリプト、およびタスク管理

Apr 16, 2025 am 12:14 AM

Pythonは、自動化、スクリプト、およびタスク管理に優れています。 1)自動化:OSやShutilなどの標準ライブラリを介してファイルバックアップが実現されます。 2)スクリプトの書き込み:Psutilライブラリを使用してシステムリソースを監視します。 3)タスク管理:スケジュールライブラリを使用してタスクをスケジュールします。 Pythonの使いやすさと豊富なライブラリサポートにより、これらの分野で優先ツールになります。

Windows 8でコードを実行できます

Apr 15, 2025 pm 07:24 PM

Windows 8でコードを実行できます

Apr 15, 2025 pm 07:24 PM

VSコードはWindows 8で実行できますが、エクスペリエンスは大きくない場合があります。まず、システムが最新のパッチに更新されていることを確認してから、システムアーキテクチャに一致するVSコードインストールパッケージをダウンロードして、プロンプトとしてインストールします。インストール後、一部の拡張機能はWindows 8と互換性があり、代替拡張機能を探すか、仮想マシンで新しいWindowsシステムを使用する必要があることに注意してください。必要な拡張機能をインストールして、適切に動作するかどうかを確認します。 Windows 8ではVSコードは実行可能ですが、開発エクスペリエンスとセキュリティを向上させるために、新しいWindowsシステムにアップグレードすることをお勧めします。

VSCODE拡張機能は悪意がありますか?

Apr 15, 2025 pm 07:57 PM

VSCODE拡張機能は悪意がありますか?

Apr 15, 2025 pm 07:57 PM

VSコード拡張機能は、悪意のあるコードの隠れ、脆弱性の活用、合法的な拡張機能としての自慰行為など、悪意のあるリスクを引き起こします。悪意のある拡張機能を識別する方法には、パブリッシャーのチェック、コメントの読み取り、コードのチェック、およびインストールに注意してください。セキュリティ対策には、セキュリティ認識、良好な習慣、定期的な更新、ウイルス対策ソフトウェアも含まれます。