脳の階層的予測により、大規模なモデルがより効率的になります。

1,000 億個のニューロンがあり、各ニューロンには約 8,000 のシナプスがあり、脳の複雑な構造は人工知能の研究にインスピレーションを与えています。

#現在、ほとんどの深層学習モデルのアーキテクチャは、生物学的な脳のニューロンにヒントを得た人工ニューラル ネットワークです。

Generative AI が爆発的に爆発し、深層学習アルゴリズムが 、能力を生成しているのがわかりますテキストを要約、翻訳、分類する機能はますます強力になっています。

#しかし、これらの言語モデルは依然として人間の言語能力に匹敵するものではありません。

# 予測コーディング理論では、この違いについて暫定的な説明を提供します。

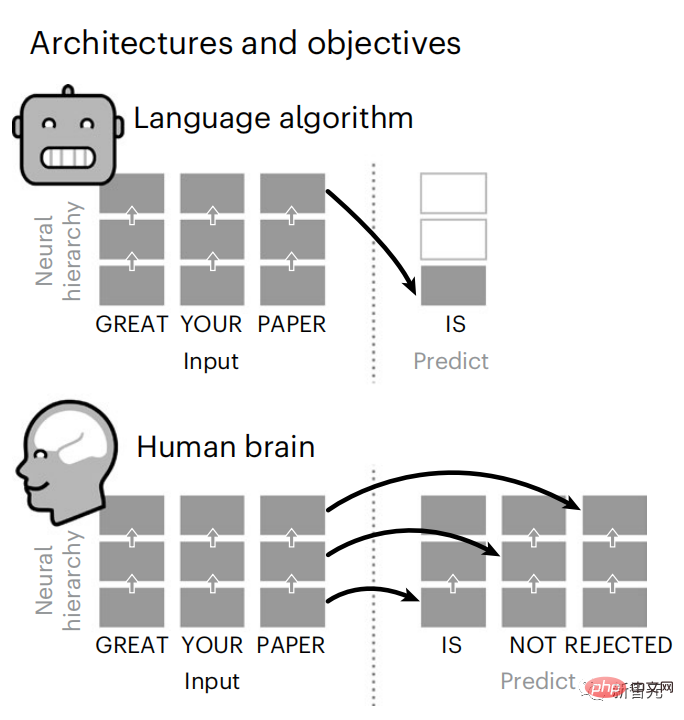

言語モデルは近くの単語を予測できますが、人間の脳は常に複数の時間スケールにわたる表現の層を予測します。

この仮説を検証するために、Meta AI の科学者たちは、短編小説を聞いた 304 人の脳の fMRI 信号を分析しました。

#階層型予測コーディングは言語処理において重要な役割を果たしていると結論付けられています。

#一方、神経科学と人工知能の相乗効果によって、人間の認知の計算基盤がどのように解明されるのかが研究によって明らかにされています。

#最新の研究は、Nature サブジャーナル Nature Human Behavior に掲載されました。

#実験中に GPT-2 が使用されたことは言及する価値があります。おそらくこの研究は、将来 OpenAI の未開封モデルにインスピレーションを与える可能性があります。

その頃には ChatGPT はさらに強力になっているのではないでしょうか?

脳の予測コーディング階層

ディープ ラーニングは、3 年足らずでテキストの生成と翻訳において大きな進歩を遂げました。 - 訓練されたアルゴリズム: 近くのコンテキストに基づいて単語を予測します。

#注目すべきことに、これらのモデルによる活性化は、音声とテキストに対する脳の反応に線形にマッピングされることが示されています。

さらに、このマッピングは主に将来の単語を予測するアルゴリズムの能力に依存しているため、この目標は脳のような計算に収束するには十分であることを示唆しています。

#しかし、これらのアルゴリズムと脳の間には依然としてギャップが存在します。大量のトレーニング データにもかかわらず、現在の言語モデルは、要約するような長い物語を生成することができません。一貫した会話と情報検索に挑戦します。

#アルゴリズムは一部の構文構造と意味論的特性を捕捉できず、言語の理解も非常に表面的なものであるためです。

#たとえば、アルゴリズムは、ネストされたフレーズ内の主語に動詞を誤って割り当てる傾向があります。

「男が持っている鍵はここにあります」

同様に、次の単語のみに最適化された予測を生成する場合、深層言語モデルは当たり障りのない一貫性のないシーケンスを生成したり、無限に繰り返されるループに陥ったりする可能性があります。

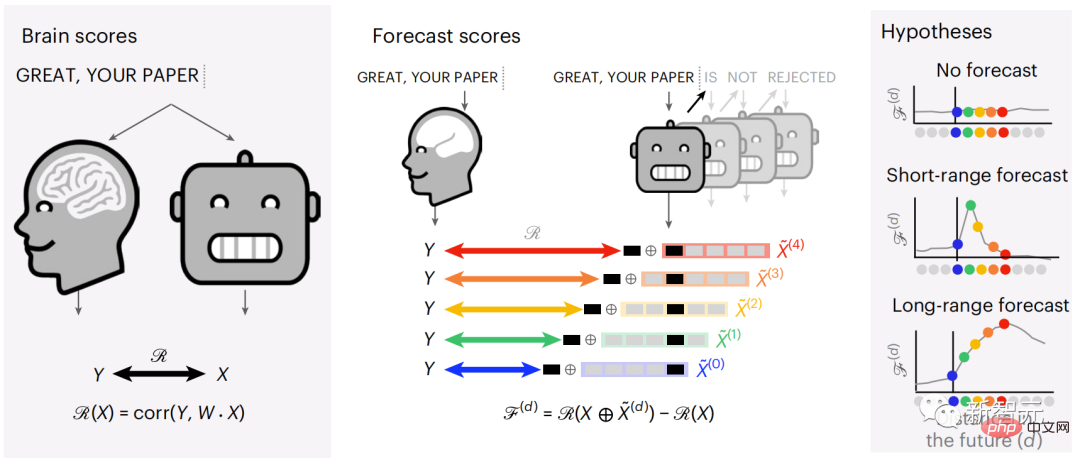

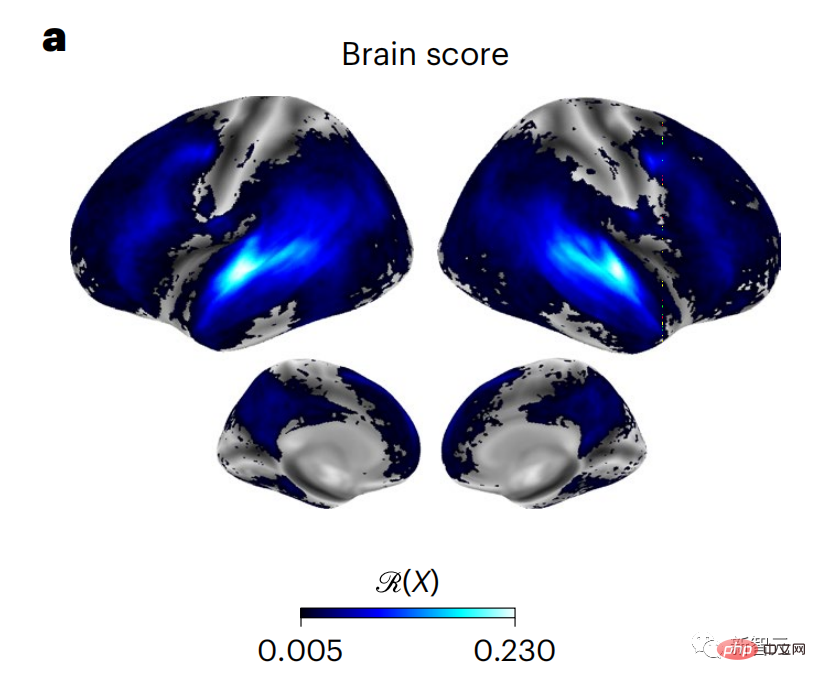

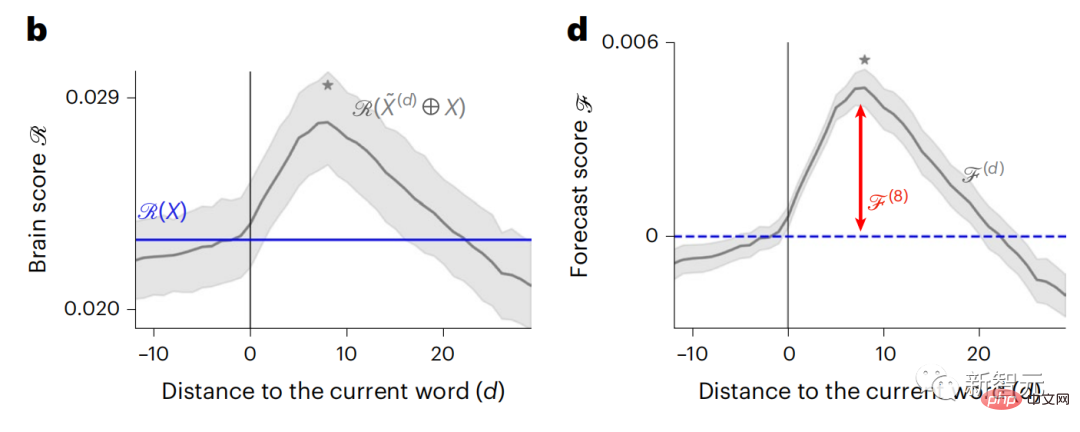

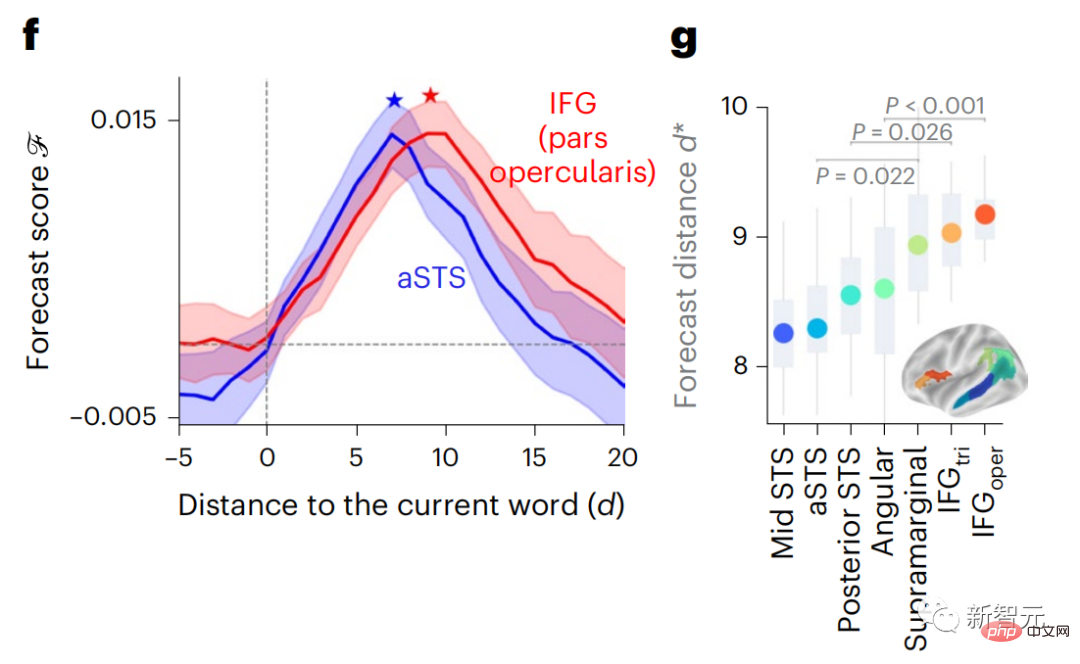

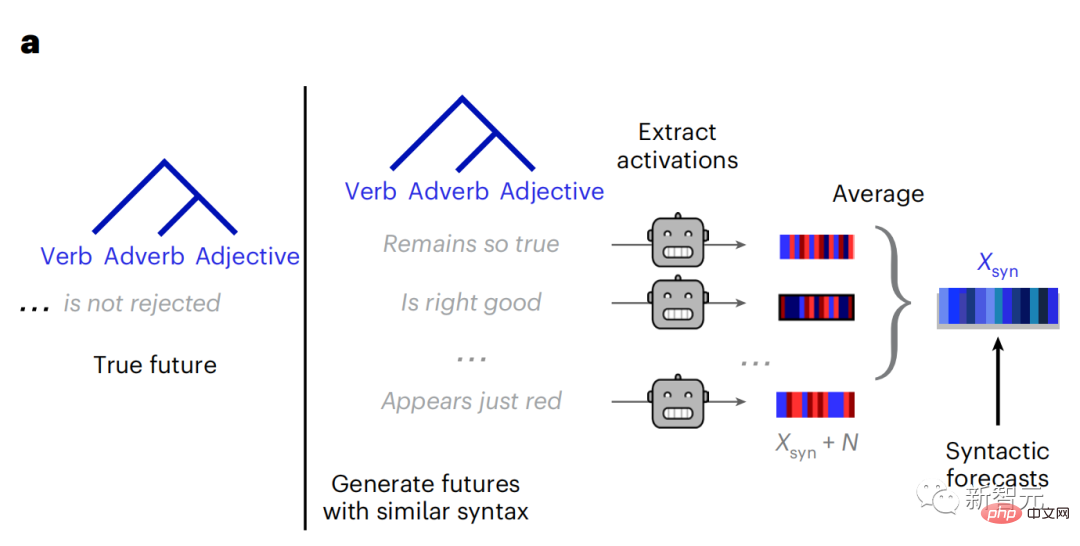

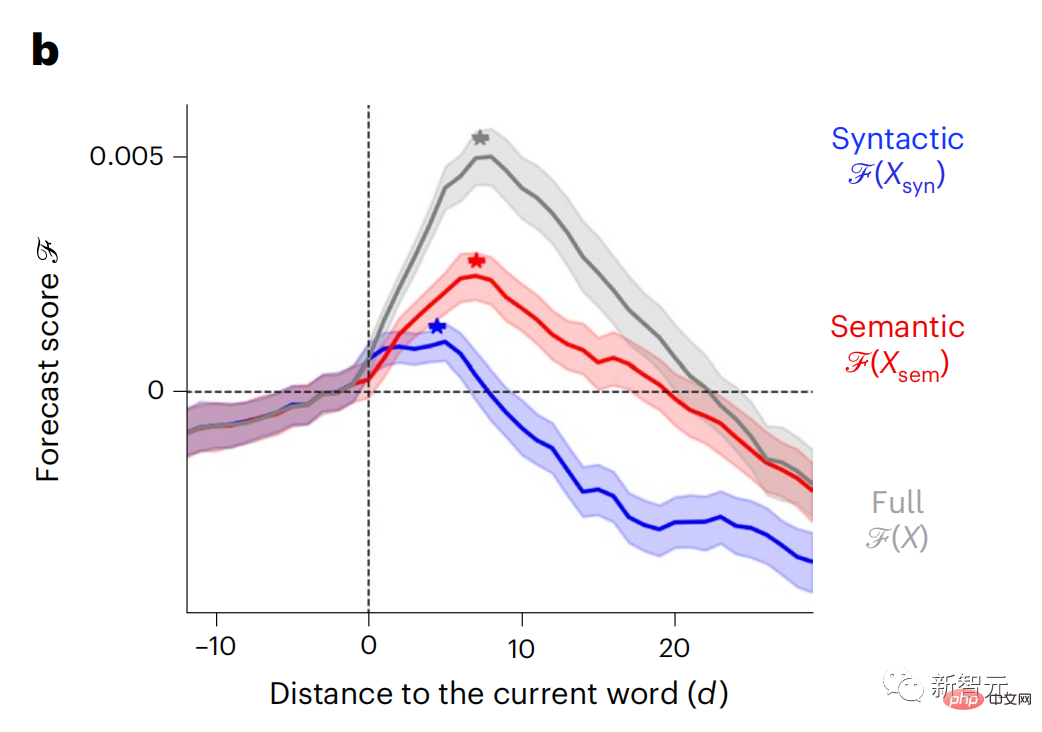

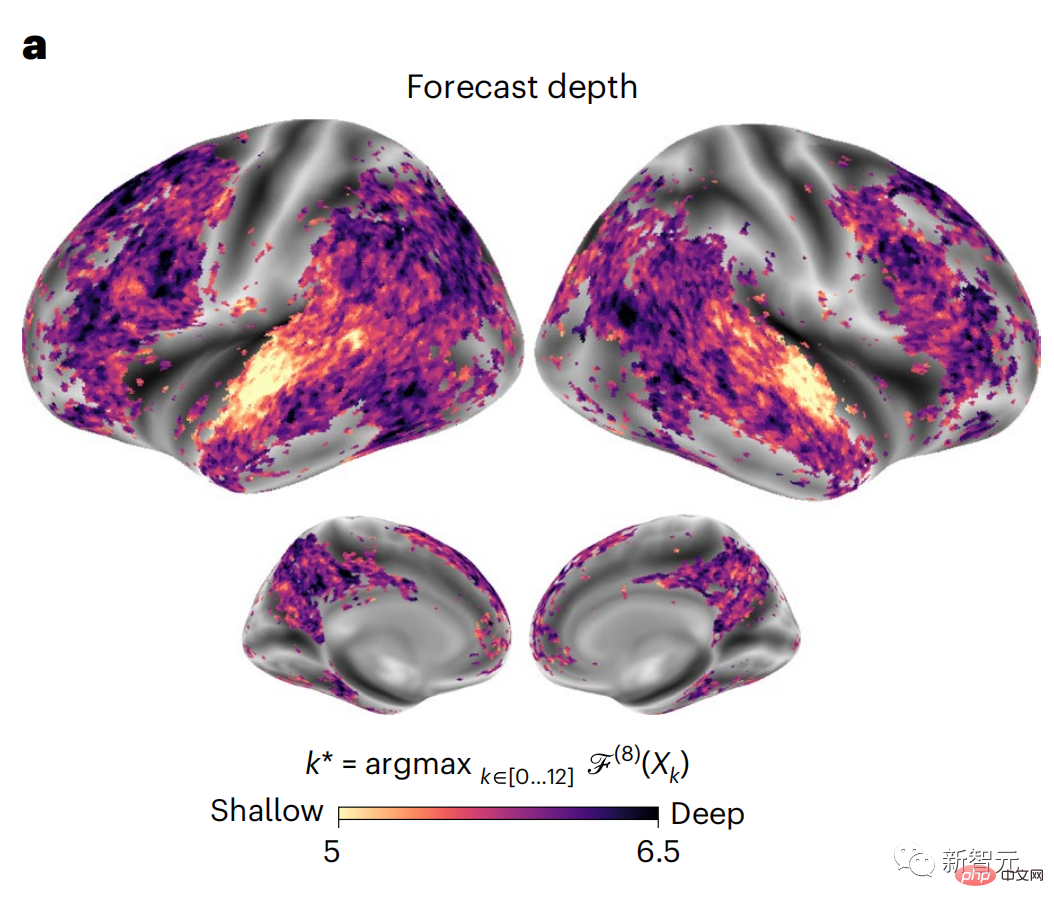

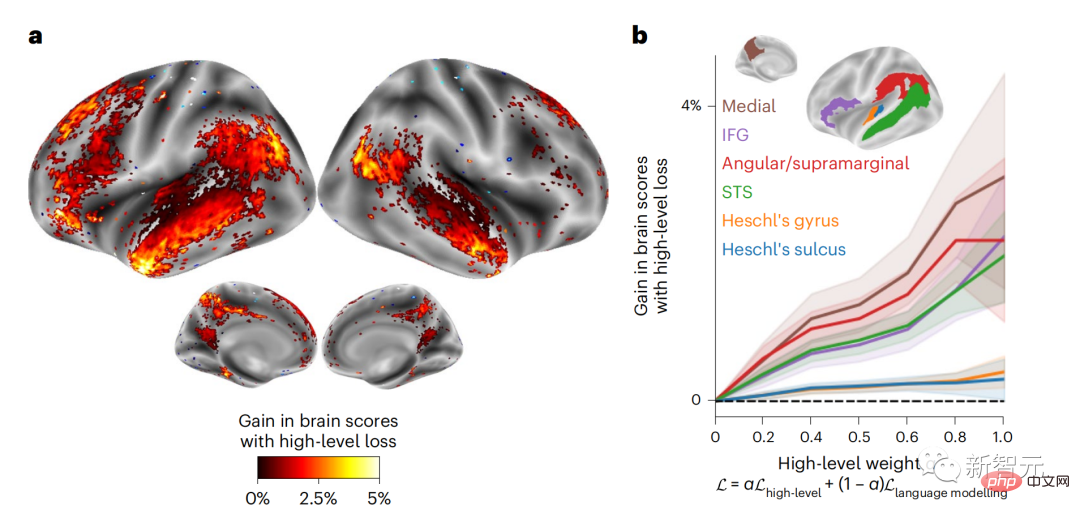

現時点では、予測コーディング理論がこの欠陥の潜在的な説明を提供しています: 深層言語モデルは主に、コードの予測に使用されます。次の言葉ですが、このフレームワークは、人間の脳が複数の時間スケールと皮質レベルの表現で予測できることを示しています。 これまでの研究では、脳内の音声予測、つまり単語や音素が機能的予測とよく相関していることが実証されています。磁気共鳴画像法 (fMRI)、脳波検査、脳磁図および皮質電図検査は相関していました。 #次の単語または音素を予測するようにトレーニングされたモデルは、その出力を単一の数値 (次の記号の確率) に減らすことができます。 # ただし、予測表現の性質と時間スケールはほとんどわかっていません。 #この研究では、研究者らは 304 人から fMRI 信号を抽出し、各人に約 26 分間聞いてもらいました。数分の短編小説 (Y) を入力し、同じ内容を入力して言語アルゴリズムをアクティブにします (X)。 X と Y の類似性は、「脳スコア」、つまり最良の線形マッピング後のピアソン相関係数 (R) によって定量化されます。 W 。 #予測された単語の表現を追加することでこの相関関係が改善されるかどうかをテストするには、ネットワークのアクティブ化 (黒い四角形 X) を変更します。 ) は予測ウィンドウ (色付きの四角形 ~X) に接続され、PCA を使用して予測ウィンドウの次元を X の次元に削減します。 最後に、F は、言語アルゴリズムによるこの予測ウィンドウの活性化を強化することによって得られる脳スコアのゲインを定量化します。異なる距離ウィンドウを使用してこの分析 (d) を繰り返します。 #これらのアルゴリズムを複数の時間スケールにわたる予測、つまり長距離予測と階層予測で強化することで、この脳のマッピングを改善できることがわかりました。 #最終的に、実験結果により、これらの予測は階層的に組織化されていることがわかりました。前頭葉皮質は、側頭葉皮質よりも高いレベル、より広い範囲、より多くの予測を予測します。コンテキスト表現。 深層言語モデルは脳活動にマッピング # 研究者らは、入力内容が同じ場合の深層言語モデルと脳との類似性を定量的に研究しました。 Narratives データセットを使用して、短編小説を聞いた 304 人の fMRI (機能的磁気共鳴画像法) が分析されました。 各ボクセルと各実験個体の結果に対して独立した線形リッジ回帰を実行し、いくつかの深層言語モデルの活性化から生じる fMRI 信号を予測します。 保持されたデータを使用して、対応する「脳スコア」、つまり fMRI 信号と得られたリッジ回帰予測結果の間の相関が計算されました。指定された言語モデル刺激セックスを入力することによって。 わかりやすくするために、まず GPT-2 の第 8 層の活性化に焦点を当てます。GPT-2 は、HuggingFace2 を利用した 12 層の因果的ディープ ニューラル ネットワークです。予測的な脳活動。 以前の研究と一致して、GPT-2 活性化は両側の脳領域の分散セットに正確にマッピングされ、脳スコアは聴覚皮質と前側頭領域および上側頭領域でピークに達しました。 メタチームはその後長距離予測機能を備えた言語モデルの刺激を増やすと、脳スコアが向上するかどうかをテストしました。 #研究者らは、単語ごとに、現在の単語のモデルのアクティブ化を、将来の単語で構成される「予測ウィンドウ」に関連付けました。予測ウィンドウの表現パラメーターには、ウィンドウ内の現在の単語と将来の最後の単語の間の距離を表す d と、連結された単語の数を表す w が含まれます。各 d について、予測表現ありとなしの脳スコアを比較し、「予測スコア」を計算します。 #その結果、d=8 のときに予測スコアが最も高く、言語処理に関係する脳領域にピーク値が現れることがわかりました。 d=8 は 3.15 秒の音声に相当し、これは 2 回の連続する fMRI スキャンの時間です。予測スコアは、下前頭回および縁上回を除き、脳の両側に分布しました。 補足分析を通じて、チームは次の結果も得ました: (1) 現在の単語から 0 ~ 10 の距離にある未来の各単語には、有意な意味があります。 ; (2) 予測表現は約 8 単語のウィンドウ サイズで最もよくキャプチャされます; (3) ランダムな予測表現は脳スコアを改善できません; (4) 実際の未来の単語と比較して、GPT-2 で生成された単語は、同様の結果が得られますが、スコアは低くなります。 解剖学と脳の層に沿って変化します。機能研究により、大脳皮質は階層的であることが示されています。予測時間枠は皮質の異なるレベルで同じですか? #研究者らは、各ボクセルのピーク予測スコアを推定し、その対応する距離を d として表しました。 結果は、前頭前野領域の予測ピークに対応する d が、平均して側頭葉領域のものよりも大きいことを示しました (図 2e)。下側頭回のd 上側頭溝よりも大きい。

構文と意味予測の時間範囲は異なります

これらの結果は、脳における複数のレベルの予測を明らかにしています。上位側頭葉皮質は主に短期的で浅い構文表現を予測し、下前頭葉と頭頂葉領域は主に長期的な表現を予測します。文脈的、高レベルの構文表現、意味表現。 予測される背景は脳階層に沿ってより複雑になります 以前と同様このメソッドは予測スコアを計算しますが、各ボクセルの k (予測スコアが最大化される深さ) を決定するための GPT-2 レイヤーの使用を変更します。 私たちの結果は、最適な予測深度は予想される皮質階層に沿って変化し、最良のモデルは下位レベルの言語野よりも連合皮質の深部を予測することを示しています。領域間の違いは、平均すると小さいですが、個人によっては非常に顕著です。 一般に、前頭皮質における長期予測は、下位皮質における短期予測よりも複雑な背景を持っています。 -レベルの脳領域 レベルが高くなります。 GPT-2 を予測符号化構造に調整する GPT-2 の現在の単語と将来の単語を調整するこれらの表現を連結して、特に前頭部の脳活動のより適切なモデルを取得できます。 GPT-2 を微調整して、より遠い距離、より豊富な背景、より高い階層レベルでの表現を予測することで、これらの領域の脳マッピングを改善できるでしょうか? 調整では、言語モデリングだけでなく、高レベルのターゲットや長距離のターゲットも使用されます。 -トレーニング済み GPT -2 モデルのレイヤー 8。 その結果、GPT-2 を高レベルおよび長距離モデリングのペアで微調整すると、前頭葉の反応が最もよく改善される一方で、聴覚野と下位領域の反応が最も改善されることがわかりました。脳領域のレベルは、そのような高レベルのターゲティングから大きな恩恵を受けず、言語の長距離、文脈、および高レベルの表現を予測する際の前頭領域の役割をさらに反映しています。 参考: https:/ / www.php.cn/link/7eab47bf3a57db8e440e5a788467c37f

#

#

以上が脳の階層的予測により、大規模なモデルがより効率的になります。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7455

7455

15

15

1375

1375

52

52

77

77

11

11

14

14

9

9

時系列確率予測のための分位回帰

May 07, 2024 pm 05:04 PM

時系列確率予測のための分位回帰

May 07, 2024 pm 05:04 PM

元のコンテンツの意味を変更したり、コンテンツを微調整したり、コンテンツを書き直したり、継続したりしないでください。 「分位回帰はこのニーズを満たし、定量化された確率で予測間隔を提供します。これは、特に応答変数の条件付き分布が重要な場合に、予測変数と応答変数の間の関係をモデル化するために使用される統計手法です。従来の回帰とは異なります」図 (A): 分位回帰 分位回帰の概念は推定です。一連の回帰子 X と変数の間の線形関係をモデル化する方法です。被説明変数 Y の分位数。既存の回帰モデルは、実際には被説明変数と説明変数の関係を調べる手法です。説明変数と被説明変数の関係に焦点を当てます。

SIMPL: 自動運転向けのシンプルで効率的なマルチエージェント動作予測ベンチマーク

Feb 20, 2024 am 11:48 AM

SIMPL: 自動運転向けのシンプルで効率的なマルチエージェント動作予測ベンチマーク

Feb 20, 2024 am 11:48 AM

原題: SIMPL: ASimpleandEfficientMulti-agentMotionPredictionBaselineforAutonomousDriving 論文リンク: https://arxiv.org/pdf/2402.02519.pdf コードリンク: https://github.com/HKUST-Aerial-Robotics/SIMPL 著者単位: 香港科学大学DJI 論文のアイデア: この論文は、自動運転車向けのシンプルで効率的な動作予測ベースライン (SIMPL) を提案しています。従来のエージェントセントとの比較

MySQL データベースを予測と予測分析に使用するにはどうすればよいですか?

Jul 12, 2023 pm 08:43 PM

MySQL データベースを予測と予測分析に使用するにはどうすればよいですか?

Jul 12, 2023 pm 08:43 PM

MySQL データベースを予測と予測分析に使用するにはどうすればよいですか?概要: 予測と予測分析はデータ分析において重要な役割を果たします。広く使用されているリレーショナル データベース管理システムである MySQL は、予測および予測分析タスクにも使用できます。この記事では、予測と予測分析に MySQL を使用する方法を紹介し、関連するコード例を示します。データの準備: まず、関連するデータを準備する必要があります。売上予測を行うには、売上データを含むテーブルが必要だとします。 MySQL では使用できます

AI の推論とトレーニングの違いは何ですか?あなたは知っていますか?

Mar 26, 2024 pm 02:40 PM

AI の推論とトレーニングの違いは何ですか?あなたは知っていますか?

Mar 26, 2024 pm 02:40 PM

AI のトレーニングと推理の違いを一言で言い表すなら、「ステージ上では 1 分、ステージ外では 10 年」が最も適切だと思います。シャオミンは長年、憧れの女神と付き合っており、誘い方や誘い方のコツは熟知しているものの、その謎については未だに戸惑っている。 AI技術の助けを借りて正確な予測を達成できるでしょうか?シャオミンは何度も考え、女神が招待を受け入れるかどうかに影響を与える可能性のある変数をまとめました。休日か、天気が悪いか、暑すぎるか寒すぎるか、機嫌が悪いか、病気か、別の予定があるか、親戚かなどです。家に来ています... .etc画像ではこれらの変数に重みを付けて合計し、それが特定のしきい値を超えた場合、女神は招待に応じなければなりません。では、これらの変数にはどれくらいの重みがあり、しきい値は何でしょうか?これは非常に複雑な質問であり、合格するのは困難です

クロスモーダル占有知識の学習: レンダリング支援蒸留技術を使用した RadOcc

Jan 25, 2024 am 11:36 AM

クロスモーダル占有知識の学習: レンダリング支援蒸留技術を使用した RadOcc

Jan 25, 2024 am 11:36 AM

原題: Radocc: LearningCross-ModalityOccupancyKnowledgethroughRenderingAssistedDistillation 論文リンク: https://arxiv.org/pdf/2312.11829.pdf 著者単位: FNii、CUHK-ShenzhenSSE、CUHK-Shenzhen Huawei Noah's Ark Laboratory Conference: AAAI2024 Paper Idea: 3D Occupancy Prediction isこれは、マルチビュー画像を使用して 3D シーンの占有状態とセマンティクスを推定することを目的とした新たなタスクです。ただし、幾何学的事前分布が欠如しているため、画像ベースのシナリオは

Microsoft 365 により Excel で Python が使用可能になります

Sep 22, 2023 pm 10:53 PM

Microsoft 365 により Excel で Python が使用可能になります

Sep 22, 2023 pm 10:53 PM

1. Excel での Python の有効化 Excel の Python は現在テスト段階にあります。この機能を使用する場合は、Microsoft 365 の Windows バージョンであることを確認し、Microsoft 365 プレビュー プログラムに参加して、ベータ チャネルを選択してください。 Excelページ左上の[ファイル]→[アカウント]をクリックします。ページの左側に次の情報が表示されます。 上記の手順を完了したら、空のブックを開きます。 [数式] タブをクリックし、 [Python の挿入] - [Excel に Python] を選択します。ポップアップダイアログボックスの[試用版プレビュー版]をクリックします。次に、Python の素晴らしい使い方を体験してみましょう。 2、

マスク氏は楽観的、OpenAIも参入中 テスラの長期的価値はロボットか?

May 27, 2023 pm 02:51 PM

マスク氏は楽観的、OpenAIも参入中 テスラの長期的価値はロボットか?

May 27, 2023 pm 02:51 PM

テクノロジーオタクのマスク氏と彼のテスラは、常に世界的な技術革新の最前線に立ってきました。最近、テスラの2023年の株主総会でマスク氏は、自動車、エネルギー貯蔵、人型ロボットなど、将来の開発に向けたより野心的な計画を再び明らかにした。マスク氏は人型ロボットについて非常に楽観的であるようで、将来のテスラの長期的な価値はロボットにあるかもしれないと信じている。 ChatGPTの親会社であるOpenAIも、初の商用ロボットEVEを構築する目的でノルウェーのロボット会社に投資していることは言及に値する。 Optimus と EVE の競争はまた、国内の二次市場で人型ロボットのコンセプトのブームを引き起こしました。このコンセプトによって推進され、人型ロボット産業チェーンのどのリンクが利益を得るでしょうか?投資対象は何ですか?自動車、エネルギー貯蔵、人型ロボットをグローバル技術として展開

iPhoneでインライン予測を無効にする方法

Nov 22, 2023 pm 11:21 PM

iPhoneでインライン予測を無効にする方法

Nov 22, 2023 pm 11:21 PM

Apple は最近、iOS 17 でインライン予測を導入しました。これは、入力時に画面に表示されるキーボード上で自動修正と予測を使用するための新しく改良された方法です。ただし、多くのユーザーは、インライン予測が入力中に表示され続けるため、少し煩わしいと感じています。予測テキストを無効にせずに無効にする方法はありませんが、iOS 17.2 のリリースでは、クイック タイプ バーを保持し、予測を有効にしたまま、インライン予測を無効にできるようになりました。 iPhone でこの新機能を使用する方法は次のとおりです。 iPhone のクイック エントリ バーを保持したまま iOS17 でインライン予測をオフにする方法 インライン予測は iOS17 で導入され、クイック エントリ バーの提案がグレー表示になっています。