HKUST と MSRA の調査: 画像から画像への変換に関しては、微調整だけで十分です

多くのコンテンツ制作プロジェクトでは、単純なスケッチをリアルな画像に変換する必要があります。これには、深層生成モデル学習を使用した画像間の変換が含まれます。入力が与えられた場合の自然画像の条件付き分布です。

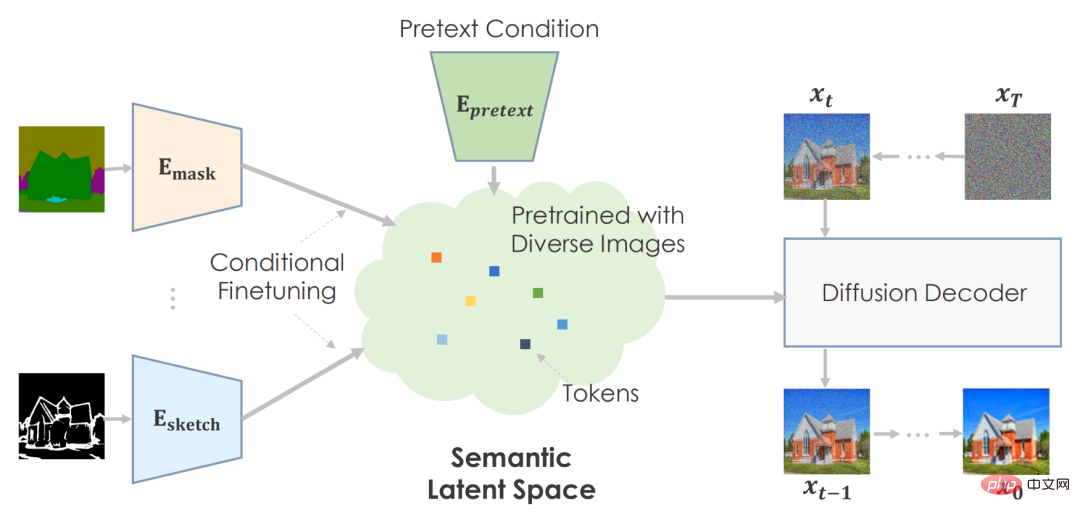

画像から画像への変換の基本概念は、事前にトレーニングされたニューラル ネットワークを利用して自然な画像多様体をキャプチャすることです。画像変換は、多様体を走査して実行可能な入力意味点を見つけることに似ています。このシステムは、潜在空間のあらゆるサンプリングから信頼性の高い出力を提供するために、多くの画像を使用して合成ネットワークを事前トレーニングします。事前トレーニングされた合成ネットワークを通じて、下流トレーニングはユーザー入力をモデルの潜在表現に適応させます。

長年にわたり、多くのタスク固有の手法が SOTA レベルに達しているのを見てきましたが、現在のソリューションでは、現実世界で使用するための高忠実度の画像を作成するのに依然として苦労しています。

最近の論文では、香港科技大学とマイクロソフト リサーチ アジアの研究者は、画像から画像への変換には事前トレーニングだけで十分であると考えています。 。従来の方法では、特殊なアーキテクチャ設計と単一の変換モデルのトレーニングを一から行う必要があり、特にペアのトレーニング データが不十分な場合、高品質の複雑なシーンを生成することが困難でした。

したがって、研究者らは、画像から画像への各変換問題を下流タスクとして扱い、さまざまな画像から画像への変換に適応するために事前トレーニングされた拡散モデルを採用する単純な一般的なフレームワークを導入しました。彼らは、提案された事前トレーニングされた画像から画像への変換モデルを PITI (事前トレーニングベースの画像から画像への変換) と呼びました。さらに、研究者らは、敵対的トレーニングを使用して拡散モデルのトレーニングにおけるテクスチャ合成を強化し、それを正規化されたガイド付きサンプリングと組み合わせて生成品質を向上させることも提案しました。

最後に、研究者らは、ADE20K、COCO-Stuff、DIODE などの挑戦的なベンチマークでさまざまなタスクについて広範な実証的比較を実施し、PITI 合成画像が前例のないリアリズムと忠実度を示すことを実証しました。

- 論文リンク: https://arxiv.org/pdf/2205.12952.pdf

- プロジェクトのホームページ: https://tengfei-wang .github.io/PITI/index.html

GAN は死んだ、拡散モデルは生き続ける

著者は特定の分野で最高のパフォーマンスを発揮した GAN を使用しませんでしたが、拡散モデルを使用し、多種多様な画像を合成します。次に、2 種類の潜在コードから画像を生成する必要があります。1 つは視覚的なセマンティクスを記述するもの、もう 1 つは画像の変動を調整するものです。セマンティックな低次元の潜在性は、下流のタスクにとって重要です。そうしないと、モーダル入力を複雑な潜在空間に変換することが不可能になります。これを考慮して、彼らは、事前学習済みの事前生成として、さまざまな画像を生成できるデータ駆動型モデルである GLIDE を使用しました。 GLIDE は潜在テキストを使用するため、意味論的な潜在スペースが可能になります。

拡散およびスコアベースの手法は、ベンチマーク全体での生成品質を実証します。クラス条件付き ImageNet では、これらのモデルは、視覚的な品質とサンプリングの多様性の点で GAN ベースの手法と競合します。最近、大規模なテキストと画像のペアでトレーニングされた拡散モデルが驚くべき機能を示しました。よく訓練された拡散モデルは、合成のための一般的な事前生成を提供できます。

フレームワーク

作成者は、プレテキスト タスクを使用して、大量のデータで事前トレーニングし、画像統計を予測するための非常に意味のある潜在空間を開発できます。

下流タスクの場合、意味空間を条件付きで微調整してタスク固有の環境をマップします。このマシンは、事前にトレーニングされた情報に基づいて、信頼できるビジュアルを作成します。

著者は、セマンティック入力を使用して拡散モデルを事前トレーニングすることを推奨しています。テキスト条件付き、画像トレーニング済みの GLIDE モデルを使用します。 Transformer ネットワークはテキスト入力をエンコードし、拡散モデルのトークンを出力します。計画通り、スペースにテキストを埋め込むのは理にかなっています。

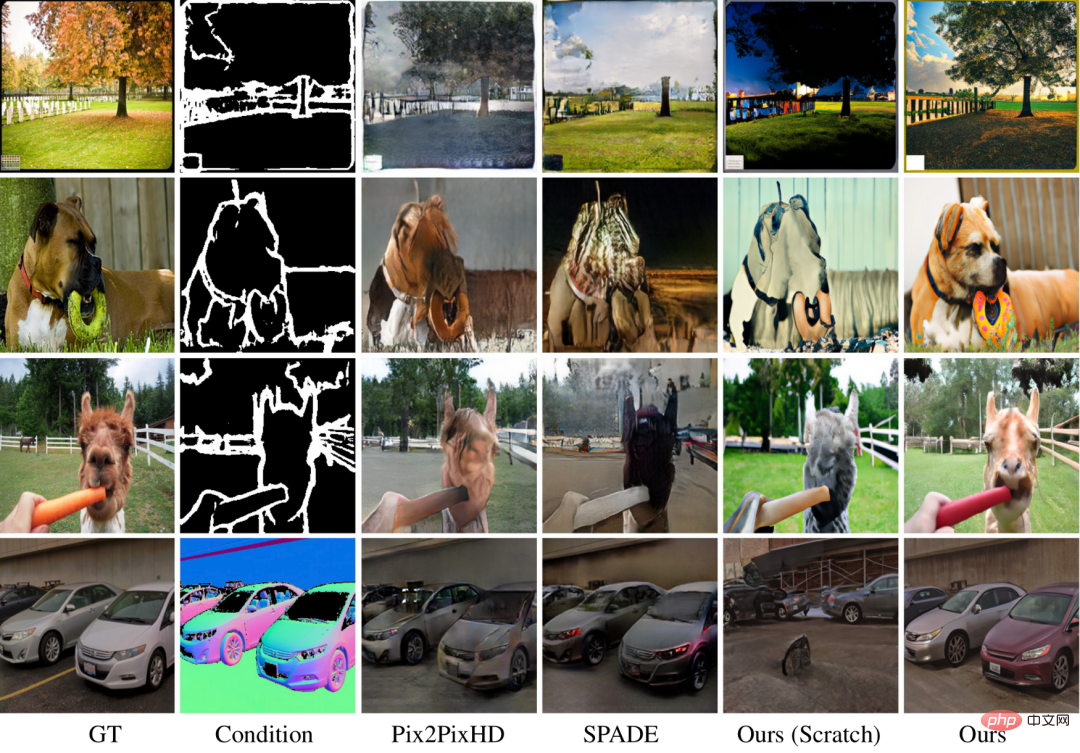

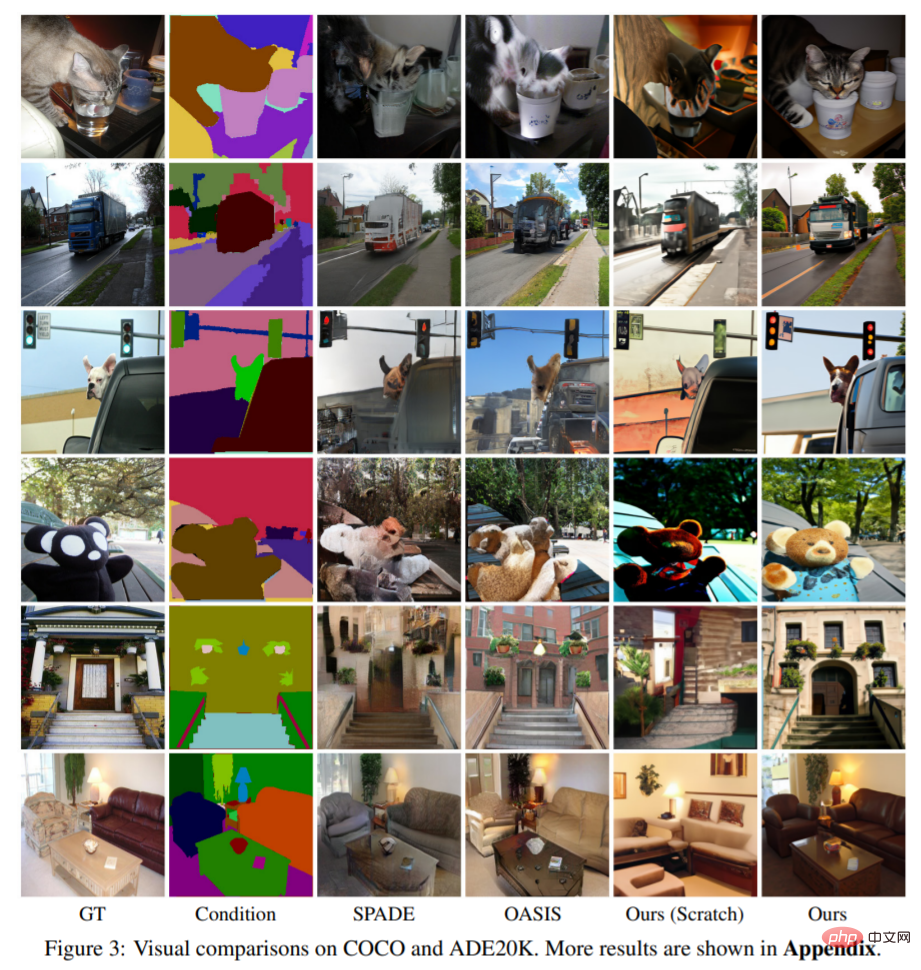

上の写真は作者の作品です。事前トレーニングされたモデルは、ゼロからの手法と比較して画質と多様性を向上させます。 COCO データセットには多数のカテゴリと組み合わせがあるため、基本的なアプローチでは魅力的なアーキテクチャを備えた美しい結果を提供できません。彼らの方法では、難しいシーンでも正確なセマンティクスを備えた豊かな詳細を作成できます。写真は彼らのアプローチの多用途性を示しています。

実験と影響

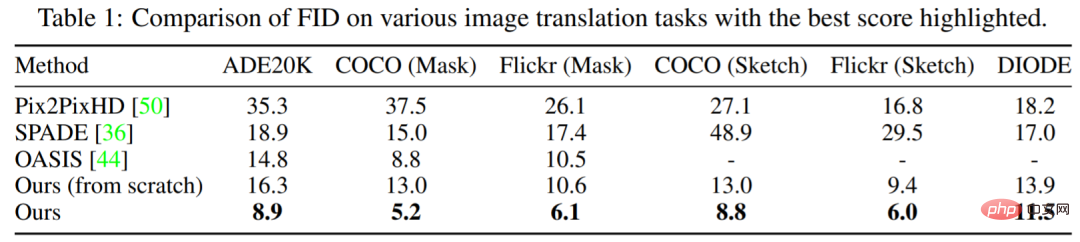

表 1 は、この研究で提案された方法のパフォーマンスが他のモデルよりも常に優れていることを示しています。主要な OASIS と比較して、PITI はマスクからイメージへの合成における FID において大幅な改善を達成しています。さらに、この方法は、スケッチからイメージへの合成タスクおよびジオメトリからイメージへの合成タスクでも優れたパフォーマンスを示します。

# 図 3 は、さまざまなタスクに関するこの研究の視覚化結果を示しています。実験によると、最初からトレーニングする方法と比較して、事前トレーニングされたモデルは、生成される画像の品質と多様性が大幅に向上します。この研究で使用された方法は、困難な生成タスクであっても、鮮明な詳細と正しいセマンティクスを生成できます。

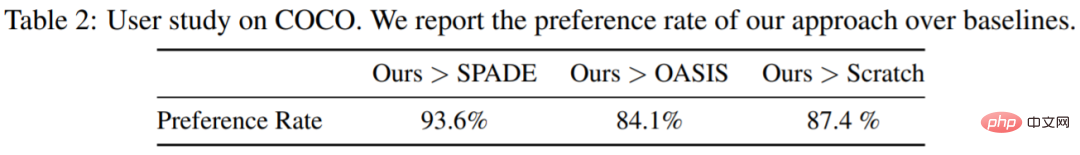

この調査では、Amazon Mechanical Turk の COCO-Stuff でのマスクから画像への合成に関するユーザー調査も実施され、20 人の参加者チケットから 3000 件の結果が得られました。参加者には一度に2枚の画像が与えられ、どちらがより現実的か投票するよう求められた。表 2 に示すように、提案された方法は、ゼロからのモデルや他のベースラインよりも大幅に優れています。

条件付き画像合成では、特定の条件を満たす高画質な画像を作成します。コンピューター ビジョンとグラフィックスの分野では、情報の作成と操作にそれが使用されます。大規模な事前トレーニングにより、画像分類、オブジェクト認識、セマンティック セグメンテーションが向上します。不明なことは、大規模な事前トレーニングが一般的な生成タスクに有益であるかどうかです。

エネルギー使用量と炭素排出量は、画像の事前トレーニングにおける重要な問題です。事前トレーニングはエネルギーを大量に消費しますが、必要なのは 1 回だけです。条件付き微調整により、下流タスクで同じ事前トレーニング済みモデルを使用できるようになります。事前トレーニングにより、少ないトレーニング データで生成モデルをトレーニングできるため、プライバシーの問題や高価なアノテーション コストによりデータが制限されている場合の画像合成が向上します。

以上がHKUST と MSRA の調査: 画像から画像への変換に関しては、微調整だけで十分ですの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7450

7450

15

15

1374

1374

52

52

77

77

11

11

14

14

7

7

世界で最も強力なオープンソース MoE モデルが登場。GPT-4 に匹敵する中国語機能を備え、価格は GPT-4-Turbo のわずか 1% 近くです

May 07, 2024 pm 04:13 PM

世界で最も強力なオープンソース MoE モデルが登場。GPT-4 に匹敵する中国語機能を備え、価格は GPT-4-Turbo のわずか 1% 近くです

May 07, 2024 pm 04:13 PM

従来のコンピューティングを超える能力を備えているだけでなく、より低コストでより効率的なパフォーマンスを実現する人工知能モデルを想像してみてください。これは SF ではありません。世界で最も強力なオープンソース MoE モデルである DeepSeek-V2[1] が登場しました。 DeepSeek-V2 は、経済的なトレーニングと効率的な推論の特徴を備えた強力な専門家混合 (MoE) 言語モデルです。これは 236B のパラメータで構成されており、そのうち 21B は各マーカーをアクティブにするために使用されます。 DeepSeek67B と比較して、DeepSeek-V2 はパフォーマンスが優れていると同時に、トレーニング コストを 42.5% 節約し、KV キャッシュを 93.3% 削減し、最大生成スループットを 5.76 倍に高めます。 DeepSeek は一般的な人工知能を研究する会社です

MLP に代わる KAN は、オープンソース プロジェクトによって畳み込みまで拡張されました

Jun 01, 2024 pm 10:03 PM

MLP に代わる KAN は、オープンソース プロジェクトによって畳み込みまで拡張されました

Jun 01, 2024 pm 10:03 PM

今月初め、MIT やその他の機関の研究者らは、MLP に代わる非常に有望な代替案である KAN を提案しました。 KAN は、精度と解釈可能性の点で MLP よりも優れています。また、非常に少数のパラメーターを使用して、多数のパラメーターを使用して実行する MLP よりも優れたパフォーマンスを発揮できます。たとえば、著者らは、KAN を使用して、より小規模なネットワークと高度な自動化で DeepMind の結果を再現したと述べています。具体的には、DeepMind の MLP には約 300,000 個のパラメーターがありますが、KAN には約 200 個のパラメーターしかありません。 KAN は、MLP が普遍近似定理に基づいているのに対し、KAN はコルモゴロフ-アーノルド表現定理に基づいているのと同様に、強力な数学的基礎を持っています。以下の図に示すように、KAN は

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas は正式に電動ロボットの時代に突入します!昨日、油圧式アトラスが歴史の舞台から「涙ながらに」撤退したばかりですが、今日、ボストン・ダイナミクスは電動式アトラスが稼働することを発表しました。ボストン・ダイナミクス社は商用人型ロボットの分野でテスラ社と競争する決意を持っているようだ。新しいビデオが公開されてから、わずか 10 時間ですでに 100 万人以上が視聴しました。古い人が去り、新しい役割が現れるのは歴史的な必然です。今年が人型ロボットの爆発的な年であることは間違いありません。ネットユーザーは「ロボットの進歩により、今年の開会式は人間のように見え、人間よりもはるかに自由度が高い。しかし、これは本当にホラー映画ではないのか?」とコメントした。ビデオの冒頭では、アトラスは仰向けに見えるように地面に静かに横たわっています。次に続くのは驚くべきことです

AI が数学研究を破壊する!フィールズ賞受賞者で中国系アメリカ人の数学者が上位 11 件の論文を主導 | テレンス・タオが「いいね!」しました

Apr 09, 2024 am 11:52 AM

AI が数学研究を破壊する!フィールズ賞受賞者で中国系アメリカ人の数学者が上位 11 件の論文を主導 | テレンス・タオが「いいね!」しました

Apr 09, 2024 am 11:52 AM

AI は確かに数学を変えつつあります。最近、この問題に細心の注意を払っている陶哲軒氏が『米国数学協会会報』(米国数学協会会報)の最新号を送ってくれた。 「機械は数学を変えるのか?」というテーマを中心に、多くの数学者が意見を述べ、そのプロセス全体は火花に満ち、ハードコアで刺激的でした。著者には、フィールズ賞受賞者のアクシャイ・ベンカテシュ氏、中国の数学者鄭楽軍氏、ニューヨーク大学のコンピューター科学者アーネスト・デイビス氏、その他業界で著名な学者を含む強力な顔ぶれが揃っている。 AI の世界は劇的に変化しています。これらの記事の多くは 1 年前に投稿されたものです。

超知性の生命力が覚醒する!しかし、自己更新 AI の登場により、母親はデータのボトルネックを心配する必要がなくなりました。

Apr 29, 2024 pm 06:55 PM

超知性の生命力が覚醒する!しかし、自己更新 AI の登場により、母親はデータのボトルネックを心配する必要がなくなりました。

Apr 29, 2024 pm 06:55 PM

世界は狂ったように大きなモデルを構築していますが、インターネット上のデータだけではまったく不十分です。このトレーニング モデルは「ハンガー ゲーム」のようであり、世界中の AI 研究者は、データを貪欲に食べる人たちにどのように餌を与えるかを心配しています。この問題は、マルチモーダル タスクで特に顕著です。何もできなかった当時、中国人民大学学部のスタートアップチームは、独自の新しいモデルを使用して、中国で初めて「モデル生成データフィード自体」を実現しました。さらに、これは理解側と生成側の 2 つの側面からのアプローチであり、両方の側で高品質のマルチモーダルな新しいデータを生成し、モデル自体にデータのフィードバックを提供できます。モデルとは何ですか? Awaker 1.0 は、中関村フォーラムに登場したばかりの大型マルチモーダル モデルです。チームは誰ですか?ソフォンエンジン。人民大学ヒルハウス人工知能大学院の博士課程学生、ガオ・イージャオ氏によって設立されました。

Kuaishou バージョンの Sora「Ke Ling」がテスト用に公開されています。120 秒以上のビデオを生成し、物理学をより深く理解し、複雑な動きを正確にモデル化できます。

Jun 11, 2024 am 09:51 AM

Kuaishou バージョンの Sora「Ke Ling」がテスト用に公開されています。120 秒以上のビデオを生成し、物理学をより深く理解し、複雑な動きを正確にモデル化できます。

Jun 11, 2024 am 09:51 AM

何?ズートピアは国産AIによって実現するのか?ビデオとともに公開されたのは、「Keling」と呼ばれる新しい大規模な国産ビデオ生成モデルです。 Sora も同様の技術的ルートを使用し、自社開発の技術革新を多数組み合わせて、大きく合理的な動きをするだけでなく、物理世界の特性をシミュレートし、強力な概念的結合能力と想像力を備えたビデオを制作します。データによると、Keling は、最大 1080p の解像度で 30fps で最大 2 分の超長時間ビデオの生成をサポートし、複数のアスペクト比をサポートします。もう 1 つの重要な点は、Keling は研究所が公開したデモやビデオ結果のデモンストレーションではなく、ショートビデオ分野のリーダーである Kuaishou が立ち上げた製品レベルのアプリケーションであるということです。さらに、主な焦点は実用的であり、白紙小切手を書かず、リリースされたらすぐにオンラインに移行することです。Ke Ling の大型モデルは Kuaiying でリリースされました。

アメリカ空軍が初のAI戦闘機を公開し注目を集める!大臣はプロセス全体を通じて干渉することなく個人的にテストを実施し、10万行のコードが21回にわたってテストされました。

May 07, 2024 pm 05:00 PM

アメリカ空軍が初のAI戦闘機を公開し注目を集める!大臣はプロセス全体を通じて干渉することなく個人的にテストを実施し、10万行のコードが21回にわたってテストされました。

May 07, 2024 pm 05:00 PM

最近、軍事界は、米軍戦闘機が AI を使用して完全自動空戦を完了できるようになったというニュースに圧倒されました。そう、つい最近、米軍のAI戦闘機が初めて公開され、その謎が明らかになりました。この戦闘機の正式名称は可変安定性飛行シミュレーター試験機(VISTA)で、アメリカ空軍長官が自ら飛行させ、一対一の空戦をシミュレートした。 5 月 2 日、フランク ケンダル米国空軍長官は X-62AVISTA でエドワーズ空軍基地を離陸しました。1 時間の飛行中、すべての飛行動作が AI によって自律的に完了されたことに注目してください。ケンダル氏は「過去数十年にわたり、私たちは自律型空対空戦闘の無限の可能性について考えてきたが、それは常に手の届かないものだと思われてきた」と語った。しかし今では、

テスラのロボットは工場で働く、マスク氏:手の自由度は今年22に達する!

May 06, 2024 pm 04:13 PM

テスラのロボットは工場で働く、マスク氏:手の自由度は今年22に達する!

May 06, 2024 pm 04:13 PM

テスラのロボット「オプティマス」の最新映像が公開され、すでに工場内で稼働可能となっている。通常の速度では、バッテリー(テスラの4680バッテリー)を次のように分類します:公式は、20倍の速度でどのように見えるかも公開しました - 小さな「ワークステーション」上で、ピッキング、ピッキング、ピッキング:今回は、それがリリースされたハイライトの1つビデオの内容は、オプティマスが工場内でこの作業を完全に自律的に行い、プロセス全体を通じて人間の介入なしに完了するというものです。そして、オプティマスの観点から見ると、自動エラー修正に重点を置いて、曲がったバッテリーを拾い上げたり配置したりすることもできます。オプティマスのハンドについては、NVIDIA の科学者ジム ファン氏が高く評価しました。オプティマスのハンドは、世界の 5 本指ロボットの 1 つです。最も器用。その手は触覚だけではありません