Python を使用して点群地面検出を実装する

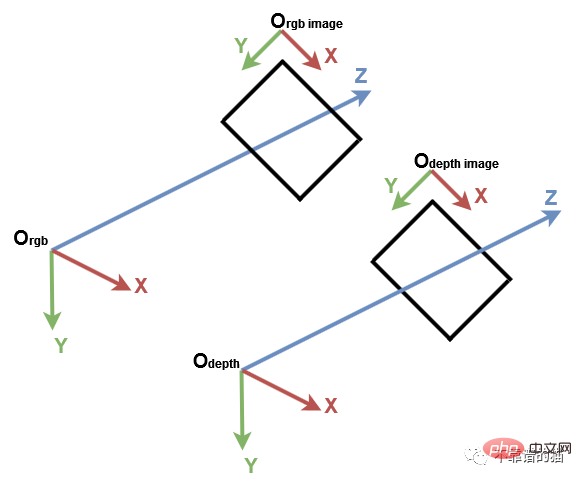

1. コンピューター ビジョンの座標系

始める前に、コンピューター ビジョンの従来の座標系を理解することが重要です。これに Open3D と Microsoft Kinect センサーが続きます。コンピューター ビジョンでは、画像は別の 2D 座標系で表されます。X 軸は左から右を指し、Y 軸は上下を指します。カメラの場合、3D 座標系の原点はカメラの焦点にあり、x 軸は右を指し、y 軸は下を指し、z 軸は前方を指します。

コンピュータ ビジョン座標系

最初に必要な Python ライブラリをインポートします:

import numpy as np import open3d as o3d

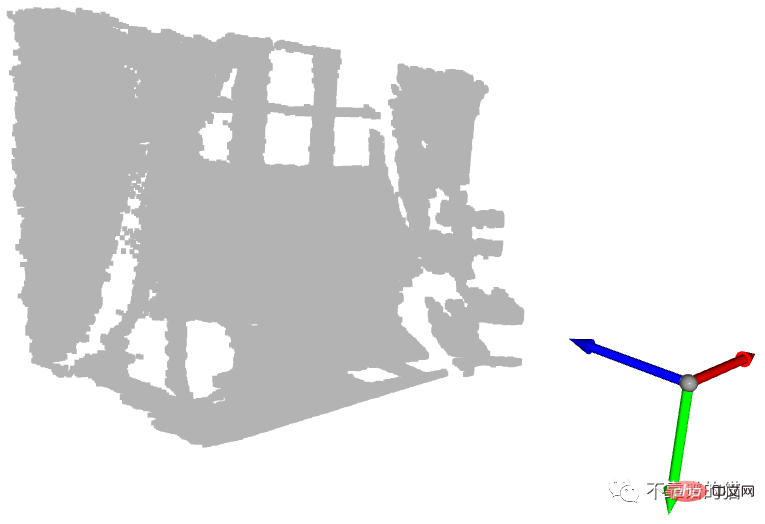

理解を助けるために、PLY ファイルから始めましょう。 Open3D を使用してデフォルトの 3D 座標系を作成し、表示します。

# Read point cloud:

pcd = o3d.io.read_point_cloud("data/depth_2_pcd.ply")

# Create a 3D coordinate system:

origin = o3d.geometry.TriangleMesh.create_coordinate_frame(size=0.5)

# geometries to draw:

geometries = [pcd, origin]

# Visualize:

o3d.visualization.draw_geometries(geometries)

座標系を使用して、点群を表示します。 origin

青い矢印は Z 軸、赤い矢印は X 軸、緑の矢印は Y 軸です。点群が Open3D 座標系と同じ座標系で表されていることがわかります。次に、各軸の最小値と最大値を持つ点を取得しましょう。

# Get max and min points of each axis x, y and z: x_max = max(pcd.points, key=lambda x: x[0]) y_max = max(pcd.points, key=lambda x: x[1]) z_max = max(pcd.points, key=lambda x: x[2]) x_min = min(pcd.points, key=lambda x: x[0]) y_min = min(pcd.points, key=lambda x: x[1]) z_min = min(pcd.points, key=lambda x: x[2])

それらは印刷できますが、視覚的にわかりやすくするために、各点の位置に球を作成します。デフォルトでは、Open3D は原点位置に 3D ジオメトリを作成します。

球を指定の位置に移動するには、平行移動変換が必要です。以下の例では、球はベクトル [1,1,1] によって変換されます。

例に戻り、各球に色を割り当ててみましょう。位置ごとに球を作成し、それをその位置に移動します。次に、正しい色を割り当て、最後にそれをディスプレイに追加します。

# Colors: RED = [1., 0., 0.] GREEN = [0., 1., 0.] BLUE = [0., 0., 1.] YELLOW = [1., 1., 0.] MAGENTA = [1., 0., 1.] CYAN = [0., 1., 1.] positions = [x_max, y_max, z_max, x_min, y_min, z_min] colors = [RED, GREEN, BLUE, MAGENTA, YELLOW, CYAN] for i in range(len(positions)): # Create a sphere mesh: sphere = o3d.geometry.TriangleMesh.create_sphere(radius=0.05) # move to the point position: sphere.translate(np.asarray(positions[i])) # add color: sphere.paint_uniform_color(np.asarray(colors[i])) # compute normals for vertices or faces: sphere.compute_vertex_normals() # add to geometry list to display later: geometries.append(sphere) # Display: o3d.visualization.draw_geometries(geometries)

実際、Y 軸は点の高さを表します。現実の世界では、最も高いボールは黄色のボールで、最も低いボールは緑です。ボール。ただし、y 軸は下向きであるため、黄色の球の値が最小となり、緑の球の値が最大になります。

もう 1 つの興味深い球は、原点にあるシアンの球です。前のチュートリアルで説明したように、深度値 0 のピクセルはノイズ ポイントであるため、原点に位置する点は、これらのノイズ ピクセルから計算された点になります (z=0 の場合、x=0、y= 0)。

2. 地面検出

いくつかの重要なポイントを示しましたが、地面検出を実行するにはどうすればよいでしょうか? 前の例では、緑色の球体が地面上にあります。正確に言うと、その中心は、地上点である y 軸に沿った最高点に対応します。地面検出のために、y_max を持つすべての点の色を緑に変更するとします。

点群を表示すると、すべての地面点が緑色であるわけではないことがわかります。実際、前の緑色の球の中心に対応する 1 つの点だけが緑色です。これは、深度カメラの精度とノイズが原因です。

この制限を克服するには、y 座標が [y_max-threshold, y_max] の点が地上点とみなされるように、しきい値を追加する必要があります。これを行うには、y_max を取得した後、各点の y 座標が間隔内にあるかどうかを確認し、その色を緑色に設定します。最後に、点群の色属性が更新され、結果が表示されます。

# Define a threshold: THRESHOLD = 0.075 # Get the max value along the y-axis: y_max = max(pcd.points, key=lambda x: x[1])[1] # Get the original points color to be updated: pcd_colors = np.asarray(pcd.colors) # Number of points: n_points = pcd_colors.shape[0] # update color: for i in range(n_points): # if the current point is aground point: if pcd.points[i][1] >= y_max - THRESHOLD: pcd_colors[i] = GREEN# color it green pcd.colors = o3d.utility.Vector3dVector(pcd_colors) # Display: o3d.visualization.draw_geometries([pcd, origin])

この例では、地面を表す点のみを緑色に着色します。実際のアプリケーションでは、ロボットや視覚障害者システムなどの歩行可能なエリアを定義したり、インテリア デザイン システムなどその上にオブジェクトを配置したりするために地面が抽出されます。これは削除することもできるので、シーン理解システムや物体検出システムのように、残りのポイントをセグメント化または分類することができます。

3. 整理された点群

点群は 3D 点のセットとして定義されることがわかっています。集合は順序付けされていない構造であるため、集合によって表される点群は非組織化点群と呼ばれます。 RGB マトリックスと同様に、組織化された点群は、点の x、y、z 座標を表す 3 つのチャネルを持つ 2D マトリックスです。マトリックス構造は隣接する点間の関係を提供するため、最近傍アルゴリズムなどの一部のアルゴリズムの時間の複雑さが軽減されます。

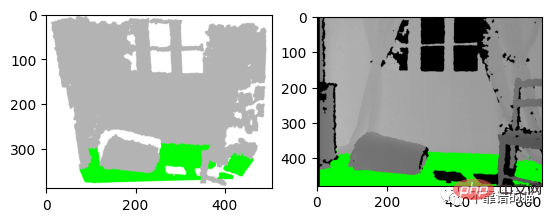

たとえば、研究論文を書いていて、検出アルゴリズムの結果をグラフの形式で表示したいと考えています。以下に示すように、点群のスクリーンショットを撮ることも、結果を深度画像に表示することもできます。私の意見では、2 番目のオプションが最善です。この場合、深度ピクセルの位置を保存するには、整理された点群が必要です。

左:3D 可视化的屏幕截图 右:深度图像的结果

让我们从之前的深度图像创建一个有组织的点云。我们首先导入相机参数。我们还导入深度图像并将其转换为3通道灰度图像,以便我们可以将地面像素设置为绿色:

import imageio.v3 as iio

import numpy as np

import matplotlib.pyplot as plt

# Camera parameters:

FX_DEPTH = 5.8262448167737955e+02

FY_DEPTH = 5.8269103270988637e+02

CX_DEPTH = 3.1304475870804731e+02

CY_DEPTH = 2.3844389626620386e+02

# Read depth image:

depth_image = iio.imread('../data/depth_2.png')

# Compute the grayscale image:

depth_grayscale = np.array(256 * depth_image / 0x0fff, dtype=np.uint8)

# Convert a grayscale image to a 3-channel image:

depth_grayscale = np.stack((depth_grayscale,) * 3, axis=-1)要计算一个有组织的点云,我们使用与上一篇教程相同的方法(Python:基于 RGB-D 图像的点云计算)。我们没有将深度图像扁平化,而是将jj和ii重塑为与深度图像相同的形状,如下所示:

# get depth image resolution: height, width = depth_image.shape # compute indices and reshape it to have the same shape as the depth image: jj = np.tile(range(width), height).reshape((height, width)) ii = np.repeat(range(height), width).reshape((height, width)) # Compute constants: xx = (jj - CX_DEPTH) / FX_DEPTH yy = (ii - CY_DEPTH) / FY_DEPTH # compute organised point cloud: organized_pcd = np.dstack((xx * depth_image, yy * depth_image, depth_image))

如果你打印出创建的点云的形状,你可以看到它是一个有3个通道的矩阵(480,640,3)。如果你觉得这个代码很难理解,请回到之前的教程(Python:基于 RGB-D 图像的点云计算)。

类似地,我们像上面那样检测地面,但不是更新点的颜色并显示点云,而是更新灰度图像的像素并显示它:

# Ground_detection: THRESHOLD = 0.075 * 1000# Define a threshold y_max = max(organized_pcd.reshape((height * width, 3)), key=lambda x: x[1])[ 1]# Get the max value along the y-axis # Set the ground pixels to green: for i in range(height): for j in range(width): if organized_pcd[i][j][1] >= y_max - THRESHOLD: depth_grayscale[i][j] = [0, 255, 0]# Update the depth image # Display depth_grayscale: plt.imshow(depth_grayscale) plt.show()

4.结论

在本教程中,为了熟悉点云,我们引入了默认坐标系统,并实现了一个简单的地面检测算法。事实上,地面检测在某些应用(如导航)中是一项重要的任务,文献中已经提出了几种算法。实现算法简单;它认为最低点是地面。然而,它的限制是,深度相机必须与地面平行,这是大多数现实应用的情况不是这样的。

以上がPython を使用して点群地面検出を実装するの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7569

7569

15

15

1386

1386

52

52

87

87

11

11

28

28

106

106

PHPおよびPython:コードの例と比較

Apr 15, 2025 am 12:07 AM

PHPおよびPython:コードの例と比較

Apr 15, 2025 am 12:07 AM

PHPとPythonには独自の利点と短所があり、選択はプロジェクトのニーズと個人的な好みに依存します。 1.PHPは、大規模なWebアプリケーションの迅速な開発とメンテナンスに適しています。 2。Pythonは、データサイエンスと機械学習の分野を支配しています。

Python vs. JavaScript:コミュニティ、ライブラリ、リソース

Apr 15, 2025 am 12:16 AM

Python vs. JavaScript:コミュニティ、ライブラリ、リソース

Apr 15, 2025 am 12:16 AM

PythonとJavaScriptには、コミュニティ、ライブラリ、リソースの観点から、独自の利点と短所があります。 1)Pythonコミュニティはフレンドリーで初心者に適していますが、フロントエンドの開発リソースはJavaScriptほど豊富ではありません。 2)Pythonはデータサイエンスおよび機械学習ライブラリで強力ですが、JavaScriptはフロントエンド開発ライブラリとフレームワークで優れています。 3)どちらも豊富な学習リソースを持っていますが、Pythonは公式文書から始めるのに適していますが、JavaScriptはMDNWebDocsにより優れています。選択は、プロジェクトのニーズと個人的な関心に基づいている必要があります。

Dockerの原則の詳細な説明

Apr 14, 2025 pm 11:57 PM

Dockerの原則の詳細な説明

Apr 14, 2025 pm 11:57 PM

DockerはLinuxカーネル機能を使用して、効率的で孤立したアプリケーションランニング環境を提供します。その作業原則は次のとおりです。1。ミラーは、アプリケーションを実行するために必要なすべてを含む読み取り専用テンプレートとして使用されます。 2。ユニオンファイルシステム(UnionFS)は、違いを保存するだけで、スペースを節約し、高速化する複数のファイルシステムをスタックします。 3.デーモンはミラーとコンテナを管理し、クライアントはそれらをインタラクションに使用します。 4。名前空間とcgroupsは、コンテナの分離とリソースの制限を実装します。 5.複数のネットワークモードは、コンテナの相互接続をサポートします。これらのコア概念を理解することによってのみ、Dockerをよりよく利用できます。

Visual StudioコードはPythonで使用できますか

Apr 15, 2025 pm 08:18 PM

Visual StudioコードはPythonで使用できますか

Apr 15, 2025 pm 08:18 PM

VSコードはPythonの書き込みに使用でき、Pythonアプリケーションを開発するための理想的なツールになる多くの機能を提供できます。ユーザーは以下を可能にします。Python拡張機能をインストールして、コードの完了、構文の強調表示、デバッグなどの関数を取得できます。デバッガーを使用して、コードを段階的に追跡し、エラーを見つけて修正します。バージョンコントロールのためにGitを統合します。コードフォーマットツールを使用して、コードの一貫性を維持します。糸くずツールを使用して、事前に潜在的な問題を発見します。

ターミナルVSCODEでプログラムを実行する方法

Apr 15, 2025 pm 06:42 PM

ターミナルVSCODEでプログラムを実行する方法

Apr 15, 2025 pm 06:42 PM

VSコードでは、次の手順を通じて端末でプログラムを実行できます。コードを準備し、統合端子を開き、コードディレクトリが端末作業ディレクトリと一致していることを確認します。プログラミング言語(pythonのpython your_file_name.pyなど)に従って実行コマンドを選択して、それが正常に実行されるかどうかを確認し、エラーを解決します。デバッガーを使用して、デバッグ効率を向上させます。

VSCODE拡張機能は悪意がありますか?

Apr 15, 2025 pm 07:57 PM

VSCODE拡張機能は悪意がありますか?

Apr 15, 2025 pm 07:57 PM

VSコード拡張機能は、悪意のあるコードの隠れ、脆弱性の活用、合法的な拡張機能としての自慰行為など、悪意のあるリスクを引き起こします。悪意のある拡張機能を識別する方法には、パブリッシャーのチェック、コメントの読み取り、コードのチェック、およびインストールに注意してください。セキュリティ対策には、セキュリティ認識、良好な習慣、定期的な更新、ウイルス対策ソフトウェアも含まれます。

Windows 8でコードを実行できます

Apr 15, 2025 pm 07:24 PM

Windows 8でコードを実行できます

Apr 15, 2025 pm 07:24 PM

VSコードはWindows 8で実行できますが、エクスペリエンスは大きくない場合があります。まず、システムが最新のパッチに更新されていることを確認してから、システムアーキテクチャに一致するVSコードインストールパッケージをダウンロードして、プロンプトとしてインストールします。インストール後、一部の拡張機能はWindows 8と互換性があり、代替拡張機能を探すか、仮想マシンで新しいWindowsシステムを使用する必要があることに注意してください。必要な拡張機能をインストールして、適切に動作するかどうかを確認します。 Windows 8ではVSコードは実行可能ですが、開発エクスペリエンスとセキュリティを向上させるために、新しいWindowsシステムにアップグレードすることをお勧めします。

Python:自動化、スクリプト、およびタスク管理

Apr 16, 2025 am 12:14 AM

Python:自動化、スクリプト、およびタスク管理

Apr 16, 2025 am 12:14 AM

Pythonは、自動化、スクリプト、およびタスク管理に優れています。 1)自動化:OSやShutilなどの標準ライブラリを介してファイルバックアップが実現されます。 2)スクリプトの書き込み:Psutilライブラリを使用してシステムリソースを監視します。 3)タスク管理:スケジュールライブラリを使用してタスクをスケジュールします。 Pythonの使いやすさと豊富なライブラリサポートにより、これらの分野で優先ツールになります。