今日、衝撃的な「逆転」がAI界に衝撃を与えた。

Google Brain の NLP 基礎研究であり、Transformer アーキテクチャを提案する先駆的な論文である「Attending Is All Your Need」の図が、コードと矛盾していることがネットユーザーによって発見されました。

論文アドレス: https://arxiv.org/abs/1706.03762

2017 年の創設以来、Transformer は AI 分野の基礎王となっています。人気の ChatGPT の本当の黒幕も彼です。

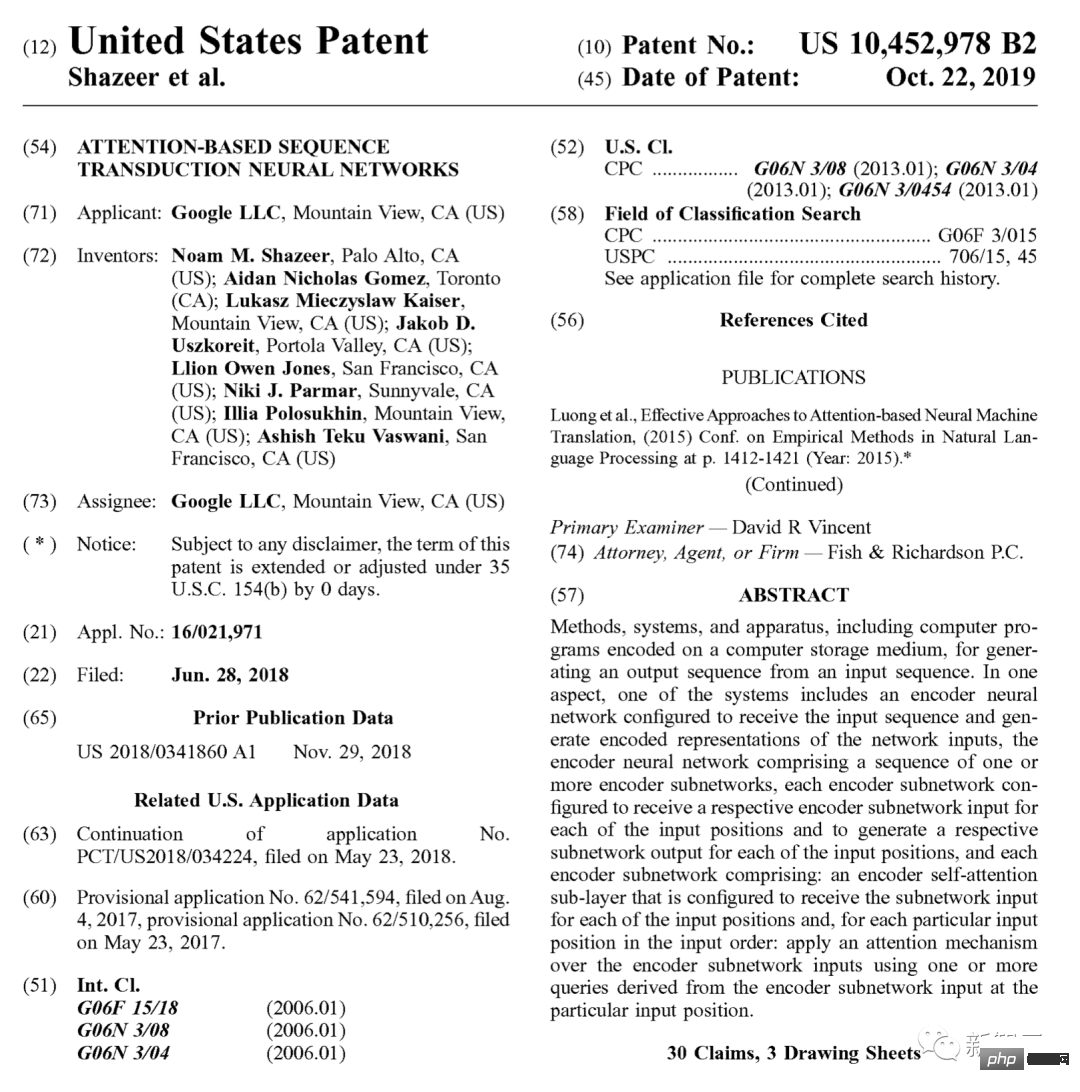

2019 年、Google もこれに特化した特許を申請しました。

原点を遡ると、無限に出現するあらゆる種類の GPT (Generative Pre-trained Transformer)ストリームはすべてこの記事から生まれました 17 年間の論文。

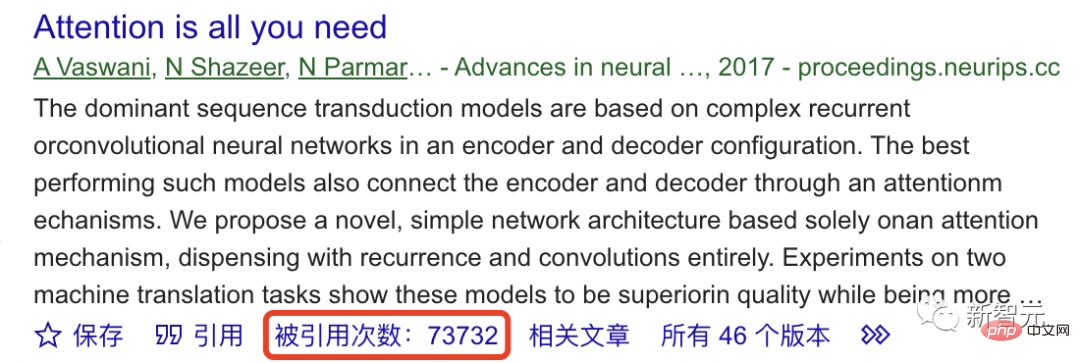

Google Scholar によると、これまでのところ、この基礎的な研究は 70,000 回以上引用されています。

ChatGPT の基礎は安定していないということですか?

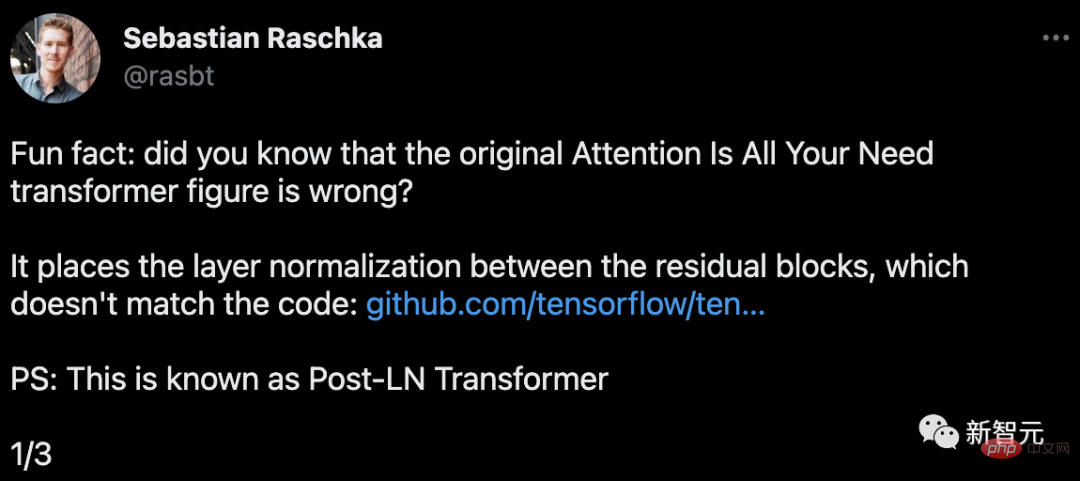

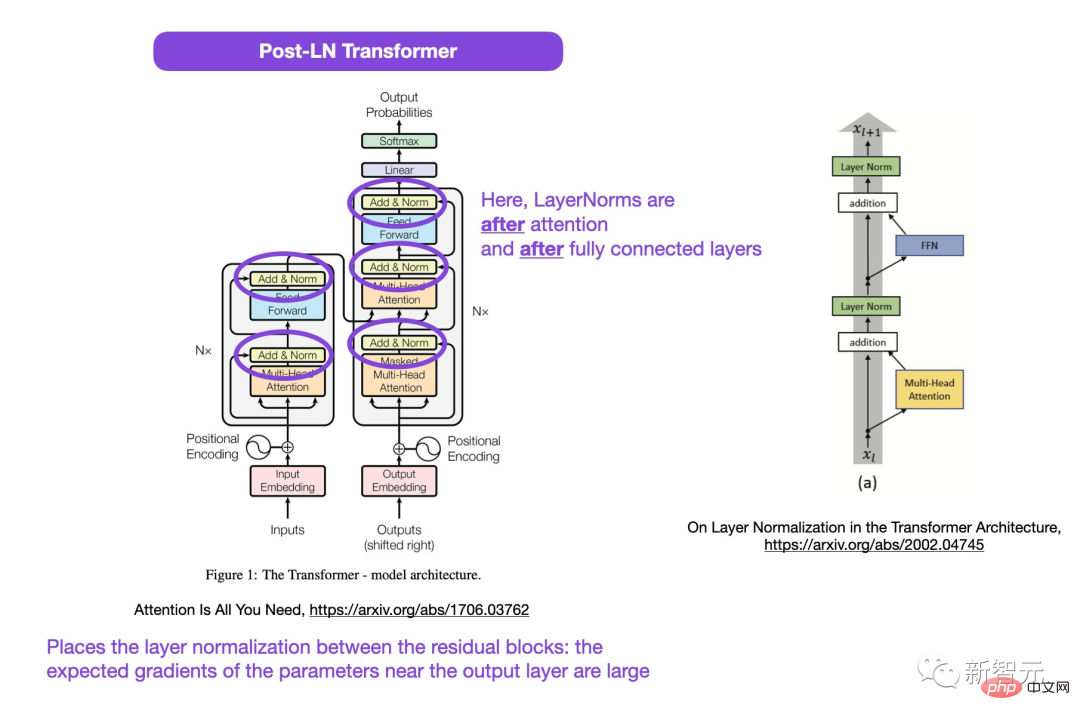

論文の「発案者」として、構造図は実は間違っているのでしょうか?Lightning AI の創設者で機械学習の研究者である Sebastian Raschka は、この論文の Transformer 図が間違っていることを発見しました。

また、これはコードと矛盾しています。

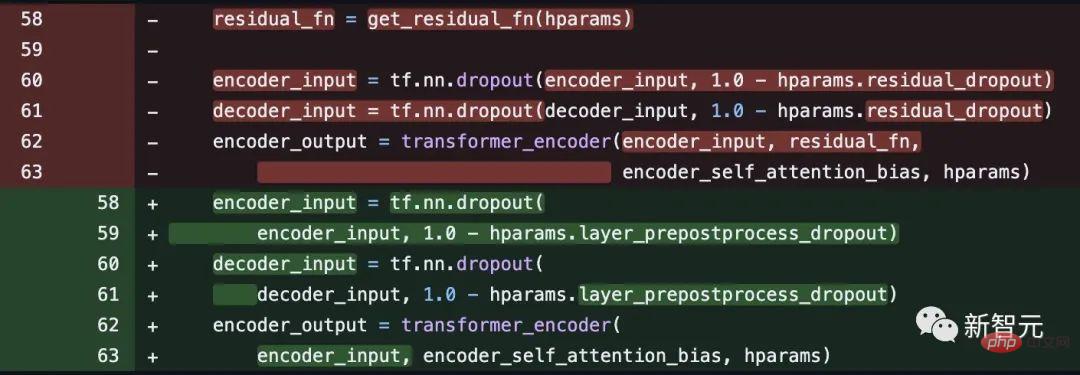

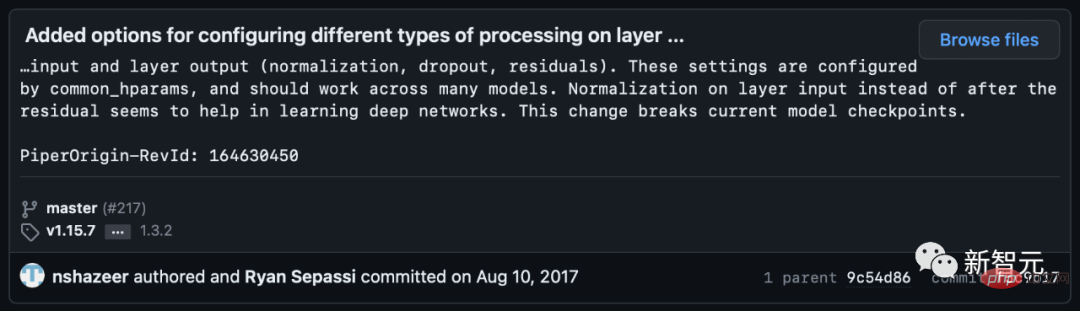

しかし、一部のネチズンは、数週間後にノーム・シェイザー氏がコードを修正したと指摘した。

レイヤーの正規化を注目レイヤーと完全に接続されたレイヤーの前の残りの接続に配置すると、より良い勾配が実現されます。

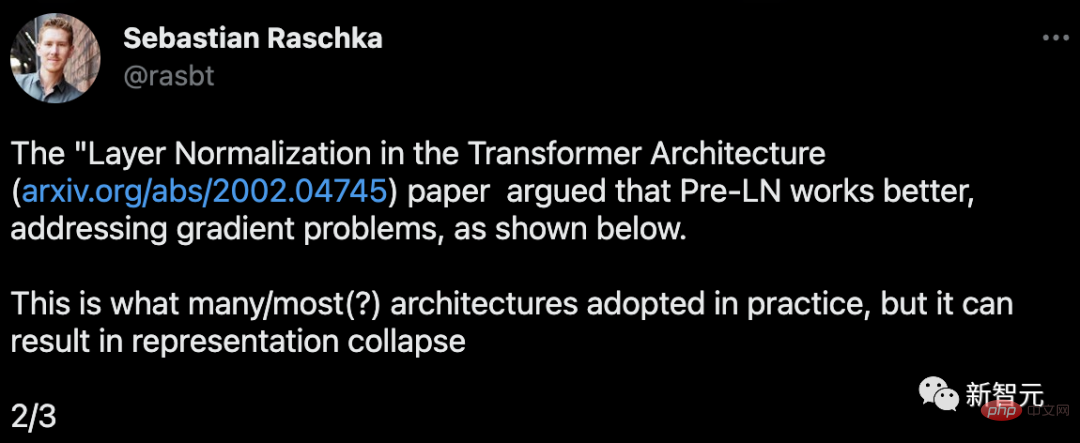

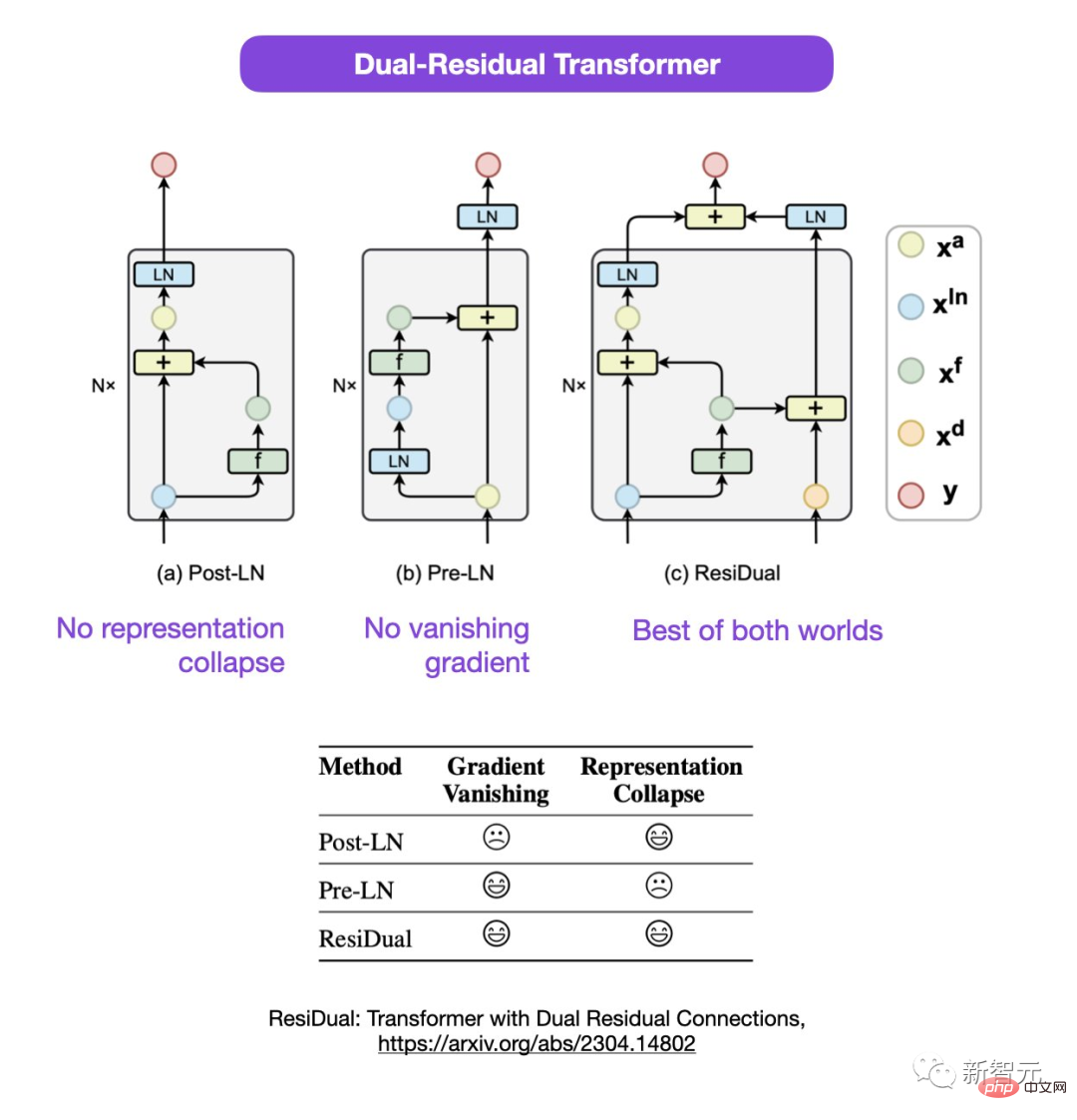

Sebastian は、Post-LN または Pre-LN の使用についての議論はまだ進行中ですが、この 2 つを組み合わせることを提案する新しい論文もあると指摘しました。

文書アドレス: https://arxiv.org/abs/2304.14802

この二重残差 Transformer では、表現の崩壊と勾配の消失の問題が解決されます。

論文の疑わしい点について、一部のネチズンは次のように指摘しました。すでに中間のものはありませんか? PreLN と PostLN を学習しましたか?

セバスチャンは、自分も少し変な気がすると答えました。おそらく 2nd LN は各トランスブロックではなく最後の出力層を指しているのかもしれませんが、彼もそれについてはよくわかりません。

一部のネチズンは次のように述べています。「コードや結果と一致しない論文によく遭遇します。それらのほとんどは期限切れです。」 「間違っていますが、時々、人々は非常に奇妙です。この論文は長い間広まっていましたが、なぜこの種の質問がこれまで提起されなかったのか、それは本当に奇妙です。」

Sebastian 氏は、公平を期すために、元のコードは画像と一致していましたが、2017 年にコード バージョンを修正しましたが、画像は更新しなかったと述べました。したがって、これは混乱を招きます。

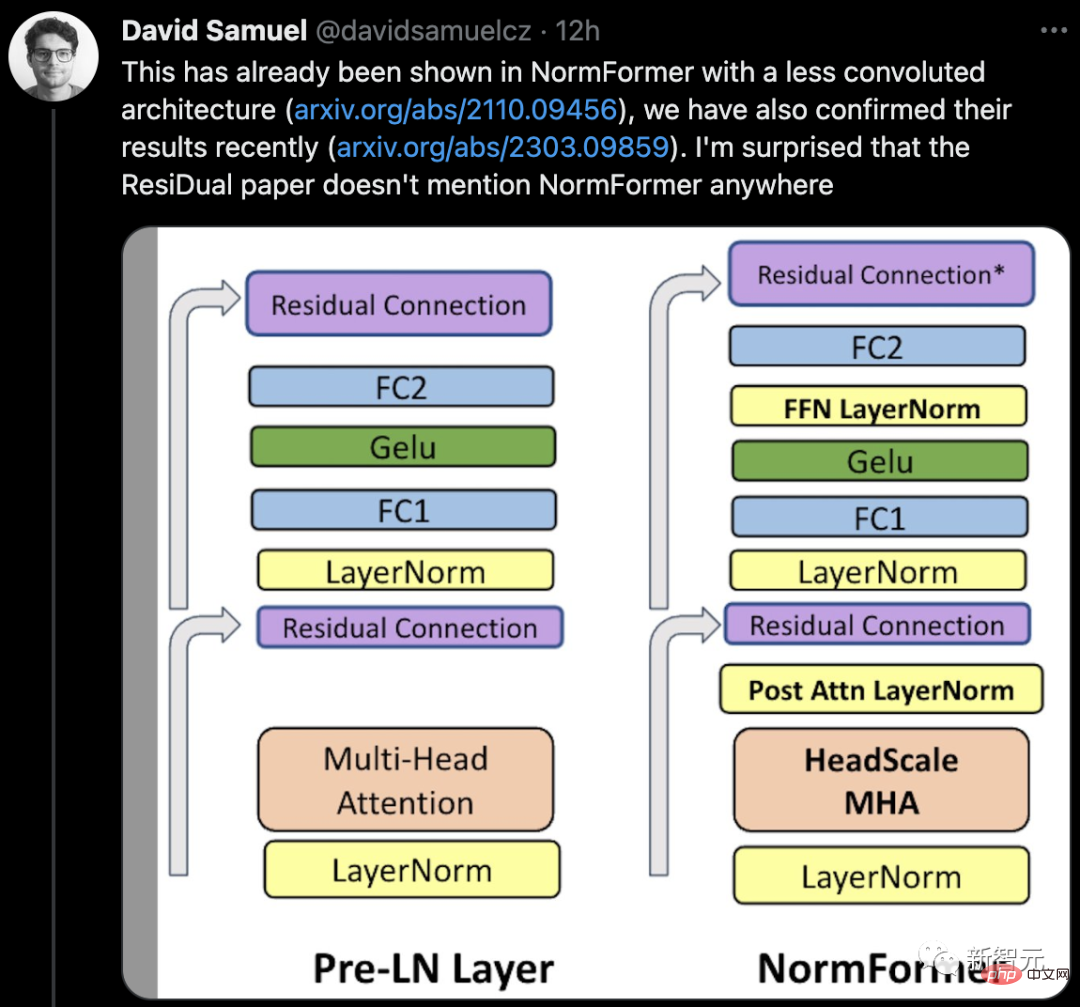

一部のネチズンは、NormFormer と彼のチームのそれほど複雑ではないアーキテクチャを示す論文がすでにあると述べました。その結果もまた、最近確認されました。 ResiDual の論文では NormFormer についてどこにも言及されていませんが、これは驚くべきことです。

###### ### 。 ########################################つまり、この論文には本当に抜け穴があるということです。自分の事件? ############次に何が起こるか見てみましょう。 ######

以上がトランスフォーマーの先駆的な論文は衝撃的ですか?画像とコードが矛盾してるし謎のバグでバカになるの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。