NginxサーバーでTCPの負荷分散を構成する方法

1. nginx のインストール

1. nginx のダウンロード

# wget http://nginx.org/download/nginx-1.2.4.tar.gz

2. TCP モジュール パッチのダウンロード

# wget https://github.com/yaoweibin/nginx_tcp_proxy_module/tarball/master

ソース コードのホームページ: https://github.com/yaoweibin/nginx_tcp_proxy_module

3. nginx

# tar xvf nginx-1.2.4.tar.gz # tar xvf yaoweibin-nginx_tcp_proxy_module-v0.4-45-ga40c99a.tar.gz # cd nginx-1.2.4 # patch -p1 < ../yaoweibin-nginx_tcp_proxy_module-a40c99a/tcp.patch #./configure --prefix=/usr/local/nginx --with-pcre=../pcre-8.30 --add-module=../yaoweibin-nginx_tcp_proxy_module-ae321fd/ # make # make install

2. 設定ファイルを変更します

nginx を変更します.conf 設定ファイル

# cd /usr/local/nginx/conf # vim nginx.conf

worker_processes 1;

events {

worker_connections 1024;

}

tcp {

upstream mssql {

server 10.0.1.201:1433;

server 10.0.1.202:1433;

check interval=3000 rise=2 fall=5 timeout=1000;

}

server {

listen 1433;

server_name 10.0.1.212;

proxy_pass mssql;

}

}3. nginx

# cd /usr/local/nginx/sbin/ # ./nginx

View 1433 ポートを開始します:

#lsof :1433

4. テスト

# telnet 10.0.1.201 1433

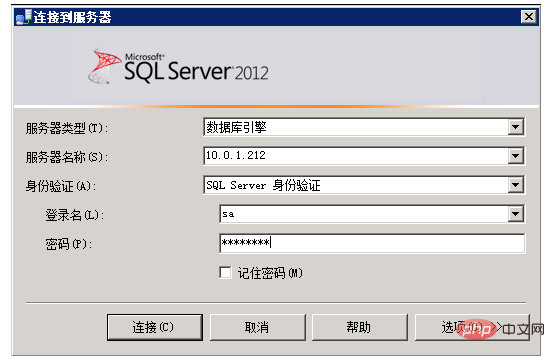

5. SQL サーバー クライアント ツールを使用してテスト

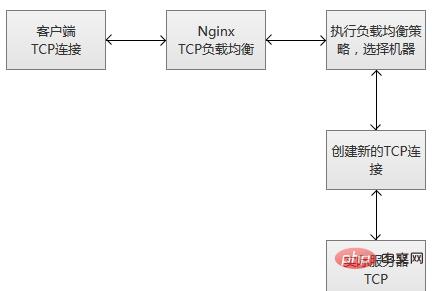

6. TCP ロード バランシングの実行原理

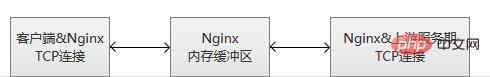

nginx は、リスニング ポートから新しいクライアント リンクを受信すると、すぐにルーティング スケジューリング アルゴリズムを実行し、接続する必要がある指定されたサービス IP を取得して、指定されたサーバーへの新しいアップストリーム接続を作成します。

ps: サービスの堅牢性モニタリング

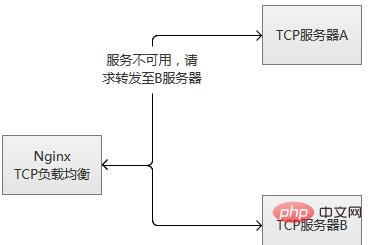

tcp ロード バランシング モジュールは、組み込みの堅牢性検出をサポートしています。上流サーバーが proxy_connect_timeout で設定された時間を超えて tcp 接続を拒否した場合、期限が切れたものとみなされます。この場合、nginx はすぐにアップストリーム グループ内の別の通常のサーバーへの接続を試みます。接続失敗情報はnginxエラーログに記録されます。 (2) 「よく使用される」データを事前に準備し、サービスを積極的に「プレヒート」し、プレヒート完了後にサーバーへのアクセスをオープンします。

TCP ロード バランシング モジュールは、組み込みの堅牢性検出をサポートしています。上流サーバーが proxy_connect_timeout で設定された時間を超えて TCP 接続を拒否した場合、失敗したものとみなされます。この場合、nginx はすぐにアップストリーム グループ内の別の通常のサーバーへの接続を試みます。接続失敗情報はnginxエラーログに記録されます。

サーバーが繰り返し失敗した場合(max_failsまたはfail_timeoutで設定されたパラメータを超えた場合)、nginxはサーバーもキックします。サーバーが起動されてから 60 秒後、nginx はサーバーが通常に戻っているかどうかを確認するために時々再接続を試みます。サーバーが正常に戻ると、nginx はそのサーバーをアップストリーム グループに追加し、接続リクエストの割合を徐々に増やします。

「徐々に増加している」理由は、通常、サービスには「ホット データ」があるためです。つまり、リクエストの 80% 以上、またはそれ以上が実際に「ホット データ キャッシュ」でブロックされるためです。 、実際に処理されるのはリクエストのほんの一部だけです。マシンが起動したばかりのときは、実際には「ホット データ キャッシュ」が確立されておらず、この時点で大量のリクエストが爆発的に転送されるため、マシンが耐えられなくなり、再びハングアップする可能性があります。 。 mysql を例にとると、通常、mysql クエリの 95% 以上がメモリ キャッシュに分類され、実際に実行されるクエリはそれほど多くありません。

実際には、単一マシンであってもクラスターであっても、同時要求の多いシナリオでの再起動や切り替えにはこのリスクが伴います。これを解決するには主に 2 つの方法があります:

(1 ) リクエストは、少ない状態から多い状態へと徐々に増加し、ホットスポット データが徐々に蓄積され、最終的には通常のサービス状態に達します。

(2) 「よく使用される」データを事前に準備し、サービスを積極的に「プレヒート」し、プレヒート完了後にサーバーへのアクセスをオープンします。

tcp ロード バランシングの原理は lvs の原理と同じで、より低いレベルで動作し、そのパフォーマンスは元の http ロード バランシングよりもはるかに高くなります。ただし、lvs よりも優れているわけではなく、lvs はカーネル モジュール内に配置されますが、nginx はユーザー モードで動作し、nginx は比較的重いです。もう一つ、非常に残念なのが、このモジュールが有料機能であることです。

以上がNginxサーバーでTCPの負荷分散を構成する方法の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7537

7537

15

15

1380

1380

52

52

82

82

11

11

21

21

86

86

Nginxが開始されるかどうかを確認する方法

Apr 14, 2025 pm 01:03 PM

Nginxが開始されるかどうかを確認する方法

Apr 14, 2025 pm 01:03 PM

nginxが開始されるかどうかを確認する方法:1。コマンドラインを使用します:SystemCTLステータスnginx(Linux/unix)、netstat -ano | FindStr 80(Windows); 2。ポート80が開いているかどうかを確認します。 3.システムログのnginx起動メッセージを確認します。 4. Nagios、Zabbix、Icingaなどのサードパーティツールを使用します。

Linuxでnginxを開始する方法

Apr 14, 2025 pm 12:51 PM

Linuxでnginxを開始する方法

Apr 14, 2025 pm 12:51 PM

Linuxでnginxを開始する手順:nginxがインストールされているかどうかを確認します。 systemctlを使用して、nginxを開始してnginxサービスを開始します。 SystemCTLを使用して、NGINXがシステムスタートアップでNGINXの自動起動を有効にすることができます。 SystemCTLステータスNGINXを使用して、スタートアップが成功していることを確認します。 Webブラウザのhttp:// localhostにアクセスして、デフォルトのウェルカムページを表示します。

Nginxが起動されているかどうかを確認する方法は?

Apr 14, 2025 pm 12:48 PM

Nginxが起動されているかどうかを確認する方法は?

Apr 14, 2025 pm 12:48 PM

Linuxでは、次のコマンドを使用して、nginxが起動されるかどうかを確認します。SystemCTLステータスNGINXコマンド出力に基づいて、「アクティブ:アクティブ(実行)」が表示された場合、NGINXが開始されます。 「アクティブ:非アクティブ(dead)」が表示されると、nginxが停止します。

Windowsでnginxを構成する方法

Apr 14, 2025 pm 12:57 PM

Windowsでnginxを構成する方法

Apr 14, 2025 pm 12:57 PM

Windowsでnginxを構成する方法は? nginxをインストールし、仮想ホスト構成を作成します。メイン構成ファイルを変更し、仮想ホスト構成を含めます。 nginxを起動またはリロードします。構成をテストし、Webサイトを表示します。 SSLを選択的に有効にし、SSL証明書を構成します。ファイアウォールを選択的に設定して、ポート80および443のトラフィックを許可します。

nginx403を解く方法

Apr 14, 2025 am 10:33 AM

nginx403を解く方法

Apr 14, 2025 am 10:33 AM

Nginx 403禁止エラーを修正する方法は?ファイルまたはディレクトリの許可を確認します。 2。HTACCESSファイルを確認します。 3. nginx構成ファイルを確認します。 4。nginxを再起動します。他の考えられる原因には、ファイアウォールルール、Selinux設定、またはアプリケーションの問題が含まれます。

nginxサーバーを開始する方法

Apr 14, 2025 pm 12:27 PM

nginxサーバーを開始する方法

Apr 14, 2025 pm 12:27 PM

NGINXサーバーを起動するには、異なるオペレーティングシステムに従って異なる手順が必要です。Linux/UNIXシステム:NGINXパッケージをインストールします(たとえば、APT-GetまたはYumを使用)。 SystemCtlを使用して、NGINXサービスを開始します(たとえば、Sudo SystemCtl Start NGinx)。 Windowsシステム:Windowsバイナリファイルをダウンロードしてインストールします。 nginx.exe実行可能ファイルを使用してnginxを開始します(たとえば、nginx.exe -c conf \ nginx.conf)。どのオペレーティングシステムを使用しても、サーバーIPにアクセスできます

Nginxクロスドメインの問題を解決する方法

Apr 14, 2025 am 10:15 AM

Nginxクロスドメインの問題を解決する方法

Apr 14, 2025 am 10:15 AM

Nginxクロスドメインの問題を解決するには2つの方法があります。クロスドメイン応答ヘッダーの変更:ディレクティブを追加して、クロスドメイン要求を許可し、許可されたメソッドとヘッダーを指定し、キャッシュ時間を設定します。 CORSモジュールを使用します。モジュールを有効にし、CORSルールを構成して、ドメインクロスリクエスト、メソッド、ヘッダー、キャッシュ時間を許可します。

nginxの実行ステータスを確認する方法

Apr 14, 2025 am 11:48 AM

nginxの実行ステータスを確認する方法

Apr 14, 2025 am 11:48 AM

nginxの実行ステータスを表示する方法は次のとおりです。PSコマンドを使用してプロセスステータスを表示します。 nginx configuration file /etc/nginx/nginx.confを表示します。 NGINXステータスモジュールを使用して、ステータスエンドポイントを有効にします。 Prometheus、Zabbix、Nagiosなどの監視ツールを使用します。