Nginxサーバーのソケットセグメンテーションとは何ですか

nginx の 1.9.1 リリースでは、so_reuseport ソケット オプションの使用を許可する新機能が導入されています。このオプションは、dragonfly bsd や linux (カーネル バージョン 3.9 以降) を含む多くのオペレーティング システムの新しいバージョンで利用できます。このソケット オプションを使用すると、複数のソケットが同じ IP とポートの組み合わせでリッスンできるようになります。カーネルは、これらのソケット間で受信接続の負荷を分散できます。 (nginx Plus の顧客の場合、この機能は年末までにリリースされるバージョン 7 に追加される予定です)

so_reuseport オプションには多くの実用的なアプリケーションの可能性があります。他のサービスもこれを使用して、実行中にローリング アップグレードを単純に実装できます (nginx はすでにローリング アップグレードをサポートしています)。 nginx の場合、このオプションを有効にすると、特定のシナリオでロックの競合が軽減され、パフォーマンスが向上します。

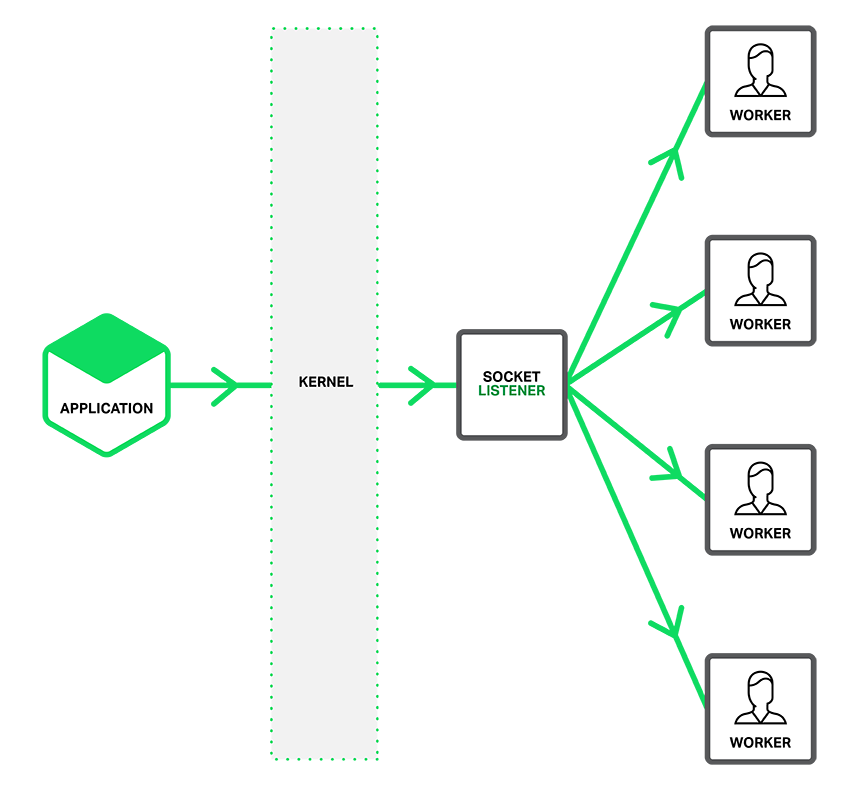

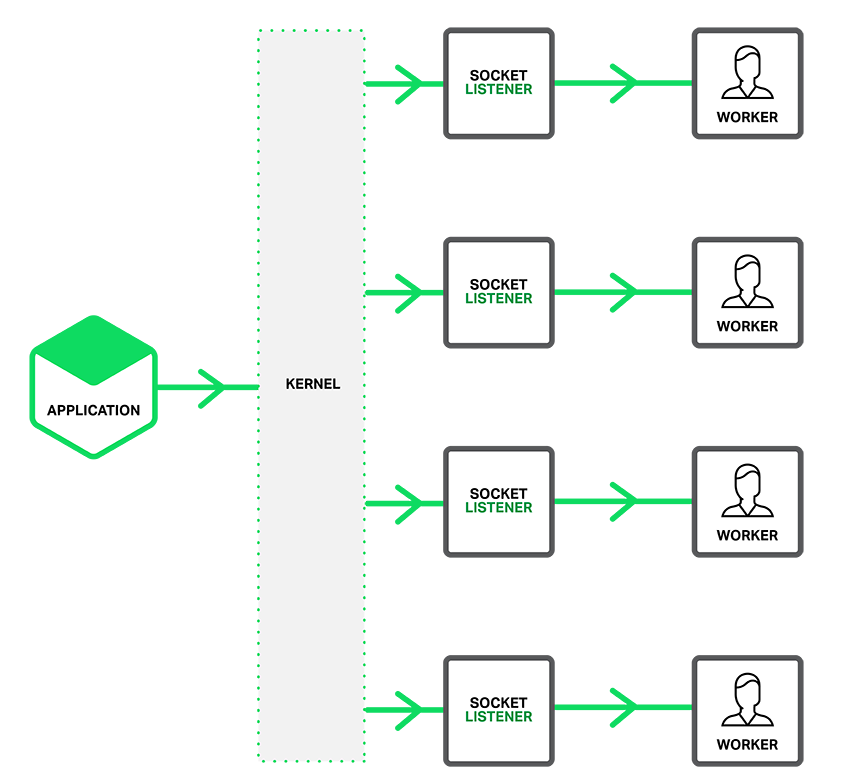

次の図で説明されているように、so_reuseport オプションが有効な場合、別のリッスン ソケットがアクセスされた接続をワーカー プロセスに通知し、各ワーカー スレッドが接続の取得を試みます。

so_reuseport オプションが有効な場合、IP アドレスとポート バインディング接続ごとに複数のソケット リスナーが存在し、各ワーカー プロセスに 1 つを割り当てることができます。システム カーネルは、どの有効なソケット リスナー (そして暗黙的にどのワーカー プロセスに対して) が接続を取得するかを決定します。これにより、新しい接続を取得する際のワーカー プロセス間のロックの競合 (翻訳者注: 相互に排他的なリソース ロックの取得を要求するワーカー プロセス間の競合) が減少し、マルチコア システムのパフォーマンスが向上します。ただし、これは、ワーカー プロセスがブロッキング操作に陥った場合、そのブロッキングは接続を受け入れたワーカー プロセスに影響するだけでなく、カーネルによって割り当てられるようにスケジュールされたワーカー プロセスにも接続要求を送信させることになることも意味します。ブロックされてしまう。

共有ソケットのセットアップ

so_reuseport ソケット オプションが機能するには、http または tcp である必要があります。 (ストリーム モード) 通信オプションの listen 項目は、次の例のように、最新の再利用ポート パラメーターを直接導入します。

コードをコピーします。 コードは次のとおりです。

http {

server { listen 80 reuseport;

}

reuseport パラメータを参照した後は、ミューテックス (mutex) が再利用ポートに対して冗長であるため、accept_mutex パラメータは参照されたソケットに対して無効になります。再利用ポートを使用しないポートの場合でも、accept_mutex を設定することが重要です。

Reuseport のベンチマーク パフォーマンス テスト

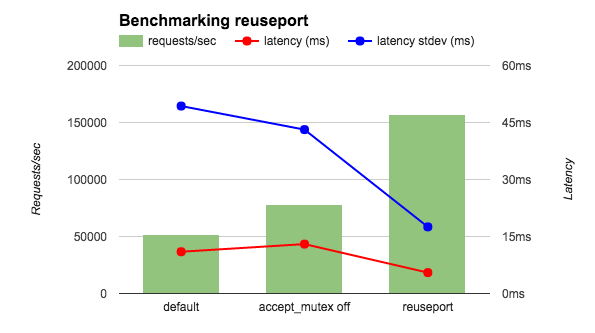

私は 36 コア AWS インスタンスでベンチマーク ツールを実行し、4 つの nginx ワーカー プロセスをテストしました。ネットワーク、クライアントと nginx の両方の影響を軽減するためにローカルで実行している場合、nginx はファイルの代わりに ok 文字列を返します。 3 つの nginx 設定、default (accept_mutex on に相当)、accept_mutex off、reuseport を比較しました。図に示されているように、reuseport の 1 秒あたりのリクエストは他のリクエストの 2 ~ 3 倍であり、レイテンシとレイテンシの標準偏差も減少しています。

latency (ms) latency stdev (ms) cpuload

accept_mutex off 15.59 26.48 10 reuseport 12.35 3.15 0.3

reuseport 12.35 3.15 0.3

これらのパフォーマンス テストでは、接続リクエストの速度は非常に高速ですが、リクエストに多くの処理は必要ありません。他の基本的なテストでは、アプリケーション トラフィックがこのシナリオに適合する場合、再利用ポートでもパフォーマンスが大幅に向上する可能性があることを指摘する必要があります。 (reuseport パラメーターは、電子メールなどのメール コンテキストの listen ディレクティブでは使用できません。電子メールのトラフィックはこのシナリオに間違いなく一致しないためです。) 大規模に直接適用するのではなく、最初にテストすることをお勧めします。

以上がNginxサーバーのソケットセグメンテーションとは何ですかの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7338

7338

9

9

1627

1627

14

14

1352

1352

46

46

1265

1265

25

25

1210

1210

29

29

Tomcat サーバーへの外部ネットワーク アクセスを許可する方法

Apr 21, 2024 am 07:22 AM

Tomcat サーバーへの外部ネットワーク アクセスを許可する方法

Apr 21, 2024 am 07:22 AM

Tomcat サーバーが外部ネットワークにアクセスできるようにするには、以下を行う必要があります。 外部接続を許可するように Tomcat 構成ファイルを変更します。 Tomcat サーバー ポートへのアクセスを許可するファイアウォール ルールを追加します。 Tomcat サーバーのパブリック IP を指すドメイン名を指す DNS レコードを作成します。オプション: リバース プロキシを使用して、セキュリティとパフォーマンスを向上させます。オプション: セキュリティを強化するために HTTPS を設定します。

thinkphpの実行方法

Apr 09, 2024 pm 05:39 PM

thinkphpの実行方法

Apr 09, 2024 pm 05:39 PM

ThinkPHP フレームワークをローカルで実行する手順: ThinkPHP フレームワークをローカル ディレクトリにダウンロードして解凍します。 ThinkPHP ルート ディレクトリを指す仮想ホスト (オプション) を作成します。データベース接続パラメータを構成します。 Webサーバーを起動します。 ThinkPHP アプリケーションを初期化します。 ThinkPHP アプリケーションの URL にアクセスして実行します。

nginxの起動コマンドと停止コマンドとは何ですか?

Apr 02, 2024 pm 08:45 PM

nginxの起動コマンドと停止コマンドとは何ですか?

Apr 02, 2024 pm 08:45 PM

Nginx の開始コマンドと停止コマンドは、それぞれ nginx と nginx -s quit です。 start コマンドはサーバーを直接起動し、stop コマンドはサーバーを正常にシャットダウンして、現在のすべてのリクエストを処理できるようにします。その他の使用可能な停止信号には、停止およびリロードがあります。

nginx へようこそ!それを解決するにはどうすればよいですか?

Apr 17, 2024 am 05:12 AM

nginx へようこそ!それを解決するにはどうすればよいですか?

Apr 17, 2024 am 05:12 AM

「nginx へようこそ!」エラーを解決するには、仮想ホスト構成を確認し、仮想ホストを有効にし、Nginx をリロードする必要があります。仮想ホスト構成ファイルが見つからない場合は、デフォルト ページを作成して Nginx をリロードすると、エラー メッセージが表示されます。が消え、ウェブサイトは通常のショーになります。

Nodejsプロジェクトをサーバーにデプロイする方法

Apr 21, 2024 am 04:40 AM

Nodejsプロジェクトをサーバーにデプロイする方法

Apr 21, 2024 am 04:40 AM

Node.js プロジェクトのサーバー デプロイメント手順: デプロイメント環境を準備します。サーバー アクセスの取得、Node.js のインストール、Git リポジトリのセットアップ。アプリケーションをビルドする: npm run build を使用して、デプロイ可能なコードと依存関係を生成します。コードをサーバーにアップロードします: Git またはファイル転送プロトコル経由。依存関係をインストールする: サーバーに SSH で接続し、npm install を使用してアプリケーションの依存関係をインストールします。アプリケーションを開始します。node Index.js などのコマンドを使用してアプリケーションを開始するか、pm2 などのプロセス マネージャーを使用します。リバース プロキシの構成 (オプション): Nginx や Apache などのリバース プロキシを使用して、トラフィックをアプリケーションにルーティングします。

phpmyadminの登録方法

Apr 07, 2024 pm 02:45 PM

phpmyadminの登録方法

Apr 07, 2024 pm 02:45 PM

phpMyAdmin に登録するには、まず MySQL ユーザーを作成して権限を付与し、次に phpMyAdmin をダウンロード、インストール、構成し、最後に phpMyAdmin にログインしてデータベースを管理する必要があります。

ウェブサイトにアクセスする際のnginxの問題を解決する方法

Apr 02, 2024 pm 08:39 PM

ウェブサイトにアクセスする際のnginxの問題を解決する方法

Apr 02, 2024 pm 08:39 PM

Web サイトにアクセスすると nginx が表示されます。その理由としては、サーバーのメンテナンス、サーバーのビジー状態、ブラウザーのキャッシュ、DNS の問題、ファイアウォールのブロック、Web サイトの構成ミス、ネットワーク接続の問題、Web サイトのダウンなどが考えられます。次の解決策を試してください: メンテナンスが終了するまで待つ、オフピーク時間にアクセスする、ブラウザのキャッシュをクリアする、DNS キャッシュをフラッシュする、ファイアウォールまたはウイルス対策ソフトウェアを無効にする、サイト管理者に連絡する、ネットワーク接続を確認する、または検索エンジンを使用するWeb アーカイブを使用して、サイトの別のコピーを見つけます。問題が解決しない場合は、サイト管理者にお問い合わせください。

Dockerコンテナ間で通信する方法

Apr 07, 2024 pm 06:24 PM

Dockerコンテナ間で通信する方法

Apr 07, 2024 pm 06:24 PM

Docker 環境でのコンテナ通信には、共有ネットワーク、Docker Compose、ネットワーク プロキシ、共有ボリューム、メッセージ キューの 5 つの方法があります。分離とセキュリティのニーズに応じて、Docker Compose を利用して接続を簡素化するか、ネットワーク プロキシを使用して分離を強化するなど、最も適切な通信方法を選択します。