ChatGPT アプリケーションは急成長していますが、安全なビッグ データベースはどこで見つけられますか?

AIGC が人類社会に重大な変化をもたらしていることは疑いの余地がありません。

まばゆいばかりの華やかな外観を脱ぎ捨てても、その運用の中核は膨大なデータのサポートから切り離すことはできません。

ChatGPT の「侵入」は、あらゆる分野でコンテンツの盗用に対する懸念を引き起こし、ネットワーク データ セキュリティに対する意識を高めています。

AI テクノロジーは中立的ですが、責任や義務を回避する理由にはなりません。

最近、英国情報機関である英国政府通信本部 (GCHQ) は、ChatGPT およびその他の人工知能チャットボットが新たなセキュリティ上の脅威になると警告しました。

ChatGPT の概念が世に出てからそれほど長くはありませんが、ネットワーク セキュリティとデータ セキュリティに対する脅威が業界の焦点になっています。

ChatGPT はまだ開発の初期段階にありますが、そのような心配は杞憂でしょうか。

セキュリティ上の脅威が発生している可能性がある

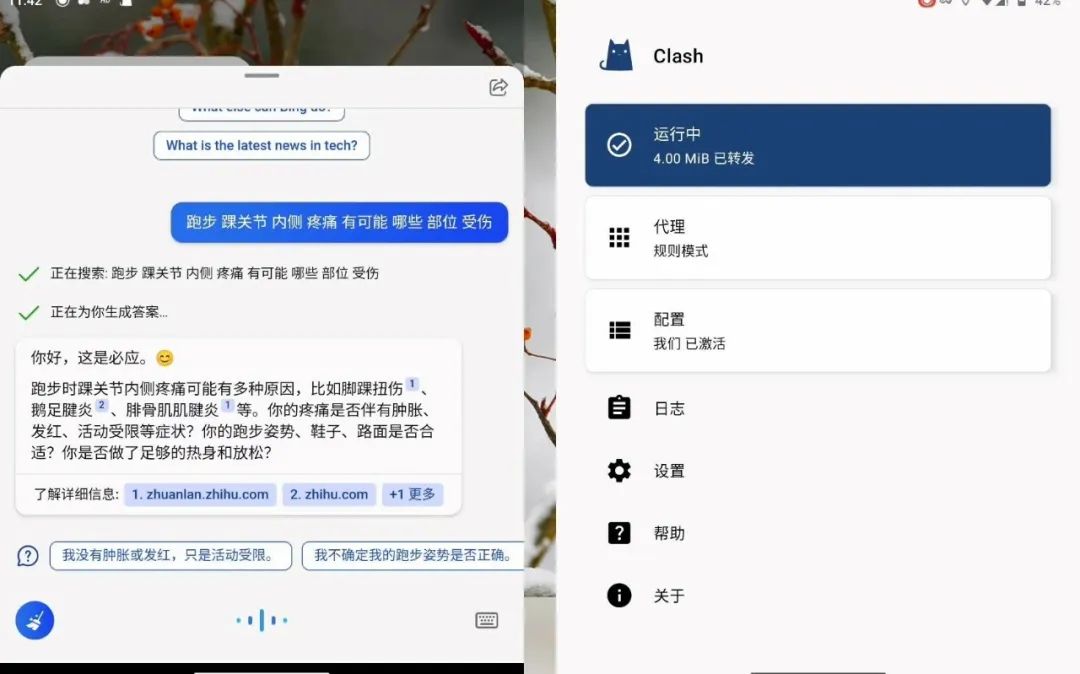

昨年末、スタートアップ OpenAI が ChatGPT を立ち上げ、その後、同社の投資家である Microsoft が ChatGPT テクノロジーに基づくチャットボットを立ち上げました。 「Bing Chat」。

この種のソフトウェアは人間のような会話を提供できるため、このサービスは世界中で人気があります。

GCHQ のサイバーセキュリティ部門は、AI チャットボットを提供する企業はユーザーが入力したクエリの内容を確認できると指摘しました。 ChatGPT は懸念しており、その開発者の OpenAI はこれを認識できます。

ChatGPT は、多数のテキスト コーパスを通じてトレーニングされており、その深層学習機能はその背後にあるデータに大きく依存しています。

情報漏洩の懸念から、多くの企業や機関が「ChatGPT 禁止令」を発行しています。

ロンドン市の法律事務所ミシュコン・デ・レイヤは、法的に特権情報が漏洩する可能性があるとの懸念から、弁護士が顧客データをChatGPTに入力することを禁止した。

国際コンサルティング会社アクセンチュアは、顧客の機密データが悪者の手に渡る可能性を懸念し、世界中の70万人の従業員に対し、同様の理由でChatGPTを使用しないよう警告した。

英国のコンピューターチップ企業アームの親会社である日本のソフトバンクグループも、社員に対し、社員の識別情報や機密データを人工知能チャットボットに入力しないよう警告した。

今年 2 月、JP モルガン チェースは、職場での ChatGPT の使用を制限した最初のウォール街の投資銀行となりました。

シティグループとゴールドマン・サックスもこれに続き、前者は社員による全社的なChatGPTへのアクセスを禁止し、後者は社員による立会場での製品の使用を制限した。

以前、Amazon と Microsoft は、従業員が ChatGPT を使用するときに秘密が漏洩するのを防ぐために、機密データを従業員と共有することを禁止しました。この情報は反復トレーニング データのさらなる利用に使用される可能性があるためです。

実際、これらの人工知能チャットボットの背後には大規模言語モデル (LLM) があり、ユーザーのクエリの内容は将来のある時点で保存され、使用されることになります。 。

これは、LLM プロバイダーが関連するクエリを読み取り、何らかの方法で将来のリリースに組み込むことができることを意味します。

LLM オペレーターはデータを保護するための措置を講じる必要がありますが、不正アクセスの可能性を完全に排除することはできません。したがって、企業は厳格なポリシーを設け、LLM の使用を監視するための技術サポートを提供して、データ漏洩のリスクを最小限に抑える必要があります。

さらに、ChatGPT 自体にはネットワーク セキュリティやデータ セキュリティを直接攻撃する機能はありませんが、自然言語を生成して理解する機能があるため、虚偽の情報を偽造したり、ソーシャル エンジニアリングを攻撃したりするために使用される可能性があります。等

さらに、攻撃者は自然言語を使用して、ChatGPT に対応する攻撃コード、マルウェア コード、スパムなどを生成させることもできます。

したがって、AIによって、本来攻撃を仕掛ける能力のない者がAIに基づいて攻撃を生成できるようになり、攻撃の成功率が大幅に向上します。

自動化、AI、「サービスとしての攻撃」などのテクノロジーとモデルのサポートにより、ネットワーク セキュリティ攻撃は急増する傾向にあります。

ChatGPT が普及する前には、AI 技術を利用したハッカーによるサイバー攻撃が数多く発生していました。

実際、人工知能が「リズムからずれる」ようにユーザーによって調整されることは珍しいことではありません。6 年前、マイクロソフトはインテリジェント チャット ロボット Tay を発売しました。オンラインでは、テイは礼儀正しく振る舞っていました。彼は礼儀正しかったのですが、24 時間も経たないうちに、悪意のあるユーザーによって「悪に導かれ」ました。彼は絶えず失礼で汚い言葉を使い、彼の言葉には人種差別、ポルノ、ナチスさえも含まれていました。彼はもうお腹いっぱいでした。差別、憎悪、偏見にさらされたため、彼はオフラインにされ、短い生涯を終えました。

一方、ユーザーに近いリスクは、ChatGPT などの AI ツールを使用するときに、ユーザーが誤ってプライベート データをクラウド モデルに入力し、そのデータが不正なデータになる可能性があることです。データは他の人に提供される答えの一部となり、データ侵害やコンプライアンスのリスクにつながる可能性もあります。

AI アプリケーションは安全な基盤を築く必要があります

大規模な言語モデルとして、ChatGPT のコア ロジックは実際には収集、処理、および演算結果の処理と出力。

一般に、これらのリンクは、技術的要素、組織管理、デジタル コンテンツという 3 つの側面における関連リスクに関連付けられている可能性があります。

ChatGPT は、モデルのトレーニングと実行に必要なデータを保存する際にプライバシーとセキュリティ ポリシーを厳格に遵守すると述べていますが、依然としてサイバー攻撃やデータ クローリングなどの問題が存在する可能性があります。データセキュリティのリスクを無視。

特に、国家の中核となるデータ、地域および業界の重要なデータ、個人のプライバシー データの取得、処理、組み合わせた使用に関しては、データ セキュリティ保護とデータ セキュリティのバランスを取る必要があります。フローの共有。

AI テクノロジーには、データやプライバシーの漏洩という隠れた危険に加えて、データの偏り、誤った情報、モデルの解釈の難しさなどの問題もあり、誤解や不信感につながる可能性があります。 。

トレンドが到来し、AIGC の波が到来しています。有望な未来を背景に、前進してデータ セキュリティ保護の壁を確立することが重要です。

特に AI 技術が徐々に向上すると、生産性向上のための強力なツールとなるだけでなく、違法犯罪のツールにもなりやすくなります。

Qi'anxin Threat Intelligence Center の監視データによると、2022 年 1 月から 10 月までに、950 億件以上の中国の機関データが海外で違法に取引され、そのうち 570 億件以上が違法に取引されました。海外で違法に取引された作品は個人情報です。

したがって、データの保存、計算、流通のセキュリティをどのように確保するかが、デジタル経済の発展の前提条件となります。

全体的な観点から、トップレベル設計と産業発展の両立を主張し、「サイバーセキュリティ法」に基づき、リスクと責任の分析体制を整備すべきである。を洗練し、セキュリティ責任のメカニズムを確立する必要があります。

同時に、規制当局は定期的な検査を実施し、セキュリティ分野の企業は協力して全プロセスのデータセキュリティシステムを構築できます。

データコンプライアンスとデータセキュリティの問題については、特に「データセキュリティ法」の施行後、データプライバシーの重要性がますます高まっています。

AI テクノロジーの適用中にデータのセキュリティとコンプライアンスが保証できない場合、企業に大きなリスクを引き起こす可能性があります。

特に中小企業は、データ プライバシー セキュリティに関する知識が比較的少なく、セキュリティの脅威からデータを保護する方法がわかりません。

データ セキュリティ コンプライアンスは、特定の部門の問題ではなく、企業全体にとって最も重要な問題です。

企業は従業員を訓練して、IT 担当者、AI 部門、データ エンジニア、開発者、ユーザーなど、データを使用するすべての人にデータを保護する義務があることを認識させる必要があります。 、人とテクノロジーを統合する必要があります。

前述の潜在的なリスクに直面して、規制当局や関連企業は AIGC 分野のデータ セキュリティ保護を組織レベルおよび技術レベルからどのように強化できるでしょうか?

ユーザー端末の使用を直接制限するなどの規制措置を講じるよりも、AI 技術の研究開発企業に科学技術倫理原則の遵守を明確に求める方が効果的です。これらの企業は、ユーザーの使用範囲を技術レベルで制限することができます。

組織レベルでは、AIGC の基盤技術に必要なデータの特性と機能に基づいて、データ分類と階層的保護システムを確立および改善する必要があります。

たとえば、トレーニング データ セット内のデータは、データ主体、データ処理レベル、データ権利属性などに応じて、データの値に応じて分類して管理できます。データをデータ権利主体に提供し、データが改ざん、破壊された場合などにデータ主体に与える損害の程度を分類します。

データの分類と分類に基づいて、データの種類とセキュリティ レベルに応じたデータ保護基準と共有メカニズムを確立します。

エンタープライズを中心に、AIGC分野における「プライベートコンピューティング」技術の適用を加速することも必要です。

このタイプのテクノロジーを使用すると、AIGC が提供できることを保証しながら、SDK を共有するか SDK 権限を開くことで、データ自体を公開することなく、複数のデータ所有者がデータを共有、相互運用、および計算できます。データが他の参加者に漏洩しないようにしながら、サービスを通常通りに提供します。

さらに、全プロセスのコンプライアンス管理の重要性がますます高まっています。

企業は、まず、使用するデータ リソースが法的および規制の要件に準拠しているかどうかに注意を払う必要があり、次に、アルゴリズムとモデルの運用プロセス全体が準拠していることを確認する必要があります。企業の研究開発もまた、公衆の倫理的期待に最大限応える必要があります。

同時に、企業は内部管理基準を策定し、AI テクノロジー適用シナリオのあらゆる側面でデータを監督する関連監督部門を設置し、データ ソースが合法であり、処理が合法であることを保証する必要があります。これにより、それ自体のコンプライアンスが保証されます。

AI 活用の鍵は導入方法とコストのバランスにありますが、セキュリティコンプライアンスやプライバシー保護が十分に行われていない場合、「より大きな問題が発生する可能性がある」ことに注意する必要があります。リスクポイント。」

AI は両刃の剣であり、うまく活用すれば企業はさらに強力になりますが、不適切に活用すると、セキュリティ、プライバシー、コンプライアンスを無視すると、企業に大きな損失をもたらすことになります。

したがって、AI を適用する前に、より安定した「データベース」を構築する必要があります。よく言われるように、安定性のみが長期的な発展につながります。

以上がChatGPT アプリケーションは急成長していますが、安全なビッグ データベースはどこで見つけられますか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7463

7463

15

15

1376

1376

52

52

77

77

11

11

18

18

18

18

ChatGPT では、無料ユーザーが 1 日あたりの制限付きで DALL-E 3 を使用して画像を生成できるようになりました

Aug 09, 2024 pm 09:37 PM

ChatGPT では、無料ユーザーが 1 日あたりの制限付きで DALL-E 3 を使用して画像を生成できるようになりました

Aug 09, 2024 pm 09:37 PM

DALL-E 3は、前モデルより大幅に改良されたモデルとして2023年9月に正式導入されました。これは、複雑な詳細を含む画像を作成できる、これまでで最高の AI 画像ジェネレーターの 1 つと考えられています。ただし、発売当初は対象外でした

Bytedance Cutting が SVIP スーパー メンバーシップを開始: 継続的な年間サブスクリプションは 499 元で、さまざまな AI 機能を提供

Jun 28, 2024 am 03:51 AM

Bytedance Cutting が SVIP スーパー メンバーシップを開始: 継続的な年間サブスクリプションは 499 元で、さまざまな AI 機能を提供

Jun 28, 2024 am 03:51 AM

このサイトは6月27日、JianyingはByteDanceの子会社であるFaceMeng Technologyによって開発されたビデオ編集ソフトウェアであり、Douyinプラットフォームに依存しており、基本的にプラットフォームのユーザー向けに短いビデオコンテンツを作成すると報告しました。 Windows、MacOS、その他のオペレーティング システム。 Jianyingは会員システムのアップグレードを正式に発表し、インテリジェント翻訳、インテリジェントハイライト、インテリジェントパッケージング、デジタルヒューマン合成などのさまざまなAIブラックテクノロジーを含む新しいSVIPを開始しました。価格的には、クリッピングSVIPの月額料金は79元、年会費は599元(当サイト注:月額49.9元に相当)、継続月額サブスクリプションは月額59元、継続年間サブスクリプションは、年間499元(月額41.6元に相当)です。さらに、カット担当者は、ユーザーエクスペリエンスを向上させるために、オリジナルのVIPに登録している人は、

微調整によって本当に LLM が新しいことを学習できるようになるのでしょうか: 新しい知識を導入すると、モデルがより多くの幻覚を生成する可能性があります

Jun 11, 2024 pm 03:57 PM

微調整によって本当に LLM が新しいことを学習できるようになるのでしょうか: 新しい知識を導入すると、モデルがより多くの幻覚を生成する可能性があります

Jun 11, 2024 pm 03:57 PM

大規模言語モデル (LLM) は巨大なテキスト データベースでトレーニングされ、そこで大量の現実世界の知識を取得します。この知識はパラメータに組み込まれており、必要なときに使用できます。これらのモデルの知識は、トレーニングの終了時に「具体化」されます。事前トレーニングの終了時に、モデルは実際に学習を停止します。モデルを調整または微調整して、この知識を活用し、ユーザーの質問により自然に応答する方法を学びます。ただし、モデルの知識だけでは不十分な場合があり、モデルは RAG を通じて外部コンテンツにアクセスできますが、微調整を通じてモデルを新しいドメインに適応させることが有益であると考えられます。この微調整は、ヒューマン アノテーターまたは他の LLM 作成物からの入力を使用して実行され、モデルは追加の実世界の知識に遭遇し、それを統合します。

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

新しい科学的で複雑な質問応答ベンチマークと大規模モデルの評価システムを提供するために、UNSW、アルゴンヌ、シカゴ大学、およびその他の機関が共同で SciQAG フレームワークを立ち上げました。

Jul 25, 2024 am 06:42 AM

編集者 |ScienceAI 質問応答 (QA) データセットは、自然言語処理 (NLP) 研究を促進する上で重要な役割を果たします。高品質の QA データ セットは、モデルの微調整に使用できるだけでなく、大規模言語モデル (LLM) の機能、特に科学的知識を理解し推論する能力を効果的に評価することもできます。現在、医学、化学、生物学、その他の分野をカバーする多くの科学 QA データ セットがありますが、これらのデータ セットにはまだいくつかの欠点があります。まず、データ形式は比較的単純で、そのほとんどが多肢選択式の質問であり、評価は簡単ですが、モデルの回答選択範囲が制限され、科学的な質問に回答するモデルの能力を完全にテストすることはできません。対照的に、自由回答型の Q&A

SOTA パフォーマンス、厦門マルチモーダルタンパク質-リガンド親和性予測 AI 手法、初めて分子表面情報を結合

Jul 17, 2024 pm 06:37 PM

SOTA パフォーマンス、厦門マルチモーダルタンパク質-リガンド親和性予測 AI 手法、初めて分子表面情報を結合

Jul 17, 2024 pm 06:37 PM

編集者 | KX 医薬品の研究開発の分野では、タンパク質とリガンドの結合親和性を正確かつ効果的に予測することが、医薬品のスクリーニングと最適化にとって重要です。しかし、現在の研究では、タンパク質とリガンドの相互作用における分子表面情報の重要な役割が考慮されていません。これに基づいて、アモイ大学の研究者らは、初めてタンパク質の表面、3D 構造、配列に関する情報を組み合わせ、クロスアテンション メカニズムを使用して異なるモダリティの特徴を比較する、新しいマルチモーダル特徴抽出 (MFE) フレームワークを提案しました。アライメント。実験結果は、この方法がタンパク質-リガンド結合親和性の予測において最先端の性能を達成することを実証しています。さらに、アブレーション研究は、この枠組み内でのタンパク質表面情報と多峰性特徴の位置合わせの有効性と必要性を実証しています。 「S」で始まる関連研究

AIなどの市場を開拓するグローバルファウンドリーズがタゴール・テクノロジーの窒化ガリウム技術と関連チームを買収

Jul 15, 2024 pm 12:21 PM

AIなどの市場を開拓するグローバルファウンドリーズがタゴール・テクノロジーの窒化ガリウム技術と関連チームを買収

Jul 15, 2024 pm 12:21 PM

7月5日のこのウェブサイトのニュースによると、グローバルファウンドリーズは今年7月1日にプレスリリースを発行し、自動車とインターネットでの市場シェア拡大を目指してタゴール・テクノロジーのパワー窒化ガリウム(GaN)技術と知的財産ポートフォリオを買収したことを発表した。モノと人工知能データセンターのアプリケーション分野で、より高い効率とより優れたパフォーマンスを探求します。生成 AI などのテクノロジーがデジタル世界で発展を続ける中、窒化ガリウム (GaN) は、特にデータセンターにおいて、持続可能で効率的な電力管理のための重要なソリューションとなっています。このウェブサイトは、この買収中にタゴール・テクノロジーのエンジニアリングチームがGLOBALFOUNDRIESに加わり、窒化ガリウム技術をさらに開発するという公式発表を引用した。 G

SKハイニックスは8月6日に12層HBM3E、321層NANDなどのAI関連新製品を展示する。

Aug 01, 2024 pm 09:40 PM

SKハイニックスは8月6日に12層HBM3E、321層NANDなどのAI関連新製品を展示する。

Aug 01, 2024 pm 09:40 PM

8月1日の本サイトのニュースによると、SKハイニックスは本日(8月1日)ブログ投稿を発表し、8月6日から8日まで米国カリフォルニア州サンタクララで開催されるグローバル半導体メモリサミットFMS2024に参加すると発表し、多くの新世代の製品。フューチャー メモリおよびストレージ サミット (FutureMemoryandStorage) の紹介。以前は主に NAND サプライヤー向けのフラッシュ メモリ サミット (FlashMemorySummit) でしたが、人工知能技術への注目の高まりを背景に、今年はフューチャー メモリおよびストレージ サミット (FutureMemoryandStorage) に名前が変更されました。 DRAM およびストレージ ベンダー、さらに多くのプレーヤーを招待します。昨年発売された新製品SKハイニックス

SearchGPT: Open AI が独自の AI 検索エンジンで Google に対抗

Jul 30, 2024 am 09:58 AM

SearchGPT: Open AI が独自の AI 検索エンジンで Google に対抗

Jul 30, 2024 am 09:58 AM

オープン AI がついに検索に進出します。サンフランシスコの同社は最近、検索機能を備えた新しい AI ツールを発表した。今年 2 月に The Information によって初めて報告されたこの新しいツールは、まさに SearchGPT と呼ばれ、次のような機能を備えています。