テクノロジー周辺機器

テクノロジー周辺機器

AI

AI

ビッグモデルの育成は「エネルギー」に注目! Tao Dacheng がチームを率いる: すべての「効率的なトレーニング」ソリューションは 1 つの記事でカバーされており、ハードウェアが唯一のボトルネックだという言い方はやめてください。

ビッグモデルの育成は「エネルギー」に注目! Tao Dacheng がチームを率いる: すべての「効率的なトレーニング」ソリューションは 1 つの記事でカバーされており、ハードウェアが唯一のボトルネックだという言い方はやめてください。

ビッグモデルの育成は「エネルギー」に注目! Tao Dacheng がチームを率いる: すべての「効率的なトレーニング」ソリューションは 1 つの記事でカバーされており、ハードウェアが唯一のボトルネックだという言い方はやめてください。

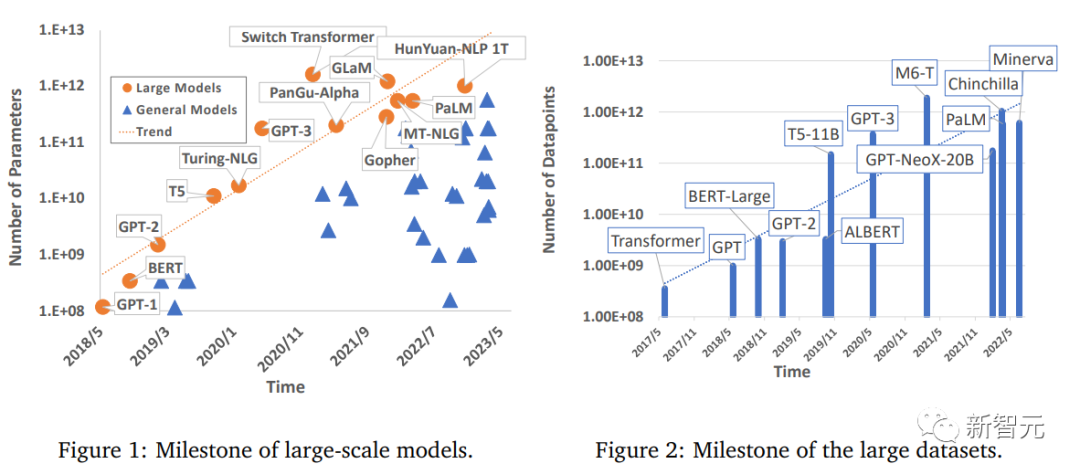

ディープラーニングの分野は、特にコンピュータビジョン、自然言語処理、音声などの分野で大きな進歩を遂げており、ビッグデータを活用して学習された大規模モデルは実用化、産業生産性の向上、社会の発展に重要です。 . 開発には大きな展望があります。

ただし、大規模なモデルのトレーニングには大規模なコンピューティング能力も必要です。コンピューティング能力に対する人々の要求は増加し続けるため、効率的なトレーニング方法を探求する多くの研究が行われていますが、深層学習モデルの高速化技術に関する包括的なレビューはまだありません。

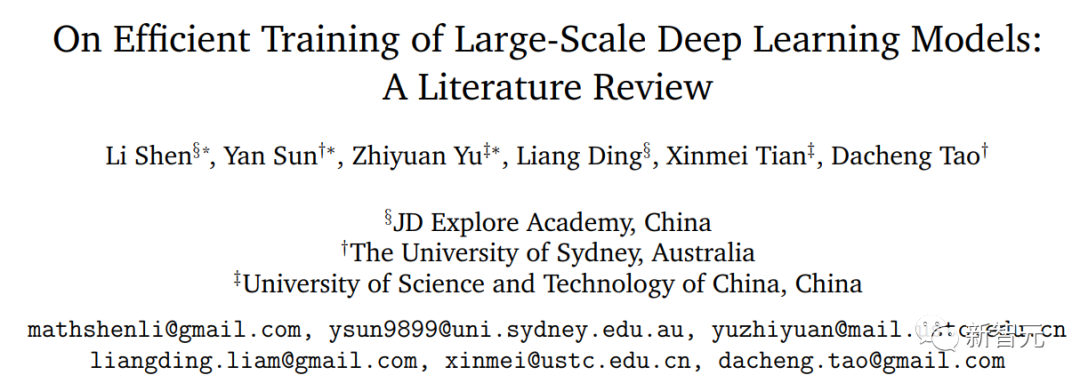

最近、シドニー大学、中国科学技術大学などの研究者らが、大規模な深層学習モデルの効率的なトレーニング手法を包括的にまとめたレビューを発表し、トレーニング プロセス の各コンポーネント内の共通メカニズム。

# 論文リンク: https://arxiv.org/pdf/2304.03589.pdf

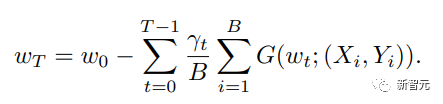

研究者らは、最も基本的な重み更新式を検討し、その基本コンポーネントを 5 つの主要な側面に分割しました。

データ中心 (データ中心) (データセットの正則化、データ サンプリング、データ中心のコース学習テクノロジを含む) により、データ サンプルの計算の複雑さを大幅に軽減できます。

2、モデル中心 (モデル中心) (基本モジュールの高速化、圧縮トレーニング、モデルの初期化、モデル中心のコース学習テクノロジはトレーニングの高速化に重点を置いています)パラメータ計算の削減による;

3、最適化中心の (学習率の選択、大きなバッチ サイズの使用、効率的な目的関数の設計、モデルの加重平均を含む)テクノロジーなど; 大規模モデルの汎用性を向上させるためのトレーニング戦略に焦点を当てる;

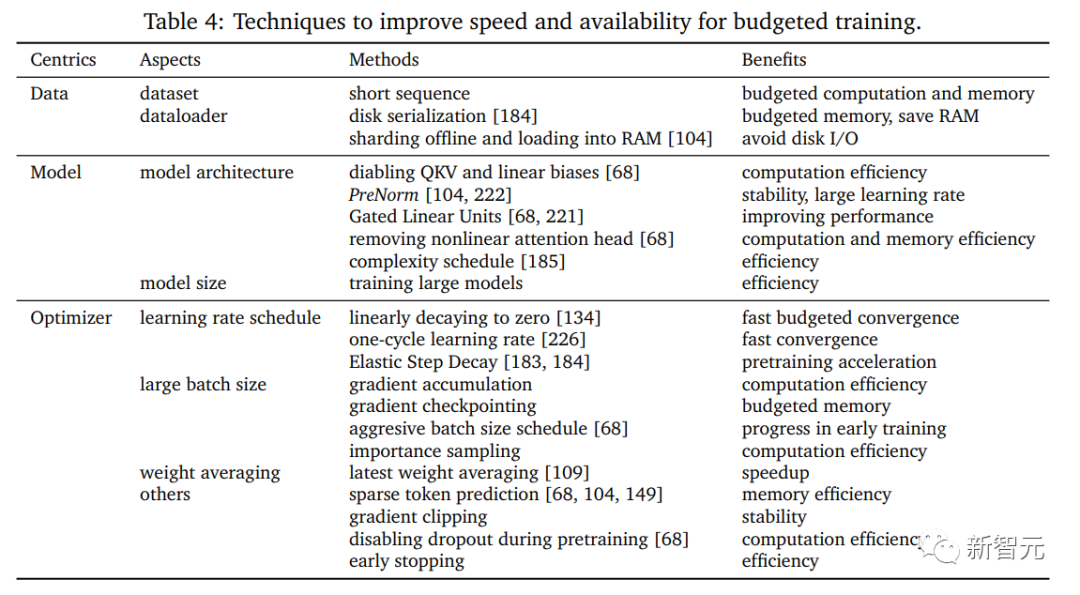

4,予算トレーニング (ハードウェアが使用されている場合に使用されるいくつかのアクセラレーション テクノロジを含む)限定的;

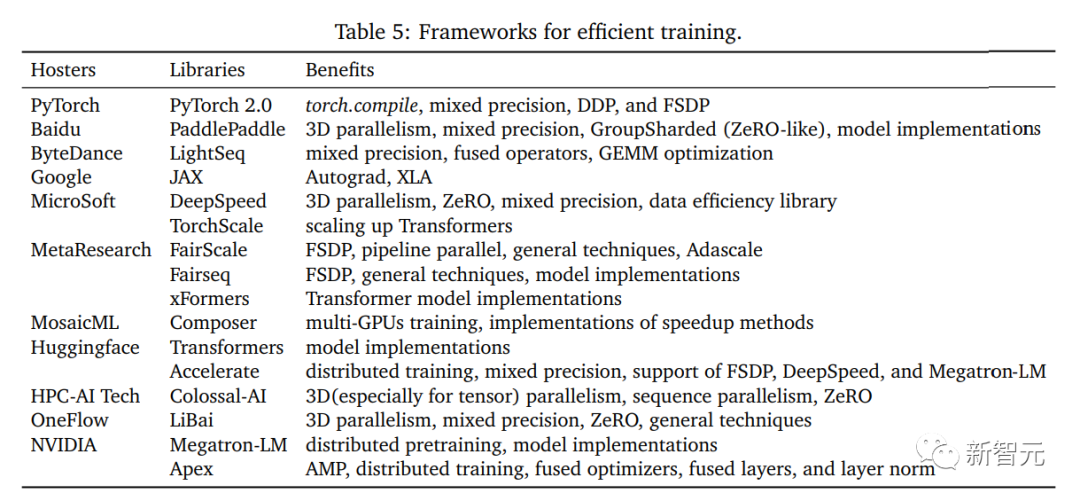

5、システム中心 (システム中心) 、いくつかの効率的な分散フレームワークとオープン ソース ライブラリを含み、高速化されたアプリケーションの実装に十分なハードウェア サポートを提供します。アルゴリズム。 効率的なデータ中心のトレーニング

最近、大規模モデルが大きく進歩する一方で、データセットに対する要件が大幅に増加しています。トレーニング プロセスを推進し、優れたパフォーマンスを達成するために、膨大なデータ サンプルが使用されます。したがって、実際の加速にはデータ中心の研究が不可欠です。データ処理の基本的な機能は、ラベル付けのコストを増やさずにデータ サンプルの多様性を効率的に高めることです。データのラベル付けのコストは高額になることが多いため、一部の開発機関には余裕がありません。これは、データ中心の分野における研究の重要性も強調するものであり、同時に、データ処理では、データ サンプルの並列ロードの効率の向上にも重点が置かれています。

研究者らは、これらすべての効率的なデータ処理を「データ中心」のアプローチと呼んでいます。これにより、大規模モデルのトレーニングのパフォーマンスを大幅に向上させることができます。

#この記事では、次の側面からテクノロジーをレビューおよび研究します:

データの正則化データの正則化 データ正則化は、一連のデータ変換を通じて元のデータ サンプルの多様性を強化する前処理手法であり、特徴空間におけるトレーニング サンプルの等価性を向上させることができます。ラベル情報は必須です。

効率的なデータ正則化手法はトレーニング プロセスで広く使用されており、大規模モデルの汎化パフォーマンスを大幅に向上させることができます。

データ サンプリングデータ サンプリング

データ サンプリングも効果的な方法です。勾配を更新するためにサンプルの大規模なバッチからサブセットを抽出する場合、小さなバッチでトレーニングして、現在のバッチ内の重要でないサンプルや不良サンプルの影響を軽減できるという利点があります。

通常、サンプリングされたデータの方が重要であり、そのパフォーマンスは完全なバッチを使用してトレーニングされたモデルのパフォーマンスと同等です。各反復の確率は、トレーニング プロセス: サンプリングに偏りがないことを確認します。

データ中心のカリキュラム学習

トレーニング プロセスのさまざまな段階でのカリキュラム学習全体的な計算コスト。

最初は、低品質のデータ セットを使用して、低レベルの機能を学習するのに十分なトレーニングを行い、その後、高品質のデータ セット (さらなる機能強化と複雑な前処理方法) を徐々に使用します。複雑な機能を学習し、トレーニング セット全体を使用した場合と同じ精度を達成するのに役立ちます。

モデル中心の効率的なトレーニング

効率的なモデル アーキテクチャの設計は、深層学習の分野において常に最も重要な研究の 1 つです。 1. 簡単に分離できる高レベルの特徴に投影できる特徴抽出ツール。

効率的で斬新なモデル アーキテクチャに特別な注意を払う他の研究とは異なり、この論文では、「モデル中心」の研究における共通モジュールの同等の代替手段により多くの注意を払っています。同等の条件下で。

ほとんどすべての大規模モデルは小さなモジュールまたはレイヤーで構成されているため、モデルの調査は大規模モデルを効率的にトレーニングするためのガイダンスを提供します。研究者は主に次の研究に焦点を当てています。側面:

#アーキテクチャ効率

深層モデルのパラメーターの数この急激な増加は膨大な計算量の消費ももたらしているため、モデル アーキテクチャの元のバージョンのパフォーマンスに近づけるために効率的な代替案を実装する必要があります。この方向性は徐々に学術界の注目を集めています。この代替案は、学術界の注目を集めています。数値計算近似には、構造の単純化とディープ モデルでの融合も含まれます。

研究者たちは、さまざまなアーキテクチャに基づいて既存の高速化技術を区別し、いくつかの観察と結論を提示します。

圧縮トレーニングの効率

圧縮は、常にコンピューティング高速化における研究の方向性でした。 1 つは、デジタル信号処理 (マルチメディア コンピューティング/画像処理) で重要な役割を果たします。

従来の圧縮には、量子化とスパースネスという 2 つの主なブランチが含まれており、この記事では、ディープ トレーニングに対する既存の成果と貢献について詳しく説明します。

#初期化効率

既存の理論解析におけるモデルパラメータの初期化です。実際のシナリオでは非常に重要な要素です。初期化状態が不良であると、トレーニング全体がクラッシュして初期のトレーニング段階で停滞する可能性もありますが、初期化状態が良好であれば、スムーズな損失範囲内で速度が向上します。全体の収束速度について, この記事では主にモデルの初期化の観点から評価とアルゴリズム設計について検討します。

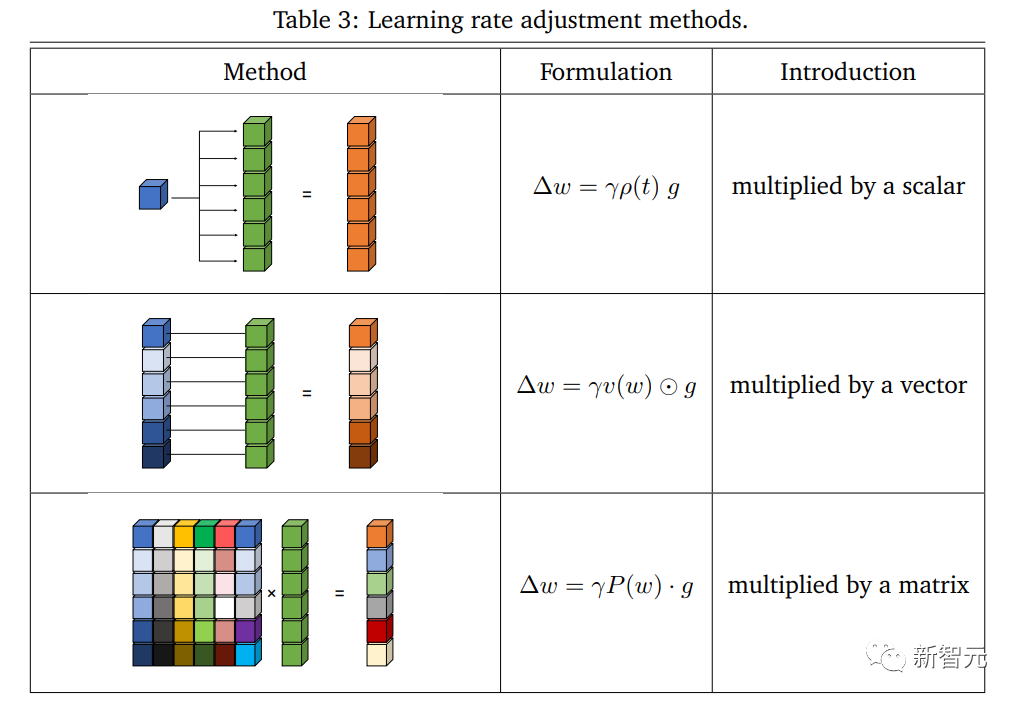

モデル中心のカリキュラム学習 モデル中心の観点から見ると、コース学習は通常、小規模モデルまたは大規模モデルの部分パラメーターからトレーニングを開始し、その後徐々にアーキテクチャ全体に回復します。加速されたトレーニング プロセスでは、利点が大きく、明らかな悪影響はないため、この記事ではトレーニング プロセスにおけるこの方法の実装と効率をレビューしています。 最適化手法の加速スキームは、機械学習の分野において常に重要な研究方向であり、最適化を達成しながら複雑さを軽減できます。セックスは常に学術界で追求されてきました。 近年、効率的で強力な最適化手法により、ディープ ニューラル ネットワークのトレーニングにおいて重要なブレークスルーが実現しました。機械学習で広く使用されている基本的なオプティマイザーとして、SGD クラス オプティマイザーは、ディープ ニューラル ネットワークのトレーニングに成功しています。モデルはさまざまな実用化を実現しますが、問題が複雑になるにつれて、SGD は極小値に陥る可能性が高く、安定して一般化できなくなります。 これらの問題を解決するために、Adam とその亜種は、更新に適応性を導入することが提案されました。このアプローチは、次のような大規模なネットワーク トレーニングで良好な結果を達成しています。 BERT、Transformer、および ViT モデル。 設計されたオプティマイザー自体のパフォーマンスに加えて、高速トレーニング手法の組み合わせも重要です。 #研究者は、最適化の観点に基づいて、加速トレーニングに関する現在の考え方を次の側面に要約しました: # #学習率 学習率 学習率は非凸最適化の重要なハイパーパラメータであり、Adam のような現在のディープ ネットワーク トレーニングでも重要です。バリアントはディープモデルで目覚ましい進歩を遂げることに成功しました。 # 高次の勾配に基づいて学習率を調整するいくつかの戦略も、トレーニングの加速を効果的に実現し、学習率の減衰の実装も効果的です。その過程でトレーニングのパフォーマンスに影響を与えます。 大きなバッチ サイズ 大きなバッチ サイズを使用すると、効果的にトレーニング効率を向上させることができます。エポック トレーニングを完了するために必要な反復回数を直接削減します。サンプルの合計数が固定されている場合、大きなバッチ サイズを処理する方が、メモリ使用率が向上し、通信のボトルネックが軽減されるため、複数の小さなバッチ サイズのサンプルを処理するよりもコストが低くなります。 効率的な目標 最も基本的な ERM は最小化問題に関するものです。多くのタスクを実用化する上での役割を果たします。 大規模ネットワークに関する研究の深化に伴い、一部の研究では最適化と一般化の間のギャップにさらに注目し、テストエラーを減らすための効果的な目標を提案し、さまざまな観点から一般化を説明し、一般化と一般化を説明しています。トレーニング中に共同で最適化することで、テストの精度を大幅に向上させることができます。 #加重平均 平均加重 予算化された効率的なトレーニング このタイプの問題は、予算付きトレーニング、つまり最高のモデル パフォーマンスを達成するために与えられた予算 (測定可能なコストの制限) 内でトレーニングすることとして定義されます。 実際の状況に近づくためのハードウェア サポートを体系的に検討するために、研究者らは、予算トレーニングを、特定のデバイス上で限られた時間内でトレーニングすることと定義しました。たとえば、単一のローエンドの深層学習サーバーでのトレーニングです。いつか最高のパフォーマンスのモデルを手に入れるために。 # 予算トレーニングに関する研究により、モデル サイズの決定など、予算トレーニングのためのトレーニング レシピの作成方法が明らかになります。モデル構造の構成、学習率の配置、およびパフォーマンスに影響を与えるその他のいくつかの調整可能な要素、および利用可能な予算に適した効率的なトレーニング手法の組み合わせ。この記事では主に、予算トレーニングのいくつかの高度な手法をレビューします。 システム中心の研究は、設計されたアルゴリズムの具体的な実装方法を提供し、真に高効率を達成する能力を研究することです。そしてトレーニングハードウェアの実践的な実行。 研究者は、マルチノード クラスター内の CPU や GPU デバイスなどの汎用コンピューティング デバイスの実装に焦点を当てており、ハードウェアの観点から設計アルゴリズムの潜在的な競合を解決することが中心となります。気がかりな。 この記事では主に、既存のフレームワークとサードパーティ ライブラリのハードウェア実装テクノロジをレビューします。これらのテクノロジは、データ、モデル、最適化の処理を効果的にサポートし、既存のオープンソース プラットフォームをいくつか紹介します。モデルの確立、トレーニング用のデータの効果的な使用、混合精度トレーニング、分散トレーニングのための強固なフレームワークを提供します。 # システム中心のデータ効率 データ量の急速な増加に伴い、特に複数ノードでの大規模なトレーニングでは、非効率なデータ処理が徐々にトレーニング効率のボトルネックになってきています。並列化により、トレーニングでの時間の無駄を効果的に回避できます。

システム中心のモデル効率 この記事では、デプロイメントの効率的な I/O と、実際のトレーニングを高速化するためのモデル並列処理の合理化された実装を実現する方法を主にレビューします。

システム中心の最適化効率 システム最適化の特徴を明確に解釈するために、この記事ではさまざまな計算段階の効率に焦点を当て、各プロセスの改善点をレビューします。

オープン ソース フレームワーク

最適化中心の効率的な学習

この記事では、これらのテクノロジーを 5 つの主な方向性 (データ中心、モデル中心、最適化中心、予算トレーニング、システム中心) に要約する新しい分類法も提案しています。 最初の 4 つのパートでは主にアルゴリズム設計と方法論の観点から総合的な研究を行い、「システム中心の効率的なトレーニング」パートではパラダイムイノベーションの観点からまとめ、ハードウェアは実際の実装をサポートします。 この記事では、各セクションに対応する一般的に使用されている技術または最近開発された技術、各技術の利点とトレードオフをレビューおよび要約し、限界と将来の有望な研究の方向性について説明します。このレビューは包括的な技術レビューとガイダンスであり、効率的なトレーニングにおける現在の画期的な進歩とボトルネックも提案しています。 研究者らは、研究者が一般的なトレーニングを効率的に加速できるよう支援し、効率的なトレーニングの将来の開発に有意義で有望な示唆を提供したいと考えています。さらに、各セクションの最後には次のような記載があります。言及されたいくつかの潜在的な発展に加えて、より広範で有望な見解は次のとおりです: 1. 効率的なプロファイル検索 効率的なトレーニングにより、データ拡張の組み合わせ、モデル構造、オプティマイザー設計などの観点から、モデルの事前構築済みのカスタマイズ可能なプロファイル検索戦略を設計できます。関連する研究では、ある程度の成果が得られています。 新しいモデル アーキテクチャと圧縮モード、新しい事前トレーニング タスク、および「モデル エッジ」知識の使用も検討する価値があります。 2. アダプティブ スケジューラ Adaptive Scheduler 最適化指向のスケジュールを使用するコース学習、学習率、バッチ サイズ、モデルの複雑さによってパフォーマンスが向上する可能性があるため、予算を意識したスケジューラーは残りの予算に動的に適応し、手動設計のコストを削減できます。適応型スケジューラーを使用できます。並列処理と通信方法を検討します。同時に、複数の地域やデータセンターにまたがる異種ネットワークでの大規模な分散トレーニングなど、より一般的で実践的なシナリオも考慮しています。

以上がビッグモデルの育成は「エネルギー」に注目! Tao Dacheng がチームを率いる: すべての「効率的なトレーニング」ソリューションは 1 つの記事でカバーされており、ハードウェアが唯一のボトルネックだという言い方はやめてください。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7569

7569

15

15

1386

1386

52

52

87

87

11

11

28

28

107

107

オープンソース!ゾーイデプスを超えて! DepthFM: 高速かつ正確な単眼深度推定!

Apr 03, 2024 pm 12:04 PM

オープンソース!ゾーイデプスを超えて! DepthFM: 高速かつ正確な単眼深度推定!

Apr 03, 2024 pm 12:04 PM

0.この記事は何をするのですか?私たちは、多用途かつ高速な最先端の生成単眼深度推定モデルである DepthFM を提案します。従来の深度推定タスクに加えて、DepthFM は深度修復などの下流タスクでも最先端の機能を実証します。 DepthFM は効率的で、いくつかの推論ステップ内で深度マップを合成できます。この作品について一緒に読みましょう〜 1. 論文情報タイトル: DepthFM: FastMonocularDepthEstimationwithFlowMatching 著者: MingGui、JohannesS.Fischer、UlrichPrestel、PingchuanMa、Dmytr

世界で最も強力なオープンソース MoE モデルが登場。GPT-4 に匹敵する中国語機能を備え、価格は GPT-4-Turbo のわずか 1% 近くです

May 07, 2024 pm 04:13 PM

世界で最も強力なオープンソース MoE モデルが登場。GPT-4 に匹敵する中国語機能を備え、価格は GPT-4-Turbo のわずか 1% 近くです

May 07, 2024 pm 04:13 PM

従来のコンピューティングを超える能力を備えているだけでなく、より低コストでより効率的なパフォーマンスを実現する人工知能モデルを想像してみてください。これは SF ではありません。世界で最も強力なオープンソース MoE モデルである DeepSeek-V2[1] が登場しました。 DeepSeek-V2 は、経済的なトレーニングと効率的な推論の特徴を備えた強力な専門家混合 (MoE) 言語モデルです。これは 236B のパラメータで構成されており、そのうち 21B は各マーカーをアクティブにするために使用されます。 DeepSeek67B と比較して、DeepSeek-V2 はパフォーマンスが優れていると同時に、トレーニング コストを 42.5% 節約し、KV キャッシュを 93.3% 削減し、最大生成スループットを 5.76 倍に高めます。 DeepSeek は一般的な人工知能を研究する会社です

AI が数学研究を破壊する!フィールズ賞受賞者で中国系アメリカ人の数学者が上位 11 件の論文を主導 | テレンス・タオが「いいね!」しました

Apr 09, 2024 am 11:52 AM

AI が数学研究を破壊する!フィールズ賞受賞者で中国系アメリカ人の数学者が上位 11 件の論文を主導 | テレンス・タオが「いいね!」しました

Apr 09, 2024 am 11:52 AM

AI は確かに数学を変えつつあります。最近、この問題に細心の注意を払っている陶哲軒氏が『米国数学協会会報』(米国数学協会会報)の最新号を送ってくれた。 「機械は数学を変えるのか?」というテーマを中心に、多くの数学者が意見を述べ、そのプロセス全体は火花に満ち、ハードコアで刺激的でした。著者には、フィールズ賞受賞者のアクシャイ・ベンカテシュ氏、中国の数学者鄭楽軍氏、ニューヨーク大学のコンピューター科学者アーネスト・デイビス氏、その他業界で著名な学者を含む強力な顔ぶれが揃っている。 AI の世界は劇的に変化しています。これらの記事の多くは 1 年前に投稿されたものです。

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas は正式に電動ロボットの時代に突入します!昨日、油圧式アトラスが歴史の舞台から「涙ながらに」撤退したばかりですが、今日、ボストン・ダイナミクスは電動式アトラスが稼働することを発表しました。ボストン・ダイナミクス社は商用人型ロボットの分野でテスラ社と競争する決意を持っているようだ。新しいビデオが公開されてから、わずか 10 時間ですでに 100 万人以上が視聴しました。古い人が去り、新しい役割が現れるのは歴史的な必然です。今年が人型ロボットの爆発的な年であることは間違いありません。ネットユーザーは「ロボットの進歩により、今年の開会式は人間のように見え、人間よりもはるかに自由度が高い。しかし、これは本当にホラー映画ではないのか?」とコメントした。ビデオの冒頭では、アトラスは仰向けに見えるように地面に静かに横たわっています。次に続くのは驚くべきことです

MLP に代わる KAN は、オープンソース プロジェクトによって畳み込みまで拡張されました

Jun 01, 2024 pm 10:03 PM

MLP に代わる KAN は、オープンソース プロジェクトによって畳み込みまで拡張されました

Jun 01, 2024 pm 10:03 PM

今月初め、MIT やその他の機関の研究者らは、MLP に代わる非常に有望な代替案である KAN を提案しました。 KAN は、精度と解釈可能性の点で MLP よりも優れています。また、非常に少数のパラメーターを使用して、多数のパラメーターを使用して実行する MLP よりも優れたパフォーマンスを発揮できます。たとえば、著者らは、KAN を使用して、より小規模なネットワークと高度な自動化で DeepMind の結果を再現したと述べています。具体的には、DeepMind の MLP には約 300,000 個のパラメーターがありますが、KAN には約 200 個のパラメーターしかありません。 KAN は、MLP が普遍近似定理に基づいているのに対し、KAN はコルモゴロフ-アーノルド表現定理に基づいているのと同様に、強力な数学的基礎を持っています。以下の図に示すように、KAN は

超知性の生命力が覚醒する!しかし、自己更新 AI の登場により、母親はデータのボトルネックを心配する必要がなくなりました。

Apr 29, 2024 pm 06:55 PM

超知性の生命力が覚醒する!しかし、自己更新 AI の登場により、母親はデータのボトルネックを心配する必要がなくなりました。

Apr 29, 2024 pm 06:55 PM

世界は狂ったように大きなモデルを構築していますが、インターネット上のデータだけではまったく不十分です。このトレーニング モデルは「ハンガー ゲーム」のようであり、世界中の AI 研究者は、データを貪欲に食べる人たちにどのように餌を与えるかを心配しています。この問題は、マルチモーダル タスクで特に顕著です。何もできなかった当時、中国人民大学学部のスタートアップチームは、独自の新しいモデルを使用して、中国で初めて「モデル生成データフィード自体」を実現しました。さらに、これは理解側と生成側の 2 つの側面からのアプローチであり、両方の側で高品質のマルチモーダルな新しいデータを生成し、モデル自体にデータのフィードバックを提供できます。モデルとは何ですか? Awaker 1.0 は、中関村フォーラムに登場したばかりの大型マルチモーダル モデルです。チームは誰ですか?ソフォンエンジン。人民大学ヒルハウス人工知能大学院の博士課程学生、ガオ・イージャオ氏によって設立されました。

Kuaishou バージョンの Sora「Ke Ling」がテスト用に公開されています。120 秒以上のビデオを生成し、物理学をより深く理解し、複雑な動きを正確にモデル化できます。

Jun 11, 2024 am 09:51 AM

Kuaishou バージョンの Sora「Ke Ling」がテスト用に公開されています。120 秒以上のビデオを生成し、物理学をより深く理解し、複雑な動きを正確にモデル化できます。

Jun 11, 2024 am 09:51 AM

何?ズートピアは国産AIによって実現するのか?ビデオとともに公開されたのは、「Keling」と呼ばれる新しい大規模な国産ビデオ生成モデルです。 Sora も同様の技術的ルートを使用し、自社開発の技術革新を多数組み合わせて、大きく合理的な動きをするだけでなく、物理世界の特性をシミュレートし、強力な概念的結合能力と想像力を備えたビデオを制作します。データによると、Keling は、最大 1080p の解像度で 30fps で最大 2 分の超長時間ビデオの生成をサポートし、複数のアスペクト比をサポートします。もう 1 つの重要な点は、Keling は研究所が公開したデモやビデオ結果のデモンストレーションではなく、ショートビデオ分野のリーダーである Kuaishou が立ち上げた製品レベルのアプリケーションであるということです。さらに、主な焦点は実用的であり、白紙小切手を書かず、リリースされたらすぐにオンラインに移行することです。Ke Ling の大型モデルは Kuaiying でリリースされました。

テスラのロボットは工場で働く、マスク氏:手の自由度は今年22に達する!

May 06, 2024 pm 04:13 PM

テスラのロボットは工場で働く、マスク氏:手の自由度は今年22に達する!

May 06, 2024 pm 04:13 PM

テスラのロボット「オプティマス」の最新映像が公開され、すでに工場内で稼働可能となっている。通常の速度では、バッテリー(テスラの4680バッテリー)を次のように分類します:公式は、20倍の速度でどのように見えるかも公開しました - 小さな「ワークステーション」上で、ピッキング、ピッキング、ピッキング:今回は、それがリリースされたハイライトの1つビデオの内容は、オプティマスが工場内でこの作業を完全に自律的に行い、プロセス全体を通じて人間の介入なしに完了するというものです。そして、オプティマスの観点から見ると、自動エラー修正に重点を置いて、曲がったバッテリーを拾い上げたり配置したりすることもできます。オプティマスのハンドについては、NVIDIA の科学者ジム ファン氏が高く評価しました。オプティマスのハンドは、世界の 5 本指ロボットの 1 つです。最も器用。その手は触覚だけではありません