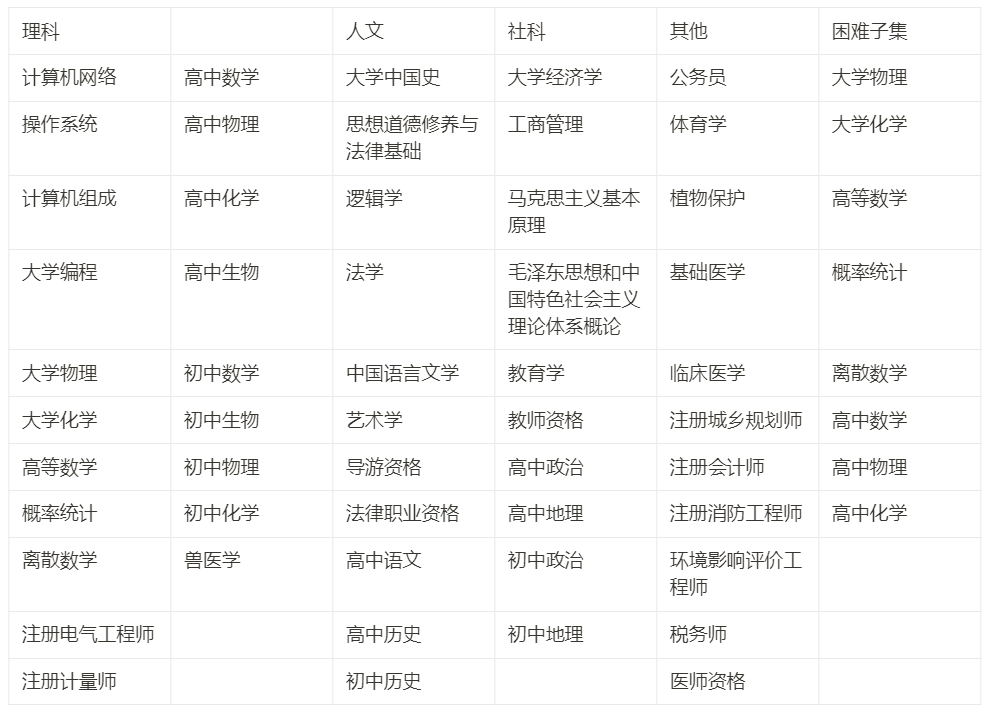

中国の大型モデル用のテストセットを作成するために、微積分や線分生成などの 52 科目をカバーする 13948 問が清華大学に提出されました。

ChatGPT の出現により、中国コミュニティは国際的な主要レベルとのギャップを認識するようになりました。最近、中国の大型モデルの開発が本格化していますが、中国の評価基準は非常に少ないです。

OpenAI GPT シリーズ/Google PaLM シリーズ/DeepMind Chinchilla シリーズ/Anthropic Claude シリーズの開発プロセスでは、MMLU/MATH/BBH の 3 つのデータセットが重要な役割を果たしました。これらは、モデルの各次元の機能を比較的包括的にカバーしています。最も注目すべきは、人文科学から社会科学、科学、工学に至る 57 分野の包括的な知識能力を考慮した MMLU データセットです。 DeepMind の Gopher モデルと Chinchilla モデルは MMLU スコアのみを参照するため、開発者が大規模な中国語モデルを開発するのを支援するために、十分に差別化された、学際的な中国語のベンチマーク リストを構築したいと考えています。

人文科学、社会科学、理工学、その他の専攻の 4 つの主要な方向と 52 科目 (微積分、直線生成...) をカバーするシステムを約 3 か月かけて構築しました。 , 中学校から大学の大学院および職業試験までの、合計 13948 問の中国語の知識と推論のテスト セットです。中国人コミュニティによる大規模なモデルの開発を支援するために、私たちはこれを C-Eval と呼んでいます。

この記事は、C-Eval を構築するプロセスを記録し、私たちの視点からの考え方と研究開発の優先事項を開発者と共有することを目的としています。私たちの最も重要な 目標は、ランキングを獲得することではなく、モデル開発を支援することです。リストの上位を盲目的に追求すると、多くの悪影響が生じますが、C-Eval を科学的に使用して反復モデルを支援できれば、C-Eval を最大化できます。したがって、 では、モデル開発の観点から C-Eval データ セットとリストを扱うことをお勧めします。

- ウェブサイト:

- #https://cevalbenchmark.com/Github:

- https://github.com/SJTU-LIT/ceval 論文:

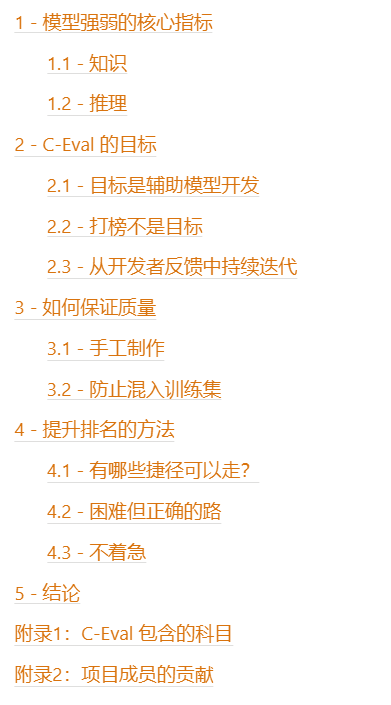

- https://arxiv.org/abs/2305.08322表目次

1 - モデルの強さの中心的な指標

と Reasoning という 2 つのコアを考慮します。 1.1 - 知識

なぜ知的能力が核となる能力なのでしょうか?次のようないくつかの議論があります:

# モデルが普遍的であり、さまざまな分野の生産性に貢献できることを期待しています。当然、モデルにはさまざまな分野の知識が必要です。 。

- また、モデルが意味のないことを話したり、それが何であるかを理解していないことを望んでいます。これには、モデルがあまり知識がないと言えるように、モデルの知識を拡張することも必要です。頻繁。

- スタンフォード大学の HELM 英語評価リストにおける重要な結論は、モデルのサイズが知識集約型タスクの効果と有意に正の相関があるということです。モデルは知識を保存するために使用できます。

- 前述したように、DeepMind の Gopher/Chinchilla などの既存の重要なモデルは、評価時にほぼ MMLU のみを参照しており、MMLU の核心はテスト モデルの知識カバレッジです。

- GPT-4 のリリース ブログでは、最初に、モデルの能力の尺度として、さまざまな科目試験におけるモデルのパフォーマンスを列挙します。

- したがって、知識ベースの機能は、基本モデルの可能性を測る適切な尺度になります。

1.2 - 推論

# 推論能力とは、知識をもとにさらに改良する能力であり、モデルが作れるかどうかを表します。難しい、とても複雑なこと。モデルが強力であるためには、まず広範な知識が必要であり、次にその知識に基づいて推論を行います。

推論は非常に重要です:

- GPT-4 のリリース ブログで、OpenAI は明確に「違いが現れる」と書いています。タスクの複雑さが十分なしきい値に達したとき」 (GPT-3.5 と GPT-4 の違いは、タスクの複雑さが特定のレベルに達した後にのみ明らかになります)。これは、強いモデルには大きな推論能力がある一方、弱いモデルにはあまり能力がないことがわかります。

- PaLM-2 の技術レポートでは、2 つの推論データセット BBH と MATH が、議論と焦点のために特別にリストされています。

- モデルを新世代のコンピューティング プラットフォームにして、その上に新しいアプリケーション エコシステムを育成したい場合は、複雑なタスクを完了できるほど強力なモデルを作成する必要があります。

ここでは、推論と知識の関係も明確にする必要があります。

- 知識ベースの能力が基礎となります。モデルの機能の推論能力はさらに昇華されており、モデルは既存のナレッジ グラフに基づいて推論する必要があります。

- 知識ベースのタスクのリストでは、モデルのサイズとモデルのスコアは通常継続的に変化しており、モデルが小さいという理由だけで崖のような低下が起こる可能性は低いです。 - この観点から、知識ベースのタスク タスクはもう少し区別されます。

- 推論タスクのリストでは、モデルがある程度大きい場合 (おそらく 50B 以上、つまり、LLaMA 65B) の大きさ)、モデル推論能力が向上します。

- 知識ベースのタスクの場合、思考連鎖 (CoT) プロンプトと回答のみ (AO) プロンプトの効果は似ていますが、推論タスクの場合は CoT の方が大幅に優れています。 AO.

- したがって、ここでは、CoT は推論効果のみを追加し、知識効果は追加しないことを覚えておく必要があります。この現象は C-Eval データセットでも観察されました。

2 - C-Eval の目標

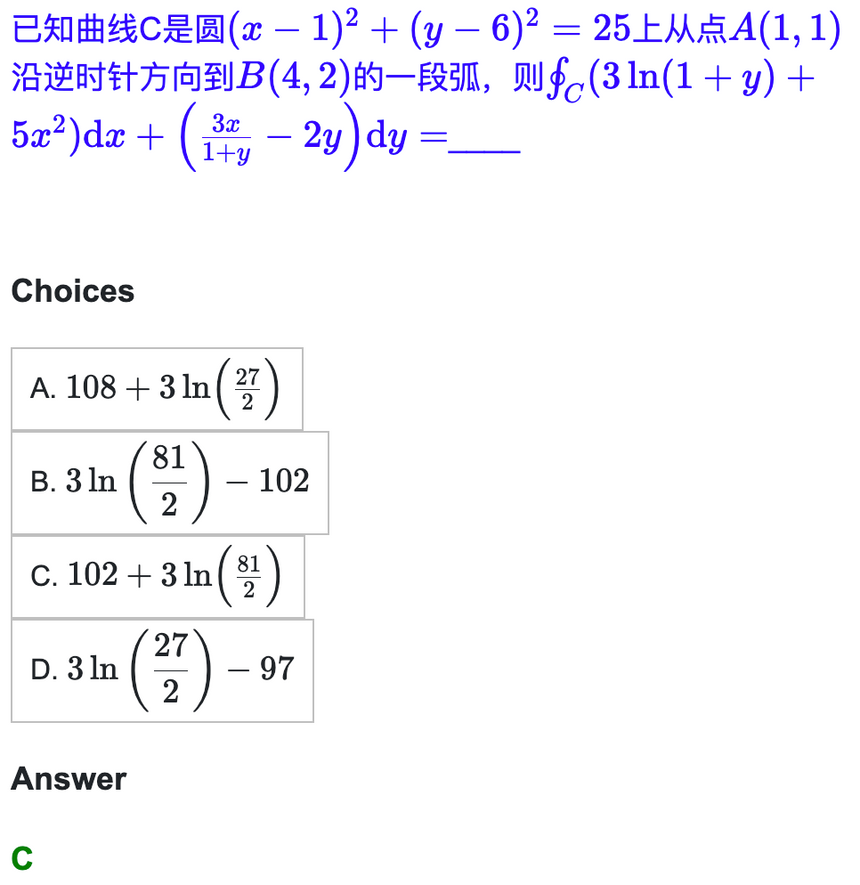

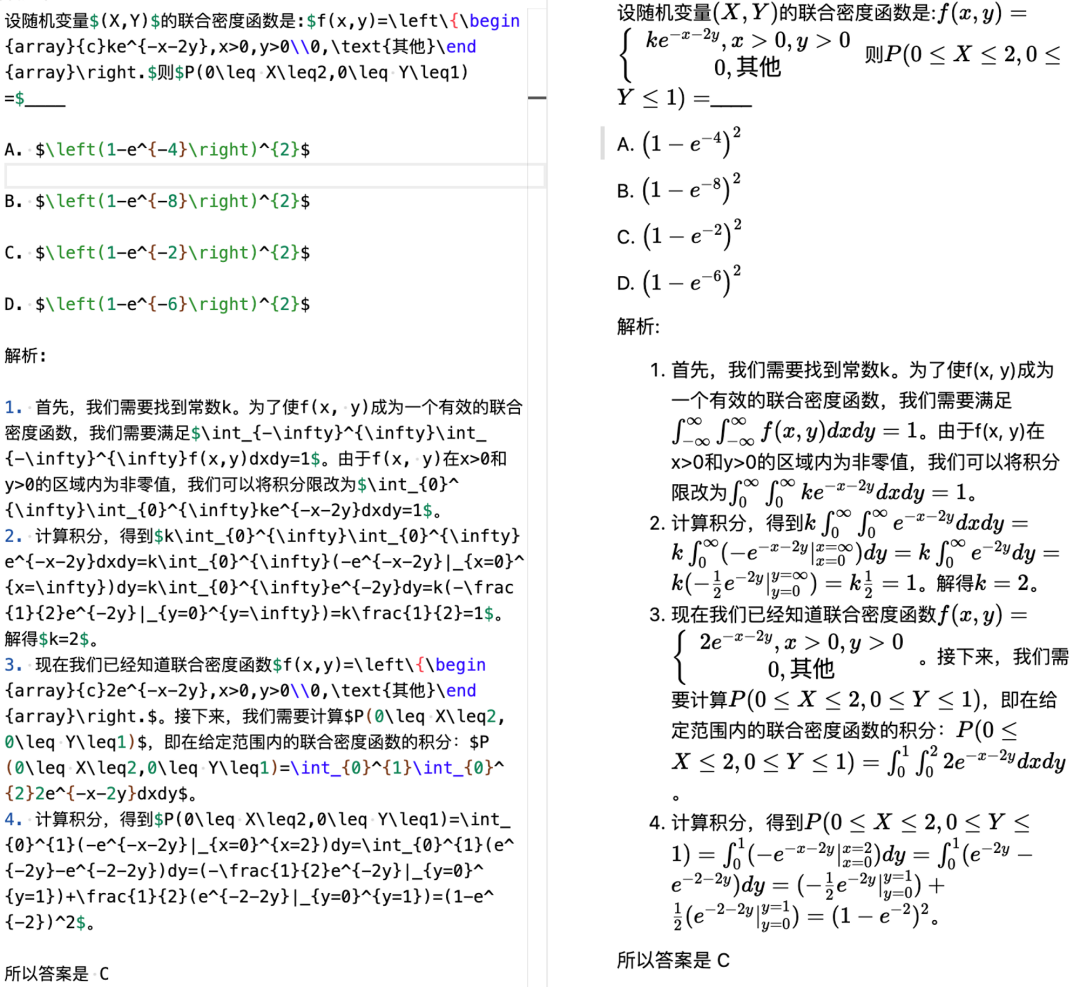

知識と推論についての上記の説明により、知識ベースから開始してデータセットを構築することにしました。タスク モデルの知識能力をテストすることは、MMLU データセットのベンチマークを行うことと同等です。同時に、モデルの高次の能力をさらに測定するために推論関連のコンテンツも提供したいと考えています。 C-Eval の強力な推論 (微積分、線形代数、確率など) は特別に抽出され、C-Eval Hard サブセットと名付けられます。これは、モデルの推論能力を測定するために使用されます。これは、MATH データセットのベンチマークと同等です。 。

C-Eval Hard では、モデルはまず数学関連の知識を持っている必要があり、次に問題を解決するための段階的なアイデアを持っている必要があります。問題解決プロセス中に Wolfram Alpha/Mathematica/Matlab を呼び出す必要がある 数値計算、記号計算、微分計算、積分計算を実行し、計算プロセスと結果を Latex 形式で表現する能力 質問のこの部分は非常に難しいです。

C-Eval は、MMLU 全体のベンチマークを行いたいと考えています (このデータセットは、GPT-3.5、GPT-4、PaLM、PaLM-2、Gopher、Chinchilla の開発に使用されます)。 、ハード部分で MATH のベンチマークを行うことを期待しています (このデータセットは GPT-4、PaLM-2、Minerva、および Gaoptica の開発で使用されます)。

ここで、私たちの最も重要な目標は、 をリストすることではなく、モデル開発を支援することであることに注意してください。リストの上位を盲目的に追求すると、多くの悪影響が生じますが、これについては後ほど説明しますが、C-Eval を科学的に使用して反復モデルを支援できれば、大きなメリットが得られます。 ## では、モデル開発の観点から C-Eval データ セットとリストを扱うことをお勧めします。

2.1 - 目標はモデル開発を支援することです実際の研究と開発プロセスでは、特定のソリューションの品質や特定のモデルの品質を知る必要があることがよくありますが、このとき、テストに役立つデータセットが必要です。以下に 2 つの古典的なシーンを示します:

- シナリオ 1、補助ハイパーパラメータ検索: 複数の事前トレーニング データ混合スキームがありますが、どれがどれであるかわかりません。どちらかがより適切です。それでは、C-Eval で相互に比較して、最適な事前トレーニング データ混合スキームを決定します。

- シナリオ 2、モデルのトレーニング フェーズの比較 #: 事前トレーニングされたチェックポイントと命令調整されたチェックポイントがあります。命令チューニングの有効性を測定したい場合は、C-Eval で 2 つのチェックポイントを相互に比較して、事前トレーニングと命令チューニングの相対的な品質を測定できます。

#2.2 - ランキングは目標ではありません

ランキングに基づいてはいけない理由を強調する必要があります目標として:

- # ランキングを目標とする場合、高スコアを得るためにリストをオーバーフィットするのは簡単ですが、汎用性が失われます。これが NLP です。 GPT-3.5 以前の学術界は、Bert の微調整に関する重要な教訓を学びました。 #リスト自体は、実際のユーザー エクスペリエンスではなく、モデルの可能性を評価するだけです。モデルがユーザーに本当に気に入っている場合でも、多くの手動評価が必要です

- ランキングが目的の場合、高スコアを獲得するための近道を選択し、堅実な科学研究の質と精神を失いがちです。

そこで、もう一度、

C-Eval データセットとリストをモデル開発の観点から扱うことをお勧めします。

2.3 - 開発者のフィードバックから継続的に反復します。

モデルをできるだけ効率的にしたいためです。開発者をサポートできるため、私たちは開発者と直接コミュニケーションを取り、開発者のフィードバックから学び、反復し続けることを選択しました。これにより、多くのことを学ぶこともできます。大きなモデルがヒューマン フィードバックからの強化学習であるのと同じように、C-Eval の開発チームは開発者のフィードバックから学び続ける。具体的には、研究開発プロセス中に、ByteDance、SenseTime、Shenyan などの企業を招待し、独自のワークフローで C-Eval Do テストを接続しました。 、そしてテストプロセスの課題点についてお互いにコミュニケーションします。このプロセスにより、当初は予期していなかった多くのことを学ぶことができました。

- 同じ会社内であっても、多くのテスト チームは、関連する問題を知る方法がありません。テスト対象のモデルに関する情報 (ブラック ボックス テスト)、このモデルが命令チューニングを経たかどうかさえわからないため、コンテキスト内学習とゼロショット プロンプトの両方をサポートする必要があります。

- 一部のモデルは黒いため、ボックス テストの場合、ロジットを取得する方法はありませんが、小さなモデルの場合はロジットがないと、答えを決定することがより困難になるため、決定するためのソリューションを決定する必要があります。その答えは小さなモデルで得られます。

- コンテキスト内学習やゼロショット プロンプトなど、多くのモデル テスト モデルがあり、回答のみや思考連鎖など、プロンプト形式も多数あります。チェックポイントには、事前トレーニングされたチェックポイントや命令によって微調整されたチェックポイントなど、さまざまな種類があるため、これらの要素のそれぞれの影響と相互作用を理解する必要があります。

- モデルは、プロンプト、プロンプト エンジニアリングが必要かどうか、プロンプト エンジニアリングが公平性を妨げるかどうかに非常に敏感です。

- GPT-3.5 / GPT-4 / Claude / PaLM プロンプト エンジニアリングが行うべきこと、そしてその経験から学ぶべきこと。

上記のプロセスは、モデル開発の観点から C-Eval データ セットとリストを扱うことが、誰もが中国の大規模モデルを開発するのに非常に役立つことを証明しています。

すべての開発者の皆様が、GitHub に問題やプル リクエストを送信し、より良い支援方法をお知らせいただけることを歓迎します。私たちはより良い支援をしたいと考えています:) この章では、実稼働プロセス中にデータセットの品質を確保するために使用する方法について説明します。ここでの最も重要な参照は、2 つのデータ セット MMLU と MATH です。最も重要な 4 つの大規模モデル チーム、OpenAI、Google、DeepMind、および Anthropic はすべて MMLU と MATH に重点を置いているため、これら 2 つに貢献できることを期待しています。データセットをインラインで設定します。予備調査と一連の議論の後、私たちは 2 つの重要な決定を下しました。1 つは データセット を最初から作成することであり、もう 1 つはキー ポイント クローラによって質問がトレーニング セットにクロールされるのを防ぎます。 3.1 - 手作り GPT の開発プロセスからの重要なインスピレーションは、人工知能の分野におけるものです。 , 人工知能があるのと同じだけの知能があります。これは、C-Eval を確立するプロセスにもよく反映されています。具体的には、質問のソースから: 次に、処理問題があります。 3 - 方法品質を確保する

- 次の困難は、公式の思考連鎖プロンプトをどのように構築するかです。ここでの重要な点は、次のことを確認する必要があるということです。私たちの CoT が正しいことを確認します。私たちの最初のアプローチは、GPT-4 にコンテキスト内のサンプルごとに思考チェーンを生成させることでしたが、後に、これは実現不可能であることがわかりました。まず、生成されたものが長すぎます (2048 トークン以上)。一部のモデルの長さはサポートされていない可能性があります。もう 1 つは、エラー率が高すぎることです。各自で確認することをお勧めします。

- そこで、学生は GPT に基づいて CoT を生成しました。 4 、微積分、直線生成、確率、離散性などのプロンプト質問を自分で実際にやってみました (文脈内の例として各科目に 5 つの質問)。以下は例です:

#左側は学生自身が作成し、Markdown - Latex 形式で記述したもので、右側はレンダリングされたエフェクトです。

なぜ質問が難しいのか、思考連鎖プロンプトが非常に長いのか、なぜモデルが記号計算と数値計算を実行できる必要があるのかを感じることもできます。

##3.2 - 私たちの質問がトレーニングセットに混入するのを防ぐ

#科学的目的のため評価に際し、私たちの質問がトレーニング セットに混入することを防ぐための一連のメカニズムを検討しました

- まず第一に、当社のテスト セットでは質問のみが公開されており、回答は公開されていません。独自のモデルを使用して回答をローカルで実行し、Web サイトに送信すると、スコアが与えられます。

- C-Eval の問題はすべて模擬問題であり、中学校から大学院入試、職業試験まで実際の問題は一切使用していません。国家試験の実際の問題はオンラインで広く入手可能であり、非常に簡単です。特定の Web ページのトピックで銀行を検索することはできますが、このような状況はまれであるはずだと考えています。そして、私たちが得た結果から判断すると、C-Eval の質問、特にハード部分はまだ十分に区別されています。

次に、モデルのランキングを向上させるためにどのような方法を使用できるかを分析します。まず、市販されていない LLaMA の使用や GPT によって生成されたデータの使用など、すべての人にとってのショートカットと、これらの方法の欠点をリストし、次に、

難しいが正しいパスとは何かについて説明します。

。 4.1 - どのようなショートカットを利用できますか?

実行できるショートカットは次のとおりです:

LLaMA をベース モデルとして使用する

- : 他の関連する英語モデル評価プロジェクト Chain-of-thought Hub では、65B LLaMA モデルが GPT-3.5 よりもわずかに弱い基本モデルであることを指摘しました。中国語データでトレーニングすれば、その強力な英語機能を自動的に中国語に移行できます。 ただし、これを行う場合の欠点は、研究開発能力の上限が LLaMA 65B によってロックされてしまうことです。いいえ、GPT-4はおろか、GPT-3.5を超える可能性があります。一方、LLaMAは商用利用できません。商用目的で使用すると直接規制に違反します。

- ##GPT-4 データを使用して生成##: 特に C-Eval Hard 部分は、GPT-4 に再度実行させてから、GPT-4 の回答を独自のモデルにフィードします。 しかし、これを行うことの欠点は次のとおりです: 第一に、これは裸の不正行為であり、得られた結果は一般化できず、モデルの真の機能を表すことができません。第二に、それが商用化された場合、直接OpenAI の使用規則に違反します。3 番目に、

- GPT-4 からの蒸留は、モデルのナンセンス現象を悪化させます。これは、RLHF がモデルに自分が知っていることを知るよう促すためです。モデルの拒否能力を微調整するとき。私は知らないのでわかりませんが、GPT-4 を直接コピーすると、GPT-4 が知っていることを他のモデルが必ずしも知っているとは限らず、モデルがナンセンスなことを話すようになる可能性があります。 。この現象は、バークレーでのジョン・シュルマン氏の最近の講演で強調されました。

- # 近道のように見えるものには、実は密かに値札が付いていることがよくあります。 4.2 - 難しいが正しい道

最良の方法は、自分らしくいることです。信頼性と自立性を備え、ゼロから開発されました。これは難しく、時間がかかり、忍耐が必要ですが、それが正しい方法です。

#具体的には、次の機関からの論文に焦点を当てる必要があります# # OpenAI - これについては疑いの余地はありません。すべての記事は完全に暗記する必要があります#Anthropic - OpenAI が教えてくれないこと、Anthropic が教えてくれます

Google DeepMind - Google はどちらかというとスケープゴートです。隠蔽して隠蔽する OpenAI とは異なり、すべてのテクノロジーを正直に伝えます。の記事。他の記事を読む前に、まず判断力を養って、良いものと悪いものを区別できるようにしてください。学問においては、ただ無批判に受け入れるのではなく、善悪を区別することが重要です。

- 研究開発の過程では、次の内容に注意することをお勧めします。

- DoReMi の手法など、事前学習データをグループ化する方法

- BLOOM の手法など、事前学習の安定性を高める方法

- The Flan Collection などの命令チューニング データをグループ化する方法

- Self-instruct などの命令チューニングを行う方法

- 憲法 AI などの RL のやり方

- 前回のブログなどの推論能力を高める方法

- 推論能力を高める方法StarCoder などのコーディング機能

- ツールの使用能力を高める方法 (C-Eval Hard では、モデルが科学計算用のツールを呼び出すことができる必要があります) (toolformer など)

- OpenAI の GPT シリーズは、GPT-3 から GPT-4 まで、2019 年から 2023 年まで合計 4 年かかりました。

- Anthropic の元のチームが OpenAI から分離された後、GPT-3 の経験があったにもかかわらず、Claude をやり直すのに 1 年かかりました。

- LLaMA のチームは、OPT と BLOOM のレッスンを受けても、6 か月かかりました。

- GLM-130Bはプロジェクト立ち上げから発売まで2年かかりました。

- RL 前のコンテンツである MOSS のアライメント部分にも半年近くかかりましたが、これにはまだ RL が含まれていません。

4.3 - 急がないでください

大規模なモデルは時間がかかります。人工知能の産業能力のテスト:

したがって、急いでランキングに行く必要も、明日結果を見る必要も、明後日オンラインにアクセスする必要もありません。ゆっくり取り組んでください。一歩ずつ。多くの場合、困難ではあるが正しい道が、実際には最速の道です。

5 - 結論

この記事では、C-Eval の開発目標、プロセス、および重要な考慮事項を紹介しました。私たちの目標は、開発者が中国の大規模モデルをより適切に開発できるように支援し、モデルの反復を支援するために学界や産業界での C-Eval の科学的使用を促進することです。大規模なモデル自体は非常に難しいものであるため、結果を確認することを急いでいません。私たちは、自分が取るべき近道を知っていますが、難しくても正しい道が実際には最速の道であることも知っています。私たちは、この取り組みが中国の大型モデルの研究開発エコロジーを促進し、人々がこの技術によってもたらされる利便性をより早く体験できることを願っています。

#付録 1: C-Eval に含まれる主題

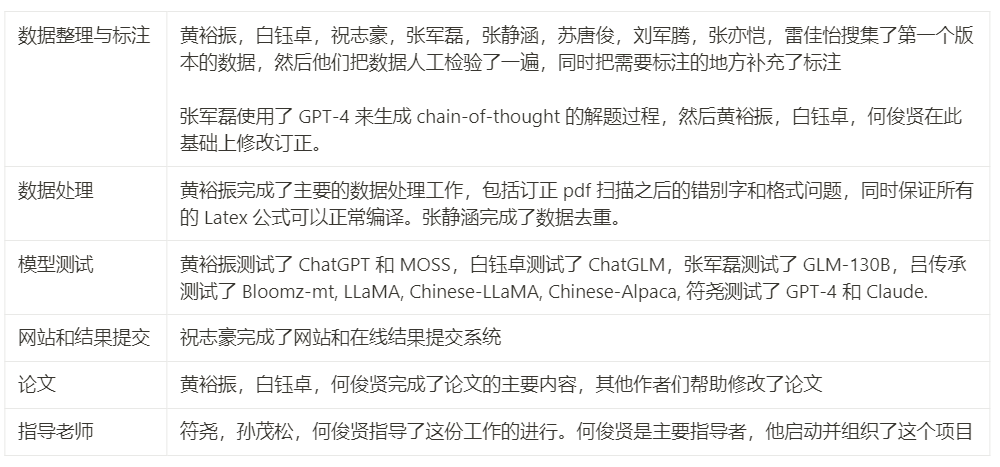

##付録 2: プロジェクト メンバーの貢献

#注: text 言及された論文の対応する URL は元のページにあります。

以上が中国の大型モデル用のテストセットを作成するために、微積分や線分生成などの 52 科目をカバーする 13948 問が清華大学に提出されました。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

AI Hentai Generator

AIヘンタイを無料で生成します。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7493

7493

15

15

1377

1377

52

52

77

77

11

11

19

19

41

41

世界で最も強力なオープンソース MoE モデルが登場。GPT-4 に匹敵する中国語機能を備え、価格は GPT-4-Turbo のわずか 1% 近くです

May 07, 2024 pm 04:13 PM

世界で最も強力なオープンソース MoE モデルが登場。GPT-4 に匹敵する中国語機能を備え、価格は GPT-4-Turbo のわずか 1% 近くです

May 07, 2024 pm 04:13 PM

従来のコンピューティングを超える能力を備えているだけでなく、より低コストでより効率的なパフォーマンスを実現する人工知能モデルを想像してみてください。これは SF ではありません。世界で最も強力なオープンソース MoE モデルである DeepSeek-V2[1] が登場しました。 DeepSeek-V2 は、経済的なトレーニングと効率的な推論の特徴を備えた強力な専門家混合 (MoE) 言語モデルです。これは 236B のパラメータで構成されており、そのうち 21B は各マーカーをアクティブにするために使用されます。 DeepSeek67B と比較して、DeepSeek-V2 はパフォーマンスが優れていると同時に、トレーニング コストを 42.5% 節約し、KV キャッシュを 93.3% 削減し、最大生成スループットを 5.76 倍に高めます。 DeepSeek は一般的な人工知能を研究する会社です

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

こんにちは、電気アトラスです!ボストン・ダイナミクスのロボットが復活、180度の奇妙な動きにマスク氏も恐怖

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas は正式に電動ロボットの時代に突入します!昨日、油圧式アトラスが歴史の舞台から「涙ながらに」撤退したばかりですが、今日、ボストン・ダイナミクスは電動式アトラスが稼働することを発表しました。ボストン・ダイナミクス社は商用人型ロボットの分野でテスラ社と競争する決意を持っているようだ。新しいビデオが公開されてから、わずか 10 時間ですでに 100 万人以上が視聴しました。古い人が去り、新しい役割が現れるのは歴史的な必然です。今年が人型ロボットの爆発的な年であることは間違いありません。ネットユーザーは「ロボットの進歩により、今年の開会式は人間のように見え、人間よりもはるかに自由度が高い。しかし、これは本当にホラー映画ではないのか?」とコメントした。ビデオの冒頭では、アトラスは仰向けに見えるように地面に静かに横たわっています。次に続くのは驚くべきことです

MLP に代わる KAN は、オープンソース プロジェクトによって畳み込みまで拡張されました

Jun 01, 2024 pm 10:03 PM

MLP に代わる KAN は、オープンソース プロジェクトによって畳み込みまで拡張されました

Jun 01, 2024 pm 10:03 PM

今月初め、MIT やその他の機関の研究者らは、MLP に代わる非常に有望な代替案である KAN を提案しました。 KAN は、精度と解釈可能性の点で MLP よりも優れています。また、非常に少数のパラメーターを使用して、多数のパラメーターを使用して実行する MLP よりも優れたパフォーマンスを発揮できます。たとえば、著者らは、KAN を使用して、より小規模なネットワークと高度な自動化で DeepMind の結果を再現したと述べています。具体的には、DeepMind の MLP には約 300,000 個のパラメーターがありますが、KAN には約 200 個のパラメーターしかありません。 KAN は、MLP が普遍近似定理に基づいているのに対し、KAN はコルモゴロフ-アーノルド表現定理に基づいているのと同様に、強力な数学的基礎を持っています。以下の図に示すように、KAN は

テスラのロボットは工場で働く、マスク氏:手の自由度は今年22に達する!

May 06, 2024 pm 04:13 PM

テスラのロボットは工場で働く、マスク氏:手の自由度は今年22に達する!

May 06, 2024 pm 04:13 PM

テスラのロボット「オプティマス」の最新映像が公開され、すでに工場内で稼働可能となっている。通常の速度では、バッテリー(テスラの4680バッテリー)を次のように分類します:公式は、20倍の速度でどのように見えるかも公開しました - 小さな「ワークステーション」上で、ピッキング、ピッキング、ピッキング:今回は、それがリリースされたハイライトの1つビデオの内容は、オプティマスが工場内でこの作業を完全に自律的に行い、プロセス全体を通じて人間の介入なしに完了するというものです。そして、オプティマスの観点から見ると、自動エラー修正に重点を置いて、曲がったバッテリーを拾い上げたり配置したりすることもできます。オプティマスのハンドについては、NVIDIA の科学者ジム ファン氏が高く評価しました。オプティマスのハンドは、世界の 5 本指ロボットの 1 つです。最も器用。その手は触覚だけではありません

FisheyeDetNet: 魚眼カメラに基づいた最初のターゲット検出アルゴリズム

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: 魚眼カメラに基づいた最初のターゲット検出アルゴリズム

Apr 26, 2024 am 11:37 AM

目標検出は自動運転システムにおいて比較的成熟した問題であり、その中でも歩行者検出は最も初期に導入されたアルゴリズムの 1 つです。ほとんどの論文では非常に包括的な研究が行われています。ただし、サラウンドビューに魚眼カメラを使用した距離認識については、あまり研究されていません。放射状の歪みが大きいため、標準のバウンディング ボックス表現を魚眼カメラに実装するのは困難です。上記の説明を軽減するために、拡張バウンディング ボックス、楕円、および一般的な多角形の設計を極/角度表現に探索し、これらの表現を分析するためのインスタンス セグメンテーション mIOU メトリックを定義します。提案された多角形モデルの FisheyeDetNet は、他のモデルよりも優れたパフォーマンスを示し、同時に自動運転用の Valeo 魚眼カメラ データセットで 49.5% の mAP を達成しました。

Llama 70B を実行するシングル カードはデュアル カードより高速、Microsoft は FP6 を A100 オープンソースに強制導入

Apr 29, 2024 pm 04:55 PM

Llama 70B を実行するシングル カードはデュアル カードより高速、Microsoft は FP6 を A100 オープンソースに強制導入

Apr 29, 2024 pm 04:55 PM

FP8 以下の浮動小数点数値化精度は、もはや H100 の「特許」ではありません。 Lao Huang は誰もが INT8/INT4 を使用できるようにしたいと考え、Microsoft DeepSpeed チームは NVIDIA からの公式サポートなしで A100 上で FP6 の実行を開始しました。テスト結果は、A100 での新しい方式 TC-FPx の FP6 量子化が INT4 に近いか、場合によってはそれよりも高速であり、後者よりも精度が高いことを示しています。これに加えて、エンドツーエンドの大規模モデルのサポートもあり、オープンソース化され、DeepSpeed などの深層学習推論フレームワークに統合されています。この結果は、大規模モデルの高速化にも即座に影響します。このフレームワークでは、シングル カードを使用して Llama を実行すると、スループットはデュアル カードのスループットの 2.65 倍になります。 1つ

オックスフォード大学の最新情報!ミッキー:2D画像を3D SOTAでマッチング! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

オックスフォード大学の最新情報!ミッキー:2D画像を3D SOTAでマッチング! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

前に書かれたプロジェクトのリンク: https://nianticlabs.github.io/mickey/ 2 枚の写真が与えられた場合、それらの写真間の対応関係を確立することで、それらの間のカメラのポーズを推定できます。通常、これらの対応は 2D 対 2D であり、推定されたポーズはスケール不定です。いつでもどこでもインスタント拡張現実などの一部のアプリケーションでは、スケール メトリクスの姿勢推定が必要なため、スケールを回復するために外部深度推定器に依存します。この論文では、3D カメラ空間でのメトリックの対応を予測できるキーポイント マッチング プロセスである MicKey を提案します。画像全体の 3D 座標マッチングを学習することで、相対的なメトリックを推測できるようになります。

OpenAI データは必要ありません。大規模なコード モデルのリストに加わりましょう。 UIUC が StarCoder-15B-Instruct をリリース

Jun 13, 2024 pm 01:59 PM

OpenAI データは必要ありません。大規模なコード モデルのリストに加わりましょう。 UIUC が StarCoder-15B-Instruct をリリース

Jun 13, 2024 pm 01:59 PM

ソフトウェア テクノロジの最前線に立つ UIUC Zhang Lingming のグループは、BigCode 組織の研究者とともに、最近 StarCoder2-15B-Instruct 大規模コード モデルを発表しました。この革新的な成果により、コード生成タスクにおいて大きな進歩が達成され、CodeLlama-70B-Instruct を上回り、コード生成パフォーマンス リストのトップに到達しました。 StarCoder2-15B-Instruct のユニークな特徴は、その純粋な自己調整戦略であり、トレーニング プロセス全体がオープンで透過的で、完全に自律的で制御可能です。このモデルは、高価な手動アノテーションに頼ることなく、StarCoder-15B 基本モデルの微調整に応じて、StarCoder2-15B を介して数千の命令を生成します。