「画像はコードと矛盾している。Transformer の論文に誤りが見つかった。ネットユーザー:1,000 回指摘されるべきだった。」

2017 年、Google Brain チームは論文「Attending Is All You Need」で Transformer アーキテクチャを独創的に提案しました。それ以来、この研究はデバッグされ、NLP 分野で最も人気のあるモデルの 1 つになりました。 1 つは、さまざまな言語タスクで広く使用されており、多くの SOTA 成果を達成していることです。

それだけでなく、NLP の分野をリードしてきた Transformer は、コンピュータ ビジョン (CV) や音声認識などの分野を瞬く間に席巻し、優れた成果を上げてきました。画像分類、ターゲット検出、音声認識などのタスクが発生します。

#論文アドレス: https://arxiv.org/pdf/1706.03762 .pdf

#発表以来、Transformer は多くのモデルのコア モジュールとなり、たとえば、おなじみの BERT、T5 などにはすべて Transformer が搭載されています。最近人気の ChatGPT も、すでに Google が特許を取得している Transformer に依存しています。

出典: https://patentimages.storage.googleapis.com /05 /e8/f1/cd8eed389b7687/US10452978.pdf

また、OpenAI がリリースした一連のモデル GPT (Generative Pre-trained Transformer) には、名前に Transformer が含まれています。トランス GPTシリーズの核となるモデルです。同時に、OpenAI の共同創設者である Ilya Stutskever 氏は最近、Transformer について話した際、Transformer が最初にリリースされたとき、実際には論文が公開されてから 2 日目だったと述べました。以前の研究を Transformer に切り替えるのを待って、GPT が導入されました。 Transformer の重要性は自明のことであることがわかります。

過去 6 年間にわたり、Transformer に基づいたモデルは成長し、開発を続けてきました。しかし今、誰かが元の Transformer 論文の誤りを発見しました。

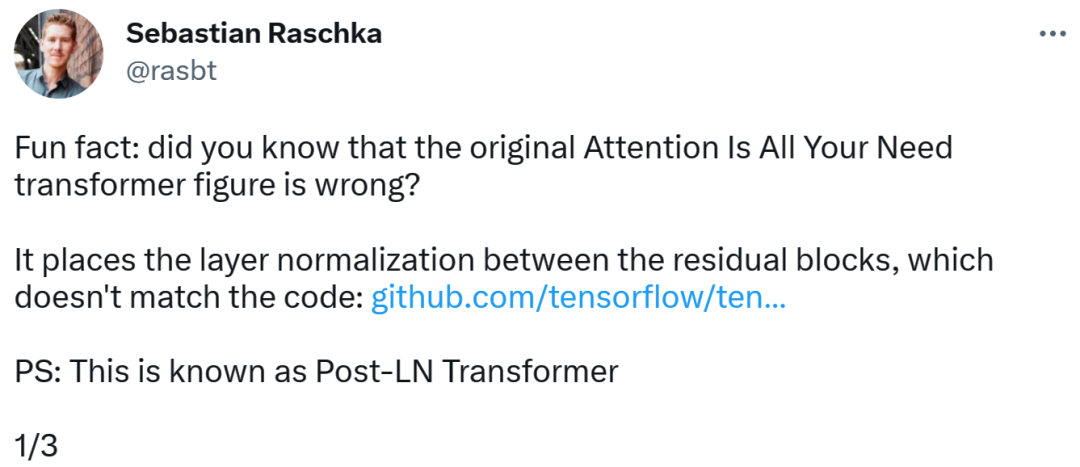

Transformer のアーキテクチャ図とコードは「一貫性がない」

エラーを発見したのは、著名な機械学習と AI 研究者であり主任 AI 教育者である Sebastian です。スタートアップ Lightning AI の Raschka。彼は、元の Transformer 論文のアーキテクチャ図が間違っており、残余ブロックの間に層正規化 (LN) が配置されており、コードと矛盾していると指摘しました。

矛盾しているコード部分は、82行目で「layer_postprocess_sequence="dan"」という実行シーケンスが記述されており、後処理ではdropout、residual_add、layer_normを順番に実行することを意味しています。上の図の左中央にある add&norm が次のように理解される場合: add は Norm の上にある、つまり、最初に Norm を付けてから add する場合、コードは確かに図と矛盾します。

コードアドレス:

https://github.com/tensorflow/tensor2tensor/commit/ f5c9b17e617ea9179b7d84d36b1e8162cb369f25#diff-76e2b94ef16871bdbf46bf04dfe7f1477bafb884748f08197c9cf1b10a4dd78e…

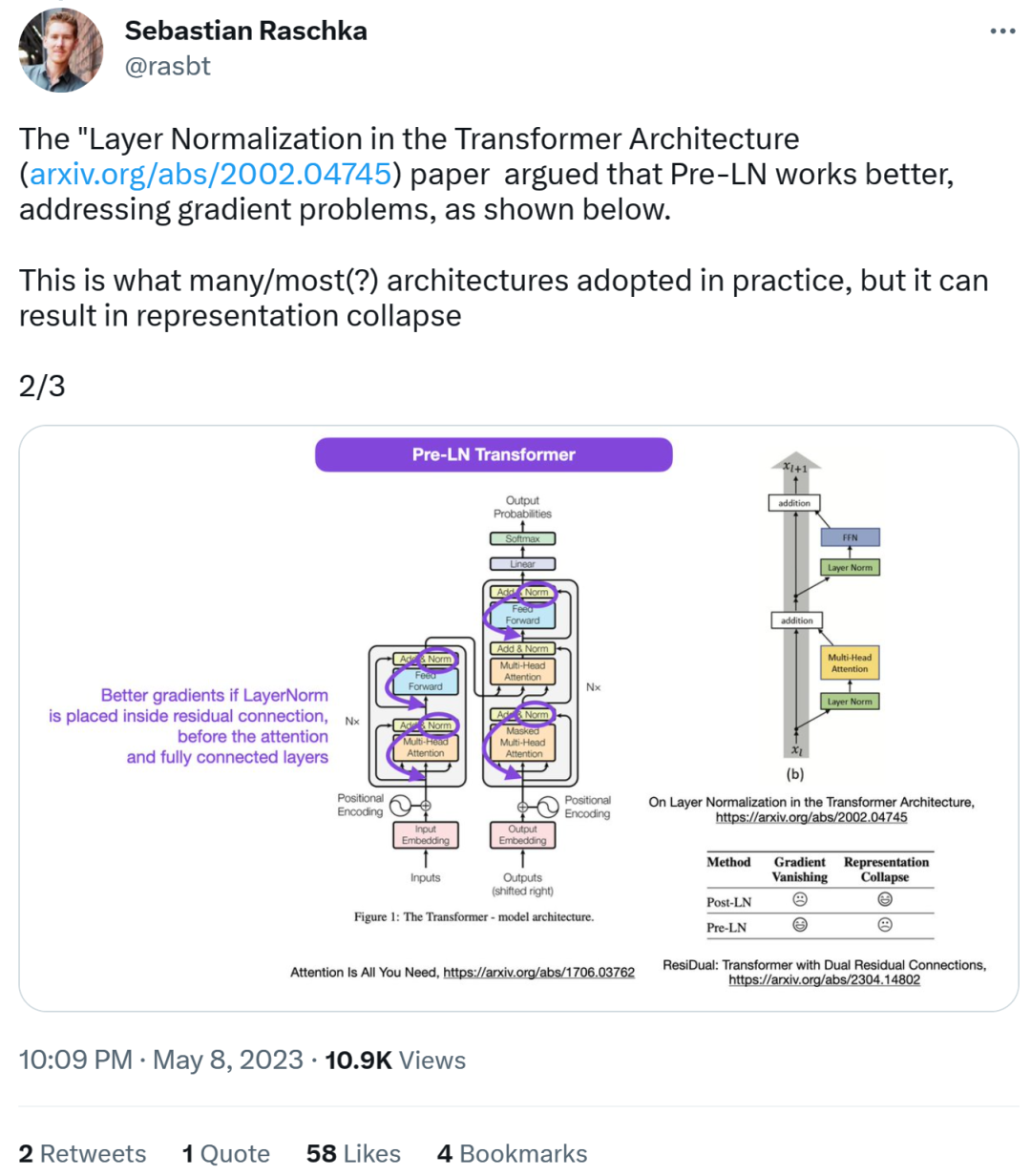

次に、Sebastian 氏は、論文「On Layer Normalization in the Transformer Architecture」では、Pre-LN のパフォーマンスが向上し、次のような問題を解決できると考えています。勾配の問題です。これは実際には多くのアーキテクチャで行われていることですが、表現の破損につながる可能性があります。

注目層と完全に接続された層の前の残りの接続に層の正規化を配置すると、より良い勾配を実現できます。

したがって、Post-LN または Pre-LN についての議論が続く一方で、別の論文がこれら 2 つの点をまとめて取り上げています。 「ResiDual: デュアル残留接続を備えたトランス」[2]。

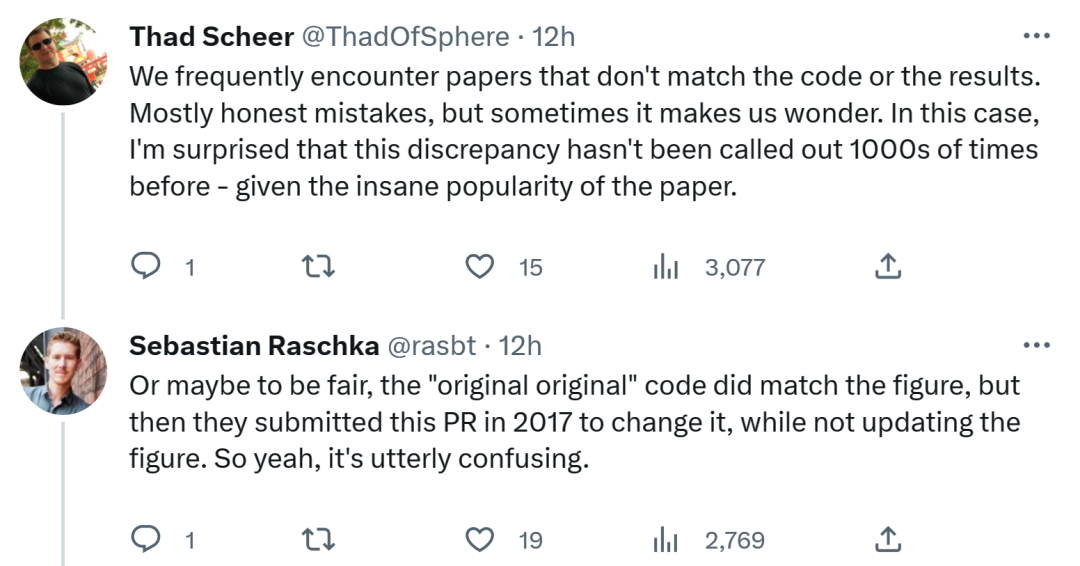

Sebastian の発見に関して、コードや結果と矛盾する論文に頻繁に遭遇すると考える人もいます。ほとんどは正直ですが、時には奇妙なこともあります。 Transformer 論文の人気を考慮すると、この矛盾については何千回も言及されるべきでした。

セバスチャンは、公平を期すために言うと、「最もオリジナルな」コードは確かにアーキテクチャ図と一致しているが、2017 年に提出されたコードのバージョンは変更されており、アーキテクチャ図は更新されていないと答えました。 。したがって、これは本当に混乱します。

あるネチズンはこう言いました、「コードを読むことに関して最悪なのは、コードを読んでしまうことだ」 #Google は今後どうするのだろうか コードを更新するのか、アーキテクチャ図を更新するのか、様子見です。

以上が「画像はコードと矛盾している。Transformer の論文に誤りが見つかった。ネットユーザー:1,000 回指摘されるべきだった。」の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

ホットAIツール

Undresser.AI Undress

リアルなヌード写真を作成する AI 搭載アプリ

AI Clothes Remover

写真から衣服を削除するオンライン AI ツール。

Undress AI Tool

脱衣画像を無料で

Clothoff.io

AI衣類リムーバー

Video Face Swap

完全無料の AI 顔交換ツールを使用して、あらゆるビデオの顔を簡単に交換できます。

人気の記事

ホットツール

メモ帳++7.3.1

使いやすく無料のコードエディター

SublimeText3 中国語版

中国語版、とても使いやすい

ゼンドスタジオ 13.0.1

強力な PHP 統合開発環境

ドリームウィーバー CS6

ビジュアル Web 開発ツール

SublimeText3 Mac版

神レベルのコード編集ソフト(SublimeText3)

ホットトピック

7704

7704

15

15

1640

1640

14

14

1394

1394

52

52

1288

1288

25

25

1231

1231

29

29

クロスチェーントランザクションとはどういう意味ですか?クロスチェーントランザクションとは何ですか?

Apr 21, 2025 pm 11:39 PM

クロスチェーントランザクションとはどういう意味ですか?クロスチェーントランザクションとは何ですか?

Apr 21, 2025 pm 11:39 PM

クロスチェーントランザクションをサポートする交換:1。Binance、2。Uniswap、3。Sushiswap、4。CurveFinance、5。Thorchain、6。1inchExchange、7。DLNTrade、これらのプラットフォームはさまざまな技術を通じてマルチチェーン資産トランザクションをサポートします。

WorldCoin(WLD)価格予測2025-2031:WLDは2031年までに4ドルに達しますか?

Apr 21, 2025 pm 02:42 PM

WorldCoin(WLD)価格予測2025-2031:WLDは2031年までに4ドルに達しますか?

Apr 21, 2025 pm 02:42 PM

WorldCoin(WLD)は、独自の生体認証とプライバシー保護メカニズムを備えた暗号通貨市場で際立っており、多くの投資家の注目を集めています。 WLDは、特にOpenai人工知能技術と組み合わせて、革新的なテクノロジーを備えたAltcoinsの間で驚くほど演奏しています。しかし、デジタル資産は今後数年間でどのように振る舞いますか? WLDの将来の価格を一緒に予測しましょう。 2025年のWLD価格予測は、2025年にWLDで大幅に増加すると予想されています。市場分析は、平均WLD価格が1.31ドルに達する可能性があり、最大1.36ドルであることを示しています。ただし、クマ市場では、価格は約0.55ドルに低下する可能性があります。この成長の期待は、主にWorldCoin2によるものです。

カーネルエアドロップ報酬を獲得する方法バイナンスフルプロセス戦略

Apr 21, 2025 pm 01:03 PM

カーネルエアドロップ報酬を獲得する方法バイナンスフルプロセス戦略

Apr 21, 2025 pm 01:03 PM

暗号通貨の賑やかな世界では、新しい機会が常に現れます。現在、Kerneldao(Kernel)Airdropアクティビティは多くの注目を集め、多くの投資家の注目を集めています。それで、このプロジェクトの起源は何ですか? BNBホルダーはそれからどのような利点を得ることができますか?心配しないでください、以下はあなたのためにそれを一つ一つ明らかにします。

なぜ仮想通貨価格の上昇または下落があるのですか?なぜ仮想通貨価格の上昇または下落があるのですか?

Apr 21, 2025 am 08:57 AM

なぜ仮想通貨価格の上昇または下落があるのですか?なぜ仮想通貨価格の上昇または下落があるのですか?

Apr 21, 2025 am 08:57 AM

仮想通貨価格の上昇の要因には、次のものが含まれます。1。市場需要の増加、2。供給の減少、3。刺激された肯定的なニュース、4。楽観的な市場感情、5。マクロ経済環境。衰退要因は次のとおりです。1。市場需要の減少、2。供給の増加、3。ネガティブニュースのストライキ、4。悲観的市場感情、5。マクロ経済環境。

「ブラックマンデーセル」は、暗号通貨業界にとって厳しい日です

Apr 21, 2025 pm 02:48 PM

「ブラックマンデーセル」は、暗号通貨業界にとって厳しい日です

Apr 21, 2025 pm 02:48 PM

暗号通貨市場での突入は投資家の間でパニックを引き起こし、Dogecoin(Doge)は最も困難なヒット分野の1つになりました。その価格は急激に下落し、分散財務財務(DEFI)(TVL)の総価値が激しく減少しました。 「ブラックマンデー」の販売波が暗号通貨市場を席巻し、ドゲコインが最初にヒットしました。そのdefitVLは2023レベルに低下し、通貨価格は過去1か月で23.78%下落しました。 DogecoinのDefitVLは、主にSOSO値指数が26.37%減少したため、272万ドルの安値に低下しました。退屈なDAOやThorchainなどの他の主要なDefiプラットフォームも、それぞれ24.04%と20減少しました。

通貨サークルでのレバレッジされた交換のランキングは

Apr 21, 2025 pm 11:24 PM

通貨サークルでのレバレッジされた交換のランキングは

Apr 21, 2025 pm 11:24 PM

2025年のレバレッジド取引、セキュリティ、ユーザーエクスペリエンスで優れたパフォーマンスを持つプラットフォームは次のとおりです。1。OKX、高周波トレーダーに適しており、最大100倍のレバレッジを提供します。 2。世界中の多通貨トレーダーに適したバイナンス、125倍の高いレバレッジを提供します。 3。Gate.io、プロのデリバティブプレーヤーに適し、100倍のレバレッジを提供します。 4。ビットゲットは、初心者やソーシャルトレーダーに適しており、最大100倍のレバレッジを提供します。 5。Kraken、安定した投資家に適しており、5倍のレバレッジを提供します。 6。Altcoinエクスプローラーに適したBybit。20倍のレバレッジを提供します。 7。低コストのトレーダーに適したKucoinは、10倍のレバレッジを提供します。 8。ビットフィネックス、シニアプレイに適しています

Web3トレーディングプラットフォームranking_web3グローバル交換トップ10の概要

Apr 21, 2025 am 10:45 AM

Web3トレーディングプラットフォームranking_web3グローバル交換トップ10の概要

Apr 21, 2025 am 10:45 AM

Binanceは、グローバルデジタルアセット取引エコシステムの大君主であり、その特性には次のものが含まれます。1。1日の平均取引量は1,500億ドルを超え、500の取引ペアをサポートし、主流の通貨の98%をカバーしています。 2。イノベーションマトリックスは、デリバティブ市場、Web3レイアウト、教育システムをカバーしています。 3.技術的な利点は、1秒あたり140万のトランザクションのピーク処理量を伴うミリ秒のマッチングエンジンです。 4.コンプライアンスの進捗状況は、15か国のライセンスを保持し、ヨーロッパと米国で準拠した事業体を確立します。

Aavenomicsは、Aaveプロトコルトークンを変更し、Tokenの買戻しを導入するための推奨事項です。

Apr 21, 2025 pm 06:24 PM

Aavenomicsは、Aaveプロトコルトークンを変更し、Tokenの買戻しを導入するための推奨事項です。

Apr 21, 2025 pm 06:24 PM

Aavenomicsは、Aaveプロトコルトークンを変更し、Aavedaoの定足数を実装したToken Reposを導入する提案です。 Aave Project Chain(ACI)の創設者であるMarc Zellerは、これをXで発表し、契約の新しい時代をマークしていることに注目しました。 Aave Chain Initiative(ACI)の創設者であるMarc Zellerは、Aavenomicsの提案にAave Protocolトークンの変更とトークンリポジトリの導入が含まれていると発表しました。 Zellerによると、これは契約の新しい時代を告げています。 Aavedaoのメンバーは、水曜日の週に100でした。